1

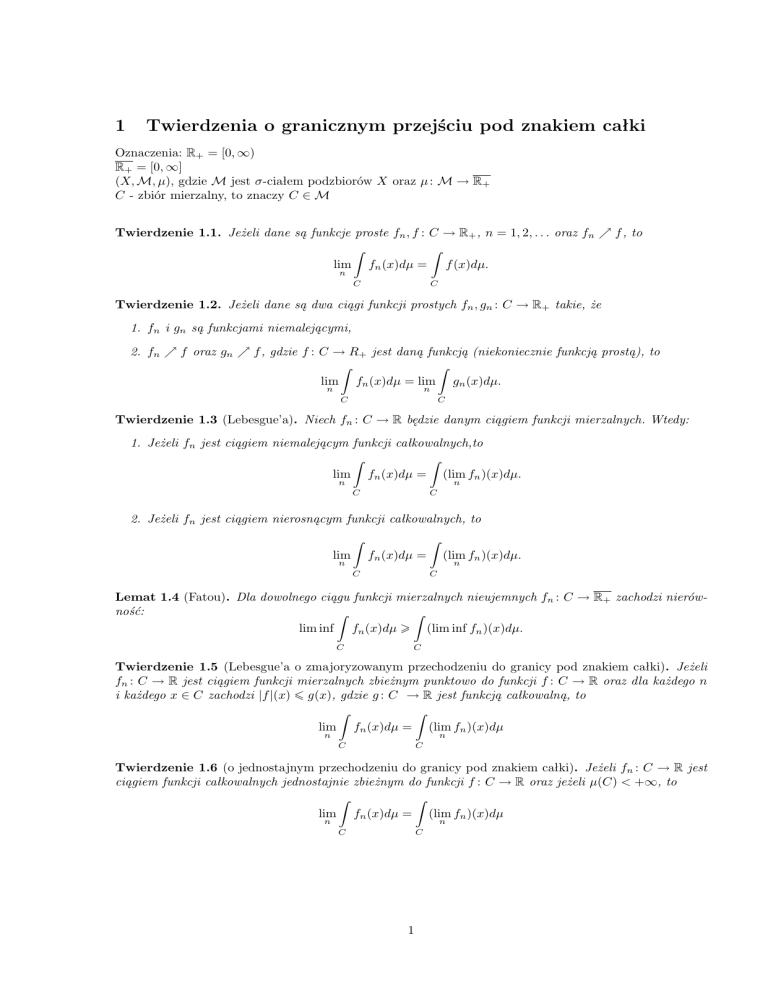

Twierdzenia o granicznym przejściu pod znakiem całki

Oznaczenia: R+ = [0, ∞)

R+ = [0, ∞]

(X, M, µ), gdzie M jest σ-ciałem podzbiorów X oraz µ : M → R+

C - zbiór mierzalny, to znaczy C ∈ M

Twierdzenie 1.1. Jeżeli dane są funkcje proste fn , f : C → R+ , n = 1, 2, . . . oraz fn % f , to

Z

Z

lim fn (x)dµ = f (x)dµ.

n

C

C

Twierdzenie 1.2. Jeżeli dane są dwa ciągi funkcji prostych fn , gn : C → R+ takie, że

1. fn i gn są funkcjami niemalejącymi,

2. fn % f oraz gn % f , gdzie f : C → R+ jest daną funkcją (niekoniecznie funkcją prostą), to

Z

Z

lim fn (x)dµ = lim gn (x)dµ.

n

n

C

C

Twierdzenie 1.3 (Lebesgue’a). Niech fn : C → R będzie danym ciągiem funkcji mierzalnych. Wtedy:

1. Jeżeli fn jest ciągiem niemalejącym funkcji całkowalnych,to

Z

Z

lim fn (x)dµ = (lim fn )(x)dµ.

n

n

C

C

2. Jeżeli fn jest ciągiem nierosnącym funkcji całkowalnych, to

Z

Z

fn (x)dµ =

lim

n

C

(lim fn )(x)dµ.

n

C

Lemat 1.4 (Fatou). Dla dowolnego ciągu funkcji mierzalnych nieujemnych fn : C → R+ zachodzi nierówność:

Z

Z

lim inf fn (x)dµ ­ (lim inf fn )(x)dµ.

C

C

Twierdzenie 1.5 (Lebesgue’a o zmajoryzowanym przechodzeniu do granicy pod znakiem całki). Jeżeli

fn : C → R jest ciągiem funkcji mierzalnych zbieżnym punktowo do funkcji f : C → R oraz dla każdego n

i każdego x ∈ C zachodzi |f |(x) ¬ g(x), gdzie g : C → R jest funkcją całkowalną, to

Z

Z

lim fn (x)dµ = (lim fn )(x)dµ

n

n

C

C

Twierdzenie 1.6 (o jednostajnym przechodzeniu do granicy pod znakiem całki). Jeżeli fn : C → R jest

ciągiem funkcji całkowalnych jednostajnie zbieżnym do funkcji f : C → R oraz jeżeli µ(C) < +∞, to

Z

Z

lim fn (x)dµ = (lim fn )(x)dµ

n

n

C

C

1

Twierdzenie 1.7 (o całkowaniu

szeregów nieujemnych). Niech fn : C → R+ będzie ciągiem funkcji mieP

rzalnych. Jeżeli szereg n fn jest punktowo zbieżny na C, to

Z X

∞

∞ Z

X

(

fn )(x)dµ =

fn (x)dµ

C

n=1

n=1 C

Twierdzenie 1.8 (Kryterium całkowe

szeregów funkcyjnych). P

Jeżeli Rdany jest ciąg funkcji

R

P∞ zbieżności

∞

całkowalnych fn : C → R taki, że n=1 |fn |(x)dµ jest zbieżny, to szereg n=1 fn (x)dµ jest zbieżny

C

oraz

C

2

C

Z X

∞

∞ Z

X

(

fn )(x)dµ =

fn (x)dµ

n=1

n=1 C

Zmienne losowe, wektory losowe i ich charakterystyki (np. wartości oczekiwane, wariancje, rozkłady)

Jeżeli f : Ω1 → Ω2 jest odwzorowaniem mierzalnym, to oznaczamy je f : (Ω1 , F1 ) → (Ω2 , F2 ), gdzie F1

(F2 ) jest σ-ciałem zbiorów mierzalnych na Ω1 (Ω2 ).

Definicja 2.1. Przestrzenią probabilistyczną nazywamy układ trzech elementów (Ω, F, P ), gdzie:

1. Ω jest pewnym zbiorem, zwanym przestrzenią zdarzeń elementarnych,

2. F jest σ-ciałem podzbiorów zbioru Ω. Elementy tego σ-ciała nazywane są zdarzeniami,

3. P : F → [0, 1] jest miarą probabilistyczną, to znaczy

(a) P (A) > 0 dla każdego A ∈ F,

(b) P (Ω) = 1,

(c) jeżeli zbiory A1 , A2 , . . . ∈ F są parami rozłączne, to P

∞

S

Ai

i=1

=

P∞

i=1

P (Ai ).

W dalszym ciągu będziemy zakładać, że dana jest przestrzeń probabilistyczna (Ω, F, P ). Zdefiniujmy

odwzorowanie charakterystyczne zbioru A ⊂ Ω: χA : Ω → R wzorem:

1 , gdy x ∈ A

χA (x) =

0 , gdy x ∈

/A

Definicja 2.2. Niech X będzie przestrzenią topologiczną. σ-ciałem zbiorów borelowskich nazywamy najmniejsze σ-ciało na X zawierające zbiory otwarte.

Definicja 2.3. Zmienną losową na przestrzeni (Ω, F, P ) nazywamy dowolną funkcję mierzalną X : (Ω, F) →

(R, B), gdzie B jest σ-ciałem zbiorów borelowskich na R.

Uwaga 2.1. Zauważmy, że:

1. X : Ω → R jest zmienną losową wtedy i tylko wtedy, gdy

∀a∈R {ω ∈ Ω : X(ω) ¬ a} ∈ F

2. X jest prostą

Pn zmienną losową (to znaczy przyjmującą skończenie wiele wartości) wtedy i tylko wtedy,

gdy X = i=1 ai χAi , gdzie a1 , . . . , an ∈ R, A1 , . . . , An ∈ F oraz Ai ∩ Aj = dla i 6= j.

3. Jeżeli X jest zmienną losową oraz ϕ : (R, B) → (R, B), to ϕ(X) jest także zmienną losową.

2

4. Jeżeli X jest zmienną losową to przez σ(X) oznaczamy σ-ciało generowane przez zmienną losową

X, to znaczy:

σ(X) = {X −1 (B) : B ∈ B} = X −1 (B)

Definicja 2.4. Zdefiniujmy:

1. Rozkładem prawdopodobieństwa na R nazywamy każdą miarę probabilistyczną µ na (R, B).

2. Rozkładem prawdopodobieństwa zmiennej losowej X nazywamy rozkład prawdopodobieństwa PX na

(R, B) określony wzorem:

∀B∈B PX (B) = P (X −1 (B)) = P ({ω ∈ Ω : X(ω) ∈ B})

Definicja 2.5. d-wymiarowym wektorem losowym na (Ω, F, P ) nazywamy odwzorowanie mierzalne X =

(X1 , . . . , Xd ) : (Ω, F) → (Rd , B d ), gdzie B d jest σ-ciałem zbiorów borelowskich na Rd .

Uwaga 2.2. X jest wektorem losowym na (Ω, F, P ) wtedy i tylko wtedy, gdy dla każdego i ∈ {1, . . . d} Xi

jest zmienną losową na (Ω, F, P ).

Definicja 2.6. Zdefiniujmy:

1. Rozkładem prawdopodobieństwa na Rd nazywamy każdą miarę probabilistyczną µ na (Rd , B d ).

2. Rozkładem prawdopodobieństwa wektora losowego X nazywamy rozkład prawdopodobieństwa PX na

(Rd , B d ) określony wzorem:

∀B∈Bd PX (B) = P (X

−1

(B)) = P ({ω ∈ Ω : X(ω) ∈ B}) = P (X ∈ B)

Definicja 2.7. Niech d ∈ {1, 2, . . .}.

1. Dystrybuantą rozkładu µ na Rd nazywamy funkcję Fµ : Rd → [0, 1] daną wzorem:

Fµ (a1 , . . . , ad ) = µ(

d

Y

(−∞, ai ]) dla a1 , . . . , ad ∈ R.

i=1

2. Dystrybuantą wektora losowego X = (X1 , . . . , Xd ) nazywamy dystrybuantę jego rozkładu PX i oznaczamy FX lub F(X1 ,...,Xd ) :

FX (a1 , . . . , ad ) = P (X ∈

d

Y

(−∞, ai ]) = P (X1 ¬ a1 , . . . , Xd ¬ ad )

i=1

Uwaga 2.3. Dystrybuanta wyznacza rozkład, to znaczy, jeżeli µ, ν są rozkładami prawdopodobieństwa na

R oraz Fµ = Fν , to µ = ν.

Twierdzenie 2.4 (Własności dystrybuanty). Dystrybuanta Fµ ma następujące własności:

1. Fµ jest funkcją niemalejącą,

2. Fµ jest prawostronnie ciągła,

3. lima→−∞ Fµ (a) = 0 oraz lima→+∞ Fµ (a) = 1.

Definicja 2.8. Niech X będzie wektorem losowym. Wówczas:

d

1. X

P ma rozkład dyskretny, jeżeli istnieją wektory X 1 , X 2 , . . . ∈ R oraz liczby p1 , p2 , . . . ∈ R+ ,

i­1 pi = 1 takie, że P (X = xi ) = pi dla i = 1, 2, . . .

3

2. X ma rozkład absolutnie ciągły z gęstością p(x), gdzie p : Rd → R+ ,

R

p(x)dx = 1, jeżeli:

Rd

Z

∀B∈Bd PX (B) = P (X ∈ B) =

p(x)dx

B

3. X ma rozkład osobliwy, jeżeli istnieje zbiór B ∈ Rd o mierze Lebesgue’a zerowej, to znaczy ld (B) = 0

taki, że PX (B) = P (X ∈ B) = 1 oraz X ma rozkład ciągły, to znaczy ∀x∈Rd P (X = x) = 0

Oznaczmy:

L1 (Ω, F, P ) = {X :

Z

|X|dP < ∞}

Ω

Lp (Ω, F, P ) = {X :

Z

|X|p dP < ∞},

Ω

gdzie p > 0

Definicja 2.9. Zdefiniujmy:

1. Dla X ∈ L1 (Ω, F, P ) jej wartością oczekiwaną nazywamy liczbę

Z

EX = XdP

Ω

2. Dla X ∈ L2 (Ω, F, P ) jej wariancją nazywamy liczbę:

D2 (X) = E(X − EX)2

3. Dla X ∈ Lp (Ω, F, P ), p > 0 jej elementem absolutnym rzędu p nazywamy liczbę mp = E|X|p .

4. Dla X, Y ∈ L2 (Ω, F, P ) ich kowariancją nazywamy liczbę:

cov(X, Y ) = E(X − EX)(Y − EY )

5. Dla X ∈ L2 (Ω, F, P ) jej odchyleniem standardowym nazywamy liczbę D(X) = D2 (X)

Twierdzenie 2.5. Niech X, Y ∈ L2 (Ω, F, P )

1. D2 (X) = EX 2 − (EX)2 ,

2. ∀c∈R D2 (cX) = c2 D2 (X),

3. ∀c∈R D2 (X + c) = D2 (X),

4. D2 (X) = 0 ⇐⇒ P (X = EX) = 1,

5. cov(X, X) = D2 (X),

6. D(X + Y ) ¬ D(X) + D(Y )

7. D2 (X ± Y ) = D2 (X) + D2 (Y ) ± 2cov(X, Y )

Definicja 2.10. Niech X = (X1 , . . . , Xd ) będzie wektorem losowym. Wówczas:

1. Wartością oczekiwaną wektora losowego nazywamy wektor

EX = (EX1 , . . . , EXd ),

o ile wszystkie współrzędne mają wartością oczekiwaną.

4

2. Macierzą kowariancji wektora X nazywamy macierz:

Cov(X) = [cov(Xi , Xj )], gdzie i, j ∈ {1, . . . d},

to znaczy

Cov(X)ij = cov(Xi , Xj ) = E(Xi − EXi )(Xj − EXj ) dla i, j ∈ {1, 2, . . . , d},

o ile wszystkie cov(Xi , Xj ) są dobrze określone.

3. Wariancją wektora X nazywamy ślad macierzy Cov(X), to znaczy:

D2 (X) =

d

X

cov(Xi , Xi ) =

i=1

gdzie ||X|| =

qP

d

i=1

d

X

D2 (Xi ) = E(

i=1

d

X

(Xi − EXi )) = E||X − EX||2 ,

i=1

Xi2

Jeżeli X jest zmienną losową na Ω o rozkładzie dyskretnym z funkcją prawdopodobieństwa P , to

EX =

∞

X

ωi P (X = ωi )

i=1

Jeżeli X ma rozkład ciągły z gęstością f , to:

+∞

Z

EX =

xf (x)dx

−∞

3

Niezależność zmiennych losowych (oraz zdarzeń i rodzin zdarzeń). Schemat Bernoullego.

Definicja 3.1. Niech (Ω, F, P ) będzie przestrzenią probabilistyczną oraz niech A1 , . . . , Ad ∈ F będą

zdarzeniami. Zdarzenia A1 , . . . , Ad nazwiemy niezależnymi, jeżeli P (A1 ∩ . . . ∩ Ad ) = P (A1 ) . . . P (Ad ).

Jeżeli {Ai }i∈I ∈ F jest rodziną zdarzeń, to powiemy, że jest ona niezależna, jeżeli dowolna skończona

podrodzina jest niezależna, to znaczy: dla dowolnego układu {i1 , . . . ik } ⊂ I zmienne losowe Ai1 , . . . Aik są

niezależne.

Uwaga 3.1. Jeżeli zdarzenia A1 , . . . , Ad ∈ F są niezależne, to oczywiście każda para zdarzeń jest niezależna. W drugą stronę wynikanie nie jest prawdziwe.

Definicja 3.2. Zdefiniujmy:

1. Zmienne losowe X1 , X2 , . . . , Xd określone na przestrzeni probabilistycznej (Ω, F, P ) nazywamy niezależnymi, jeżeli dla dowolnych zbiorów borelowskich B1 , . . . , Bd ∈ B mamy:

P (X1 ∈ B1 , . . . Xd ∈ Bd ) = P (X1 ∈ B1 ) . . . P (Xd ∈ Bd )

2. Zmienne losowe {Xi }i∈I tworzą rodzinę niezależnych zmiennych losowych, jeżeli każdy ich skończony

podzbiór składa się z niezależnych zmiennych losowych.

Uwaga 3.2. Jeżeli {Xi }i∈I tworzy rodzinę niezależnych zmiennych losowych, to dla I0 ∈ I mamy, że

{Xi }i∈I0 również tworzy rodzinę niezależnych zmiennych losowych.

Definicja 3.3. Zdefiniujmy:

5

1. Rozkładem łącznym zmiennych losowych X1 , . . . Xd nazywamy rozkład wektora losowego X = (X1 , . . . Xd ).

Oznaczamy go symbolem P(X1 ,...,Xd ) .

2. Rozkładami brzegowymi wektora X = (X1 , . . . Xd ) nazywamy rozkłady jego współrzędnych X1 , . . . Xd .

Twierdzenie 3.3. Niech X1 , . . . Xd będą zmiennymi losowymi na przestrzeni (Ω, F, P ). Następujące warunki są równoważne:

1. Zmienne losowe są niezależne

2. P(X1 ,...,Xd ) = PX1 × . . . × PXd

3. Dla wszystkich a1 , . . . ad ∈ R mamy:

F(X1 ,...,Xd ) (a1 , . . . ad ) = FX1 (a1 ) . . . FXd (ad )

Wniosek 3.4. Zmienne losowe o rozkładach dyskretnych X1 , . . . Xd są niezależne wtedy i tylko wtedy, gdy

dla dowolnych y1 , . . . , yd ∈ R takich, że P (Xi = yi ) > 0 dla i ∈ {1, 2, . . . , d} zachodzi warunek:

P (X1 = y1 , . . . , Xd = yd ) = P (X1 = y1 ) . . . P (Xd = yd )

Twierdzenie 3.5. Niech A1 , . . . Ad będą zdarzeniami na (Ω, F, P ). Zmienne losowe χA1 , . . . , χAd są niezależne wtedy i tylko wtedy, gdy zdarzenia A1 , . . . Ad są niezależne.

Funkcja p jest gęstością rozkładu P(X1 ,...,Xd ) , jeżeli dla każdego B ∈ B d zachodzi:

Z

P ((X1 , . . . , Xd ) ∈ B) = p(x)dx.

B

Twierdzenie 3.6. Jeżeli X1 , . . . Xd są zmiennymi losowymi o rozkładach ciągłych z gęstościami odpowiednio p1 (x), . . . pd (x), to zmienne te są niezależne wtedy i tylko wtedy, gdy P(X1 ,...,Xd ) jest rozkładem

absolutnie ciągłym z gęstością p(x) = p1 (x1 ) . . . pd (xd )

Definicja 3.4. Niech (Ω, F, P ) będzie przestrzenią probabilistyczną.

1. σ-ciała F1 , . . . , Fd ⊂ F nazywamy niezależnymi, jeśli P (A1 ∩ . . . ∩ Ad ) = P (A1 ) . . . P (Ad ) dla dowolnych A1 ∈ F1 , . . . , Ad ∈ Fd .

2. σ-ciała {Fi }i∈I tworzą rodzinę niezależnych σ-ciał, jeżeli każdy ich skończony podzbiór składa się z

niezależnych σ-ciał.

Twierdzenie 3.7. Dla zmiennych losowych X1 , . . . , Xd na (Ω, F, P ) następujące warunki są równoważne:

1. X1 , . . . , Xd sa niezależne.

2. σ-ciała σ(X1 ), . . . , σ(Xd ) są niezależne.

3. Dla dowolnych funkcji borelowskich f1 , . . . , fd : (R, B) → (R, B) zmienne losowe f1 (X1 ), . . . fd (Xd ) są

niezależne.

Twierdzenie 3.8. Jeżeli X, Y są niezależnymi zmiennymi losowymi całkowalnymi, to znaczy X, Y ∈

L1 (Ω, F, P ), to:

1. XY ∈ L1 (Ω, F, P ),

2. E(XY ) = EXEY .

Wniosek 3.9. Jeżeli X, Y są niezależnymi zmiennymi losowymi, a f1 , . . . fd : (R, B) → (R, B) funkcjami

borelowskimi takimi, że E|fi (Xi )| < +∞ dla i ∈ {1, . . . d}, to f1 (X1 ) . . . fd (Xd ) jest całkowalną zmienną

losową oraz:

E(f1 (X1 ) . . . fd (Xd )) = Ef1 (X1 ) . . . Efd (Xd )

6

Definicja 3.5. Mówimy, że zmienne losowe {Xi }i∈I są nieskorelowane, jeżeli dla wszystkich i, j ∈ I, i 6= j

mamy: cov(Xi , Xj ) = 0.

Jeżeli zmienne losowe są niezależne, to są nieskorelowane.

Twierdzenie 3.10. Jeżeli X1 , . . . , Xd są nieskorelowanymi zmiennymi losowymi, to

d

d

X

X

D2 (

Xi ) =

D2 (Xi )

i=1

i=1

Schematem Bernoulliego nazywamy skończony ciąg niezależnych powtórzeń tego samego doświadczenia

o dwóch możliwych wynikach nazywanych sukcesem i porażką.

W schemacie Bernoullego:

1. Poszczególne doświadczenia wykonywane są niezależnie.

2. Wynikiem doświadczenia jest sukces (symbolicznie 1) lub porażka (symbolicznie 0).

3. Prawdopodobieństwo sukcesu jest dla każdej próby takie samo i wynosi p ∈ (0, 1) oraz prawdopodobieństwo porażki wynosi 1 − p.

Przestrzeń probabilistyczna odpowiadająca temu schematowi:

Ω = {(ω1 , . . . , ωn ) : ωi ∈ {0, 1}, i = 1, . . . , n}

F = 2Ω

n

n

P

P

ωi

P ((ω1 , . . . , ωn )) = pi=1

n−

(1 − p)

ωi

i=1

Twierdzenie 3.11. Prawdopodobieństwo pojawienia się dokładnie k sukcesów w schemacie

n prób Ber

noullego, z prawdopodobieństwem sukcesu w pojedynczej próbie równym p, wynosi nk pk (1 − p)n−k . Jeżeli

Sn jest zmienną losową, która opisuje to prawdopodobieństwo, to:

1. ESn = np

2. D2 (Sn ) = np(1 − p)

7