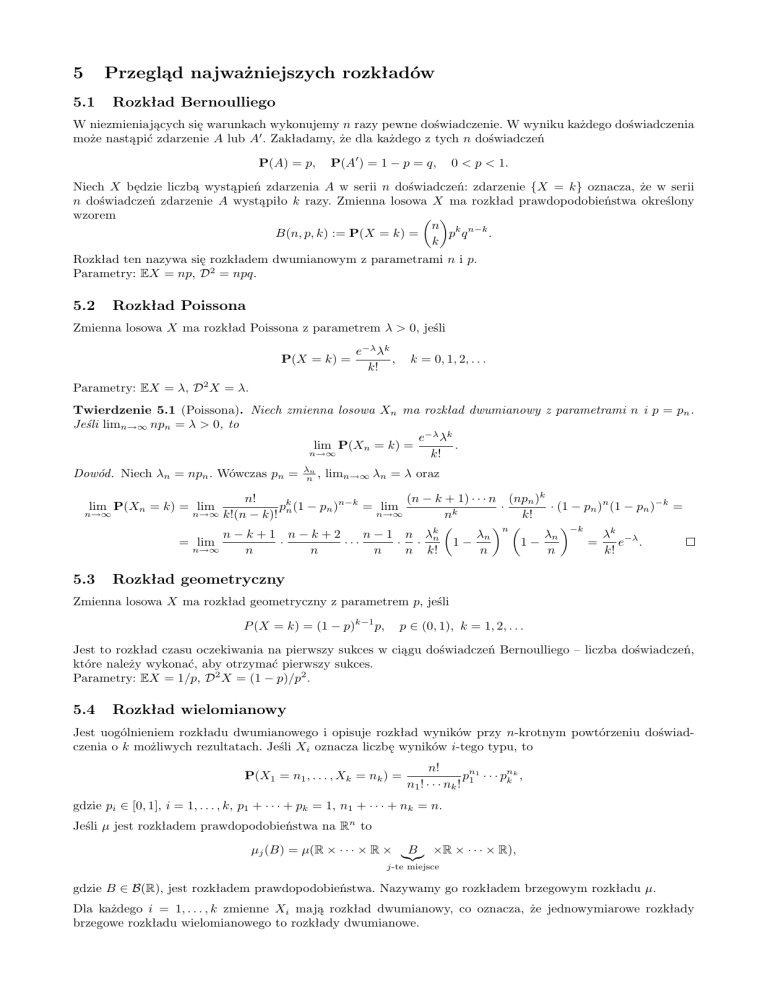

5

Przegląd najważniejszych rozkładów

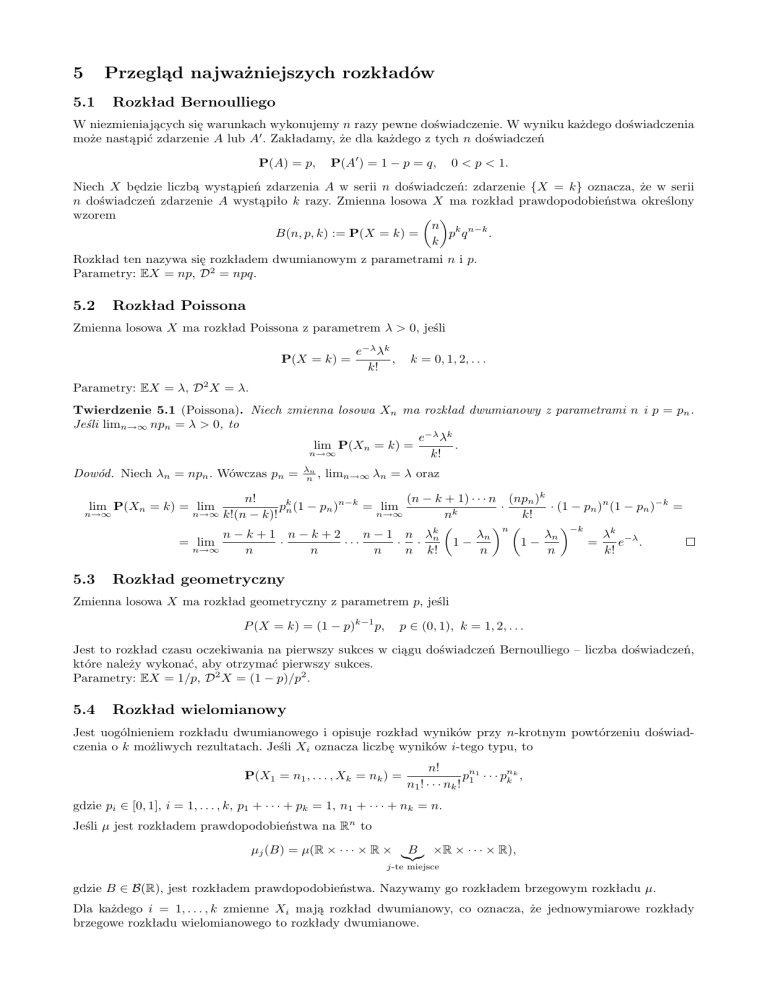

5.1

Rozkład Bernoulliego

W niezmieniających się warunkach wykonujemy n razy pewne doświadczenie. W wyniku każdego doświadczenia

może nastąpić zdarzenie A lub A0 . Zakładamy, że dla każdego z tych n doświadczeń

P(A) = p,

P(A0 ) = 1 − p = q,

0 < p < 1.

Niech X będzie liczbą wystąpień zdarzenia A w serii n doświadczeń: zdarzenie {X = k} oznacza, że w serii

n doświadczeń zdarzenie A wystąpiło k razy. Zmienna losowa X ma rozkład prawdopodobieństwa określony

wzorem

n k n−k

B(n, p, k) := P(X = k) =

p q

.

k

Rozkład ten nazywa się rozkładem dwumianowym z parametrami n i p.

Parametry: EX = np, D2 = npq.

5.2

Rozkład Poissona

Zmienna losowa X ma rozkład Poissona z parametrem λ > 0, jeśli

P(X = k) =

e−λ λk

,

k!

k = 0, 1, 2, . . .

Parametry: EX = λ, D2 X = λ.

Twierdzenie 5.1 (Poissona). Niech zmienna losowa Xn ma rozkład dwumianowy z parametrami n i p = pn .

Jeśli limn→∞ npn = λ > 0, to

e−λ λk

lim P(Xn = k) =

.

n→∞

k!

Dowód. Niech λn = npn . Wówczas pn =

λn

n ,

limn→∞ λn = λ oraz

n!

(n − k + 1) · · · n (npn )k

·

pkn (1 − pn )n−k = lim

· (1 − pn )n (1 − pn )−k =

n→∞ k!(n − k)!

n→∞

nk

k!

n −k

n−k+1 n−k+2

n − 1 n λkn

λn

λn

λk −λ

= lim

·

···

· ·

1−

1−

=

e .

n→∞

n

n

n

n k!

n

n

k!

lim P(Xn = k) = lim

n→∞

5.3

Rozkład geometryczny

Zmienna losowa X ma rozkład geometryczny z parametrem p, jeśli

P (X = k) = (1 − p)k−1 p,

p ∈ (0, 1), k = 1, 2, . . .

Jest to rozkład czasu oczekiwania na pierwszy sukces w ciągu doświadczeń Bernoulliego – liczba doświadczeń,

które należy wykonać, aby otrzymać pierwszy sukces.

Parametry: EX = 1/p, D2 X = (1 − p)/p2 .

5.4

Rozkład wielomianowy

Jest uogólnieniem rozkładu dwumianowego i opisuje rozkład wyników przy n-krotnym powtórzeniu doświadczenia o k możliwych rezultatach. Jeśli Xi oznacza liczbę wyników i-tego typu, to

P(X1 = n1 , . . . , Xk = nk ) =

n!

pn1 · · · pnk k ,

n1 ! · · · nk ! 1

gdzie pi ∈ [0, 1], i = 1, . . . , k, p1 + · · · + pk = 1, n1 + · · · + nk = n.

Jeśli µ jest rozkładem prawdopodobieństwa na Rn to

µj (B) = µ(R × · · · × R × |{z}

B ×R × · · · × R),

j-te miejsce

gdzie B ∈ B(R), jest rozkładem prawdopodobieństwa. Nazywamy go rozkładem brzegowym rozkładu µ.

Dla każdego i = 1, . . . , k zmienne Xi mają rozkład dwumianowy, co oznacza, że jednowymiarowe rozkłady

brzegowe rozkładu wielomianowego to rozkłady dwumianowe.

5.5

Rozkład jednostajny

Niech A ⊆ Rn będzie zbiorem o dodatniej i skończonej mierze Lebesgue’a λ. Rozkład o gęstości

g(x) =

1

1A (x),

λ(A)

x ∈ Rn ,

nazywamy rozkładem jednostajnym na zbiorze A. Najczęściej spotykamy się z sytuacją jednowymiarową, gdy

A jest przedziałem [a, b], a wówczas jego gęstość ma postać

g(x) =

1

1[a,b] (x),

b−a

x ∈ R,

a dystrybuanta

0,

t − a

F (t) =

,

b−a

1,

t < a,

a ¬ t < b,

b ¬ t.

Rozkład ten oznacza się często U[a, b].

a+b

(b − a)2

Parametry: EX =

, D2 X =

.

2

12

5.6

Rozkład wykładniczy

Rozkład wykładniczy z parametrem λ ma gęstość

g(x) = λe−λx 1(0,∞) (x).

Dystrybuanta tego rozkładu to:

F (t) = (1 − e−λt )1(0,∞) (t).

Rozkład geometryczny i rozkład wykładniczy mają własność braku pamięci, to znaczy jeśli X jest zmienną

losową o jednym z tych rozkładów, to:

P(X > t + s|X > t) = P(X > s)

gdzie t, s > 0 oraz dodatkowo t, s ∈ N dla rozkładu geometrycznego.

Parametry: EX = 1/λ, D2 X = 1/λ2 .

5.7

Rozkład gamma

Rozkładem gamma nazywamy rozkład o gęstości

γa,b (x) =

ba a−1 −bx

x

e 1(0,∞) (x),

Γ(a)

a, b > 0.

Jeśli a jest liczbą naturalną, to jest to rozkład sumy a niezależnych

zmiennych losowych o rozkładzie wykładR∞

niczym z parametrem b. (Funkcja Gamma Eulera: Γ(a) = 0 ta−1 e−t dt, a > 0).

Parametry: EX = a/b, D2 X = a/b2 .

5.8

Rozkład beta

Jest to rozkład o gęstości

βa,b (x) =

1

xa−1 (1 − x)b−1 1[0,1] (x),

B(a, b)

a, b > 0,

gdzie funkcja beta

B(a, b) =

Na przykład dla a = b =

1

2

Γ(a)Γ(b)

=

Γ(a + b)

Z

1

ta−1 (1 − t)b−1 dt,

0

otrzymujemy rozkład arcusa sinusa o gęstości:

β1/2,1/2 (x) =

1[0,1] (x)

π

p

x(1 − x)

Parametry: EX = a/(a + b), D2 X = ab/[(a + b)2 (a + b + 1)].

.

a, b > 0.

5.9

Rozkład normalny

Zmienna losowa X ma jednowymiarowy rozkład normalny o średniej µ i wariancji σ 2 , co zapisujemy X ∼

N (µ, σ 2 ), jeżeli ma gęstość

2

2

1

ϕµ,σ (x) = √ e−(x−µ) /2σ , µ ∈ R, σ > 0.

σ 2π

Wektor losowy X = (X1 , X2 , . . . , Xn ) ma wielowymiarowy rozkład normalny, jeśli jego funkcja gęstości dana

jest wzorem:

1

1

exp [− (x − µ)T V−1 (x − µ)],

f (x) =

n/2

1/2

2

(2π) |V|

gdzie µ jest wektorem wartości oczekiwanych, a V symetryczną i dodatnio określoną (nieosobliwą) macierzą

(kowariancji).

Parametry: EX = µ, D2 X = σ 2 .

5.10

Rozkład χ2 .

Niech X = (X1 , X2 , . . . , Xn )0 będzie wektorem niezależnych zmiennych losowych o rozkładach normalnych z

E(Xi ) = 0 oraz D2 (Xi ) = 1, i = 1, . . . , n. Zmienna

Z = X0 X =

n

X

Xi2

i=1

ma rozkład χ2 z n stopniami swobody, co zapisujemy Z ∼ χ2n . Rozkład ten ma gęstość:

f (x) =

1

xn/2−1 e−x/2 1(0,∞) (x).

2n/2 Γ(n/2)

Zauważmy, że jest rozkład Γ(2, n/2). Rozkład ten ma następującą własność: jeśli Z1 ∼ χ2n , Z2 ∼ χ2m oraz Z1 i

Z2 są niezależne, to:

Z1 + Z2 ∼ χ2n+m .

Twierdzenie 5.2. Jeśli A jest macierzą idempotentną (A2 = A) o wymiarach n × n rzędu r, to

X0 AX ∼ χ2r .

Jeśli A1 , A2 są macierzami idempotentnymi oraz A1 A2 = 0, to zmienne X0 A1 X i X0 A2 X są niezależne.

Parametry: EX = n, D2 X = 2n.

5.11

Rozkład t-Studenta.

Jeśli X ∼ N (0, 1) oraz Y ∼ χ2n oraz X i Y są niezależne, to

X

Z=p

Y /n

ma rozkład t z n stopniami swobody, co oznaczamy Z ∼ tn . Rozkład ten ma gęstość:

Γ((n + 1)/2)

f (x) = √

nπΓ(n/2)

x2

1+

n

−(n+1)/2

.

Dla n = 1 rozkład t-Studenta jest rozkładem Cauchy’ego o gęstości

f (x) =

1

.

π(1 + x2 )

Możemy również rozważać bardziej ogólną jego postać z gęstością:

f (x) =

h

.

π(h2 + (x − m)2 )

Dla n → ∞ rozkład t-Studenta zbiega do rozkładu normalnego.

Parametry: przy n stopniach swobody istnieją momenty rzędu mniejszego niż n.

5.12

Rozkład F-Snedecora.

Jeśli Y1 ∼ χ2n1 , Y2 ∼ χ2n2 oraz Y1 i Y2 są niezależne, to zmienna

F =

Y1 /n1

Y2 /n2

ma rozkład F z n1 i n2 stopniami swobody: Z ∼ Fn1 ,n2 .

6

Parametry rozkładów

Ustalmy przestrzeń probabilistyczną (Ω, F, P).

Definicja 6.1. O zmiennej losowej X mówimy, że jest całkowalna, jeśli skończona jest całka

R

Ω

|X(ω)| dP(ω).

Definicja 6.2. Wartością średnią (oczekiwaną, przeciętną) całkowalnej zmiennej losowej X nazywamy liczbę

Z

E(X) =

X dP.

Ω

Wartością oczekiwaną zmiennej losowej X = (X1 , . . . , Xn ) o wartościach w Rn nazywamy wektor

E(X) = (EX1 , . . . , EXn ),

o ile wszystkie współrzędne mają wartość średnią.

Jeśli zmienna losowa nie jest całkowalna, to nie ma wartości oczekiwanej.

Twierdzenie 6.3. Załóżmy, że wartości oczekiwane EX i EY istnieją. Wtedy

• Jeśli X ­ 0, to EX ­ 0;

• |EX| ¬ E|X|;

• Dla a, b ∈ R istnieje wartość średnia zmiennej aX + bY oraz

E(aX + bY ) = aEX + bEY.

Twierdzenie 6.4. Niech ϕ : Rn → R będzie funkcją borelowską, a X zmienną losową o wartościach w Rn .

Wtedy

Z

Eϕ(X) =

ϕ(x) dµX (x),

Rn

przy czym całkowalność jednej ze stron implikuje całkowalność drugiej i rowność całek.

Wniosek 6.5. Jeśli zmienna losowa P

X ma rozkład dyskretny {(xi , pi )i∈I }, to wartość oczekiwana istnieje wtedy

i tylko wtedy, gdy zbieżny jest szereg i∈I |ϕ(xi )|pi i wyraża się wzorem

Eϕ(X) =

X

ϕ(xi )pi .

i∈I

Wniosek 6.6. Jeśli zmienna losowa X o wartościach w Rn ma rozkład ciągły o gęstości g, a funkcja ϕ : Rn → R

jest borelowska, to

Z

ϕ(x)g(x) dx,

Eϕ(X) =

Rn

przy czym całkowalność jednej ze stron implikuje całkowalność drugiej i równość całek.

Twierdzenie 6.7. Jeśli X jest nieujemną zmienną losową, to zachodzi wzór:

Z ∞

EX =

P(X > s) ds.

0

Definicja 6.8. Jeśli E(X − EX)2 < ∞, to tę liczbę nazywamy wariancją zmiennej losowej X i oznaczamy D2 X.

Twierdzenie 6.9. Jeśli X jest zmienną losową dla której EX 2 < ∞, to istnieje D2 X oraz

• D2 X = E(X 2 ) − E2 X, D2 (cX) = c2 D2 X, D2 (X + a) = D2 X,

• D2 X ­ 0, natomiast D2 X = 0 wtedy i tylko wtedy, gdy X jest stała.

Zauważmy, że jeśli zmienna losowa X ma wartość oczekiwaną µ = EX oraz wariancję σ 2 = D2 X, to zmienna

X − EX

Y =

ma parametry:

σ

EY =

EX − µ

= 0,

σ2

D2 Y =

D2 (X − µ)

D2 X

=

= 1.

2

σ

σ2

Zmienną o takich własnościach nazywamy zmienną losową standaryzowaną, a transformację polegającą na

odjęciu wartości oczekiwanej i podzieleniu przez odchylenie standardowe – standaryzacją.

√

• Pierwiastek z wariancji nazywamy odchyleniem standardowym: σ(X) = D2 X.

• Liczbę mk = E(X k ) nazywamy momentem zwykłym rzędu k zmiennej losowej X.

• Liczbę µk = E(X − m1 )k = E(X − EX)k nazywamy momentem centralnym rzędu k zmiennej losowej X.

• Współczynnik asymetrii: α3 = µ3 /σ 3 .

• Kurtoza (współczynnik spłaszczenia): α4 = (µ4 /σ 4 − 3).

Definicja 6.10. Medianą zmiennej losowej X nazywamy każdą taką liczbę q, która spełnia nierówności

P(X ¬ q) ­

1

2

∧

P(X ­ q) ­

1

,

2

i oznaczamy M e(X).

Zmienna losowa X ma rozkład: P(X = 0) = P(X = 1) = 14 , P(X = 2) =

przedziału [1, 2]. Wartość przeciętna to E(X) = 0 · 14 + 1 · 14 + 2 · 12 = 45 .

1

2.

Medianą jest każdy punkt

Definicja 6.11. Kwantylem rzędu p (0 < p < 1) zmiennej losowej X o dystrybuancie F nazywamy każdą liczbę

qp spełniającą zależności

F (qp −) ¬ p ¬ F (qp ).

Mediana jest kwantylem rzędu 1/2.

Twierdzenie 6.12 (Nierówność Schwartza). Jeśli EX 2 < ∞, EY 2 < ∞, to (E|XY |)2 ¬ E(X 2 ) · E(Y 2 ).

√

√

Dowód. Zauważmy, że 2|ab| ¬ a2 + b2 , weźmy a = X/ EX 2 , b = Y / EY 2 , podstawmy i obłóżmy wartością

oczekiwaną.

Twierdzenie 6.13 (Nierówność Jensena). Niech E|X| < ∞ oraz g będzie taką funkcją wypukłą, że E|g(X)| <

∞. Wówczas g(EX) ¬ Eg(X).

Definicja 6.14. Kowariancją zmiennych losowych X i Y , posiadających wariancję, nazywamy wielkość

cov(X, Y ) = E(X − EX)(Y − EY ).

Mamy cov(X, Y ) = E(XY − Y EX − XEY + EXEY ) = E(XY ) − E(Y )E(X) − E(X)E(Y ) + E(X)E(Y ) =

E(XY )−E(X)E(Y ). Jeśli cov(X, Y ) = 0, to zmienne losowe nazywamy nieskorelowanymi. Na mocy nierówności

Schwartza mamy

p

| cov(X, Y )| ¬ D2 (X)D2 (Y ),

przy czym równość zachodzi, gdy zmienne losowe X i Y są związane deterministyczną zależnością linową, tzn.

aX + bY = c, gdzie a2 + b2 > 0. Wynika stąd, że współczynnik korelacji zdefiniowany jako

ρ(X, Y ) = p

cov(X, Y )

D2 (X)D2 (Y )

ma własność |ρ(X, Y )| ¬ 1 oraz |ρ(X, Y )| = 1 tylko dla zmiennych liniowo zależnych.

Twierdzenie 6.15. Jeśli zmienne losowe X1 , . . . , Xn mają wariancję, to istnieje wariancja sumy i

D2 (X1 + · · · + Xn ) =

n

X

i=1

D2 Xi + 2

X

1¬i<j¬n

cov(Xi , Xj ).

Dowód.

D2 (X1 + · · · + Xn ) = E(X1 + · · · + Xn )2 − (EX1 + · · · + EXn )2

n

n

X

X

X

= E

Xi2 + 2

Xi Xj − (EXi )2 + 2

i=1

=

n

X

n

X

i=1

X

EXi2 − (EXi )2 + 2

i=1

=

i=1

1¬i<j¬n

X

EXi EXj

1¬i<j¬n

(E(Xi Xj ) − EXi EXj )

1¬i<j¬n

X

D2 Xi + 2

cov(Xi , Xj ).

1¬i<j¬n

Wniosek 6.16. Jeśli zmienne losowe X1 , . . . , Xn mają wariancję i są parami nieskorelowane, to

D2 (X1 + · · · + Xn ) =

n

X

D2 Xi .

i=1

2

Definicja 6.17. Jeśli D Xi istnieje dla każdego i = 1, . . . , n, to macierz QX = [cov(Xi , Xj )]ni,j=1 nazywamy

macierzą kowariancji wektora losowego X = (X1 , . . . , Xn ).

Macierz kowariacji jest symetryczna oraz nieujemnie określona: dla dowolnego x ∈ Rn mamy

n

X

xT Qx =

xi xj cov(Xi , Xj ) ­ 0.

i,j=1

Jeśli rząd rank(Q) = k < n, to wektor X przyjmuje wartości w pewnej k-wymiarowej podprzestrzeni.

Twierdzenie 6.18 (Nierówność Czebyszewa). Niech X będzie nieujemną zmienną losową. Wtedy dla dowolnego

ε>0

EX

.

P(X ­ ε) ¬

ε

R

R

Dowód. EX = Ω X dP ­ {X­ε} X dP ­ εP(X ­ ε).

Twierdzenie 6.19 (Uogólniona nierówność Czebyszewa). Niech g będzie nieujemną funkcją niemalejącą. Wtedy

dla dowolnego ε > 0

Eg(X)

.

P(|X| ­ ε) ¬

g(ε)

R

Dowód. Eg(X) ­ {|X|­ε} g(X) dP ­ g(ε)P(|X| ­ ε).

Wniosek 6.20 (Nierówność Markowa). Dla p > 0 i dowolnego ε > 0

P(|X| ­ ε) ¬

E|X|p

.

εp

Wniosek 6.21 (Nierówność Czebyszewa-Bienaymé). Jeśli zmienna losowa X ma skończoną wariancję, to dla

dowolnego ε > 0

D2 X

P(|X − EX| ­ ε) ¬ 2 .

ε

7

Niezależność zmiennych losowych

Ustalmy przestrzeń probabilistyczną (Ω, F, P).

Definicja 7.1. Zmienne losowe X1 , X2 , . . . , Xn o wartościach w R, określone na przestrzeni (Ω, F, P) nazywamy

niezależnymi, gdy dla każdego ciągu zbiorów borelowskich B1 , B2 , . . . , Bn zachodzi równość

P(X1 ∈ B1 , X2 ∈ B2 , . . . , Xn ∈ Bn ) = P(X1 ∈ B1 )P(X2 ∈ B2 ) · · · P(Xn ∈ Bn ).

Inaczej można wypowiedzieć powyższą równość w języku rozkładów zmiennych Xi :

µ(X1 ,X2 ,...,Xn ) (B1 × B2 × · · · × Bn ) = µX1 (B1 )µX2 (B2 ) · · · µXn (Bn ),

co oznacza, że dla zmiennych niezależnych rozkład łączny jest wyznaczony przez rozkłady brzegowe. Jeszcze

inaczej możemy powiedzieć, że zmienne są niezależne, jeśli niezależne są σ-ciała generowane przez te zmienne.

Oczywiste jest ponadto następujące twierdzenie.

Twierdzenie 7.2. Zmienne losowe X1 , X2 , . . . , Xn są niezależne wtedy i tylko wtedy, gdy dla wszystkich

t1 , t2 , . . . , tn ∈ R

F(X1 ,...,Xn ) (t1 , . . . , tn ) = FX1 (t1 ) · · · FXn (tn ).

Przykład 7.3. Niech X1 , . . . , Xn będą niezależnymi zmiennymi losowymi. Znaleźć rozkład zmiennych Y =

max(X1 , . . . , Xn ), Z = min(X1 , . . . , Xn ). Mamy

FY (t) = P(Y ¬ t) = P(max(X1 , . . . , Xn ) ¬ t) = P(X1 ¬ t, . . . , Xn ¬ t) = F1 (t) · · · Fn (t),

FZ (t) = P(Z ¬ t) = 1 − P(Z > t) = 1 − P(min(X1 , . . . , Xn ) > t) = 1 − P(X1 > t, . . . , Xn > t) =

= 1 − P(X1 > t)P(X2 > t) · · · P(Xn > t) = 1 − (1 − F1 (t)) · · · (1 − Fn (t)).

Twierdzenie 7.4. Zmienne losowe X1 , . . . , Xn o rozkładach dyskretnych są niezależne wtedy i tylko wtedy, gdy

dla każdego ciągu x1 , . . . , xn , gdzie xi jest punktem skokowym zmiennej Xi , i = 1, . . . , n,

P(X1 = x1 , . . . , Xn = xn ) = P(X1 = x1 ) · · · P(Xn = xn ).

Twierdzenie 7.5. Zmienne losowe X1 , . . . , Xn o rozkładach ciągłych z gęstościami g1 , . . . , gn , są niezależne

wtedy i tylko wtedy, gdy wektor (X1 , . . . , Xn ) ma rozkład ciągły z gęstością

g(x1 , . . . , xn ) = g1 (x1 ) · · · gn (xn ).

Definicja 7.6. Zmienne losowe (Xi )i∈I określone na tej samej przestrzeni nazywamy niezależnymi, gdy dla

każdego skończonego podzbioru J ⊆ I zmienne (Xi )i∈J są niezależne.

Twierdzenie 7.7. Załóżmy, że zmienne losowe X1,1 , X1,2 , . . . , X1,k1 , X2,1 , . . . , X2,k2 , . . . , Xn,1 , . . . , Xn,kn są

niezależne. Wówczas zmienne losowe

Yj = ϕj (Xj,1 , . . . , Xj,kj ), j = 1, 2, . . . , n,

gdzie ϕj są takimi funkcjami borelowskimi, że zmienne Yj są dobrze zdefiniowane, są niezależne.

Twierdzenie 7.8. Niech X1 , . . . , Xn będą zmiennymi losowymi, które maja wartość oczekiwaną. Wtedy istnieje

wartość oczekiwana iloczynu X1 X2 · · · Xn oraz

E(X1 X2 · · · Xn ) = E(X1 )E(X2 ) · · · E(Xn ).

Uwaga 7.9.

1. Powyższe twierdzenie nie jest prawdziwe dla ciągów nieskończonych.

2. Z powyższego twierdzenia wynika, że jeśli zmienne X1 i X2 są niezależne, to są również nieskorelowane:

cov(X1 , X2 ) = E(X1 X2 ) − E(X1 )E(X2 ) = E(X1 )E(X2 ) − E(X1 )E(X2 ) = 0.

Niech X, Y będą niezależnymi zmiennymi losowymi oraz B ∈ B(R). Wówczas

µX+Y (B) = P(X + Y ∈ B) = P((X, Y ) ∈ {(x, y) ∈ R2 : x + y ∈ B})

Z

Z

=

1{x+y∈B} (x, y)µ(X,Y ) (dx, dy) =

1{x+y∈B} (x, y)µX (dx)µY (dy)

R2

R2

Z

Z ∞

Z ∞

∞

=

1B−y (x)µX (dx) µY (dy) =

µX (B − y)µY (dy) = (µX ∗ µY )(B).

−∞

−∞

−∞

Miarę µX ∗ µY nazywamy splotem rozkładów µX i µY . Jeśli rozkłady te mają gęstości gX i gY odpowiednio, to

zmienna X + Y ma gęstość

Z ∞

(gX ∗ gY )(u) =

gX (u − y)gY (y) dy,

−∞

nazywaną splotem gęstości gX i gY . Uwaga: ponieważ X+Y = Y +X, to µX ∗µY = µY ∗µX oraz gX ∗gY = gY ∗gX .

8

Zbieżność zmiennych losowych. Twierdzenia graniczne

Ustalmy przestrzeń probabilistyczną (Ω, F, P).

Definicja 8.1. Ciąg zmiennych losowych X1 , X2 , . . . jest zbieżny do zmiennej losowej X z prawdopodobieństwem 1 (prawie na pewno, prawie wszędzie), jeśli

P {ω : lim Xn (ω) = X(ω)} = 1.

n→∞

Definicja 8.2. Ciąg zmiennych losowych X1 , X2 , . . . jest zbieżny do zmiennej losowej X według prawdopodobieństwa (stochastycznie, według miary), jeśli dla każdego ε > 0

lim P ({ω : |Xn (ω) = X(ω)| < ε}) = 1.

n→∞

(lub równoważnie limn→∞ P ({ω : |Xn (ω) = X(ω)| ­ ε}) = 0).

Definicja 8.3. Ciąg zmiennych losowych X1 , X2 , . . . jest zbieżny do zmiennej losowej X średniokwadratowo

(w L2 ), jeśli

lim E(|Xn − X|2 ) = 0.

n→∞

Definicja 8.4. Mówimy, że ciąg dystrybuant F1 , F2 , . . . jest słabo zbieżny do dystrybuanty F , jeśli

limn→∞ Fn (x) = F (x) dla każdego x będącego punktem ciągłości dystrybuanty F . Jeśli ciąg dystrybuant (Fn )

zmiennych losowych (Xn ) jest zbieżny słabo do dystrybuanty F zmiennej losowej X, to mówimy, że ciąg (Xn )

zbiega według dystrybuant (słabo, w sensie słabym) do zmiennej losowej X.

Przykład 8.5. Rozważmy przestrzeń Ω = [0, 1) z rozkładem jednostajnym. Przyjmujemy

(

1, ω ∈ [ nk , k+1

n ),

k = 0, . . . , n − 1, n = 1, 2, . . .

Xkn =

0, ω 6∈ [ nk , k+1

n ),

Zmienne losowe Xkn mają rozkłady dwupunktowe

n−1

,

n

P(Xkn = 0) =

P(Xkn = 1) =

1

,

n

a stąd dla dowolnego ε > 0

1

= 0,

n

zatem ciąg X01 , X02 , X12 , X03 , X13 , X23 , . . . jest zbieżny według prawdopodobieństwa do zmiennej losowej stale

równej 0. Jednakże w każdym punkcie ω ∈ [0, 1), dla każdego n ∈ N istnieje takie k, że Xkn (ω) = 1 oraz

Xjn (ω) = 0 dla j 6= k, zatem powyższy ciąg nie jest zbieżny punktowo w żadnym punkcie.

lim P(|Xkn − 0| > ε) = lim

n→∞

n→∞

Uwaga 8.6.

• Jeśli ciąg X1 , X2 , . . . jest zbieżny średniokwadratowo do zmiennej losowej X, to jest także

zbieżny według prawdopodobieństwa do X.

• Jeśli ciąg X1 , X2 , . . . jest zbieżny do z prawdopodobieństwem 1 do zmiennej losowej X, to jest także

zbieżny według prawdopodobieństwa do X.

• Jeśli ciąg X1 , X2 , . . . jest zbieżny według prawdopodobieństwa do zmiennej losowej X, to ciąg dystrybuant

FX1 , FX2 , . . . zmiennych losowych X1 , X2 , . . . jest słabo zbieżny do dystrybuanty FX zmiennej losowej X.

Przykład 8.7. Niech (Xn ) będzie ciągiem

niezależnych zmiennych losowych o wartościach oczekiwanych m

Pn

oraz wariancjach σ 2 . Wówczas ciąg n1 k=1 (Xk − m)2 jest zbieżny średniokwadratowo do 0.

Definicja 8.8. Mówimy, że ciąg całkowalnych zmiennych losowych X1 , X2 , . . . spełnia słabe prawo wielkich

liczb (SPWL), jeśli

!

n

1 X

(Xk − E(Xk )) ­ ε = 0.

∀ε>0 lim P

n→∞

n

k=1

Twierdzenie 8.9 (SPWL Czebyszewa-Markowa).

Jeżeli (Xn ) jest ciągiem zmiennych losowych całkowalnych

Pn

z kwadratem oraz limn→∞ n12 D2 ( k=1 Xk ) = 0, to ciąg ten spełnia SPWL.

Dowód. Dla dowolnego ε > 0 mamy

P

!

n

1 X

(Xk − E(Xk ) ­ ε = P

n

k=1

!

X

Pn

n

D2 ( k=1 Xk )

(Xk − E(Xk ) ­ nε ¬

→ 0.

n2 ε2

k=1

Definicja 8.10. Mówimy, że ciąg zmiennych losowych X1 , X2 , . . . spełnia mocne prawo wielkich liczb (MPWL),

jeśli

n

1X

(Xk − E(Xk )) = 0 p.n.

lim

n→∞ n

k=1

Twierdzenie 8.11 (Kryterium Kołomogorowa). Niech (Xn )n∈N będzie ciągiem niezależnych zmiennych losoP∞

2

n

wych całkowalnych z kwadratem. Jeżeli n=1 DnX

< ∞, to ciąg (Xn ) spełnia MPWL.

2

Twierdzenie 8.12 (MPWL Kołomogorowa). Niech (Xn )n∈N będzie ciągiem niezależnych zmiennych losowych

o tym samym rozkładzie. Jeżeli E|X1 | < ∞, to ciąg (Xn ) spełnia MPWL, w szczególności

n

1X

Xk = EX1 p.n.

n→∞ n

lim

k=1

Twierdzenie 8.13 (Centralne Twierdzenie Graniczne Lindeberga-Levy’ego). Jeśli (Xn )n∈N jest ciągiem niezależnych zmiennych losowych o jednakowym rozkładzie całkowalnych z kwadratem, to

Pn

Z x

1 2

1

k=1 Xk − nEX1

√

e− 2 t dt.

lim P

¬

x

=

n→∞

2π −∞

nD2 X1

Inaczej mówiąc, jeśli przyjmiemy

Pn

Yn =

Xk − nEX1

√

,

nD2 X1

k=1

to ciąg dystrybuant (FYn ) zmiennych losowych (Yn ) jest zbieżny słabo do dystrybuanty rozkładu normalnego

standardowego.

Wniosek 8.14 (Twierdzenie Moivre’a-Laplace’a). Niech (Xn )n∈N będą próbami Bernoulliego z prawdopodobieństwem sukcesu p. Wtedy

Pn

Z x

1 2

1

k=1 Xk − np

e− 2 t dt.

¬x =

lim P

√

n→∞

npq

2π −∞

Twierdzenie 8.15 (CTG Lapunowa). Niech (Xn )n∈N będzie ciągiem niezależnych zmiennych losowych i niech

mn = E(Xn ),

σn2 = D2 (Xn ),

bn = E(|Xn − mn |3 ),

p

√

1 X

(Xk − mk ),

Fn (u) = P(Un < u).

B n = 3 b1 + · · · + bn ,

Un =

C n = σ1 + · · · + σn ,

Cn

k=1

Jeśli limn→∞

Bn

Cn

= 0, to dla każdego u

lim Fn (u) =

n→∞

1

2π

Z

u

−∞

1 2

e− 2 t dt.