Rachunek prawdopodobieństwa MAP1151

Wydział Elektroniki, rok akad. 2011/12, sem. letni

Wykładowca: dr hab. A. Jurlewicz

Wykład 7: Zmienne losowe dwuwymiarowe. Rozkłady łączne, brzegowe. Niezależność zmiennych losowych. Momenty. Współczynnik korelacji. Sumowanie niezależnych zmiennych losowych. Prawo wielkich liczb.

Zmienne losowe dwuwymiarowe, rozkład łączny, rozkłady

brzegowe.

Definicja.

Zmienna losowa dwuwymiarowa to wektor (X, Y ), którego składowe X, Y są

zmiennymi losowymi.

Rozkład wektora losowego (X, Y ) to funkcja P ((X, Y ) ∈ C), gdzie C to borelowski podzbiór płaszczyzny R2 . Nazywamy go rozkładem łącznym zmiennych

losowych X, Y .

Rozkład zmiennej losowej X i rozkład zmiennej losowej Y nazywamy rozkładami

brzegowymi wektora losowego (X, Y ).

Pełna informacja o rozkładzie łącznym zmiennych losowych X, Y zawarta jest:

(a) w dystrybuancie tego rozkładu, czyli funkcji

FX,Y (x, y) = P (X < x, Y < y)

(b) w przypadku dyskretnego wektora losowego (X, Y ) zawarta jest także w ciągu

trójek {(xn , yk , pnk ), n ∈ T1 ⊂ N, k ∈ T2 ⊂ N}, gdzie {xn , n ∈ T1 } oraz {yk , k ∈ T2 }

to ciągi wszystkich wartości przyjmowanych odpowiednio przez X i Y z dodatnimi

prawdopodobieństwami, natomiast pnk = P (X = xn , Y = yk ), n ∈ T1 , k ∈ T2 .

(Ciągi {xn , n ∈ T1 } oraz {yk , k ∈ T2 } muszą być różnowartościowe, natomiast

P P

pnk ­ 0 dla wszystkich n, k oraz

pnk = 1, aby rozkład był dobrze określony.)

n∈T1 k∈T2

(c) w przypadku ciągłego rozkładu wektora losowego (X, Y ) zawarta jest także w

gęstości łącznej f (x, y), czyli takiej funkcji f (x, y) ­ 0 dla każdego (x, y), że

Zx

FX,Y (x, y) =

−∞

ds

Zy

f (s, t)dt

−∞

(Aby funkcja f (x, y) była gęstością pewnego rozkładu prawdopodobieństwa musi

spełniać warunki: f (x, y) ­ 0 dla każdego (x, y) oraz

Z∞

−∞

1

dx

Z∞

−∞

f (x, y)dy = 1.)

Fakt: Jeśli znamy rozkład łączny, to znamy też rozkłady brzegowe, gdyż:

FX (x) = P (X < x) = P (X < x, Y < ∞) =

lim FX,Y (x, y),

y→∞

FY (y) = P (Y < y) = P (X < ∞, Y < y) =

lim FX,Y (x, y)

x→∞

W przypadku dyskretnego wektora losowego (X, Y ) zadanego ciagiem

{(xn , yk , pnk ), n ∈ T1 , k ∈ T2 }:

rozkład zmiennej losowej X zadany jest ciągiem {(xn , pn· ), n ∈ T1 }, gdzie

P

P

pn· = P (X = xn ) =

P (X = xn , Y = yk ) =

pnk

k∈T2

k∈T2

Podobnie, rozkład zmiennej losowej Y zadany jest ciągiem {(yk , p·k ), k ∈ T2 },

P

P

gdzie p·k = P (Y = yk ) =

P (X = xn , Y = yk ) =

pnk

n∈T1

n∈T1

W przypadku wektora o rozkładzie ciągłym o gęstości łącznej f (x, y)

można pokazać, że:

rozkład zmiennej losowej X jest ciągły o gęstości fX (x) =

Z∞

f (x, y)dy,

−∞

rozkład zmiennej losowej Y jest ciągły o gęstości fY (y) =

Z∞

f (x, y)dx.

−∞

Niezależność zmiennych losowych

Definicja.

Zmienne losowe X i Y są niezależne, gdy dla dowolnych borelowskich zbiorów B1 i B2

zdarzenia {X ∈ B1 } i {Y ∈ B2 } są niezależne,

tzn. P (X ∈ B1 , Y ∈ B2 ) = P (X ∈ B1 )P (Y ∈ B2 ).

Zmienne losowe X1 , X2 , . . . , Xn są niezależne, gdy dla dowolnych borelowskich zbiorów

B1 , B2 , . . . , Bn rodzina {{Xi ∈ Bi }, i = 1, 2, . . . , n} jest rodziną zdarzeń niezależnych.

Fakt.

Zmienne losowe X i Y są niezależne wtedy i tylko wtedy, gdy dla każdego (x, y)

FX,Y (x, y) = FX (x)FY (y).

W przypadku rozkładu dyskretnego warunek ten jest równoważny warunkowi

pnk = pn· p·k

dla każdego (n, k) z odpowiedniego zakresu.

W przypadku rozkładu ciągłego warunkiem równoważnym jest

f (x, y) = fX (x)fY (y)

dla prawie wszystkich (x, y) (tzn. równość może nie zachodzić na zbiorze o polu 0).

Przykłady do zad. 5.1, 5.2

2

Wartość oczekiwana i macierz kowariancji zmiennej losowej dwuwymiarowej. Współczynnik korelacji.

Definicja.

(EX, EY ) to wektor wartości oczekiwanych zmiennej losowej dwuwymiarowej (X, Y ).

Cov(X, Y ) = EXY − EXEY - współczynnik kowariancji zmiennych X i Y

"

D2 X

Cov(X, Y )

Cov(X, Y )

D2 Y

#

to macierz kowariancji zmiennej losowej dwuwymiarowej (X, Y )

Parametry te są dobrze określone, o ile istnieją wartości oczekiwane i wariancje zmiennych

losowych X i Y

Fakt.

Dla dowolnej funkcji borelowskiej

EZ = Eg(X, Y ) =

Z∞ Z∞

g(x, y)dFX,Y (x, y) =

−∞ −∞

P P

g(xn , yk )pnk ,

n∈T1 k∈T2

=

R∞ R∞

gdy X ma rozkład dyskretny

zadany ciągiem {(xn , yk , pnk ), n ∈ T1 , k ∈ T2 };

g(x, y)f (x, y)dxdy, gdy X ma rozkład ciągły o gęstości f (x, y).

−∞ −∞

o ile całka (szereg) zbieżne.

Stąd jeśli istnieją EX i EY , to

E(X + Y ) = EX + EY

oraz jeśli istnieją D2 X i D2 Y , to

D2 (X + Y ) = D2 X + D2 Y + 2Cov(X, Y ).

Definicja.

Przy założeniu, że istnieją D2 X > 0 i D2 Y > 0, określamy współczynnik korelacji

zmiennych losowych X i Y jako:

Cov(X, Y )

ρXY = √

.

D2 X · D2 Y

Własności współczynnika korelacji:

• |ρXY | ¬ 1.

• |ρXY | = 1 wtedy i tylko wtedy, gdy Y = aX + b dla pewnych stałych a 6= 0, b, przy

czym ρXY = 1 odpowiada a > 0, a ρXY = −1 odpowiada a < 0 (pełna liniowa

zależność Y od X).

• Gdy ρXY = 0, mówimy, że X i Y są nieskorelowane.

Przykłady do zad. 5.3

3

Fakt.

Jeżeli zmienne losowe X i Y są niezależne oraz ich wartości oczekiwane i wariancje istnieją,

przy czym wariancje są niezerowe, to

EXY = EXEY

a stąd

D2 (X + Y ) = D2 X + D2 Y

oraz ρXY = 0.

Zatem jeśli zmienne losowe o skończonych i niezerowych wariancjach są niezależne, to są

też nieskorelowane. Implikacja odwrotna nie jest prawdziwa.

Przykłady do zad. 5.4

Suma niezależnych zmiennych losowych.

X i Y to niezależne zmienne losowe odpowiednio o dystrybuantach FX (x) i FY (y).

Wówczas Z = X + Y ma rozkład o dystrybuancie

FX+Y (z) =

Z∞

FX (z − y)dFY (y).

−∞

Jest to tzw. splot dystrybuant (miar).

Jeśli X i Y mają rozkłady ciągłe o gęstościach odpowiednio fX (x) i fY (y),

to Z = X + Y też ma rozkład ciągły o gęstości

fX+Y (z) =

Z∞

fX (z − y)fY (y)dy = (fX ∗ fY )(z).

−∞

Jest to znany nam splot gęstości.

4

Zbieżności ciągu zmiennych losowych z prawdopodobieństwem 1 i stochastyczna.

Definicja.

Ciąg zmiennych losowych X1 , X2 , . . . jest zbieżny z prawdopodobieństwem 1

(in. prawie na pewno) do zmiennej losowej X, jeżeli

P (ω : n→∞

lim Xn (ω) = X(ω)) = 1.

z pr.1

p.n.

−→

Oznaczenie: Xn −→

n→∞ X, Xn n→∞ X, lim Xn = X z prawd. 1.

n→∞

Uwaga:

Ciąg zbieżny punktowo jest zbieżny z prawdopodobieństwem 1.

(Ciąg X1 , X2 , . . . jest zbieżny punktowo do X, jeżeli

lim Xn (ω) = X(ω) dla każdego ω ∈ Ω.)

n→∞

Zbieżność stochastyczna:

Definicja.

Ciąg zmiennych losowych X1 , X2 , . . . jest zbieżny stochastycznie

(in. według prawdopodobieństwa) do zmiennej losowej X, jeżeli

^

P (|Xn − X| ­ ) −→

n→∞ 0.

>0

P

Oznaczenie: Xn −→

n→∞ X, P − lim Xn = X.

n→∞

Fakt.

z pr.1

P

−→

(a) Jeżeli Xn −→

n→∞ X, to Xn n→∞ X.

z pr.1

P

−→

(b) Jeżeli Xn −→

n→∞ X, to istnieje podciąg (Xkn ) ciagu (Xn ), taki że Xkn n→∞ X.

5

Prawa wielkich liczb (PWL)

Definicja.

Niech X1 , X2 , . . . będzie ciągiem zmiennych losowych o skończonych wartościach oczekiwanych EXn = mn . Niech Sn = X1 + X2 + . . . + Xn , an = m1 + m2 + . . . + mn .

Mówimy, że ciąg (Xn ) spełnia słabe prawo wielkich liczb (SPWL), gdy

n

S n − an

1X

P

=

(Xk − mk ) −→

n→∞ 0.

n

n k=1

Mówimy, że ciąg ten spełnia mocne prawo wielkich liczb (MPWL), gdy

Sn − an z pr.1

−→

n→∞ 0.

n

Oczywiście MPWL =⇒ SPWL.

PWL dla ciągów zmiennych losowych o jednakowym

rozkładzie

Twierdzenie Chinczyna.

Niech (Xn ) będzie ciągiem niezależnych zmiennych losowych o jednakowym rozkładzie,

przy czym E|Xn | < ∞. Wtedy ciąg ten spełnia SPWL, które w tym przypadku można

zapisać w postaci

n

1X

Sn

P

=

Xk −→

n→∞ m = EX1 .

n

n k=1

MPWL Kołmogorowa.

Niech (Xn ) będzie ciągiem niezależnych zmiennych losowych o jednakowym rozkładzie.

Ciąg ten spełnia MPWL, które w tym przypadku można zapisać w postaci

n

z pr.1

Sn

1X

=

Xk −→

n→∞ m = EX1 .

n

n k=1

wtedy i tylko wtedy, gdy E|Xn | < ∞.

6

Szczególny przypadek:

Jeżeli (Xn ) to ciąg niezależnych zmiennych losowych o jednakowym rozkładzie zerojedynkowym B(1, p), tzn. P (Xn = 1) = p = 1 − P (Xn = 0), to Sn ma rozkład Bernoulliego

B(n, p), taki jak rozkład ilości sukcesów w n próbach Bernoulliego z prawdopodobieństwem sukcesu p, a m = EX1 = p.

Prawo wielkich liczb Bernoulliego, twierdzenie Borela:

Niech Sn będzie liczbą sukcesów w n próbach Bernoulliego z prawdopodobieństwem sukcesu p. Wtedy zachodzi

• PWL Bernoulliego (XVII/XVIII w.) (SPWL)

Sn P

−→ p.

n n→∞

• twierdzenie Borela (pocz. XX w.) (MPWL)

Sn z pr.1

−→ p.

n n→∞

Interpretacja:

Częstość występowania sukcesu w n próbach Bernoulliego przybliża przy dużym n prawdopodobieństwo p sukcesu w pojedynczej próbie. Odpowiada to obserwacjom z natury, że

częstość zdarzenia losowego stabilizuje się na pewnym poziomie.

Przykłady do zad. 5.5

7

Przykłady zastosowań PWL

Metoda Monte Carlo obliczania całek oznaczonych:

Niech X1 , X2 , . . . Xn będzie ciągiem niezależnych zmiennych losowych o jednakowym rozkładzie jednostajnym na przedziale [a, b] oraz niech f będzie funkcją rzeczywistą taką, że

Ef (X1 ) istnieje i jest skończona.

Przy powyższych założeniach f (X1 ), f (X2 ), . . . f (Xn ) jest także ciągiem niezależnych zmiennych losowych o jednakowym rozkładzie, przy czym istnieje wartość oczekiwana Ef (X1 ).

b

1 Z

f (x)dx. Z MPWL Kołmogorowa mamy

Ponadto Ef (X1 ) =

b−a a

b

n

z pr.1

1 Z

1X

−→

f (Xk ) n→∞ Ef (X1 ) =

f (x)dx.

n k=1

b−a a

Możemy zatem do obliczania przybliżonej wartości całki oznaczonej

Rb

f (x)dx zastosować

a

następujący algorytm:

(i) losujemy niezależnie liczby u1 , u2 , . . . , un z rozkładu jednostajnego U[0, 1];

(ii) przekształcamy xk = a + (b − a)uk dla k = 1, 2, . . . , n otrzymując w ten sposób

próbkę z rozkładu U(a, b);

(iii) jako przybliżoną wartość całki przyjmujemy

Rb

f (x)dx ≈

a

n

b−a X

f (xk ).

n k=1

Przykładowy program w Matlabie

function calkowanieMonteCarlo

N=10000; %N - ilość prób Monte Carlo

%(im wieksze N, tym wynik przyblizony blizszy rzeczywistej wartosci calki)

a=-1; %a - poczatek przedzialu calkowania

b=1; %b - koniec przedzialu calkowania

%generujemy x1 , x2 , ..., xN z rozkładu jednostajnego na przedziale (a, b)

x=a+(b-a)*rand(1,N);

√

%liczymy wartości funkcji podcałkowej f (x1 ), f (x2 ), . . . , f (xN ), gdzie f (x) = 1 − x2

f=sqrt(1-x.ˆ2);

Pn

%obliczamy przybliżoną wartość całki ze wzoru b−a

k=1 f (xk )

n

calka=(b-a)/N*sum(f)

Uwaga:

Rb

a

f (x)dx =

R1

−1

√

1 − x2 dx =

π

2

≈ 1, 5707963267

Kilka otrzymanych wyników przybliżonych: 1,5725; 1,5680; 1,5736; 1,5729.

8

Dystrybuanta empiryczna:

Rozważmy ciąg X1 , X2 , . . . Xn niezależnych zmiennych losowych o jednakowym rozkładzie

opisanym dystrybuantą F (x). Ciąg ten interpretujemy jako opis wyników n niezależnych

pomiarów pewnej wielkości fizycznej X, dokonywanych w tych samych warunkach fizycznych. Wartości x1 , x2 , . . . xn zmiennych losowych w tym ciągu to wyniki konkretnych takich pomiarów. Ciąg X1 , X2 , . . . Xn nazywamy próbą prostą.

Niech Sn (x; X1 , X2 , . . . Xn ) oznacza ilość elementów próby prostej, których wartość jest

mniejsza niż x.

Sn (x; X1 , X2 , . . . Xn )

(albo Fn (x; x1 , x2 , . . . xn )) nazywamy dysFn (x; X1 , X2 , . . . Xn ) =

n

trybuantą empiryczną.

Zauważmy, że Sn (x; X1 , X2 , . . . Xn ) oznacza ilość tych Xi , których wartość jest mniejsza

niż x. Jest to zatem ilość sukcesów w n próbach Bernoulliego, gdzie sukces w itej próbie

to zdarzenie {Xi < x} i p = P (Xi < x) = F (x) niezależnie od i.

Zatem Sn (x; X1 , X2 , . . . Xn ) ma rozkład Bernoulliego B(n, p = F (x)).

Z tw. Borela otrzymujemy, że

Fn (x; X1 , X2 , . . . Xn ) =

Sn (x; X1 , X2 , . . . Xn ) z pr.1

−→

n→∞ p = F (x).

n

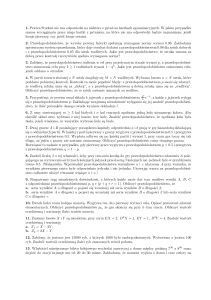

Inaczej mówiąc, dla dużych n, dla prawie każdej wartości (x1 , x2 , . . . xn ) wektora losowego

(X1 , X2 , . . . Xn ) mamy Fn (x; x1 , x2 , . . . xn ) ≈ F (x), czyli dystrybuanta empiryczna jest w

przybliżeniu równa dystrybuancie teoretycznej F .

1

n=10

0

0

2

4

6

8

1

Przykład:

Niebieski wykres:

F (x) = 1 − e−x dla x > 0,

czerwony wykres:

realizacja dystrybuanty empirycznej.

n=100

0

0

2

4

6

8

1

n=1000

0

0

9

2

4

6

8