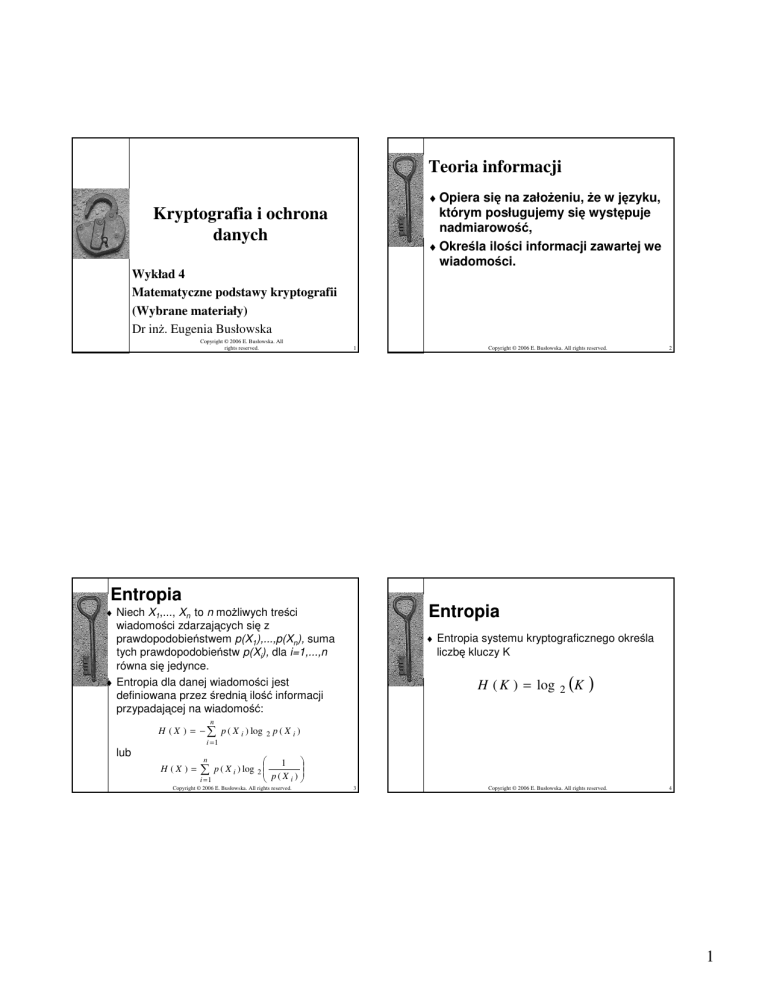

Teoria informacji

♦ Opiera si na zało eniu, e w j zyku,

Kryptografia i ochrona

danych

którym posługujemy si wyst puje

nadmiarowo ,

♦ Okre la ilo ci informacji zawartej we

wiadomo ci.

Wykład 4

Matematyczne podstawy kryptografii

(Wybrane materiały)

Dr in . Eugenia Busłowska

Copyright © 2006 E. Busłowska. All

rights reserved.

1

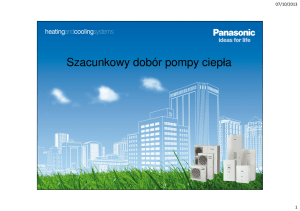

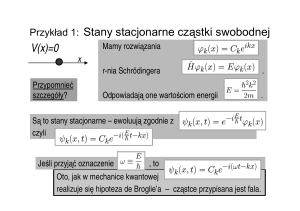

Entropia

wiadomo ci zdarzaj cych si z

prawdopodobie stwem p(X1),...,p(Xn), suma

tych prawdopodobie stw p(Xi), dla i=1,...,n

równa si jedynce.

♦ Entropia dla danej wiadomo ci jest

definiowana przez redni ilo informacji

przypadaj cej na wiadomo :

n

i =1

lub

H (X ) =

n

i =1

p ( X i ) log

p ( X i ) log

2

2

2

Entropia

♦ Niech X1,..., Xn to n mo liwych tre ci

H (X ) = −

Copyright © 2006 E. Busłowska. All rights reserved.

♦ Entropia systemu kryptograficznego okre la

liczb kluczy K

H ( K ) = log

2

(K )

p(X i)

1

p(X i )

Copyright © 2006 E. Busłowska. All rights reserved.

3

Copyright © 2006 E. Busłowska. All rights reserved.

4

1

Teoria informacji

Teoria informacji

♦ Ogólnie dla danego j zyka, bior c pod uwag zbiór

♦ Nadmiarowo

♦

♦

♦

♦

♦

wszystkich wiadomo ci o długo ci N znaków.

Zawarto informacji j zyka (entropy rate) dla

wiadomo ci o długo ci N znaków definiuje si

r=H(X)/N,

Jest to rednia liczba bitów dla ka dej litery,

Je li prawdopodobie stwo wyst pienia wszystkich

liter jest takie samo wówczas bezwzgl dna entropia

(bezwzgl dna zawarto informacji) R dla liczby

znaków alfabetu L wynosi:

R=log2L,

Okre la ona maksymaln liczb bitów jakie mog by

przyporz dkowane ka dej literze

Copyright © 2006 E. Busłowska. All rights reserved.

♦

♦

♦

♦

5

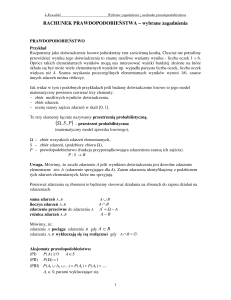

zdarzaj cych si z prawdopodobie stwem

p(X1),...,p(Xn), suma tych prawdopodobie stw p(Xi), dla

i=1,...,n równa si jedynce.

♦ Entropia warunkowa X dla danej wiadomo ci Y jest

definiowana

n

i =1

H ( X ,Y ) =

n

i =1

p ( X i , Y i ) log

p ( X i , Y i ) log

2

2

6

♦ Wyst puj trzy klasy informacji:

p ( X i , Yi )

1

p ( X i | Yi )

Gdzie P(X|Y) oznacza prawdopodobie stwo warunkowe

wyst pienia wiadomo ci X przy znanym Y.

Copyright © 2006 E. Busłowska. All rights reserved.

Copyright © 2006 E. Busłowska. All rights reserved.

Bezpieczny system

kryptograficzny

Entropia

♦ Niech X1,..., Xn to n mo liwych wiadomo ci

H (X |Y ) = −

j zyka (redundancy)

D = R-r,

Dla j zyka angielskiego dla alfabetu długo ci

26 znaków, D = 3,4bity/liter .

Zapisuj c w kodach ASCII nadmiarowo

mo e wynie 6,7bity/liter

Zapisuj c w 5-bitowych kodach

nadmiarowo mo e wynie 0,74bity/liter

7

Tekst jawny M zdarzaj cy si z

prawdopodobie stwem a priori p(M), gdzie

ΣMp(M)=1,

Tekst zaszyfrowany C zdarzaj cy si z

prawdopodobie stwem a priori p(C), gdzie

ΣCp(C)=1,

Klucz K zdarzaj cy si z

prawdopodobie stwem a priori p(K), gdzie

ΣKp(K)=1,

♦ Niech pc(M) b dzie prawdopodobie stwem, e

wiadomo M przesłana jako C

(C jest kodem

M).

Copyright © 2006 E. Busłowska. All rights reserved.

8

2

Poufno

Teoria zło ono ci (Complexity

Theory)

doskonała (absolutna)

♦ Poufno

doskonała (Perfect secrecy) jest

definiowana przez warunek:

♦ H(M|C) =H(M)

♦ Poufno doskonała jest mo liwa u ywaj c

całkowicie losowych kluczy tylko raz, o długo ci

takiej jak długie wiadomo ci one szyfruj .

Copyright © 2006 E. Busłowska. All rights reserved.

♦ Daje mo liwo

oceny czasu i pami ci

potrzebnych do rozwi zania jakiego

problemu obliczeniowego, rozwi zywanego

przez zastosowanie odpowiedniego

algorytmu.

♦ Teoria zło ono ci okre la czas i zasób

komputera, w jakim znany algorytm

rozwi zuje ka dy problem z okre lonej klasy

problemów obliczeniowych.

9

Copyright © 2006 E. Busłowska. All rights reserved.

10

3