L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

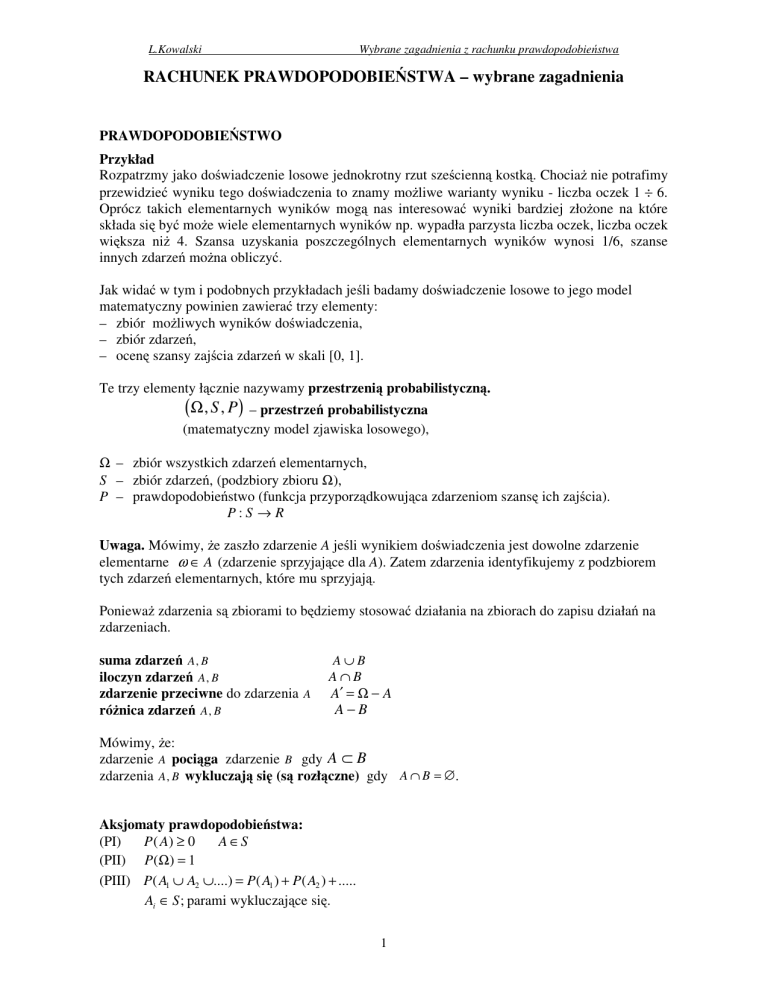

RACHUNEK PRAWDOPODOBIE STWA – wybrane zagadnienia

PRAWDOPODOBIE STWO

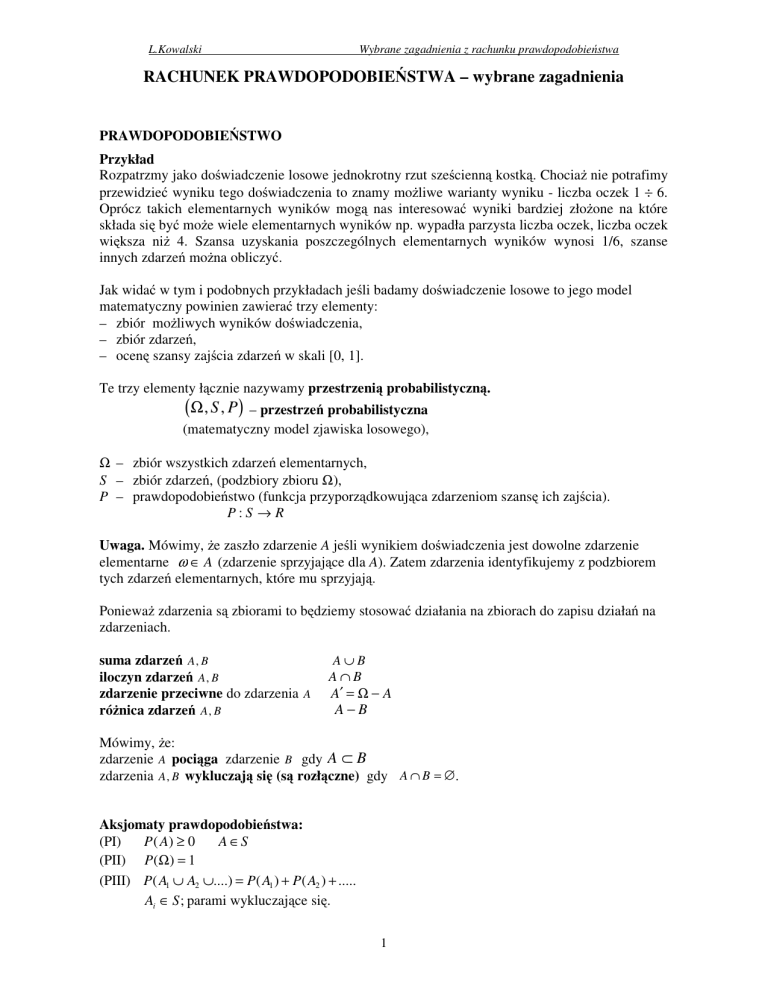

Przykład

Rozpatrzmy jako do wiadczenie losowe jednokrotny rzut sze cienn kostk . Chocia nie potrafimy

przewidzie wyniku tego do wiadczenia to znamy mo liwe warianty wyniku - liczba oczek 1 ÷ 6.

Oprócz takich elementarnych wyników mog nas interesowa wyniki bardziej zło one na które

składa si by mo e wiele elementarnych wyników np. wypadła parzysta liczba oczek, liczba oczek

wi ksza ni 4. Szansa uzyskania poszczególnych elementarnych wyników wynosi 1/6, szanse

innych zdarze mo na obliczy .

Jak wida w tym i podobnych przykładach je li badamy do wiadczenie losowe to jego model

matematyczny powinien zawiera trzy elementy:

– zbiór mo liwych wyników do wiadczenia,

– zbiór zdarze ,

– ocen szansy zaj cia zdarze w skali [0, 1].

Te trzy elementy ł cznie nazywamy przestrzeni probabilistyczn .

(Ω, S , P) – przestrze

probabilistyczna

(matematyczny model zjawiska losowego),

Ω – zbiór wszystkich zdarze elementarnych,

S – zbiór zdarze , (podzbiory zbioru Ω),

P – prawdopodobie stwo (funkcja przyporz dkowuj ca zdarzeniom szans ich zaj cia).

P:S → R

Uwaga. Mówimy, e zaszło zdarzenie A je li wynikiem do wiadczenia jest dowolne zdarzenie

elementarne ω ∈ A (zdarzenie sprzyjaj ce dla A). Zatem zdarzenia identyfikujemy z podzbiorem

tych zdarze elementarnych, które mu sprzyjaj .

Poniewa zdarzenia s zbiorami to b dziemy stosowa działania na zbiorach do zapisu działa na

zdarzeniach.

suma zdarze A , B

iloczyn zdarze A , B

zdarzenie przeciwne do zdarzenia A

ró nica zdarze A , B

A∪B

A∩B

A′ = Ω − A

A−B

Mówimy, e:

zdarzenie A poci ga zdarzenie B gdy A ⊂ B

zdarzenia A , B wykluczaj si (s rozł czne) gdy A ∩ B = ∅ .

Aksjomaty prawdopodobie stwa:

(PI)

P ( A) ≥ 0

A ∈S

(PII) P(Ω) = 1

(PIII) P( A1 ∪ A2 ∪....) = P( A1 ) + P( A2 ) + .....

Ai ∈ S ; parami wykluczaj ce si .

1

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Własno ci prawdopodobie stwa

a) P(∅) = 0

b) P ( A ′ ) = 1 − P ( A)

gdzie

A ′ = Ω − A jest zdarzeniem przeciwnym

c) Je li zdarzenia A1,...An wykluczaj si , to P( A1 ∪ ... ∪ An ) = P( A1 ) + ... + P( An )

d) P ( A1 ∪ A2 ) = P ( A1 ) + P ( A2 ) − P ( A1 ∩ A2 )

e) P( A1 ) ≤ P( A2 )

A1 , A2 ∈ S ;

dla A1 ⊂ A2 A1, A2 ∈ S ;

f) Je li A1 ⊂ A2 , to P( A2 − A1 ) = P( A2 ) − P( A1 ) ,

Je li zdarze elementarnych jest sko czenie wiele i s one jednakowo prawdopodobne to mo emy

skorzysta z tzw. klasycznej definicji prawdopodobie stwa.

P ( A) =

A

Ω

=

liczba zdarze – elementarn ych sprzyjaj c ych

liczba wszystkich zdarze – elementarn ych

A∈ S

Tak okre lona funkcja P spełnia aksjomaty prawdopodobie stwa.

Uwaga.

Liczba mo liwych sposobów ustawienia n ró nych elementów w ci g czyli permutacji zbioru

n elementowego wynosi P n = n !

Liczba mo liwych ci gów długo ci k o mog cych powtarza si elementach ze zbioru

n elementowego czyli k wyrazowych wariacji z powtórzeniami zbioru n elementowego wynosi

k

Wn = n k .

Liczba mo liwych ci gów długo ci k o ró nych elementach ze zbioru n elementowego czyli

k

zbioru n elementowego ( k ≤ n) wynosi Vn =

k wyrazowych wariacji bez powtórze

k

n!

.

(n − k )!

n

Je li n = k, to Vn = Vn = Pn = .

Liczba mo liwych k elementowych podzbiorów zbioru n elementowego czyli k wyrazowych

n

n!

=

. Zauwa my,

k

k!(n − k )!

k

kombinacji zbioru n elementowego ( k ≤ n) wynosi C n =

Vnk

C =

bo w kombinacjach kolejno

k!

k

n

elementów nie jest istotna.

Dyskretna przestrze probabilistyczna.

Niech Ω = {ω1 , ω 2 ,...} ,

S = 2Ω

Je li okre limy prawdopodobie stwo dla zdarze jednoelementowych

P({ω i }) = pi

gdzie pi ≥ 0,

pi = 1

wtedy dla A = {ω i1 , ω i2 ,...} mamy

({

})

({ } { }

i

)

P ( A) = P ω i1 , ω i2 ,... = P ω i1 ∪ ω i2 ∪ ... =

({ }) ({ })

= P ω i1 + P ω i2 + ... = pi1 + pi2 + ...

2

e

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Tak okre lona funkcja P spełnia aksjomaty prawdopodobie stwa. Spełnienie aksjomatu PIII wynika

z faktu, e suma zbie nego szeregu liczb nieujemnych nie ulega zmianie przy dowolnym

grupowaniu i przestawianiu wyrazów tego szeregu.

1

Je li Ω = N i pi =

to otrzymujemy klasyczn definicj prawdopodobie stwa.

N

Prawdopodobie stwo geometryczne

Je li zdarzenia elementarne s podzbiorem o mierze sko czonej przestrzeni Rn (je li n = 1 to miar

jest długo , dla n = 2 pole, dla n = 3 obj to ) i s one jednakowo prawdopodobne to stosujemy

tzw. prawdopodobie stwo geometryczne.

miara A

A∈ S

miara Ω

Tak okre lona funkcja P spełnia aksjomaty prawdopodobie stwa.

P( A) =

Uwaga

Je li mamy mo liwo wielokrotnego powtarzania (niezale nie) do wiadczenia losowego w tych

samych warunkach to mo emy wyznaczy przybli on warto prawdopodobie stwa wybranego

zdarzenia A

P( A) ≈

k

= cz sto

n

zdarzenia A

gdzie

n – liczba wykonanych do wiadcze ;

k – liczba tych do wiadcze w których zaszło zdarzenie A.

Sposób ten stosuje si w statystyce.

PRAWDOPODOBIE STWO WARUNKOWE. NIEZALE NO

Prawdopodobie stwo warunkowe.

Oceniaj c szans zaj cia jakiego zdarzenia mo emy wykorzystywa dodatkowe informacje

o innych zdarzeniach, które zaszły (lub spekulowa o konsekwencjach ich zaj cia). Informacje te

mog wpływa na prawdopodobie stwo zaj cia rozpatrywanego zdarzenia lub nie.

Aby oceni stopie wpływu zaj cia jednego zdarzenia na szans

wprowadzamy nast puj ce okre lenie.

zaj cia innego zdarzenia

Je li P( B) > 0 , B ∈ S to okre lamy prawdopodobie stwo warunkowe dowolnego zdarzenia A

pod warunkiem, e zaszło zdarzenie B:

P( A B ) =

P( A ∩ B)

P( B)

A ∈S

Pisz c P ( A B ) b dziemy domy lnie zakłada , e P( B) > 0 .

Własno .

Je li (Ω, S, P ) jest przestrzeni probabilistyczn i P( B) > 0 , B ∈ S to

(Ω, S , P ) gdzie P* ( A) = P( A B),

*

A ∈ S jest równie przestrzeni probabilistyczn .

Okazuje si , e zaj cie zdarzenia A zwi ksza szanse zaj cia zdarzenia B wtedy i tylko wtedy, gdy

zaj cie zdarzenia B zwi ksza szanse zaj cia zdarzenia A.

3

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

P( A B) > P( A) ⇔ P( B A) > P( B)

(uzasadnienie: obie strony równowa no ci s na mocy definicji prawdopodobie stwa warunkowego

równowa ne nierówno ci P ( A ∩ B ) > P ( A) P ( B ) wi c s równowa ne mi dzy sob ).

Prawdopodobie stwo warunkowe mo na wykorzysta

iloczynu zdarze .

do wyznaczania prawdopodobie stwa

Przykład.

Je li przekazywany sygnał ma dotrze z punktu emisji do punktu B przez po redni punkt A i na

ka dym etapie mo e by zniekształcony z odpowiednim prawdopodobie stwem.

Niezniekształcony sygnał dotrze do punktu B pod warunkiem, e dotrze niezniekształcony do

punktu A. Zatem licz c prawdopodobie stwo dotarcia niezniekształconego sygnału do punktu B

mno ymy prawdopodobie stwo jego dotarcia do punktu A przez prawdopodobie stwo jego

dotarcia do B pod warunkiem, e do A sygnał dotarł.

Zatem intuicyjnie korzystamy z wzoru P( A ∩ B) = P( A) P( B A) wynikaj cego z okre lenia

P( B A) . Podobnie P( A ∩ B) = P( B) P( A B) .

Powy szy wzór mo na uogólni nast puj co:

Niech zdarzenia A1, A2, ..., An, spełniaj warunek

P ( A1 ∩ A2 ∩ ... ∩ An ) > 0

wtedy

P ( A1 ∩ A2 ∩ ... ∩ An ) = P ( A1 ) P ( A2 A1 ) ⋅ ... ⋅ P (An A1 ∩ A2 ∩ ... ∩ An -1 )

Powy szy wzór stanowi uzasadnienie metody drzewek cz sto stosowanej np. przy losowaniach

wieloetapowych, gał ziom odpowiadaj prawdopodobie stwa warunkowe, przemieszczanie si

wzdłu gał zi oznacza mno enie tych prawdopodobie stw.

Nast puj ce twierdzenie pozwala wyrazi prawdopodobie stwo dowolnego zdarzenia jako sumy

"wkładów" zupełnego układu zdarze do rozpatrywanego zdarzenia.

Twierdzenie (o prawdopodobie stwie całkowitym)

Niech zdarzenia A1, A2, ..., An, spełniaj warunki:

A1, A2, ..., An, s parami wykluczaj ce si , A1 ∪ A2 ∪ ... ∪ An =

(o takim układzie zdarze mówimy, e jest zupełny)

P(Ai) > 0, i = 1,2, ..., n.

wtedy dla dowolnego zdarzenia B

P ( B ) = P ( A1 ) P ( B A1 ) + P ( A2 ) P ( B A2 ) + .... + P ( An ) P ( B An ) =

n

i =1

P ( Ai ) P ( B Ai )

Dowód. Z zało enia o układzie zupełnym i definicji prawdopodobie stwa warunkowego mamy

P( B) = P

n

( B ∩ Ai ) =

i =1

n

i =1

P ( B ∩ Ai ) =

n

i =1

P ( Ai ) P ( B Ai )

Powy sze twierdzenie jest równie prawdziwe dla przeliczalnego zupełnego układu zdarze .

A1

A2

A3

A4

A5

A6

B

4

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Twierdzenie (Bayesa)

Niech zdarzenia A1, A2, ..., An, spełniaj warunki poprzedniego twierdzenia.

Wtedy dla dowolnego zdarzenia B takiego, e P(B) > 0 mamy:

P ( Ak B ) =

P ( Ak ) P ( B A k )

P(B)

=

P ( A k ) P ( B Ak )

P ( A1 ) P ( B A1 ) + P ( A2 ) P ( B A2 ) + .... + P ( An ) P ( B An )

=

P ( Ak ) P ( B A k )

n

i =1

P ( Ai ) P ( B Ai )

Zdarzenia A i B s niezale ne gdy

P ( A ∩ B) = P ( A) P ( B)

A, B ∈ S

Poj cie

to

powoduje,

e

teoria

prawdopodobie stwa

w porównaniu z teori miary i innymi działami matematyki.

Zauwa my , e je li zdarzenie A jest niezale ne od zdarzenia B to

ma

swoj

specyfik

P( A B) = P( A)

Ogólnie. Zdarzenia A1 , .. ., A n ( n ≥ 2) s niezale ne, je li

P( Ai1 ∩...∩ Aik ) = P( Ai1 ) ⋅ ... ⋅ P( Aik )

∀ 1 ≤ i1 ≤ i2 ≤ ... ≤ ik ≤ n, k ≥ 2

Np. trzy zdarzenia A , B i C s niezale ne wtedy i tylko wtedy, gdy

P ( A ∩ B ∩ C ) = P ( A ) P ( B ) P (C ) ,

P( A ∩ B) = P( A) P( B) , P ( A ∩ C ) = P ( A ) P ( C ) i P ( B ∩ C ) = P ( B ) P ( C ).

Uwaga.

Je li A, B niezale ne to A, B' s równie niezale ne.

ZMIENNA LOSOWA JEDNOWYMIAROWA

Aby mo na było wykorzysta aparat analizy matematycznej do badania prawdopodobie stwa,

wygodnie jest przenie wyniki do wiadczenia losowego ze zbioru zdarze elementarnych Ω,

specyficznego dla tego do wiadczenia do uniwersalnego zbioru R bardziej "przyjaznego" dla

operacji ró niczkowych i całkowych.

Zmienn losow X nazywamy funkcj

elementarnym liczby rzeczywiste.

(praktycznie ka d ) przyporz dkowuj c

X:

zdarzeniom

→ R

Okre laj c zmienn losow otrzymujemy mo liwo liczbowego opisu wyników do wiadczenia

losowego, mo emy te "odfiltrowa " zb dne informacje, które nas nie interesuj . Najcz ciej

bowiem wa ne s tylko pewne charakterystyki liczbowe zale ne od wyniku do wiadczenia.

Przykład zmiennych losowych

Dla przestrzeni probabilistycznej – dwa rzuty kostk .

X – suma oczek, (warto ci: 2, 3, ..., 12).

X – wynik rzutu o wi kszej liczbie oczek (warto ci: 1, 2, ..., 6).

5

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Stosujemy uproszczenia np.

- zapis

P(X < x)

oznacza

P({ω∈Ω: X(ω) < x}),

- zapis

P ( x1 < X < x 2 )

oznacza

P({ω∈Ω: x1 < X(ω) < x2}),

Zdarzeniom s przyporz dkowane podzbiory zbioru R, musimy tym podzbiorom przyporz dkowa

odpowiadaj ce im prawdopodobie stwa. Przyporz dkowanie to nazywamy rozkładem

prawdopodobie stwa zmiennej losowejX i oznaczamy PX.

(

PX ( B) = P X −1( B)

)

dla B ∈ Β(R),

B(R) - zbiory borelowskie

Tak okre lone PX spełnia aksjomaty prawdopodobie stwa.

X

Ω

B=X(A)

A=X-1(B)

P

R

PX

1

0

P(A)=PX(B)

Dla zmiennej losowej mo na zdefiniowa dystrybuant - funkcj rzeczywist , która wyznacza

rozkład zmiennej losowej jednoznacznie.

Dystrybuant zmiennej losowej X nazywamy funkcj F: R

→ R okre lon wzorem:

Własno ci dystrybuanty:

F ( x ) = P ( X < x ) = PX (( −∞ , x ))

a) F jest funkcj niemalej c ,

b) F jest funkcj lewostronnie ci gł ,

c)

F ( −∞) = 0; F (∞) = 1 ,

d) dystrybuanta zmiennej losowej wyznacza jednoznacznie jej rozkład,

e) P ( a ≤ X < b) = F (b) − F ( a );

+

f) P( X = a ) = F ( a ) − F ( a );

a <b

gdzie F (a + ) oznacza granic

prawostronn , (je li a jest punktem ci gło ci dystrybuanty to P(X = a ) = 0).

Uwaga

Je li funkcja rzeczywista spełnia własno ci a), b), c) to jest dystrybuant pewnej zmiennej losowej,

jej rozkład jest wyznaczony jednoznacznie.

Zmienna losowa jest skokowa (dyskretna) je li zbiór wszystkich jej warto ci jest sko czony lub

przeliczalny.

Rozkład zmiennej losowej skokowej cz sto okre lamy za pomoc funkcji prawdopodobie stwa:

P( X = x k ) = pk

pk = 1; pk > 0 )

(własno :

k

Liczby pk nazywamy skokami, a warto ci xk punktami skokowymi.

6

L.Kowalski

Znaj c funkcj

dystrybuant

Wybrane zagadnienia z rachunku prawdopodobie stwa

prawdopodobie stwa zmiennej losowej skokowej mo na wyznaczy

F (x ) =

k

x k <x

oraz jej rozkład prawdopodobie stwa

jej

pk

P ( X ∈ B) =

pk

k

x k ∈B

Przykład

Zmienna ta przyjmuje warto ci 1, 2, 3 z prawdopodobie stwami odpowiednio

P( X = 1) = 0,2 ;

P( X = 2) = 0,6 ;

P( X = 3) = 0,2 .

Warto ci funkcji prawdopodobie stwa mo na zestawi w tabeli:

xk

pk

1

0,2

2

0,6

3

0,2

dla

x ≤1

dla 1 < x ≤ 2

dla 2 < x ≤ 3

dla

x>3

0

0,2

Jej dystrybuanta ma posta F ( x) =

0,8

1

1

0,8

0,2

1

2

3

Zauwa my, e punkty skokowe s punktami nieci gło ci dystrybuanty a skoki wyznaczaj

przyrosty dystrybuanty (jej skoki) w tych punktach.

Dla zmiennej losowej skokowej dystrybuanta jest zawsze kawałkami stała.

Zmienna losowa X o dystrybuancie F jest ci gła je li jej dystrybuanta da si przedstawi w postaci

x

F ( x) =

x ∈R

f (t )dt

−∞

gdzie f jest funkcj spełniaj c warunki:

∞

f ( x ) ≥ 0; x ∈ R;

f (t )dt = 1

−∞

i nazywamy j g sto ci prawdopodobie stwa zmiennej losowej X.

Własno ci zmiennej losowej ci głej:

a) P( X < a ) =

a

f ( x )dx = F (a ) ,

−∞

b) P (a ≤ X ≤ b) = P(a < X ≤ b) = P( a ≤ X < b) = P( a < X < b) =

b

a

7

f ( x)dx = F (b) − F (a)

L.Kowalski

c) P ( X > b) =

∞

Wybrane zagadnienia z rachunku prawdopodobie stwa

f ( x )dx = 1 − F (b) ,

b

d) P ( X = a ) = 0, dla dowolnego a ∈ R ; (brak punktów skokowych),

e) F jest funkcj ci gł i prawie wsz dzie ró niczkowaln

F ′ ( x ) = f ( x ) (równo

zachodzi dla

punktów ci gło ci g sto ci). Wyznaczaj c g sto

przez ró niczkowanie dystrybuanty,

w punktach w których F nie jest ró niczkowalna mo na przyj , e g sto jest równa zero.

Przykład.

Wyznaczymy warto ci c dla której funkcja

cx

dla

x ∈ (0 , 1]

0

dla

x ∉ (0 , 1]

jest g sto ci pewnej zmiennej losowej ci głej?

f ( x) =

∞

Aby g sto

f ( x)dx = 1 , musi by c > 0 i pole odpowiedniego trójk ta

była nieujemna i

−∞

prostok tnego równe 1. St d c = 2.

Dystrybuanta tej zmiennej losowej ma posta

dla

dla

dla

x

x ∈ (− ∞ ; 0]

F ( x ) = 0 dt = 0

x ∈ (0 , 1]

F ( x) =

x ∈ (1 , ∞ ]

−∞

0

−∞

0

0

1

x

−∞

0

1

F ( x) = 0dt + 2tdt + 0dt = 1

0

Ostatecznie

x

0dt + 2tdt = x 2

F ( x) = x

1

x ∈ (− ∞ ; 0]

dla

2

x ∈ (0, 1]

x ∈ (1, ∞ ]

dla

dla

Obliczymy prawdopodobie stwo P(0,25 ≤ X ≤ 0,75) .

0, 75

Sposób I. Za pomoc g sto ci P(0,25 ≤ X ≤ 0,75) =

2 xdx = x 2

0 , 25

0 , 75

0 , 25

= 0,5

Sposób II. Za pomoc dystrybuanty P(0,25 ≤ X ≤ 0,75) = F (0,75) − F (0,25) = 0,5

Uwagi o rozkładzie funkcji zmiennej losowej.

Je li X - skokowa, o funkcji prawdopodobie stwa P(X = xi) = pi, g - dowolna to funkcja

prawdopodobie stwa zmiennej losowej Y = g(X) ma posta :

g(x1)

g(x2)

...

g(xk)

p1

p2

...

pk

Po uporz dkowaniu rosn co warto ci g(xi) i zsumowaniu odpowiednich prawdopodobie stw.

Dokładniej

P(Y = y ) = P( g ( X ) = y ) = P

(X

{i: g ( xi ) = y }

= xi ) =

P( X = xi ) =

{i: g ( xi ) = y }

8

pi

{i: g ( x i ) = y }

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Przykład.

X - zmienna losowa skokowa o funkcji prawdopodobie stwa:

-4

-2

-1

0

1

0,4

0,1

0,1

0,1

0,1

wyznaczymy funkcj prawdopodobie stwa zmiennej losowej Y = sgnX .

sgn(-4) = sgn(-2) = sgn(-1) = -1.

sgn(0) = 0.

sgn(1) = sgn(2) = 1.

Zatem funkcja prawdopodobie stwa zmiennej losowej Y jest nast puj ca

-1

0

1

0,6

0,1

0,3

X - dana zmienna losowa ci gła o g sto ci f.

Wyznaczy g sto g(y) zmiennej losowej Y.

2

0,2

Y = g(X) ,

1) Je li g - ci le monotoniczna i ró niczkowalna w przedziale (a, b) koncentracji X to:

g ( y ) = f (h( y ) ) h ' ( y )

gdzie h = g-1.

Nale y pami ta o przekształceniu przedziału koncentracji.

Przykład.

Y = aX + b, wtedy g ( y ) = f

y −b 1

,

a

a

Przykład.

0

Je li X ma rozkład o g sto ci f ( x) =

e

−x

dla x ≤ 0

Y = X − 2,

dla x > 0

wtedy h( y ) = ( y + 2 ) , h′( y ) = 2( y + 2 ) , g(0) = -2, g(∞) = ∞,

2

g ( y) =

2) Je li g - przedziałami

(a, b) koncentracji X to:

dla x ≤ −2

0

2( y + 2) e

ci le

g ( y) =

− ( y + 2) 2

dla x > −2

monotoniczna

k

i =1

i

,

ró niczkowalna

w

przedziale

f (hi ( y) ) hi ( y )

'

gdzie hi - funkcje odwrotne do g dla poszczególnych przedziałów,

k - liczba warto ci funkcji odwrotnej odpowiadaj cych danemu y.

W niektórych zagadnieniach wyznaczania rozkładu funkcji zmiennej losowej najpierw

wyznaczamy dystrybuant rozkładu zmiennej losowej Y = g(X), wg schematu

FY ( y ) = P(Y < y ) = P(g ( X ) < y ) = P X ∈ g −1 ((−∞, y ) ) < y

nast pnie je li to mo liwe, wyznaczamy funkcj prawdopodobie stwa (gdy jest to rozkład

skokowy) lub g sto (gdy jest to rozkład ci gły).

(

)

9

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

PARAMETRY ZMIENNEJ LOSOWEJ JEDNOWYMIAROWEJ

Własno ci rozkładu zmiennej losowej cz sto charakteryzujemy jej parametrami.

Jednym z podstawowych parametrów jest warto oczekiwana.

Warto oczekiwana. Oznaczenie EX lub m.

Dla zmiennej losowej skokowej

EX =

xi pi

i

(je li ewentualny szereg jest zbie ny bezwzgl dnie, takie szeregi s "odporne" np. na zmian

kolejno ci wyrazów).

Dla zmiennej losowej ci głej

∞

EX =

xf ( x ) dx

−∞

(je li ewentualna całka niewła ciwa jest zbie na bezwzgl dnie).

Przyjmuj c, e warto oczekiwana istnieje mamy te na uwadze, e ma sko czon warto .

Przykład

Dla zmiennej losowej o funkcji prawdopodobie stwa

xk

pk

-1

0,2

2

0,6

3

0,2

EX = −1 ⋅ 0,2 + 2 ⋅ 0,6 + 3 ⋅ 0,2 = 1,6 .

Interpretacja.

Warto oczekiwana wyznacza rodek ci ko ci masy jednostkowej rozło onej w punktach

skokowych.

0,2

-1

1,6

0,6

0,2

2

3

Mo na te powiedzie , e jest to rednia warto przyjmowana przez zmienn losow

(z uwzgl dnieniem wag jakimi s prawdopodobie stwa).

Przykład

Dla zmiennej losowej o g sto ci

f ( x) =

x ∈< 01

, >

2x

x ∉< 01

, >

0

1

1

0

0

EX = x ⋅ 2 xdx = 2 x 2 dx = 2

Własno ci warto ci oczekiwanej

a) Ec = c; c – stała,

b) E(aX) = aE(X),

c) E(X + Y) = EX + EY,

d) X, Y – niezale ne, to E(XY) = EX⋅EY.

10

x3 1 2

=

3 0 3

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Miar rozrzutu warto ci zmiennej losowej jest wariancja.

Wariancja. Oznaczenie D2X lub σ2 lub VX.

D2X = E(X – EX)2

Dla zmiennej losowej skokowej

D2 X =

Dla zmiennej losowej ci głej

D2 X =

( xi − EX ) 2 pi

∞

( x − EX ) 2 f ( x )dx

−∞

Własno ci wariancji

a) D2c = 0;

2

c – stała,

2

b) D (aX) = a D2(X),

c) D2(X + b) = D2X , b – stała,

2

2

2

d) X, Y – niezale ne, to D (X ± Y) = D X + D Y

e) D2X = E(X2) – (EX)2.

Uzasadnienie e)

D2X = E(X – EX)2 = E(X2 – 2XEX + (EX)2) = EX2 – 2EXEX + (EX)2 = E(X2) – (EX)2.

Je li rozrzut warto ci zmiennej losowej chcemy (np. z powodu interpretacji w zastosowaniach)

mierzy w tych samych jednostkach co X to stosujemy odchylenie standardowe.

Odchylenie standardowe. Oznaczenie DX lub σ.

DX =

Własno

Je li X ma warto

D2 X

oczekiwan m i odchylenie standardowe σ > 0

X −m

to zmienna losowa Y =

ma EY = 0 i DX = 1.

σ

Zmienn losow Y nazywamy zmienn losow standaryzowan .

Przykład

Dla zmiennej losowej o g sto ci f ( x ) =

1

2

3

0

II sposób (na podstawie własno ci e))

D2 X =

x−

1

2x

0

2

⋅ 2 xdx =2

2

D X = x ⋅ 2 xdx −

3

0

2

x ∈< 01

, >

2

zatem

mamy EX =

x ∉< 01

, >

3

2

1

x3 −

0

2

1

4 2 4

1

x + x dx =

3

9

18

=2 x 3dx −

0

4 1 4 1

= − =

9 2 9 18

Przykład

Je li niezale ne zmienne losowe Xi (i = 1, 2, ..., n) maj tak sam warto

oczekiwan m i takie

1 n

samo odchylenie standardowe σ > 0 to zmienna losowa X b d ca ich redni X =

X i ma

n i =1

EX = m ;

DX =

11

σ

n

L.Kowalski

Nierówno Czebyszewa.

Je li zmienna losowa X

ma

σ > 0 to dla dowolnego ε > 0 mamy

Wybrane zagadnienia z rachunku prawdopodobie stwa

warto

oczekiwan

m

i

odchylenie

standardowe

σ2

ε2

Z nierówno ci tej wynika, e wariancja (odchylenie standardowe) jest miar odchylenia warto ci

zmiennej losowej od warto ci oczekiwanej.

P( X − m ≥ ε ) ≤

Moment rz du k ( k - liczba naturalna)

mk = E (X k )

Zauwa my, e w szczególno ci m1 = EX = m, oraz własno e) dystrybuanty mo na zapisa

D2 X = m2 – m2 .

Własno . Je li istnieje mk to istnieje ms dla ka dego s < k.

Moment centralny rz du k ( k - liczba naturalna)

µk = E ( X − EX )k

Zauwa my, e w szczególno ci µ1 = 0, µ2 = D2X.

(

)

Za pomoc momentów wy szych rz dów okre lamy współczynnik asymetrii (sko no ci)

a=

µ3

σ3

k=

µ4

σ4

i współczynnik skupienia (kurtoz )

Wielko ci te s cz sto stosowane w statystyce.

Kwantylem rz du p (0 < p < 1) zmiennej losowej X o dystrybuancie F nazywamy liczb xp, tak ,

e

F (x p ) ≤ p ≤ F x +p

Zauwa my, e dla zmiennej losowej ci głej xp wyznaczymy z równo ci

F (x p ) = p

Kwantyl rz du 0,5 nazywamy median .

Kwantyle rz du 0,25 ; 0,5; 0,75 nazywamy kwartylami (drugi kwartyl jest median ).

Wielko ci te s cz sto stosowane w statystyce.

Kwantyle istniej dla ka dej zmiennej losowej, lecz nie zawsze s wyznaczone jednoznacznie.

( )

PODSTAWOWE ROZKŁADY PRAWDOPODOBIE STWA

Rozkłady skokowe

Rozkład dwupunktowy (zerojedynkowy)

Niech p ∈ ( 0, 1) b dzie ustalon liczb . Okre lamy:

P(X = 0) = q, P(X = 1) = p ; gdzie q = 1 – p.

Rozkład ten jest wykorzystywany w statystycznej kontroli jako ci. Mo na np. przyj , e X = 0 gdy

wyrób dobry, X = 1 gdy wyrób jest wadliwy, wtedy p = P(X = 1) traktujemy jako wadliwo

wyrobu.

12

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Rozkład dwumianowy

Dla danych p ∈ ( 0, 1) , n ∈ N okre lamy funkcj prawdopodobie stwa

n k n−k

gdzie q = 1 – p

p q

k

k = 0, 1, 2, ... , n.

Zauwa my, e gdy n = 1 to rozkład dwumianowy jest rozkładem zerojedynkowym.

P( X = k ) =

Je li przyjmiemy, e n oznacza liczb niezale nych do wiadcze z których ka de ko czy si

jednym z dwóch wyników: „sukcesem" (z prawdopodobie stwem p w ka dym do wiadczeniu) lub

„pora k ” i zmienna losowa X oznacza liczb „sukcesów” to powy szy wzór wyznacza

prawdopodobie stwo uzyskania dokładnie k sukcesów w n do wiadczeniach (próbach).

Rozkład Poissona

Dla λ > 0 okre lamy funkcj prawdopodobie stwa

P (X = k ) =

λk

k!

e − λ k = 0, 1, 2, ...

(warto ci tych prawdopodobie stw zawiera tablica rozkładu Poissona)

Rozkład Poissona (mo liwo odczytu w tablicy) mo e dla du ych n (praktycznie n ≥ 30) i małych

p (praktycznie p ≤ 0,2) przybli a rozkład dwumianowy (przybli enie Poissona)

n

k

p q

k

n−k

≈

λk

k!

e −λ

gdzie λ = n ⋅ p

Rozkłady ci głe

Rozkład jednostajny

Rozkład którego g sto

jest stała w pewnym przedziale nazywamy jednostajnym.

1

x ∈ ( a; b)

G sto rozkładu jednostajnego w (a, b) f ( x ) = b − a

0

x ∉ ( a; b)

Poniewa g sto ta ma o symetrii w punkcie x = (a + b)/2 to

EX = (a+b)/2

Poka emy, e

D2X = (b – a)2/12

Przykład

Najpierw obliczymy EX2

b

1

1 x3

EX = x

dx =

b−a

b−a 3

a

2

b

=

2

a

Zatem D 2 X = EX 2 − ( EX ) 2 =

1 b3 a3

a 2 + 2ab + b2

−

=

b−a 3

3

3

a 2 + 2ab + b 2

a+b

−

3

2

2

=

(b − a )2

12

Rozkład wykładniczy

Rozkład ten wyst puje cz sto w zagadnieniach rozkładu czasu mi dzy zgłoszeniami (awariami) lub

czasu oczekiwania na obsług w systemach kolejkowych.

G sto rozkładu wykładniczego o parametrze a > 0 ma posta f ( x) =

13

ae − ax

x>0

0

x≤0

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

dystrybuant tego rozkładu jest funkcja

F ( x) =

1 − e − ax

x>0

x≤0

0

Rozkład normalny

m ∈ R , σ ∈(0, + ∞)

Dla

f ( x) =

1

σ 2π

okre lamy g sto

−

e

( x − m)2

2σ 2

rozkładu

x∈R

W tablicy II dla x ∈ [0; 5) podano warto ci dystrybuanty Φ rozkładu N(0, 1)

Warto ci dystrybuanty dla argumentów ujemnych wyznaczamy na podstawie zale no ci

Φ (– x) = 1 – Φ (x)

Uwaga

Je li X ma rozkład N(m, σ) to zmienna losowa Y = (X – m)/σ ma rozkład N(0, 1)

(takie przekształcenie nazywamy standaryzacj ).

Przykład

Dochód miesi czny (zł) w pewnej populacji osób ma rozkład normalny N(1600; 300).

Jaki procent osób w tej populacji ma dochód miesi czny poni ej 1000 zł?

X – wysoko

miesi cznego dochodu

P( X < 1000) = P

X − 1600 1000 − 1600

<

= P(Y < −2 ) = Φ (−2) = 1 − Φ (2) = 1 − 0,9772 = 0,0228 = 2,28%

300

300

Prawo trzech sigm

Je li X ma rozkład N(m, σ) to

P (m − σ < X < m + σ ) = 0,683 ,

P (m − 2σ < X < m + 2σ ) = 0,955 ,

P(m − 3σ < X < m + 3σ ) = 0,997

wiadczy o tym, e chocia rozkład normalny ma g sto ró n od zera na całej

Ostatnia równo

prostej to praktycznie niemal wszystkie realizacje skupiaj si w przedziale

( m − 3σ , m + 3σ )

własno

t nazywamy prawem trzech sigm.

14

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

m

m – 3σ

m + 3σ

Interpretacja graficzna parametrów rozkładu N(m, σ)

Trzy rozkłady ci głe, które maj du e znaczenie w statystyce matematycznej:

– Rozkład chi kwadrat,

– Rozkład Studenta,

– Rozkład F – Snedecora

Przedstawione s w zestawieniu rozkładów ci głych.

Rozkłady te s stablicowane.

15

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Odczyt z tablicy (tablica III) dla rozkładu chi kwadrat.

(podobnie interpretujemy graficznie odczyt (tablica V) z tablicy F – Snedecora.)

P (Yn ≥ k ) = α

Uwaga.

1) Dla n = 1, 2 wykres g sto ci rozkładu chi kwadrat jest inny (tylko cz

malej ca wykresu)

2) dla n > 30 stosujemy przybli enie rozkładem normalnym.

Odczyt z tablicy (tablica IV) dla rozkładu Studenta.

P ( Tn ≥ k ) = α

Rozkłady i tablice zawiera oddzielne zestawienie.

FUNKCJA CHARAKTERYSTYCZNA

Funkcj ϕ : R → C (zespolon zmiennej rzeczywistej) okre lon wzorem

∞

ϕ (t ) = ϕ X (t ) = E (e itX ) = e itx dF ( x) ,

−∞

t∈R

nazywamy funkcj charakterystyczn zmiennej losowej X.

Zatem dla zmiennej losowej skokowej o funkcji prawdopodobie stwa P( X = xk ) = pk

ϕ (t ) =

pk e itxk ,

k

16

t∈R

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

natomiast dla zmiennej losowej ci głej o g sto ci f(x)

ϕ (t ) =

∞

f ( x)e itx dx ,

t∈R

−∞

Powy szy szereg i całka s bezwzgl dnie zbie ne do 1 (bo warto ci modułu zmiennej losowej

eitX ,

t ∈ R s równe 1 i odpowiednio

∞

pk = 1 ,

k

f ( x)dx =1 ), zatem funkcja charakterystyczna

−∞

zawsze istnieje.

Własno ci funkcji charakterystycznej.

a) ϕ (0) = 1, ϕ (t ) ≤ 1, t ∈ R ,

b) ϕ jest funkcj jednostajnie ci gł ,

itb

c) ϕ aX +b (t ) = e ϕ X (ta) ,

d) je li istnieje E X

EX k =

e)

f)

g)

h)

k

< ∞, k ≥ 1 , to ϕ jest funkcj klasy Ck oraz ϕ ( k ) (0) = i k EX k , czyli

ϕ (k ) (0)

,

ik

je li istnieje i jest sko czona pochodna ϕ (2 k ) (0) to EX 2 k < ∞, k ≥ 1

ϕ X (t ) = ϕ X (−t ) = ϕ − X (t )

je li X, Y - niezale ne zmienne losowe to ϕ X +Y (t ) = ϕ X (t )ϕY (t ) ,

funkcja charakterystyczna okre la rozkład zmiennej losowej jednoznacznie.

W szczególnych przypadkach mo na (korzystaj c z retransformaty) na podstawie funkcji

charakterystycznej wyznaczy rozkład zmiennej losowej .

Własno 1.

Je li funkcja charakterystyczna ϕ zmiennej losowej X jest bezwzgl dnie całkowalna, to X jest

zmienn losow ci gł i g sto jej wyra a si wzorem

f ( x) =

1

2π

∞

ϕ (t )e −itx dt

−∞

Własno 2.

Je li funkcja charakterystyczna ϕ zmiennej losowej X jest okresowa o okresie 2π, to X jest zmienn

losow skokow o warto ciach całkowitych i jej funkcja prawdopodobie stwa wyra a si wzorem

P( X = k ) =

1

2π

π

k - liczba całkowita

ϕ (t )e −itk dt

−π

ZMIENNA LOSOWA DWYWYMIAROWA (WIELOWYMIAROWA)

Je li Xi i = 1, 2, ..., n s zmiennymi losowymi w ustalonej przestrzeni probabilistycznej (Ω, S , P) to

ci g X = (X1 , X2 , ..., Xn) nazywamy zmienn losow n-wymiarow (wektorem losowym).

Zauwa my, e w tym przypadku ka demu zdarzeniu elementarnemu przyporz dkowujemy ci g

n liczb rzeczywistych.

X : Ω → Rn

W szczególno ci gdy n = 2 mamy dwuwymiarow zmienn losow (X, Y).

Zmienne losowe wielowymiarowe słu do modelowania takich do wiadcze losowych których

wyniki opisuje si układem wielu liczb rzeczywistych np. losowo wybranego człowieka mo emy

m.in. scharakteryzowa trzema liczbami: wzrostem, wag i wiekiem.

17

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Zmienna losowa 2-wymiarowa.

( )

P( X ,Y ) : Β R 2 → [0, 1] - rozkład prawdopodobie stwa zmiennej losowej (X,Y).

(

)

( )

P( X ,Y ) ( A) = P ( X , Y ) ( A) ,

−1

∀A ∈ Β R 2

Rozkłady prawdopodobie stwa zmiennych losowych X, Y nazywamy rozkładami brzegowymi.

Rozkład prawdopodobie stwa zmiennej losowej (X, Y) nazywamy rozkładem ł cznym.

Dystrybuanta

F ( x, y ) = P ( X < x , Y < y )

Własno ci dystrybuanty zmiennej losowej (X,Y).

a) F jest niemalej ca wzgl dem ka dego argumentu,

b) ∀x

lim F ( x, y ) = 0 ; ∀y

y →−∞

(lim F ( x, y) = 0);

x→−∞

,

lim F ( x, y ) = 1

x →∞

y →∞

c) F jest lewostronnie ci gła wzgl dem ka dego argumentu,

d)

∀x1 ≤ x2 ; ∀y1 ≤ y2 ; F (x2 , y2 ) − F (x1 , y 2 ) − F (x2 , y1 ) + F (x1 , y1 ) =

= P( x1 ≤ X < x2 ; y1 ≤ Y < y 2 ) ≥ 0

Je li F(x, y) jest dystrybuant zmiennej losowej (X,Y) to funkcje

FX ( x) = lim F ( x, y ) = F ( x, ∞);

y →∞

FY ( y) = lim F ( x, y ) = F (∞, y )

x→∞

s dystrybuantami odpowiednich rozkładów brzegowych.

Zmienne losowe X,Y

A, B na prostej mamy

niezale ne

s

gdy

dla

dowolnych

zbiorów

borelowskich

P( X ∈ A, Y ∈ B) = P( X ∈ A) P(Y ∈ B)

Zmienne losowe X,Y s niezale ne wtedy i tylko wtedy, gdy dla dowolnych x, y rzeczywistych

F(x, y) = FX(x)FY(y)

Dwuwymiarowa zmienna losowa (X, Y) ma rozkład skokowy je li zmienne losowe X i Y maj

sko czony lub przeliczalny zbiór warto ci.

Rozkład zmiennej losowej (X, Y) (ł czny rozkład zmiennych X i Y) okre la si za pomoc funkcji

prawdopodobie stwa lub dystrybuanty.

Funkcj prawdopodobie stwa skokowej zmiennej losowej (X, Y) przyjmuj cej warto ci

(xi, yj) jest

pij =P(X = xi, Y = yj) i, j = 1, 2, ...

przy czym pij ≥ 0 oraz

pij = 1

i

j

Dystrybuant F(x, y) skokowej zmiennej losowej (X, Y) jest funkcja rzeczywista

F ( x, y ) =

xi < x y j < y

pij

Funkcj prawdopodobie stwa skokowej zmiennej losowej (X, Y) przyjmuj cej warto ci (xi, yj)

mo na zapisa w postaci tablicy:

18

L.Kowalski

Y

Wybrane zagadnienia z rachunku prawdopodobie stwa

y1

y2

.......

yl

pi.

x1

x2

p11

p21

p12

p22

.......

.......

p1l

p2l

p1.

p2.

....

....

....

....

....

.....

xk

p.j

pk1

p.1

pk2

p.2

.......

......

pkl

p.l

pk.

1

X

gdzie

x1, x2, .... , xk – warto ci zmiennej losowej X,

y1, y2, .... , yl – warto ci zmiennej losowej Y,

p.j – sumy prawdopodobie stw w kolumnach, p.j =

pij

i

pi. – sumy prawdopodobie stw w wierszach, pi. =

pij .

j

Uwaga.

pij = 1 .

i, j

Rozkładem brzegowym

prawdopodobie stwa:

xi

pi.

x1

p1.

Rozkładem brzegowym

prawdopodobie stwa:

yj

p.j

y1

p.1

zmiennej

x2

p2.

zmiennej

y2

p.2

losowej

X

nazywamy

...

...

rozkład

okre lony

funkcj

rozkład

okre lony

funkcj

xk

pk.

losowej

Y

nazywamy

.......

......

yl

p.l

Je li zmienna losowa (X, Y) jest skokowa to zmienne losowe X i Y s niezale ne gdy dla ka dej

pary (xi, yj) (i, j = 1, 2, ...) spełniony jest warunek:

P(X = xi, Y = yj) = P(X = xi)P(Y = yj)

Warunek ten mo na równie zapisa w postaci

pij = pi.⋅p.j

Przykład.

Rzucamy dwa razy kostk . X - liczba parzystych oczek w pierwszym rzucie, tzn. X = 0 lub X = 1.

Y - liczba jedynek w obu rzutach, tzn. Y = 0 lub Y = 1, lub Y = 2.

Funkcja rozkładu prawdopodobie stwa tej zmiennej losowej dana jest tabelk :

Y

X

0

1

p.j

0

1

2

pi.

10/36

15/36

25/36

7/36

3/36

10/36

1/36

0

1/36

18/36

18/36

1

Rozkłady brzegowe wyznaczone s przez brzegowe warto ci tej tabeli.

Rozkład brzegowy zmiennej losowej X :

xi

pi.

0

18/36

1

18/36.

19

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Rozkład brzegowy zmiennej losowej Y :

yj

p.j

0

25/36

1

10/36

2

1/36

(X, Y) nazywamy zmienn losow ci gł je li jej dystrybuanta da si przedstawi w postaci

F ( x, y ) =

x y

f ( s, t )dsdt

− ∞− ∞

dla pewnej nieujemnej funkcji f zwanej g sto ci .

Uwaga.

1.

∞ ∞

f ( x, y )dxdy = 1

− ∞− ∞

2. W punktach ci gło ci funkcji f zachodzi:

∂ 2 F ( x, y )

= f ( x, y )

∂x∂y

3. Dla A ∈ Β( R 2 ) mamy P( X ,Y ) ( A) =

f ( x, y ) dxdy .

A

Maj c g sto rozkładu ł cznego g sto ci rozkładów brzegowych wyznaczamy nast puj co.

Je li f(x, y) jest g sto ci zmiennej losowej (X,Y) to funkcje

f X ( x) =

∞

f ( x, y )dy;

∞

fY ( y ) =

−∞

f ( x, y )dx

−∞

s g sto ciami odpowiednich rozkładów brzegowych.

Je li ł czny rozkład (X, Y) jest ci gły, to zmienne losowe X,Y s niezale ne wtedy i tylko wtedy,

gdy dla dowolnych x, y rzeczywistych

f(x, y) = fX(x)fY(y)

Przykład.

Funkcja f(x, y) jest g sto ci zmiennej losowej (X,Y).

f ( x, y ) =

c

dla 0 ≤ x ≤ 2, 0 ≤ y ≤ 2

0

dla innych x, y

Przez całkowanie lub z interpretacji geometrycznej wynika, e c = 0,25 (bo pole rozpatrywanego

kwadratu wynosi 4).

Przez całkowanie lub z interpretacji geometrycznej wynika, e dystrybuanta tego rozkładu ma

posta

0

0,25 xy

F ( x, y ) = 0,5 x

0,5 y

1

x≤0 ∨ y≤0

0 < x ≤ 2, 0 < y ≤ 2

0 < x ≤ 2, y > 2

0 < y ≤ 2, x > 2

x > 2, y > 2

Rozkłady brzegowe to rozkłady jednostajne na przedziale [0, 2].

Zauwa my, e zmienne losowe X,Y s niezale ne.

Przykład

Funkcja

rozkładu

(X, Y) dana jest tabelk :

prawdopodobie stwa

20

zmiennej

losowej

dwuwymiarowej

L.Kowalski

Y

X

Wybrane zagadnienia z rachunku prawdopodobie stwa

–1

1

–1

1/6

1/6

0

1/3

0

1

1/6

1/6

p.j

2/3

1/3

rozkład warunkowy zmiennej losowej X

prawdopodobie stwa

pi.

1/3

1/3

1/3

1

pod warunkiem, e Y = 1 jest okre lony przez funkcj

P(X= -1|Y = 1) = (1/6)/(1/3) = 1/2,

P(X= 0|Y = 1) = 0/(1/3) = 0,

P(X= 1|Y = 1) = (1/6)/(1/3) = 1/2,

Je li g sto

f1,...,k > 0 to rozkład zmiennej losowej ci głej (n - k) wymiarowej okre lonej wzorem:

f ( x k +1 , ..., x n | x1 , ..., x k ) =

f ( x1 , ..., xn )

f ( x1 , ..., x k )

nazywamy rozkładem warunkowym zmiennej losowej

( X 1 = x1 , ..., X k = xk ) .

( X k +1 ,

..., X n ) pod warunkiem,

Przykład.

Funkcja f(x, y) jest g sto ci zmiennej losowej (X,Y).

0,25

dla 0 ≤ x ≤ 2, 0 ≤ y ≤ 2

f ( x, y ) =

0

dla innych x, y

g sto

rozkładu warunkowego X|Y = 1 ma dla 0 < x < 2 posta 0,25/0,5 = 0,5; zatem

0

x ∉(0,2 )

f ( x | Y = 1) =

0,5

x ∈(0,2 )

Niezale no zmiennych losowych n - wymiarowych.

Zmienne losowe X1, X2, ..., Xn s niezale ne je li

F ( x1 , ..., x n ) = F1 ( x1 ) ⋅ F2 ( x2 )... ⋅ Fn ( x n ) dla dowolnych x1, x2, ..., xn ∈ Rn.

gdzie Fi - dystrybuanty rozkładów brzegowych jednowymiarowych.

Dla zmiennych losowych skokowych odpowiedni warunek ma posta :

P( X 1 = x1 j , ..., X n = xnj ) = P1 ( X 1 = x1 j ) ⋅ ... ⋅ Pn ( X n = xnj )

dla dowolnych x1 j , ..., x nj ∈ R n

Dla zmiennych losowych ci głych odpowiedni warunek ma posta :

f ( x1 , ..., xn ) = f1 ( x1 ) ⋅ f 2 ( x2 ) ⋅ ... ⋅ f n ( xn )

dla dowolnych x1, x2, ..., xn ∈ Rn.

Je li zmienne losowe X1, X2, ..., Xn s niezale ne to funkcje od nich te s niezale ne.

Wybrane parametry zmiennej losowej dwuwymiarowej

Kowariancj zmiennych losowych (X, Y) nazywamy wielko

Cov(X, Y) = E[(X – EX)(Y – EY)] = E(XY) – E(X)E(Y)

Dla zmiennej losowej skokowej (X, Y) mamy:

21

e

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

k

E(XY) =

l

i =1 j =1

Cov(X, Y) =

k

l

xi y j pij

xi y j pij − EX ⋅ EY

i =1 j =1

Dla zmiennej losowej ci głej (X, Y) mamy:

E(XY) =

Cov(X, Y) =

∞ ∞

xyf ( x, y )dxdy

−∞−∞

∞ ∞

xyf ( x, y )dxdy − EX ⋅ EY

−∞ − ∞

Uwaga

a) Dla zmiennych losowych niezale nych Cov(X, Y) = 0, zatem zmienne losowe niezale ne s

nieskorelowane (odwrotna własno nie zachodzi – patrz przykład),

2

b) Cov(X, X) = D X,

2

2

2

c) D (X + Y) = D X + D Y +2Cov(X, Y),

X, Y – dowolne zmienne losowe

Unormowan kowariancj nazywamy współczynnikiem korelacji mi dzy zmiennymi X i Y:

ρ = ρ ( X ,Y ) =

Cov( X , Y )

( DX ) ⋅ ( DY )

Współczynnik korelacji mierzy „sił ” zale no ci liniowej mi dzy zmiennymi

X i Y.

Własno ci współczynnika korelacji:

a) − 1 ≤ ρ ( X , Y ) ≤ 1

b) dla niezale nych zmiennych losowych współczynnik korelacji jest równy zero,

c) je eli współczynnik korelacji jest dodatni, to mi dzy zmiennymi X i Y istnieje zale no

liniowa

dodatnia, co oznacza, e ze wzrostem warto ci jednej zmiennej rosn rednie warto ci drugiej

zmiennej,

d) je eli współczynnik korelacji jest ujemny, to mi dzy zmiennymi X i Y istnieje zale no liniowa

ujemna, co oznacza, e ze wzrostem warto ci jednej zmiennej malej rednie warto ci drugiej

zmiennej,

e) je eli współczynnik korelacji jest równy 1 lub – 1, to mi dzy zmiennymi X i Y istnieje funkcyjna

zale no liniowa,

Je eli współczynnik korelacji jest równy 0 to mówimy, e zmienne losowe X i Y s

nieskorelowane.

Macierz

K=

D2 X

Cov( X ,Y )

Cov(Y , X )

D 2Y

nazywamy macierz kowariancji

Przykład

Funkcja rozkładu prawdopodobie stwa zmiennej losowej dwuwymiarowej

(X, Y) dana jest tabelk :

Y

X

–1

0

1

p.j

–1

0

1

pi.

1/6

1/3

1/6

2/3

0

0

0

0

1/6

0

1/6

1/3

1/3

1/3

1/3

1

22

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Obliczymy współczynnik korelacji mi dzy tymi zmiennymi.

Rozkład brzegowy zmiennej losowej X:

xi

pi.

–1

1/3

0

1/30

1

1/3

EX = 0

Rozkład brzegowy zmiennej losowej Y:

yj

p.j

–1

2/3

0

0

1

1/3

EY = – 1/3

Poniewa

E(XY) = (– 1)⋅(– 1) ⋅1/6 + – 1) ⋅1⋅1/6 + 1⋅ (– 1) ⋅1/6 + 1⋅1⋅1/6 = 0 ,

Cov(X, Y) = 0

to

ρ = 0.

EX⋅EY = 0;

Zatem zmienne X, Y s nieskorelowane.

Uwaga. Zauwa my, e powy sze zmienne losowe chocia s zale ne to s nieskorelowane.

Zakładamy, e macierz kowariancji K istnieje.

Regresja I rodzaju Y wzgl dem X = zbiór punktów (x, E(Y|x)).

Regresja I rodzaju X wzgl dem Y = zbiór punktów (E(X|y),y).

Gdzie E(Y|x), E(X|y) to warunkowe warto ci oczekiwane.

Linie regresji I rodzaju tylko w szczególnych przypadkach s liniami prostymi.

Twierdzenie.

E ((Y − ϕ ( X )) 2 ) osi ga warto

najmniejsz gdy ϕ ( x) = E (Y | x) z prawdopodobie stwem 1.

Je li poszukujemy funkcji liniowej minimalizuj cej wyra enie E ((Y − ϕ ( X )) 2 ) to otrzymamy prost

regresji zwan prost regresji II rodzaju.

σY

σ

x + mY − ρ Y m X .

σX

σX

σX

σ

y + mX − ρ X mY .

Regresja II rodzaju X wzgl dem Y to prosta x = ρ

σY

σY

Regresja II rodzaju Y wzgl dem X to prosta y =

ρ

Powy sze poj cia regresji mo na uogólni na przypadek n - wymiarowych zmiennych losowych.

W szczególno ci hiperpłaszczyzna regresji II rodzaju Zmiennej X1 wzgl dem zmiennych

X2, X3, ...,Xn ma równanie

x1 - EX1 = a12(x2 - EX2) + ...+ a1n(xn - EXn)

gdzie K1i s dopełnieniami algebraicznymi elementów k1i macierzy

kowariancji K.

Parametry zmiennej losowej n - wymiarowej.

T

Warto oczekiwana E ( X ) = [EX 1 , EX 2 , ..., EX n ] .

Moment (zwyczajny) rz du l1 + l2 + ...+ ln

23

a1i = −

K1i

K11

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

(

)

ml1 l2 ...ln = E X 1l1 X 2l2 ... X nln ,

Moment centralny rz du l1 + l2 + ...+ ln

(

)

µ l l ...l = E (X 1 − EX 1 ) ...(X n − EX n ) ,

Macierz kowariancji

K = [kij], gdzie

k ij = cov( X i , X j ) = E [( X i − EX i )(X j − EX j )] = E (X i X j ) − E ( X i )E (X j )

Uwaga kii = D2Xi, jest wariancj i - tej składowej.

Macierz K jest kwadratowa, symetryczna i słabo dodatnio okre lona (w szczególno ci ma

wyznacznik nieujemny).

Macierz korelacji R = [ρij], gdzie ρij = cov(Xi , X j )

1 2

n

l1

ln

DXi ⋅ DX j

Uwaga ρii = 1.

Rozkład normalny 2-wymiarowy

Zmienna losowa (X, Y) o rozkładzie normalnym 2-wymiarowym zale y od pi ciu parametrów: m1,

m2, σ1, σ2, ρ.

m1 = EX; m2 = EY; σ1 = DX; σ2 = DY; ρ = współczynnik korelacji.

Współczynnik korelacji musi spełnia warunek: ρ2 ≠ 1.

σ 12

ρσ 1σ 2

Macierz kowariancji K ma wtedy posta K =

G sto

ρσ 1σ 2

.

σ 22

rozkładu normalnego 2-wymiarowego N(m1, m2, σ1, σ2, ρ) mo na zapisa nast puj co:

f (x, y) =

1

2πσ1 σ 2 1 − ρ 2

⋅ exp −

1

2 1− ρ 2

(

)

(x − m1 )2 − 2ρ (x − m1 )( y − m2 ) + ( y − m2 )2

σ12

σ1 σ 2

σ 22

Twierdzenie

Dowolny rozkład brzegowy normalnego rozkładu 2-wymiarowego jest rozkładem normalnym.

Twierdzenie

Je li składowe normalnego rozkładu 2-wymiarowego s nieskorelowane to s niezale ne.

TWIERDZENIA GRANICZNE

Zbie no ci gu zmiennych losowych z prawdopodobie stwem 1 (prawie napewno)

Ci g zmiennych losowych (Xn) jest zbie ny do zmiennej losowej X z prawdopodobie stwem 1 je li

({

})

P ω : lim X n (ω ) = X (ω ) = 1

n →∞

redniokwadratowa zbie no ci gu zmiennych losowych

Ci g zmiennych losowych (Xn) jest redniokwadratowo zbie ny do zmiennej losowej X je li

(

lim E X n − X

n→∞

2

)= 0

Rozpatruj c ten rodzaj zbie no ci zakładamy, e dla wyst puj cych tu zmiennych losowych (Xn), X

istnieje sko czony moment rz du 2.

Niekiedy stosuje si zapis l.i.m. X n = X (skrót od „limit in mean”).

24

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

Stochastyczna zbie no ci gu zmiennych losowych

Ci g zmiennych losowych (Xn) jest stochastycznie (wg prawdopodobie stwa) zbie ny do zmiennej

losowej X je li

∧

lim P( X n − X < ε ) = 1

∧

lim P( X n − X ≥ ε ) = 0

ε >0

lub równowa nie

ε >0

n→∞

n→∞

Zbie no ci gu zmiennych losowych wg dystrybuant (wg rozkładu)

Ci g zmiennych losowych (Xn) jest zbie ny do zmiennej losowej X wg dystrybuant je li ci g ich

dystrybuant Fn jest zbie ny do dystrybuanty F w ka dym punkcie jej ci gło ci (F jest dystrybuant

zmiennej losowej X).

Zale no ci miedzy zbie no ciami.

ZBIE NO Z

PRAWDOPODOBIE STWEM 1

ZBIE NO

REDNIOKWADRATOWA

ZBIE NO

STOCHASTYCZNA

zbie no do stałej

(tzn. gdy granica ma rozkład

jednopunktowy)

ZBIE NO WG

DYSTRYBUANT

Uwaga.

Punktowa granica ci gu dystrybuant nie musi by dystrybuant .

Je li ci g funkcji charakterystycznych odpowiadaj cych rozpatrywanemu ci gowi dystrybuant jest

punktowo zbie ny do funkcji ci głej to granica tych dystrybuant jest dystrybuant .

Centralne twierdzenie graniczne Lindeberga – Levy'ego

Je li niezale ne zmienne losowe Xi (i = 1, 2, ..., n) maj taki sam rozkład oraz istnieje E(Xn) = m i

D2(Xn) = σ2 > 0 to ci g dystrybuant (Fn) standaryzowanych rednich arytmetycznych X n (lub

standaryzowanych sum n X )

i =1

i

n

Yn =

Xn −m

σ/ n

=

jest zbie ny do dystrybuanty Φ rozkładu N(0, 1).

Wniosek

Dla du ych n (w praktyce n ≥ 30)

25

i =1

X n − mn

σ n

L.Kowalski

Wybrane zagadnienia z rachunku prawdopodobie stwa

n

P a≤

i =1

X i − nm

σ n

< b ≅ Φ (b) − Φ ( a)

W przypadku szczególnym gdy Xi (i = 1, 2, ..., n) maja rozkład zerojedynkowy to powy sze

twierdzenie nazywamy twierdzeniem Moivre'a-Laplace'a

(zmienne losowe Yn =

n

i =1

X i maj rozkład dwumianowy).

Wniosek z twierdzenia Moivre'a-Laplace'a:

P a≤

Yi − np

npq

< b ≅ Φ (b) − Φ (a )

Uwaga. Powy sze twierdzenia wskazuj na wa n rol rozkładu normalnego.

Przykład

Wadliwo partii arówek wynosi 0,01. Z tej partii arówek wylosowano 625 arówek. Obliczy

prawdopodobie stwo, e w ród wylosowanych arówek b dzie mniej ni 10 wadliwych,

Rozwi zanie.

Yn – liczba wadliwych arówek w ród wylosowanych,

P(Yi < 10) = P

Yi − 625⋅ 0,01

10− 625⋅ 0,01

<

≅

625⋅ 0,01⋅ 0,99

625⋅ 0,01⋅ 0,99

≅ Φ(1,51) = 0,93448

Prawo wielkich liczb Chinczyna

(Xi) – ci g niezale nych zmiennych losowych o takim samym rozkładzie oraz niech istnieje E(Xi) =

m.

n

Wtedy ci g Yn = 1 X i jest zbie ny stochastycznie do m.

n

i =1

Wniosek

Dla du ych n je li istnieje D2(Xn) = σ2 > 0 to

∧

ε >0

P (Yn − m < ε ) ≅ 2Φ

ε n

−1

σ

Przypadek szczególny – prawo wielkich liczb Bernoulliego:

(Xi) – ci g niezale nych zmiennych losowych o rozkładzie dwumianowym wtedy ci g X n jest

n

stochastycznie zbie ny do p.

Wniosek

Dla du ych n:

∧

ε >0

P

Xn

ε n

− p < ε ≅ 2Φ

−1

n

pq

26