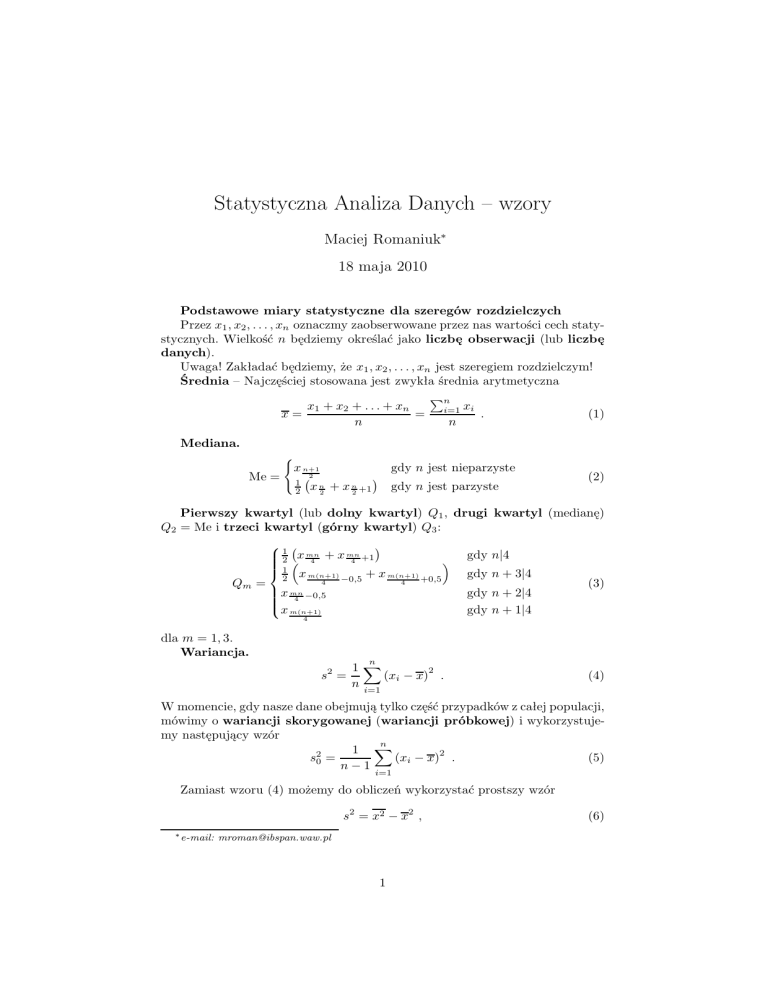

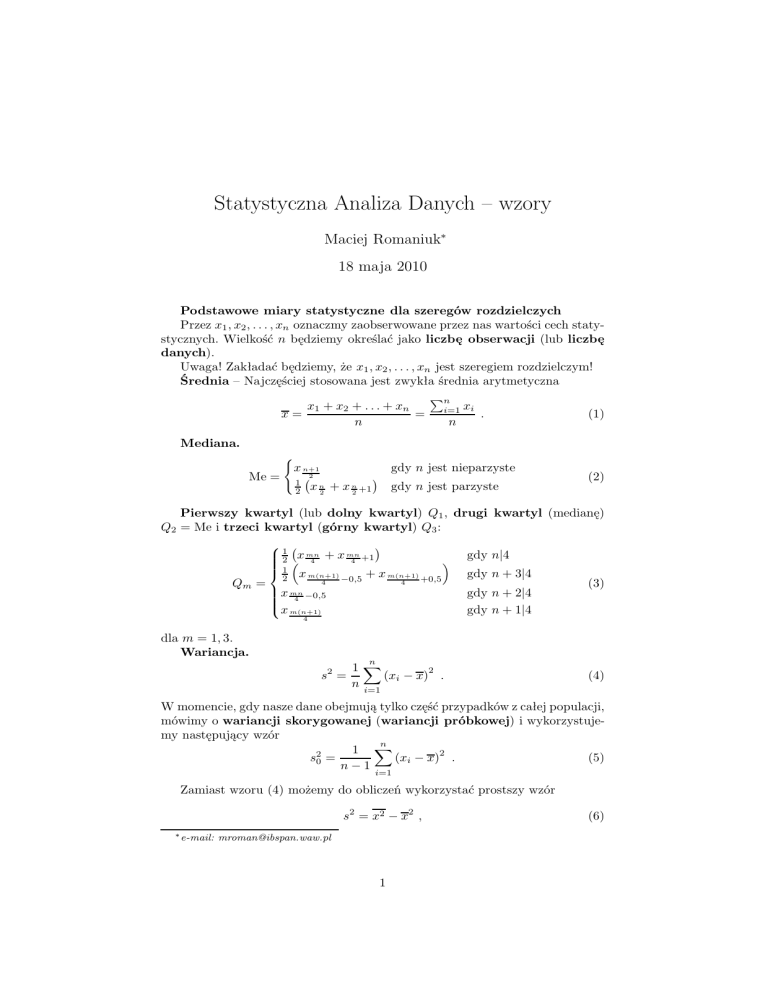

Statystyczna Analiza Danych – wzory

Maciej Romaniuk∗

18 maja 2010

Podstawowe miary statystyczne dla szeregów rozdzielczych

Przez x1 , x2 , . . . , xn oznaczmy zaobserwowane przez nas wartości cech statystycznych. Wielkość n będziemy określać jako liczbę obserwacji (lub liczbę

danych).

Uwaga! Zakładać będziemy, że x1 , x2 , . . . , xn jest szeregiem rozdzielczym!

Średnia – Najczęściej stosowana jest zwykła średnia arytmetyczna

Pn

xi

x1 + x2 + . . . + xn

x=

= i=1

.

(1)

n

n

Mediana.

Me =

(

gdy n jest nieparzyste

x n+1

2

x n2 + x n2 +1

1

2

gdy n jest parzyste

(2)

Pierwszy kwartyl (lub dolny kwartyl) Q1 , drugi kwartyl (medianę)

Q2 = Me i trzeci kwartyl (górny kwartyl) Q3 :

Qm =

1

mn

mn

2 x 4 + x 4 +1

1 x m(n+1)

+ x m(n+1)

2

4

−0,5

4

gdy n|4

+0,5

x mn

−0,5

4

x m(n+1)

gdy n + 3|4

gdy n + 2|4

gdy n + 1|4

(3)

4

dla m = 1, 3.

Wariancja.

n

s2 =

1X

2

(xi − x) .

n i=1

(4)

W momencie, gdy nasze dane obejmują tylko część przypadków z całej populacji,

mówimy o wariancji skorygowanej (wariancji próbkowej) i wykorzystujemy następujący wzór

n

1 X

s20 =

(xi − x)2 .

(5)

n − 1 i=1

Zamiast wzoru (4) możemy do obliczeń wykorzystać prostszy wzór

s2 = x2 − x2 ,

∗ e-mail:

[email protected]

1

(6)

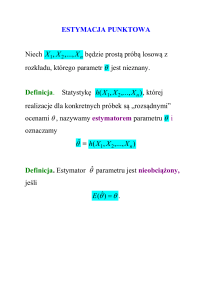

gdzie

n

x2 =

Odchylenie standardowe s:

1X 2

x .

n i=1 i

v

u n

√

u1 X

2

(xi − x)2 .

s= s =t

n i=1

(7)

(8)

Uwaga! Podobnie jak w przypadku wariancji, wzór (8) wykorzystujemy dla

populacji (odchylenie standardowe populacyjne), a dla próbki przyjmujemy wzór

v

u

n

q

u 1 X

2

2

s0 = s0 = t

(xi − x) .

(9)

n − 1 i=1

współczynnik zmienności

Vs =

s

.

x

(10)

Odchylenie przeciętne

n

d=

Odchylenie ćwiartkowe

1X

|xi − x|

n i=1

Q=

Q3 − Q1

.

2

Istnieje kilka różnych wzorów na miarę asymetrii

3

1 Pn

i=1 (xi − x)

n

As =

,

(s)3

(11)

(12)

(13)

x−D

,

(14)

s

Q3 + Q1 − 2 Me

As(Me) =

.

(15)

2Q

Uwaga! Należy pamiętać, że są to różne wzory, tzn. nie muszą one dawać

takich samych wartości (i najczęściej nie dają)!

Miara koncentracji (zwana też współczynnikiem spłaszczenia lub kurtozą)

4

1 Pn

i=1 (xi − x)

n

−3 .

(16)

K=

(s2 )2

As(D) =

Jeśli populacja, którą badamy składa się z różnych podpopulacji (czyli podzbiorów całej zbiorowości) i jeśli znamy wartości średnich x(1) , . . . x(m) dla m

dla tych podpopulacji oraz ich liczności n(1) , . . . , n(m) , to wtedy średnia (zwana

czasami wielką średnią) jest równa

Pm (i) (i)

x n

x = i=1

.

(17)

n

2

Oprócz średniej arytmetycznej, w statystyce wykorzystywana jest średnia

harmoniczna i średnia geometryczna.

Średnia harmoniczna dana jest wzorem

n

xH = Pn

1

i=1 xi

.

(18)

Średnia geometryczna jest przydatna wszędzie tam, gdzie rozpatrujemy tzw.

indeksy łańcuchowe, czyli dane o postaci

x1 =

y1

y2

yn

, x2 =

, . . . , xn =

.

y0

y1

yn−1

Wzór na średnią geometryczną jest następujący

√

xG = n x1 x2 . . . xn .

(19)

(20)

Histogram Liczba klas

k = 1 + 3, 322 log n

(21)

lub

√

3√

n¬k¬ n,

(22)

4

gdzie k jest poszukiwaną liczbą klas.

Statystyka opisowa dla danych grupowanych

Dane grupowane (dane przedziałowe) przedstawione są za pomocą cią(d)

(g)

(d)

(g)

gu granic wartości przedziałów x1 , x1 , x2 , . . . , xm oraz ciągu liczności ob(d)

(g)

serwacji zawartych w poszczególnych przedziałach i1 , i2 , . . . , im . Liczby xi , x1

oznaczają hzatem początek

i koniec i-tego przedziału (zazwyczaj zapisywanego

(d)

(g)

w postaci xi ; xi

(d)

xi+1

), a ni to liczba danych w tym przedziale. Bardzo często

(g)

xi .

=

Średnią otrzymujemy ze wzoru

x=

ẋ1 n1 + . . . + ẋm nm

,

n

(23)

gdzie ẋi jest środkiem i-tego przedziału, a n = n1 +. . .+nm jest liczbą wszystkich

obserwacji.

Z kolei mediana dana jest wzorem

PkMe −1

n

ni

i=1

2 −

Me = xMe +

iMe ,

(24)

nMe

gdzie xMe jest dolnym krańcem przedziału, w którym znajduje się mediana,

kMe – numerem przedziału, w którym znajduje się mediana, iMe – szerokością

przedziału, w którym znajduje się mediana, nMe – liczba danych w przedziale,

w którym jest mediana. Przedział, w którym znajduje się mediana jest to ten

przedział, w którym znajduje się obserwacja o numerze równym połowie ilości

obserwacji.

Kwartyle obliczane są według wzoru

Qj = xQj +

jn

4

−

3

PkQj −1

i=1

nQj

ni

iQj ,

(25)

gdzie użyte symbole mają podobne znaczenie co we wzorze (24). Przedziały,

w których znajdują się kwartyle są to te przedziały, w których znajdują się

obserwacje o numerze odpowiednio równym 25%n dla pierwszego kwartyla i

75%n dla trzeciego.

Wariancja liczona jest z wykorzystaniem formuły

m

1X

(ẋi − x)2 ni ,

n i=1

s2 =

(26)

a odchylenie standardowe jako

s=

√

s2 .

(27)

Wykorzystywane jest też odchylenie ćwiartkowe

Q=

Q1 − Q3

2

(28)

oraz odchylenie przeciętne

m

d=

1X

|ẋ − x| ni .

n i=1

(29)

Dominantę liczymy według wzoru

D = xD +

nD − nD−1

iD ,

(nD − nD−1 ) + (nD − nD+1 )

(30)

gdzie xD oznacza początek przedziału, w którym powinna znajdować się dominanta, nD – ilość danych w przedziale, w którym powinna być dominanta,

nD+1 – ilość danych w przedziale następnym, nD−1 – ilość danych w przedziale wcześniejszym. Przedział, w którym powinna być dominanta to przedział z

największą ilością obserwacji.

Współczynnik asymetrii liczymy według wzoru

Pm

1

(ẋ − x)3 ni

As = n i=1 3

(31)

(s)

lub według formuł dla As(D) i As(Me) , które są analogiczne jak dla szeregów

rozdzielczych.

Definicja 1. Silnią nazywamy funkcję f (n) : N → N, oznaczaną symbolem n!

i zdefiniowaną następującym wzorem rekurencyjnym:

0! = 1 , n! = (n − 1)! · n .

(32)

Permutacje Ilość ciągów (czyli zbiorów posiadających porządek), które możemy ułożyć z n elementów zbioru A określona jest wzorem n!.

Kombinacje Ilość sposobów wyboru podzbioru (czyli bez istotności porządku) k elementowego ze zbioru n elementowego wynosi

n

(33)

k

4

Wariacje bez powtórzeń Ilość ciągów k elementowych, które możemy

stworzyć ze zbioru n elementowego (przy czym k ¬ n) bez powtarzania wybranych elementów dana jest wzorem

n!

.

(n − k)!

(34)

Wariacje z powtórzeniami Ilość ciągów k elementowych, które możemy

stworzyć ze zbioru n elementowego z ewentualnym powtarzaniem wybranych

elementów dana jest wzorem

nk .

(35)

Definicja 2. Zdarzenia A i B nazwiemy niezależnymi, jeżeli

P(A ∩ B) = P(A) P(B) .

(36)

Definicja 3. Dystrybuanta zmiennej losowej X jest to funkcja F : R → R

określona wzorem

F (a) = P(X ¬ a) = P ({ω ∈ Ω : X(ω) ¬ a}) .

(37)

Uwaga! W niektórych książkach dystrybuanta jest zdefiniowana przy pomocy

nieco zmienionego warunku

F (a) = P(X < a) = P ({ω ∈ Ω : X(ω) < a}) .

(38)

Przedział ufności dla średniej w modelu normalnym ze znaną wariancją

Niech X1 , X2 , . . . , Xn będzie próbą z rozkładu normalnego N (µ, σ 2 ), przy

czym wartość σ 2 jest już nam znana. Mamy zatem wzór na przedział ufności w

postaci

σz 1+β σz 1+β

(39)

X̄ − √ 2 ; X̄ + √ 2

n

n

Przedział ufności dla średniej w przypadku nieznanego odchylenia

standardowego

Przedział ufności jest postaci

s0

s0

x̄ − √ t 1+β ,n−1 ; x̄ + √ t 1+β ,n−1 .

(40)

n 2

n 2

Przedział ufności dla wariancji

Podobnie jak poprzednio, niech X1 , X2 , . . . , Xn ∼ N (µ, σ 2 ). Przedział ufności ma postać

"

#

(n − 1)s20

(n − 1)s20

;

.

(41)

χ2(1+β)/2,n−1 χ2(1−β)/2,n−1

Wybrane rozkłady prawdopodobieństwa

Rozkład dwupunktowy

Doświadczenie losowe ma tylko dwa możliwe wyniki, zazwyczaj zapisywane

jako „1” i „0” (tak / nie, sukces / porażka, prawidłowy, nieprawidłowy, itd.).

5

Prawdopodobieństwo „sukcesu” jest równe p, gdzie oczywiście 0 ¬ p ¬ 1. Stąd

rozkład prawdopodobieństwa dany jest wzorem

P(X = 1) = p , P(X = 0) = 1 − p .

(42)

Ważniejsze charakterystyki: E X = p, Var X = p(1 − p).

Rozkład dwumianowy

Załóżmy, że mamy n niezależnych powtórzeń takiego doświadczenia losowego, które ma tylko dwa możliwe wyniki (zwane tradycyjnie porażką i sukcesem). Oznacza to, że n razy powtarzamy doświadczenie z rozkładu dwupunktowego. Przez p, jak poprzednio, oznaczmy prawdopodobieństwo sukcesu w pojedynczej próbie. Wtedy prawdopodobieństwo zajścia k sukcesów w n próbach

(czyli zdarzenia X = k) określone jest wzorem

n k

P(X = k) =

p (1 − p)n−k .

(43)

k

Ważniejsze charakterystyki: E X = np, Var X = np(1 − p). Tradycyjnie rozkład

ten zapisujemy skrótowo Bin(n; p).

Rozkład geometryczny

Załóżmy, że wykonujemy niezależne powtórzenia doświadczenia losowego,

które ma tylko dwa możliwe wyniki, aż do osiągnięcia sukcesu. Przez p

oznaczymy prawdopodobieństwo zajścia sukcesu w pojedynczej próbie. Wtedy

liczba wykonanych doświadczeń ma rozkład geometryczny. Niech X będzie tą

liczbą prób do momentu zajścia pierwszego sukcesu. Prawdopodobieństwo zdarzenia X = k (czyli na początku nastąpiło k − 1 porażek, a potem pierwszy

sukces) dane jest wzorem

P(X = k) = p(1 − p)k−1 ,

(44)

gdzie k = 0, 1, . . . Ważniejsze charakterystyki: E X = 1/p, Var X = (1 − p)/p2 .

Rozkład Poissona

Jeśli zmienna pochodzi z rozkładu Poissona, to jej rozkład prawdopodobieństwa opisany jest wzorem

P(X = k) =

λk −λ

e

k!

(45)

dla k = 0, 1, . . ., gdzie λ > 0 jest parametrem tego rozkładu. Tradycyjnie rozkład

ten oznaczamy skrótem Poiss(λ). Ważniejsze charakterystyki: E X = λ, Var X =

λ.

Rozkład jednostajny (równomierny)

Najprostszy z ciągłych rozkładów prawdopodobieństwa, oznaczany zazwyczaj skrotem U [a; b]. Jego gęstość na przedziale [a; b] opisana jest wzorem

f (t) =

1

.

b−a

(46)

Oznacza to zatem, że prawdopodobieństwo zaobserwowania wartości zmiennej

z dowolnego, małego przedziału o długości dx jest stałe i takie samo na całym

(b−a)2

przedziale [a; b]. Ważniejsze charakterystyki: E X = a+b

2 , Var X =

12 .

Rozkład wykładniczy

6

Zmienna losowa X pochodzi z rozkładu wykładniczego (co zapisujemy X ∼

Ex(λ)), jeśli gęstość f (.) jest równa

f (t) = λe−λt

(47)

dla t ­ 0 i f (t) = 0 dla t < 0. Ważniejsze charakterystyki: E X = λ, Var X = λ.

Rozkład normalny

Jeden z najważniejszych w statystyce rozkładów. Zmienna losowa X pochodzi z rozkładu normalnego (co zapisujemy X ∼ N (µ, σ 2 )), jeśli gęstość f (.) jest

równa

1

(t − µ)2

f (t) = √ exp −

,

(48)

2σ 2

σ 2π

gdzie σ > 0. Parametr µ nazywamy wartością oczekiwaną (lub średnią), a σ 2 –

wariancją.

Rozkład t-Studenta (rozkład t)

Rozkład bardzo często wykorzystywany w wielu testach statystycznych. Zmienna losowa X pochodzi z rozkładu t-Studenta (w skrócie rozkładu t, co zapisujemy

X ∼ t(n)), jeśli gęstość f (.) ma postać

f (t) =

− n+1

2

Γ n+1

t2

2

1

+

,

n √

n

Γ 2

nπ

(49)

gdzie parametr n ∈ N+ zwany jest stopniami swobody (lub liczbą śladów).

Ważniejsze charakterystyki (dla n > 2, dla mniejszej liczby stopni swobody

n

niektóre momenty nie istnieją): E X = 0, Var X = n−2

.

Dla n → ∞ wykres gęstości tego rozkładu coraz bardziej przypomina gęstość

standardowego rozkładu normalnego.

Rozkład χ2 (chi-kwadrat)

Rozkład bardzo często wykorzystywany w wielu testach statystycznych. Zmienna losowa X pochodzi z rozkładu chi-kwadrat, co zapisujemy X ∼ χ2 (n), jeśli

gęstość f (.) ma postać

n

t

t 2 −1 e− 2

(50)

f (t) = n

2 2 Γ n2

dla t > 0, przy czym parametr n ∈ N+ zwany jest ilością śladów. Wykres gęstości

ma postać „wolno przesuwającej się górki”.

Przykłady testów statystycznych

Test proporcji / frakcji Test, sprawdzający hipotezę

H0 : p = p 0

(51)

dla pewnego ustalonego p0 względem hipotezy alternatywnej

H1 : p 6= p0

(52)

przy założeniu, że obserwacje pochodzą z pewnego rozkładu dwumianowego.

Otóż H0 odrzucamy, jeśli

p

|X − np| > z1−α/2 np(1 − p) ,

(53)

gdzie z1−α/2 jest kwantylem standardowego rozkładu normalnego o rzędzie 1− α2 .

7

Porównywanie dwóch proporcji / frakcji Zakładamy, że analizowane

dane są realizacjami dwóch zmiennych losowych o rozkładach dwumianowych z

prawdopodobieństwami sukcesu p1 i p2 (czyli X ∼ Bin(n1 ; p1 ) i Y ∼ Bin(n2 ; p2 ).

Będziemy weryfikować hipotezę postaci

H0 : p 1 = p 2

(54)

na poziomie istotności α przeciw hipotezie

H1 : p1 6= p2

(55)

Oznaczmy przez n1 i n2 liczbę danych w pierwszej i drugiej grupie obserwacji

(czyli liczności w odpowiednich rozkładach dwumianowych), a przez k1 i k2 liczby zajść zdarzeń, które „nas interesują” (tzn. są opisywane przez odpowiednie

zmienne). Na początku obliczamy następującą statystykę:

r

n1 + n2

z = (n2 k1 − n1 k2 ) ·

.

(56)

n1 n2 (k1 + k2 ) (n1 + n2 − k1 − k2 )

Nie ma podstaw do odrzucenia hipotezy zerowej, jeżeli wartość bezwzględna

obliczonej statystyki z jest mniejsza od kwantyla standardowego rozkładu normalnego z1−α . Hipotezę zerową odrzucamy na korzyść hipotezy: p2 > p1 , gdy

obliczona statystyka jest mniejsza od −zβ . Gdy statystyka ta jest większa od

zβ , odrzucamy H0 na korzyść hipotezy: p1 > p2 .

Test χ2 niezależności

Rozpatrujemy zmienne losowe X i Y , których wartości należą do rozłącznych

kategorii: x(1) , x(2) , ..., x(k) (dla zmiennej X) oraz y (1) , y (2) , ..., y (r) (dla zmiennej

Y ). Naszym celem jest weryfikacja hipotezy

H0 : X i Y są niezależne,

(57)

wobec hipotezy alternatywnej

H1 : istnieje zależność pomiędzy X i Y .

(58)

Niech nij oznacza liczbę obserwacji, dla których zmienna X należy do kategorii

x(i) oraz zmienna Y należy do kategorii y (j) . Symbolem ni. oznaczamy całkowitą

liczbę obserwacji, dla których zmienna X należy do kategorii x(i) , a symbolem

n.j – całkowitą liczbę obserwacji, dla których zmienna Y należy do kategorii

y (j) . Zatem

r

k

X

X

ni. =

nij oraz n.j =

nij .

(59)

j=1

i=1

Niech n oznacza całkowitą liczbę obserwacji. Dla i = 1, 2, ..., k i j = 1, 2, ..., r

wyznaczamy liczebności teoretyczne według następującego wzoru

n̂ij =

ni. · n.j

.

n

(60)

Aby zweryfikować hipotezę zerową obliczamy wartość statystyki danej formułą

χ2 =

k X

r

X

n2ij

i=1 j=1

8

n̂ij

−n

(61)

lub równoważnie

χ2 =

k X

r

X

(nij − n̂ij )2

.

n̂ij

i=1 j=1

(62)

Hipotezę zerową odrzucamy na poziomie istotności α, jeżeli χ2 > χ21−α;(k−1)·(r−1) .

Jeżeli k = r = 2, statystykę χ2 można obliczyć posługując się prostszym

wzorem:

2

χ2 =

n (n11 n22 − n21 n12 )

.

(n11 + n12 ) (n21 + n22 ) (n11 + n21 ) (n12 + n22 )

(63)

Podstawowymi założeniami dla prawidłowego przeprowadzenia testu jest duża

liczba obserwacji (n > 100) oraz nij > 5 dla i = 1, 2, ..., k i j = 1, 2, ..., r.

Test χ2 zgodności

Załóżmy mianowicie, że zmienna losowa X przyjmować może jedynie wartości x(1) , . . . , x(k) , z których każda przyjmowana jest z pewnym ustalonym prawdopodobieństwem p(1) , . . . , p(k) . Chcemy dokonać testu hipotezy zerowej

(1)

(k)

H0 : p(1) = p0 , . . . , p(k) = p0

(1)

(64)

(k)

dla przyjętych przez nas liczbowych wartości p0 , . . . , p0 . Przez nj oznaczymy

liczbę obserwacji, które mają wartość x(j) . W celu weryfikacji hipotezy zerowej

obliczamy statystykę

2

(i)

k

ni − np0

X

χ2 =

.

(65)

(i)

np0

i=1

Jeśli χ2 > χ21−α,k−1 , to odrzucamy H0 . Test ten możemy zastosować przy dostatecznie dużej liczebność próby n.

Testy porównywania średnich

Dla dwóch grup przykładem są tzw. testy t. W teście tym zakładamy, że

obserwujemy dwie próby X1 , X2 , . . . , Xn1 oraz Y1 , Y2 , . . . , Yn2 , przy czym zakładamy, że X1 , X2 , . . . , Xn1 ∼ N (µX , σ 2 ) oraz Y1 , Y2 , . . . , Yn1 ∼ N (µY , σ 2 ).

Hipoteza zerowa ma postać

H0 : µX = µY .

(66)

Jak widzimy, chcemy sprawdzić hipotezę o równości średnich, przy założeniu,

że nieznana wariancja jest taka sama w obydwu próbach i wynosi σ 2 .

Przez x oznaczymy średnią dla pierwszej próby („iksów”), przez y – średnią

dla drugiej próby („igreków”), przez s2X – empiryczną wariancję obliczoną dla

pierwszej próby, a przez s2Y – empiryczną wariancję obliczoną dla drugiej próby.

Wtedy statystyka testowa ma postać

s

x−y

n1 n2 (n1 + n2 − 2)

T = p

.

(67)

2

2

n1 + n2

n 1 sX + n 2 sY

Hipotezę (66) odrzucamy, jeśli

|T | ­ t 1+β ;n1 +n2 −2 .

2

Analiza regresji

9

(68)

Kowariancja i korelacja liniowa

Kowariancja empiryczna dana jest wzorem

n

X

ˆ (X,Y ) = 1

Cov

(xi − x̄) (yi − ȳ) ,

n i=1

(69)

gdzie n jest liczbą par obserwacji, a (x1 , y1 ), (x2 , y2 ), . . . , (xn , yn ) jest szeregiem

statystycznym obserwacji dla zmiennych (X, Y ). Wzór (69) można przedstawić

także w postaci

ˆ (X,Y ) = xy − x̄ · ȳ ,

Cov

(70)

gdzie

n

xy =

1X

xi · yi .

n i=1

(71)

Wykorzystuje się współczynnik korelacji liniowej Pearsona

ρ(X,Y ) = ρ(Y,X) =

ˆ (X,Y )

Cov

,

sX · sY

(72)

gdzie sX i sY są odchyleniami standardowymi odpowiednio zmiennej X i zmiennej Y . Ponadto

Pn

i=1 (xi − x̄) (yi − ȳ)

ρ(X,Y ) = qP

.

(73)

n

2 Pn

2

(x

−

x̄)

·

(y

−

ȳ)

i

i

i=1

i=1

Prosta regresja liniowa Zakładać będziemy, że obserwujemy w pewnym

doświadczeniu pary (x1 , Y1 ), (x2 , Y2 ), . . . (xn , Yn ). Zmienną x będziemy nazywać

zmienną niezależną (objaśniającą), a Y – zmienną zależną (objaśnianą). Model analizy regresji zapisać możemy jako

Y = b1 x + b0 + ε ,

(74)

gdzie ε jest nieobserwowalnym przez nas błędem losowym, zmienna x – obserwowaną przez nas, deterministyczną zmienną, Y – obserwowaną przez nas zmienną

losową, b0 , b1 – nieznanymi parametrami funkcji regresji.

Funkcję

y = b1 x + b0

(75)

nazywamy prostą regresji.

W celu znalezienia wartości parametrów, musimy skonstruować ich estymatory. Wykorzystujemy do tego metodę najmniejszych kwadratów, która

polega na minimalizacji wartości

SSE =

n

X

i=1

2

(Yi − b1 xi − b0 )

(76)

względem poszukiwanych wartości b0 i b1 . Prowadzi to do następujących wzorów

na estymatory

Pn

i=1 (xi − x̄) Yi − Ȳ

Pn

b̂1 =

, b̂0 = Ȳ − b̂1 x̄ ,

(77)

2

i=1 (xi − x̄)

10

czyli

ˆ (x,Y )

Cov

, b̂0 = Ȳ − b̂1 x̄ .

s2x

b̂1 =

(78)

Niech

Ŷi = b̂1 xi + b̂0 .

(79)

Wartość Ŷi nazywać będziemy przewidywaną wartością zmiennej objaśnianej

(zależnej).

Wielkości

ε̂i = Yi − Ŷi = Yi − b̂1 xi − b̂0

(80)

nazywamy resztami.

Równanie (79) może w prosty sposób posłużyć do predykcji (czyli prognozowania) wartości zmiennej zależnej. Wystarczy obliczyć

Ŷ0 = b̂1 x0 + b̂0

(81)

Podstawowa tożsamość analizy wariancji i jej interpretacja Zachodzi

n

X

i=1

Yi − Ȳ

2

=

n X

i=1

Ŷi − Ȳ

2

n 2

X

+

Yi − Ŷi

,

(82)

i=1

co zapisujemy często jako

SST = SSR + SSE .

(83)

SSR

SSE

=1−

SST

SST

nazywany jest współczynnikiem dopasowania. Zachodzi

R2 =

R 2 = ρ2 ,

(84)

(85)

gdzie ρ jest poznanym wcześniej współczynnikiem korelacji liniowej.

Testy związane z analizą regresji Test F sprawdza prawdziwość hipotezy zerowej

H0 : b 1 = 0

(86)

wobec

H1 : b1 6= 0 .

(87)

SSR

,

MSE

(88)

W teście F obliczamy tzw. statystykę F postaci

F =

gdzie

SSR =

n 2

X

Ŷi − Ȳ

(89)

i=1

i

MSE =

SSE

=

n−2

Pn

i=1

11

Yi − Ŷi

n−2

2

,

(90)

przy czym MSE nazywany jest błędem średniokwadratowym. Hipotezę H0

odrzucamy wtedy, gdy

F > F1−α,1,n−2 ,

(91)

gdzie symbol po prawej stronie oznacza kwantyl rozkładu F, o rzędzie 1 − α i

parametrach 1, n − 2.

Przedział ufności dla parametru b0 ma postać

P

P

MSE ni=1 x2i

MSE ni=1 x2i

b̂0 − t1−α/2,n−2 Pn

; b̂0 + t1−α/2,n−2 Pn

, (92)

n i=1 (xi − x̄)2

n i=1 (xi − x̄)2

a dla parametru b1

MSE

MSE

b̂1 − t1−α/2,n−2 Pn

; b̂1 + t1−α/2,n−2 Pn

.

2

2

i=1 (xi − x̄)

i=1 (xi − x̄)

(93)

Regresja wieloraka Nasz model analizy regresji przedstawić możemy jako

Y = b0 + b1 x.1 + . . . + bp x.p + ε ,

(94)

gdzie Y jest zmienną losową obserwowalną, x.1 , x.2 , . . . , x.p – zmiennymi deterministycznymi obserwowalnymi, ε – losowym, nieobserwowanym błędem. Model

można zapisać w postaci macierzowej

b

Y1

1 x11 . . . x1p 0

ε

b1 .1

.. ..

.

.

.

..

..

.. . + .. ,

(95)

. = .

..

Yn

1 xn1 . . . xnp

εn

bp

a w skrócie

Y = Xb + ǫ .

(96)

W celu znalezienia estymatorów parametrów stosujemy zmodyfikowaną metodę

najmniejszych kwadratów

T

min (Xb − Y) (Xb − Y) .

b0 ,...,bp

(97)

Estymatory najmniejszych kwadratów dane są wzorem

b̂ = XT X

−1

XT Y ,

(98)

gdzie b̂ = (b̂0 , . . . , b̂p )T .

Indeksy indywidualne

Indeksem jednopodstawowym nazywamy iloraz postaci

ij/k =

xj

,

xk

(99)

gdzie k nazywamy okresem (momentem) bazowym.

Indeksem łańcuchowym nazywamy iloraz postaci

ij/j−1 =

12

xj

.

xj−1

(100)

Średnia ruchoma W celu obliczenia średniej ruchomej tworzymy ciąg średnich

o postaci

x̄1:k =

x1 + x2 + . . . + xk

x2 + x3 + . . . + xk+1

, x̄2:k+1 =

,

k

k

xn−k+1 + xn−k+2 + . . . + xn

. . . , x̄n−k+1:n =

, (101)

k

gdzie k nazywamy szerokością okna w średniej ruchomej.

13