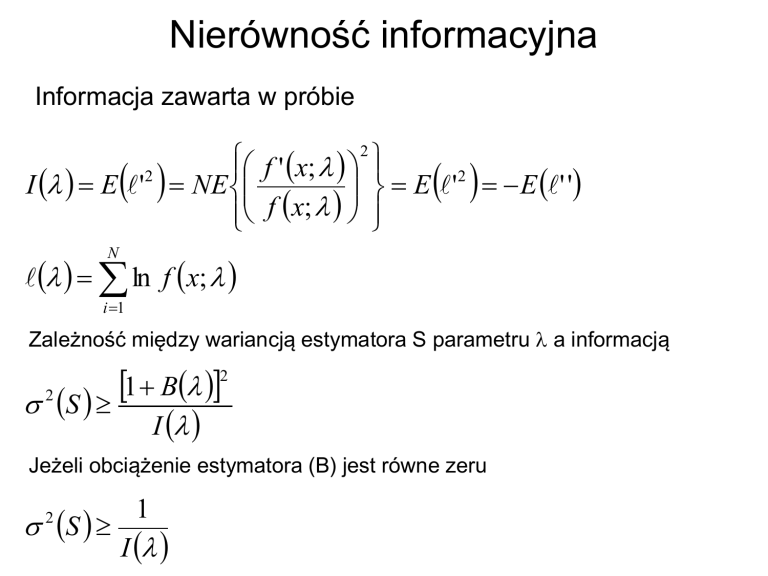

Nierówność informacyjna

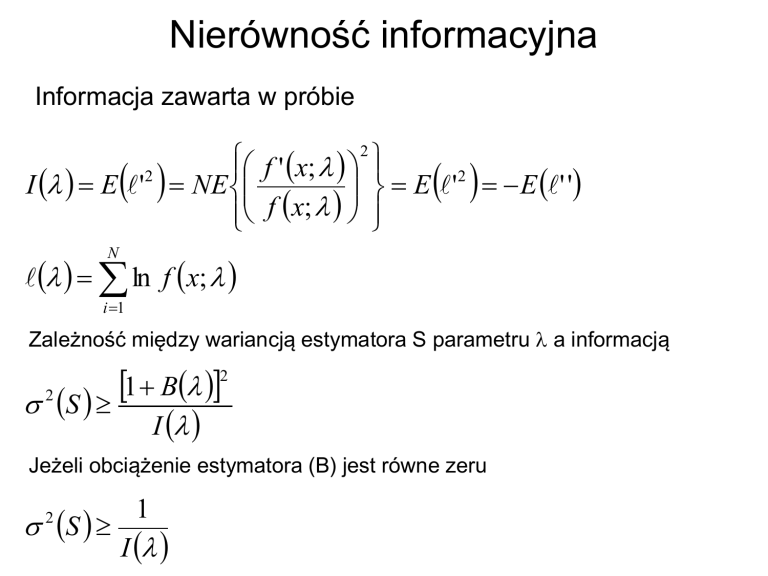

Informacja zawarta w próbie

2

f ' x;

2

E '2 E ' '

I E ' NE

f x;

N

ln f x;

i 1

Zależność między wariancją estymatora S parametru a informacją

2

1

B

2 S

I

Jeżeli obciążenie estymatora (B) jest równe zeru

S

2

1

I

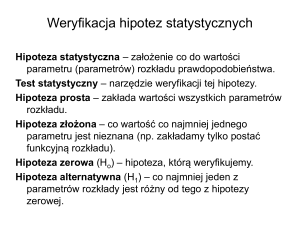

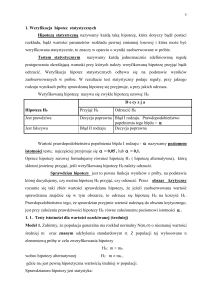

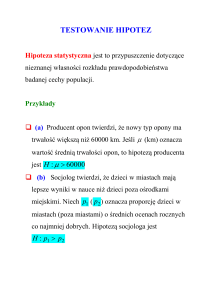

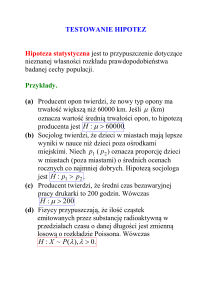

Weryfikacja hipotez statystycznych

Hipoteza statystyczna – założenie co do rozkładu

cech w populacji.

Test statystyczny – narzędzie weryfikacji tej

hipotezy.

Testy parametryczne: weryfikacja hipotez

parametrycznych, które dotyczą parametrów

rozkładu danej cechy w populacji generalnej.

Testy nieparametryczne: weryfikacja hipotez

nieparametrycznych dotyczących, np. zgodności

rozkładu cech w populacji z rozkładem

teoretycznym, zgodności rozkładów cech w

dwóch różnych populacjach, losowości próby.

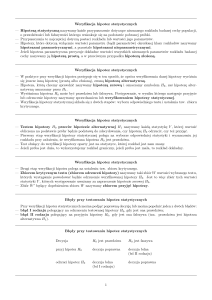

Hipotezy i testy parametryczne

Hipoteza prosta – zakłada wartości wszystkich

parametrów rozkładu.

Hipoteza złożona – wartość co najmniej jednego

parametru jest nieznana (np. zakładamy tylko

postać funkcyjną rozkładu).

Hipoteza zerowa (Ho) – hipoteza, którą

weryfikujemy.

Hipoteza alternatywna (H1) – co najmniej jeden z

parametrów rozkłady jest różny od tego z

hipotezy zerowej.

Błędy popełniane podczas weryfikacji hipotez

statystycznych

Błąd pierwszego rodzaju (false negative) –

odrzucenie prawdziwej hipotezy Ho.

Błąd drugiego rodzaju (false positive) –

przyjęcie fałszywej hipotezy Ho.

Poziom istotności (a)

P(|x|xo)=a

(test dwustronny)

P(xxo)=a

(test jednostronny)

Obszar krytyczny (Sc):

P(xSc|Ho)=a

Poziom istotności definiuje

prawdopodobieństwo popełnienia błędu

pierwszwego rodzaju (odrzucenia prawdziwej

hipotezy zerowej).

Moc testu: prawdopodobieństwo odrzucenia

hipotezy zerowej w zależności od hipotezy

alternatywnej.

M(Sc,)=P(XSc|H)=P(XSc|)

Test najmocniejszy hipotezy prostej Ho

względem hipotezy alternatywnej H1:

P(Sc,1)=1-b=max

Test jednostajnie najmocniejszy: test

najmocniejszy względem jakiejkolwiek hipotezy

alternatywnej.

Test F Fishera równości wariancji

Mamy dwie populacje o rozkładzie normalnym (np.

przypadek pomiaru tej samej wielkości różnymi

przyrządami). Pytanie: czy te populacje mają tą samą

wariancję. W tym celu rozważamy iloraz F=s12/s22

X 12

( N1 1) s12

f

2

2

1

1

f

2

2

f 2 X 12

F

f1 X 22

1

f

2

fs12

2

1

1

2 2 ( f 2)

X 22

( N 2 1) s22

1 2

exp

2

2

2

fs22

22

s12

X 12

W ( F ) P 2 F P 2 F

s2

X2

f1 f 2

f1 f 2

f1

F f1 1

2

2

f1

f

2

F 2 1 1 F

dF

f2

f 2 f1 f 2 0

2 2

s12

P 2 F1a 1 a

s2

Porównywanie wartości średnich (test

Studenta)

N

1

2

2

x j x

sx

N ( N 1) j 1

Nf

x

N

t x

x

sx

sx

x Nf

F (t ) P ( t ) P

t

1

1

( f 1)

(f 1) t

2

2

2

1

F( t )

d

f

1

f f

2

t 'a

1

0 f ()d 2 (1 a)

Weryfikacja hipotezy, że x=0

| x 0 | N

| t |

t 1

1 a

sx

2

Weryfikacja hipotezy o równości wartości średnich z dwóch

serii pomiarów

|| |x y|

| t |

s

s

N1 N 2 2

s s s

s

N1 N 2

2

s2

t

2

x

2

y

( N1 1) s x2 ( N 2 1) s y2

( N1 1) ( N 2 1)

s

x y

s

f N1 N 2 2

ta t

'

1

1 a

2

Przykład: porównywanie średnich z dwóch serii oznaczeń

azotu w cynchoninie

Grupa 1

Grupa 1

9,29

9,53

9,38

9,48

9,35

9,61

9,43

9,68

średnia

9,363

9,575

odch.stand.

0,058

0,088

3 0,0582 3 0,0882

44

s

0,0745; s

0,0745 0,0527

6

4 4

9,363 9,575

t

4,02; f 4 1 4 1 6; t (0,01,6) 3,71

0.0527

Test Studenta dla par wiązanych

Oznaczanie zawartości NaOH w dwóch seriach roztworu

po elektrolizie NaCl (mg/dm3) przed (x) i za filtrem (y)

x

y

d=y-x

100,1

96,6

-3,5

115,1

115,6

+0,5

sd 2,32

130,0

125,5

-4,5

f 8 1 7

93,6

94,0

+0,4

108,3

103,3

-5,0

137,2

134,4

-2,8

104,4

100,2

-4,2

97,3

97,3

0

d 2,40

t

2,40

8 2,93

2,32

P0,95 , 7 2,36

Wykrywanie błędów grubych: test

Dixona (nieparametryczny)

Q

x1 x2

xmax xmin

x1 – wynik podejrzany o błąd gruby

x2 – wynik mu najbliższy

Wynik x1 możemy odrzucić na poziomie istotności

a jeżeli Q > Q(a, n) (n jest liczbą pomiarów).

Wartości krytyczne testu Dixona

n

3

4

5

6

7

8

0.90

0.89

0.68

0.56

0.48

0.43

0.40

1-a

0.95

0.94

0.77

0.64

0.56

0.51

0.48

0.99

0.99

0.89

0.76

0.70

0.64

0.58

Przykład: pomiar zawartości grafitu w

żeliwie

1

2,86

2

2,89

3

2,90

4

2,91

5

2,99

2.99 2.91

Q

0.62

2.99 2.86

Q Q0,95 , 5

Testy nieparametryczne

• Testy losowości: badamy, czy próba jest losowa

– test mediany (Stevensa).

• Testy zgodności: badamy, czy rozkład z próby jest

zgodny z założonym

– Test 2, test W Shapiro-Wilka, test Kołmogorowa test

Lillieforsa (badanie normalności rozkładu).

• Testy jednorodności: badamy, czy dwie próby

pochodzą z tej samej populacji

– test serii Walda-Wolfowitza, test U Manna-Whitneya, test

Kołmogorowa-Smirnowa (dla prób niezależnych),

– test znaków, test kolejnosci par Wilcoxona (dla prób

zależnych).

Test 2 dobroci dopasowania

gi: wynik i-tego pomiaru

fi: wartość teoretyczna wyniku i-tego pomiaru

i: odchylenie standardowe i-tego pomiaru.

ui

gi fi

i

gi fi

T u

i

i 1

i 1

N

N

2

2

i

Wielkości ui mają rozkład normalny o zerowej średniej i jednostkowej wariancji a

zatem wielkość T ma rozkład 2 o N-p stopniach swobody, gdzie p jest liczbą

estymowanych parametrów funkcji f.

Dopasowanie uznajemy za złe na poziomie istotności a jeżeli T21a

Zastosowanie testu 2 do weryfikacji

hipotezy o rozkładzie częstości obserwacji

f(x)

}

}

}

}

1 2 … k … r

x

pi P( x i ) f ( x)dx

i

ni: liczba obserwacji wielkości w i-tym przedziale; n: całkowita

liczba obserwacji.

npi: wartość oczekiwana liczby obserwacji w i-tym przedziale

r

2

i 1

r

n ni

i 1

(ni npi )

2

i

2

(ni npi )

npi

i 1

r

2

Wartość oczekiwana wariancji

liczby obserwacji.

Hipotezę o zgodności rozkładu obserwowanego z rozkładem założonym

odrzucamy na poziomie istotności a jeżeli 221a dla f stopni swobody.

f=liczba stopni swobody=r-p-1 gdzie p jest liczbą parametrów rozkładu (najwyżej r-1

stopni swobody).

Przykład: porównanie liczby

zliczeń par elektron-pozyton w

komorze pęcherzykowej

naświetlonej promieniowaniem

g z rozkładem Poissona.

p(k )

k

e

k!

~

k nk / k!

2=10.44

20.99=16.81

Nie ma zatem podstaw do

odrzucenia rozkładu Poissona.

Zastosowanie testu 2 do analizy tabeli wkładów

x, y: zmienne losowe mogące przyjmować wartości odpowiednio

x1, x2,…, xk oraz y1, y2,…, yl.

Każdej kombinacji zmiennych (xi,yj) przyporządkowana jest

liczba obserwacji nij.

y1

y2

…

yl

x1 n11

n12

…

n1l

x2 n21

n22

…

n2l

… …

…

…

…

xk nk1

nk2

…

nkl

~

~ )2

(

n

n

p

q

ij

i j

2

n~

p q~

k

l

i 1 j 1

l

1

~

pi nij

n j 1

k

i

j

k

1

q~ j nij

n i 1

l

n nij

i 1 j 1

Jeżeli zmienne są współzależne na poziomie istotności a to 221a dla f=kl-1(k+l-2)=(k-1)(l-1) stopni swobody.

Przykład z medycyny: ocena skuteczności dwóch metod

leczenia danej choroby.

x1: pierwsza metoda leczenia

y1

y2

x1 n11=a n12=b

x2 n21=c n22=d

x2: druga metoda leczenia

y1: przypadki wyleczone

y2: przypadki niewyleczone

n(ad bc)

(a b)(c d )( a c)(b d )

2

2

f=liczba stopni swobody=(2-1)(2-1)=1

Jeżeli metody leczenia mają różną skuteczność to 221a

Test mediany (badanie losowości próby)

1. Wyznaczamy medianę (m).

2. Danym nieuporządkowanym przyporządkowujemy

następujące oznaczenia:

• A gdy x<m

• B gdy x>m

• 0 gdy x=m

3. Obliczamy liczbę następujących po sobie serii AAA…A i

BBB…B.

Liczby serii spełniają rozkład normalny z następującą

wartością średnią i wariancją

2na nb

E K

1

n

2na nb 2na nb 1

s K

n 2 n 1

2

na – liczba pomiarów A; nb – liczba pomiarów B; n – liczba pomiarów

Przykład (seria 12 pomiarów)

74,5

191,0

55,5

5,15

36,4

35,0

46,0

10,9

7,35

6,65

B

B

B

A

B

A

B

A

A

A

173,5

26,0

B

A

Mediana m=35,7

n=12, na=6, nb=6

Liczba serii k=8

E(k)=2*6*6/12+1=7, s2(k)=2*6*6*(2*6*6-1)/[12*12*(12-1)]=3.23

Dla a=5% (ok. 3s odchylenia) przedział ufności rozciąga się od

k=3 do k=10. Próba jest zatem losowa.

Test Wilcoxona (par wiązanych)

• W tabeli ustawiamy w pary odpowiadające

wielkości i obliczamy różnice.

• Sortujemy pary według różnic.

• Każdej parze przyporządkowujemy rangę, która

jest równa numerowi porządkowemu pary (po

sortowaniu), przy czym uśredniamy rangi,

którym odpowiadają te same różnice.

• Osobno sumujemy rangi dodatnie i ujemne.

• Mniejsza z tych sum stanowi statystykę W

Wilcoxona.

• Porównujemy W z wartością krytyczną i

odrzucamy hipotezę o identyczności wyników w

parach jeżeli W>Wtab.

Przykład: ocena różnic wysokości drzew wiosną i

jesienią

suma

W

3,2

2,7

3,1

J

3,5

3,0

3,8

d

0,3

0,3

0,7

ranga

5

5

10

znak

+

+

+

2,9

3,4

2,8

3,2

3,8

3,2

0,3

0,4

0,4

5

8,5

8,5

+

+

+

3,4

3,4

3,7

3,6

0,3

0,2

5

1,5

+

+

3,2

3,4

0,2

1,5

+

3,3

3,6

0,3

6

+

31,4

34,8

3,4

55

Dla dużych prób liczba znaków „+” spełnia rozkład

normalny z wartością średnią E(W+) i wariancją

s2(W+):

EW

nn 1

4

2

s W

nn 12n 1

24