Program Obliczeń Wielkich Wyzwań Nauki i Technki

20 IX 2012

Nr 4

W ramach projektu POWIEW

centrum kompetencji symulacji

złóż naturalnych zajmuje się

badaniem właściwości petrofizycznych skał roponośnych.

Centrum kompetencji

symulacji złóż naturalnych

Lokalizacja, a następnie eksploatacja

złóż naturalnych (np. ropy lub gazu) jest

bardzo skomplikowanym procesem, zarówno od strony inżynierskiej jak i od

strony modeli i metod numerycznych

wykorzystywanych w symulacjach komputerowych. Odpowiednie rozpoznanie

właściwości petrofizycznych skał roponośnych, takich jak porowatość czy przepuszczalność, jest kluczowe dla poprawnego i ekonomicznie wydajnego wykorzystania złóż naturalnych. Proces ten

jest wspierany i optymalizowany przez

złożone algorytmy i symulacje komputerowe.

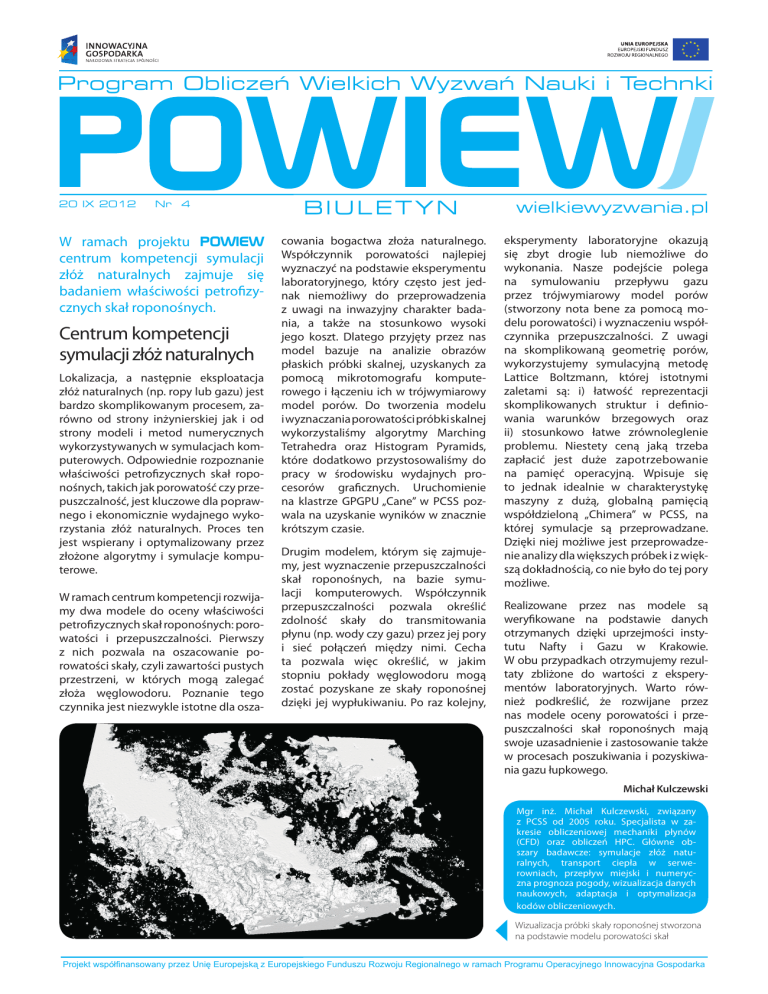

W ramach centrum kompetencji rozwijamy dwa modele do oceny właściwości

petrofizycznych skał roponośnych: porowatości i przepuszczalności. Pierwszy

z nich pozwala na oszacowanie porowatości skały, czyli zawartości pustych

przestrzeni, w których mogą zalegać

złoża węglowodoru. Poznanie tego

czynnika jest niezwykle istotne dla osza-

BIULETYN

cowania bogactwa złoża naturalnego.

Współczynnik porowatości najlepiej

wyznaczyć na podstawie eksperymentu

laboratoryjnego, który często jest jednak niemożliwy do przeprowadzenia

z uwagi na inwazyjny charakter badania, a także na stosunkowo wysoki

jego koszt. Dlatego przyjęty przez nas

model bazuje na analizie obrazów

płaskich próbki skalnej, uzyskanych za

pomocą mikrotomografu komputerowego i łączeniu ich w trójwymiarowy

model porów. Do tworzenia modelu

i wyznaczania porowatości próbki skalnej

wykorzystaliśmy algorytmy Marching

Tetrahedra oraz Histogram Pyramids,

które dodatkowo przystosowaliśmy do

pracy w środowisku wydajnych procesorów graficznych. Uruchomienie

na klastrze GPGPU „Cane” w PCSS pozwala na uzyskanie wyników w znacznie

krótszym czasie.

Drugim modelem, którym się zajmujemy, jest wyznaczenie przepuszczalności

skał roponośnych, na bazie symulacji komputerowych. Współczynnik

przepuszczalności pozwala określić

zdolność skały do transmitowania

płynu (np. wody czy gazu) przez jej pory

i sieć połączeń między nimi. Cecha

ta pozwala więc określić, w jakim

stopniu pokłady węglowodoru mogą

zostać pozyskane ze skały roponośnej

dzięki jej wypłukiwaniu. Po raz kolejny,

wielkiewyzwania.pl

eksperymenty laboratoryjne okazują

się zbyt drogie lub niemożliwe do

wykonania. Nasze podejście polega

na symulowaniu przepływu gazu

przez trójwymiarowy model porów

(stworzony nota bene za pomocą modelu porowatości) i wyznaczeniu współczynnika przepuszczalności. Z uwagi

na skomplikowaną geometrię porów,

wykorzystujemy symulacyjną metodę

Lattice Boltzmann, której istotnymi

zaletami są: i) łatwość reprezentacji

skomplikowanych struktur i definiowania warunków brzegowych oraz

ii) stosunkowo łatwe zrównoleglenie

problemu. Niestety ceną jaką trzeba

zapłacić jest duże zapotrzebowanie

na pamięć operacyjną. Wpisuje się

to jednak idealnie w charakterystykę

maszyny z dużą, globalną pamięcią

współdzieloną „Chimera” w PCSS, na

której symulacje są przeprowadzane.

Dzięki niej możliwe jest przeprowadzenie analizy dla większych próbek i z większą dokładnością, co nie było do tej pory

możliwe.

Realizowane przez nas modele są

weryfikowane na podstawie danych

otrzymanych dzięki uprzejmości instytutu Nafty i Gazu w Krakowie.

W obu przypadkach otrzymujemy rezultaty zbliżone do wartości z eksperymentów laboratoryjnych. Warto również podkreślić, że rozwijane przez

nas modele oceny porowatości i przepuszczalności skał roponośnych mają

swoje uzasadnienie i zastosowanie także

w procesach poszukiwania i pozyskiwania gazu łupkowego.

Michał Kulczewski

Mgr inż. Michał Kulczewski, związany

z PCSS od 2005 roku. Specjalista w zakresie obliczeniowej mechaniki płynów

(CFD) oraz obliczeń HPC. Główne obszary badawcze: symulacje złóż naturalnych, transport ciepła w serwerowniach, przepływ miejski i numeryczna prognoza pogody, wizualizacja danych

naukowych, adaptacja i optymalizacja

kodów obliczeniowych.

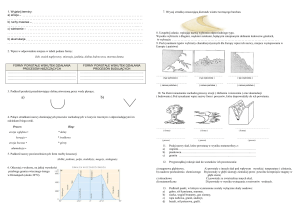

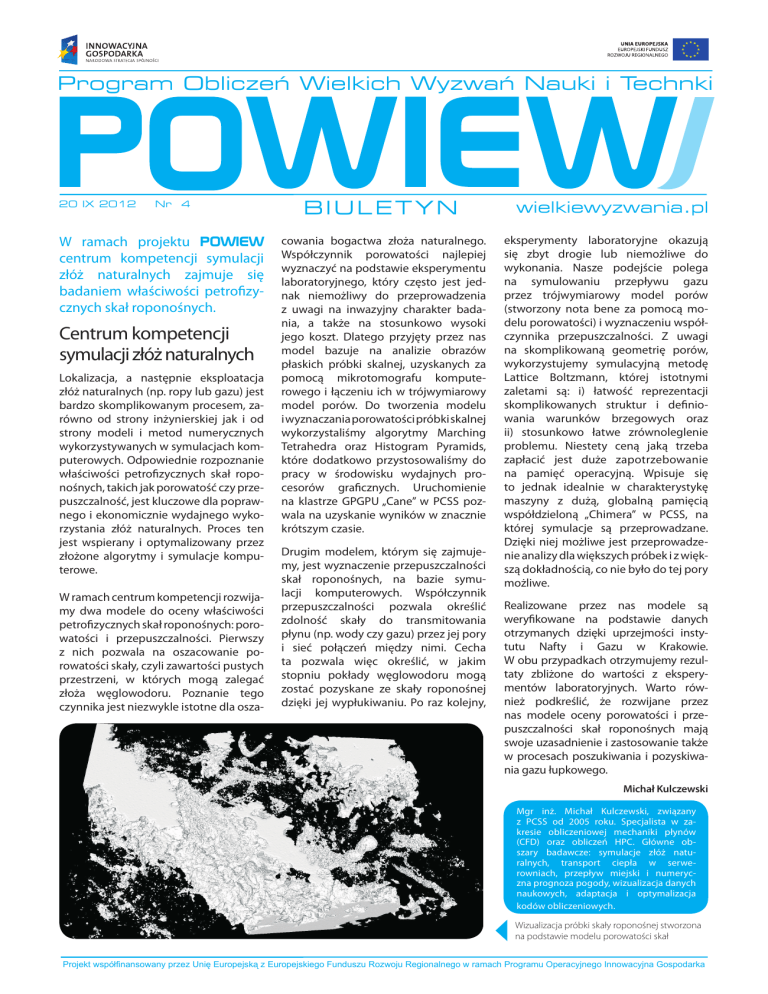

Wizualizacja próbki skały roponośnej stworzona

na podstawie modelu porowatości skał

Projekt współfinansowany przez Unię Europejską z Europejskiego Funduszu Rozwoju Regionalnego w ramach Programu Operacyjnego Innowacyjna Gospodarka

P

Ob

Na

P

Ob

Na

P

Ob

Na

Systemy obliczeniowe

zainstalowane w PCSS

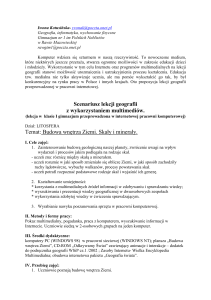

Klaster obliczeniowy GPGPU wyposażony jest w tradycyjne procesory oraz karty GPGPU pozwalające

na akcelerację obliczeń

W grudniu 2011 r. w ramach projektu

POWIEW w PCSS udostępnione

zostały dwa systemy obliczeniowe:

klaster węzłów SGI/Rackable wyposażonych w akceleratory graficzne

GPU, połączonych wydajną siecią

InfiniBand QDR oraz wieloprocesorowy serwer obliczeniowy SGI UltraViolet (UV) 1000.

biblioteki MPI) i pozwala na wydajną

pracę nawet kilkuset użytkownikom

równocześnie. Wiele czasochłonnych

obliczeń może być realizowanych na

modułach GPGPU, które zapewniają

wsparcie dla popularnych bibliotek

matematycznych (np. BLAS, Basic Linear

Algebra).

Klaster GP-GPU (nazwa systemu: „cane”)

oferuje moc obliczeniową na poziomie

157 TFLOPS i składa się ze 159 2-procesorowych węzłów wyposażonych

w 12-rdzeniowe procesory ogólnego

przeznaczenia AMD Opteron 6234 oraz

234 moduły GPU NVIDIA Tesla M2050,

które są wykorzystywane do akceleracji

obliczeń przy użyciu specjalistycznych

procesorów wywodzących się technologicznie ze świata wysokowydajnych

kart graficznych. Całość jest połączona

dedykowaną siecią InfiniBand QDR w topologii fat-tree, umożliwiającej uzyskanie najwyższych (rzędu 32 Gbit/s)

przepustowości pomiędzy węzłami na

potrzeby komunikacji w aplikacjach rozproszonych oraz dostępu do sieciowego

systemu plików Lustre.

System został zoptymalizowany dla

dużej liczby zadań o niewysokich

wymaganiach pamięciowych (lub zadań

rozproszonych,

gdzie

komunikacja

została zaimplementowana przy użyciu

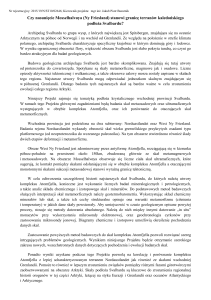

Drugi z systemów, serwer SGI UV 1000

(„chimera”), udostępnia moc obliczeniową

na poziomie 22 TFLOPS. Maszyna jest zbudowana w technologii SMP (Symmetric

multiprocessing), gdzie wszystkie 256 8rdzeniowych procesorów Intel Xeon E78837 (razem 2048 rdzenie) ma dostęp

do jednej wspólnej przestrzeni pamięci

RAM o wielkości aż 16 TB. Dzięki takiemu

rozwiązaniu możliwe jest uruchamianie

Maszyna SGI UV 1000 pozwala na dostęp do 16 TB

w modelu SMP

aplikacji o bardzo dużych wymaganiach

pamięciowych (np. ładowanie do pamięci

i przetwarzanie bardzo dużych zbiorów

danych).

Oba systemy ze względu na znaczny

pobór mocy (łącznie ok. 160 kW –

równoważne średniemu poborowi mocy

przez ok. 80 domów jednorodzinnych)

związany z generowaniem dużej ilości

ciepła chłodzone są wodą przy wykorzystaniu dedykowanych, specjalnie zbudowanych instalacji.

Maszyny pracują pod kontrolą systemu operacyjnego Linux oraz systemu

zarządzania zasobami SLURM, który

umożliwia kolejkowanie i nadzorowanie

przebiegu realizacji zadań obliczeniowych przy jednoczesnym uwzględnieniu

polityk, priorytetów, itp.

Aplikacje użytkowników realizują zadania obliczeniowe m.in. z takich dziedzin

jak: symulacje biomolekularne, chemia

molekularna, mechanika kwantowa, magnetohydrodynamika, metody numeryczne, powstawanie układów planetarnych,

poszukiwanie nowych źródeł energii.

Głównie dzięki systemowi GP-GPU klaster

PCSS znalazł się 2-krotnie w 2011 oraz

w 2012 roku na liście najszybszych komputerów – TOP500.

Systemy udostępniane w ramach projektu POWIEW dla użytku centrów

kompetencji i innych grup naukowych

z Polski budują również infrastrukturę

obliczeniową HPC w Europie w ramach projektu PRACE (Partnership

for Advanced Computing in Europe,

http://www.prace-project eu/).

Systemy zainstalowane w PCSS i opisywane w tym numerze biuletynu są

już częścią tej infastruktury. Aktualnie

integrowane są także systemy projektu POWIEW z ICM i Cyfronetu,

a także klaster z WCSS we Wrocławiu.

Dostęp do największych systemów

europejskich może mieć każdy, kto

uzasadni swoją potrzebę obliczeń w ramach prowadzonych prac naukowych na systemach Tier-0 (obecnie

4 systemy w Niemczech, Francji oraz

we Włoszech) oraz na mniejszych

systemach Tier-1 (m.in. w Polsce).

Konkursy na wykorzystanie europejskich zasobów HPC ogłaszane są kilka

razy w roku. Kilka polskich zespołów

badawczych już złożyło swoje aplikacje

na Tier-1.

Projekt współfinansowany przez Unię Europejską z Europejskiego Funduszu Rozwoju Regionalnego w ramach Programu Operacyjnego Innowacyjna Gospodarka