BABBAGE

CHARLES

(1792–1871), bryt. matematyk i wynalazca; 1828–39 prof. uniw. w Cambridge; czł. Tow. Król.

w Londynie i Petersburskiej Akad. Nauk; autor projektów maszyn liczących: 1822 — maszyny

do liczenia metodą różnic skończonych („różnicowej”), częściowo skonstruowanej; 1833 —

„maszyny analitycznej”, będącej właściwie prototypem współcz. komputerów.

R. LIGONNIÈRE Prehistoria i historia komputerów, Wrocław 1992.

KOMPUTER [ang.], elektroniczna maszyna cyfrowa, urządzenie elektron. służące do

automatycznego przetwarzania informacji (danych) przedstawionych cyfrowo (tzn. za pomocą

odpowiednio zakodowanych liczb). Istotną cechą odróżniającą komputer od innych urządzeń jest

jego „programowalność”, tzn. wykonywanie konkretnych zadań (np. obliczeń) jest związane

z wykonywaniem zapisanych w

. Pojęcie komputer obejmuje

obecnie zarówno komputery zaprogramowane na stałe, używane jako automaty sterujące, np.

w urządzeniach gospodarstwa domowego, jak i komputery uniwersalne, dające się dowolnie

zaprogramować. Tradycyjnie przyjął się podział komputerów na: superkomputery, duże

komputery (ang. mainframe), minikomputery i mikrokomputery; podział ten opiera się

przede wszystkim na odmiennych sposobach konstruowania komputerów i biorących się stąd

różnicach w ich wydajności (mocy obliczeniowej) i sposobie użytkowania: superkomputery są

stosowane do szybkich obliczeń nauk., produkcji grafiki film. itp. (np. CRAY), duże komputery

są gł. przeznaczone do zastosowań bankowych, finansowych i adm. na szczeblu dużego

przedsiębiorstwa (np. IBM 9000/ES), minikomputery obsługują małe instytucje lub grupy

użytkowników (np. VAX), mikrokomputery są zwykle przeznaczone do obsługi pojedynczego

użytkownika (np. IBM PS/2, MacIntosh).

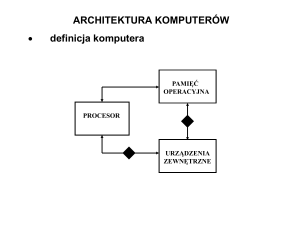

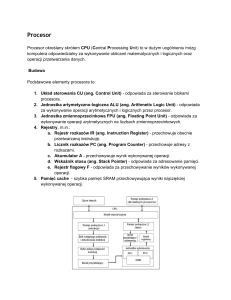

Budowa. Główne części sk

postaci układu

(zewnętrzne). Zadaniem procesora, zw. też czasem jednostką centr., jest wykonywanie rozkazów

i sterowanie pracą pozostałych bloków funkcjonalnych komputera; na procesor składają się gł.:

układ sterowania, jednostka arytm.-log., zw. arytmometrem, oraz zespół rejestrów: rejestr

rozkazów, licznik rozkazów, akumulatory i in.; procesor wykonuje kolejne cykle rozkazowe

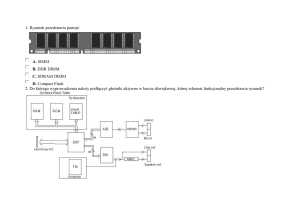

pobierając rozkazy i dane bezpośrednio z pamięci operacyjnej, składającej się

z

peryferyjne, dołączone do komputera najczęściej za pośrednictwem układów wejścia–wyjścia,

służą do komunikacji komputera ze światem zewn. (z użytkownikiem), np. klawiatura, monitor

ekranowy, drukarka, mysz, joystick, pióro świetlne, skaner, ploter; do urządzeń peryferyjnych

zalicza się też pamięci zewn., np. dyski magnet. i optyczne. Urządzenia peryferyjne w obecnie

używanych komputerach pracują z reguły jako autonomiczne jednostki współbieżnie

z procesorem.

Zasada działania. Informacja w komputerze jest przedstawiona w postaci ciągu elementów ze

itami i oznaczane symbolami 0 i 1;

fizycznie są reprezentowane przez 2 różne stany elektr. lub magnet. układów komputera. Ciągi

bitów o

w komórkach pamięci bądź rejestrach komputera; ciąg taki jest zw. słowem maszynowym, a jego

interpretację w danej chwili określa rodzaj wykonywanego na nim działania, np. gdy jest to

działanie arytmetyczne, słowo jest traktowane jako zapis liczby (w określony dla danego

yka komputera); gdy jest to działanie log. — słowo jest zapisem

wartości log. itd. Każdy komputer ma ustalony zestaw działań, zw. listą rozkazów, z których są

budowane programy. Rozkaz ma postać słowa maszynowego, składającego się z części

operacyjnej (będącej zakodowanym działaniem) i części adresowej (informacja, na której to

działanie ma być wykonane, lub jej adres, tzn. numer komórki pamięci zawierającej tę

informację). W chwili gdy słowo znajduje się w rejestrze rozkazów, jest interpretowane jako

rozkaz. Na wykonanie rozkazu składa się wiele operacji wykonywanych przez różne podzespoły

komputera Operacje te tworzą tzw. cykl rozkazu — jedną z nich jest wskazanie słowa, które

w następnym cyklu będzie wprowadzone do rejestru rozkazów jako następny wykonywany

rozkaz. Przejście do następnego cyklu następuje zaraz po zakończeniu aktualnie realizowanego

— w ten sposób przebiega samoczynne wykonanie sekwencji rozkazów, wymagające tylko

zapoczątkowania (wprowadzenia do rejestru rozkazów pierwszego rozkazu). Program w języku

wewnętrznym komputera to zatem zbiór słów, z którego wybiera on i wykonuje sekwencję

rozkazów w

Opisana powyżej zasada wewn. sterowania pochodzi od J. von Neumanna (1950).

Oprogramowanie stanowi zespół programów wykonywanych przez komputer; określane często

terminem ang. software, w połączeniu ze sprzętem komputerowym (elektron. i mech. części

komputera), zw. dla przeciwieństwa hardware, tworzy system komputerowy. Do

oprogramowania podstawowego zalicza się programy niezbędne do efektywnej eksploatacji

operacyjnymi. Programy uruchamiane na danym komputerze pod danym systemem operacyjnym

na

kompilatory, tłumaczące algorytmy zapisane w

wykonywane przez komputer (ciągi bitów); są to programy używane gł. przez programistów. Do

także różne rodzaje gier komputerowych. Do bardziej

także

wspomagające inżynierów i

najróżniejsze rodzaje działalności ludzkiej stale rośnie, przy czym ich cena (zwł.

oprogramowania tworzonego na specjalne zamówienie użytkownika) często znacznie przewyższa

cenę samego sprzętu komputerowego.

Rys historyczny. Do XVII w. jedynymi przyrządami ułatwiającymi liczenie były różnego

rodzaju liczydła. Znaczny postęp nastąpił po odkryciu logarytmów (pałeczki Nepera, suwak

logarytmiczny). W tym okresie powstały też pierwsze maszyny liczące (W. Schickard, B. Pascal,

S. Morland, G.W. Leibniz), wykonujące mechanicznie operacje dodawania i odejmowania,

a niektóre także mnożenia i dzielenia. Prawdziwych początków informatyki można się jednak

doszukiwać dopiero w XIX w., gdy Ch. Babbage stworzył koncepcję automatycznej

i uniwersalnej maszyny liczącej (projekt maszyny „analitycznej”, po częściowo skonstruowanej

maszynie „różnicowej”), odpowiadającej w swej strukturze współczesnemu komputerowi:

z pamięcią (magazynem) i jednostką liczącą (młynem), sterowaną programem zapisanym na

kartach dziurkowanych; ok. 1800 takie karty zostały użyte przez J.M. Jacquarda do sterowania

krosnem tkackim, a ok. 1890 przez H. Holleritha do automatyzacji prac przy spisie powszechnym

w Stanach Zjednoczonych. Idee Babbage'a zostały zrealizowane dopiero przez matematyka amer.

H. Aikena, który 1944 zbudował z przekaźników elektromech. maszynę liczącą, znaną pod

nazwą ASCC (ang. Automatic Sequence Controlled Calculator) lub MARK I i którą można

uznać za pierwszy komputer. Era współczesnych komputerów rozpoczęła się w momencie

zastosowania w nich elementów elektron. umożliwiających znaczne przyspieszenie

wykonywanych działań; pierwszą całkowicie elektron. (zawierała 18 tys. lamp elektronowych)

maszyną cyfrową był ENIAC (ang. Electronic Numerical Integrator And Calculator), zbud. 1946

przez amer. uczonych J. Mauchly'ego i J.P. Eckerta; ENIAC był ponad 1000 razy szybszy od

MARKA I. W dalszym rozwoju komputerów rozróżnia się kilka etapów, zw. generacjami

komputera: I. 1946–59, kiedy podstawowymi elementami komputera były lampy elektronowe, II.

1959–65 — tranzystory, III. 1965–75 — układy scalone, IV. od 1975 — układy scalone wielkiej

skali integracji (VLSI). Pierwszym uruchomionym w Polsce komputer był XYZ, wykonany

techniką lampową, pod kierunkiem L. Łukaszewicza (1958).

R. LIGOMNIÉRE Prehistoria i historia komputerów, Wrocław 1992.

GATES BILL (WILLIAM) HENRY III (ur. 1955), amer. przemysłowiec, programista

komputerowy; założyciel i prezes Microsoft Corporation; współtwórca systemu operacyjnego

MS-DOS; autor książki o Internecie i nowych możliwościach przekazu informacji Droga ku

przyszłości (1996, wyd. pol. 1998).

KOMPUTEROWA SIEĆ, zespół oddalonych od siebie komputerów i urządzeń peryferyjnych,

połączonych liniami transmisji danych; w przypadku sieci specjalizowanych — również

urządzeń o specjalnych funkcjach (np. uliczne automaty wydające gotówkę w sieci bankowej,

punkty ogniowe w sieciach militarnych i in.). Zależnie od wielkości, rodzaju i stopnia złożoności

sieci komputerowej, liniami transmisji danych mogą być zwykłe kable lub linie

telekomunikacyjne. Sieć komputerowa może ograniczać się do jednego lub kilku budynków

(sieci LAN — ang. Local Area Networks), do miasta, ale może też pokrywać wielkie obszary —

kraje, a nawet kontynenty. Ważniejsze cele tworzenia sieci komputerowych 1) umożliwienie

użytkownikom korzystania z odległych zasobów informacyjnych i urządzeń; 2) zwiększenie

niezawodności działań, dzięki możliwości użycia kilku komputerów do wykonywania tego

samego programu; 3) bardziej równomierne wykorzystanie mocy obliczeniowej sprzętu

informatycznego (gdy dany komputer jest przeciążony zadaniami, można wykorzystać inny,

w danej chwili nieobciążony); 4) usprawnienie zbierania, przetwarzania, rozprowadzania

i wykorzystania na rozległych obszarach informacji o specjalnym przeznaczeniu, np. militarnym,

informacji z różnych dziedzin, np. nauki; 7) usprawnienie pracy biur podróży, rezerwacji lotn.,

operacji bankowych, handlu, bibliotekarstwa, systemu ubezpieczeń i in.

Sieci mniejsze bywają często podłączane do większych. Taki zhierarchizowany system

teleinformatyczny znacznie zwiększa dostępność informacji, zwł. że rozpowszechniło się

w prywatnych mieszkaniach. Szczególnie istotnym elementem przy tworzeniu sieci

komputerowych jest ochrona informacji — ułatwiony dostęp do baz danych wiąże się bowiem

z niebezpieczeństwem użycia (lub zmiany) pewnych informacji (dotyczących obronności, kont

bankowych, sytuacji ekon. przedsiębiorstw i in.) przez osoby nieuprawnione („włamywaczy”

komputerowych — ang. hacker).

Pierwszą siecią komputerową, uruchomioną jeszcze w latach 50., była amer. sieć SAGE (ang.

Semi Automatic Ground Environment), służąca do sterowania obroną kontynentu Ameryki

Północnej. Obecnie w krajach rozwiniętych istnieje wiele sieci komputerowych, zarówno

o charakterze ogólnodostępnym (sieci publ., abonenckie), jak i o charakterze zamkniętym (sieci

wykorzystywane przez konkretne instytucje).