Biała księga zarządzania

Tadeusz Gospodarek

Wyższa Szkoła Bankowa we Wrocławiu

[email protected]

Wersja beta

Copyright

Tadeusz Gospodarek

Kamieniec Wrocławski 2017

Spis treści

SPIS TREŚCI ...............................................................................................................................2

WSTĘP .........................................................................................................................................6

1

KONTEKST ZARZĄDZANIA .........................................................................................9

1.1 SYSTEM SPOŁECZNY Z FUNKCJONUJĄCĄ WARTOŚCIĄ .....................................................11

1.1.1

Człowiek w systemie generującym wartość .......................................................... 14

1.1.2

Zasady etyczne i normy moralne ..........................................................................17

1.1.3

Zasady optimum działania ...................................................................................19

1.2 POTRZEBY I DOBRA ........................................................................................................23

1.2.1

Potrzeby ...............................................................................................................24

1.2.2

Dobra ...................................................................................................................25

1.2.3

Konsumpcja ..........................................................................................................31

1.3 RYNEK............................................................................................................................ 35

1.3.1

Konkurencja .........................................................................................................38

1.3.2

Koniunktura i cykl Kondratiewa ..........................................................................41

1.3.3

Informacja i wiedza .............................................................................................. 44

1.3.4

Równowaga makroekonomiczna ..........................................................................50

1.4 KAPITAŁ JAKO REPREZENTACJA WARTOŚCI ....................................................................55

1.4.1

O jednostce kapitału ............................................................................................. 56

1.4.2

Jak mierzyć kapitał ............................................................................................... 58

1.4.3

Kapitał uogólniony ............................................................................................... 59

1.5 DZIAŁALNOŚĆ GOSPODARCZA ........................................................................................ 60

1.5.1

Model systemowy działalności gospodarczej .......................................................62

1.5.2

Otoczenie działalności gospodarczej ...................................................................65

1.5.3

Przedsiębiorczość .................................................................................................66

1.5.4

innowacyjność ......................................................................................................70

2

PODMIOT I PRZEDMIOT ZARZĄDZANIA .............................................................. 75

2.1 ORGANIZACJA JAKO SYSTEM GENERUJĄCY WARTOŚĆ ....................................................75

2.1.1

Definicja systemowa organizacji..........................................................................77

2.1.2

Rodzaje organizacji .............................................................................................. 80

2.1.3

Cykl życia organizacji .......................................................................................... 83

2.2 ŁAŃCUCH WARTOŚCI ORGANIZACJI, ...............................................................................86

2.2.1

Łańcuch dostaw w łańcuchu wartości, .................................................................90

2.2.2

Zasoby i kluczowe kompetencje ............................................................................93

2.2.3

Procesy w organizacji i ich znaczenie dla zarządzania .......................................97

2.2.4

Organizacja jako układ warstw logicznych ........................................................ 103

2.3 CZŁOWIEK W ORGANIZACJI .......................................................................................... 106

2.3.1

Relacje człowieka i organizacji ..........................................................................106

2.3.2

Model systemowy budowania relacji w organizacji ...........................................108

2.3.3

Pracownik w organizacji ....................................................................................111

2.3.4

Menedżer i przywódca ........................................................................................ 113

2.3.5

Aspekty etyczne...................................................................................................115

3

ZARZĄDZANIE. ZAKRES, CELE, METODY .......................................................... 119

3.1 ZARZĄDZANIE JAKO ZAGADNIENIE ZŁOŻONE, .............................................................. 120

3.1.1

Ujęcie cynefin .....................................................................................................121

3.1.2

Stan organizacji, ................................................................................................ 123

3.1.3

Cele stawiane przed zarządzaniem.....................................................................126

3.1.4

Niejednoznaczność rezultatu zarządzania .......................................................... 129

2

3.1.5

Zarządzanie mikro i makro ................................................................................131

3.2 ASPEKT CZASOWY ZARZĄDZANIA.................................................................................138

3.2.1

Struktura decyzji.................................................................................................138

3.2.2

Ograniczona racjonalność i heurystyki uproszczone .........................................140

3.2.3

Aspekt czasowy decyzji ....................................................................................... 142

3.2.4

Własność Markowa i zasada Bellmana .............................................................. 143

3.2.5

Scenariusze i pakiety decyzyjne ..........................................................................144

3.3 METODOLOGIA ZARZĄDZANIA .....................................................................................146

3.3.1

Dzieło Adama Smitha ......................................................................................... 146

3.3.2

Kierunek produktywność ....................................................................................148

3.3.3

Kierunek niezawodność, efektywność, jakość ....................................................151

3.3.4

Kierunek optymalizacja funkcjonalna organizacji .............................................161

3.3.5

Ujęcia systemowe ............................................................................................... 169

3.3.6

Kierunek strategiczny ......................................................................................... 173

4

WYBRANE ZAGADNIENIA PRAKTYCZNE ........................................................... 187

4.1 ZARZĄDZANIE PROJEKTEM ........................................................................................... 187

4.1.1

Studium wykonalności ........................................................................................ 189

4.1.2

Zarządzanie zwinne projektami (agile) .............................................................. 193

4.1.3

Metoda PERT/CPM i harmonogramowanie ...................................................... 195

4.2 ZMIANA W BIZNESIE .....................................................................................................204

4.2.1

Aspekty epistemologii zmiany .............................................................................204

4.2.2

Metodologia zmiany ........................................................................................... 208

4.2.3

Biznes plan jako projekt zmiany .........................................................................213

4.3 ZARZĄDZANIE RYZYKIEM ............................................................................................. 217

4.3.1

Taksonomia ryzyka ............................................................................................. 219

4.3.2

Style zarządzania ryzykiem .................................................................................222

4.3.3

Model zarządzania ryzykiem w organizacji ....................................................... 223

4.4 ZARZĄDZANIE INFORMACJĄ I WIEDZĄ (UJĘCIE ZASOBOWE)..........................................224

4.4.1

Wiedza jako cenny zasób organizacji .................................................................225

4.4.2

Koszty zasobów IT i ich użyteczność ..................................................................231

4.4.3

Bezpieczeństwo informacyjne .............................................................................232

4.5 ZARZĄDZANIE ZASOBAMI LUDZKIMI ............................................................................234

4.5.1

Relacje i interakcje w organizacji ......................................................................236

4.5.2

Motywacja ..........................................................................................................241

4.5.3

Coaching i ścieżka kariery .................................................................................245

4.5.4

Płace...................................................................................................................249

4.5.5

Wsparcie komputerowe zarządzania kadrami i płacami ....................................253

4.6 MARKETING I DYSTRYBUCJA ........................................................................................ 264

4.6.1

Budowanie strategii marketingowej ...................................................................266

4.6.2

Strategie marketingowe ...................................................................................... 269

4.6.3

Strategie cenowe ................................................................................................ 270

4.6.4

Kanały dystrybucji ............................................................................................. 275

4.6.5

Marketing bezpośredni ....................................................................................... 278

4.6.6

Model etyczny marketingu ..................................................................................279

4.6.7

Zarządzanie marką ............................................................................................. 281

4.7 ASPEKTY ZARZĄDZANIA FINANSAMI ............................................................................292

4.7.1

Analiza finansowa projektu biznesowego ........................................................... 293

4.7.2

Oszacowania zmian wartości pieniądza w czasie ..............................................296

4.7.3

Wybrane aspekty rachunkowości .......................................................................300

4.7.4

Hedging ..............................................................................................................312

4.8 WYBRANE KWESTIE ZARZĄDZANIA LOGISTYKĄ ........................................................... 324

4.8.1

Optymalizacja logistyczna..................................................................................325

3

4.8.2

Zagadnienie magazynowe ..................................................................................328

4.8.3

Magazyn jako obiekt logiczny ............................................................................331

4.8.4

Kolejkowanie ......................................................................................................335

4.8.5

Problem transportowy ........................................................................................ 339

4.8.6

Zagadnienie komiwojażera (Zadanie chińskiego listonosza) ............................. 341

4.8.7

Strategie logistyczne ........................................................................................... 342

4.9 KONTROLING ................................................................................................................346

4.9.1

Metoda KPI (Key Performance Indicators) ....................................................... 347

4.9.2

Aspekty finansowe kontrolingu ...........................................................................349

4.9.3

Aspekty procesowe ............................................................................................. 351

4.9.4

Aspekty struktury informacyjnej kontrolingu .....................................................356

5

POMIAR I OCENA W ZARZĄDZANIU. ...................................................................359

5.1 MIARA .......................................................................................................................... 360

5.1.1

Skala ...................................................................................................................360

5.1.2

Miara integralna w zagadnieniu wielowymiarowym .........................................362

5.1.3

Dystans do frontiery (ranking benchmarkingowy) .............................................362

5.2 WNIOSKOWANIE STATYSTYCZNE I TESTOWANIE HIPOTEZ ............................................364

5.2.1

Porównanie grup mierzonych niezależnie .......................................................... 365

5.2.2

Porównanie więcej niż dwóch zmiennych .......................................................... 366

5.2.3

Stwierdzenie istnienia związku pomiędzy zmiennymi .........................................366

5.3 METODY ILOŚCIOWE W ZARZĄDZANIU .........................................................................367

5.3.1

Programowanie liniowe .....................................................................................368

5.3.2

Optymalizacja nieliniowa ...................................................................................375

5.3.3

Symulacja ...........................................................................................................379

5.3.4

Analiza „What if” .............................................................................................. 381

5.3.5

Elementy teorii gier ............................................................................................ 384

5.4 GLOBALNE WSKAŹNIKI EKONOMICZNE W OTOCZENIU ..................................................392

5.4.1

Dochód narodowy brutto PKB ...........................................................................393

5.4.2

Dochód narodowy na jednego mieszkańca ........................................................ 395

5.4.3

Dochód do dyspozycji......................................................................................... 396

5.4.4

Globalny wskaźnik przedsiębiorczości GEM .....................................................397

5.4.5

GCI Globalny indeks konkurencyjności ............................................................. 401

5.4.6

GII Globalny indeks innowacyjności .................................................................402

5.4.7

Globalny wskaźnik „Doing Business” ............................................................... 405

5.4.8

PMI (Purchasing Managers Index) ....................................................................409

5.4.9

Wskaźnik moralności płatniczej (IPM) ............................................................... 411

5.4.10

Wskaźnik IFO (ZEW) .....................................................................................412

6

DODATKI ....................................................................................................................... 414

6.1 METODA WIELOKRYTERIALNA .....................................................................................414

6.1.1

Kryterium oparte na skali nominalnej ................................................................ 414

6.1.2

Kryterium oparte na skali porządkowej ............................................................. 415

6.1.3

Kryterium oparte na skali interwałowej ............................................................. 417

6.1.4

Kryterium oparte na skali ilorazowej .................................................................419

6.1.5

Kryterium integralne .......................................................................................... 420

6.2 BADANIA ZALEŻNOŚCI ZMIENNYCH ..............................................................................421

6.2.1

Metoda najmniejszych kwadratów .....................................................................421

6.2.2

Test chi-kwadrat .................................................................................................423

6.2.3

Test Wilcoxona-Manna-Whitney’a .....................................................................425

6.3 ANALIZA PEST(LE) .....................................................................................................427

6.3.1

Tablica czynników PEST ....................................................................................428

6.3.2

Scenariusze PEST............................................................................................... 431

4

6.4 ANALIZA GE-MCKINSEY ............................................................................................. 432

6.4.1

Atrakcyjność rynkowa sektora............................................................................433

6.4.2

Ustalanie pozycji rynkowej ................................................................................435

6.5 ANALIZA PORTFELOWA BCG ....................................................................................... 436

6.6 ANALIZA SWOT WERSJA QUASI-ILOŚCIOWA................................................................ 438

6.6.1

Analiza czynników .............................................................................................. 440

6.6.2

Macierz interakcji SWOT ...................................................................................443

6.7 METODA MACIERZY LOGICZNEJ LFA ...........................................................................447

6.7.1

Projekt inwestycyjny w ramach EFRR ............................................................... 449

6.7.2

Matryca logiczna dla strategii ...........................................................................451

6.8 OBLICZENIA WARTOŚCI DLA OPCJI................................................................................451

6.8.1

Wartość podstawowa opcji.................................................................................452

6.8.2

Symulacja wartości opcji metodą Monte Carlo .................................................457

LITERATURA PRZEDMIOTU............................................................................................. 459

SPIS ILUSTRACJI .....................................................................................................................471

SPIS TABEL ............................................................................................................................. 473

5

Wstęp

Zapyta ktoś skąd wziął się tytuł biała księga zarządzania i co to oznacza?

Otóż jest to najlepsze określenie tego, co chciałbym przekazać czytelnikowi w tej

książce. Jest to coś, co stanowi podsumowanie rozważań modelowania konceptualnego i semantycznego w odniesieniu do całości struktury zarządzania, które

ma być wspomagane w jakikolwiek sposób komputerowo. Biała księga określa,

jak sformułować zarządzanie jako model koncepcyjny, prowadzący do tworzenia bazy znaczeniowej dla procedur (modeli semantycznych), dobrych praktyk

oraz sposobów rozwiązywania trudnych kwestii w codziennej działalności, tak

menedżera praktyka, jak i naukowca. Biała księga pomaga również w tworzeniu

reprezentacji formalnych zagadnień niematematycznych, które następnie da się

przetworzyć na język informatyki. To jest jakby model syntetyczny całego zbioru

modeli, analogii i metafor, które w naukach o zarządzaniu funkcjonują od zarania na różnych poziomach jego interoperacyjności w działalności gospodarczej.

Książka „Biała księga zarządzania” stanowi rekapitulację moich doświadczeń prowadzenia firmy IT oraz pracy ze studentami w kontekście problemów

z pisaniem sensownych prac magisterskich i licencjackich. Uważam, że największym problemem we współpracy promotor-magistrant jest różnica oczekiwań

tego pierwszego i możliwości twórczych tego drugiego. Faktem jest, że większość studentów traktuje prace dyplomowe jedynie jako niemiły obowiązek, którego celem jest uzyskanie kwitu, a nie ujawnienie rzetelnej wiedzy, użytecznej

dla innych. Stąd miernota i sztampa tematyczna królują w produkcji kolejnych

magistrów półgłówków, ale zgodnie z bolońską ideologią i biurokratycznymi

ramami kompetencji, dzielnie pielęgnowanymi przez uczone gremia komisji

akredytacyjnych. W tym, ogólnym nieporozumieniu zwanym edukacją wyższą

zagubiła się gdzieś akademickość kształcenia, na rzecz hipertekstu, manuali,

przypadkowości tematycznej i braku logiki w programach nauczania oferowanych przez kolejne wyższe szkoły gotowania na parze i ognisku.

Rozmycie rzetelnej wiedzy naukowej w zakresie zarządzania na rzecz beletrystycznych opracowań o kulturze organizacji, bajań o kapitale intelektualnym

oraz roli gender w zarządzaniu zorzami polarnymi, oddala coraz bardziej problematykę od twardej wiedzy wpieranej pomiarem, kwantyfikacją i oparcia wyniku na sprawdzalnych teoriach. To właśnie skłania mnie do napisania pracy

fundamentalnej, porządkującej wszystko to, co moim zdaniem jest wartościowe

w zarządzaniu i co stanowi fundament rzetelnej wiedzy w tym zakresie. Jeżeli

chcemy coś zmieniać lub naprawiać, musimy zacząć od definicji i formalizacji

pojęć. Tylko język formalny pozwala na mierzalność i daje nadzieje na stworzenie teorii objaśniającej, natomiast miejsce beletrystyki jest w dziale literatury

pięknej. Bez tego na wyjściu rozważań otrzymamy opowiadania i teorie deskryptywne dla ornitologa obserwatora, a nie objaśniające.

6

Wspomaganie problematyki dostępu do wiedzy syntetycznej na temat zarządzania i jego otoczenia polegać powinno na udostępnianiu odnośników do

najnowszej literatury przedmiotu oraz pokazywaniu multidyscyplinarności zarządzania, jako wiedzy zbliżonej do prawdziwości sądów o faktach, ale również

sztuki praktycznego działania weryfikowalnych teorii. Menedżer powinien

orientować się bardzo dokładnie, gdzie może znaleźć dane wskaźnikowe i prognostyczne. Powinien poznać sposoby jak skorzystać z danych statystycznych,

żeby mógł ograniczyć poziom niepewności decyzyjnej oraz ryzyka działalności

gospodarczej, którą zarządza lub którą chce podjąć. Stąd wiedza ogólna, dotycząca praw ekonomicznych, zagadnień społecznych, elementów psychologii, filozofii nauki oraz metod wypracowanych przez teorię zarządzania jest niezbędna, żeby w oparciu o opracowania dotyczące szczegółowej tematyki, menedżer mógł zbudować własne reguły postępowania i dobre praktyki. Ukazać to

wszystko w formie syntetycznej jest fundamentalnym celem niniejszej monografii.

Książka składa się z czterech części. W pierwszej starałem się opisać kontekst zarządzania i jego otoczenie, czyli to, co uzasadnia działania zarządu i

wskazuje ogólne reguły postępowania wobec ciągłych zmian dziejących się ekosystemie każdego biznesu. Część druga dotyczy podmiotu i przedmiotu zarządzania, ukazując rolę organizacji w teorii i praktyce oraz opisy formalne umożliwiające pomiar stanu i jego kontrolę w czasie. Część trzecia dotyczy metod wypracowanych przez ponad 100 lat istnienia teorii zarządzania i sposobów użycia

wiedzy nagromadzonej w tym okresie, a odkrywanej za każdym razem na nowo,

gdy kolejne władze zmieniają zagmatwane prawo gospodarcze wraz z menedżerami swoich kluczowych organizacji. Tam również znajdują się praktyczne opisy

wybranych działań przez lata praktyki ugruntowanych. W części czwartej

przedstawiam zarządzanie wymierne wraz z przykładami zastosowania metod

pomiarowych, a więc to, co leży po naukowej stronie rozważań teoretycznych,

określonych przez demarkację selekcjonującą dla problematyki nauk o zarządzaniu jako naukowe.

Jak to trafnie ujął W. Deming „In God we trust. The rest must bring data”. Tak

właśnie ma być w prawidłowo zarządzanej organizacji – menedżer ma przedstawić wynik mierzalny, choćby po to, żeby naliczyć podatki lub ustalić swoją pozycję ekonomiczną w danej chwili czasu. Dlatego przedstawienie metod pomiarowych, dostępnych w konkretnych problemach decyzyjnych lub procesach biznesowych, wydaje się szczególnie ważne. Wiąże się to również z budowaniem

kryteriów ocen aksjologicznych w kategoriach „dobre” – „złe” oraz „racjonalne”

– „nieracjonalne”. Jest to wiedza zbyt słabo prezentowana w polskiej literaturze

przedmiotu i programach nauczania, gdzie dominują opowieści w temacie miałkich zagadnień społecznych oraz metaforyczne, głównie werbalne odniesienia

7

do „twardych” modeli zaczerpniętych z poważniejszych nauk. Dlatego w niniejszej książce zawarłem, jako dodatek, opisy ukazujące metody użycia niektórych

ilościowych lub quasi-ilościowych technik analitycznych, szczególnie użytecznych w pracy menedżera.

Książka przeznaczona jest przede wszystkim dla piszących prace dyplomowe, magisterskie oraz rozprawy doktorskie, chcących zrozumieć szerzej procesy relacji organizacja-otoczenie oraz zasady ujęcia systemowego w budowaniu

wiedzy. Z pewnością będzie przydatna dla autorów, ułatwiając dobranie metod

badawczych, analitycznych oraz dotarcie do wartościowej literatury przedmiotu

w łatwy sposób. Również studenci kursu magisterskiego mogą znaleźć niniejszą

monografię jako użyteczny podręcznik syntetyczny porządkujący wiedzę z obszaru kilku przedmiotów z siatki godzin kierunków zarządzania. Dotyczy to

przede wszystkim wykładów: „podstawy zarządzania”, „nauka o organizacji”,

„pomiar i analiza w zarządzaniu”, „podejmowanie decyzji” oraz „zarządzanie

zmianami”. Liczne rysunki, schematy oraz bogactwo danych literaturowych powinny pomóc każdemu wykładowcy w opracowaniu przeźroczy do zajęć, a

kompletność wiedzy ogólnej zawarta w monografii, powinna wystarczyć na

szybkie wybranie informacji dotyczących większości tematów związanych z zarządzaniem.

Specjalną uwagę w książce poświęcam menedżerom i kandydatom na

przedsiębiorców. Dla nich przedstawiam to, co decyduje o bezpiecznym podejściu do biznesu. Zwracam uwagę na konieczność uczenia się przez całe życie, a

także na ciągłą niepewność towarzyszącą działalności gospodarczej i wynikający

stąd obowiązek stałego monitorowania pewnych danych, jeżeli myśli się o sukcesie. Imperatywem kategorycznym każdego menedżera jest pomiar, a zatem

wykorzystanie metod zawartych w tej monografii. Ich znajomość ułatwia nawiązanie dialogu z naukowcem lub konsultantem w zakresie optymalizacji i zabezpieczenia własnego interesu przez turbulencjami płynącymi z otoczenia.

Liczę, że książka zostanie uznana za przydatną pozycję w literaturze przedmiotu, czego każdy autor sobie życzy, a co może zostać zweryfikowane wyłącznie przez opinie czytelników. Traktuję tą monografię jako egzamin samego siebie z zakresu zarządzania. Większość zagadnień opisanych miałem okazję

sprawdzić w praktyce. Znalazły się tu również moje oprcowania z obszaru zastosowań teorii pomiaru, metod filozofii nauki oraz ujęć systemowych. Będę zatem wdzięczny za wszelkie uwagi, które mogą poprawić tą książkę.

Tadeusz Gospodarek

8

1 Kontekst zarządzania

Rozważania nad podstawami zarządzania należy rozpocząć od zapoznania

się z kontekstem działalności gospodarczej. Fundamentem wszelkich przejawów działalności gospodarczej jest człowiek, jego potrzeby i natura (pożądanie,

chciwość, lenistwo…). Stąd pojawia się kwestia wartości jako kluczowy element

wyrażania sensu działań gospodarczych. Z faktu generowania i konsumpcji

dóbr wynika stratyfikacja ekonomiczna i kulturowa społeczeństw. Tworzą się

systemy społeczne, wyróżniające się poziomem kultury, zdolności produkcyjnych oraz skutecznością gospodarowania, w których funkcjonuje wartość. To

wszystko generuje aktywność wytwórczą grup ludzkich, tworzących podmioty

gospodarcze, łączących się w organizacje, grupy i inne struktury poprawiające

efektywność funkcjonowania wartości na danym obszarze. Takimi systemami

gospodarczymi można sterować, ale tylko w ograniczonym zakresie. Są to bowiem struktury samoreflekyjne i inteligentne. Ich ewolucja podlega procesom

dynamicznej adaptacji do coraz szybciej i głębiej zmieniającego się otoczenia. To

właśnie stanowi tło zarządzania. Zrozumieć środowisko i jego zmienność. Wówczas reguła przekory Le Châteliera1 pozwoli na dobre określenie parametrów

sprzężeń zwrotnych, umożliwiających optymalne działanie systemów gospodarczych oraz utrzymanie stanu równowagi dynamicznej mikro-makro oraz

makro. Ten sam kontekst pozwala na interpretację wyników zarządzania organizacją na tle analogicznych pomiarów w sektorach gospodarczych, kraju, kontynentu czy świata. Pozwala na stworzenie kryteriów oceny aksjologicznej i definiuje kierunki działań optymalizacyjnych. Dlatego kontekst jest tak ważny we

wszelkich analizach zarządzania i ekonomii. Nie da się analizować stanów mikro bez makro. Dzięki temu nie można przyjąć, że takie same działania w skali

mikro przyniosą wszędzie identyczne rezultaty. Po prostu zależy to od otoczenia.

Otoczenie wymusza na każdym systemie generującym wartość określone

zachowania, które ten w elastyczny sposób dostosowuje do sytuacji ad-hoc. W

ten sposób systemy adaptatywne zorientowane są na wykorzystywanie okazji

pojawiających się w otoczeniu, jak również na procesy ciągłej reorientacji własnych celów oraz strategii, oparte na sprzężeniach zwrotnych zarówno dodatnich, jak i ujemnych. Może stąd wynikać niemożliwość istnienia w pewnych sytuacjach najlepszej metody zarządzania lub osiągnięcia zakładanego wyniku

ekonomicznego, albowiem to zmienność otoczenia wprowadza wysoki poziom

Hatta T., "Le Châtelier principle," The New Palgrave: A Dictionary of Economics, 3, (1987), s. 155–57

1

9

niepewności wyniku oraz ryzyka, a w dodatku mogą zmieniać się metody pomiaru w czasie. T. Burns i G. Stalker2, oraz P. Lawrence i J. Lorsch3 stwierdzili,

że nie ma najlepszej formy organizacji, albowiem zależy ona od czynników środowiskowych, które decydują o dostępności określonych zasobów dla systemu generującego wartość. Koncepcja ciągłej autoadaptacji do warunków otoczenia nazywa się teorią kontyngencji (teorią wpływów) i opiera się na następujących założeniach4:

Organizacje generujące wartość stanowią systemy otwarte, które wymagają ostrożnego zarządzania w celu utrzymania równowagi wewnętrznej i dostosowania się do

warunków otoczenia.

Nie istnieje jeden, najlepszy sposób budowy organizacji. Odpowiednia jej forma zależy od jej celów i zadań oraz możliwych oddziaływań z otoczeniem.

Zarząd musi być zainteresowanych przede wszystkim osiągnięciami dobrego dopasowania do zmienności środowiska.

Różne rodzaje lub formy organizacji są potrzebne w zależności od środowiska bizne-

sowego.

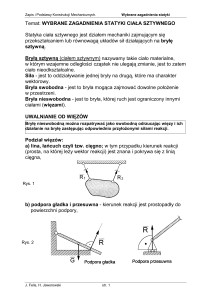

Rys. 1.1 Modelowanie zarządzania organizacją w ujęciu teorii kontyngencji.

Dla jasności wywodu, konieczne jest zatem poznanie fundamentalnych

aspektów kontekstu gospodarki rozumianego jako ekosystem biznesu.

Burns, T., Stalker, G. M., “The Management of Innovation”, London: Tavistock, 1961,

http://uk.sagepub.com/sites/default/files/upm-binaries/27412_8.pdf

3

Lawrence, P. R., Lorsch, J. W., “Organization and Environment: Managing Differentiation and Integration”,

Boston, MA: Harvard University, 1967.

4

Morgan G., “Obrazy organizacji”, Wydawnictwo Naukowe PWN, Warszawa, 1997.

2

10

1.1 System społeczny z funkcjonującą wartością

Dowolna wartość przejawia się w układzie interesariuszy człowiek lub grupa ludzi

– byt stanowiący wartość – otoczenie (rys. 1.2). Taki układ, w którym zdefiniowano

wartość, jako pewien pozytyw przynoszący określoną korzyść dowolnemu interesariuszowi nazwiemy układem wartości. W tym układzie wyróżniamy system z funkcjonującą wartością jako kluczowego interesariusza. Celem działania

tego systemu jest ciągłe ustalanie czym jest wartość, jak ją mierzyć, jak oceniać i

jak ma ona bytować w układzie wartości5. To fundamentalne założenie ustanawia rolę wartości jako nośnika określonych korzyści dla dowolnego z interesariuszy, należącego do układu wartości, w którym ona funkcjonuje. Tym samym

wartość ma charakter bytu, który bądź to sam z siebie jest wewnętrznie dobry,

bądź stanowi cechę innego, pozostającego z nią w relacji bytu, uznawanego

przez system jako pewien pozytyw.

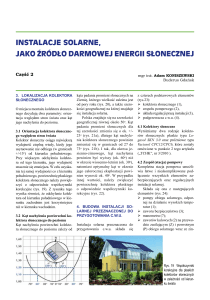

Rys. 1.2 Funkcjonowanie układu wartości.

Przez bytowanie należy rozumieć wszelkie przejawy funkcjonowania wartości, w tym jej kreowania, wymiany, anihilacji, zmiany, etc.

5

11

Z faktu, że wartość bytuje w określony sposób gdzieś w układzie wartości,

pojawia się również kwestia istnienia w tym układzie podsystemów: posiadających, generujących, ustalających, przejmujących i wpływających na wartość.

Mogą to być przedsiębiorstwa komercyjne, organizacje non profit, rzemieślnicy,

twórcy, konsumenci, sprzedawcy, media, etc. Są oni uczestnikami łańcuchów

wartości w sensie Portera6 (rozdział 2.2), globalnych łańcuchów dostaw7 oraz

nadbudowy etycznej, moralnej i filozoficznej związanej z normami społecznymi,

prawnymi, dobrym obyczajem. Aby ustalić racjonalność własnej produkcji dóbr,

wartość konsumpcji, czy też wartość rynkową, te podsystemy muszą definiować

i mierzyć wartość, która następnie może zostać weryfikowana przez otoczenie,

będące de facto jej adresatem.

Dla określenia wartości konieczne jest wprowadzenie pewnego konstruktu

logicznego, na który składa się:

system z funkcjonującą wartością (zbiór interesariuszy, organizacja),

zbiór korzyści rozumianych jako stany psychofizyczne lub emocjonalne interesariuszy, wynikające z pozyskania danego pozytywu (który albo sam

stanowi wartość albo posiada cechę wartości),

reprezentacji wymiernej korzyści wnoszonych przez dany pozytyw,

zbiór zasobów (w tym zasoby wiedzy i doświadczenie) umożliwiający realne tworzenie pozytywów,

zbiór użyteczności tego pozytywu, przekładających się na zbiór korzyści.

Wyobraźmy sobie teraz jak funkcjonuje system definiujący wartość. Otóż

ma on określone potrzeby i zasoby (w tym pieniądze) umożliwiające uruchomienie procesów ich zaspakajania. Z drugiej strony, system może generować wartość dysponując wiedzą, kreatywnością, przedsiębiorczością oraz możliwością

wykonania pracy, które to cechy można wymierzyć metodami oceny pozostającymi do dyspozycji, a następnie ustalić za pomocą posiadanych kryteriów wartość podjętych działań oraz poziom zaspokojenia potrzeb. Nie odbywa się to jednak ani w próżni, ani w izolacji od otoczenia. Dla całości działania systemu ekosystem biznesowy (otoczenie) wnosi: procesy wytwórcze, łańcuchy dostaw, towary i usługi oraz warunki funkcjonowania systemów generujących lub przejmujących wartość, możliwe do ustalenia metodą PESTLE8 (rozdział 6.3). Ale

żeby możliwe było funkcjonowanie wartości w takim układzie, konieczne są co

najmniej cztery elementy, którymi musi dysponować system:

Porter M. E., “Competitive Advantage”, Free Press, New York, 1985

Neace M.B., Gospodarek T., Neace X.G., „Global supply chains as holistic systems: an expanded perspective”, International Journal of Economics and Business Research, Vol 5, No 2, (2013), 165-182 http://gospodarek.eu/publikacje/Global%20Supply%20Chain%20as%20Holistic.pdf

8

Gospodarek T., „Zarządzanie dla racjonalnego menedżera”, DIFIN Warszawa, 2014.

6

7

12

zdefiniowany zbiór korzyści możliwych do wyrażenia za pomocą akceptowalnej

miary i skali (np. w jednostkach kapitałowych lub bezwymiarowej punktowej

oceny porównawczej albo w kategoriach dobra i zła),

zbiór zasobów i kluczowych kompetencji umożliwiających powstawanie lub

przejmowanie wartości w układzie z funkcjonującą wartością,

zdefiniowany zbiór użyteczności odpowiadających potrzebom, które mogą zostać zaspokojone za pomocą określonych pozytywów (towarów, usług lub

stanów psychofizycznych interesariuszy),

zbiór informacji powiązanych z wartością, możliwych do uwiadomienia przez

system i nadających się do przetwarzania w układzie wartości.

Zachodzą przy tym następujące fakty, przedstawione za pomocą układu relacji

zwrotnych i przechodnich, przedstawionych na rys. 1.2

1. Bez zasobów nie powstanie kapitał9. Bez kapitału nie powstaną wartościowe zasoby.

Zasoby stanowią to, co pozwala generować wartość lub ją przejmować. Jest

to ogólne pojęcie, które zawiera w sobie zarówno środki trwałe, jak i wiedzę,

zasoby ludzkie oraz kapitał. W teorii zarządzania ujęcie zasobowe stanowi

ważną teorię (RBT)10. Wartościowe zasoby i kluczowe kompetencje są tym,

co pozwala generować wartość i zajmować odpowiednią pozycję na rynku.

Kapitał zaś, w relacji do zasobów, stanowi reprezentację ilościową tychże

wartości, umożliwiając wyrażenie wartości w umownych jednostkach pieniężnych. Kapitał, będąc jednocześnie zasobem i równoważnikiem wartości,

stanowi siłę sprawczą dla tworzenia zasobów wartościowych i umożliwia

ich utrzymanie w stanie gotowości do kreowania określonych użyteczności

oraz korzyści.

2. Wartość nie istnieje, jeżeli obiekt wartościowy nie jest użyteczny w jakimkolwiek

sensie. Nie istnieje bowiem użyteczność bezwartościowa. Korzyścią dla systemu

wartościującego jest z pewnością zaspokojenie jego potrzeb. To może być

zrealizowane przez pozyskanie określonych dóbr lub usług (w szerszym

sensie, np. prawa, norm etycznych, etc.). Dobra te są z definicji użyteczne, a

zatem mają wartość, podobnie jak zasoby wartościowe. Co więcej mogą one

zasilić zbiór wartościowych zasobów systemu.

3. Wartość pozostaje w równowadze dynamicznej z kapitałem z nią powiązanym – kapitał sam z siebie stanowi wartość (intrinsic value). Kapitał jest reprezentacją wymierną wartości. Ten ciąg sądów stanowi kluczowe stwierdzenie na temat

miary wartości, definiując zarówno jej jednostkę i skalę. To samo dotyczy

Kapitał należy w tym miejscu rozumieć szerzej, niż u K. Marksa. Może to być dowolna forma określonego

potencjału oddziaływania systemu na otoczenie, rozróżniana w teorii zarządzania jako, np. kapitał ludzki,

kapitał społeczny, kapitał organizacyjny, kapitał intelektualny, kapitał relacyjny, etc. Szerzej na ten temat

pisałem w pracy „Aspekty złożoności i filozofii nauki w zarządzaniu”, str. 174-181.

10

Barney J. B., Clark D. N., “Resource Based Theory. Creating and Sustaining Competitive Advantage”,

Oxford University Press, Oxford, 2007.

9

13

oszacowania zasobów. Mogą one zostać ocenione jako wartościowe na podstawie miary użyteczności, ale również mogą być reprezentowane wartościowo poprzez ilość pieniądza, który można za nie otrzymać.

4. Użyteczność nie powstanie bez wartościowych zasobów. Wartościowe zasoby są z

definicji użyteczne i przynoszą korzyść ich posiadaczowi. To twierdzenie umożliwia przede wszystkim ustalenie, że zasoby są konieczne do generowania

wartości oraz to, że zasób może być wartością lub być wartościowym. Jeżeli

zgadzamy się z tym sądem, to z punktu widzenia teorii ekonomii i zarządzania, wszelkie teorie dotyczące zasobów odnoszą się bezpośrednio do teorii

wartości i budowania reprezentacji ilościowych. To jest bardzo istotny element w obronie pozycji teorii zasobowej zarządzania, jako wymiernego modelu reprezentatywnego stanu organizacji. Szerzej o roli teorii zasobowej i

koncepcji systemowej organizacji można znaleźć w rozdziale 2.1.

5. Korzyść stanowi warunek przemiany użyteczności na kapitał z udziałem zasobów.

Nie można ustalić wartości bez ustalenia wymiernej korzyści dla użyteczności. To

oznacza, że definiowanie wartości opiera się na korzyściach, które niesie ze

sobą dany pozytyw. Może on być użyteczny w jakimkolwiek sensie, również

metafizycznym (np. wzbudza pozytywne doznania z patrzenia na niego).

Żeby jednak daną użyteczność pozyskać, konieczne jest zaangażowanie odpowiednich zasobów, co może być równoważne zaangażowaniu odpowiedniego kapitału. Tym samym dla działań w zamkniętym układzie korzyśćzasoby-kapitał-użyteczność istnieje równoważność wartości, korzyści i użyteczności wyrażanej za pomocą kapitału albo wkładu kreatywności zasobów

w wygenerowanie danego pozytywu.

Powyższe kwestie pozwalają również zrozumieć problem odróżnienia wartości w sensie ekonomicznym (tej wymiernej w pieniądzu lub innej formie wymiennej) od wartości rozumianej jako dobro o niemierzalnych bezpośrednio korzyściach (np. pokój na danym terytorium, czyste środowisko, swoboda przemieszczania się…). Pewne dobra, takie jak woda, powietrze czy ciepło są pozytywami wewnętrznie dobrymi, a jednocześni stanowią wartościowe zasoby. Bez

nich nie byłoby możliwe życie i istnienie systemu z funkcjonującą wartością.

1.1.1 Człowiek w systemie generującym wartość

W rozważaniach nad wartością warto zająć się rolą człowieka w systemie

generującym wartość i posługującym się nią. Jest to związane z działalnością gospodarczą człowieka, jako unikatowym zjawisku. Należy mu przypisać domeny

aktywności, nie dające się zastąpić przez żadne systemy fizykalne, nie dające się

zmierzyć wprost, a przy tym stanowiące istotne aspekty zarządzania oraz ekonomii.

Przedsiębiorczość i innowacyjność – zdolność do działań prowadzących do pozyskania wartościowych dóbr, wprowadzania ich do otoczenia, nadzór nad

14

ich funkcjonowaniem, wymiana dóbr na równoważniki wartości, stanowiącą

cechę jednostki ludzkiej albo zorganizowanej grupy ludzi.

Tworzenie dzieł sztuki i bytów metafizycznych – zdolność do tworzenia dóbr służących zaspokojeniu potrzeb estetycznych, transcendentalnych i poznania.

Przykładem może być matematyka i filozofia, jako baza dla opisów rzeczywistości oraz muzyka jako ciąg dźwięków sprawiających przyjemność tym, którzy potrafią słuchać.

Podejmowanie i wykonanie decyzji – zdolność do rozwiązywania problemów w

sposób wariantowy, połączona z analizą ilościową i jakościową oraz racjonalizacją wyboru najlepszego wariantu. Elementem decyzji jest przekazanie informacji przez podejmującego decyzję i jej użycie przez wykonawcę pozostającego w relacji niezależnie od intencji, czy też konsekwencji wdrożenia działania.

Prowadzenie badań naukowych – specyficzna zdolność do odkrywania prawdy

na temat otaczającej nas rzeczywistości, związana z wykorzystaniem heurystyki, eksperymentu i wiedzy a priori. W wyniku badań naukowych powstaje

wartość, a czasem wartość ukryta zostaje w ich wyniku ujawniona.

Komunikowanie się i kreowanie zasobów wiedzy – zdolność do przekazania informacji do odbiorcy i jej zrozumienie przez adresata, a następnie dokonania jej

filtracji i przetworzenia na wiedzę oraz wartościowe zasoby, umożliwiające

generowanie wartości opartej na wiedzy, albo dodanie wartości do istniejących dóbr, zmieniające ich funkcjonalność lub użyteczność.

Tworzenie wartościowych zasobów i kluczowych kompetencji – zdolność do akumulacji dóbr materialnych i niematerialnych klasy VRIN11 oraz nabywanie

kluczowych umiejętności i kompetencji12, umożliwiających kreację wartości

przez systemy generujące wartość. Kreowanie unikatowych zasobów oraz

VRIN – Określone, kluczowe zasoby organizacji niezbędne do wdrożenia strategii kreowania wartości

przez organizacje. Są one scharakteryzowane przez cztery cechy:

1. VALUABLE – Zasoby muszą umożliwić wdrożenie strategii kreującej wartość, albo poprzez prze-wagę

konkurencyjną albo redukcję słabości. Istotnym jest że inwestycja w zasoby musi być niższa niż NPV

po określonym czasie, a IRR musi być większa niż zakładane dyskonto.

2. RARE – Unikatowość zasobu wartościowana jego cechą rynkową, jako generującego stosowny NPV

oraz pozycję rynkową organizacji. Taka unikatowość jest szczególnie widoczna przez ze-wnętrznego

obserwatora (wycena akcji).

3. IN-IMITABLE - Jeżeli jakiś zasób kontrolowany przez organizację stanowi źródło jej przewagi konkurencyjnej, wówczas ta przewaga będzie trwała do momentu do którego konkurenci nie będą w stanie

wytworzyć imitacji zasobu. (Czasami trudno jest ustalić skąd pochodzi przewaga, zwłasz-cza gdy wymiana kapitałowa organizacji oparta jest na wiedzy).

4. NON-SUBSTITUTABLE – Nawet jeżeli zasób unikatowy nie jest imitowalny, istnieje zawsze ryzy-ko

znalezienia rozwiązań alternatywnych i możliwość zastąpienia go. Stąd utrudnienia naśladow-nictwa

przez konkurencję stanowią istotny aspekt funkcjonowania organizacji.

12

Prahalad C.K., Hamel G., “Kluczowe kompetencje” Harvard Business Rev, vol. May-June, (1990), 7990. http://www.profrandes.com.br/wp-content/uploads/2013/03/Core-Competence-of-the-Corporation.pdf

11

15

budowanie kluczowych kompetencji stanowi jeden z celów działalności gospodarczej opisywany w teorii zasobowej zarządzania13.

Budowanie układów relacji oraz struktur organizacyjnych. System generujący wartość może być rozpatrywany jako układ interesariuszy, którzy powinni zostać

skompensowani w sposób zoptymalizowany w sensie Pareto. To oznacza, że

organizacje związane z generowaniem i bytowaniem wartości w otoczeniu są

strukturami ludzi powiązanych ze sobą relacjami wewnętrznymi oraz relacjami z sieciami zewnętrznymi (formalnymi i nieformalnymi) w celach prowadzenia działalności kreatywnej.

Tworzenie struktur społecznych, ekonomicznych oraz władzy. Ludzie łączą się w

grupy według określonych preferencji (religia, zasady moralne, cele, potrzeby, interesy) w wyniku czego wyłaniają się przywódcy oraz struktury hierarchiczne lub wyspecjalizowane podgrupy, narzucające swoje reguły współistnienia pozostałym. W ten sposób powstają państwa, organizacje, korporacje, sieci prowadzące do tworzenia nowych wartości społecznych, często

sprzecznych z interesami jednostki.

Podejmowanie ryzyka i prognozowanie. Ryzyko wynika z niepewności oszacowania skutków podjęcia określonej decyzji i jej wdrożenia (podjęcie działań).

Wiąże się to z prawdopodobieństwem poniesienia określonej straty (wartość

ujemna). Ale ewentualne korzyści w przypadku pozytywnych rezultatów

mogą przeważać potencjalne straty, co jest racjonalnym impulsem do podjęcia działań. Aby obniżyć ryzyko, człowiek lub system dokonuje prognozy

skutków podjęcia działań. Jest to ważny aspekt generowania wartości.

Definiowanie wartości i jej reprezentacji. Próby definiowania wartości są tak

stare, jak dzieje ludzkości, a jej wyrażanie w formie pieniężnej znane było ludziom starożytnym. Jednak uogólnienie wartości jako wynik aksjologicznej

analizy wielokryterialnej jest sam z siebie zagadnieniem złożonym, niosącym

znaczny ładunek subiektywizmu, a czasami demokratycznego wyboru. To

jest znamienne ludzkiemu działaniu i powoduje, że do dnia dzisiejszego nie

ma w pełni akceptowalnej teorii wartości ani sądów pewnych co do jej bytowania w otoczeniu.

Podejmowanie inteligentnych działań odkrywczych. Ciekawość świata była i jest

domeną natury ludzkiej. Wielkie odkrycia geograficzne, podróże w kosmos,

czy też zejście na dno Rowu Mariańskiego stanowią przykłady działań odkrywczych. To prowadzi zwykle do odkrywania nowych wartości albo konwersji wartości ukrytej do jawnej i wymaga złożonych działań inteligentnych,

których nie da się zautomatyzować, ani przedstawić formalnie. Wykorzystanie sprzężeń zwrotnych, reguły przekory, czy zasad minimum (np. minimum

Gospodarek T., „Aspekty złożoności i filozofii nauki w zarządzaniu”, Wydawnictwo WWSZiP, Wałbrzych, 2012; http://www.gospodarek.eu/publikacje/Filozofia%20nauki%20zarzadzanie.pdf

13

16

działania) jest fundamentem inteligentnych optymalizacji i pozwala na generowanie wartości dodanej.

Uczenie się, samorefleksja i sterowanie z wykorzystaniem sprzężeń zwrotnych. Systemy inteligentne będące zbiorowościami ludzkimi, do których można zaliczyć systemy dysponujące wartością lub generujące wartość, charakteryzują

się zdolnością do uczenia się, przekazywania wiedzy oraz wnioskowania o

faktach na podstawie danych dostarczanych z otoczenia w procesach sprzężenia zwrotnego. Takie zachowania można nazwać samorefleksją nad stanem

systemu, co umożliwia projektowanie i prognozowanie rozwoju w czasie w

sposób pożądany (wartościowy). W ten sposób zasoby wiedzy służą generowaniu wartości dodanej przez system.

Powyższe cechy stanowią o złożoności działań w obszarze generowania dóbr,

ich konsumpcji i posługiwania się wartością, przenosząc cechy złożoności na zagadnienia ekonomii, teorię zarządzania i nauki społeczne. Jednocześnie wskazują one na brak możliwości utworzenia ścisłej definicji i kwantyfikacji stanu

systemu generującego wartość, w tym zupełności opisu formalnego procesów

biznesowych.

1.1.2 Zasady etyczne i normy moralne

W każdej tradycji moralnej złota zasada postępowania, którą najlepiej wyraża sentencja „Nie czyń drugiemu, co tobie niemiłe” wydaje się być powszechnie

akceptowalnym fundamentem ludzkiego zmysłu etycznego. Na tej zasadzie

chciało by się budować relacje społeczne, biznesowe i systemowe. Ale istnieją

również dwie inne zasady: zasada klina „Daj palec – weźmie rękę” oraz „Kropla

drąży skałę” mające powszechne zastosowanie w relacjach gospodarczych, politycznych i społecznych. Ponadto znana jest również z obserwacji otoczenia alegoria równi pochyłej w odniesieniu do zasad etyki i moralności, kiedy to po pewnym czasie od rozpoczęcia działań, które nadwątliły fundamentalne reguły postępowania i współżycia społecznego, zadajemy sobie pytanie – jak do tego doszło?

Te przykłady wskazują, jak erozja norm moralnych albo pozornie błahe działania nieetyczne powoli, ale systematycznie prowadzą do nieodwracalnych zmian,

których nikt się nie spodziewał, podejmując intencję poluzowania ustalonych zasad. Tak oto wyłania się fundamentalny problem działalności biznesowej i zarządzania, wynikający z podstaw konsekwencjalizmu, który można wyrazić kolejną przypowieścią: „Cokolwiek czynisz, czyń rozważnie i patrz końca”.

Istnieją różnego rodzaju obiektywnie prawdziwe fakty, niezależne od nas

(np. opis naukowy eksperymentu, zjawisko przyrodnicze). Istnieją również

fakty etyczne, odnoszące się do rzeczy w świecie, które mogą być dobre lub złe.

G.E. Moore wprowadził pojęcie „błędu naturalistycznego”, polegającego na

utożsamianiu pojęć etycznych z pojęciami naturalnymi. „Dobro oznacza mniej więcej zawsze to samo co przyjemność ale pozostaje kwestią otwartą, czy przyjemność jest

17

zawsze dobrem”14. Problemem fundamentalnym etyki, który równie mocno rysuje

się w ekonomii i zarządzaniu jest: W jaki sposób można przejść od twierdzenia opisowego, które zdaje relację z tego jak jest do twierdzenia normatywnego – jak być powinno.

Mamy bowiem wokół nas określoną sytuację społeczno polityczną i geopolityczną. Mamy szereg relacji w otoczeniu, ale czy z tego wynika jak powinny one

wyglądać, żeby uznać je za moralne i etyczne. Czy sytuacja zadłużania Polski

dla doraźnych celów politycznych jest etyczna?

Jesteśmy przekonani, że żyjemy w świecie fizycznym, który może być zrozumiany dzięki prawom odkrywanym przez naukę (świat faktów obiektywnych, z którego wartości są wyłączone). Ale wypowiadając sądy etyczne (np. że

ludobójstwo jest czymś złym), wypowiadamy pewną prawdę o świecie – coś,

czego możemy się dowiedzieć i jest prawdziwe niezależnie od naszego stosunku

do tej kwestii. Niestety sądy te są zwykle obarczone znaczącym subiektywizmem, co szczególnie ciekawie przedstawił A.N. Whitehead: „Moralnym jest to,

co większość w danym miejscu i czasie lubi. Niemoralnym jest natomiast to, czego większość nie lubi”. Co oznacza określenie „dobre etycznie” w relacji do zarządzania?

Czy osiągnięcie celu ekonomicznego przez organizację stosując, np. oszustwa

podatkowe można uznać za „dobre zarządzanie”? Czy wykorzystywanie do

pracy dzieci przez niektórych producentów elektroniki można uznać za element

„dobrego zarządzania”? Są to pytania o ograniczenia moralne, nakładane nie

tylko na zarządzanie ale na całość działań biznesu. Nad tym każdy menedżer

musi się zastanowić. Tego się nie ureguluje prawem stanowionym.

Problemem stosowalności złotej zasady postępowania zawsze wymaga dokładniejszych rozważań ze względu na konieczność określenia kontekstu oraz

warunków jej skuteczności i sensowności (określenie kryteriów etycznych) dla

danej kwestii. Zbytnie uszczegółowienie może prowadzić do utraty ogólności i

powstania poważnych wątpliwości przy budowaniu analogii do znanych przypadków. Dlatego odwołanie do kryteriów pragmatycznych (uwzględniających

kontekst) wydaje się być nieuniknione, a te kryteria są zmienne i nie zawsze

oczywiste. Np. jeżeli egoista powoła się na fakt, że „wszyscy postępują jak egoiści”, wówczas złota zasada stanie się niespójna i wewnętrznie sprzeczna. Żądanie spójności sformułowania sądu etycznego jest zatem kluczowym kryterium

stosowalności złotej zasady. Dotyczy to zwłaszcza tych, którzy kierując się moralną krótkowzrocznością, preferują partykularyzm interesu własnego lub reprezentowanej organizacji. Obserwujemy te zjawiska w Polsce co cztery lata

wraz z kolejnymi wyborami władz. Nie ma moralności, zwłaszcza tej prawdziwie demokratycznej – jest partykularny interes do zrobienia.

Problem ten w filozofii znany jest jako “gilotyna Hume’a”.

14

18

Fundamentalnym problemem moralnym każdego menedżera powinno być

postępowanie zgodnie z zasadami etycznymi. Dylemat przebiega na linii podziału etyki opartej na obowiązku (deontologizm), od tej opartej na konsekwencjach (konsekwencjalizm). Konsekwencjalizm wiąże się z problemami wyboru w

zarządzaniu najmniejszego zła oraz zasadą „Cel uświęca środki”. Deontologizm,

zakłada obowiązek za wszelką cenę (nie patrząc na konsekwencje). Wyraża się

to sformułowaniem imperatywu kategorycznego „Postępuj zawsze według maksymy, abyś mógł zarazem chcieć, by stała się ona podstawą powszechnego prawodawstwa

[I. Kant]”. Przy dokonywaniu osądu moralnego podjętego działania, kluczową

rolę odgrywają intencje podmiotu. Zgodnie z zasadą podwójnego efektu: działanie, które miało zarówno dobre, jak i złe efekty, może zostać usprawiedliwione, jeżeli intencje z którymi było podejmowane były dobre, a efekty negatywne były jedynie przewidywane a nie zamierzone. Zasada powyższa rozróżnia przewidywanie skutków

działania od intencji.

Konsekwencjonalista stwierdza, że na pytanie o to, czy działanie jest dobre

bądź złe, powinno się odpowiadać wyłącznie na podstawie konsekwencji stanowiących jego wynik. Działanie staje się jedynie środkiem prowadzącym do uzyskania pożądanego celu, a jego etyczna wartość określona jest przez efektywność

z jaką dany środek do celu prowadzi. Celem konsekwenconalisty jest stan rzeczy

(zadowolenia, równowagi), będący konsekwencją różnorodnych działań. Wybór

działań wynika z oceny konsekwencji z nich płynących.

Działania podejmowane w systemach deontologicznych mogą być w samym sobie złymi lub dobrymi z punktu widzenia konsekwencjonalisty (nie są

postrzegane wyłącznie jako środki prowadzące do celu). Działania takie posiadają samoistną wartość etyczną, a nie wyłącznie instrumentalną – osiągania celu.

Czyn jedynie wtedy jest moralnie dopuszczalny, jeżeli można zastosować do

jego oceny imperatyw kategoryczny stale i powszechnie wobec siebie oraz innych (wariant złotej zasady postępowania).

1.1.3 Zasady optimum działania

Ten rozdział warto zacząć od przedstawienia założeń utylitaryzmu, jako

kierunku etycznego myślenia, wynikającego bezpośrednio z konsekwencjonalizmu. Ma on ogromne znaczenie w postępowaniu ludzi oraz systemów generujących wartość. Z jednej strony oferuje stosowanie zasad optymalności podejmowanych działań w ramach normalnej aktywności życiowej, z drugiej zaś, próbuje

ustalić kryteria ocen moralnych oparte na użyteczności i „rachunku szczęścia”.

Dla utylitarysty intencja czynu nie ma większego znaczenia etycznego – ważne

jest tylko, czy daje on więcej efektów korzystnych czy szkodliwych. Działania są

19

dobre w takim stopniu, w jakim prowadzą do szczęścia, złe zaś, jeśli prowadzą

do przeciwnych uzyskania szczęścia15.

Działania powinny być osądzane jako dobre bądź złe w zależności od tego

czy zwiększają, czy zmniejszają ludzkie dobre samopoczucie (czyli czy są użyteczne). Poszczególne przyjemności różnią się jedynie cechami ilościowymi (czas

trwania oraz intensywność), abstrahując od charakterystyk jakościowych. J.S.

Mill uzupełnił to, wprowadzając „przyjemności wyższe i niższe”16. Z kolei J.

Bentham zaproponował wprowadzenie „rachunku szczęścia”, umożliwiającego

pomiar ilości przyjemności i bólu wywołanych przez określone działania17. Jego

teoria słusznych działań sprowadza się do hasła „największe szczęście dla największej liczby ludzi”. Stąd większość działań ludzkich w społeczeństwach hołdujących konsumpcjonizmowi wyznaje właśnie takie zasady za optymalne działanie

i tak zarządza dostępnymi zasobami, żeby rachunek szczęścia był najwyższy.

Warto zauważyć, jak dobrze ta zasada koresponduje z II prawem H. Gossena18 o

maksymalizacji przyjemności z konsumpcji przy ograniczonych środkach.

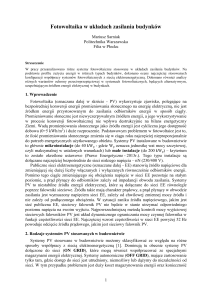

Rys. 1.3 Podstawowe prawa człowieka

Istnieje jednak jakiś ogólny i optymalny porządek moralny „prawo naturalne”, który wyznacza granice etyczne zachowań społecznych. Prawo naturalne

reprezentuje wartości samoistne, autonomiczne, uniwersalne i ponadczasowe,

które są przeciwstawiane prawu pozytywnemu, stanowionemu w danym czasie

Mill J.S., „Utylitaryzm”. 1863; http://www.earlymoderntexts.com/assets/pdfs/mill1863.pdf

Mill J. S., “Utilitarianism”, G.Sher Ed., 2nd Ed., Hackett Publishing Co. Inc., Indianapolis, 2001.

17

Bentham J., “Introduction to the Principles of Moral Legislation”, 1781 Batoche Books, Kitchener,

http://socserv2.socsci.mcmaster.ca/econ/ugcm/3ll3/bentham/morals.pdf

18

Gossen H.H., “Die Entwicklung der Gesetze des menschlichen Verkehrs und der daraus fließenden Regeln

für menschliches Handeln” (1854). Wersja angielska “The Laws of Human Relations and the Rules of Human

Action Derived Therefrom” (1983) MIT Press; Cambridge MA.

15

16

20

i miejscu przez określonych ludzi, zmienne na przestrzeni dziejów. Prawo naturalne ma uzasadniać (bronić) nienaruszalne prawa człowieka i jako takie jest

uważane za nadrzędne wobec prawa stanowionego, wobec czego zwolennik

prawa natury jest zwolniony z przestrzegania prawa stanowionego, gdy jest ono

z nim w sprzeczności. Koncepcje prawa natury poszukują odpowiedzi na pytania: jakie powinno być prawo stanowione, co to znaczy sprawiedliwość oraz czy

i kiedy można odmówić posłuszeństwa prawu stanowionemu. Jest to niewątpliwie jeden z najbardziej istotnych aspektów otoczenia ekonomii. Z prawa naturalnego wynikają bowiem prawa człowieka (rys. 1.3). Te prawa przekładają się

na zbiór potrzeb (rys. 1.4) dla godnego życia człowieka. I dlatego działania optymalne, zgodne z etyką utylitaryzmu można uznać za archetyp racjonalnego

zarządzania.

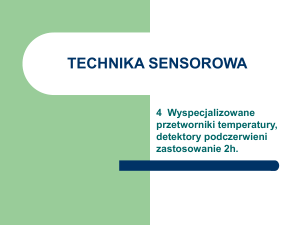

Rys. 1.4 Kostka prakseologiczna

Problematyką działań optymalnych zajmuje się prakseologia stanowiąca

konsekwencje zastosowania myśli konsekwencjonalizmu, rozwijana przez A.

Espinasa, T. Kotarbińskiego19,20,21, oraz L.von Misesa22,23. Zadaniem prakseologii

jest poszukiwanie najszerszych uogólnień odnoszących się do wszelkich form

świadomego i celowego działania, rozpatrywanego ze względu na sprawność;

konstruowanie i uzasadnianie dyrektyw praktycznych. Jest to poszukiwanie optymalności działania na wszelkich możliwych polach aktywności ludzkiej, w

Kotarbiński T., „Dzieła wszystkie. Traktat o dobrej robocie”, Wyd. Ossolineum, Wrocław , 2000.

Kotarbiński T., “Dzieła wszystkie. Prakseologia cz. I”, tom 6, Wyd. Ossolineum, Wrocław, 1999.

21

Kotarbiński T., “Dzieła wszystkie. Prakseologia cz. II”, tom 7, Wyd. Ossolineum, Wrocław, 2003.

22

Kotarbiński T., Praxiology. an introduction to the sciences of efficient action”, Pergamon Press, 1965

23

Mises L von, “The Ultimate Foundation of Economic Science. An Essay on Method”, D.van Nostrand,

Princeton, 1962.

19

20

21

tym działalności gospodarczej. Sens działania prakseologicznego najlepiej

przedstawia rys. 1.4

Każde działanie powinno być charakteryzowane przez zbiór cech umieszczonych na kostce, przy czym każda ściana zawiera cztery charakterystyki (atrybuty) cechy głównej, np. „gospodarność” jest określana przez: korzystność, oszczędność, wydajność i efektywność procesów. Jest to wskazanie kierunków optymalizacji działań dla racjonalnego zarządzania. To właśnie z zasad prakseologicznych wywodzą się japońskie metody produkcji i zarządzania: Kaizen, Kanban24 oraz wszelkie koncepcje z obszaru tzw. „lean management”25 (str. 151).

Jako podsumowanie niniejszego wywodu warto przytoczyć zasadę działań

optymalnych, w sformułowaniu W. Pogorzelskiego26, stanowiącą aksjomat centralny ujęcia systemowego: „Najogólniejszą, najbardziej powszechną, głęboką i wyrazistą przyczyną wszystkiego jest optymalność. W niej zawiera się cały ogrom wiedzy o

świecie”. Ta zasada wynika z obserwacji natury i jej funkcjonowania. Można ją

przenosić na racjonalne działania człowieka. Należy jednak zachować ostrożność w tej kwestii, albowiem racjonalność postępowania ludzkiego jest ograniczona przez wpływ otoczenia i braki informacji, co wykazał w swoich pracach

H. Simon27,28. Zgodnie z teorią ograniczonej racjonalności decyzje nie są podejmowane w sposób zgodny z zasadami minimum lub maksimum, ale w momencie osiągnięcia pewnego progu satysfakcji menedżera, niezależnie od poziomu

niepewności. Jest to jednak również jakaś forma optymalności, tyle że rozumiana

w sposób subiektywny. Tłumaczy to fakt, że model człowieka homo economicus J.

S. Milla w kwestiach podejmowania decyzji nie jest realizowany w praktyce w

100%. Relacje pomiędzy ekonomią a psychologią i socjologią umożliwiły powstanie koncepcji człowieka społeczno-ekonomicznego, racjonalności selektywnej i ograniczonej. Odnoszą się one do wpływu otoczenia i niemierzalnych kwestii na jednostkę przy podejmowaniu decyzji i jej wybory, a także do luki informacyjnej uniemożliwiającej w pełni racjonalne zachowania na rynku. Stały się

Imai M., „Gemba Kaizen. Zdroworozsądkowe, niskokosztowe podejście do zarządzania”, MT Biznes,

Warszawa 2012.

25

Ohno T., „System produkcyjny Toyoty. Więcej niż produkcja na wielką skalę”, ProdPress, Taylor &

Francis, Wrocław 2008, http://wydawnictwo.prodpublishing.com/wp-content/uploads/2011/07/System-Produkcyjny-Toyot-fragmenty.pdf oraz Art of Lean http://www.artoflean.com/files/Basic_TPS_Handbook_v1.pdf

26

Pogorzelski W., „O filozofii badań systemowych”, Wyd. Nauk. Scholar, Warszawa 2002, s. 47

27

Simon H.A., “Administrative Behavior”, Free Press, New York 1957.

28

Simon H.A., “Podejmowanie decyzji i zarządzanie ludźmi w biznesie i administracji”, wyd. 4, One Press

- Helion, Gliwice, 2007

24

22

one podstawą ekonomii behawioralnej i ważnego kierunku badań w obszarze

nauk o zarządzaniu29,30,31

1.2 Potrzeby i dobra

W zasadzie całość zagadnień psychologizmu w zarządzaniu i ekonomii zaczyna się od teorii potrzeb A. Maslowa32. Jej podstawy można wywodzić z benthamowskiej koncepcji „rachunku szczęścia” i postaw konsekwencjalnych czło-

wieka konsumenta. Teoria potrzeb nie ma wprawdzie ścisłego potwierdzenia,

ale praktyka pokazuje, że można posługiwać się nią w objaśnianiu wielu aspektów działalności gospodarczej oraz zarządzania z dobrym skutkiem. Podstawą

rozważań jest hierarchiczna piramida potrzeb przedstawiona na rys. 1.5.

Rys. 1.5 Hierarchia potrzeb wg Maslowa

Kahneman D., Tversky A., “Prospect theory: An analysis of decisions under risk”, Econometrica, 47,

(1979), 313-327.

30

Camerer, C.F., Löwenstein, G., “Behavioral Economics: Past, Present, Future.”, [w] Camerer, Löwenstein

and Rabin, “Advances in Behavioral Economics”, New York: Princeton University Press, (2004), pp. 1-51.

31

Sołek A., “Ekonomia behawioralna a ekonomia neoklasyczna”, Zeszyty Naukowe PTE, No. 8, (2010), 2134; http://www.pte.pl/pliki/1/1066/01_Solek.doc.pdf

32

Maslow, A. H., „Motivation and Personality”, Harper, New York 1954.

29

23

1.2.1 Potrzeby

A. Maslow stwierdził, że potrzeby funkcjonują na pewnych poziomach, niezależnie od siebie i hierarchicznie (tzn. potrzeby wyższego rzędu pojawiają się

dopiero po zaspokojeniu tych, niższego rzędu). Istnieją trzy zasadnicze grupy

potrzeb związanych z egzystencją (fizjologiczne, bezpieczeństwa i przynależności), z bytem metafizycznym (szacunku, poznania, estetyczne) oraz z refleksją

transcendentalną (samorealizacji, transcendencji), jak na rys. 1.5.

Człowiek rozwija się przez spełnianie coraz wyższych kategorii potrzeb.

Przy tym dopóki nie zostanie zaspokojona potrzeba kategorii niższej, jednostka

nie stara się zaspokajać potrzeb kategorii wyższej. Obserwuje się, że zaspokojone

w znacznej mierze potrzeby danego poziomu, najczęściej przestają motywować

i jednostka pozostaje na pewnym, określonym poziomie potrzeb. Może ona rozpocząć realizację potrzeby wyższego rzędu o ile dozna motywacji33.

W obrębie hierarchii potrzeb można wysunąć cztery hipotezy, które stanowią fundament zarządzania kadrami (Human Resources). Są to:

1. hipoteza frustracji: nie spełniona potrzeba staje się dominującą;

2. hipoteza regresji potrzeb: jeżeli nie może być spełniona potrzeba wyższego

rzędu, potrzeba niższa w hierarchii staje się dominującą;

3. hipoteza progresywności rozwoju: zaspokojenie potrzeby niższej hierarchii aktywuje hierarchicznie wyższe potrzeby;

4. hipoteza rozwoju przez frustrację: nawet stały poziom niezaspokojonych potrzeb może przyczynić się z czasem do rozwoju osobistego, uaktywniając potrzeby wyższego rzędu lub prowadząc do wyższego poziomu aspiracji.

Trzeba zaznaczyć, że zarówno jednostka (pracownik), jak i organizacja (pracodawca) mają swoje potrzeby, które zwykle znacząco się różnią. Menedżer musi

zdawać sobie sprawę z faktu, że pracownik przychodzący do pracy ma swoje

potrzeby kluczowe oraz pewien poziom egzystencji. Część z tych potrzeb może

zostać zaspokojonych wyłącznie przez organizację oraz przynależność do społeczności lub grupy. To jest właśnie punkt wyjścia dla wszelkich rozważań na

temat relacji pracownik – organizacja i budowania zespołu, którego cele są pokrewne celom organizacji (rozdział 2.3 oraz 4.5). Ten fakt można dobrze spożytkować, ale równie łatwo go zmarnować, budując korporacyjną strukturę frustratów wzajemnie się zwalczających w niezdrowej konkurencji. Wprawdzie ktoś

może stwierdzić, że korporacja posiada wysoką kulturę organizacyjną i wymiana w niej pracownika na innego nie wpływa na zdolność do kreowania wartości, ale odejście pracownika wiedzy powoduje czasami niemałe perturbacje,

których koszty mogą przekroczyć znacząco ewentualną poprawę warunków

pracy dla całej grupy.

Amstrong M., „Zarządzanie zasobami ludzkimi”, Oficyna Ekonomiczna Dom Wydawniczy ABC, Kraków,

2000

33

24

Motywacje, pragnienia, odczucia stanowią przedmiot nieustających badań

psychologii oraz ekonomii i nauk o zarządzaniu. Czy można z tych badań wywieść jakieś zdania o charakterze teoriotwórczym? Dotyczy to zwłaszcza zagadnienia, dlaczego człowiek podejmuje wysiłek i pracuje? Dlaczego zjawisko „wyścigu

szczurów” pojawiło się w dzisiejszym świecie? Warto wspomnieć w tym miejscu

o koncepcji ERG (Existence, Relatedness, Growth) C. Alderfera34, stanowiącej

modyfikację, a bardziej adaptację dla celów zarządzania, wspomnianej wcześniej

teorii potrzeb A. Maslowa32. Zakłada ona, że do działań w obrębie systemu społecznego, a zwłaszcza do pracy, motywuje jednocześnie kombinacja trzech kategorii potrzeb: egzystencjalnej (E), więzi społecznej (R) oraz stałego rozwoju osobistego (G) i przewiduje pewne relacje dominacji potrzeb wynikające z obserwacji.

Do koncepcji natężenia potrzeb ERG i ich relacji nawiązuje teoria osiągnięć

D. McClellanda35. Wyodrębnił on trzy podstawowe potrzeby człowieka w zakresie rozwoju osobistego „G” z koncepcji Alderfera: potrzebę osiągnięć (A), potrzebę przynależności (R) oraz potrzebę władzy (P). Za pomocą testu psychologicznego dokonał próby ilościowego oszacowania presji tych potrzeb i okazało

się, że w tym obszarze istnieje znaczące pole dla zajmujących się tematyką human

resources i budowaniem efektywnych zespołów w organizacjach. Przede wszystkim okazało się, że wartością nie są wyłącznie dobra materialne, ale równie

ważne są te niematerialne aspekty egzystencji. A zatem z punktu widzenia zarządzania jest to grupa bardzo interesujących zagadnień, które stanowią podstawę zarządzania kadrami, przywództwa oraz relacji człowiek-technologia.

1.2.2 Dobra

Potrzeby mogą zostać zaspokojone za pomocą dóbr, które należy rozumieć

jako pozytywy (materialne lub niematerialne), przynoszące jakąś korzyść interesariuszowi, wywołując u niego chęć ich pozyskania. Dobra powstają w wyniku działań

produkcyjnych, działań twórczych albo świadczenia usług. Jeżeli kreowanie

dóbr staje się stałym źródłem korzyści wytwórcy, takie działanie nazywa się

działalnością gospodarczą (rozdział 1.5).

Z dobrami powiązana jest ściśle wartość w sensie ekonomicznym oraz teoria

równowagi ogólnej, która zakłada, że istnieje pewien zbiór cen na dobra prowadzący do zrównoważenia podaży i popytu tych dóbr w całym systemie ekonomicznym. Dostawca (producent), oferuje dobra wartościowe, które można wycenić rynkowo przez parametr ceny. Konsument dysponuje ograniczonymi zasobami (kapitałem) i zwykle nie może zaspokoić wszystkich potrzeb, podobnie

jak producent nie może wyprodukować nieskończonej ilości dóbr. Stąd wynika

Alderfer C.P:, “Existence, Relatedness, and Growth; Human Needs in Organizational Settings”. Free Press,

New York 1972.

35

McClelland D.C., „Human Motivation”, Cambridge: Cambridge University Press, 1988.

34

25

istnienie pojęcia „preferencja” dla każdego konsumenta. Oznacza to, że spośród

wielu możliwych dóbr, wybiera on określone tak, żeby zaspokoić jak najlepiej

swoje potrzeby przy ograniczonym poziomie zasobów. Stanowią o tym prawa

Gossena, malejącej użyteczności krańcowej oraz wyrównywania krańcowej użyteczności36, a także teoria wartości w sensie ekonomicznym G. Debreu37. Ustala

ona ekonomiczne podstawy mikroekonomii. Fundamentalnym założeniem istnienia równowagi ogólnej jest stwierdzenie: można skonsumować tylko tyle ile uda

się wyprodukować.

Praktyka gospodarcza pokazuje, że nie można traktować wszystkich konsumentów w jednakowy sposób, jako anonimowego agenta, a dóbr jako identycznych co do uposażenia ontycznego obiektów, możliwych do zaklasyfikowania

do jednej kategorii (np. przestrzeni liniowej dóbr). To powoduje, że ekonomiczne

modele równowagi rynkowej, np. ADM38,39 pozwalają jedynie pozostawać w sferze rozważań teoretycznych. Udział emocji i psychologii w budowaniu preferencji oraz decyzji o zakupie powoduje, że cena równowagowa w wielu przypadkach nie jest możliwa do obliczenia metodami analizy kosztów, a jedynie poprzez autoadaptację do aktualnych warunków popytu (ustalanie cen przez aukcje lub giełdę). Tym samym podejmując się wartościowania dóbr należy w

wielu przypadkach odrzucić ściśle ilościowe kryteria ustalania cen, albowiem

istotniejsze są przesłanki behawioralne oraz siła ekspresji cech40,41. Subiektywizm

tych ocen wynika nie tylko z psychologizmu, ale również z pozycji oceniającego.

Można to zilustrować jak na rys. 1.6 (relatywizm oszacowania).

To, co może być zaliczone do kategorii dóbr nie musi mieć formy materialnej. Ten fakt stanowi o istnieniu całej grupy wartości niematerialnych i prawnych

oraz wartości intelektualnej, stanowiącej o tworzeniu kapitału intelektualnego.

Stanowią one dobra zaspokajające potrzeby związane z prawami człowieka (rys.

1.3) oraz potrzeby wyższej kategorii niż podstawowe w piramidzie Masłowa

(rys. 1.5). W zarządzaniu dobra niematerialne są niezwykle istotnym elementem,

choćby motywowania pracowników, czy też wartości dodanej do dóbr materialnych. Dotyczy to zwłaszcza informacji w formie programów sterujących oraz

Gossen H. H., “Die Entwicklung …“ op. Cit.

Debreu G., „Theory of Value. An Axiomatic Analysis of Economic Equilibrium”, Yale University Press,

New Haven and London, 1959. http:// http://cowles.econ.yale.edu/P/cm/m17 .

38

McKenzie L.W., “The Classical Theorem on Existence of Competitive Equilibrium”, Econometrica, Vol.

49, No. 4 (1981), pp. 819-841. http://www.dklevine.com/archive/refs41388.pdf

39

Düppe T., & Weintraub E.R., “Finding Equilibrium: Arrow, Debreu, McKenzie and the Problem of Scientific Credit”, Princeton Univ. Press, Princeton, 2014.

40

Porównajmy dwa samochody jaguar xj i fiat panda. Oba jadą do przodu, do tyłu. Oba mają fotele, szyby,

klamki, silnik, itd. Innymi słowy – mają podną użyteczność. Nie da się jednak zaprzeczyć, że samochody te

różnią się zasadniczo wszystkim cechami użytkowymi w sposób ewidentny. Mówimy wówczas, że ekspresja

cech limuzyny jaguara jest istotnie wyższa, niż fiata pandy. Jest to przedmiot dociekań aksjometrii, która

próbuje zmierzyć subiektywizm odbioru mentalnego danego dobra.

41

Hartman, R. S., "Axiometric Structure of Intrinsic Value", Journal of Value Inquiry (Summer, 1974; v.8,

no. 2, pp. 88-101

36

37

26

wiedzy ukrytej (np. dostarczonej wiedzy o optymalnym obiegu dokumentów w

systemie ewidencji w ramach oferowanego programu FK).

Rys. 1.6 Ilustracja subiektywizmu oceny wartości dobra

W odniesieniu do produktu wartość dodana stanowi istotne poszerzenie pojęcia produktu stanowiącego dobro42:

Produkt rdzenny (oferta bazowa). Zapewnia nabywcy korzyści bazowe.

Produkt generyczny (zdefiniowano ustaloną użyteczność lub funkcjonalność).

Jest tym, co nabywca rzeczywiście kupuje w myśl zasady „koń jaki jest każdy

widzi”.

Produkt oczekiwany (o zdefiniowanym uposażeniu ontycznym). Posiada cechy

fizyczne, możliwe do makroskopowej oceny takie, jak: kształt, kolor, marka,

model, cena, opakowanie, jakość;

Produkt poszerzony posiada dodane korzyści niematerialne, takie jak: forma

dostawy, gwarancja, rękojmia, serwis posprzedażny, usługi komplementarne, empatia załogi, sposób załatwiania reklamacji, instrukcje, instalacje on

site, finansowanie (kredyty, sprzedaż ratalna, odroczone terminy płatności).

“Theodore Levitt’s Product Level Hierarchy”, http://www.spookybin.com/study-zone/marketing-for-beginners/product-strategies/theodore-levitts-product-level-hierarchy/

42

27

Produkt potencjalny jest produktem poszerzonym charakteryzującym się zdefiniowanym oddziaływaniem z otoczeniem. Oprócz korzyści dodanych, obejmuje wszystkie działania oraz informacje, które mogą uczynić go jeszcze bardziej atrakcyjnym i przyciągnąć nabywcę (np. kastomizacja, marketing, forma

dostawy).

Zarządzanie ma na tym polu istotne zadanie: dopasowania możliwości konsumpcji społeczeństwa do potencjału sił wytwórczych, czego objawem są działania marketingowe i próby wykreowania nowych potrzeb oraz produktów w

celu zwiększania sprzedaży i poszerzenia rynku. Procesy te są ciągłe w czasie i

nieograniczone ani ilościowo ani jakościowo, podobnie, jak potrzeby.

Cykl życia produktu.

Nic nie jest wieczne. Upodobanie klientów są zmienne. Potrzeby są nieograniczone i dodatkowo zmienia się ich układ w czasie u każdego konsumenta. To