Rachunek prawdopodobieństwa – MAEW 104

Materiały do wykładu przygotowane przez

L. Janicką, M. Rutkowską, W. Wawrzyniak-Kosz

Literatura

[1] J.Jakubowski, R.Sztencel, Wstep do teorii prawdopodobieństwa, SCRIPT,

Warszawa 2001

[2] J.Jakubowski, R.Sztencel, Rachunek prawdopodobieństwa dla (prawie)

kaŜdego, SCRIPT,Warszawa 2002

[3] T.Inglot, T.Ledwina, T.Ławniczak, Materiały do ćwiczen z rachunku

prawdopodobieństwa i statystyki matematycznej, Wydawnictwo Politechniki

Wrocławskiej, Wrocław 1979

[4] H.Jasiulewicz, W.Kordecki, Rachunek prawdopodobieństwa i statystyka

matematyczna. Przykłady i zadania, GiS.Wrocław 2002

[5] W.Kordecki, Rachunek prawdopodobieństwa i statystyka matematyczna.

Definicje, twierdzenia, wzory , GiS, Wrocław 2002

[6] W.Krysicki, J.Bartos,W.Dyczka, K.Królikowska,M.Wasilewski, Rachunek

prawdopodobieństwa i statystyka matematyczna w zadaniach, część I, PWN

Warszawa, 1997

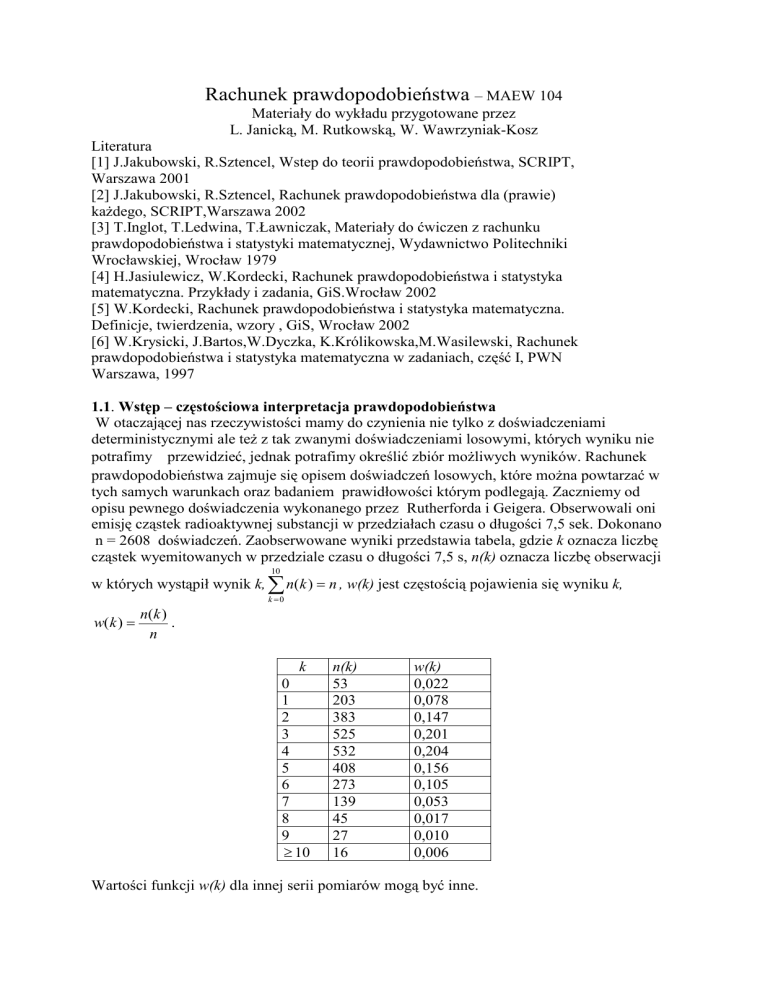

1.1. Wstęp – częstościowa interpretacja prawdopodobieństwa

W otaczającej nas rzeczywistości mamy do czynienia nie tylko z doświadczeniami

deterministycznymi ale teŜ z tak zwanymi doświadczeniami losowymi, których wyniku nie

potrafimy przewidzieć, jednak potrafimy określić zbiór moŜliwych wyników. Rachunek

prawdopodobieństwa zajmuje się opisem doświadczeń losowych, które moŜna powtarzać w

tych samych warunkach oraz badaniem prawidłowości którym podlegają. Zaczniemy od

opisu pewnego doświadczenia wykonanego przez Rutherforda i Geigera. Obserwowali oni

emisję cząstek radioaktywnej substancji w przedziałach czasu o długości 7,5 sek. Dokonano

n = 2608 doświadczeń. Zaobserwowane wyniki przedstawia tabela, gdzie k oznacza liczbę

cząstek wyemitowanych w przedziale czasu o długości 7,5 s, n(k) oznacza liczbę obserwacji

10

w których wystąpił wynik k, ∑ n(k ) = n , w(k) jest częstością pojawienia się wyniku k,

k =0

w(k ) =

n(k )

.

n

k

0

1

2

3

4

5

6

7

8

9

≥ 10

n(k)

53

203

383

525

532

408

273

139

45

27

16

w(k)

0,022

0,078

0,147

0,201

0,204

0,156

0,105

0,053

0,017

0,010

0,006

Wartości funkcji w(k) dla innej serii pomiarów mogą być inne.

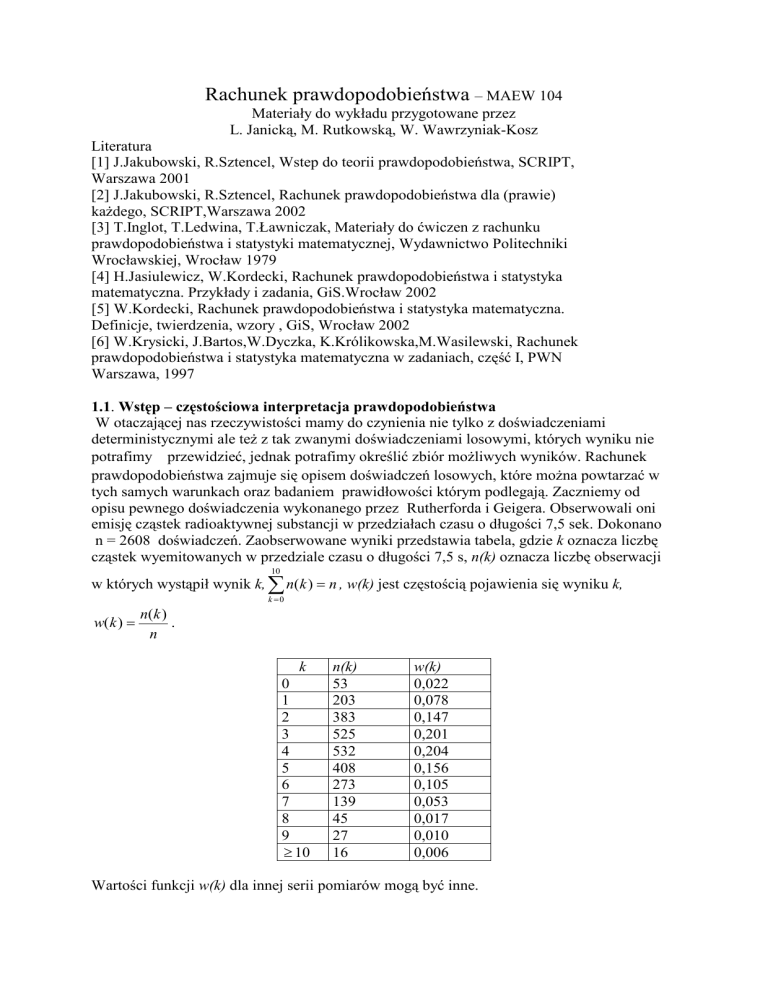

ZauwaŜono, Ŝe dla długich serii pomiarów wartości funkcji w(k) stabilizują się wokół

e − λ λk

wartości funkcji p(k ) =

, gdzie λ jest pewną stałą (w podanym przykładzie

k!

λ = 3,877871 ). Wartości funkcji p(k) nie zaleŜą od n.

k

n(k)

53

203

383

525

532

408

273

139

45

27

16

0

1

2

3

4

5

6

7

8

9

≥ 10

w(k)

0,022

0,078

0,147

0,201

0,204

0,156

0,105

0,053

0,017

0,010

0,006

p(k)

0,021

0,081

0,156

0,201

0,195

0,151

0,097

0,054

0,026

0,011

0,007

0,25

w(k), p(k)

0,2

0,15

w(k)

p(k)

0,1

0,05

0

0

1

2

3

4

5

6

7

8

9

10

liczba emitowanych cząstek

Inne przykłady doświadczeń losowych to rzut kostką, rzut monetą, obserwacja czasu

niezawodnej pracy pewnego urządzenia,..

1.2. Definicja i własności prawdopodobieństwa.

Zbiór wszystkich moŜliwych wyników doświadczenia losowego nazywamy przestrzenią

zdarzeń elementarnych i oznaczamy przez Ω .Elementy zbioru Ω nazywamy zdarzeniami

elementarnymi i oznaczamy przez ω.

Przykłady przestrzeni zdarzeń elementarnych.

1. W doświadczeniu Rutherforda i Geigera obserwowano liczbę cząstek wyemitowanych

przez ciało radioaktywne - Ω = {0,1,2,....} .

2. Wykonujemy rzut kostką - obserwujemy liczbę oczek na kostce - Ω = {1,2,3,4,5,6}

3. Obserwujemy czas t niezawodnej pracy urządzenia - Ω = {t : t ∈ [0, ∞)} .

4. Wyznaczamy czas ściągania pliku i liczbę przerw w jego ściąganiu Ω = {(t , k ) : t ∈ [0, ∞), k ∈ {0,1,2,....}} .

5. Rzucamy symetryczną monetą aŜ do pojawienia się orła - Ω = {O, RO, RRO,....} .

Zdarzeniem losowym nazywamy podzbiór Ω . Zbiór wszystkich zdarzeń oznaczać będziemy

literą F. Dla zdarzeń, podobnie jak dla zbiorów, określamy alternatywę (sumę) zdarzeń,

koniunkcję (iloczyn) zdarzeń, róŜnicę zdarzeń. Zdarzeniem przeciwnym do zdarzenia A

nazywamy zdarzenie A` = Ω \A. Ω nazywamy zdarzeniem pewnym, φ - zdarzeniem

niemoŜliwym. JeŜeli A I B = φ , to mówimy, Ŝe zdarzenia A, B wykluczają się.

Nie wszystkie podzbiory Ω będziemy uwaŜać za zdarzenie i zaliczyć do zbioru F.

Ze względu na wymagania dotyczące działań na zdarzeniach, zakładamy, Ŝe zbiór zdarzeń F

spełnia następujące warunki:

1 .F ≠ φ ,

2. A ∈ F ⇒ A'∈ F ,

∞

3. A1 , A2 ,... ∈ F ⇒ U An ∈ F

n =1

Rodzinę F nazywamy σ-ciałem zbiorów.

Z podanych warunków wynika, Ŝe Ω = A ∪ A′ ∈ F , jeśli A ∈ F oraz ,

φ = Ω′ ∈ F .

W przypadku dyskretnej (tzn. skończonej lub przeliczalnej) przestrzeni Ω zdarzeniem

losowym moŜe być dowolny jej podzbiór. W przypadku nieprzeliczalnej przestrzeni Ω

rodzinę F naleŜy precyzyjnie określić. W zagadnieniach dobrym modelem probabilistycznym

okazują się pewne podzbiory prostej, płaszczyzny lub przestrzeni. Za rodzinę F przyjmuje się

wówczas σ-ciało zbiorów borelowskich na prostej, płaszczyźnie lub w przestrzeni, przez co

rozumie się najmniejsze σ-ciało zbiorów zawierające przedziały otwarte (a, b) w R (koła

otwarte w R2, kule otwarte w R3) Mówiąc obrazowo, zbiór borelowski w R (w Rk ,k=2,3) to

kaŜdy zbiór, który moŜna otrzymać jako wynik przeliczalnych działań mnogościowych

wykonanych na rodzinie wszystkich przedziałów na prostej czy kul otwartych w przestrzeni

k-wymiarowej (k=2,3). Na przykład zbiorem borelowskim w R jest kaŜdy przedział

jednostronnie czy dwustronnie domknięty i kaŜda półprosta.

Opisując doświadczenia losowe podajemy zbiór wszystkich moŜliwych wyników, określamy

rodzinę F ale najbardziej interesujące są pytania o szansę zajścia poszczególnych zdarzeń. Tę

szansę określającą zajście zdarzenia mierzy funkcja zwana prawdopodobieństwem.

Definicja 1.2.

Prawdopodobieństwem nazywamy funkcję określoną na rodzinie zdarzeń F spełniającą

następujące warunki:

1.0 ≤ P ( A) ≤ 1, dla kaŜ deg o A ∈ F

2 .P ( Ω ) = 1

3. JeŜeli A1 , A2 ,... są parami rozłączne (tzn. Ai ∩ A j = φ , dla dowolnych i ≠ j ), to

∞

∞

n =1

n =1

P (U An ) = ∑ P ( An ) .

W szczególności P ( A ∪ B ) = P ( A) + P ( B ) dla zdarzeń rozłącznych A, B.

Z powyŜszych warunków (aksjomatów) wynika wiele własności prawdopodobieństwa,

z których najwaŜniejsze są przedstawione poniŜej:

Fakt 1.3.

1. JeŜeli A ⊂ B, to P( A) ≤ P( B),

2. P(A’) = 1 – P(A), a stąd P(φ) = 0.

3. JeŜeli A ⊂ B, to P( B \ A) = P( B) − P( A) = P( B) − P( A ∩ B)

4. P ( A ∪ B ) = P ( A) + P ( B ) − P ( A ∩ B ).

n

n

i =1

i =1

,

5. P (U Ai ) ≤ ∑ P ( Ai ) .

∞

6. JeŜeli A1 ⊂ A2 ⊂ ..., to P (U An ) = lim P ( An ),

n =1

∞

n →∞

7. JeŜeli A1 ⊃ A2 ⊃ ..., to P (I An ) = lim P ( An ).

n =1

n→ ∞

W przypadku trzech zbiorów A, B, C wzór z punktu 4. przyjmie postać:

P ( A ∪ B ∪ C ) = P ( A) + P ( B ) + P (C ) − P ( A ∩ B ) − P ( B ∩ C ) − P (C ∩ A) + P ( A ∩ B ∩ C ) a

przypadku dowolnej, skończonej liczby zbiorów wzór ten moŜna uogólnić w następujący

sposób:

n

P (U Ai ) =

i =1

∑ P( A ) − ∑ P( A

1≤i ≤ n

i

1≤i1 <i2 ≤ n

i1

∩ Ai2 ) + ... + (−1) n +1 P ( A1 ∩ ... ∩ An )

Fakt.1.4.

JeŜeli Ω = {ω i : i ∈ I } , gdzie I jest zbiorem skończonym lub I = N oraz P (ω i ) = pi , przy

czym pi ≥ 0 oraz

∞

∑p

i =1

i

= 1 , to dla A ⊂ Ω wzór P( A) =

∑p

ωi ∈A

i

określa

prawdopodobieństwo na rodzinie wszystkich podzbiorów zbioru Ω.

Trójkę (Ω, F, P) nazywamy przestrzenią probabilistyczną.

1

• Przykład 1.1.

Niech A, B, C będą zdarzeniami. Zapisać za pomocą działań na zbiorach następujące

zdarzenia:

a) zachodzi dokładnie jedno ze zdarzeń A, B, C;

b) zachodzą dokładnie dwa spośród zdarzeń A, B, C;

c) zachodzą przynajmniej dwa spośród zdarzeń A, B, C.

d) zachodzą co najwyżej dwa spośród zdarzeń A, B, C.

R o z w i ą z a n i e.

a) Zachodzi dokładnie jedno ze zdarzeń A, B, C, to oznacza dokładnie, że zachodzi A i nie

zachodzą B ani C lub zachodzi B i nie zachodzą A ani C lub zachodzi C i nie zachodzą

A ani B czyli, że zachodzi zdarzenie

A ∩ B ′ ∩ C ′ ∪ A′ ∩ B ∩ C ′ ∪ A′ ∩ B ′ ∩ C.

b) Podobnie — zachodzą dokładnie dwa spośród zdarzeń A, B, C oznacza, że zachodzi

zdarzenie

A ∩ B ∩ C ′ ∪ A ∩ B ′ ∩ C ∪ A′ ∩ B ∩ C.

c) Zachodzą przynajmniej dwa spośród zdarzeń A, B, C oznacza, że zachodzą dokładnie dwa spośród zdarzeń A, B, C lub zachodzą wszystkie trzy zdarzenia, czyli zachodzi

zdarzenie

A ∩ B ∩ C ′ ∪ A ∩ B ′ ∩ C ∪ A′ ∩ B ∩ C ∪ A ∩ B ∩ C.

d) Zachodzą co najwyżej dwa spośród zdarzeń A, B, C oznacza, że nie zachodzą wszystkie

trzy zdarzenia, czyli zachodzi zdarzenie

• Przykład 1.2.

(A ∩ B ∩ C)′ = A′ ∪ B ′ ∪ C ′ .

Studenci Wydziału Elektroniki muszą zaliczyć dwa lektoraty: z języka angielskiego i z języka niemieckiego. Z danych Dziekanatu wynika, że 23 studentów zalicza lektorat z języka

angielskiego, oba lektoraty zalicza co czwarty student, zaś przynajmniej jeden z lektoratów zalicza również 23 studentów. Jakie jest prawdopodobieństwo, że losowo wybrany

student:

a) nie zaliczył żadnego lektoratu?

b) zaliczył język angielski i nie zaliczył języka niemieckiego?

R o z w i ą z a n i e.

Niech A oznacza zdarzenie ”losowo wybrany student zaliczył lektorat z języka angielskiego”, przyjmujemy, że P (A) = 23 , B - zdarzenie ”losowo wybrany student zaliczył lektorat

z języka niemieckiego”.

a) Oczywiście chodzi o zdarzenie A′ ∩ B ′ , więc

P (A′ ∩ B ′ ) = P ((A ∪ B)′ ) = 1 − P (A ∪ B) = 1 −

1

2

3

=

1

3

b) Podobnie: P (A∩B) = 41 , P (A∪B) = 23 , więc P (A\B) = P (A)−P (A∩B) = 32 − 14 =

5

12

• Przykład 1.3.

Studenci Wydziału PPT zdają w sesji zimowej I roku egzaminy z przedmiotów A,B,C.

Wiadomo, z danych poprzednich lat, że przedmiot A zalicza 60% studentów, przedmiot B

zalicza 80% studentów i przedmiot C zalicza 70% studentów. Studenci, którzy zaliczyli A

i B stanowią 55% ogółu, ci którzy zaliczyli A i C stanowią 45% ogółu a studenci, którzy

zaliczyli B i C stanowią 60% ogółu. Sesję zimową zalicza ok. 40% studentów. Obliczyć

prawdopodobieństwo, że losowo wybrany student:

a) zaliczył przynajmniej jeden egzamin,

b) zaliczył przynajmniej dwa egzaminy.

R o z w i ą z a n i e.

7

Wiemy, że P (A) = 53 , P (B) = 45 , P (C) = 10

oraz

P (A ∩ B) =

55

,

100

P (A ∩ C) =

P (C ∩ B) =

45

,

100

60

,

100

P (A ∩ B ∩ C) =

40

.

100

Zatem:

a) P (A∪B∪C) = P (A)+P (B)+P (C)−P (A∩B)−P (B∩C)−P (C ∩A)+P (A∩B∩C) =

3

7

55

45

60

40

9

+ 54 + 10

− 100

− 100

− 100

+ 100

= 10

.

5

b) P (A ∩ B ∪ A ∩ C ∪ B ∩ C)) = P (A ∩ B) + P (A ∩ C) + P (B ∩ C) − P ((A ∩ B) ∩ (A ∩

C)) − P ((A ∩ B) ∩ (B ∩ C)) − P ((A ∩ C) ∩ (B ∩ C)) + P ((A ∩ B) ∩ (A ∩ C) ∩ (B ∩ C)) =

8

.

P (A ∩ B) + P (A ∩ C) + P (B ∩ C) − 2P (A ∩ B ∩ C) = 10

1.1

1.1.1

Przykłady przestrzeni probabilistycznych.

Prawdopodobieństwo klasyczne

Przestrzeń Ω = {ω1 , ω2 , . . . , ωn } jest zbiorem n zdarzeń elementarnych, z których każde

zachodzi z tym samym prawdopodobieństwem, czyli P ({ωk }) = n1 dla k = 1, 2, . . . , n.

Zgodnie z Faktem 1.4. wzór

P (A) =

A

,

n

(1)

gdzie A oznacza liczbę elementów zbioru A, określa prawdopodobieństwo na wszystkich

zdarzeniach A ⊂ Ω. Jest to tzw. prawdopodobieństwo klasyczne.

W rozwiązywaniu zagadnień, w których przestrzeń zdarzeń elementarnych jest skończona

przydadzą się nam wiadomości z kombinatoryki.

Podstawowe schematy kombinatoryczne

Niech A oznacza dowolny zbiór n różnych elementów A = {a1 , a2 , . . . , an }.

• Wariacje z powtórzeniami.

k-wyrazową wariacją z powtórzeniami zbioru A nazywamy każdy k-wyrazowy ciąg

elementów tego zbioru Liczba Vnk wszystkich wariacji k-wyrazowych z powtórzeniami ze

zbioru n-elementowego wynosi

k

V n = nk .

2

(2)

• Wariacje bez powtórzeń.

k-wyrazową wariacją bez powtórzeń zbioru A (k ¬ n)nazywamy każdy k-wyrazowy

ciąg różnych elementów tego zbioru Liczba Vnk wszystkich k-wyrazowych wariacji bez

powtórzeń ze zbioru n-elementowego wynosi

Vnk = n(n − 1)(n − 2) · · · · · (n − k + 1)

(3)

Jeżeli k = n, to k-wyrazową wariację bez powtórzeń ze zbioru A nazywamy n-wyrazową

permutacją. Zatem liczba Pn wszystkich permutacji zbioru n-elementowego wynosi

Pn = n!.

(4)

• Kombinacje.

k-elementową kombinacją bez powtórzeń z n-elementowego zbioru A nazywamy

każdy k-elementowy podzbiór zbioru A. Liczba Cnk wszystkich kombinacji k-elementowych

bez powtórzeń ze zbioru n-elementowego wynosi

!

n

k

.

(5)

Cn =

k

• Kombinacje z powtórzeniami.

k-elementową kombinacją z powtórzeniami z n-elementowego zbioru A nazywamy zbiór składający się z k elementów, różnych lub nie różniących się między sobą,

wybranych spośród n elementów, przy czym nie jest istotna kolejność, w jakiej elementy

k

tego zbioru są ustawione. Liczba C n wszystkich k-elementowych kombinacji z powtórzeniami ze zbioru n-elementowego jest taka sama, jak liczba wszystkich różnych zbiorów

k-elementowych, jakie można utworzyć ze zbioru (n+k-1) elementów. Kombinacje z powtórzeniami można interpretować, jako rozmieszczenie k nierozróżnialnych elementów w n

szufladach, przy czym w każdej szufladzie może być dowolna, nie przekraczająca k, liczba

elementów.

!

!

k+n−1

k+n−1

k

.

(6)

=

Cn =

n−1

k

• Przykład 1.4.

W teorii cząstek elementarnych bada się rozmieszczenie k cząstek w podzielonej na komórki przestrzeni fazowej, którą można matematycznie opisać np.jako podzbiór przestrzeni

czterowymiarowej, gdzie współrzędnymi są położenie i pęd cząstki. Fizycy stwierdzili doświadczalnie, że niektóre cząstki zachowują się, jak kule rozróżnialne, inne - jak kule

nierozróżnialne i zaproponowali trzy następujące modele zachowania się cząstek :

a) statystyka Maxwella-Boltzmanna. Cząstki zachowują się, jak kule rozróżnialne, więc

pytając o liczbę możliwych rozmieszczeń k cząstek w n komórkach mamy do czynienia z

wariacjami z powtórzeniami i każde spośród nk rozmieszczeń jest jednakowo prawdopodobne. Nie znaleziono jeszcze cząstek, które zachowywałyby się zgodnie z tym modelem.

b) statystyka Fermiego-Diraca. Cząstki zachowują się, jak kule nierozróżnialne, ale w każdej komórce może być co najwyżej jedna cząstka i wszystkie możliwe rozmieszczenia są

jednakowo prawdopodobne. Tak zachowują się np. elektrony, protony i neutrony.

c) statystyka Bosego-Einsteina. Cząstki zachowują się, jak kule nierozróżnialne, w każdej

3

komórce może być dowolna liczba cząstek i wszystkie możliwe rozmieszczenia są jednakowo prawdopodobne. Tak zachowują się np. fotony.

Zadanie — w każdym z rozważanych wyżej modeli wyznaczyć prawdopodobieństwo, z

jakim k (k ¬ n) cząstek można rozmieścić po jednej w k z góry zadanych komórkach.

R o z w i ą z a n i e.

a) Przy ustalonej permutacji k rozróżnialnych cząstek tylko jedno rozmieszczenie spośród

wszystkich nk możliwych rozmieszczeń spełnia żądany warunek. Ponieważ cząstki można ustawić na k! sposobów, więc prawdopodobieństwo, z jakim k rozróżnialnych cząstek

można rozmieścić po jednej w k z góry zadanych komórkach równe jest nk!k .

b) Jeżeli nie odróżniamy cząstek, ale w każdej komórce może być co najwyżej jedna to

wystarczy

wybrać k spośród n komórek i wrzucić do niej cząstkę, a to można zrobić na

n

sposobów.

Tylko jeden z nich spełnia warunek z zadania, więc prawdopodobieństwo,

k

z jakim k nierozróżnialnych cząstek można rozmieścić po jednej w k z góry zadanych

komórkach wynosi n1 .

(k )

c) W tym przypadku mamy do czynienia z k-elementowymi kombinacjami z powtórzeniami z n różnych elementów. Dla ustalonych k-komórek jest tylko jeden ciąg cząstek

spełniający warunki zadania, więc prawdopodobieństwo, z jakim k nierozróżnialnych czą1

.

stek można rozmieścić po jednej w k z góry zadanych komórkach wynosi k+n−1

( k )

• Przykład 1.5.

W pudle są kule białe i czarne. Razem jest ich n. Ile powinno być kul czarnych, aby prawdopodobieństwo wylosowania (bez zwracania) dwu kul różnych kolorów było takie samo,

jak prawdopodobieństwo wylosowania dwu kul tego samego koloru?

R o z w i ą z a n i e.

Dwie spośród n kul można wybrać na n2 sposobów. Oznaczmy przez k liczbę kul czarnych. Zdarzeniu A ”wylosowano dwie kule różnych kolorów” sprzyja k(n −k) zdarzeń

elementarnych. Zdarzeniu B ”wylosowano kule tego samego koloru” sprzyja k2 + n−k

2

zdarzeń elementarnych. Wykorzystując wzór na prawdopodobieństwo klasyczne otrzymujemy

P (A) =

k·(n−k)·2

n(n−1)

oraz

P (B) =

2k 2 −2nk+n2 −n

.

n(n−1)

Ponieważ zdarzenia A i B są przeciwne, to zamiast warunku P (A) = P (B) wystarczy

rozważać jeden z warunków P (A) = 12 lub P (B) = 21 . Każdy z nich jest równoważny

równaniu

4k 2 − 4kn + n2 − n = 0.

√

√

Rozwiązaniami tego równania są liczby k1 = n+2 n oraz k2 = n−2 n . Zauważmy,

że jeżeli

√

√

n nie jest liczbą naturalną, to zadanie nie ma rozwiązania. Jeżeli zaś n jest liczbą

naturalną, to zarówno

k1 =

√

n− n

2

=

√

√

n( n−1)

2

jak i k2 =

√

n+ n

2

=

√

√

n( n+1)

2

są liczbami naturalnymi oraz k1 + k2 = n.

Podsumowując — zadanie ma rozwiązanie

jedynie w przypadku, gdy n jest kwadratem

√

liczby naturalnej

(tylko wówczas √n jest√liczbą

naturalną), czarnych kul powinno być

√

√ √

√

n( n−1)

n( n+1)

n− n

n+ n

k1 = 2 =

lub k2 = 2 =

.

2

2

4

• Przykład 1.6.

W szufladzie są dwie skarpety na prawą nogę i jedna na lewą nogę. Prawdopodobieństwo,

że losowo wybierając dwie skarpety otrzymamy parę równe jest 23 = 23 , zaś prawdopodo(2 )

2

()

bieństwo wyciągnięcia dwu prawych wynosi 32 = 13 . Do szuflady dołożono jedną skarpetę.

(2)

Jaka to jest skarpeta, skoro teraz prawdopodobieństwo, że wylosowane dwie skarpety stanowią parę, wynosi 12 ?

R o z w i ą z a n i e.

Wykorzystajmy poprzedni przykład. Mamy n = 4. Wylosowanie pary skarpet odpowiada wylosowaniu kul różnych kolorów. Zatem skarpet jednego typu może być k1 = 3 lub

k2 = 1, czyli dołożono prawą skarpetę.

• Przykład 1.7.

Przypuśćmy, że do jeziora zawierającego nieznaną liczbę N ryb wpuszczono dodatkowo

1000 ryb oznakowanych (np. pomalowanych na czerwono). Po pewnym czasie dokonano

połowu 1000 ryb i znaleziono wśród nich 100 ryb z czerwonymi plamami. Jak na podstawie tych danych ocenić liczbę ryb w jeziorze?

R o z w i ą z a n i e.

Za ocenę N przyjmiemy taką liczbę, dla której prawdopodobieństwo wyłowienia 100 znaczonych ryb spośród 1000 jest największe. Przyjmując, że liczba ryb w jeziorze równa

się (N + 1000), wyznaczymy prawdopodobieństwo pN (A), gdzie A oznacza zdarzenie polegające na wylosowaniu 100 ryb oznaczonych przy losowaniu 1000 ryb. Ω jest zbiorem

kombinacji 1000-elementowych ze zbioru N + 1000 elementowego. Wśród wylosowanych

jest 900 nieoznakowanych, więc N ­ 900. Stąd

Ω=

N +1000

1000

A=

,

1000

100

N

900

,

więc

pN (A) =

N

(1000

100 )(900 )

.

N+1000

( 1000 )

Aby określić najbardziej prawdopodobną liczbę ryb w jeziorze, wyznaczymy wartość N,

przy której pN (A) osiąga wartość maksymalną. Rozpatrzmy

pN (A)

pN−1 (A)

=

N2

(N −900)(N +1000)

=1+

−100N +900·1000

.

(N −900)(N +1000)

Zauważmy, że iloraz ten jest większy od 1 bądź mniejszy niż 1 w zależności od tego, czy

100N < 900 · 1000, czy 100N > 900 · 1000. Oznacza to, że gdy N rośnie, liczby pN (A)

najpierw rosną a potem maleją. Rozważany iloraz osiąga wartość największą, gdy N jest

, czyli N = 900·1000

lub N = 8999.

największą liczbą naturalną nie przekraczjącą 900·1000

100

100

1.1.2

Przeliczalna nieskończona przestrzeń probabilistyczna

Niech Ω = {ω1, ω2 , . . . }. Jeżeli P (ωi ) = pi przy czym pi ­ 0 oraz

dobieństwo zdarzenia A ⊂ Ω określone jest wzorem

X

pi .

P (A) =

ωi ∈ A

5

∞

P

i=1

pi = 1, to prawdopo(7)

• Przykład 1.8.

Dwaj gracze, A oraz B, rzucają na przemian monetą, dopóki dwa razy pod rząd upadnie

ona na tę samą stronę. Jeżeli drugi pod rząd orzeł albo druga pod rząd reszka pojawi się

w rzucie nieparzystym, to wygrywa gracz A. W przeciwnym przypadku wygrywa gracz

B. Obliczyć prawdopodobieństwo wygranej dla każdego z graczy.

R o z w i ą z a n i e.

W opisanej grze zdarzeniem elementarnym jest ciąg, którego elementami są orły lub reszki

i na ostatnich dwu miejscach, po raz pierwszy pod rząd są dwa orły lub dwie reszki, czyli

Ω = {oo, rr, orr, roo, oroo, rorr, . . .} ma nieskończenie, ale przeliczalnie, wiele zdarzeń

elementarnych. Niech αk oznacza zdarzenie ”druga reszka pod rząd pojawiła się po raz

pierwszy w k-tym rzucie monetą”, zaś βk - ”drugi orzeł pod rząd pojawił się po raz

pierwszy w k-tym rzucie.”. Oczywiście k = 2, 3, . . . . Na przykład α5 = ororr, β5 = roroo.

Prawdopodobieństwo dla zdarzeń αk , βk wynosi

P ({αk }) = P ({βk }) = 2−k , k = 2, 3, . . . .

Gracz A wygra, jeżeli zajdzie zdarzenie A = {α3 , β3 , α5 , β5 , . . .}. Wygranej gracz a B

sprzyja zdarzenie A = {α2 , β2 , α4 , β4 , . . .}. Zatem

P (A) =

∞

P

k=1

oraz

P (B) =

P ({α2k+1 , β2k+1}) = 2

∞

P

k=1

P ({α2k , β2k }) = 2

∞

P

k=1

∞

P

k=1

2−(2k+1) = 2 · 2−3 ·

2−2k = 2 · 2−2 ·

1

1−2−2

1

1−2−2

=

1

3

= 32 .

Prawdopodobieństwo wygranej gracza, który rzuca monetą na parzystych miejscach jest

dwa razy większe niż gracza, który rzuca monetą na nieparzystych miejscach. W tej grze

pozwólmy przeciwnikowi rozpocząć grę! My rzucajmy na miejscach parzystych!

1.1.3

Prawdopodobieństwo geometryczne

W wielu zagadnieniach zbiór Ω można przedstawić jako podzbiór borelowski przestrzeni

IR (IR2 lub IR3 ), który ma skończoną miarę m - długość (pole, objętość). Dla zdarzenia

losowego A ⊂ Ω, dla którego tę miarę potrafimy obliczyć, prawdopodobieństwo zdarzenia

A zdefiniowane wzorem

m(A)

,

(8)

P (A) =

m(Ω)

nazywamy prawdopodobieństwem geometrycznym.

• Przykład 1.9.

Kawałek drutu o długości 20cm zgięto pod kątem prostym w przypadkowo wybranym

punkcie. Następnie zgięto drut jeszcze w dwu punktach tak, by powstała ramka prostokątna o obwodzie 20cm.

a) Jakie jest prawdopodobieństwo, że pole ograniczone ramką nie przekroczy 21cm2 ?

b) Jakie jest prawdopodobieństwo, że pole ograniczone ramką jest równe 21cm2 ?

R o z w i ą z a n i e.

a) Niech x oznacza odległość wybranego punktu od bliższego końca drutu. Wówczas

Ω = [0, 10]. Zdarzenie A ”pole ograniczone ramką nie przekracza 21cm2 ” zachodzi wtedy

i tylko wtedy, gdy x(10 − x) ¬ 21. Rozwiązując nierówność

−x2 + 10x − 21 ¬ 0 dla x ∈ [0, 10]

6

otrzymujemy

A = {x ∈ [0, 10] : x ∈ [0, 3] ∪ [7, 10]}, więc P (A) =

m(A)

m(Ω)

=

6

.

10

b) Niech B oznacza zdarzenie ”pole ograniczone ramką jest równe 21cm2 ”. Wówczas B

zachodzi wtedy i tylko wtedy, gdy x = 3 lub x = 7, więc P (B) = m(B)

= 0, ponieważ

m(Ω)

długość zbioru złożonego z dwu punktów wynosi 0. Zauważmy, że zdarzenie B jest możliwe

ale prawdopodobieństwo jego zajścia równe jest 0.

• Przykład 1.10.

W każdej chwili odcinka czasu T jednakowo możliwe jest nadejście do odbiornika każdego z dwu sygnałów, które w tym odcinku czasu zostaną przesłane. Odbiornik nie może

przyjąć drugiego sygnału, jeżeli nadejdzie on w czasie krótszym niż τ od chwili nadejścia

pierwszego sygnału. Obliczyć prawdopodobieństwo przyjęcia przez odbiornik obu sygnałów.

R o z w i ą z a n i e.

Niech x i y oznaczają czasy nadejy

ścia sygnałów do odbiornika. Wtedy

przestrzeń zdarzeń elementarnych

T

Ω = {(x, y) : x, y ∈ [0, T ]}

możemy interpretować jako kwadrat

o boku T a interesujące nas zdarzenie można zapisać w postaci

τ

O

τ

A = {(x, y) ∈ T × T : |x − y| ­ τ }.

Zatem P (A) =

(T −τ )2

• Przykład 1.11.

T2

= 1−

2

τ

T

T

x

Rys. 1.01.

.

Z przedziału [0, 1] wybieramy losowo trzy liczby x, y, z. Jakie jest prawdopodobieństwo,

że ich suma jest liczbą z przedziału [ 21 , 1]?

R o z w i ą z a n i e.

W tym przykładzie Ω = {(x, y, z) : 0 ¬ x, y, z ¬ 1}, czyli geometrycznie Ω jest sześcianem

jednostkowym. Rozważane zdarzenie to zbiór

n

A = (x, y, z) :

1

2

o

¬x+y+z ¬1 .

Tutaj m(A) jest objętością zbioru A, który jest różnicą dwu ostrosłupów. Zatem

m(A) =

1

3

1

2

·1·1− ·

1

2

Ponieważ m(Ω) = 1, więc P (A) = 81 .

7

1

2

·

1

2

=

1

3

·

3

8

= 81 .

2

Prawdopodobieństwo warunkowe.

Niezależność zdarzeń.

2.1

Prawdopodobieństwo warunkowe.

Niech (Ω, F , P ) będzie przestrzenią probabilistyczną, a B - dowolnie ustalonym zdarzeniem takim, że P (B) > 0.

• Definicja 2.1. Prawdopodobieństwem warunkowym zdarzenia A pod warunkiem B nazywamy liczbę

P (A ∩ B)

.

P (B)

P (A|B) =

Stąd oczywiście P (A ∩ B) = P (A|B)P (B).

Posługując się zasadą indukcji matematycznej możemy udowodnić, że dla dowolnego n,

przy założeniu, że P (A1 ∩ · · · ∩ An−1 ) > 0, prawdziwa jest równość

P (A1 ∩ · · · ∩ An ) = P (A1 )P (A2 |A1 )P (A3 |A1 ∩ A2 ) · . . . · P (An |A1 ∩ · · · ∩ An−1 ).

(9)

• Fakt 2.2.

Jeżeli P (B) > 0, to funkcja P (·|B) określona na F spełnia aksjomaty prawdopodobieństwa.

• Przykład 2.1.

Rzucamy dwa razy symetryczną kostką.

a) Jakie jest prawdopodobieństwo wyrzucenia różnej liczby oczek?

b) Jakie jest prawdopodobieństwo wyrzucenia różnej liczby oczek, jeżeli suma oczek wynosi 11?

c) Jakie jest prawdopodobieństwo wyrzucenia różnej liczby oczek, jeżeli suma oczek wynosi 10?

R o z w i ą z a n i e.

Przestrzeń zdarzeń elementarnych Ω jest zbiorem par uporządkowanych (a, b), gdzie

a, b ∈ {1, 2, 3, 4, 5, 6}. Wszystkie zdarzenia elementarne są jednakowo prawdopodobne.

a) Niech A oznacza zdarzenie ”wypadła różna liczba oczek”, czyli

A = {(a, b) ∈ Ω : a 6= b} = Ω \ {(1, 1), (2, 2), (3, 3), (4, 4), (5, 5), (6, 6)}.

= 56 . b) Zdarzenie ”suma

Ponieważ Ω = 62 = 36 oraz A = 36 − 6 = 30, więc P (A) = 30

36

oczek wynosi 11” oznaczmy przez B. Oczywiście B = {(5, 6), (6, 5)}. Ponieważ B ⊂ A,

więc B ∩ A = B i stąd

P (A|B) =

P (B)

P (B)

= 1.

W tym przykładzie informacja o zdarzeniu B dawała pewność, że zajdzie zdarzenie A.

c) Warunkiem jest zdarzenie D = {(4, 6), (6, 4), (5, 5)}. Mamy:

P (D) =

1

,

12

A ∩ D = {(4, 6), (6, 4)},

Zatem

8

P (A ∩ D) =

1

.

18

P (A∩D)

P (D)

P (A|D) =

= 23 .

Jak widać, przy różnych warunkach prawdopodobieństwo zajścia zdarzenia A jest różne.

• Przykład 2.2.

Wybrano losowo dwie liczby z przedziału [0, 1]. Jakie jest prawdopodobieństwo, że xy ­

0, 09 , jeżeli wiadomo, że x + y ¬ 1 ?

R o z w i ą z a n i e.

Przestrzeń zdarzeń elementarnych jest kwadratem jednostkowym Ω = {(x, y) : x, y ∈ [0, 1]}.

Interesujące nas zdarzenia to A = {(x, y) : xy ­ 0.09}

oraz B = {(x, y) : x + y ¬ 1}. Oczywiście P (B) = 21 .

Ponieważ

n

A ∩ B = (x, y) : 0.1 ¬ x ¬ 0, 9;

więc P (A ∩ B) =

Stąd P (A|B) =

• Przykład 2.3.

0.9

R

0,1

(1 − x −

P (A∩B)

P (B)

=2·

0,09

)dx

x

2

5

−

o

0,09

x

¬y ¬1−x ,

=

−

9

100

2

5

9

100

y

1

O

1

x

ln 9.

Rys. 1.02.

ln 9 .

Studenci Wydziału Elektroniki muszą zdać w I semestrze trzy egzaminy: z fizyki (A),

analizy matematycznej (C) i z algebry (B). Z danych Dziekanatu wynika, że 70% studentów zalicza I semestr a 90% - zdaje egzamin z fizyki. Jeżeli student zaliczy algebrę i

fizykę, to prawdopodobieństwo, że zda analizę wynosi 45 . Jakie jest prawdopodobieństwo,

że student, który zdał fizykę, zda algebrę?

R o z w i ą z a n i e.

Skorzystamy ze wzoru

P (A ∩ B ∩ C) = P (A) · P (B|A) · P (C|A ∩ B).

Mamy

2.2

7

10

=

9

10

· P (B|A) · 54 , skąd P (B|A) =

18

.

25

Wzór na prawdopodobieństwo całkowite i wzór Bayesa.

Załóżmy,że Ω jest sumą rozłącznych zbiorów Bi ∈ F dla i ∈ I. Wówczas dla dowolnego

S

zdarzenia A zbiory A ∩ Bi są parami rozłączne. Ponadto A =

(A ∩ Bi ), więc P (A) =

i ∈I

P

i∈

P (A∩Bi ). Jeżeli wszystkie zdarzenia Bi mają dodatnie prawdopodobieństwo, to P (A∩

Bi ) = P (A|Bi ) · P (Bi) dla każdego i ∈ I i otrzymujemy następujące twierdzenie.

• Twierdzenie 2.1. (Twierdzenie o prawdopodobieństwie całkowitym)

Jeżeli Ω jest sumą rozłącznych zbiorów Bi , przy czym P (Bi ) > 0 dla wszystkich i ∈ I, to

dla dowolnego zdarzenia A zachodzi równość

P (A) =

X

i∈I

P (A|Bi ) · P (Bi).

9

Czasem zdarzenia Bi występujące we wzorze na prawdopodobieństwo całkowite nazywamy przyczynami, zdarzenie A - skutkiem. Rozważmy zagadnienie w pewnym sensie

odwrotne do zagadnienia obliczania prawdopodobieństwa całkowitego. Mianowicie zapytajmy, jakie jest prawdopodobieństwo przyczyny Bi , gdy znany jest skutek A. Ponieważ

P (Bi ∩ A) = P (A|Bi ) · P (Bi), więc otrzymujemy tzw. wzór Bayesa

P (Bi |A) = P

P (A|Bi)P (Bi )

.

P (A|Bi ) · P (Bi)

(10)

i∈I

Wzór Bayesa nazywamy wzorem na prawdopodobieństwo przyczyny.

• Przykład 2.4.

Na stole leży 5 długopisów. Każde przypuszczenie (hipoteza) dotyczące liczby zepsutych

długopisów jest jednakowo prawdopodobne. Wybrany losowo długopis okazał się zepsuty.

Które przypuszczenie dotyczące liczby zepsutych długopisów jest najbardziej prawdopodobne?

R o z w i ą z a n i e.

Oznaczmy przez Hi hipotezę, że liczba zepsutych długopisów wynosi i, i = 0, 1, 2, 3, 4, 5.

Mamy P (Hi) = 16 . Niech A oznacza zdarzenie ”wylosowany długopis jest zepsuty”, wówczas P (A|Hi) = 5i . Zatem, ze wzoru na prawdopodobieństwo całkowite otrzymujemy

P (A) =

a stąd

5

X

i 1

1

· = ,

2

i=0 5 6

P (A|Hi) · P (Hi)

P (Hi|A) =

=

P (A)

i

5

·

1

2

1

6

=

i

.

15

Przy warunku, że wylosowano zepsuty długopis najbardziej prawdopodobne jest, że wszystkie długopisy są zepsute.

W statystyce prawdopodobieństwa hipotez P (Hi) nazywamy prawdopodobieństwami

a priori (przed doświadczeniem), prawdopodobieństwa P (Hi|A) - prawdopodobieństwami a posteriori (po doświadczeniu).

• Przykład 2.5.

Telegraficzne przesyłanie informacji polega na wysyłaniu sygnałów: 0 albo 1. Przy przesyłaniu 0 przekłamanie występuje w dwu przypadkach na trzydzieści, a przy przesyłaniu 1

przekłamanie występuje w dwu przypadkach na czterdzieści. Stosunek liczby wysyłanych

0 do liczby wysyłanych 1 wynosi 5 : 3. Obliczyć prawdopodobieństwo, że:

a) wysłano 0, jeżeli wiadomo, że odebrano 0,

b) wysłano 1, jeżeli wiadomo, że odebrano 1,

c) wysłano 1, jeżeli wiadomo, że odebrano 0.

R o z w i ą z a n i e.

a) Oznaczmy przez B1 zdarzenie ”wysłano 0”, przez B2 zdarzenie ”wysłano 1”,

A1 zdarzenie ”odebrano 0” oraz przez A2 zdarzenie ”odebrano 1” . Wiemy, że

P (A2|B1 ) =

2

,

30

P (A1 |B2 ) =

10

2

,

40

P (B1 )

P (B2 )

= 53 .

przez

Zgodnie ze wzorem Bayesa, prawdopodobieństwo zdarzenia ”wysłano 0, jeżeli odebrano

0” równe jest

P (B1 |A1 ) =

P (A1 |B1 )·P (B1 )

.

P (A1 )

Zdarzenia B1 , B2 spełniają założenia twierdzenia o prawdopodobieństwie całkowitym,

więc

P (A1 ) = P (A1 |B1 ) · P (B1 ) + P (A1 |B2 ) · P (B2 ).

Ponieważ P (B2 ) = 35 P (B1 ) oraz P (A1 |B1 ) = 1 − P (A2 |B1 ), więc

P (B1 |A1 ) =

1−P (A2 |B1 )

1−P (A2 |B1 )+P (A1 |B2 )· 53

=

280

289

≈ 0, 969.

b) Zgodnie ze wzorem Bayesa, prawdopodobieństwo zdarzenia ”wysłano 1, jeżeli odebrano

1” równe jest

P (B2 |A2 ) =

P (A2 |B2 )·P (B2 )

.

P (A2 )

Zdarzenia B1 , B2 spełniają założenia twierdzenia o prawdopodobieństwie całkowitym,

więc

P (A2 ) = P (A2 |B1 ) · P (B1 ) + P (A2 |B2 ) · P (B2 ).

Ponieważ P (B1 ) = 53 P (B2 ) oraz P (A2 |B2 ) = 1 − P (A1 |B2 ), więc

P (B2 |A2 ) =

1−P (A1 |B2 )

1−P (A1 |B2 )+P (A1 |B2 )· 53

≈ 0, 919

c) P (B2 |A1 ) = 1 − P (B1 |A1 ) = 1 − 0.969 = 0.031.

• Przykład 2.6.

Przeciętnie 3% wyprodukowanych elementów ma wadę. Do wykrywania wady stosuje się

test, który z prawdopodobieństwem 0, 9 wskazuje wadę (wynik testu pozytywny), jeżeli

element ma wadę i z prawdopodobieństwem 0, 95 nie wskazuje wady, jeżeli element jej nie

ma.

a) Jakie jest prawdopodobieństwo, że element ma wadę, jeżeli wynik testu jest pozytywny?

b) Jakie jest powyższe prawdopodobieństwo, jeżeli element poddamy testowi dwukrotnie

i za każdym razem otrzymamy pozytywny wynik testu?

R o z w i ą z a n i e.

a) Oznaczmy przez W zdarzenie ”element ma wadę” i przez N zdarzenie ”element nie ma

wady.” Zdarzenia te są rozłączne, W ∪ N = Ω oraz

P (W ) = 0.03,

P (N) = 0.97.

Niech D oznacza zdarzenie ”wynik testu jest pozytywny”. Z danych zawartych w zadaniu

wynika, że

P (D|W ) = 0.9,

P (D ′|N) = 0.95.

Do obliczenia prawdopodobieństwa zdarzenia ”element ma wadę, jeżeli wynik testu był

pozytywny”, czyli prawdopodobieństwa warunkowego P (W |D) wykorzystamy wzór Bayesa.

P (W |D) =

P (D|W )·P (W )

P (D)

=

P (D|W )·P (W )

P (D|W )·P (W )+P (D|N )·P (N )

=

0.9·0.03

0.9·0.03+0.05·0.97

= 0.358

ponieważ z własności prawdopodobieństwa warunkowego wynika, że

11

P (D|N) = 1 − P (D ′ |N).

Zatem, jeżeli wynik testu jest pozytywny, to prawdopodobieństwo, że losowo wybrany

element ma wadę wynosi 35, 8%, czyli wśród elementów, które test wskazuje jako wadliwe

tylko 35, 8% elementów ma wadę! Co wpływa na taką jakość testu? Jaki test byłby lepszy?

Dla wad, które występują rzadko należałoby wykorzystywać testy o większych wartościach

P (D|W ) oraz P (D ′ |N).

b) Obliczamy, jakie jest prawdopodobieństwo, że element ma wadę, jeżeli test przeprowadzony na nim dwukrotnie dał wyniki pozytywne.

Niech A oznacza zdarzenie ”test przeprowadzony dwukrotnie na elemencie dał za każdym

razem wynik pozytywny”. Wówczas

P (A|W ) = P (D|W ) · P (D|W ) oraz P (A|N) = P (D|N) · P (D|N).

2

P (A|W )·P (W )

(0.9) ·0.03

Stąd P (W |A) = P (A|W )·P

= (0.9)2 ·0.03+(0.05)

2 ·0.97 = 0.909. Zatem, jeżeli

(W )+P (A|N )·P (N )

dwukrotnie zastosowany test dał wyniki pozytywne, to prawdopodobieństwo, że element

ma wadę wynosi 0.909. Prawdopodobieństwo trafnej diagnozy znacznie wzrosło, gdy test

przeprowadzilśmy dwukrotnie! ťatwo policzyć, że prawdopodobieństwo zdarzenia ”element

ma wadę, jeżeli test przeprowadzony trzykrotnie na tym elemencie dał za każdym razem

wynik pozytywny” równe jest 0.994.

• Przykład 2.7.

Prawdopodobieństwo, że pogoda w danej miejscowości jest taka sama, jak dnia poprzedniego równe jest a dla dnia deszczowego i b — dla dnia bezdeszczowego (a, b ∈ (0, 1)).

Prawdopodobieństwo, że pierwszy dzień roku jest deszczowy równe jest p1 . Obliczyć prawdopodobieństwo pn , że n-ty dzień roku jest deszczowy.

R o z w i ą z a n i e.

Oznaczmy przez Dn zdarzenie ”n-ty dzień roku jest deszczowy”, a przez Bn zdarzenie

”n-ty dzień roku jest bezdeszczowy”. Wówczas dla dowolnego n ­ 1 mamy:

P (Dn+1 |Dn ) = a,

Policzmy

P (Bn+1 |Bn ) = b,

P (Dn+1 |Bn ) = 1 − b,

P (Bn+1 |Dn ) = 1 − a.

p2 = P (D2 ) = P (D2 |D1 ) · p1 + P (D2 |B1 ) · (1 − p1 ) = ap1 + (1 − b)(1 − p1 )

= p1 (a + b − 1) + 1 − b,

p3 = P (D3 ) = P (D3 |D2 ) · p2 + P (D3 |B2 ) · (1 − p2 ) = ap2 + (1 − b)(1 − p2 )

= p1 (a + b − 1)2 + (1 − b)(a + b − 1) + 1 − b,

p4 = P (D4 ) = P (D4 |D3 ) · p3 + P (D4 |B3 ) · (1 − p3 ) = p3 (a + b − 1) + 1 − b

= p1 (a + b − 1)3 + (1 − b)(a + b − 1)2 + (1 − b)(a + b − 1) + 1 − b,

Posługując się zasadą indukcji matematycznej można pokazać, że

pn = p1 (a + b − 1)

n−1

+ (1 − b)

n−2

X

k=0

(a + b − 1)k

1 − (a + b − 1)n−1

1−a−b+1

(1 − b)(a + b − 1)n−1

1 − b)

+ p1 (a + b − 1)n−1 −

.

=

(1 − a) + (1 − b)

(1 − a) + (1 − b)

= p1 (a + b − 1)n−1 + (1 − b)

Ponieważ a + b − 1 ∈ (0, 1), więc lim (a + b − 1)n−1 = 0 i stąd lim pn =

n→∞

n→∞

12

1−b

.

(1−a)+(1−b)

2.3

Niezależność zdarzeń.

• Definicja 2.3. Dwa zdarzenia A i B nazywamy niezależnymi, jeżeli

P (A ∩ B) = P (A) · P (B).

Jeżeli P (B) > 0, to z niezależności zdarzeń A i B wynika, że P (A|B) = P (A), czyli, jak

się potocznie mówi, zajście zdarzenia B nie ma wpływu na prawdopodobieństwo zajścia

zdarzenia A. Oczywiście dla dowolnego A ∈ F zdarzenia A i Ω są niezależne. Podobnie

- zdarzenia A i ∅ są niezależne. Jeżeli zdarzenia A i B są rozłączne i mają niezerowe

prawdopodobieństwa, to nie mogą być niezależne.

Zdarzenia A1 , A2 , A3 , . . . nazywamy rodziną zdarzeń niezależnych, jeżeli dla każdej

skończonej ilości zdarzeń Ai1 , Ai2 , . . . , Ain zachodzi równość

P (Ai1 ∩ · · · ∩ Ain ) = P (Ai1 ) · · · P (Ain ).

(11)

• Fakt 2.4. Jeżeli zdarzenia A1 , A2, . . . , An są niezależne, to niezależne są także zdarzenia

B1 , B2 , . . . , Bn , gdzie Bi = Ai lub Bi = Ai dla i = 1, 2, . . . , n.

′

• Przykład 2.8.

Wyrazić prawdopodobieństwo sumy n niezależnych zdarzeń Ai , i = 1, 2, . . . , n za pomocą

prawdopodobieństw poszczególnych składników.

R o z w i ą z a n i e.

Ponieważ

n

S

i=1

Ai = Ω \

n

T

i=1

A′i ,

więc korzystając z własności prawdopodobieństwa i z niezależności zdarzeń Ai , i =

1, 2, . . . , n możemy napisać

P

n

S

i=1

czyli

n

T

A′i ) = 1 −

[

n

Ai = 1 −

Ai = 1 − P (

P

i=1

i=1

n

Q

P (A′i ) = 1 −

n

Y

(1 − P (Ai )).

i=1

i=1

n

Q

i=1

(1 − P (Ai )).

(12)

W tym momencie warto sobie przypomnieć, jak się oblicza prawdopodobieństwo sumy

zdarzeń, o których nie wiadomo, czy są parami rozłączne (wzór ??). Widać, że, gdy

zdarzenia Ai są niezależne, ten dość skomplikowany wzór można mocno uprościć.

• Przykład 2.9.

Trzech kontrolerów jakości pracuje niezależnie. Pierwszy wykrywa 90% wad, drugi - 80%

a trzeci - 60%. Jaki procent wad wykrywają łącznie? Jaki procent wad wykrywa trzeci

kontroler a nie wykrywa pierwszy ani drugi?

R o z w i ą z a n i e.

Niech Ai oznacza zdarzenie ”wadę wykrył i-ty kontroler”. Wówczas:

P (A1 ) =

9

,

10

P (A2 ) =

8

,

10

P (A3 ) =

6

,

10

Wada zostanie wykryta, gdy zajdzie zdarzenie A = A1 ∪ A2 ∪ A3 . Wykorzystując wzór

na prawdopodobieństwo zdarzenia przeciwnego oraz prawa de Morgana otrzymujemy

13

P (A1 ∪ A2 ∪ A3 ) = 1 − P (A1 ∩ A2 ∩ A3 ).

′

′

′

Ponieważ z niezależności zdarzeń A1 , A2 , A3 wynika niezależność zdarzeń A1 , A2 , A3 , więc

′

′

′

P (A1 ∪ A2 ∪ A3 ) = 1 − P (A1 )P (A2 )P (A3) = 1 − 0, 1 · 0, 2 · 0, 4 = 0, 992.

′

′

′

Zatem łącznie kontrolerzy wykrywają 99, 2% wad.

Zdarzenie ”spośród trzech kontrolerów wadę wykrył tylko trzeci kontroler” można zapisać

′

′

′

′

jako zdarzenie A1 ∩ A2 ∩ A3 . Ponieważ te trzy zdarzenia (tzn. A1 , A2 , A3 ) są niezależne,

więc

P (A1 ∩ A2 ∩ A3 ) = 0, 1 · 0, 2 · 0, 6 = 0, 012.

′

′

• Przykład 2.10.

Niezawodnością urządzenia nazywamy prawdopodobieństwo tego, że będzie ono pracować poprawnie przez czas nie mniejszy niż T. Obliczyć niezawodność urządzeń, których

schematy przedstawiają poniższe rysunki. Liczby p1 , p2 , . . . oznaczają niezawodności poszczególnych, niezależnie pracujących elementów.

a)

p1

p2

pn

p1

p2

b)

pn

p5

p2

p1

p6

p3

c)

p4

p7

.

R o z w i ą z a n i e.

Niech Ai oznacza zdarzenie, że i-ty element pracuje poprawnie co najmniej przez czas T.

Wtedy pi = P (Ai ). Niech p oznacza niezawodność urządzenia.

a) Urządzenie pracuje niezawodnie wtedy i tylko wtedy, gdy niezawodny jest każdy element, czyli, gdy zajdzie zdarzenie A1 ∩A2 ∩. . .∩An . Wykorzystując niezawodność zdarzeń

Ai otrzymujemy

p = P (A1 ∩ A2 ∩ . . . ∩ An ) = p1 · p2 · . . . · pn .

b) Urządzenie pracuje niezawodnie wtedy i tylko wtedy, gdy przynajmniej jeden element

jest niezawodny, czyli, gdy zajdzie zdarzenie A1 ∪ A2 ∪ . . . ∪ An . Stąd

p = P (A1 ∪ A2 ∪ . . . ∪ An )

i wykorzystując prawa de Morgana oraz niezależność tych zdarzeń, otrzymujemy

′

′

′

′

′

′

p = 1 − P (A1 ∩ A2 ∩ . . . ∩ An ) = 1 − P (A1 ) · P (A2) · . . . · P (An ) = 1 −

14

n

Y

i=1

(1 − pi )

c) Urządzenie pracuje niezawodnie wtedy i tylko wtedy, gdy zajdzie zdarzenie A1 i zdarzenie A2 ∪ (A3 ∩ A4 ) i zdarzenie A5 ∪ A6 ∪ A7 . Wykorzystując wzór na sumę zdarzeń oraz

ich niezależność otrzymujemy

p = P (A1 ) · P (A2 ∪ (A3 ∩ A4 )) · P (A5 ∪ A6 ∪ A7 )

= p1 (p2 + p3 · p4 − p2 · p3 · p4 )(p5 + p6 + p7 − p5 · p6 − p6 · p7 − p5 · p7 + p5 · p6 · p7 ).

• Przykład 2.11.

Rozważamy rodziny posiadające n dzieci. Niech A oznacza zdarzenie, że rodzina ma dzieci obu płci, a B - rodzina ma przynajmniej jedną dziewczynkę. Czy zdarzenia A i B są

niezależne?

R o z w i ą z a n i e.

Przyjmując, że dzieci w rodzinie uporządkowane są np. według starszeństwa, oznaczmy

przez Ω zbiór ciągów n-elementowych o elementach 0 (dziewczynka) i 1 (chłopiec). Wówczas

Ω = 2n ,

A = 2n − 2, B = 2n − 1, A ∩ B = 2n − 2.

Zatem

P (A ∩ B) =

2n −2

,

2n

a P (A) · P (B) =

2n −2

2n

·

2n −1

2n

i równość nigdy nie zachodzi.

• Przykład 2.12.

Wkładamy losowo n ponumerowanych kul do n ponumerowanych szuflad. Jakie jest prawdopodobieństwo pn , że przynajmniej jedna kula trafi do szuflady o tym samym numerze?

Obliczyć lim pn .

n→∞

R o z w i ą z a n i e.

Niech Ai oznacza zdarzenie ”i-ta kula wpadła do i-tej szuflady, i = 1, 2, . . . , n . Każda

kula wpada niezależnie do każdej z szuflad z tym samym prawdopodobieństwem równym

1

. Stąd, wykorzystując wzór 12, otrzymujemy

n

pn = P (

Zatem lim pn = 1 − lim

n→∞

3

3.1

n→∞

n−1

n

n

n

S

i=1

Ai ) = 1 −

n−1

n

n

.

= 1 − e−1 .

Zmienne losowe jednowymiarowe.

Definicja oraz rozkład i dystrybuanta zmiennej losowej.

Matematyczny opis doświadczenia losowego wymaga sprecyzowania przestrzeni probabilistycznej, z którą mamy do czynienia. Wprowadzimy teraz pojęcia, które pozwolą uprościć

i stworzyć jednolity opis doświadczenia losowego. Zacznijmy od przykładu.

Badamy jakość czterech wyprodukowanych elementów. Każdy z nich może być dobry

(oznaczmy to przez 1) lub wadliwy (oznaczmy to przez 0). Mamy wówczas

Ω = {(ω1 , ω2 , ω3 , ω4 ) : ωi ∈ {0, 1}, i = 1, 2, 3, 4}.

15

F jest zbiorem wszystkich podzbiorów zbioru Ω. Faktycznie, najczęściej interesuje nas

tylko liczba elementów dobrych wśród sprawdzanych, czyli wynikowi (ω1 , ω2 , ω3 , ω4 ) przypisujemy liczbę (ω1 + ω2 + ω3 + ω4 ). Określamy zatem na Ω funkcję X o wartościach w IR

wzorem

X(ω1 , ω2 , ω3, ω4 ) = ω1 + ω2 + ω3 + ω4 .

•

Wartościami funkcji X jest jedna z liczb ze zbioru {0, 1, 2, 3, 4}.

Zdarzenie {(ω1 , ω2 , ω3 , ω4 ) : X(ω1 , ω2 , ω3 , ω4 ) = k} oznaczamy krótko (X = k).

Definicja 3.1. Zmienna֒ losowa֒ nazywamy każdą funkcję X : Ω −→ IR taką, że dla

dowolnego a ∈ IR zbiór (X < a) = {ω ∈ Ω : X(ω) < a} jest zdarzeniem losowym, czyli

{ω ∈ Ω : X(ω) < a} ∈ F dla dowolnego a ∈ IR.

W dalszym ciągu zapisujemy krótko

{ω ∈ Ω : X(ω) < a} = (X < a).

Z własności rodziny F wynika, że zdarzeniami losowymi są też wszystkie zbiory postaci:

(X ¬ a), (X > a), (X ­ a), (a < X < b), (a < X ¬ b), (a ¬ X < b).

Ze zmienną losową wiąże się pojęcie jej dystrybuanty.

• Definicja 3.2. Dystrybuanta֒ zmiennej losowej X: Ω → IR nazywamy funkcję

FX : IR → [0, 1] określoną wzorem:

FX (x) = P (X < x)

• Twierdzenie 3.1. Funkcja F : IR −→ IR jest dystrybuantą pewnej zmiennej losowej wtedy

i tylko wtedy, gdy :

• F jest niemalejąca,

• lim F (x) = 0,

x→−∞

lim F (x) = 1.

x→+∞

• F jest lewostronnie ciągła,

Z dwu pierwszych warunków wynika, że dla każdego x ∈ IR prawdziwa jest nierówność

0 ¬ F (x) ¬ 1.

16

• Przykład 3.1.

Czy można dobrać stałe a, b tak, by funkcja F (x) była dystrybuantą pewnej zmiennej

losowej?

x

gdy x ¬ −1,

ae

gdy −1 < x ¬ 1,

F (x) = 0, 5

b(2 − x1 ) gdy x > 1.

R o z w i ą z a n i e.

Sprawdźmy, czy istnieją stałe a, b, dla których F (x) spełnia założenia twierdzenia 3.1.

F (x) jest lewostronnie ciągła.

lim aex = 0, więc a ­ 0.

x→−∞

lim b(2 − x1 ) = 2b = 1, więc b = 12 . Aby F (x) była niemalejąca musi zachodzić warunek

x→+∞

−1

ae ¬ 21 oraz b = 12 . Zatem dla każdej pary liczb (a, b), gdzie 0 ¬ a ¬ 2e , b = 21 funkcja

F (x) jest dystrybuantą pewnej zmiennej losowej. Tylko dla pary liczb ( 2e , 12 ) F (x) jest

ciągła na IR.

Jeżeli potrafimy dla każdego podzbioru borelowskiego B określić prawdopodobieństwo,

z jakim X przyjmuje wartości w zbiorze B, to mówimy, że został określony rozkład

zmiennej losowej X:

PX (B) = P ({ω : X(ω) ∈ B}).

W dalszym ciągu oznaczamy krótko

P (X ∈ B) = PX (B).

Zauważmy, że rozkład zmiennej losowej spełnia aksjomaty prawdopodobieństwa.

Rozkład zmiennej losowej jest jednoznacznie wyznaczony przez jej dystrybuantę, co jest

treścią następującego faktu.

• Fakt 3.3. Prawdziwe są następujące równości:

1. P (X ­ a) = 1 − FX (a),

2. P (a ¬ X < b) = FX (b) − FX (a),

3. P (X = a) = FX (a+ ) − FX (a)

(stąd, jeżeli FX jest ciągła w punkcie a, to P (X = a) = 0),

4. P (X ¬ a) = FX (a+ ),

5. Jeżeli X jest typu ciągłego, to P (X = a) = 0 dla każdego a ∈ IR.

Wyróżniamy dwa zasadnicze typy zmiennych losowych: zmienne losowe typu skokowego i

zmienne losowe typu ciągłego.

•

Definicja 3.4. Mówimy, że zmienna losowa X jest typu skokowego lub X jest zmienna֒ dyskretna֒, jeżeli X przyjmuje skończenie lub co najwyżej przeliczalnie wiele wartości

P

pi = 1.

xi , i ∈ I przy czym P (X = xi ) = pi > 0 oraz

i∈I

Rozkład prawdopodobieństwa zmiennej dyskretnej nazywa się często funkcją prawdopodobieństwa i zapisuje w postaci

{(xi , pi) : i ∈ I}

17

Dystrybuanta FX : IR −→ [0, 1] zmiennej dyskretnej ma postać

FX (x) = P (X < x) =

X

pi .

{i:xi <x}

Jest to funkcja schodkowa, lewostronnie ciągła o skokach o wartości pi w punktach xi , i ∈ I.

• Przykład 3.2.

Zorganizowano następującą grę : gracz wyciąga z talii 52 kart dwie karty (bez zwracania).

Jeżeli są to dwa asy - gracz otrzymuje 20 punktów; jeżeli dwie figury (król, dama, walet) gracz otrzymuje 10 punktów; w każdym pozostałych przypadków gracz traci dwa punkty.

Znaleźć rozkład zmiennej losowej X oznaczającej wygraną gracza. Wyznaczyć i narysować

dystrybuantę X.

3.2

Najważniejsze rozkłady dyskretne

• Rozkład zerojedynkowy .

Mówimy, że zmienna losowa X ma rozkład zerojedynkowy z parametrem p (rozkład

B(1, p)), jeżeli X przyjmuje tylko dwie wartości oznaczane przez 1 i 0 (nazywane odpowiednio sukcesem i porażką) oraz

P (X = 1) = p, P (X = 0) = q = 1 − p gdzie p ∈ (0, 1).

Typowymi przykładami zmiennych o rozkładzie zerojedynkowym są zmienne losowe, które

opisują jakość wyrobu (dobry, wadliwy), pracę urządzeä dwustanowych czy wynik gry

(wygrana, przegrana).

• Rozkład dwumianowy - rozkład Bernoulli’ego

Eksperyment ze zmienną losową o rozkładzie B(1, p) powtarzamy niezależnie n razy. Niech

X oznacza liczbę sukcesów w n powtórzeniach. Wówczas

!

n k n−k

p q ,

P (X = k) =

k

dla k = 0, 1, . . . , n

Mówimy, że zmienna losowa zdefiniowana wyżej ma rozkład Bernoulli’ego z parametrami

(n, p). Piszemy wówczas, że zmienna losowa ma rozkład B(n, p). Łatwo sprawdzić, wykorzystując wzór na dwumian Newtona, że nieujemne wartości P (X = k) sumują się do 1:

n

P

k=0

P (X = k) =

n P

n

k=0

k

pk q n−k = (p + q)n = 1.

Zauważmy, że jeżeli Xi (i = 1, 2, . . . , n) są niezależnymi zmiennymi losowymi, z których

każda ma rozkład B(1, p), to zmienna losowa Y = X1 +X2 +. . .+Xn opisuje łączną liczbę

sukcesów w tych n próbach, czyli ma właśnie rozkład Bernoulli’ego z parametrami n, p.

Wartość k0 , którą zmienna losowa dyskretna przyjmuje z największym prawdopodobieństwem, nazywamy najbardziej prawdopodobną wartością X. Jeżeli X ma rozkład

B(n, p), to

(

(n + 1)p lub (n + 1)p − 1 gdy (n + 1)p ∈ IN

k0 =

[(n + 1)p] gdy (n + 1)p ∈6 IN.

18

• Przykład 3.3.

W pewnym biurze zainstalowano 10 drukarek. Każda z drukarek pracuje niezależnie średnio przez 12 minut w ciągu jednej godziny.

a) Jakie jest prawdopodobieństwo, że w losowo wybranej chwili będzie włączonych 7 drukarek? co najmniej 7 drukarek?

b) Jaka jest najbardziej prawdopodobna liczba drukarek włączonych w danej chwili?

R o z w i ą z a n i e.

Jeżeli drukarki pracują niezależnie średnio przez 12 minut w ciągu jednej godziny, to

zmienna losowa X oznaczająca liczbę drukarek włączonych w danym momencie ma roz12

kład Bernoulli’ego z parametrami n = 10, p = 60

= 15 .

Zatem prawdopodobieństwo,

że w losowo wybranej chwili będzie włączonych 7 druka 7 3

10

4

≈ 0.00079, a prawdopodobieństwo, że w losowo

rek wynosi P (X = 7) = 7 51

5

wybranej chwili będzie włączonych co najmniej 7 drukarek równe jest

P (X ­ 7) =

10 k 10−k

P

10

1

4

5

k

k=7

5

≈ 0, 00086.

Zatem, jeżeli zasilanie drukarek ustalone jest na poziomie dla sześciu drukarek, to prawdopodobieństwo przeciążenia (czyli P (X ­ 7)) równe 0,00086. Czyli średnio przeciążenie ma

miejsce w ciągu 86 minut na 100000 minut (1 minute na 1157 minut). Czy te rozważania

mogą pomóc w ustaleniu poziomu zasilania?

• Przykład 3.4.

Prawdopodobieństwo prawidłowo wykonanej czynności przez pracownika wynosi 0.99.

a) Jakie jest prawdopodobieństwo, że wszystkie spośród 100 takich samych, niezależnie

wykonywanych, czynności zostaną wykonane prawidłowo?

b) Jaka jest najbardziej prawdopodobna liczba czynności wykonanych prawidłowo?

Rozważyć powyższe pytania, gdy czynność będzię powtarzana 199 razy.

R o z w i ą z a n i e.

a) Liczba prawidłowo wykonanych czynności wśród 100 niezależnych powtórzeń opisanej

czynności jest zmienną losową o rozkładzie B(100, 0.99). Wszystkie czynności wykonane

prawidłowo opisuje zdarzenie (X = 100), więc

P (X = 100) =

100

100

(0.99)100 (0.01)0 ≈ 0.3660.

b) Ponieważ dla zmiennej losowej X liczba (n + 1)p = 101 · 0.99 = 99.99 nie jest całkowita, więc najbardziej prawdopodobną wartością X jest część całkowita z tej liczby, czyli

99. Zatem zmienna losowa z największym prawdopodobieństwem przyjmuje wartość 99 i

prawdopodobieństwo to wynosi

P (X = 99) =

100

99

(0.99)99 (0.01)1 ≈ 0.3697.

Niech zmienna losowa Y określa liczbę czynności wykonanych prawidłowo przy 199 powtórzeniach. Y ma rozkład B(199, 0.99), więc

P (X = 199) =

199

199

(0.99)199 (0.01)0 ≈ 0.1353.

Dla zmiennej losowej Y liczba (n + 1)p = 200 · 0.99 = 198 jest całkowita, więc Y z największym prawdopodobieństwem przyjmuje wartości 198 albo 197. Prawdopodobieństwo

to wynosi

P (X = 197) = P (Y = 198) = 0.2720.

19

Widać, że nawet jeżeli prawdopodobieństwo sukcesu w jednej próbie jest bardzo duże,

to prawdopodobieństwo samych sukcesów oraz największa wartość prawdopodobieństwa

maleje dość szybko wraz ze wzrostem liczby powtórzeń.

• Przykład 3.5.

Co jest bardziej prawdopodobne: wygrać z równorzędnym przeciwnikiem nie mniej niż 3

partie z 4 partii, czy nie mniej niż 5 partii z 8 partii?

R o z w i ą z a n i e.

Zmienna

losowa X określająca liczbę wygranych spotkań w czterech partiach ma rozkład

1

B 4, 2 , a zmienna losowa Y określająca liczbę wygranych spotkań w ośmiu partiach ma

rozkład B 8, 12 . Otrzymujemy zatem

P (X = 3) =

3 1

4

3

1

2

1

2

P (Y = 5) =

= 41 ,

5 3

8

5

1

2

1

2

=

7

.

64

Zatem bardziej prawdopodobne jest wygranie dokładnie trzech spośród czterech partii.

P (X ­ 3) =

P (Y ­ 5) =

5 3

8

5

1

2

+

1

2

3 1

4

3

1

2

1

2

6 2

8

6

1

2

1

2

+

+

4 0

4

4

1

2

1

2

7 1

8

7

1

2

1

2

=

+

5

,

16

8 0

8

8

1

2

1

2

=

11

,

16

czyli bardziej prawdopodobne jest wygranie przynajmniej pięciu spośród ośmiu partii niż

przynajmniej trzech spośród czterech partii.

• Rozkład Poissona z parametrem λ

Można udowodnić, że prawdziwe jest następujące twierdzenie.

• Twierdzenie 3.2. (Poissona)

Jeżeli (Xn ) jest ciągiem zmiennych losowych o rozkładzie dwumianowym B(n, pn ), przy

czym lim npn = λ, to dla każdego k ∈ IN zachodzi równość

n→+∞

lim

n→+∞

λk

n k

pn (1 − pn )n−k = e−λ .

k

k!

!

Mówimy, że zmienna losowa X ma rozkład Poissona z parametrem λ, λ > 0, jeżeli

P (X = k) =

λk −λ

e . dla k = 0, 1, 2, . . . .

k!

Oczywiście łatwo sprawdzić, że P (X = k) ­ 0 oraz

∞

P

P (X = k) =

k=0

∞

P

k=0

λk −λ

e

k!

= e−λ

∞

P

k=0

λk

k!

= e−λ · eλ = 1.

Przybliżanie rozkładu Bernoulli’ego rozkładem Poissona jest stosowane w przypadku, gdy

n jest duże (n ­ 50) a p — małe tak, by np(1 − p) ¬ 9.

Najbardziej prawdopodobną wartością zmiennej lososwej o rozkładzie Poissona jest

k0 =

(

λ lub λ − 1

[λ]

20

gdy λ ∈ IN

gdy λ ∈6 IN.

• Przykład 3.6.

Po mieście jeździ 1000 samochodów. Prawdopodobieństwo, że samochód ulegnie uszkodzeniu w ciągu jednej doby równe jest p = 0, 002. Jakie jest prawdopodobieństwo, że co

najmniej jeden samochód w ciągu doby ulegnie uszkodzeniu? Zakładamy, że samochody

psują się niezależnie. Jaka jest najbardziej prawdopodobna liczba uszkodzonych samochodów? Ile miejsc należy przygotować na stacjach obsługi,by z prawdopodobieństwem 0, 95

było wolne miejsce dla uszkodzonego samochodu?

R o z w i ą z a n i e.

Oczywiście możemy tu skorzystaćze schematu

Bernoulli’ego, czyli

1000

0

P (X ­ 1) = 1 − P (X = 0) = 1 − 0 (0.002) (0.998)1000 ≈ 0.8649, jednak takie obliczenia są żmudne.

Zgodnie z Twierdzeniem 3.2 (biorąc λ = 1000 · 0, 002 = 2) otrzymujemy

P (X ­ 1) = 1 − P (X = 0) = 1 −

20 −2

e

0!

≈ 0.8647.

Ponieważ (n + 1)p = 2.002 ∈6 IN, więc najbardziej prawdopodobną liczbą uszkodzonych

samochodów jest k0 = 2.

Aby odpowiedzieć na ostatnie pytanie należy znaleźć takie l, gdzie l jest liczbą miejsc w

stacji obsługi, że P (X ¬ l) ­ 0, 95, czyli P (X > l) = P (X ­ l + 1) < 0, 05.

Posługując się tablicami rozkładu Poissona znajdujemy l + 1 ­ 6, czyli l ­ 5.

• Przykład 3.7.

Wiadomo, że 1% produkowanych żarówek to braki. Obliczyć dokładnie i w przybliżeniu,

prawdopodobieństwo, że:

a) wśród losowo wybranych 100 żarówek nie ma ani jednej wybrakowanej,

b) wśród losowo wybranych 100 żarówek są 2 wybrakowane,

c) jaka jest minimalna liczba żarówek, które należy sprawdzić, by prawdopodobieństwo

znalezienia złej żarówki było nie mniejsze niż 0,9.

R o z w i ą z a n i e.

Niech X oznacza

liczbę wybrakowanych

żarówek wśród 100 wylosowanych.

0 100

100

1

99

1

−1 10

a) P (X = 0) = 0

=1

≈ e 0! ≈ 0, 368 (λ = 100 · 100

100

100

b) P (X ­ 2) = 1 − P (X = 0) − P (X = 1) ≈ 0.2642

c) Niech Y oznacza liczbę wybrakowanych żarówek wśród n wylosowanych. Y ma rozkład

1

). P (Y ­ 1) = 1 − P (Y = 0) ­ 0, 9, więc P (Y = 0) ¬ 0, 1. Zatem

Bernoulli’ego B(n, 100

szukamy n takiego, że P (Y = 0) =

• Przykład 3.8.

n

0

1

100

0 99

100

n

¬ 0.1. Stąd n ­ 230.

Śrubki są pakowane w pudełka po 100 sztuk. Prawdopodobieństwo, że śrubka jest wybrakowana wynosi 0,01. Ile sztuk należałoby dodać do każdego pudełka, aby w celach

marketingowych można było powiedzieć, że z prawdopodobieństwem nie mniejszym niż

0,9 w każdym pudełku jest co najmniej 100 sztuk dobrych?

R o z w i ą z a n i e.

Niech X oznacza liczbę elementów wybrakowanych w pudełku. Zmienna losowa X ma

rozkład Bernoulli’ego z parametrami n = 100, p = 0, 01. Zatem

P (X = 0) =

100

0

p0 (1 − p)100 ≈ 0, 366.

21

Jeżeli rozkład zmiennej X przybliżymy rozkładem Poisoona z parametrem

λ = 100 · 0, 01 = 1, to

P (X = 0) = e−1 ≈ 0, 367.

Dodanie do pudełka kilku (k0 ) elementów tylko nieznacznie zmieni parametr λ (np. dla

k0 = 2 jest λ = 1, 02 oraz P (X = 0) = e−1,02 ≈ 0, 36059). Korzystając z przybliżonego

rozkładu zmiennej X szukajmy więc najmniejszej liczby k0 , dla której

P (X ¬ k0 ) ≈ e−λ 1 +

λ

1!

+

λ2

2!

λk0

(k0 )!

+ ...+

­ 0, 9.

Przyjmując dla uproszczenia λ = 1 i korzystając z tablic rozkładu Poissona otrzymujemy

k0 = 2, bo

e−1 1 + 1 +

Dokładniej — dla λ = 1, 02 mamy

1

2

P (X ¬ 2) = e−1,02 1 +

= 0, 9196.

1,02

1!

+

1,02

2!

­ 0, 9295.

W rzeczywistości prawdopodobieństwo znalezienia co najmniej 100 sztuk dobrych w pudełku zawierającym 102 śruby (czyli dla X o rozkładzie Bernoulli’ego z parametrami

n = 102, p = 0, 01) wynosi

P (X ¬ 2) = (0, 99)102 + (0, 99)101 · 0, 01 · 1, 02 +

102·101

2

· (0, 99)100 · (0, 01)2 ≈ 0, 9169.

• Przykład 3.9.

Liczba komputerów, które mogą być zarażone wirusem przez pewną sieć ma rozkład Poissona z parametrem λ. W każdym zarażonym komputerze wirus niezależnie uaktywnia

się z prawdopodobieństwem p. Jakie jest prawdopodobieństwo, że wirus uaktywni się w

m komputerach?

R o z w i ą z a n i e.

Niech zmienna losowa X oznacza liczbę zarażonych komputerów. X ma rozkład Poissona

z parametrem λ. Ponieważ zdarzenia (X = k), k = 0, 1, 2, . . . są parami rozłączne oraz

∞

S

k=0

k

(X = k) = Ω i P (X = k) = e−λ λk! > 0, więc spełnione są założenia twierdzenia o

prawdopodobieństwie całkowitym. Niech zmienna losowa Y oznacza liczbę komputerów,

w których wirus uaktywni się. Mamy:

P (Y = m) = P (Y = m) ∩

∞

[

(X = k) = P

k=0

[

∞

k=0

((Y = m) ∩ (X = k)) .

Ponieważ zdarzenia (X = k), k = 0, 1, 2, . . . są parami rozłączne, więc zdarzenia (Y =

m) ∩ (X = k), k = 0, 1, 2, . . . są też parami rozłączne. Ponadto dla k < m jest (Y =

m) ∩ (X = k) = ∅. Zatem, wykorzystując twierdzenie o prawdopodobieństwie całkowitym

otrzymujemy

P (Y = m) =

∞

X

k=0

P ((Y = m) ∩ (X = k)) =

∞

X

k=m

P (Y = m|X = k) · P (X = k)).

Zdarzenie (Y = m|X = k) dla k ­ m oznacza, że spośród k zarażonych komputerów

wirus uaktywni się w m komputerach, w każdym z prawdopodobieństwem p (m sukcesów

w k próbach), czyli

22

P (Y = m|X = k) =

k

m

pm (1 − p)k−m.

Podstawiając wartości prawdopodobieństw i dokonując elementarnych przekształceń, otrzymujemy

P (Y = m) =

∞ P

k

m

k=0

=

e−λ

m!

k

pm (1 − p)k−m · e−λ λk!

m P

∞

((1−p)λ)l+m

p

1−p

l!

l=0

=

(pλ)m −λp

e .

m!

• Rozkład geometryczny z parametrem p.

Eksperyment ze zmienną losową o rozkładzie B(1, p) powtarzamy niezależnie dopóki pojawi się sukces. Niech X oznacza numer próby, w której sukces pojawił się po raz pierwszy.

Wówczas, kładąc q = 1 − p otrzymujemy

P (X = k) = pq k−1 , dla k = 1, 2 . . .

Mówimy, że zmienna losowa zdefiniowana wyżej ma rozkład geometryczny z parametrem

p. Prawdopodobieństwa zdarzeń (X = k) są wyrazami ciągu geometrycznego i sumują się

do 1:

∞

P

k=0

P (X = k) =

∞

P

pq k−1 = p

k=1

∞

P

k=1

q k−1 = p ·

1

1−q

= 1.

Zmienną o rozkładzie geometrycznym wygodnie jest interpretować jako czas oczekiwania

na pierwszy sukces, tzn. liczbę powtórzeń eksperymentu poprzedzających eksperyment,

w którym po raz pierwszy otrzymaliśmy sukces.

•

Fakt 3.5. Jeżeli zmienna losowa X ma rozkład geometryczny, to dla dowolnych liczb

naturalnych n0 , k zachodzi równość:

P (X > n0 + k|X > n0 ) = P (X > k).

O zmiennej losowej spełniającej warunek z Faktu 3.5 mówimy, że ma tzw. własność

braku pamięci. Ciekawszym jest fakt, że rozkład geometryczny jest jedynym rozkładem

dyskretnym posiadającym własność braku pamięci.

• Przykład 3.10.

Prawdopodobieństwo, że danego dnia w miejscowości A latem świeci słońce jest stałe i

równe p. Jakie jest prawdopodobieństwo, że jeszcze co najmniej przez 7 dni będzie piękna

słoneczna pogoda, jeżeli już od dwu tygodni świeci słońce?

R o z w i ą z a n i e.

Przy założeniu, że pogoda w danym dniu nie zależy od pogody w dniach poprzednich,

zmienna losowa X określająca liczbę kolejnych słonecznych dni ma rozkład geometryczny

z parametrem p. Zatem

P (X ­ 21|X ­ 14) = P (X > 20|X > 13) = P (X > 7) = (1 − p)7 .

23

• Przykład 3.11.

Główna wygrana w totolotku to prawidłowe skreślenie 6 liczb spśród 49. Jakie jest prawdopodobieństwo głównej wygranej za 1001 razem, jeżeli przez 1000 razy nie było głównej

wygranej?

R o z w i ą z a n i e.

Sześć liczb spośród 49-u można wybrać na 49

sposobów (uporządkowanie liczb nie jest

6

istotne). Wygranej sprzyja tylko jeden spośrod 49

jednakowo prawdopodobnych sposo6

bów, czyli prawdopodobieństwo głównej wygranej p równe jest

p=

1

(496)

=

1

,

13983816

można powiedzieć, że jest bliskie jeden do czternastu milionów.

Grę w ”Toto-lotka” powtarza się i w każdym powtórzeniu prawdopodobieństwo głównej

wygranej równe jest wyżej obliczonemu p. Niech zmienne losowa X określa numer losowania, w którym główna wygrana pojawi się po raz pierwszy. X ma rozkład geometryczny z

parametrem p. Prawdopodobieństwo głównej wygranej za 1001 razem, jeżeli przez 1000 razy nie było głównej wygranej to prawdopodobieństwo warunkowe P (X = 1001|X > 1000).

Zatem

P (X = 1001|X > 1000) =

P (X=1001∩X>1000)

P (X>1000)

=

P (X=1001)

.

P (X>1000)

Ponieważ

P (X > 1000) =

∞

P

P (X = k) =

k=1001

więc

∞

P

k=1001

q k−1 p = q 1000 ·

P (X = 1001|X > 1000) =

q 1000 ·p

q 1000

p

1−q

= q 1000 ,

= p,

czyli prawdopodobieństwo wygranej za 1001 razem, jeżeli nie wygraliśmy przez pierwsze

1000 jest takie samo, jak prawdopodobieństwo wygranej za pierwszym razem. Na tym

polega własność ”braku pamięci” rozkładu zmiennej losowej, a ma ją opisana zmienna

losowa X. Jeżeli wiemy, że zmienna losowa przyjęła wartość większą niż n, to wszystkie

następne wartości n+k są przyjmowane z takimi samymi prawdopodobieństwami, z jakimi

przyjmowane są wartości k. ”Przeszłość, jeżeli dotrwamy do chwili n, nie ma wpływu na

”przyszłość”.

• Rozkład Pascala z parametrami r,p.

Eksperyment ze zmienną losową o rozkładzie B(1, p) powtarzamy niezależnie dopóki pojawi się r sukcesów. Niech X oznacza numer próby, w której r-ty sukces pojawił się po

raz pierwszy. Wówczas dla r ­ 1, q = 1 − p mamy

k − 1 r k−r

p q , dla k = r, r + 1, . . . , gdzie r ­ 1, 0 < p < 1.

P (X = k) =

r−1

!

Mówimy, że zmienna losowa zdefiniowana wyżej ma rozkład Pascala z parametrami r, p.

Zmienną o rozkładzie Pascala wygodnie jest interpretować jako czas oczekiwania na pierwszy r-ty sukces.

24

• Przykład 3.12.

Na ulicy stoi sprzedawca gazet. Każdy z mijających go przechodniów kupuje gazetę z

prawdopodobieństwem p = 13 . Niech X oznacza ilość ludzi mijających go do momentu,

gdy sprzeda 100 gazet. Znaleźć rozkład zmiennej X.

R o z w i ą z a n i e.

X ma rozkład Pascala z parametrami r = 100, p = 31 ,

• Rozkład hipergeometryczny

Z populacji składającej się z N elementów jednego rodzaju i M elementów drugiego

rodzaju losujemy n elementów. Niech X oznacza liczbę elementów pierwszego rodzaju

wśród wszystkich wylosowanych. Wówczas

P (X = k) =

N

M

k

n−k

N +M

n

,

k = 0, 1, . . . , N.

Mówimy, że wyżej zdefiniowana zmienna losowa ma rozkład hipergeometryczny z parametrami N, M, n, n < N, n < M. Definicja jest poprawna, bo można sprawdzić, że

N

P

k=0

P (X = k) =

M

)

(Nk )(n−k

= 1.

N+M

)

(

n

k=0

N

P

Przybliżenie rozkładem Poissona możemy stosować również w przypadku, gdy zmienna

N

· n mieści się

losowa ma rozkład hipergeometryczny, gdzie N + M jest duże a liczba N +M

w przedziale (0, 10).

• Przykład 3.13.

Zauważmy, że w Przykładzie 1.7 liczba ryb oznaczonych wśród 1000 wyłowionych (jeżeli

w jeziorze jest N + 1000 ryb) jest zmienną losową o rozkładzie hipergeometrycznym z

parametrami N, M = 1000, n = 1000.

• Przykład 3.14.

Spośród liczb 1, 2, . . . , 35 losujemy pięć liczb. Jakie jest prawdopodobienstwo, że będą

wśród nich cztery mniejsze od 21? Jaka jest najbardziej prawdopodobna ilość liczb wylosowanych mniejszych od 21? Porównać wynik ze średnią z takich liczb.

R o z w i ą z a n i e.

W tym zadaniu mamy do czynienia ze zmienną losową (określającą ilość liczb mniejszych od 21 wśród wszystkich wylosowanych) o rozkładzie hipergeometrycznym, gdzie

N = 20, M = 15, n = 5, więc:

P (X = 4) =

(204)(151)

.

(355)

Warunek P (X = k) < P (X = k + 1) równoważny jest nierówności

15

15

)

( 20 )(5−(k+1)

)

(20k )(5−k

< k+1 35

,

35

(5)

(5)

której rozwiązanie daje k < 3.

25

• Przykład 3.15.

Pudełko kulek potrzebnych do zmontowania łożyska zawiera 10 sztuk o dodatniej odchyłce od nominalnego wymiaru średnicy i 15 sztuk - o ujemnej odchyłce. Do zmontowania

łożyska potrzeba 6 kulek, z których co najwyżej 3 mogą mieć dodatnią odchyłkę od nominalnego wymiaru średnicy. Jakie jest prawdopodobieństwo, że monterowi, który wybiera

6 kulek losowo, uda się zmontować łożysko?

R o z w i ą z a n i e.

Niech X oznacza liczbę kulek wśród 6 wybranych o ddatniej odchyłce. Monterowi uda

się zmontować łożysko, X ¬ 3. X ma rozkład hipergeometryczny z parametrami: N =

10, M = 15, n = 6. Zatem P (X ¬) = 1 − P (X = 4) − P (X = 5) − P (X = 6).

• Rozkład wielomianowy

Rozkład dwumianowy możemy uogólnić na przypadek n powtarzanych niezależnych eksperymentów, z których każdy może mieć jeden z k (k ­ 2) wyników. Niech pi oznacza

prawdopodobieństwo realizacji wyniku i-tego rodzaju w każdej próbie, pi ∈ (0, 1), i =

1, 2, . . . , k, p1 + p2 + . . . + pk = 1, zaś Xi niech oznacza liczbę wyników i-tego rodzaju w

n powtórzeniach. Wówczas

n!

P (X1 = n1 , X2 = n2 , . . . , Xk = nk ) =

pn1 1 · pn2 2 · . . . · pnk k ,

n1 ! · n2 ! · . . . · nk !

gdzie ni , i = 1, 2, . . . , k są liczbami naturalnymi oraz n1 + n2 + . . . + nk = n.

• Przykład 3.16.

Jakie jest prawdopodobieństwo, że w sześciocyfrowym kodzie wystąpią trzy zera, dwie

piątki i jedna ósemka?

R o z w i ą z a n i e.

Zmienne losowe Xi , gdzie i = 0, 1, 2, . . . , 9 oznaczają odpowiednio liczbę zer, jedynek, . . .,

dziewiątek w sześciocyfrowym kodzie. pi jest prawdopodobieństwem wylosowania jednej

1

, i = 0, 1, 2, . . . , 9. Zatem

z dziesięciu cyfr, czyli pi = 10

P (X0 = 3, X5 = 2, X8 = 1, X1 = X2 = X3 = X4 = X6 = X7 = X9 = X0 = 0) =

6!

3!2!1!

1

10

3 1

10

2 1

10

• Przykład 3.17.

1

= 0.00006.

Po wstępnej kontroli technicznej 70% wyrobów oceniono jako dobre, 5% - jako wadliwe,

a 25% zdecydowano poddać dalszej kontroli. Jakie jest prawdopodobieństwo, że wśród 10

wylosowanych wyrobów jest 7 dobrych, 2 – wadliwe i 1 należy poddać dalszej kontroli?

R o z w i ą z a n i e.

Niech zmienne losowe X1 , X2 , X3 określają odpowiednio liczbę wyrobów dobrych, wadliwych i przeznaczonych do dalszej kontroli wśród 10 wylosowanych. Prawdopodobieństwa

dla poszczególnej jakości wyrobów wynoszą odpowiednio: p1 = 0.7, p2 = 0.05, p3 = 0.25.

Zatem

P (X1 = 7, X2 = 2, X3 = 1) =

10!

(0.7)7

7!2!1!

· (0.05)2 · (0.25)1 = 0.0185.

W rozkładzie wielomianowym zmienna losowa Xi określa liczbę elementów i-tego rodzaju

wśród n elementów, więc Xi ma rozkład dwumianowy B(n, pi ). Zatem najbardziej prawdopodobna liczba elementów przeznaczonych do dalszej kontroli spośród 10 wylosowanych

to 2.

26

3.3

Zmienne losowe typu ciągłego

• Definicja 3.6. Mówimy, że zmienna losowa X jest typu cia֒glego, jeżeli istnieje nieujemna

66

funkcja całkowalna fX : IR −→ IR taka, że:

FX (x) =

Zx

−∞

fX (t)dt dla każdego x ∈ IR.

Funkcję fX nazywamy ge֒stościa֒ prawdopodobieństwa.

Wiemy z analizy, że funkcja FX jest wówczas ciągła. Ponadto - jest ona różniczkowalna

we wszystkich punktach ciągłości funkcji fX i w punktach tych zachodzi równożć

′

FX (x) = fX (x).

Nietrudno wykazać, że prawdziwa jest następująca charakteryzacja.

• Twierdzenie 3.3. Funkcja f jest gęstością pewnej zmiennej losowej wtedy i tylko wtedy,

gdy :

• f (x) ­ 0 dla każdego x ∈ IR,

•

+∞

R

f (x)dx = 1.

−∞

• Przykład 3.18.

Czy istnieje stała c, dla której podana funkcja jest funkcją gęstości:

0, gdy x ¬ 0,

c, gdy 0 < x ¬ 1

c

, gdy x > 1

x2

f (x) =

Wykorzystamy twierdzenie 3.3. Dla funkcji f (x) mamy c ­ 0 oraz

Z

zatem dla c =

ma postać

1

2

0

−∞

0dx +

Z

1

0

cdx +

Z

∞

1

c

dx = 2c = 1

x2

funkcja f (x) jest gęstością pewnej zmiennej losowej Y . Jej dystrybuanta

F (x) =

1

0, gdy x ¬ 0,

gdy 0 < x ¬ 1,

gdy x > 1.

1

x,

2

1

− 2x

,

Obliczmy, dla zmiennej losowej Y prawdopodobieństwo zdarzeń:

1

1

dx = ,

2

0 2

Z 1

Z 4

1

1

7

P (0 < X < 4) = F (4) − F (0) =

dx +

=

,

8

0 2

1 2x2

Z ∞

1

1

dx = .

P (X > 2) = 1 − F (2) =

2

2x

4

2

P (−2 < X < 1) = F (1) − F (−2) =

27

Z

1

• Przykład 3.19.

Dzienne zużycie energii (100 kWh =1) pewnej firmy jest zmienną losową X o gęstości:

fX (x) =

(

1

(3

9

0

+ 2x − x2 )

dla 0 ¬ x ¬ 3,

dla x < 0 lub x > 3.

Jakie jest prawdopodobieństwo zdarzeń: (X > 12 ), (1 < X < 2)?

R o z w i ą z a n i e.

FX (x) =

0

Rx

+

1 2

x

9

1

P (X > 21 ) = 1 − FX ( 21 ) =

3.4

f (t)dt =

0

1

x

3

41

,

63

−

1 3

x

27

−

dla x ¬ 0,

dla 0 < x ¬ 3,

11

27

dla x > 3

P (1 < X < 2) = FX (2) − FX (1) =

11

.

27

Najważniejsze rozkłady ciągłe

• Rozkład jednostajny na odcinku [a,b]:

Zmienna losowa X ma rozkład jednostajny na odcinku [a, b], jeżeli jej gęstość jest postaci

fX (x) =

(

Wówczas

FX (t) =

1

b−a

dla x ∈ [a, b],

dla x ∈ IR \ [a, b]

0

gdy t ¬ a,

gdy t ∈ (a, b],

gdy t > b.

0

y

t−a

b−a

1

y

1

2

1

2

2

O

x

2

O

x

Rys. 1.03.

Rys. 1.03.

Gęstość rozkładu jednostajnego

Dystrybuanta rozkładu jednostajnego

na przedziale [0,2]

na przedziale [0,2]

• Przykład 3.20.

Z przystanku autobusy odjeżdżają co 10 minut. Zakładamy, że rozkład T czasu przybycia

pasażera na przystanek jest zmienną losową o rozkładzie jednostajnym. Obliczyć prawdopodobieństwo, że pasażer będzie czekał co najmniej 4 minuty, mniej niż 3 minuty.

R o z w i ą z a n i e.

fT (x) =

(

1

10

0

dla x ∈ [0, 10],

dla x ∈ IR \ [0, 10]

FT (t) =

28

0

t

10

1

gdy t ¬ 0,

gdy t ∈ (0, 10],

gdy t > 10.

Zatem

P (T < 3) = FT (3) =

oraz

3

.

10

P (T ­ 4) = 1 − P (T < 4) = 1 − FT (4) =

6

.

10

• Przykład 3.21.

Automat produkuje kulki metalowe o średnicy X będącej zmienną losową o gęstości

fX (x) =

(

5

0

dla x ∈ [0.4, 0.6],

dla x ∈ IR \ [0.4, 0.6]

Za zgodne z normą uznaje się kulki o średnicy z przedziału [0.41, 0.59]. Obliczyć prawdopodobieństwo, że wybrana losowo z produkcji kulka spełnia wymagania normy. Jaka

jest najbardziej prawdopodobna liczba kulek spełniających wymagania normy wśród 1000

kulek.