Projekt pn. „Wzmocnienie potencjału dydaktycznego UMK w Toruniu w dziedzinach matematyczno-przyrodniczych”

realizowany w ramach Poddziałania 4.1.1 Programu Operacyjnego Kapitał Ludzki

Statystyka

i eksploracja danych

Treść wykładów

Adam Jakubowski

UMK Toruń 2011

Projekt współfinansowany przez Unię Europejską w ramach Europejskiego Funduszu Społecznego

Spis treści

Wstęp

1

1 Formalizm teorii prawdopodobieństwa

Po co nam formalizm matematyczny? . . . .

Co to jest ... . . . . . . . . . . . . . . . . . . . .

Przestrzeń probabilistyczna . . . . . . . . .

Przykłady przestrzeni probabilistycznych

Przestrzeń statystyczna . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2 Zmienne losowe i charakterystyki ich rozkładów

Zmienna losowa i jej rozkład . . . . . . . . . . . .

Wartość oczekiwana zmiennej losowej . . . . . .

Dystrybuanta zmiennej losowej . . . . . . . . . .

Rozkłady dyskretne i absolutnie ciągłe . . . . .

Momenty, wariancja, odchylenie standardowe .

Mediana, kwantyle . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3

3

3

4

7

8

.

.

.

.

.

.

9

9

10

11

12

13

14

3 Wektory losowe i charakterystyki ich rozkładów

15

Wektory losowe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

Macierz kowariancji wektora losowego . . . . . . . . . . . . . . . . . 16

Współczynnik korelacji . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

4 Niezależność

Brak korelacji a niezależność zmiennych losowych

Niezależność zmiennych losowych . . . . . . . . . . . .

Kryteria niezależności . . . . . . . . . . . . . . . . . . .

Niezależność zdarzeń . . . . . . . . . . . . . . . . . . . .

Niezależność parami . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

19

19

21

22

23

24

5 Estymatory

Jak wyliczyć współczynnik korelacji?

Próba prosta z populacji . . . . . . . . .

Estymator nieobciążony . . . . . . . . .

Zgodność ciągu estymatorów . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

25

25

26

27

29

i

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

ii

Spis treści

6 Estymatory II

Estymatory największej wiarogodności . . . . .

Estymatory minimalnej wariancji . . . . . . . . .

Rodziny wykładnicze rozkładów . . . . . . . . . .

Estymatory nieobciążone minimalnej wariancji

7 Przedziały ufności

Obszar ufności . . . . . . .

Przedział ufności . . . . . .

Rozkład t-Studenta . . . .

Rozkład chi-kwadrat . . .

Rozkład F -Snedecora . . .

Asymptotyczne przedziały

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

31

31

33

34

36

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

39

39

40

41

42

43

44

8 Prognoza. Warunkowa wartość oczekiwana

Zagadnienie prognozowania . . . . . . . .

Warunkowa wartość oczekiwana . . . . .

Prognoza liniowa . . . . . . . . . . . . . . .

Procesy gaussowskie . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

47

47

48

50

51

. . . . . .

. . . . . .

. . . . . .

. . . . . .

. . . . . .

ufności .

.

.

.

.

.

.

.

.

.

.

.

.

9 Testowanie hipotez statystycznych

53

Test hipotezy, poziom istotności, moc testu . . . . . . . . . . . . . . 53

Lemat Neymana-Pearsona . . . . . . . . . . . . . . . . . . . . . . . . . . 55

Konkluzje . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57

10 Testowanie hipotez - przykłady

Dystrybuanta empiryczna i tw.

Test zgodności Kołmogorowa .

Porównywanie średnich . . . . .

Test χ2 Pearsona . . . . . . . . .

Gniedenki-Cantellego .

. . . . . . . . . . . . . . . .

. . . . . . . . . . . . . . . .

. . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

59

59

60

62

63

11 Metoda najmniejszych kwadratów i regresja liniowa

65

Model liniowy i regresja liniowa . . . . . . . . . . . . . . . . . . . . . 65

Metoda najmniejszych kwadratów . . . . . . . . . . . . . . . . . . . . . 66

Twierdzenie Gaussa-Markowa . . . . . . . . . . . . . . . . . . . . . . . . 67

12 Redukcja wymiaru danych

Procedura standaryzacji danych . . . . . . . . . . . . . . . . . . . . .

Analiza składowych głównych . . . . . . . . . . . . . . . . . . . . . . .

Analiza czynnikowa . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

69

69

71

72

Literatura

75

Wstęp

Plan studiów na kierunku „Informatyka” na Wydziale Matematyki i Informatyki Uniwersytetu Mikołaja Kopernika w Toruniu przewiduje na pierwszym roku studiów drugiego stopnia obowiązkowy blok statystyczno-probabilistyczny, składający się z przedmiotów „Statystyka i eksploracja danych” i „Metody i modele probabilistyczne”. Według

założeń programowych realizacja tego bloku ma stanowić podstawę do szerokiego stosowania metod stochastycznych, w zagadnieniach algorytmicznych, obliczeniowych i w

modelowaniu systemów złożonych.

Przedmiot „Statystyka i analiza danych” prowadzony jest w semestrze zimowym, w

wymiarze 30 godzin wykładu i 30 godzin ćwiczeń rachunkowo-laboratoryjnych, w dużej

mierze wykorzystujących najnowsze wersje pakietu SPSS.

Zaliczenie przedmiotu polega na uzyskaniu zaliczenia ćwiczeń rachunkowo-laboratoryjnych oraz zdaniu dwuczęściowego egzaminu, składającego się z egzaminu praktycznego

w laboratorium (wykonanie analizy przykładowych danych) oraz egzaminu ustnego z

teorii.

Do wykładu prowadzone są kursy wyrównawcze, podczas których osoby mające trudności z podstawowymi pojęciami teorii prawdopodobieństwa lub rachunkami mogą uzupełnić swoje umiejętności. Podstawą zajęć wyrównawczych jest materiał dydaktyczny

Adam Jakubowski „Statystyka i eksploracja danych. Repetytorium z teorii prawdopodobieństwa”, Toruń 2011. Należy podkreślić, że podczas egzaminu wiadomości zawarte w

„Repetytorium” są bezwzględnie wymagane.

Ćwiczenia dydaktyczne prowadzone są w oparciu o materiały dydaktyczne Joanna

Karłowska-Pik „Statystyka i eksploracja danych. Ćwiczenia i zadania”, Toruń 2011.

Niniejsze opracowanie zawiera treści przekazywane w trakcie wykładów. Najważniejsze definicje i twierdzenia przedstawiane są w postaci zrzutu ekranowego odpowiedniej

transparencji. Podstawowy materiał uzupełniany jest komentarzami i przykładami. Zagadnienia omawiane na wykładach, wraz z ewentualnymi uzupełnieniami, są dostępne

na:

https://plas.mat.umk.pl/moodle/

w kategorii Studia stacjonarne/Statystyka i eksploracja danych.

Całość materiału podzielono na 12 jednostek, z grubsza odpowiadających dwugodzinnemu wykładowi. Istotne poszerzenie zakresu materiału wydaje się mało prawdopodobne, ze względu na konieczność „wyrównania poziomu” podczas pierwszych wykładów.

1

2

Wstęp

Doświadczenie wskazuje bowiem, że studenci drugiego stopnia „Informatyki” posiadają

bardzo różne przygotowanie w zakresie metod probabilistycznych, często ograniczające

się do elementarnego rachunku prawdopodobieństwa wykładanego w ramach „Matematyki dyskretnej”. Należy podkreślić, że pewne aspekty analizy danych (np. metody bayesowskie) są przekazywane w ramach przedmiotu „Metody i modele probabilistyczne”,

po systematycznej prezentacji dynamicznych metod Monte Carlo (MCMC).

Literatura podstawowa przedmiotu zawiera książki: W. Niemiro „Rachunek prawdopodobieństwa i statystyka matematyczna”, Szkoła Nauk Ścisłych, Warszawa 1999,

oraz D.T. Larose „Metody i modele eksploracji danych”, Wydawnictwo Naukowe PWN,

Warszawa 2008.

Jako literatura uzupełniająca zalecane są ksiązki: J. Jakubowski i R. Sztencel „Wstęp

do teorii prawdopodobieństwa”, Script, Warszawa 2004, D.T. Larose „Odkrywanie wiedzy z danych. Wprowadzenie do eksploracji danych”, Wydawnictwo Naukowe PWN,

Warszawa 2006, oraz R. Zieliński „Siedem wykładów wprowadzających do statystyki

matematycznej”, PWN Warszawa 1990.

Adam Jakubowski

1. Formalizm teorii prawdopodobieństwa

Po co nam formalizm matematyczny?

• Podstawa porozumienia - aby skutecznie porozumiewać się z innymi przy realizacji

projektów lub w trakcie rozwiązywania problemów.

• Możliwość uzyskania pomocy - aby umieć postawić specjalistom problem do rozwiązania.

• Lepsze zrozumienie materii - np. naturalnych ograniczeń stosowanych narzędzi.

Co to jest ...

• Rachunek prawdopodobieństwa to sztuka (umiejętność) obliczania prawdopodobieństw zdarzeń.

• Teoria prawdopodobieństwa to dział matematyki, na którym opierają się praktyczne obliczenia dokonywane w rachunku prawdopodobieństwa.

• Statystyka to sztuka (umiejętność) wnioskowania na podstawie próby losowej.

• Statystyka matematyczna to dział matematyki, który rozwija metody uzasadniające poprawność wnioskowania statystycznego.

• Eksploracja danych (drążenie danych, ekstrakcja danych) to umiejętność wydobywania użytecznych informacji z dużych zbiorów danych.

Uwaga: Przyjmuje się, że twórcą matematycznego formalizmu teorii prawdopodobieństwa był rosyjski matematyk A.N. Kołmogorow (1903-1987), który w 1933 roku opublikował książkę „Grundbegriffe der Wahrscheinlichkeitsrechnung”.

3

4

1. Formalizm teorii prawdopodobieństwa

Przestrzeń probabilistyczna

Uwaga: Pojęcia występujące w definicji przestrzeni probabilistycznej można interpretować w sposób następujący:

• Ω to zbiór wszystkich możliwych wyników eksperymentu losowego.

• Zdarzenia (elementy F) reprezentują fakty, których zajście możemy stwierdzić,

tzn. dla A ∈ F zawsze możemy powiedzieć, czy wynik ω ∈ A, czy ω 6∈ A. W ten

sposób F reprezentuje całość wiedzy, którą możemy uzyskać w wyniku realizacji

eksperymentu losowego.

• ∅ ∈ F nigdy nie może zajść (jest zdarzeniem „niemożliwym”), więc P (∅) = 0. Ale

idziemy dalej: P (A) = 0 oznacza, że zdarzenie A jest „niemożliwe”, choć może być

A 6= ∅.

• Ω ∈ F zachodzi „zawsze” (jest zdarzeniem „pewnym”), więc P (Ω) = 1. Podobnie:

P (A) = 1 oznacza, że zdarzenie A jest „pewne”, choć A może być właściwym

podzbiorem Ω.

Przestrzeń probabilistyczna

5

6

1. Formalizm teorii prawdopodobieństwa

Przykłady przestrzeni probabilistycznych

7

Przykłady przestrzeni probabilistycznych

• „Klasyczna definicja prawdopodobieństwa”. Niech Ω będzie zbiorem skończonym

i niech F = 2Ω . Określamy

#A

.

P (A) =

#Ω

(„Zasada racji dostatecznej Laplace’a”.)

• „Prawdopodobieństwo dyskretne”. Niech Ω0 = {ω1 , ω2 , . . .} będzie podzbiorem

P

przeliczalnym zbioru Ω. Niech p1 , p2 , . . . ­ 0, j pj = 1. Przyjmując z definicji

P

∅ ≡ 0, określamy

X

pj .

P (A) =

{j : ωj ∈A}

(F = 2Ω !)

• Niech Ω = R1 i p(x) ­ 0 będzie funkcją na R1 taką, że

my:

Z b

P ((a, b]) =

p(x) dx,

a

R +∞

−∞

p(x) dx = 1. Określa-

a < b, a, b ∈ R1 .

Uwaga: Jak wygląda F? To problem badany przez teorię miary i całki Lebesgue’a. Można

1

pokazać, że nie istnieje prawdopodobieństwo Q : 2R → [0, 1] pokrywające się z P na

odcinkach.

8

1. Formalizm teorii prawdopodobieństwa

Z drugiej strony istnieje σ-algebra B 1 (tzw. zbiorów borelowskich) na którą można

rozszerzyć funkcję P , tak aby spełnione były własności prawdopodobieństwa.

Przestrzeń statystyczna

2. Zmienne losowe i charakterystyki ich

rozkładów

Zmienna losowa i jej rozkład

9

10

2. Zmienne losowe

Wartość oczekiwana zmiennej losowej

Uwaga: zmienna losowa X ma skończoną wartość oczekiwaną dokładnie wtedy, gdy

E|X| < +∞. Mówimy również, że zmienna X jest całkowalna i piszemy X ∈ L1 (P ).

2.1 Twierdzenie (Własności wartości oczekiwanej)

1. Jeżeli X ­ 0, to EX ­ 0. Jeżeli X ­ 0 i EX = 0, to P (X = 0) = 1.

2. |EX| ¬ E|X|.

3. Jeżeli E|X| < +∞ i E|Y | < +∞, to dla dowolnych liczb α, β ∈ R1 funkcja

αX + βY jest zmienna losową i ma miejsce równość:

E (αX + βY ) = αEX + βEY.

4. Jeżeli Y ­ X, to EY ­ EX pod warunkiem, że wartości oczekiwane istnieją.

Dystrybuanta zmiennej losowej

11

Dystrybuanta zmiennej losowej

2.2 Twierdzenie (Własności dystrybuanty zmiennej losowej)

1. Jeżeli u ¬ v, to FX (u) ¬ FX (v) (monotoniczność).

2. FX jest funkcją prawostronnie ciągłą.

3.

lim FX (u) = 0,

u→−∞

lim FX (u) = 1.

u→+∞

2.3 Twierdzenie Twierdzenie (O dystrybuantach) Jeżeli funkcja F : R1 → [0, 1] spełnia warunki 1-3 z powyższego twierdzenia, to istnieje zmienna losowa X taka, że F = FX .

12

2. Zmienne losowe

Rozkłady dyskretne i absolutnie ciągłe

2.4 Fakt (Skoki dystrybuanty) PX {x} = P (X = x) > 0 wtedy i tylko wtedy, gdy

dystrybuanta FX ma skok w punkcie x i FX (x) − FX (x−) = P (X = x).

2.5 Twierdzenie (Gęstość a pochodna dystrybuanty) Każda dystrybuanta F jest

`-prawie wszędzie różniczkowalna i pochodna F 0 (określona `-prawie wszędzie) spełnia

warunek

Z

F 0 (x) dx.

F (x) ­

(−∞,x]

Uwaga: Może się zdarzyć, że

R

R1

F 0 (x) dx < 1.

2.6 Twierdzenie Jeżeli R1 F 0 (x) dx = 1, to rozkład odpowiadający dystrybuancie F

jest absolutnie ciągły z gęstością p(x) = F 0 (x).

R

2.7 Twierdzenie (Obliczanie EX dla rozkładu dyskretnego) Jeżeli X ma rozkład

dyskretny, to dla dowolnej funkcji f : R1 → R1

Ef (X) =

∞

X

i=1

f (xi )P (X = xi ) =

∞

X

i=1

f (xi )pi ,

Momenty, wariancja, odchylenie standardowe

13

przy czym Ef (X) istnieje dokładnie wtedy, gdy

∞

X

|f (xi )|pi < +∞.

i=1

2.8 Twierdzenie (Obliczanie EX dla rozkładu absolutnie ciągłego) Jeżeli X

ma rozkład absolutnie ciągły o gęstości p(x), to dla dowolnej funkcji (borelowskiej) f :

R1 → R1

Z +∞

f (x)p(x) dx,

Ef (X) =

−∞

przy czym Ef (X) istnieje dokładnie wtedy, gdy

R +∞

−∞

|f (x)|p(x) dx < +∞.

Momenty, wariancja, odchylenie standardowe

14

Mediana, kwantyle

2. Zmienne losowe

3. Wektory losowe i charakterystyki ich

rozkładów

Wektory losowe

~

Podobnie jak w przypadku zmiennych losowych, dystrybuantą wektora losowego X

d

nazywamy funkcję FX~ : IR → [0, 1], zadaną wzorem

FX~ (a1 , a2 , . . . , ad ) := PX~ ({X1 ¬ a1 , X2 ¬ a2 , . . . , Xd ¬ ad }) .

Uwaga: dystrybuanta wektora losowego określa rozkład wektora losowego. W jaki sposób?

Uwaga: nie każda funkcja na IRd , która jest niemalejąca po współrzędnych, zadaje dystrybuantę! (Przykład!)

15

16

3. Wektory losowe

Macierz kowariancji wektora losowego

80

80

Współczynnik korelacji

17

~ <

3.1 Twierdzenie (Równoważna definicja wartości oczekiwanej) Niech EkXk

d

~

+∞. Wartość oczekiwana wektora X to jedyny wektor m ∈ IR taki, że

~ = hx, mi,

Ehx, Xi

x ∈ IRd .

~ 2<

3.2 Twierdzenie (Równoważna definicja macierzy kowariancji) Niech EkXk

~

+∞. Macierz kowariancji wektora X jest jedyną symetryczną macierzą Σ wymiaru d × d

wyznaczoną przez formę kwadratową

~ − E Xi

~ 2 = Var (hx, Xi)

~ = hx, Σ xi,

Ehx, X

x ∈ IRd .

~ jest więc jedyną macierzą Σ spełniającą związek

Cov (X)

~ − E Xihy,

~

~ − E Xi

~ = cov (hx, Xi,

~ hy, Xi)

~ = hx, Σ yi, x, y ∈ IRd .

Ehx, X

X

3.3 Twierdzenie (Charakteryzacja macierzy kowariancji) Macierz kowariancji

~ jest symetryczna i nieujemnie określona. Na odwrót, dla dowolnej

wektora losowego X

symetrycznej i nieujemnie określonej macierzy Σ rozmiaru d × d istnieje d-wymiarowy

~ taki, że

wektor losowy X

~ = Σ.

Cov (X)

Współczynnik korelacji

3.4 Twierdzenie (Interpretacja wspólczynnika korelacji) |r(X, Y )| = 1 wtedy, i

tylko wtedy, gdy istnieją stałe α, β takie, że X = αY + β lub Y = αX + β.

18

3. Wektory losowe

4. Niezależność

Brak korelacji a niezależność zmiennych losowych

Niech zmienne losowe X i Y będą jak na stronie 18. Rozważmy zmienne X 2 i Y 2 .

19

20

4. Niezależność

Niezależność zmiennych losowych

21

Niezależność zmiennych losowych

Uwaga: Jeżeli rodzina {Xi }i∈II jest niezależna, to niezależna jest również każda rodzina

postaci {gi (Xi )}i∈II .

4.1 Twierdzenie (Niezależność pociąga nieskorelowanie) Jeżeli zmienne losowe

X i Y są niezależne i całkowalne, to iloczyn XY jest całkowalną zmienną losową i

EXY = EX · EY. W szczególności niezależne zmienne losowe są nieskorelowane.

Uwaga: Bez założenia o niezależności warunek dostateczny dla całkowalności iloczynu

XY odwołuje się do nierówności Höldera.

E|XY | ¬ (E|X|p )1/p (E|Y |q )1/q ,

1 1

+ = 1.

p q

4.2 Wniosek (Mnożenie wartości oczekiwanych) Niech X1 , X2 , . . . , Xd będą niezależne. Jeżeli funkcje fi sa takie, że f1 (X1 ), f2 (X2 ), . . . , fd (Xd ) są całkowalnymi zmiennymi losowymi, tj. E|fi (Xi )| < +∞, i = 1, 2, . . . , d, to

Ef1 (X1 )f2 (X2 ) · · · fd (Xd ) = Ef1 (X1 ) · Ef2 (X2 ) · · · · Efd (Xd ).

22

4. Niezależność

Kryteria niezależności

4.3 Twierdzenie Zmienne losowe X1 , X2 , . . . , Xd są niezależne wtedy, i tylko wtedy,

gdy dla dowolnych liczb a1 , a2 , . . . , ad ma miejsce równość

P (X1 ¬ a1 , X2 ¬ a2 , . . . , Xd ¬ ad )

= P (X1 ¬ a1 )P (X2 ¬ a2 ) · . . . · P (Xd ¬ ad ).

Innymi słowy

F(X1 ,X2 ,...,Xd ) (a1 , a2 , . . . , ad ) = FX1 (a1 ) · FX2 (a2 ) · . . . · FXd (ad ),

tzn. dystrybuanta rozkładu łącznego jest iloczynem dystrybuant brzegowych.

4.4 Przykład (Klasyczne prawdopodobieństwo na produkcie) Niech wyniki itego eksperymentu będą elementami skończonej przestrzeni Ωi . Połóżmy Ω = Ω1 × Ω2 ×

. . . × Ωd . Niech P będzie klasycznym prawdopodobieństwem na Ω.

Wtedy dla dowolnych funkcji fi : Ωi → IR1 , zmienne losowe

Xi (ω1 , ω2 , . . . , ωd ) = fi (ωi )

są stochastycznie niezależne.

Uwaga: W tym szczególnym przypadku niezależność stochastyczna pokrywa się z niezależnością funkcyjną (zmienne Xi w istocie są funkcjami różnych argumentów). Przewaga

niezależności stochastycznej polega na uwolnieniu tej własności od konkretnej przestrzeni

funkcyjnej.

Niezależność zdarzeń

23

4.5 Twierdzenie (Niezależność dyskretnych zmiennych losowych) Niech rozkłady zmiennych X1 , X2 , . . . , Xd będą dyskretne.

Zmienne losowe X1 , X2 , . . . , Xd są niezależne dokładnie wtedy, gdy dla dowolnych

x1 , x2 , . . . , xd ∈ IR1 ma miejsce związek

P (X1 = x1 , X2 = x2 , . . . , Xd = xd )

= P (X1 = x1 )P (X2 = x2 ) · · · P (Xd = xd ).

4.6 Twierdzenie (Niezależność absolutnie ciągłych zmiennych losowych)

Niech rozkłady zmiennych X1 , X2 , . . . , Xd będą absolutnie ciągłe z gęstościami p1 (x), p2 (x), . . . , pd (x).

Zmienne losowe X1 , X2 , . . . , Xd są niezależne dokładnie wtedy, gdy rozkład łączny

tych zmiennych jest absolutnie ciągły (tzn. posiada gęstość względem miary Lebesgue’a

na IRd ) i jego gęstość ma postać

pX~ (x1 , x2 , . . . , xd ) = p1 (x1 )p2 (x2 ) · · · pd (xd ).

Niezależność zdarzeń

24

Niezależność parami

4. Niezależność

5. Estymatory

Jak wyliczyć współczynnik korelacji?

• W przykładach podanych na poprzednim wykładzie dane maja postać chmury

punktów (wektorów dwuwymiarowych).

• Na podstawie danych, za pomocą odpowiedniego wzoru, wyliczamy liczbę, która

stanowi pewną charakterystykę zbioru danych.

• Nasuwają się następujące naturalne pytania:

– Skąd wiemy, że to, co policzyliśmy, odpowiada naszym oczekiwaniom?

– Jaka jest jakość uzyskanego wyniku?

– A raczej: Jak mierzyć jakość naszego wyniku?

– Jak znajdować „odpowiednie wzory”?

5.1 Przykład (n-krotny pomiar jednym przyrządem) Xk = m + εk , gdzie m

- „rzeczywista wartość pomiaru”, a εk - błąd k-tego pomiaru. Co przyjąć za wynik

pomiaru?

X1 + X2 + . . . + Xn

X̄n =

.

n

Dlaczego?

• Prawo wielkich liczb stwierdza, że

ε1 + ε2 + . . . + εn

→ Eε1 ,

n

gdzie Eε1 = 0 dla przyrządu poprawnie skalibrowanego („brak błędu systematycznego”).

• Powyżej korzystamy z modelu „błędu pomiaru” w postaci ciągu niezależnych

zmiennych losowych o jednakowym rozkładzie, z wartością oczekiwaną zero.

• Inne spojrzenie:

E X̄n = m,

jeśli brak jest błędu systematycznego (obciążenia).

25

26

5. Estymatory

Próba prosta z populacji

5.2 Przykład (Losowanie ze zwracaniem) Jesteśmy zainteresowani rozkładem danej cechy U w populacji Ω. Losujemy (ze zwracaniem) N „osobników” i badamy wartości

cechy. Jak określić odpowiednią przestrzeń statystyczną (X , B, {Pθ }θ∈Θ )?

Niech X0 = {U (ω) : ω ∈ Ω} ⊂ IRd . Kładziemy:

• X = (X0 )N ;

• B =? (jak wynika z kontekstu);

• Θ = P(X0 ) (zbiór wszystkich rozkładów prawdopodobieństwa na X0 );

•

Pθ = |θ × θ ×{z. . . × θ} .

N razy

Estymator nieobciążony

Estymator nieobciążony

27

28

5. Estymatory

5.3 Przykład (Estymator wartości oczekiwanej) Θ = {θ ∈ P(IR1 ) : E|Y | <

+∞, jeśli Y ∼ θ},

g(θ) = EY , jeśli Y ∼ θ.

ĝ(X1 , X2 , . . . , XN ) = X̄N =

X1 + X2 + . . . + XN

.

N

5.4 Przykład (Nieobciążony estymator wariancji) Θ = {θ ∈ P(IR1 ) : EY 2 <

+∞, jeśli Y ∼ θ},

g(θ) = Var (Y ) = EY 2 − (EY )2 , jeśli Y ∼ θ.

2

ĝ(X1 , X2 , . . . , XN ) = S̄N

=

2

(X1 − X̄N ) + (X2 − X̄N )2 + . . . + (XN − X̄N )2

=

.

N −1

5.5 Przykład (Nieobciążony estymator wariancji przy znanej wartości oczekiwanej) Θ = {θ ∈ P(IR1 ) : EY 2 < +∞, EY = µ, jeśli Y ∼ θ},

g(θ) = Var (Y ) = EY 2 − µ2 , jeśli Y ∼ θ.

ĝ(X1 , X2 , . . . , XN ) =

(X1 − µ)2 + (X2 − µ)2 + . . . + (XN − µ)2

.

N

5.6 Przykład (Estymator prawdopodobieństwa sukcesu w schemacie Bernoullego) Θ = {rozkład dwupunktowy, P (Y = 1) = θ = 1 − P (Y = 0)},

Zgodność ciągu estymatorów

29

g(θ) = θ.

ĝ(X1 , X2 , . . . , XN ) =

X1 + X2 + . . . + XN

.

N

5.7 Przykład (Dwa estymatory dla P (X = 0) z rozkładu Poissona)

Θ = {rozkład Poissona z parametrem θ ∈ IR+ },

g(θ) = e−θ (= Pθ (Y = 0)).

ĝ1 (X1 , X2 , . . . , XN ) =

1I {{X1 =0}} + 1I {{X2 =0}} + . . . + 1I {{XN =0}}

.

N

ĝ2 (X1 , X2 , . . . , XN ) = 1 −

1

N

X1 +X2 +...+XN

.

Zgodność ciągu estymatorów

Uwaga: Jeśli ciąg {ĝn } jest mocno zgodny, to jest słabo zgodny. Jeśli ciąg {ĝn } jest

zgodny w sensie L2 , to jest słabo zgodny.

5.8 Przykład Jeśli istnieją drugie momenty, to ciąg estymatorów {X̄n } jest zgodny w

sensie L2 .

30

5. Estymatory

5.9 Wniosek

• Ciąg estymatorów {X̄n } jest mocno zgodny.

• Zgodność obu ciągów estymatorów wariancji.

• Zgodność ciągu estymatorów prawdopodobieństwa sukcesu w schemacie Bernoullego.

• Zgodność obu ciągów estymatorów dla P (Y = 0) z rozkładu Poissona.

6. Estymatory II

Estymatory największej wiarogodności

Uwaga: Na poprzednim wykładzie pojawiło się wiele wzorów, które miały rozmaite dobre

własności. Czy istnieje metoda znajdowania takich wzorów?

Uwaga: gdy wszystkie rozkłady Pθ są dyskretne i skoncentrowane na tym samym zbiorze przeliczalnym X0 , jako miarę referencyjną możemy wybrać miarę liczącą: Λ(A) =

#A, A ⊂ X0 . Wtedy „gęstość w punkcie” x ∈ X0 jest dana wzorem

pθ (x) = Pθ ({x}).

31

32

6. Estymatory II

Uwagi:

• ENW nie musi być nieobciążony.

• ENW może nie istnieć.

• ENW może nie być określony jednoznacznie lub jego wyznaczenie może być bardzo

trudne.

6.1 Przykłady

• ENW dla prawdopodobieństwa sukcesu w schemacie N prób Bernoullego.

p̂(X1 , X2 , . . . , XN ) =

X1 + X2 + . . . + XN

.

N

• ENW dla wartości oczekiwanej i wariancji dla próby prostej gaussowskiej długości

N.

X1 + X2 + . . . + XN

µ̂ =

= X̄N .

N

(X1 − X̄N )2 + (X2 − X̄N )2 + . . . + (XN − X̄N )2

N −1 2

σˆ2 =

=

S̄N .

N

N

Estymatory minimalnej wariancji

33

Estymatory minimalnej wariancji

6.2 Przykład (Porównywanie estymatorów) Przypomnijmy dwa estymatory dla

P (X = 0) z rozkładu Poissona Θ = {rozkład Poissona z parametrem θ ∈ IR+ }, g(θ) =

e−θ (= Pθ (X = 0)).

ĝ1 (X1 , X2 , . . . , XN ) =

1I {{X1 =0}} + 1I {{X2 =0}} + . . . + 1I {{XN =0}}

.

N

ĝ2 (X1 , X2 , . . . , XN ) = 1 −

1

N

X1 +X2 +...+XN

.

Który jest lepszy i w jakim sensie?

Var θ (ĝ2 ) < Var θ (ĝ1 ) !

Uwaga: Istnieje piękna teoria, równie pięknie przedstawiona w książce R. Zieliński, Siedem wykładów wprowadzających do statystyki matematycznej, PWN Warszawa 1990,

która pojęcie „estymator nieobciążony minimalnej wariancji” analizuje z punktu widzenia tzw. statystyk dostatecznych (tzn. zawierających pełną informację o modelu statystycznym). Na wykładzie podamy tylko najważniejsze zastosowanie tej teorii.

34

6. Estymatory II

Rodziny wykładnicze rozkładów

6.3 Przykład Rozkład dwupunktowy (Bernoullego) Pθ {1} = θ = 1 − Pθ {0} ma gęstość

na {0, 1}

θ

pθ (x) = exp x ln

+ ln(1 − θ) .

1−θ

W reprezentacji

pθ (x) = exp

k

X

cj (θ)Tj (x) − b(θ) · h(x),

j=1

mamy:

• T1 (x) = x,

• c1 (θ) = ln θ/(1 − θ) ,

• b(θ) = − ln(1 − θ),

• h(x) ≡ 1.

6.4 Przykład Rozkład normalny N (µ, σ 2 ) ma gęstość na IR1

√

1

µ

µ2

pµ,σ (x) = exp − 2 · x2 + 2 · x − [ 2 + ln(σ 2π)] .

2σ

σ

2σ

!

W reprezentacji pθ (x) = exp

P

k

j=1 cj (θ)Tj (x)

− b(θ) · h(x), mamy θ = (µ, σ 2 ) oraz:

Rodziny wykładnicze rozkładów

35

• T1 (x) = x2 ,

• c1 (θ) = −1/(2σ 2 ),

• T2 (x) = x,

• c2 (θ) = µ/σ 2 ,

√

• b(θ) = µ2 /(2σ 2 ) + ln(σ 2π),

• h(x) ≡ 1.

6.5 Przykład Rozkład gamma Γ(α, λ), α > −1, γ > 0 ma gęstość na IR1

1

pα,λ (x) = exp − · x + (α − 1) · ln x − ln[λα Γ(α)] · 1I {[0,∞)} (x).

λ

W reprezentacji pθ (x) = exp

P

k

j=1 cj (θ)Tj (x)

− b(θ) · h(x), mamy θ = (α, γ) oraz:

• T1 (x) = x,

• c1 (θ) = −1/λ,

• T2 (x) = ln x,

• c2 (θ) = α − 1,

• b(θ) = ln λα Γ(α) ,

• h(x) = 1I {[0,∞)} (x)..

6.6 Przykład Rozkład Poissona z parametrem λ ma gęstość na IN

pλ (x) = exp (ln λ · x − λ) ·

W reprezentacji pθ (x) = exp

P

k

j=1 cj (θ)Tj (x)

1

.

x!

− b(θ) · h(x), mamy (θ = λ):

• T1 (x) = x,

• c1 (λ) = ln λ,

• b(λ) = λ,

• h(x) = 1/x!.

6.7 Przykład Próba prosta długości N z rozkładu Bernoullego z prawdopodobieństwem

sukcesu θ ∈ (0, 1) ma gęstość na przestrzeni {0, 1}N

pN

θ (x1 , x2 , . . . , xN ) = pθ (x1 ) · pθ (x2 ) · . . . · pθ (xN )

θ

= exp (x1 + x2 + . . . xN ) ln

+ N · ln(1 − θ) .

1−θ

W reprezentacji pN

θ (x) = exp

P

k

j=1 cj (θ)Tj (x) − b(θ) · h(x) mamy więc:

36

6. Estymatory II

• T1 (x1 , x2 , . . . , xN ) = x1 + x2 + . . . + xN ,

• c1 (θ) = ln θ/(1 − θ) ,

• b(θ) = −N · ln(1 − θ),

• h(x) ≡ 1.

Podobnie transformują się gęstości dla prób prostych z innych rodzin wykładniczych.

Estymatory nieobciążone minimalnej wariancji

6.8 Przykłady

• Populacja normalna, µ znane.

EN M W (σ 2 ) =

(X1 − µ)2 + (X2 − µ)2 + . . . + (XN − µ)2

.

N

• Populacja normalna, µ znane.

EN M W (σ) = √

Γ( n2 )

2Γ( n+1

2 )

q

(X1 − µ)2 + (X2 − µ)2 + . . . + (XN − µ)2 .

Estymatory nieobciążone minimalnej wariancji

37

• Populacja normalna, σ znane.

EN M W (µ) = X̄N .

• Populacja normalna, µ i σ nie są znane.

EN M W (µ) = X̄N .

• Populacja normalna, µ i σ nie są znane.

EN M W (σ 2 ) =

(X1 − X̄N )2 + (X2 − X̄N )2 + . . . + (XN − X̄N )2

.

(N − 1)

• Populacja normalna, µ i σ nie są znane. Estymator kwantyla rzędu p ∈ (0, 1), tzn.

liczby up spełniającej relację p = Φµ,σ (up ) lub up = µ + σ · Φ−1 (p).

Γ( N −1 )

EN M W (up ) = X̄N + √ 2 N · σ̄N · Φ−1 (p),

2Γ( 2 )

gdzie

σ̄N =

q

(X1 − X̄N )2 + (X2 − X̄N )2 + . . . + (XN − X̄N )2 .

Uwaga:

• Estymatory nieobciążone nie zawsze istnieją.

• ENMW może nie istnieć, mimo że istnieją estymatory nieobciążone.

• ENMW może mieć większy błąd średniokwadratowy (funkcję ryzyka)

R(δ̂, θ) = Eθ (δ̂ − g(θ))2

od estymatora obciążonego.

• ENMW może być zupełnie nieprzydatny.

38

6. Estymatory II

7. Przedziały ufności

Obszar ufności

Problem: jak

ocenić jakość

przybliżenia parametru przez estymator?

Niech X , B, {Pθ }θ∈Θ będzie modelem statystycznym i niech ĝ : X → IRd będzie

estymatorem parametru g : Θ → IRd .

• W modelach ciągłych (tzn. Pθ ({x}) = 0 dla każdego x ∈ X i θ ∈ Θ) najczęściej

mamy

Pθ ĝ = y0 = 0.

• Tymczasem na podstawie estymacji „przyjmujemy” g(θ) = y0 . Na ile można ufać

takiej ocenie wartości parametru?

• Wyjściem może być stosowanie estymatorów jako odwzorowań przestrzeni próbek

o wartościach w „masywnych” zbiorach.

39

40

7. Przedziały ufności

Przedział ufności

7.1 Przykład (Przedział ufności dla średniej ze znaną wariancją) Niech X1 , X2 ,

. . . , XN będzie próbą prostą z rozkładu N (µ, σ 2 ). Zakładamy, że σ 2 jest znane (np.

dokonujemy pomiaru skalibrowanym

przyrządem o znanej dokładności). Jeśli położymy

X1 +X2 +...+XN

σ2

X̄N =

∼ N µ, N , to

N

X̄N − µ

√

∼ N (0, 1).

σ/ N

Niech ζ = ζ1−α/2 będzie takie, że Φ(−ζ) = 1 − Φ(ζ) = α/2. Wtedy

Pµ X̄N −

σ · ζ1−α/2 σ · ζ1−α/2

√

¬ µ ¬ X̄N + √

= 1 − α.

N

N

Piszemy:

µ = X̄N ±

σ · ζ1−α/2

√

.

N

Rozkład t-Studenta

41

Rozkład t-Studenta

7.2 Przykład (Przedział ufności dla średniej z nieznaną wariancją) Niech X1 , X2 ,

. . . , XN będzie próbą prostą z rozkładu N (µ, σ 2 ). Nie znamy ani µ, ani σ 2 . Niech

s

S̄N =

(X1 − X̄N )2 + (X2 − X̄N )2 + . . . + (XN − X̄N )2

.

N −1

7.3 Twierdzenie Zmienna losowa

tN −1 =

X̄N − µ

√

S̄N / N

ma rozkład t-Studenta z N − 1 stopniami swobody.

7.4 Wniosek Jeżeli FtN −1 (τ1−α/2 ) = 1 − α/2, to na poziomie ufności α

µ = X̄N ±

S̄N · τ1−α/2

√

.

N

42

7. Przedziały ufności

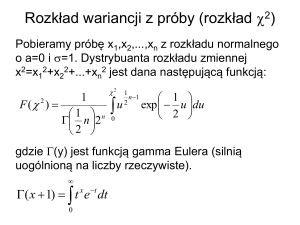

Rozkład chi-kwadrat

7.5 Przykład (Przedział ufności dla wariancji) Podobnie jak poprzednio X1 , X2 ,

. . . , XN jest próbą prostą z rozkładu N (µ, σ 2 ), gdzie µ i σ 2 nie są znane.

7.6 Twierdzenie Zmienna losowa

χ2N −1 =

2

(N − 1)S̄N

σ2

ma rozkład chi-kwadrat z N − 1 stopniami swobody.

7.7 Wniosek Jeśli Fχ2

N −1

ności dla

σ2

(ξα/2 ) = α/2 i Fχ2

N −1

(ξ1−α/2 ) = 1 − α/2, to przedziałem uf-

na poziomie ufności α jest

"

#

2 (N − 1)S̄ 2

(N − 1)S̄N

N

,

.

ξ1−α/2

ξα/2

Rozkład F -Snedecora

43

Rozkład F -Snedecora

7.8 Przykład (Przedział ufności dla ilorazu wariancji) Niech X1 , X2 , . . . , XN bę2 ), a Y , Y , . . . , Y

dzie próbą prostą z rozkładu N (µX , σX

1 2

M próbą prostą z rozkładu

2

2

2

2 będzie statystyką

N (µY , σY ), gdzie nie znamy ani µX i σX , ani µY i σY . Niech S̄X

2

2

2

S̄N zbudowaną na próbce {Xk }, a S̄Y będzie statystyką S̄M zbudowaną na próbce {Yk }.

7.9 Twierdzenie Zmienna losowa

FN −1,M −1 =

2 · σ2

S̄X

Y

2 ,

S̄Y2 · σX

ma rozkład F -Snedecora z N − 1 stopniami swobody licznika i M − 1 stopniami swobody

mianownika.

7.10 Wniosek Niech

FFN −1,M −1 (φα/2 ) = α/2, FFN −1,M −1 (φ1−α/2 ) = 1 − α/2.

2 na poziomie ufności α jest

Przedziałem ufności dla σY2 /σX

"

#

S̄ 2

S̄ 2

φα/2 Y2 , φ1−α/2 Y2 .

S̄X

S̄X

44

7. Przedziały ufności

Asymptotyczne przedziały ufności

7.11 Przykład (Przedziały ufności dla prawdopodobieństwa sukcesu w schemacie Bernoullego) Niech X1 , X2 , . . . będzie schematem Bernoullego z prawdopodobieństwem sukcesu θ ∈ (0, 1), a SN liczbą sukcesów w N próbach. Rozkład SN jest

znany (dwumianowy). Teoretycznie znamy więc również rozkład zmiennej standaryzowanej √ SN /N −θ√ . W praktyce lepiej jednak używać przybliżenia danego przez sławne

θ(1−θ)/ N

twierdzenie de Moivre’a-Laplace’a.

7.12 Wniosek Jeśli Φ(ζ1−α/2 ) = 1 − α/2, mamy „asymptotycznie”:

2

Pθ ζ1−α/2

θ(1 − θ) ­ N SN /N − θ

2 ≈ 1 − α.

W szczególności na „przybliżonym” poziomie ufności α

r

θ=

2

SN + ζ1−α/2

/N

2

N + ζ1−α/2

±

ζ1−α/2

2

ζ1−α/2

SN (N −SN )

+

N

4

2

N + ζ1−α/2

.

7.13 Przykład (Nieparametryczne przedziały ufności dla kwantyli) Niech X1 , X2 , . . .

będzie próbą prostą z rozkładu o dystrybuancie F = FX1 . Niech ξp będzie kwantylem

rzędu p rozkładu F (zakładamy, że F jest ciągła i ściśle rosnąca w otoczeniu ξp , więc ξp

Asymptotyczne przedziały ufności

45

jest określony jednoznacznie). Połóżmy

LN =

N

X

1I {{Xj ¬ξp }} .

j=1

Zmienna LN ma rozkład dwumianowy! Z twierdzenia de Moivre’a-Laplace’a wynika, że

!

LN /N − p

¬ ζ1−α/2

−ζ1−α/2 ¬ p

p(1 − p)N

= Φ(ζ1−α/2 ) − Φ(−ζ1−α/2 ) = 1 − α.

lim P

N →∞

Niech k N i k N będą takie, że

k /N − p

k N /N − p

= −ζ1−α/2 , lim p

= ζ1−α/2 .

lim p N

p(1 − p)/N

p(1 − p)/N

N →∞

N →∞

Wtedy

lim PF k N ¬ LN ¬ k N = 1 − α,

N →∞

lub równoważnie

lim PF XkN :N ¬ ξp ¬ XkN :N = 1 − α,

N →∞

gdzie Xk:N jest k-tą statystyką porządkową z próby prostej N -elementowej.

Uwaga: Szczególny charakter rozkładu normalnego najbardziej widoczny jest w centralnym twierdzeniu granicznym.

46

7. Przedziały ufności

8. Prognoza. Warunkowa wartość oczekiwana

Zagadnienie prognozowania

• Przypuśćmy, że mamy dany ciąg liczb x1 , x2 , . . . , xn , stanowiących wyniki pomiaru

pewnej zmiennej w czasie wielkości x, w chwilach t1 < t2 < . . . < tn . Inaczej

mówiąc, mamy dany „szereg czasowy”.

• Zagadnienie prognozowania: Niech T > tn . Jaką wartość przyjmie badana wielkość

w chwili T ?

• Jeżeli x jest funkcją tylko czasu t, tzn. xk = f (tk ), k = 1, 2, . . . , tn , możemy próbować odgadnąć postać funkcji f , np.

– znajdując współczynniki wielomianu interpolacyjnego,

– lub amplitudę, częstość i przesunięcie sygnału sinusoidalnego,

– lub parametry przekształcenia S, którego kolejne iteracje S(t0 ), S 2 (t0 ), . . . Sn (t0 )

dają nam kolejne wartości x1 , x2 , . . . , xn .

• To jest jednak rzadka sytuacja. Na ogół musimy zakładać, że liczby x1 , x2 , . . . , xn

są wartościami ciągu zmiennych losowych.

47

48

8. Prognoza. Warunkowa wartość oczekiwana

Warunkowa wartość oczekiwana

~ iZ

~ będą wektorami losowymi o wartościach w IRm i IRn , określonymi na

Niech Y

~ = ~z) > 0, to rozkładem

tej samej przestrzeni probabilistycznej (Ω, F, P ). Jeżeli P (Z

~ gdy Z

~ = ~z nazywamy prawdopodobieństwo

warunkowym wektora Y

~

~

~

~ z ) = P (Y ∈ A, Z = ~z) .

⊃ A 7→ PY~ |Z=~

~ z (A) = P (Y ∈ A|Z = ~

~ = ~z)

P (Z

!

IR

m

Pytanie: jak określić rozkład warunkowy w ogólnym przypadku? Jeżeli P(Y,Z) jest absolutnie ciągły z gęstością pY,Z (y, z), to można określić gęstość rozkładu PY |Z=z za pomocą

wzoru

pY |Z=z (y) =

R +∞pY,Z (y,z)

−∞

pY,Z (u,z) du

1I {[0,1]} (y),

, jeśli

R

pY,Z (u, z) du > 0

jeśli

R

pY,Z (u, z) du = 0

.

Warunkowa wartość oczekiwana

49

Uwaga: w terminach przestrzeni Hilberta L2 (Ω, F, P ) warunkowa wartość oczekiwana

~

~

jest rzutem ortogonalnym na podprzestrzeń funkcji postaci {h(Z)},

czyli funkcji σ(Z)mierzalnych. W tym kontekście (niemal) oczywiste są następujące fakty:

50

8. Prognoza. Warunkowa wartość oczekiwana

• Jeżeli E|Y | < +∞ i g : IRn → IRm , to

~ = E(Y |g(Z)).

~

~ g(Z)

E E(Y |Z)

~ jest funkcją stałą, to E(Y |Z)

~ = EY .

• Jeżeli Z

~

• Co by było, gdybyśmy minimalizowali E|Y − h(Z)|?

Prognoza liniowa

Procesy gaussowskie

51

Procesy gaussowskie

Wnioski z definicji: Biorąc α

~ = (0, . . . , 0, 1, 0, . . . , 0)T , otrzymujemy rozkład normalny

dla składowych Xk ∼ N (mk , σk2 ). W ogólności,

~ = h~

~

mα~ = E(α1 X1 + α2 X2 + · · · + αn Xn ) = Eh~

α, Xi

α, E Xi.

Podobnie

~ = h~

~ α

σα~2 = Var (h~

α, Xi)

α, Cov (X)

~ i.

8.1 Twierdzenie (Transformacja liniowa zmiennych gaussowskich) Jeżeli wek~ = (X1 , X2 , . . . , Xn )T ma składowe gaussowskie, przy czym E X

~ = m

tor losowy X

~ i

n

m

Cov (X) = Σ) i jezeli A : IR → IR jest odwzorowaniem liniowym, to składowe wektora

~ też są gaussowskie, przy czym

A(X)

~ = A(m),

~ = AΣAT .

EA(X)

~ Cov (A(X))

8.2 Twierdzenie (Konstrukcja zmiennych gaussowskich) Jeżeli m

~ ∈ IRn i Σ jest

~ o

macierzą n × n, symetryczną i nieujemnie określoną, to istnieje wektor losowy X

składowych gaussowskich, który spełnia związki

~ = m,

EX

~

~ = Σ.

Cov (X)

8.3 Twierdzenie (Charakterystyka rozkładu łącznego zmiennych gaussowskich)

Rozkład łączny zmiennych losowych gaussowskich (X1 , X2 , . . . , Xn ) (nazywany n-wymiarowym

rozkładem normalnym) jest w pełni określony przez swoja wartość oczekiwaną m

~ i ma~ ∼ N (m, Σ).

cierz kowariancji Σ. Piszemy X

52

8. Prognoza. Warunkowa wartość oczekiwana

8.4 Twierdzenie (Absolutna ciągłość rozkładu normalnego) Rozkład normalny

jest absolutnie ciągły dokładnie wtedy, gdy macierz Σ jest nieosobliwa (det(Σ) 6= 0). W

takim przypadku gęstość zadana jest wzorem:

1

1

1

~ .

pm,Σ

x) = √ d √

exp − h~x − m,

~ Σ−1 (~x − m)i

~ (~

2

( 2π) det Σ

8.5 Twierdzenie (Niezależność zmiennych gaussowskich) Zmienne gaussowskie

X1 , X2 , . . . , Xn są niezależne dokładnie wtedy, gdy są nieskorelowane:

cov (Xi , Xj ) = 0, i, j = 1, 2, . . . , n, i 6= j.

9. Testowanie hipotez statystycznych

Test hipotezy, poziom istotności, moc testu

53

54

9. Testowanie hipotez statystycznych

Lemat Neymana-Pearsona

Lemat Neymana-Pearsona

55

56

9. Testowanie hipotez statystycznych

9.1 Przykład (za R. Zielińskim „Siedem wykładów ...”) Niech X = IN . Rozważmy hipotezę prostą H0 = {B(10; 0, 1)} (rozkład dwumianowy: liczba sukcesów 10, p-stwo

sukcesu 0, 01) przeciw hipotezie prostej H1 = {P o(1)} (rozkład Poissona z parametrem

1).

x

B(10; 0, 1)

P o(1)

P o(1)

B(10;0,1)

0

1

2

3

4

5

6

7

8

0,3468

0,38742

0,19371

0,05739

0,01116

0,00149

0,00014

0,00001

0,00000

0, 36788

0,36788

0,18394

0,06131

0,01533

0,00307

0,00051

0,00007

0,00001

1,05506

0,94956

0,94956

1,06830

1,37366

2,06040

3,64286

7,0000

+∞

obszar krytyczny K

{x : x ­ 8}

{x : x ­ 7}

{x : x ­ 6}

{x : x ­ 5}

{x : x ­ 4}

{x : x ­ 3}

PH0 (K)

0,00000

0,00001

0,00015

0,00164

0,01280

0,07019

PH1 (K)

0,00001

0,00008

0,00059

0,00366

0,01899

0,08030

Test niezrandomizowany na poziomie istotności α = 0, 05:

(

φ(x) =

1,

0,

gdy x ­ 4

gdy x < 4.

Rozmiar testu EPH0 φ = PH0 {x : x ­ 4} = 0, 01280.

Jeśli γ = 0, 6482, to

PH0 {x : x ­ 4} + γPH0 {x : x = 3} = 0, 05.

Test zrandomizowany na poziomie istotności α = 0, 05

1,

gdy x ­ 4

φ(x) = 0, 6482 gdy x = 3

0,

gdy x ¬ 2.

ma również rozmiar 0, 05.

Jaka jest moc tego testu? Tylko 0, 05873!

Interpretacja: prawdopodobieństwo nieodrzucenia weryfikowanej hipotezy H0 = {B(10; 0, 1)},

gdy prawdziwa jest hipoteza alternatywna H1 = {P o(1)}, wynosi 0,94127.

Konkluzje

57

Konkluzje

• W przypadku hipotez złożonych teorię Neymana-Pearsona można przenieść na tzw.

modele z monotonicznym ilorazem wiarogodności.

• Teoria porównywania testów ma ograniczone znaczenie praktyczne.

58

9. Testowanie hipotez statystycznych

10. Testowanie hipotez - przykłady

Dystrybuanta empiryczna i tw. Gniedenki-Cantellego

59

60

10. Testowanie hipotez - przykłady

Test zgodności Kołmogorowa

Przypuścmy, że X1 , X2 , . . . , XN jest próba prostą z nieznanego rozkładu. Rozważmy

hipotezę H0 : zmienne maja rozkład o dystrybuancie F , przeciw alternatywie H1 :

zmienne mają inny rozkład o dystrybuancie G 6= F . Jak przetestować tę hipotezę?

• Niech zmienne będą miały rozkład G i niech GN będzie odpowiednią dystrybuantą

empiryczną. Określamy statystykę

DN = sup |GN (x) − F (x)|.

x∈IR1

• Jeżeli G = F , to statystyka powinna przyjmować małe wartości; jeżeli G 6= F ,

to wartości powinny być znacząco większe. Określamy więc zbiór krytyczny dla

poziomu istotności α wzorem

KDN ,α = {DN > DN (α)},

gdzie PF (KDN ,α ) ¬ α.

• Problem: PF (KDN ,α ) zależy od F ! Jak obliczyć to prawdopodobieństwo dla każdego F ? Na szczęście w obszernej klasie rozkładów PF (KDN ,α ) nie zależy od F !

• Jeżeli f jest funkcją niemalejącą, to dla dowolnej zmiennej losowej X i t ∈ IR1

{f (X) < f (t)} ⊂ {X ¬ t} ⊂ {f (X) ¬ f (t)}.

Test zgodności Kołmogorowa

61

• Niech F będzie dystrybuantą zmiennej losowej X. Jeśli F jest ciągła, to

F (X) ∼ U (0, 1).

• Niech X1 , X2 , . . . , XN będzie próbką prostą z F . Jeżeli F jest ciągła, to F (X1 ), F (X2 ), . . .

jest próbką prostą z rozkładu U (0, 1).

62

10. Testowanie hipotez - przykłady

Porównywanie średnich

Przypomnijmy, że rozkładem t-Studenta o k stopniach swobody nazywamy rozkład

Test χ2 Pearsona

zmiennej losowej

63

√

Z0

T =q

k,

Z12 + Z22 + . . . Zk2

gdzie Z0 , Z1 , . . . Zk są niezależne o rozkładzie N (0, 1).

Test χ2 Pearsona

• Niech niezależne zmienne losowe X1 , X2 , . . . , XN przyjmują wartości ai z prawdopodobieństwem pi > 0, p1 + . . . + pk = 1.

• Określamy:

νi =

N

X

1I {{Xj =ai }} .

j=1

• Jeśli n1 + n2 + . . . nk = N i spełnione są pewne inne założenia, to

P (ν1 = n1 , ν2 = n2 , . . . , νk = nk ) =

N!

pn1 pn2 . . . pnk k .

n1 !n2 ! . . . nk ! 1 2

(rozkład wielomianowy).

Przypomnijmy, że rozkład χ2 z k-stopniami swobody to rozkład zmiennej losowej

χ2k ∼ X12 + X22 + . . . + Xk2 ,

64

10. Testowanie hipotez - przykłady

gdzie X1 , X2 , . . . , Xk są niezależne o rozkładzie N (0, 1). Rozkład χ2k jest rozkładem

Gamma(k/2, 1/2).

11. Metoda najmniejszych kwadratów i

regresja liniowa

Model liniowy i regresja liniowa

65

66

11. Metoda najmniejszych kwadratów i regresja liniowa

Metoda najmniejszych kwadratów

Twierdzenie Gaussa-Markowa

Twierdzenie Gaussa-Markowa

67

68

11. Metoda najmniejszych kwadratów i regresja liniowa

12. Redukcja wymiaru danych

Procedura standaryzacji danych

12.1 Definicja (Standaryzacja zmiennej losowej) Niech X będzie zmienną losową

o skończonym drugim momencie. Standaryzacją zmiennej X nazywamy zmienną losową

X − EX

Z=p

.

Var (X)

Uwaga: EZ = 0, Var (Z) = 1.

~ = (X1 , X2 , . . . , Xd )T jest wektorem losowym o macierzy kowariancji

Uwaga: Jeżeli X

~ ma wartość oczekiwaną E Z

~ =0i

Σ, to wektor standaryzowany (po współrzędnych) Z

~

macierz kowariancji R = [rij ] równą macierzy KORELACJI wektora X, tj.

cov (Xi , Xj )

rij = ρij = q

.

Var (Xi )Var (Xj )

Uwaga: prosta baza danych + ewentualna liczbowa etykietyzacja niektórych pól = ciąg

~ n (rekordów), których składowe mierzone są na ogół w różnych jedwartości wektorów X

nostkach. Wartości poszczególnych pól (współrzędnych rekordów), nawet jeśli mają podobny charakter, mogą być mierzone w różnych jednostkach, co powoduje, że w analizie

dominować mogą wielkości marginalne. Z tego powodu przed rozpoczęciem statystycznej

analizy danych przeprowadza się standaryzację lub normalizację.

12.2 Definicja (Empiryczna standaryzacja ciągu wektorów losowych) Niech

~ n = (Xn1 , Xn2 , . . . , Xnd )T , n = 1, 2, . . . , N będzie ciągiem wektorów losowych. Niech

X

N

1 X

X̄j =

Xnj , Sj =

N n=1

sP

N

n=1 (Xnj

− X̄j )2

.

N −1

~ n } nazywamy ciąg wektorów losowych Z

~ n o składowych

Standaryzacją ciągu {X

Znj =

(Xnj − X̄j )

.

Sj

69

70

12. Redukcja wymiaru danych

Analiza składowych głównych

Analiza składowych głównych

Uwaga: Innymi słowy, w analizie składowych głównych (PCA) szukamy:

71

72

12. Redukcja wymiaru danych

• k możliwie małego (w stosunku do d), które spełnia warunek

• λi /d + λ2 /d + . . . + λk /d > α,

• i dla którego odpowiednie kombinacje liniowe zmiennych wyjściowych posiadają

sensowną interpretację.

Analiza czynnikowa

W szczególności:

~ − E X)(

~ X

~ − E X)

~ T = E(LF~ + ~ε)(LF~ + ~ε)T

Σ = E(X

= E(LF~ F~ T LT ) + E(LF~ ~εT ) + E(~εF~ T LT ) + E(~ε~εT )

= LLT + Λε .

Rozwiązanie powyższego równania oraz poszukiwanie czynników F~ przeprowadza się

numerycznie.

Uwagi:

• Niech (F~ , L) będzie rozwiązaniem dla modelu analizy czynnikowej. Nich B będzie

dowolnym odwzorowaniem ortogonalnym. Wówczas (B F~ , LB T ) tez jest rozwiązaniem i konieczna jest dodatkowa analiza i wybór odpowiedniej „rotacji czynników”.

Analiza czynnikowa

73

• Analiza czynnikowa, mimo bogatej literatury i mnogości algorytmów pozostaje

zawsze narzędziem bardzo kontrowersyjnym.

74

12. Redukcja wymiaru danych

Literatura

Literatura podstawowa

1. W. Niemiro „Rachunek prawdopodobieństwa i statystyka matematyczna”, Szkoła

Nauk Ścisłych, Warszawa 1999.

2. D.T. Larose „Metody i modele eksploracji danych”, Wydawnictwo Naukowe PWN,

Warszawa 2008.

Literatura uzupełniająca

1. J. Jakubowski i R. Sztencel „Wstęp do teorii prawdopodobieństwa”, Script, Warszawa 2000, 2001, 2004.

2. D.T. Larose „Odkrywanie wiedzy z danych. Wprowadzenie do eksploracji danych”,

Wydawnictwo Naukowe PWN, Warszawa 2006.

3. R. Zieliński „Siedem wykładów wprowadzających do statystyki matematycznej”,

PWN Warszawa 1990.

75