Uniwersytet Wrocławski

Instytut Fizyki Teoretycznej

Teoria Przejść Fazowych i Zjawiska

Krytyczne

Katarzyna Sznajd-Weron

Wrocław, luty 2012

1

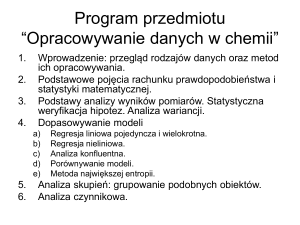

2

Spis treści

1 Literatura pomocnicza

1.1 Książki w języku polskim . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2 Książki w języku angielskim . . . . . . . . . . . . . . . . . . . . . . . . . .

1.3 Skrypty na www . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

1

1

2

2 Wstęp

2.0.1

2.0.2

4

6

9

Diagram fazowy wody . . . . . . . . . . . . . . . . . . . . . . . . .

Diagram fazowy ferromagnetyka . . . . . . . . . . . . . . . . . . . .

3 Termodynamika przejść fazowych

3.1 Wielkości termodynamiczne . . . . . . . . . . . . . . . .

3.2 Równanie Fundamentalne i Potencjały Termodynamiczne

3.2.1 Parametry intensywne i ekstensywne . . . . . . .

3.2.2 Równanie Fundamentalne . . . . . . . . . . . . .

3.2.3 Potencjały termodynamiczne . . . . . . . . . . .

3.3 Funkcje odpowiedzi . . . . . . . . . . . . . . . . . . . . .

3.3.1 Odpowiedź termiczna - ciepło właściwe . . . . . .

3.3.2 Odpowiedź mechaniczna . . . . . . . . . . . . . .

3.4 Warunki równowagi i stabilności . . . . . . . . . . . . . .

3.5 Klasyfikacja przejść fazowych . . . . . . . . . . . . . . .

3.6 Co to jest potencjał chemiczny? . . . . . . . . . . . . . .

4 Parametr Porządku i Teoria Landaua

4.0.1 Parametr porządku . . . . . . . . . . . . . .

4.0.2 Dwupunktowa funkcja korelacyjna i promień

4.0.3 Wykładniki krytyczne i klasy uniwersalności

4.1 Teoria Landaua ciągłych przejść fazowych . . . . .

4.1.1 Ciepło właściwe i entropia dla B > 0 . . . .

4.1.2 Uogólnienie: B ujemne . . . . . . . . . . . .

4.1.3 Gdzie są fluktuacje? . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

. . . . .

korelacji

. . . . .

. . . . .

. . . . .

. . . . .

. . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

11

12

13

13

13

15

16

16

17

17

18

20

.

.

.

.

.

.

.

22

22

23

24

24

26

27

29

5 Model Perkolacji w Ekonomii

33

5.1 Model Conta-Bouchaud . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

5.2 Samoorganizujący się model perkolacji fluktuacji na rynku finansowym . . 35

6 Modele

37

3

7 Co wiemy

7.0.1

7.0.2

7.0.3

7.0.4

na pewno? - czyli ścisłe wyniki w teorii przejść fazowych

Jednowymiarowy model Isinga z polem i dwuwymiarowy bez pola.

Model Perkolacji typu bond na sieci kwadratowej. . . . . . . . . .

Twierdzenie van Hove’a . . . . . . . . . . . . . . . . . . . . . . .

Twierdzenie Mermina-Wagnera . . . . . . . . . . . . . . . . . . .

8 Metoda Średniego Pola - Mean Field Approximation

8.0.5 Twierdzenie Peierlsa . . . . . . . . . . . . . . .

8.0.6 Metoda MFA dla modelu Isinga . . . . . . . . .

8.0.7 Metoda MFA dla modelu Perkolacji . . . . . . .

.

.

.

.

39

39

39

39

39

(MFA)

. . . . . . . . . . .

. . . . . . . . . . .

. . . . . . . . . . .

41

42

42

43

9 Metody Monte Carlo

45

9.1 Łańcuch Markowa i równanie Master . . . . . . . . . . . . . . . . . . . . . 47

9.2 Model Isinga i dynamika Glaubera . . . . . . . . . . . . . . . . . . . . . . 48

10 Skalowanie

52

10.1 Hipoteza skalowania w teorii przejść fazowych . . . . . . . . . . . . . . . . 53

11 Grupa Renormalizacyjna (GR)

11.1 Renormalizacja w przestrzeni rzeczywistej. . . . . . . . . . . . . .

11.2 Zastosowanie idei GR do polityki . . . . . . . . . . . . . . . . . .

11.3 Transformacja GR i Model Isinga . . . . . . . . . . . . . . . . . .

11.3.1 Decymacja w jednowymiarowym modelu Isinga . . . . . .

11.3.2 Transformacja blokowa w dwuwymiarowym modelu Isinga

4

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

58

59

60

61

61

63

5

Rozdział 1

Literatura pomocnicza

1.1

Książki w języku polskim

1. J. J. Binney, N. J. Dowrick, A. J. Fisher, M. E. J. Newman, ”Zjawiska krytyczne.

Wstęp do grupy renormalizacji”, PWN, Warszawa 1998

2. J. Klamut, K. Durczewski, J. Sznajd, ”Wstęp do fizyki przejść fazowych”, (Wyd.

PAN 1979)

3. K. Huang ”Mechanika statystyczna” (PWN, Warszawa 1986)

4. D. W. Heerman, ”Podstawy symuacji komputerowych w fizyce”, (WNT, Warszawa

1997)

5. N. G. van Kampen ”Procesy stochastyczne w fizyce i chemii” (PWN, Warszawa

1990)

6. H. G. Schuster ”Chaos Deterministyczny” (PWN, Warszawa 1993)

7. H.-O. Peitgen, H. J´’urgens, D. Saupe ”Granice Chaosu Fraktale” (PWN, Warszawa

1997)

1.2

Książki w języku angielskim

1. Silvio, R. A. Salinas ”‘Introduction to Statistical Physics”’ (Springer-Verlag 2001)

2. Linda E. Reichl ”‘A Modern Course in Statistical Physics”’ (Wiley 2009)

3. Michael Plischke, Birger Bergersen ”‘Equilibrium Statistical Physics”’ (PrenticeHall, Inc. 1989)

4. Herbert B. Callen ”‘Thermodynamics and an introduction to thermostatistics”’ second edition (John Wiley & Sons 1985)

5. Pavel L. Krapivsky, Sidney Redner, Eli Ben-Naim ”‘A kinetic view of Statistical

Physics”’ (Cambridge University Press 2011)

1

6. Malte Henkel, Haye Hinrichsen, Sven Lübeck ”‘Non-Equilibrium Phase Transitions”’

(Springer 2008)

7. Kim Christensen, Nicholas R. Moloney ”‘Complexity and Criticality”’ (Imperial

College Press 2005)

8. Dietrich Stauffer and Ammon Aharony ”Introduction To Percolation Theory”, (TAYLOR & FRANCIS LTD 1994)

9. D. P. Landau, K. Binder ”‘A Guide to Monte Carlo simulations in Statistical Physics”’, 2nd Edition (Cambridge University Press 2005)

1.3

Skrypty na www

1. http://panoramix.ift.uni.wroc.pl/ - Skrypt do wykładu z Wstępu do Teorii Przejść

Fazowych prof. dr hab. Andrzeja Pękalskiego (Uniwersytet Wrocławski)

2. http://panoramix.ift.uni.wroc.pl/ - Skrypt do wykładu z Fizyki Statystycznej II

prof. dr hab. Andrzeja Pękalskiego (Uniwersytet Wrocławski)

3. http://www.cmp.caltech.edu/refael/phys127b/ - Gil Refael notatki po angielsku do

wykładu Statistical Physics - Continuous Phase Transitions

4. http://www.dbc.wroc.pl/Content/994/gonczarek2.pdf - elektroniczna wersja książki Ryszard Gonczarek ”Teoria przejść fazowych - wybrane zagadnienia”, Oficyna

Wydawnicza Politechniki Wrocławskiej 2004

2

3

Rozdział 2

Wstęp

Kiedy byłam jeszcze na studiach, miałam trójkę znajomych zapaleńców górskich, których

największym marzeniem było spędzenie sylwestra na szczycie jakiejś wysokiej góry. Pewnej zimy, zaopatrzeni w super ciepłe śpiwory, butlę gazową i prowiant, pojechali w Tatry.

Jak później wspominali - ”Usiedliśmy na szycie góry, wyciągnęliśmy z plecaka butlę gazową i zaczęliśmy gotować jajka na naszą sylwestrową ucztę.” Ku ich zdumieniu jaja, mimo

trochę dłuższego niż zwykle gotowania okazały się na wpół surowe. Zaparzona na górze

herbata też nie smakowała jak należy. Czary? Złośliwość losu? Oczywiście, że nie.

Przyzwyczailiśmy się do tego, że woda gotuje się w temperaturze 1000 C. Zwykle zapominamy jednak, że jest to prawdą dopóki ciśnienie atmosferyczne wynosi 1bar = 1000hP a.

Ciśnienie atmosferyczne zależy zaś od tego na jakiej znajdujemy się wysokości - im wyżej tym ciśnienie niższe. Jeżeli mieszkamy na wybrzeżu morskim to ciśnienie atmosferyczne będzie rzeczywiście bliskie 1000hP a(1bar), ale już na Rysach wyniesie tylko

747hP a(0.747bar). No i co z tego? - ktoś mógłby się zapytać? Otóż okazuje się, że przy

ciśnieniu 0.747bar woda wcale nie zacznie się gotować w temperaturze 1000 C, tylko w

ok. 920 C. Możemy ją gotować oczywiście dłużej, ale woda wyższej temperatury już nie

osiągnie - po prostu zacznie się zamieniać w parę.

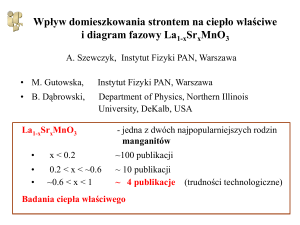

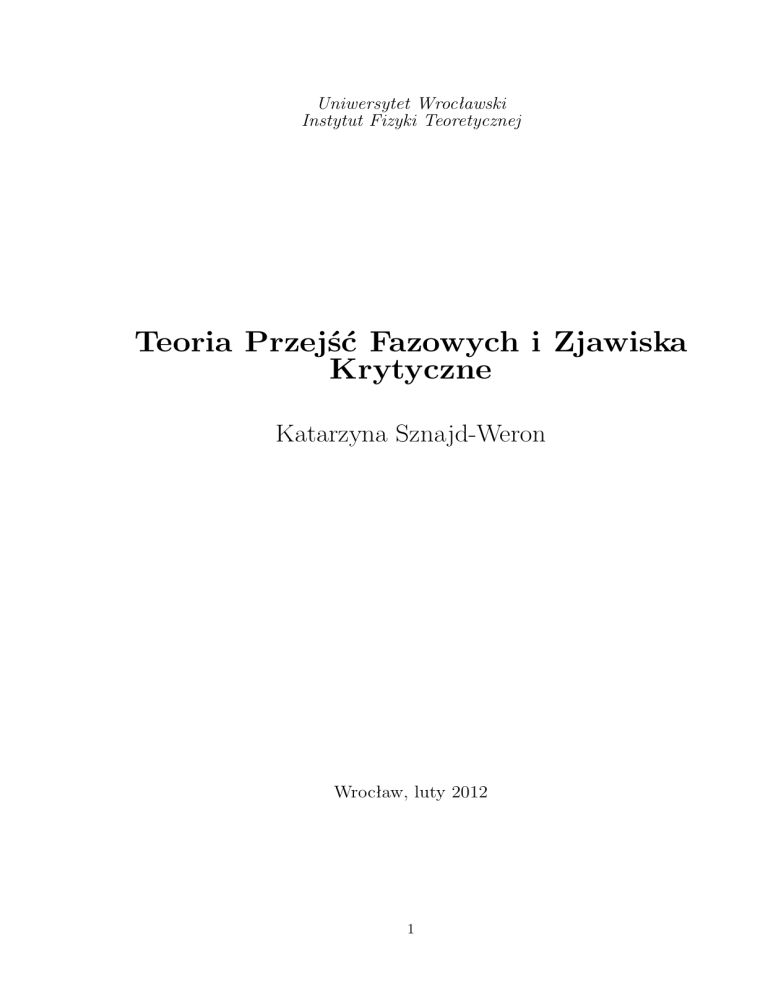

Spójrzcie na rysunek 2.1. Na rysunku tym przedstawiony został tzw. diagram fazowy dla wody. Pokazuje on w jakiej fazie znajduje się woda przy określonym ciśnieniu i

temperaturze. Jak wiadomo woda może znaleźć się zarówno w fazie stałej (lód), ciekłej,

jak i gazowej (para wodna). Jeżeli spojrzycie na diagram to zobaczycie, że przy ciśnieniu

0.747bar (na Rysach) w temperaturze 1000 C woda jest już parą, więc nie bardzo nadaje

się do parzenia herbaty.

Czarną herbatę zaparza się w temperaturze 1000 C, jeżeli zalejemy ją zimniejszą wodą

nie osiągnie pełni smaku. Niektórzy twierdzą, że właśnie dlatego Górale do kubka herbaty dolewają zawsze ”wzmacniaczy”. Może wobec tego na wyprawy wysokogórskie lepiej

zabrać herbatę białą lub zieloną, które parzy się w niższych temperaturach? W Tybecie,

gdzie zielona herbata już od prawie 1400 jest podstawowym napojem, dużo łatwiej ją zaparzyć niż we np. Wrocławiu - tam gotująca sią woda będzie miała temperaturę ok. 80 0 C,

czyli idealną do parzenia zielonej herbaty. U nas, woda po zagotowaniu ma temperaturę

prawie 1000 C, czyli musimy chwilę odczekać zanim zaczniemy herbatę parzyć. Problem

w tym, że nie bardzo wiadomo jak długo czekać ...

Wróćmy jeszcze na chwilę do diagramu fazowego wody. To co dotychczas pokazałam

to nie jest pełny diagram fazowy. Okazuje się, że lód może występować w wielu postaciach

(ogółem istnieje szesnaście odmian polimorficznych lodu, oznaczanych symbolicznie licz4

Poziom morza (0 m n.p.m)

1

p [bar]

0.8

Rysy (2500 m n.p.m)

0.6

Tybet (4800 m n.p.m)

0.4

Mount Everest (8848 m n.p.m)

0.2

LÓD

0

−40

−20

WODA

0

20

PARA

40

T [ C]

67 80

100

o

Rysunek 2.1: Diagram fazowy dla wody. Ciągłe linie dzielą diagram na trzy obszary, odpowiadające trzem fazom - stałej (lód), ciekłej (płynna woda) i gazowej (para wodna).

Jak widać przy ciśnieniu na Rysach (tzn. przy ciśnieniu 0.747 bar) w temperaturze 1000 C

woda jest już parą, więc nie bardzo nadaje się do parzenia herbaty. Na Mount Everest

jest jeszcze gorzej, bo woda już w temperaturze poniżej 700 C przechodzi w stan gazowy. Biorąc pod uwagę, że żółtko jajka ścina się w temperaturze 65 − 700 C, lepiej nie

nastawiać się na gotowanie tam jajek na twardo. Natomiast, jak widać z diagramu, Tybet jest idealnym miejscem do spożywania zielonej herbaty - tam woda zacznie wrzeć w

temperaturze ok 800 C, czyli idealnej do zaparzania tego napoju. Rysunek przygotowany

na podstawie danych dostępnych na stronie http://www.chemicalogic.com. Dane dla linii

topnienia i sublimacji na podstawie W. Wagner, A. Saul, A. Pruß: International Equations

for the Pressure along the Melting and along the Sublimation Curve for Ordinary Water

Substance, J. Phys. Chem. Ref. Data 23, No 3 (1994) 515

5

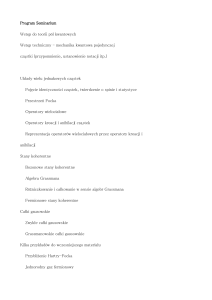

bami rzymskimi) i dlatego pełny diagram fazowy wody jest dużo bardziej skomplikowany

niż moglibyśmy przypuszczać (rys. 2.2).

Phase Diagram: Water - Ice - Steam

1.E+06

Sublimation Line

Ice I Line

Melting Line

(Ice V)

Ice III Line

1.E+04

Melting Line

(Ice VII)

Melting Line

(Ice VI)

Saturation Line

1.E+05

Ice V Line

Ice VI Line

Melting Line

(Ice III)

Ice VII Line

1.E+03

Liquid

Critical Point

1.E+02

Melting Line

(Ice I)

Saturation Line

Pressure (bar)

1.E+01

Solid

1.E+00

1.E-01

1.E-02

Triple Point

1.E-03

Sublimation Line

1.E-04

Vapor

1.E-05

1.E-06

1.E-07

0

100

200

300

400

Temperature (K)

500

600

700

800

Copyright © 1998 ChemicaLogic Corporation.

Rysunek 2.2: Pełny diagram fazowy dla wody przygotowany na podstawie danych dostępnych na stronie http://www.chemicalogic.com. Dane dla linii topnienia i sublimacji na

podstawie W. Wagner, A. Saul, A. Pruß: International Equations for the Pressure along

the Melting and along the Sublimation Curve for Ordinary Water Substance, J. Phys.

Chem. Ref. Data 23, No 3 (1994) 515

Zwróciliście też może uwagę na pewien szczególny punkt, oznaczony na rysunku 2.2

czarnym kwadratem i opisany jako Critical Point (punkt krytyczny)? To jest rzeczywiście bardzo szczególny punkt, ponieważ jak widać powyżej tego punktu nie istnieje już

linia rozdzielająca fazę ciekłą od gazowej. Czyli powyżej tego punktu nie występuje już

przejście fazowe. Nie występuje, bo nie ma już dwóch faz. Co w takim razie tam jest? Zachęcam do obejrzenia filmu ze strony http://www.youtube.com/watch?v=yBRdBrnIlTQ,

na którym profesor Martyn Poliakoff pokazuje eksperyment pokazujący co znajduje się

powyżej punktu krytycznego - nie jest to ani gaz, ani ciecz.

Przejście fazowe, które zachodzi w punkcie krytyczny (tzw. ciągłe) zasadniczo różni

się od tego, które zachodzi gdy przekraczamy linię współistnienia faz - jakie są to różnice

do tego jeszcze wrócimy w dalszej części wykładu.

2.0.1

Diagram fazowy wody

Przyjrzyjmy się jeszcze raz diagramowi fazowemu wody (rysunek 2.3). Czarne linie (górny

rysunek, przedstawiający diagram fazowy) oznaczają linie współistnienia faz - na liniach

tych obie fazy są w równowadze. Czy wiedzielibyście jak wyznaczyć te linie - tzn. jaki

jest warunek równowagi? Jeśli nie, to jeszcze do tego wrócimy. Przy przejściu przez linie

następuje przejście fazowe - przejście pomiędzy różnymi fazami. Jak zachodzi to przejście?

Na dolnym rysunku widać zależność pomiędzy dostarczanym do układu ciepłem a temperaturą. Aby podnieść temperaturę musimy dostarczyć do układu ciepło. Kiedyś koleżanka

6

wykonała następujący eksperyment. Wlała wodę do garnka, włożyła do wody termometr

(nie taki, jakim mierzy się temperaturę ciała, bo taki nie ma wystarczająco dużej skali),

a potem postawiła garnek na kuchence elektrycznej i zaczęła podgrzewać wodę. Co 10

sekund odczytywała temperaturę wody i zapisywała ją na kartce. Okazało się, że temperatura wody stale rosła w czasie aż do pewnego momentu ... W pewnej chwili mimo, ze

garnek z wodą nadal był podgrzewany temperatura przestała się zmieniać. Domyślacie

się ile wtedy wynosiła temperatura wody? Dlaczego pomimo dalszego podgrzewania temperatura pozostawała stała? Odpowiedź jest natychmiastowa jeżeli spojrzycie na dolną

część rysunku 2.3. Oczywiście analogiczne zjawisko zaobserwujecie, jeżeli włożycie wodę

z termometrem do zamrażalnika - temperatura do pewnego momentu będzie malała a

potem ...

Rysunek 2.3: Schematyczny diagram fazowy gaz-ciecz-ciało stałe oraz (poniżej) zależność

pomiędzy dostarczanym do układu ciepłem a temperaturą (Cooling Curve).

To doświadczenie z zamrażarką jest szczególnie interesujące. Jeżeli będziecie mieli tro7

chę szczęścia to możecie swoim gościom pokazać niezłą sztuczkę. Zajrzyjcie na stronę

youtube i wpiszcie hasło Supercooled Water - znajdziecie tam mnóstwo filmików z zamrażaniem wody. Supercooled Water (w języku polskim ciecz przechłodzona) to taka ciecz,

której temperatura jest na tyle niska, że powinna już być w stanie stałym, ale jednak w

takim nie jest. Znajduje się w stanie metastabilnym i zaburzenie tej cieczy (wstrząśnięcie

naczyniem z cieczą, fala dźwiekowa, wrzucenie kawałeczka lodu lub innego ciała – tzw.

zarodków krystalizacji) spowoduje jej natychmiastowe zamrożenie. Ciecz przechłodzoną

można otrzymać przez bardzo powolne ochładzanie czystej cieczy w naczyniu o gładkich

ściankach, przy braku drgań i wstrząsów mechanicznych lub bardzo szybkie ochładzanie. W wyniku nagłej krystalizacji cieczy przechłodzonej następuje wydzielenie ciepła i

podwyższenie temperatury substancji. Zjawisko to wykorzystywane jest przy produkcji

ogrzewaczy dłoni.

Ogrzewacze dłoni wykorzystujące ciepło krystalizacji roztworów przesyconych dostępne są w formie hermetycznie zamkniętych pojemników z tworzywa sztucznego, wypełnionych cieczą (postać gotowa do użycia) lub kryształkami (po użyciu). W pojemniku znajduje się też odpowiednio ukształtowana, metalowa blaszka, służąca jako „włącznik”. Wykorzystany ogrzewacz tego typu

można łatwo zregenerować ogrzewając go we wrzątku. W pojemniku znajduje

się sól o dużej skłonności do tworzenia roztworów przesyconych, zazwyczaj

uwodnionego octanu lub tiosiarczanu sodu. Sól w wyniku ogrzania pojemnika

w temperaturze kilkudziesięciu stopni ulega rozpuszczeniu we własnej wodzie

krystalizacyjnej i tworzy jednorodny roztwór. Po schłodzeniu ciecz staje się

roztworem przesyconym, lecz ze względu na brak zarodków krystalizacja nie

następuje. Aby uruchomić ogrzewacz należy wygiąć zawartą w opakowaniu

blaszkę tak, by przybrała drugi ze stabilnych kształtów. Powstająca przy tym

fala dźwiękowa, słyszalna jako „kliknięcie” zaburza stan metastabilny roztworu

i inicjuje krystalizację, która w ciągu kilkunastu sekund obejmuje całą objętość pojemnika. Wydzielane podczas krystalizacji ciepło rozgrzewa pojemnik,

a jego podwyższona temperatura może utrzymywać się od kilkunastu minut

do kilku godzin. [źródło: Wikipedia]

Jak już wspomniałam ciecz przechłodzona jest z termodynamicznego punktu widzenia

stanem metastabilnym, tzn. dla małych zaburzeń stabilnym, ale dla większych niestabilnym. Żeby lepiej zrozumieć czym jest stan metastabilny spójrzcie na rysunek 4.1.

Ze stanami metastabilnymi związane jest pojęcie histerezy. Ogólnie w naukach przyrodniczych histereza oznacza zależności aktualnego stanu układu od stanów w poprzedzających chwilach. Na przykład w przemianie fazowej ciało stałe-ciecz histereza występuje

kiedy temperatury topnienia i krzepnięcia są różne – np. agar topi się w temperaturze ok.

850 C a krzepnie w zakresie od 32 do 400 C. Oznacza to, że agar stopiony przy temperaturze

850 C pozostaje w stanie ciekłym do temperatury 400 C. Z drugiej strony jeżeli początkowo

jest w stanie stałym to aż do temperatury 850 C w takim stanie pozostanie. Dlatego w

temperaturach 40 − 850 C agar może być w postaci ciekłej lub stałej w zależności od stanu

wyjściowego.

Najbardziej znane jednak przypadki histerezy występują w materiałach magnetycznych, głównie w ferromagnetycznych, gdzie namagnesowanie następuje dopiero po pewnym wzroście zewnętrznego pola magnetycznego – do diagramu fazowego dla ferromagne8

stany metastabilne

stan stablilny

Rysunek 2.4: Kulka - w ”‘górzystym”’ krajobrazie (energia potencjalna) – poglądowe

przedstawienie stanów równowagi stabilnej, metastabilnej i niestabilnej. Podobnie może

wyglądać energia wewnętrzna układu, w którym realizowane są stany równowagi stabilnej,

metastabilnej i niestastabilnej.

tyka wrócimy w kolejnym rozdziale. Na razie jeszcze na chwilę wróćmy do dolnej części

rysunku 2.3.

Jak już powiedzieliśmy wydać z niego po pierwsze, że w momencie przemiany fazowej

dostarczanie lub wydzielanie się ciepła nie powoduje zmiany temperatury substancji –

ciepło zużyte zostaje na przemianę fazową. To ciepło nazywa się utajonym ciepłem przemiany (latent heat) i występuje tylko przy tzw. nieciągłych przejściach fazowych. Kolejna

obserwacja (patrz rys. 2.3) – przy tego rodzaju przejściu mamy obszary współistnienia

dwóch faz - w momencie topnienia lodu zarówno lód, jak i woda są obecne w układzie. To

współistnienie faz jest również charakterystyczne dla przejść nieciągłych. Do klasyfikacji

przejść fazowych jeszcze wrócimy, ale na razie możemy już podsumować, że dla przejść

nieciągłych jakimi są między innymi topnienie, krystalizacja, parowanie charakterystyczne

jest:

• Występowanie utajonego ciepła przemiany - ciepło jest pochłaniane lub wydzielane

w trakcie przemiany fazowej przy stałej temperaturze układu.

• W trakcie przemiany fazowej obserwujemy współistnienie faz, pomiędzy którymi

zachodzi przejście.

• Obserwowane są stany metastabilne, a co za tym idzie histerezy - stanu układu

zależy od stanów w poprzedzających chwilach.

2.0.2

Diagram fazowy ferromagnetyka

9

Rysunek 2.5: Magnetyzacja w zależności od temperatury.

10

Rozdział 3

Termodynamika przejść fazowych

Przejścia fazowe są zjawiskami kooperatywnymi, a więc zjawiskami zachodzącymi w układach wielocząstkowych. Oznacza to, że do ich opisu można użyć albo termodynamiki czyli

metody fenomenologicznej 1 , albo mechaniki statystycznej, która jest narzędziem pozwalającym przewidzieć zachowanie układu z dużą liczbą stopni swobody na podstawie praw

rządzących na poziomie mikroskopowym.

Termodynamika zajmuje się głównie problemami zamiany energii (pracy i ciepła) oraz

własnościami równowagowymi. Równowaga jest zjawiskiem makroskopowym i odnosi się

do skali czasu znacznie większej niż skala charakteryzująca ruch mikroskopowy. Z punktu

widzenia mikroskopowego równowaga jest takim szczególnym stanem ruchu, w którym, w

czasie obserwacji, nie zmienia się stan makroskopowy obserwowanego ciała.

Podstawą termodynamiki jest założenie, że przy określonych warunkach zewnętrznych dany układ ma jednoznacznie zdefiniowane własności równowagowe. Te zewnętrzne

warunki są określone przez zewnętrzne parametry takie jak: temperatura, ciśnienie, pole magnetyczne itd. Oczywiście przy różnych warunkach zewnętrznych układ ma różne

własności równowagowe. Przy czym przez własności równowagowe rozumiemy własności

strukturalne, termiczne, elektryczne, magnetyczne, elastyczne itd. Zazwyczaj małe zmiany

parametrów zewnętrznych np. temperatury powodują niewielkie zmiany własności układu.

Są jednak takie punkty na skali temperatur w pobliżu, których bardzo niewielka zmiana

temperatury powoduje gwałtowną zmianę własności układu. Taka nagła zmiana własności

nosi nazwę przejścia fazowego. Oznacza to, że dla wystąpienia przejścia fazowego potrzebne jest istnienie dwóch różnych równowagowych stanów układu (faz).

Gwałtowne, a często również niespodziewane zmiany występują w przeróżnych układach złożonych - poczynając od fizycznych (przejścia fazowe, np. topnienie lodu), poprzez

biologiczne (np. wymieranie i powstawanie gatunków), społeczne (np. bunty, rewolucje)

aż po ekonomiczne (np. krachy giełdowe). Okazuje się również, że wiele z tych zjawisk

wykazuje zaskakujące podobieństwo przynajmniej z formalnego punktu widzenia.

1

Fenomenologia w fizyce: Widzimy jak przebiega dane zjawisko, znajdujemy jakieś regularności, potrafimy przewidzieć, że takie regularności powinny wystąpić gdzie indziej, ale nie potrafimy tego zjawiska

wyjaśnić.

11

3.1

Wielkości termodynamiczne

Jak już wspomnieliśmy jednym z głównych zagadnień opisywanych przez termodynamikę

jest problemem zmiany energii wukładu. Energia wewnętrzna układu, podstawowa funkcja

stanu, może być zmieniona przez:

1. zewnętrzne siły, które wykonują pracę dW na tym układzie, ew. układ może wykonać

pracę,

2. oddanie (ew. pobranie) ciepła dQ = T dS,

3. zmianę liczby cząstek w układzie (cząstki mogą być różnych typów indeksowanych

przez j = 1, 2, ...), wkład do zmiany energii wewnętrznej wynosi wówczas:

X

µj dNj ,

(3.1)

j

gdzie µj jest potencjałem chemicznym cząstek typu j.

Opierając się na analogii mechanicznej możemy powiedzieć, że praca równa się sile

razy przesunięcie. W zależności od rodzaju układu może mieć postać:

• Praca dW wykonana przez napięcie f ciągnące metalowy pręt na dystansie dX jest

równa:

dW = −f dL.

(3.2)

• Zewnętrzne pole magnetyczne h wykonuje pracę, przy której wzrost energii obiektu

związany jest ze wzrostem namagnesowania:

dW = −hdM.

(3.3)

• Ciśnienie p jest siłą, która powoduje zmianę objętości V , a odpowiadająca temu

praca

dW = pdV

(3.4)

Brak znaku minus oznacza, że wzrost ciśnienia powoduje zmniejszanie się objętości.

Jak widać wszystkie czynniki 1-3 powodujące zmianę energii wewnętrznej mają postać pracy, przy czym Dystans L, namagnesowanie M , objętość V , liczba cząstek

N czy entropia S grają rolę uogólnionych współrzędnych, natomiast napięcie

f , pole magnetyczne h, ciśnienie p, potencjał chemiczny µ oraz temperatura T są uogólnionymi siłami zewnętrznymi, które mogą zmienić odpowiednie

współrzędne. Te uogólnione współrzędne są współrzędnymi makroskopowymi

(termodynamicznymi). Na szczególną uwagę zasługuje entropia, która nie jest typową

współrzędną – dzięki niej można wyrazić ruch mikroskopowy cząstek w sposób kolektywny.

12

3.2

Równanie Fundamentalne i Potencjały Termodynamiczne

Językiem współczesnej teorii przejść fazowych jest magnetyzm. Poznaliśmy już w czasie

kursu fizyki statystycznej równanie fundamentalne dla układu P T V , ale dla porządku

przypomnijmy je sobie i wprowadźmy je dla układów magnetycznych.

Aby opisać układ można podawać za każdym razem zbiór wszystkich wielkości termodynamicznych, charakteryzujących stan równowagi termodynamicznej, ale żeby opis ten

był bardziej przejrzysty i wygodniejszy w użyciu lepiej ograniczyć się do wyboru zmiennych niezależnych. Oczywiście taki wybór nie jest jednoznaczny - możemy traktować na

przykład S, V, N (lub S, M, N dla układów magnetycznych) jako zmienne niezależne, a

wtedy T, p, µ (odpowiednio T, h, µ) będą mogły być wyrażone przez te zmienne - pamiętacie siły i współrzędne uogólnione są związane ze sobą przez energię. Oczywiście można

też wybrać jako trójkę zmiennych niezależnych np. T, V, N lub dokonać jeszcze innego

wyboru. Musimy też znaleźć sposób wyrażenie tych zmiennych za pomocą pozostałych

wielkości termodynamicznych.

Układy w stanie równowagi opisujemy za pomocą pewnych funkcji termodynamicznych

- tzw. równania fundamentalnego lub potencjałów termodynamicznych, tzn. transformacji

Legendre’a równania fundamentalnego. Wszystkie te funkcje mają tę własność, że dzięki nim możemy określić wszystkie wielkości charakteryzujące dany układ. W przypadku

równania fundamentalnego zmiennymi zależnymi są wyłącznie tzw. parametry ekstensywne (patrz dalej), w przeciwieństwie do znacznie ogólniejszego przypadku potencjałów

termodynamicznych.

3.2.1

Parametry intensywne i ekstensywne

Wszystkie termodynamiczne parametry układu można podzielić na dwie kategorie

1. Addytywne (ekstensywne), tzn. mające taką własność, że wartość tego parametru

dla całego układu równa się sumie wartości tego paratemru identycznych podukładów tworzących dany układ. Przykładami takich parametrów są energia, entropia,

objętość, magnetyzacja, liczba cząstek: U (λS, λV, λN1 , ..., λNr ) = λU (S, V, N1 , ..., Nr )

2. Nieaddytywne (intensywne), wartość tego parametru dla całego układu równa się

wartości tego paratemru dla każdego z identycznych podukładów tworzących dany

układ, np. temperatura czy ciśnienie: T (λS, λV, λN1 , ..., λNr ) = T (S, V, N1 , ..., Nr )

3.2.2

Równanie Fundamentalne

W stanie równowagi układ może być określony jednoznacznie poprzez podanie tzw. równania fundamentalnego, tzn. związku pomiędzy energią wewnętrzną (albo entropią) a

pozostałymi parametrami ekstensywnymi. Równanie fundamentalne może więc przybierać

następujące postaci:

• Dla układów P T V :

S = S(U, V, N1 , ..., Nr )

U = U (S, V, N1 , ..., Nr ).

13

(3.5)

(3.6)

• Dla układów magnetycznych:

S = S(U, h, N )

U = U (S, h, N ).

(3.7)

(3.8)

Parametry intensywne można wprowadzić formalnie obliczając różniczkę zupełną:

dU =

∂U

∂S

!

∂U

dS +

∂V

V,N1 ,...,Nr

!

dV +

r

X

j=1

S,N1 ,...,Nr

∂U

∂Nj

!

dNj

(3.9)

S,V,...Nk

Wprowadźmy następujące oznaczenia:

∂U

∂S

!

∂U

−

∂V

!

≡T

temperatura

(3.10)

≡P

ciśnienie

(3.11)

≡ µj

potencjał chemiczny

(3.12)

V,N1 ,...,Nr

∂U

∂Nj

S,N1 ,...,Nr

!

S,V,...Nk

Dla układów magnetycznych będziemy mieli oczywiście odpowiednio:

dU =

∂U

∂S

!

∂U

dS +

∂M

V,N

!

∂U

dM +

∂N

S,N

!

dN

(3.13)

S,V

gdzie pojawia się dodatkowo pole magnetyczne jako pochodna magnetyzacji:

∂U

∂M

!

≡ H.

(3.14)

S,N

W przypadku układów magnetycznych liczba cząstek N będzie praktycznie zawsze ustalona, także dN = 0 i nie będziemy zaznaczać, że pracujemy dla N = const. Dodatkowo,

żeby uniezależnić zmienne od wielkości układu będziemy zwykle używać zmiennych na

cząstkę i oznaczać je małymi literami, np magnetyzacja m = M/N .

Jak widać parametry intensywne pojawiają się wówczas jako odpowiednie pochodne

cząstkowe parametrów ekstensywnych i można zamiast równania fundamentalnego zapisać

3 równania stanu (napisz analogiczne dla układu magnetycznego):

T = T (S, V, N ) = T (s, v)

p = p(S, V, N ) = p(s, v)

µ = µ(S, V, N ) = µ(s, v)

(3.15)

Jeżeli znamy dwa z powyższych równań to trzecie możemy wyznaczyć z tzw. relacji

Gibbsa-Duhema, która dla układu jednoskładnikowego ma postać (pokaż na ćwiczeniach):

SdT − V dP + N dµ = 0.

(3.16)

Jeżeli mamy już wszystkie 3 równania stanu wówczas możemy odtworzyć równanie fundamentalne, tzn. mamy pełna termodynamiczną informację o układzie.

14

Oczywiście zawsze możemy wyrazić energię wewnętrzną jako funkcję innych zmiennych niż S, V, N (S, M, N ). Na przykład moglibyśmy wyeliminować S z U = U (S, V, N )

i T = T (S, V, N ) w rezultacie otrzymując U = U (T, V, N ). Jednak takie równanie nie

daje pełnej informacji o układzie tzn. nie jest równaniem fundamentalnym. Dlaczego?

Przypomnijmy sobie, że: T = (∂U/∂S)V,N . Rozważmy teraz zależność U = U (T, V, N ) i

zobaczmy czy potrafimy jednoznacznie wyznaczyć z niej zależność U = U (S, V, N ). Jeżeli

wykreślilibyśmy przy V, N = const zależność U = U (T ) = U (∂U/∂S) to odpowiadałoby

jej nieskończenie wiele zależności U = U (S) o tym samym nachyleniu co U (T ), ale dowolnie poprzesuwanych wzdłuż osi S, ponieważ jak wiecie różniczka za stałej wartości wynosi

zero. Wobec tego z zależnosci U = U (S) możemy jednoznacznie wyznaczyć U = U (T ), ale

nie odwrotnie. A gdybyśmy chcieli, żeby to nie temperatura była pochodną, ale entropia?

Wówczas musimy wprowadzić potencjały termodynamiczne.

3.2.3

Potencjały termodynamiczne

Dotychczas termodynamiczną informację o układzie otrzymywaliśmy z równania fundamentalnego, które mogło być zapisane w języku energii albo entropii. W obu tych reprezentacjach parametry ekstensywne odgrywały rolę zmiennych niezależnych a parametry

intensywne pojawiały się jako odpowiednie pochodne. Jednakże z punktu widzenia eksperymentu znacznie wygodniej operować parametrami intensywnymi. To właśnie parametry

intensywne są łatwo kontrolowane i mierzone. Wygodniej zatem byłoby móc operować nimi jako zmiennymi niezależnymi. Poznaliście już na mechanice klasycznej formalizm, który to umożliwia - transformata Legendre’a. Potencjałami termodynamicznymi będziemy

nazywali właśnie różne transformaty Legendre’a równania fundamentalnego. W różnych

podręcznikach nazywają się one różnie, ale nie nazwy są dla nas istotne, ale to jak wygląda

potencjał w zależności od tego z jakimi parametrami chcemy mieć do czynienia.

W ogólności mamy związek:

Y = Y (X0 , X1 , ..., Xr )

(3.17)

i chcemy aby zmiennymi niezależnymi zamiast Xk były:

Pk ≡

∂Y

.

∂Xk

(3.18)

X

(3.19)

Umożliwia nam to transformata Legendre’a:

Ψ=Y −

Pk X k .

k

Możemy na przykład zastąpić w równaniu fundamentalnym entropię przez temperaturę. Taki potencjał nazywany jest zwykle energią swobodną Helmholtza i oznaczany przez

F . Transformacja Legendre’a ma wtedy postać

U = U (S, V, N1 , N2 , ...)

S → T

∂F

S = −

∂T

F = U − TS

F = F (T, V, N1 , N2 , ...)

15

(3.20)

(3.21)

Podobnie można otrzymać inne potencjały termodynamiczne, np. entalpię H:

U = U (S, V, N1 , N2 , ...)

V → P

∂U

−P =

∂V

H = U +VP

H = H(S, P, N1 , N2 )

(3.22)

(3.23)

(3.24)

Innym popularnym potencjałem termodynamicznym jest energia swobodna Gibbsa, w

który zamiast entropii zmienną niezależną jest temperatura, a zamiast objętości występuje

jako zmienna niezależna ciśnienie:

U

S

V

G

G

3.3

=

→

→

=

=

U (S, V, N1 , N2 , ...)

T

P

U − TS + V P

G(T, p, N1 , N2 , ...)

(3.25)

(3.26)

Funkcje odpowiedzi

Niezwykle ważne z punktu widzenia zrozumienia przejść fazowych, są funkcje, które określają nam jak układ reaguje na zmianę pewnych parametrów zewnętrznych. Takie funkcje

nazywamy funkcjami odpowiedzi, są to wielkości termodynamiczne, które są najbardziej

przydatne z punktu widzenia eksperymentu.

Odpowiedź układu może być dwojakiego rodzaju - termiczna lub mechaniczna.

3.3.1

Odpowiedź termiczna - ciepło właściwe

Odpowiedź termiczną mierzy tzw. ciepło właściwe (heat capacity), które określa jak dużo

trzeba dodać do układu ciepła, żeby zmienić jego temperaturę:

C≡

dQ

.

dT

(3.27)

Gdy mierzymy C to staramy się ustalić wszystkie inne zmienne niezależne poza temperaturą. Jeżeli rozważamy układ o ustalonej liczbie cząstek N = const to oczywiście zmienne,

które moglibyśmy ew. zmienić to p i V (ew. h i M ). Jednak p jest zależne od V (podobnie

h od M ) - możemy więc przyjąć za zmienną niezależną V , wtedy p jest zależne lub p

i wtedy V jest zależne (odpowiednio ta sama dyskusja dla magnetykow). W zależności

na co się zdecydujemy mamy T, V, N jako zmienne niezależne lub T, p, N i odpowiednio

mierzymy ciepło właściwe przy stałej objętości CV lub przy stałym ciśnieniu Cp . Wygodnie jest wyrazić oba te ciepła przy pomocy entropii korzystając ze związku dQ = T dS

16

(ćwiczenia):

CV = T

Cp = T

∂S

∂T

!

∂S

∂T

!

(3.28)

V

,

(3.29)

p

lub dla układów magnetycznych:

cv = T

cp = T

3.3.2

∂s

∂T

!

∂s

∂T

!

(3.30)

m

.

(3.31)

h

Odpowiedź mechaniczna

Pierwszą z funkcji odpowiedzi mechanicznej jest tzw. podatność izotermiczna, czyli

jak nazwa wskazuje jak układ reaguje na zmianę pewnego zewnętrznego (kontrolnego)

parametru przy stałej temperaturze. Co może być tym parametrem skoro T = const?

Oczywiście ciśnienie (wpływa na zmianę objętości) lub pole magnetyczne (wpływa na

zmianę magnetyzacji) w zależności od rozważanego układu:

• Podatność magnetyczna:

ξT =

∂m

∂h

!

• Ściśliwość izotermiczna:

∂V

∂p

1

κT =

V

.

(3.32)

T

!

.

(3.33)

T

Szybkie pytanie kontrolne: Dlaczego w równaniu na ściśliwość izotermiczną mamy dzielenie przez V , a w równaniu na podatność magnetyczną nie?

Formalnie można również analogicznie zdefiniować podatność adiabatyczną (przy stałej entropii), ale nie będziemy jej używać ze względu na małą użyteczność praktyczną

(dlaczego?). Można również zapytać jak będzie reagowała objętość przy zmianie temperatury. Tą informację daje nam tzw. rozszerzalność cieplna:

1

α=

V

∂V

∂T

!

,

(3.34)

P

jednak ponieważ będziemy się zajmowali głównie układami magnetycznymi, nie będziemy

z niej korzystali.

3.4

Warunki równowagi i stabilności

Rozważmy teraz izolowany układ, tzn. U = const złożony z dwóch podukładów przedzielonych ścianą, która nie przepuszcza cząstek ale przepuszcza ciepło. Energie podukładów

oznaczymy przez U1 i U2 . Z addytywności energii otrzymujemy natychmiast:

U1 + U2 = U = const.

17

(3.35)

Chcemy teraz znaleźć warunek na równowagę takiego układu. Z drugiej zasady termodynamiki w stanie równowagi:

dS = 0.

(3.36)

Ponieważ entropia jest ekstensywna:

S = S1 (U1 , V1 , N1 ) + S2 (U2 , V2 , N2 ).

(3.37)

Możemy teraz obliczyć:

dS =

∂S1

∂U1

!

∂S2

dU1 +

∂U2

V1 ,N1

!

dU2 .

(3.38)

V2 ,N2

Pozostałe wyrazy nie występują ponieważ w rozważanym przykładzie dV1 , dV2 , dN1 , dN2 =

0. Zgodnie z naszą definicją:

1

1

dS = dU1 + dU2

(3.39)

T1

T2

Ponieważ U1 + U2 = const, więc:

dU1 + dU2 = 0 → dU1 = −dU2 .

(3.40)

Czyli:

1

1

−

dS =

dU2

(3.41)

T1 T2

Ponieważ w stanie równowagi dS = 0 dla dowolnej wartości dU2 ,tzn. dowolny skończony

przepływ energii z podukładu 1 do 2 nie zmienia entropii całego układu, czyli

1

1

=

T1

T2

(3.42)

Oczywiście dotychczas określiliśmy jedynie warunki równowagi w przypadku gdy podukłady nie zmieniają objętości ani nie wymieniają cząstek. Jakie byłyby warunki równowagi

w przypadku gdy możliwa byłaby zmiana objętości i liczby cząstek podukładów (ćwiczenia)? Kolejnym problemem jest zbadanie stabilności takiej równowagi, tzn. znalezienie

warunku, dla którego dS 2 < 0, dU 2 > 0. Dopuszcza się możliwość wzbudzeń, przy których

tylko jedna z tych nierówności jest spełniona. Stan taki nazywamy stanem równowagi

metastabilnej. Stany metastabilne realizowane są na przykład przy przegrzaniu lub przechłodzeniu.

Można pokazać (ćwiczenie), że warunek stabilności równowagi ma postać:

cv , κT > 0

(3.43)

Jeżeli kryterium stabilności nie jest spełnione wówczas układ rozpada się na dwa lub

więcej faz. Ten rozpad nazywamy przejściem fazowym.

3.5

Klasyfikacja przejść fazowych

Każdy nas chyba codziennie spotyka się z przejściami zachodzącymi w wodzie - gotując wodę czy mrożąc lód do napojów. W normalnych warunkach są to tak zwane przejścia nieciągłe (albo pierwszego rodzaju). Można się łatwo domyśleć, że skoro istnieją

18

przejścia nieciągłe to są również ciągłe. Modelowym przykładem przejścia ciągłego jest

przemiana żelaza z postaci paramagnetycznej w ferromagnetyczną w temperaturze Curie

Tc = 1043K. W temperaturze T > Tc żelazo (miedź, cynk) jest paramagnetyczne, tzn. nie

ma pola magnetycznego. Natomiast dla T < Tc materiał jest w stanie ferromagnetycznym, tzn. jest namagnesowany nawet bez zewnętrznego pola, natomiast w polu moment

magnetyczny obraca się natychmiast w kierunku przyłożonego pola.

Parametrem pozwalającym eksperymentalnie podzielić wszystkie przejścia fazowe jednoznacznie na ciągłe i nieciągłe jest ciepło utajone przemiany. Przejścia nieciągłe są to

takie przejścia, w których występuje ciepło przemiany, tzn. w trakcie przejścia z fazy wysokotemperaturowej do niskotemperaturowej w pobliżu temperatury przejścia wydziela się

skończona ilość ciepła, zwana ciepłem przemiany. Wszystkie przejścia fazowe, w których

nie występuje ciepło przemiany klasyfikujemy jako ciągłe. Większość przejść fazowych I

rodzaju redukuje się w pewnym punkcie do przejścia ciągłego.

Ciepło utajone przemiany q jest energią potrzebną do przeniesienia cząstki z jednej

fazy do drugiej. Niech Ni oznacza liczbą cząstek w i-tej fazie oraz:

i =

Ei

Ni

vi =

Vi

Ni

si =

Si

Ni

(3.44)

oznaczają odpowiednio energię, objętość i entropię przypadającą na cząstkę w i-tej fazie.

Z pierwszej zasady termodynamiki (zasady zachowania energii), wiemy że:

dE = dQ − dW → dQ = dE + dW = dE + pdV

(3.45)

gdzie dE oznacza zmianę energii wewnętrznej układu, dQ ilość ciepła dodaną układowi,

a dW = pdV pracę wykonaną przez układ. Czyli ciepło utajone przemiany:

q = (1 − 2 ) + p(v1 − v2 ).

(3.46)

Z warunku równowagi:

µ1 = µ2

T1 = T2 = T

p1 = p2 = p.

(3.47)

Potencjał chemiczny układu złożonego z identycznych cząstek jest po prostu potencjałem

termodynamicznym Gibbsa na cząstkę:

µi =

Gi

Ei − T Si + pVi

=

= i − T si + pvi .

Ni

Ni

(3.48)

Czyli:

µ1 −µ2 = (1 −2 )−T (s1 −s2 )+p(v1 −v2 ) = [(1 −2 )+p(v1 −v2 )]−T (s1 −s2 ) = 0 (3.49)

Korzystając teraz ze wzoru (3.46) otrzymujemy:

q − T (s1 − s2 ) = 0 ⇒ q = T (s1 − s2 ).

(3.50)

Ciepło utajone przemiany jest parametrem pozwalającym eksperymentalnie podzielić wszystkie przejścia fazowe na ciągłe, przy których obserwuje się

skok entropii i q 6= 0 oraz ciągłe, w których entropia zmienia się w sposób

ciągły i w związku z tym q = 0

19

3.6

Co to jest potencjał chemiczny?

Jak napisałam w poprzednim rozdziale potencjał chemiczny układu złożonego z identycznych cząstek jest po prostu potencjałem Gibbsa termodynamicznym na cząstkę. Czy to

jest takie oczywiste? Jak można to pokazać?

Można to pokazać niemal natychmiast jeżeli skorzystamy ze szczególnej postaci równania Eulera:

U = T S − pV + µN.

(3.51)

Wówczas z transformaty Legendre’a otrzymamy:

G = U − T S + pV = T S − pV + µN − T S + pV = µN.

(3.52)

Skąd bierze się równanie Eulera (3.51)? Żeby je wyprowadzić musimy skorzystać z

pewnej istotnej własności energii wewnętrznej – ekstensywności, która oznacza:

U (λS, λX1 , ...) = λU (S, X1 , ...)

(3.53)

Zróżniczkujmy to obustronnie po λ:

∂U (λS, λX1 , ...) ∂(λS) ∂U (λS, λX1 , ...) ∂(λX1 )

+

+ ... = U (S, X1 , ...).

∂(λS)

∂λ

∂(λX1 )

∂λ

(3.54)

To ma być prawda dla dowolnego λ, a więc również λ = 1:

∂U

∂U

S+

X1 + ... = U.

∂S

∂X1

(3.55)

Czyli dla układu jednoskładnikowego P V T otrzymujemy:

U = T S − pV + µN

20

(3.56)

21

Rozdział 4

Parametr Porządku i Teoria Landaua

W tym rozdziale dowiemy się jak teoretycznie opisać przejścia fazowe, a w szczególności

ciągłe przejścia fazowe. Pierwszym krokiem w tym kierunku będzie wprowadzenie tak

zwanego parametru porządku, a uwieńczeniem genialna teoria Landaua z 1937.

Załóżmy, że mamy do czynienia z kryształem, którego komórka elementarna jest prostą

komórką kubiczną. Infinityzymalne przemieszczenie węzłów sieci może doprowadzić do

przejścia komórki kubicznej w tetragonalną, a więc do zmiany symetrii. Podobnie symetria

fazy paramagnetycznej jest inna niż ferromagnetycznej. Ideę Landaua można sprowadzić

do założenia, że przy tego typu przejściach fazowych zawsze można znaleźć wielkość, której

mała zmiana powoduje zmianę symetrii. Wielkość tę nazywamy parametrem porządku.

Rysunek 4.1: Który twoim zdaniem układ ma wyższą symetrię - ten po lewej (T < Tc )

czy po prawej (T > Tc ). Zastanów się dobrze - co się stanie gdy odwrócisz rysunki do

góry nogami?

4.0.1

Parametr porządku

Do opisu każdego przejścia fazowego ciągłego można zdefiniować tzw. parametr porządku

φ, tzn. parametr, który pozwala rozróżnić nam poszczególne fazy. Jest to wielkość, która

jest różna poniżej punktu krytycznego jest różna od zera, a powyżej tego punktu równa

22

przejście fazowe

parametr porządku

własność

ciecz-gaz

gęstość

skalar

ferro-paramegnetyk

magnetyzacja

wektor

antyferro-paramagnetyk

magnetyzacja podsieci

wektor

polaryzacja

wektor

ferro-paraelektryk

nadciekłość

amplit. fun. fal. He4

zespolone pole skalarne

amplit. fun. fal. par elektronów zespolone pole skalarne

nadrzewodnictwo

ω+ −ω−

Wszechświat

skalar

ω+ +ω−

ωL −ωR

Życie

skalar

ωL +ωR

Tabela 4.1: Przykłady parametru porządku. ω± oznacza liczbę cząstek i antycząstek, ωL,R

liczbę lewo- i prawoskrętnych aminokwasów.

zero. Znikanie parametru porządku jest związane z podwyższeniem symetrii, a więc pojawieniem sie jakiegoś nowego elementu symetrii. Przykłady parametrów porządku zebrane

zostały w tabeli.

W przypadku przejścia ciecz-gaz parametrem porządku jest różnica gęstości cieczy i

gazu; φ = (ρciecz − ρgaz ). Dla ferromagnetyka natomiast będzie to po prostu spontaniczna

magnetyzacja φ = M .

4.0.2

Dwupunktowa funkcja korelacyjna i promień korelacji

Wiele naszej wiedzy o ciągłych przejściach fazowych pochodzi z eksperymentów, w których

rozpraszane są cząstki (np. fotony, fonony, elektrony czy neurony) w układach znajdujących się w pobliżu stanu krytycznego. Okazuje się, że analiza rozpraszania prowadzi prawie

natychmiast do dwupunktowej funkcji korelacyjnej 1 :

G(ri , rj ) = hφ(ri )φ(rj )i =< φ(ri ) >2 + hδφ(ri )δφ(rj )i

(4.1)

W ogólności wartość parametru porządku zależy od położenia ri . Możemy jednak

zawsze podzielić nasz parametr porządku na dwie części: średnią φ =< φ(ri ) > oraz

fluktuacje δφ(ri ). Wówczas parametr porządku w punkcie ri możemy zapisać jako:

φ(ri ) = φ + δφ(ri ).

(4.2)

Jeżeli policzymy teraz funkcję korelacyjną to otrzymamy:

hφ(ri )φ(rj )i =

D

E

φ2 + φ(δφ(ri ) + δφ(rj )) + δφ(ri )δφ(rj ) + hδφ(ri )δφ(rj )i

= φ2 + hδφ(ri )δφ(rj )i .

(4.3)

Pierwsza część tej funkcji tzn. φ2 opisuje daleki porządek parametru porządku, a drugi

Gzw (ri , rj ) = hδφ(ri )δφ(rj )i - bliski porządek.

Eksperymenty z rozpraszaniem pokazują, że dla T = Tc ogon funkcji korelacyjnej, tzn.

gdy r = |ri − rj | jest duże opisywana jest również prawem potęgowym:

Gzw (r) ∼

1

1

rd−2−η

,

(4.4)

Nie będziemy tego tutaj pokazywać, ale zainteresowani mogą odnaleźć odpowiedni rachunek w książce

J.J. Binney, N. J. Dowrick, A. J. Fisher, M. E. Newman ”Zjawiska krytyczne. Wstęp do

teorii grupy renormalizacji”, PWN 1998.

23

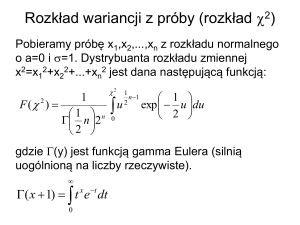

wykładnik krytyczny

zależność

α

c ∼ |T − Tc |−α

β

φ ∼ |T − Tc |−β

γ

κT ∼ |T − Tc |−γ

η

G(r) ∼ r2−d−η

ν

ξ ∼ |T − Tc |−ν

Fe

∼ −0.03

∼ −0.37

∼ 1.33

∼ 0.07

∼ 0.69

Tabela 4.2: Wykładniki krytyczne

gdzie d jest wymiarem układu, a η wykładnikiem krytycznym. Praw potęgowych i wykładników krytycznych mamy zresztą w teorii przejść fazowych znacznie więcej i wkrótce

je poznamy. Dla temperatur dalekich od krytycznej można przyjąć, że asymptotycznie

(tzn. dla dużych r):

!

r

Gzw (r) ∼ exp −

,

(4.5)

ξ

gdzie ξ jest tak zwanym promieniem korelacji. Ogólnie można zapisać:

Gzw (r) ∼

exp − rξ

rd−2−η

.

(4.6)

Promień korelacji ξ jest kluczowym pojęciem współczesnej teorii przejść fazowym i

oznacza odległość, na której fluktuacje parametru porządku są znacząco skorelowane.

Dzięki pojęciu promienia korelacji możemy wprowadzić ogólną, precyzyjną definicję punktu krytycznego:

T → Tc ⇒ ξ → ∞.

(4.7)

4.0.3

Wykładniki krytyczne i klasy uniwersalności

Poznaliśmy już jeden wykładnik krytyczny η, okazuje się, że wiele wielkości termodynamicznych wykazuje rozbieżność przy ciągłym przejściu fazowym.

Jest rzeczą zdumiewającą, że czasem wykładniki krytyczne dla zupełnie odmiennych

przejść są identyczne. Ta cecha, która oznacza, że układy niepodobne do siebie mają takie

same wykładniki krytyczne jest nazywana uniwersalnością. Do tej samej klasy uniwersalności należą układy, które mają te same wykładniki krytyczne.

4.1

Teoria Landaua ciągłych przejść fazowych

Teoria Landaua jest genialna przynajmniej z dwóch powodów 2 i chociażby z tej przyczyny

muszę tu o niej wspomnieć. Po pierwsze jest absolutnie uniwersalna i opisuje wszystkie

bez wyjątku ciągłe przejścia fazowe przy pomocy tego samego formalizmu. Po drugie, co

jest chyba jeszcze bardziej fenomenalne, tłumaczy zjawisko, którego istotą są fluktuacje,

zupełnie te fluktuacje zaniedbując.

Teoria Landaua pierwotnie została zaproponowana do opisu przejść fazowych ciągłych

i oparta jest na dwóch założeniach:

2

czytaj więcej w J. Sznajd ”Introduction to the modern theory of phase transitions” w ”Patterns of

Symmetry Breaking” H. Arodz et al. (eds.) 139-159 (2003) Kluwer Academic Publisher

24

• Dla każdego przejścia ciągłego można znaleźć wielkość, która spełnia rolę miary

uporządkowania układu - parametr porządku.

• Potencjał termodynamiczny można w pobliżu punktu krytycznego rozwinąć w szereg

potęgowy względem parametru porządku.

O parametrze porządku już wspominaliśmy, przypomnijmy tylko, że powinien on mieć

następujące własności:

• W fazie nieuporządkowanej (o wyższej symetrii) φ = 0, a w fazie uporządkowanej

(o niższej symetrii) φ 6= 0.

• Parametr porządku musi dążyć do zera w sposób ciągły gdy T → Tc .

• Poniżej punktu krytycznego parametr porządku nie jest w pełni określony przez

warunki zewnętrzne i przy tych samych warunkach może przybierać dwie lub więcej

różnych wartości.

Potencjał termodynamiczny, np. energię swobodną Gibbsa G = U + xX − T S możemy

przedstawić jako funkcje zmiennych termodynamicznych X, T oraz φ, przy czym φ powinno być wyznaczone z minimalizacji G przy zadanych X, T . Przypomnijmy, że X jest

odpowiednią siłą uogólnioną, np. ciśnieniem XX = X) dla cieczy lub polem (X = h) dla

magnetyka, a x jest odpowiednią współrzędną uogólnioną (np. V lub M odpowiednio).

Ponieważ zakładamy, że zmiana stanu w pobliżu punktu krytycznego odbywa się w sposób ciągły, a więc G przybiera dowolnie małe wartości to możemy G(X, T, φ) rozwinąć w

szereg potęgowy Taylora względem φ.

Myślę, że wszyscy pamiętają jak wygląda rozwinięcie w szereg Taylora. Na wszelki

wypadek przypomnijmy sobie, że każda funkcja f (z) analityczna wewnątrz pewnego koła

o środku a, może być w każdym punkcie tego koła przedstawiona jednoznacznie w postaci

szeregu potęgowego:

f (z) =

∞

X

cn (z − a)n =

n=0

∞

X

f (n) (a)

(z − a)n .

n!

n=0

(4.8)

Wobec tego:

G(X, T, φ) = G0 + αφ + Aφ2 + βφ3 + Bφ4 + . . . ,

(4.9)

Jak już mówiliśmy równaniem stanu może być równanie fundamentalne (reprezentacja

U lub S) lub dowolny potencjał termodynamiczny. Okazuje się, że również warunek równowagi może być sformułowany w każdej z wymienionych reprezentacji. W reprezentacji

Gibbsa i dla X = p (tzn. gdy stan układu zadajemy potencjałem Gibbsa) warunek równowagi brzmi: Wartość równowagowa dowolnego parametru układu będącego w kontakcie

z termostatem o ustalonej temperaturze Tr i ciśnieniu pr minimalizuje potencjał Gibbsa

w stałej temperaturze T = Tr i ciśnieniu p = pr . Warunek ten można wyprowadzić z

warunku minimalizacji energii wewnętrzej U (patrz H.B. Callen ”‘Thermodynamics”’).

Wobec tego, z warunku równowagi w reprezentacji Gibbsa:

α=

∂G

∂φ

!

25

= 0.

X,T

(4.10)

Jeżeli ponadto rozważamy układy symetryczne ze względy na zmianę φ → −φ, to współczynniki również β = 0 i otrzymujemy:

G(X, T, φ) = G0 + Aφ2 + Bφ4 + . . . .

(4.11)

Warunek równowagi stabilnej jest następujący:

∂G

= 2φ(A + 2Bφ2 ) = 0

∂φ

∂ 2G

= 2(A + 6Bφ2 ) > 0.

∂φ2

(4.12)

(4.13)

Z pierwszego warunku otrzymujemy natychmiast dwa rozwiązania:

φ=0

(4.14)

φ = ± −A/2B.

(4.15)

q

q

Wiemy, że φ = 0 odpowiada fazie nieuporządkowanej, a φ = ± −A/2B fazie uporządkowanej, czyli biorąc pod uwagę drugi warunek:

∂ 2G

= 2A > 0 ⇒ A > 0

∂φ2

∂ 2G

= −4A > 0 ⇒ A < 0.

∂φ2

Faza nieuporządkowana:

Faza uporządkowana:

(4.16)

(4.17)

Wynika stąd, że w punkcie przejścia A zmienia znak. Landau założył najprostszą możliwą

postać A spełniającą ten warunek, tzn. A = a(T −Tc ). To założenie natychmiast prowadzi

do wyniku:

q

q

φ = ± −a(T − Tc )/2B = ± −a/2B(T − Tc )1/2 ∼ (T − Tc )β .

(4.18)

Oczywiście jeżeli:

A = a(T − Tc ) =

A > 0 T > Tc

A < 0 T < Tc

A = 0 T = Tc

(FN)

(FU)

(4.19)

to wówczas warunek stabilności w T = Tc :

∂ 2G

= 2(A + 6Bφ2 ) = 12Bφ2 > 0 ⇒ B > 0.

2

∂φ

4.1.1

(4.20)

Ciepło właściwe i entropia dla B > 0

Dla B > 0 teoria Landaua opisuje nam ciągłe przejścia fazowe. Co się dzieje przy takim

przejściu z entropią? Pamiętamy, że przy ciągłych przejściach fazowych nie ma ciepła

przemiany, a co za tym idzie skoku entropii. Czy rzeczywiście teoria Landaua prawidłowo

opisuje tę własność ciągłych przejść fazowych? Obliczmy wartość entropii w obu fazach

- nieuporządkowanej S N oraz uporządkowanej S U . Najpierw musimy obliczyć wartość

potencjału w obu fazach. Korzystając z naszych rozwiązań:

φ=0q

φ = ± −A/2B

A = a(T − Tc )

26

(FN)

(FU)

(4.21)

Otrzymujemy:

GN = G0

(4.22)

a

a

(T − Tc ) = F0 −

(T − Tc )2

2B

2B

(4.23)

2

GU = G0 − a(T − Tc )

Czyli odpowiednie entropie:

∂GN

∂F0

= |F N → φ = 0| = −

= S0

∂T

∂T

∂GU

∂F0 a2

a2

SU = −

=−

− (T − Tc ) = S0 − (T − Tc ).

∂T

∂T

B

B

SN = −

(4.24)

(4.25)

W punkcie przejścia tzn. dla T = Tc mamy:

S N − S U = S0 − S0 + 0 = 0

(4.26)

czyli nie ma skoku entropii zgodnie z obserwacją doświadczalną.

A jak zachowuje się ciepło właściwe?

cN = T

∂S N

a2

∂S U

= c0 cU = T

= c0 − Tc

∂T

∂T

B

(4.27)

czyli:

a2

6= 0.

(4.28)

B

Czyli w przypadku ciągłych przejść fazowych mamy do czynienia ze skokiem ciepła

właściwego przy jednoczesnym braku skoku entropii. Przypomnijmy tu definicję indeksu

krytycznego związanego z zachowaniem się w pobliżu punktu krytycznego ciepła właściwego (patrz tabela 4.2): c ∼ |T − Tc |−α . Wobec tego otrzymujemy natychmiast, że w teorii

Landaua α = 0 (bo w cieple właściwym nie ma zależności od temperatury w żadnej z

faz).

W ten sposób wyznaczyliśmy w teorii Landaua dwa indeksy krytyczne: α = 0, β = 1/2.

Z teorii tej można wyznaczyć dalsze indeksy δ = 3 i γ = 1 odpowiedzialne za zachowanie

się podatności magnetycznej (w zależności od pola magnetycznego i temperatury). Zainteresowanych odsyłam do podręcznika J. Klamuta i innych ”‘Wstęp do fizyki przejść

fazowych”’.

δc = cN − cU = Tc

4.1.2

Uogólnienie: B ujemne

Ten rozdział nie jest obowiązkowy dla studentów ekonofizyki. Jedyne co powinni zapamiętać to fakt, że dla B < 0 istnieje zakres temperatur, dla których mogą istnieć dwie

fazy i wobec tego dla B < 0 teoria Landaua opisuje przejścia nieciągłe. Zainteresowanych

(i fizyków teoretyków) zapraszam do dalszej lektury rozdziału i samodzielnejo wykonania

kilku rachunków.

Widzieliśmy, że warunek równowagi stabilnej w punkcie T = Tc nałożył warunek

na współczynnik B > 0. Co jednak stałoby się gdyby B < 0. Wówczas w rozwinięciu

potencjału termodynamicznego uwzględnia się wyższe potęgi:

G(X, T, φ) = F0 + Aφ2 + Bφ4 + Cφ6 .

27

(4.29)

Teraz już nie można założyć, że przejście występuje dla A = 0. Przyjmijmy jednak przez

analogię z poprzednim przypadkiem, że A = a(T − Θ), chociaż oczywiście Θ nie jest teraz

temperaturą przejścia (nie wiemy w ogóle na razie czym jest). Warunkiem koniecznym

dla istnienia minimum potencjału (a co za tym idzie równowagi) jest oczywiście:

∂G

= 2φ(A + 2Bφ2 + 3Cφ4 ) = 0.

∂φ

(4.30)

Podobnie jak poprzednio możliwe są dwa rozwiązania φ = 0 i φ 6= 0. Napiszmy dodatkowo

warunek równości potencjałów:

GN = 0

GU = F0 + Aφ2 + Bφ4 + Cφ6

GN = GU ⇒ φ2 (A + Bφ2 + Cφ4 ) = 0

(4.31)

Mamy więc układ równań, który pozwala wyznaczyć φ w fazie uporządkowanej oraz temperaturę równych energii stanów N i U (ćwiczenia).

A + 2Bφ2 + 3Cφ4 = 0

A + Bφ2 + Cφ4 = 0

(4.32)

Z tego otrzymujemy w punkcie równych energii φ2 = −2A/B oraz A = B 2 /4C. Podstawiając A = a(T − Θ) dostajemy, że temperatura, w której energie obu stanów są równe

to:

B2

T0 = Θ +

.

(4.33)

4aC

To wyrażenie ma sens przy założeniu, że współczynniki B i C są w szerokim zakresie

niezależne od temperatury, co nie zawsze musi być prawdziwe. Na razie jednak załóżmy,

że z pewnym przybliżeniem można tak przyjąć. Wówczas w punkcie równych energii:

A

B2

B

= −2

=−

(4.34)

B

4CB

2C

Oczywiście warunek konieczny minimum potencjału pozwala wyznaczyć φ również poza

punktem równych energii (przeliczyć to na ćwiczeniach):

√

−B ± B 2 − 3AC

2

φ =

.

(4.35)

3C

Jeżeli C > 0 to wówczas jedynym fizycznym rozwiązaniem jest:

√

−B + B 2 − 3AC

2

φ =

.

(4.36)

3C

φ2 = −2

Ostatecznie okaże się, że mamy zakres temperatur A ∈ [0, B 2 /3C], dla których mogą istnieć dwie fazy. W punkcie A = 0 φ2 = −2B/3C, natomiast w punkcie równych

energii A = B 2 /3C, φ2 = −B/2C. W punkcie powyżej, którego faza U nie może być

już realizowana (wartość wyrażenia pod pierwiastkiem zmienia znak - nie ma już rozwiązań rzeczywistych): A = B 2 /3C, φ2 = −B/3C. Dla A ∈ [0, B 2 /3C] mogą istnieć dwie

fazy, przy czym dla A < B 2 /4C warunek minimum absolutnego spełnia faza U , a dla

A > B 2 /4C faza N . Przy przejściu w punkcie równych energii tzn. dla A = B 2 /4C skok

parametru porządku wynosi φ2 = −B/2C. Wobec tego dla B < 0 teoria Landaua opisuje

przejścia nieciągłe.

28

4.1.3

Gdzie są fluktuacje?

Jak już wielokrotnie podkreślałam, fluktuacje odgrywają niezwykle istotną, można powiedzieć fundamentalną rolę w przejściach fazowych. Nie tylko determinują zachowanie się

wielkości w pobliżu przejścia, ale przede wszystkim samo przejście. A jednak, przedstawiona w tym rozdziale teoria Landaua całkowicie zaniedbuje fluktuacje parametru porządku.

Fluktuacje te jednak można wprowadzić zapisując parametr porządku w znanej już nam

formie:

φ(ri ) = φ + δφ(ri ),

(4.37)

gdzie δφ(ri ) opisuje fluktuacje parametru porządku w punkcie ri . Założenie, które zrobił Landau polegało na przyjęciu φ(ri ) = φ, czyli δφ(r) = 0. Rozszerzeniem jego teorii

jest tzw. teoria Landaua-Ginsburga, która uwzględnia występowanie fluktuacji (najniższy

rząd) w układach izotropowych. Teoria ta

Jak wiemy w przypadku fluktuacji parametru porządku funkcję korelacyjną możemy

zapisać jako:

G(ri , rj ) = hφ(ri )φ(rj )i =< φ(ri ) >2 + hδφ(ri )δφ(rj )i

(4.38)

Jeżeli dopuścimy zależność parametru porządku od położenia to w rozwinięciu Landaua, obok wyrazów proporcjonalnych do φ(r) musimy uwzględnić również pochodne

parametru porządku względem zmiennych przestrzennych. Dla układu izotropowego najniższego rzędu wyraz tego rodzaju ma postać c[∇φ(r)]2 . Wykorzystując dla tak zmodyfikowanego rozwinięcia warunek na minimum funkcjonału G otrzymamy wówczas wspominaną już wcześniej postać funkcji korelacyjnej (postać Orsteina-Zernike):

Gzw (r) ∼

exp − rξ

rd−2−η

.

(4.39)

W 2003 roku Nagrodę Nobla z fizyki dostali: Witalij Ginzburg (Rosja) i Aleksiej A.

Abrikosow (Rosja, a ostatnio USA) za ”pionierski wkład do teorii nadprzewodnictwa”

oraz Anthony J. Leggett (Wielka Brytania i ostatnio USA) za ”pionierski wkład do teorii

nadciekłości”.

Fragment wykładu Noblowskiego wygłoszonego przez Alexeia

A. Abrikosova 8 grudnia 2003:

In 1950, Vitalii Ginzburg and Lev Landau published their famous paper on

the theory of superconductivity. The approach was based on the general theory

of the second order phase transitions proposed by Landau in 1937. There

Landau introduced the main variable, the so called “order parameter” which

was finite below the transition and zero above it. Different phase transitions

had different order parameters, and whereas it was evident for, e. g., the

ferromagnetic transition, namely, the spontaneous magnetization, it was far

less evident for the superconducting transition. Ginzburg and Landau had a

stroke of genius, when they chose, as the order parameter some sort of wave

function. (...)

Fragment artykułu ”‘Nobel z fizyki: za nadprzewodnictwo i

nadciekłość”’, Gazeta Wyborcza 07.10.2003

Nagrodą Nobla nagrodzono fizyków, których teorie pomogły okiełznać dwa

niezwykłe zjawiska przyrody: nadprzewodnictwo (w materiałach, w których

29

prąd elektryczny płynie bez żadnych strat energii) oraz nadciekłość (w cieczy,

która nie ma lepkości, a więc każdy wir trwa w niej wiecznie).

Jak płynie wieczny prąd

Zacznijmy od elektryczności, bo to ona stała u podstaw rewolucji technicznej XX wieku. W powietrzu, w wodzie i na ziemi siła tarcia hamuje wszystko,

co się porusza. Podobnie prąd elektryczny, czyli strumień elektronów, napotyka opór w metalach, nawet dobrych przewodnikach. Opór sprawia, że energia

prądu się rozprasza, a materiał, przez który płynie prąd, rozgrzewa się. Dobrze

o tym wie każdy, kto trzymał w ręce rozgrzane prądem żelazko. Dzięki temu

również świeci rozżarzone do białości włókno żarówki.

Niespodziewanie na początku XX wieku holenderski fizyk Heike KamerlinghOnnes odkrył, że istnieją materiały, w których opór elektryczny całkowicie

znika. W odróżnieniu od zwykłych przewodników (np. miedzi, aluminium)

nazwano je nadprzewodnikami, a samo zadziwiające zjawisko - nadprzewodnictwem. W pętli wykonanej z nadprzewodnika prąd będzie krążył wiecznie,

bo jego energia nie ulegnie rozproszeniu.

Praktyczne równania

Przez niemal pół wieku bezskutecznie starano się wyjaśnić to zjawisko.

Dopiero na początku lat 50. rosyjscy uczeni Lew Landau i Witalij Ginzburg

przedstawili równania, które świetnie radziły sobie z opisem własności nadprzewodników. Wprawdzie nie tłumaczyły one, co takiego dzieje się z prądem w mikroskali - na poziomie elektronów (to dopiero później było zasługą

tzw. teorii BCS nagrodzonej Noblem), ale teoria okazała się nieoceniona dla

praktycznego wykorzystania nowych materiałów w technice i badaniach naukowych.

Niecałą dekadę później Aleksiej Abrikosow wykorzystał ich metodę do opisu tzw. nadprzewodników II rodzaju, których ”cudowne” własności nie znikają

nawet w silnych polach magnetycznych. Dzięki temu nadprzewodniki zaczęły

robić wielką karierę w badaniach naukowych. Konstruuje się z nich silne elektromagnesy, w które są wyposażone najlepsze laboratoria - np. akceleratory i

detektory cząstek elementarnych. Korzysta się z nich w medycynie - w szpitalnych tomografach, skanerach rezonansu jądrowego i dosłownie wszędzie tam,

gdzie potrzeba silnego pola magnetycznego.

Cieplej, coraz cieplej

Do niedawna nadprzewodniki musiały być schładzane ciekłym helem, który skrapla się w temperaturze minus 269 st. C. W połowie lat 80. okazało się,

że nadprzewodnictwo nie jest ograniczone wyłącznie do temperatur zbliżonych

do zera bezwzględnego. Odkryto materiały ceramiczne, które nadprzewodzą

w wyższych temperaturach. Dziś trwa pogoń za takimi nadprzewodnikami,

w których prąd będzie płynąć wiecznie w temperaturze takiej, jaka panuje na

powierzchni Ziemi. Dlaczego? Można byłoby z nich zbudować linie przesyłowe,

które dostarczą prąd z elektrowni do domów i fabryk bez kosztownych strat

(dziś po drodze traci się średnio 30 proc. energii). Mogłyby powstać elektromagnesy, które nie będą wymagały nieustannego i kosztownego chłodzenia,

a z ich pomocą - rozpowszechnić pociągi na poduszkach magnetycznych i tanie szpitalne tomografy. Dalszej miniaturyzacji uległaby też elektronika (dziś

procesory nie mogą mieć zbyt małych rozmiarów, bo przegrzewają się).

30

Stare teorie, których podstawy ułożyli m.in. Ginzburg i Abrikosow, są

wciąż używane, również do opisu nadprzewodników nowego typu i mogą przyczynić się do prawdziwej rewolucji technologicznej. I pewnie dlatego spotkały

się z uznaniem Komitetu Noblowskiego. Można też podejrzewać, że nadrabia

on opóźnienia w nagradzaniu często kiedyś niedocenianych osiągnięć naukowców, którzy pracowali w b. ZSRR.

Jak wiecznie wiruje ciekły hel

Jury noblowskie jednocześnie nagrodziło Anthony’ego J. Leggetta za teoretyczny opis zachowania się ciekłego helu-3 w niskiej temperaturze. Ale co ma

wspólnego ciekły hel z wiecznie płynącym prądem? Wbrew pozorom wiele.

Gdy hel zostanie schłodzony prawie do zera bezwzględnego, z cieczy podobnej do tych, jakie znamy na co dzień, zmienia się w ciecz kwantową. Traci

lepkość, co oznacza, że gdy np. wiruje, nie traci energii na wewnętrzne tarcie

i może poruszać się bez końca. Jego cieniutka warstewka przykleja się i ślizga

po powierzchni, może np. ”wypełznąć” po ściankach z naczynia. Deszcz z nadciekłego helu swobodnie przeciekałby przez parasole, bo przeciska się on nawet

przez najmniejsze dziurki rzędu zaledwie dziesiątek mikrometrów. Rosyjski fizyk Piotr Kapica, który po raz pierwszy zaobserwował to dziwne zjawisko,

nazwał je nadciekłością. Okazuje się przy tym, że atomy nadciekłego helu-3

zachowują się podobnie jak elektrony prądu, które bez straty energii płyną w

nadprzewodniku.

31

32

Rozdział 5

Model Perkolacji w Ekonomii

5.1

Model Conta-Bouchaud

Model został zaproponowany przez dwóch fizyków, a obecnie finansistów, Rama Conta

i Jean-Philippa Bouchaud (Rama Cont i Jean-Philipp Bopuchaud, HERD BEHAVIOR

AND AGGREGATE FLUCTUATIONS IN FINANCIAL MARKETS, Macroeconomic

Dynamics, 4, 170–196 (2000)). Rozważmy układ składający się z N agentów, oznakowanych przez liczby naturalne 1 ¬ i ¬ N , handlujących w pewnym dobrem, którego cenę

w chwili t oznaczymy przez x(t). W każdym przedziale czasowym (każdej chwili czasu)

agent może albo kupować albo sprzedawać albo w ogóle nie handlować. Dla uproszczenia

przyjmiemy, że w każdym przedziale czasowym agent może handlować tylko pojedynczą

jednostką kapitału. Wobec tego stan każdego agenta i reprezentowany jest przez zmienną

losową φi = 0, −1, 1, przy czym:

-1 bear

0

φi =

1 bull

chce sprzedać

nie handluje

chce kupić

(5.1)

Skumulowany nadmiar popytu nad podażą w chwili t jest wobec tego:

D(t) =

N

X

φi (t).

(5.2)

i=1

Zakładamy, że początkowy rozkład roszczeń agentów jest symetryczny, tzn.

P (φi = +1) = P (φi = −1) = a0.5cmP (φi = 0) = 1 − 2a.

(5.3)

Wobec tego średnio D = 0 czyli układ fluktuuje wokół stanu równowagi.

Pojawia się teraz pytanie jak zdefiniować cenę lub jej zmianę (tzw. zwrot). Autorzy

założyli, że zwrot jest proporcjonalny do D, czyli:

∆x = x(t + 1) − x(t) =

N

1X

φi (t),

λ i=1

(5.4)

gdzie λ jest parametrem mierzącym wrażliwość ceny na fluktuacje podaży. Oczywiście

związek między nadwyżką podaży a zwrotem ceny nie musi być liniowy i w ogólności

33

kształtowanie się ceny to bardzo złożony proces. Jednak w modelu CB uproszczenia przyjęto zależność liniową

Zacznijmy od najprostszego przypadku, tzn. φi są niezależnymi zmiennymi losowymi

o tym samym rozkładzie (independent identically distributed random variables). W takim

przypadku łączny rozkład agentów jest po prostu rozkładem Gaussa zgodnie z centralnym twierdzeniem granicznym. Jednakże agenci w prawdziwym rynku nie są niezależni.

Musimy jakoś wprowadzić miedzy nimi komunikację. Jedną z możliwości jest założenie

istnienia pewnej struktury komunikacji między agentami, ale pytanie jaka to powinna być

struktura? Wyniki prawdopodobnie silnie zależałyby od wybranej przez nas struktury.

Innym pomysłem jest założenie, że struktura komunikacji na rynku jest stochastyczna.

Jedną z możliwości w takim przypadku są losowe spotkania agentów i że do transakcji

dochodzi wówczas gdy agent który chce sprzedać spotka takiego, który chce kupić. Taka

procedura nosi w literaturze nazwę random matching (RM). Innym pomysłem na wygenerowanie losowej struktury jest rozważenie klastrów jakie tworzą agenci poprzez proces RM

i założenie, że handel nie odbywa się wewnątrz grup, ale wszyscy agenci należący do tego

samego klastra dostosowują się do pewnej wspólnej strategii. Różne grupy mogą ze sobą

nawzajem handlować. Takie klastry mogą reprezentować grupy inwestorów. Taki właśnie

pomysł pojawił się w pracy Conta-Bouchaud. Teraz przejdźmy do bardziej szczegółowego

opisu modelu.

Załóżmy, że wszyscy agenci należący do danego klastra mają takie same żądanie φα ,

gdzie α = 1...k indeksuje klastry. Wobec tego:

∆x =

1X

kWα φα (t),

λ α=1

(5.5)

gdzie Wα jest wielkością klastra, a φalpha (wspólną) decyzją agenta w danym klastrze α.

Klaster tworzą agenci, którzy są połączeni. Niech pij będzie prawdopodobieństwem, że

agenci i i j są połączeni. Dla uproszczenia załóżmy, że wszystkie połączenia są równo

prawdopodobne, tzn. pij = p. Oczywiście (N − 1)p jest średnią liczbą połączeń agentów

z jednym wybranym agentem. Oczywiście nas interesuje, jak zwykle w teorii przejść fazowych, granica N → ∞. Wobec tego p powinno być tak wybrane, żeby (N − 1)p miało

lim

skończoną granicę N → ∞ (N − 1)p = c. Naturalnym wyborem jest pij = p = c/N ,

gdzie c mierzy stopień sklastrowania agentów. Taka struktura znana jest jako graf losowy

(random graph). Można pokazać, że jeżeli c = 1 wówczas rozkład wielkości klastrów dany

jest prawem potęgowym:

A

(5.6)

P (W ) ∼ 5/2 ,

W

podczas gdy dla c < 1, ale takich, że (0 < 1 − c << 1) rozkład wielkości klastrów jest

obcięty przez wykładniczy ogon tzn.

A

(c − 1)W

P (W ) ∼ 5/2 exp −

W

W0

!

.

(5.7)

Oznacza to, że dla c = 1 rozkład ma nieskończoną wariancję, podczas gdy dla c < 1

wariancja staje się skończona.

34

5.2

Samoorganizujący się model perkolacji fluktuacji

na rynku finansowym

W roku 1999 Dietrich Stauffer i Didier Sornette zaproponowali modyfikację powyższego

modelu. Model C-B zakładał, że inwestorzy są połączeni z pewnym prawdopodobieństwem

i w ten sposób tworzą klastry. Następnie utworzone losowo klastry (tzn. wszyscy inwestorzy w danym klastrze) podejmują decyzję kupić z prawdopodobieństwem a czy sprzedać

z a, czy też nie handlować z prawdoodobieństwem 1 − 2a. To jest w gruncie rzeczy idea

oparta na modelu perkolacji. W modelu C-B założono dodatkowo, że zwrot ceny zależy

liniowo od różnicy między popytem a podażą. Dla małych a zwykle handluje najwyżej

jeden klaster i w konsekwencji rozkład zwrotów P (R) skaluje się zgodnie z dobrze znanym

rozkładem wielkości klastrów w teorii perkolacji. Dla dużej aktywności a i bez nieskończonego klastra (p < pc ), zwroty są sumą wielu klastrów i wówczas zgodnie z centralnym

twierdzeniem granicznym rozkład jest normalny (Gaussowski). Dla niskiej aktywności a

w progu perkolacji p = pc , kiedy pojawia się nieskończony klaster obserwujemy prawo potęgowe. Dla p 6= pc liczba klastrów zanika wykładniczo (p < pc ) lub stretched exponential

(p > pc ).

Czasowe korelacje zmienności można zmierzyć pozwalając inwestorom powoli dyfundować do najbliższego sąsiedztwa. Ta dyfuzja pozwala na zmianę w czasie grup inwestycyjnych. Przypomnijmy, że zmienność jest zdefiniowana jako wartość bezwzględna ze zwrotu

i jej korelacje czasowe powinny być dalekozasięgowe w przeciwieństwie do korelacji czasowych samych zwrotów. Zmienność zachowuje się podobnie jak średnia wielkość klastra i

czasowe korelacje spowodowane są powolną dyfuzją z typowym zanikiem wolniejszym niż

wykładniczy. Wobec tego model C-B w progu perkolacji zgadza się jakościowo (ale nie

ilościowo) z trzema znanymi własnościami rynku (stylized facts):

1. średni zwrot R = 0, pod warunkiem, że nie ma inflacji i odrzucimy inne stale trendy,

2. ogon rozkładu zwrotów P (R) zanika zgodnie z prawem potęgowym

3. Czasowa korelacja zmienności V (t) =< R(t)2 >1/2 zanika powoli do zera.

Pojawia się pytanie:

1. Dlaczego rynek miałby coś wiedzieć w progu perkolacji i pracować właśnie w tym

progu?

Żeby poradzić sobie z tym problemem zaproponujemy teraz pewną modyfikację C-B.

Dlaczego p = pc ? Nowy pomysł polega na tym, że p w ogóle nie musi być stałe. Nie ma

powodu, żeby tak było. Jak zmieniać p? Najprościej wybierać nowe losowe p w każdym

kroku czasowym. W konsekwencji rozkład zwrotów będzie uśrednieniem po

35

36

Rozdział 6

Modele

Ten rozdział jest w trakcie uzupełniania - zachęcam do korzystania z literatury, notatek

z wykładu oraz prezentacji PPT dostępnej na panoramixie.

37

38

Rozdział 7

Co wiemy na pewno? - czyli ścisłe

wyniki w teorii przejść fazowych

Ten rozdział jest w trakcie uzupełniania - zachęcam do korzystania z literatury i notatek

z wykładu.

7.0.1

Jednowymiarowy model Isinga z polem i dwuwymiarowy

bez pola.

7.0.2

Model Perkolacji typu bond na sieci kwadratowej.

7.0.3

Twierdzenie van Hove’a

Żaden układ o skończonym zasięgu oddziaływań nie może wykazywać dalekiego porządku

w temperaturach wyższych od zera.

7.0.4

Twierdzenie Mermina-Wagnera

Twierdzenie Mermina-Wagnera mówi, że w jedno- i dwuwymiarowych sieciowych układach spinowych nie istnieje uporządkowanie dalekiego zasięgu w dodatnich temperaturach,

jeśli układ posiada ciągłą grupę symetrii (jak np. model Heisenberga lub XY). Twierdzenie to, mimo iż jest znane od 40 lat, ciągle jest jednym z ważniejszych faktów w dziedzinie

przejść fazowych. Zainteresowanych odsyłam do pracy źródłowej, która ukazała się w roku

1966 w niezwykle prestiżowym czasopismie fizycznym Physical Review Letters (PRL): N.

D. Mermin and H. Wagner ’Absence of Ferromagnetism or Antiferromagnetism in one- or

two-dimensional isotropic Heisenberg models’, PRL 17, 1133 (1966)

39

40

Rozdział 8

Metoda Średniego Pola - Mean Field

Approximation (MFA)

Teoretyczny opis zjawiska fizycznego składa się zazwyczaj z trzech etapów:

1. Skonstruowania lub wyboru spośród już istniejących odpowiedniego modelu.

2. Rozwiązania modelu, a więc wyznaczenie wielkości mierzalnych eksperymentalnie.

3. Interpretacji otrzymanych wyników.

Podstawą etapów pierwszego i trzeciego jest coś nie do końca zdefiniowanego, a nazywanego zwykle intuicją fizyczną. Natomiast etapu drugiego umiejętność sensownego ”psucia

matematyki”, tzn. umiejętność wyboru i zastosowania właściwego przybliżenia, które będzie na tyle proste, że da się efektywnie zastosować, a jednocześnie na tyle wiarygodne, że

nie będzie zachodziła obawa, iż otrzymane wyniki bardziej zależą od użytego przybliżenia

niż od rozważanego modelu. Najprostszą możliwie teorią, a jednocześnie bardzo ważną

jest teoria pola średniego MFA. W wielu skomplikowanych problemach fizyki statystycznej jest to praktycznie jedyne dostępne narzędzie badawcze. Chociaż przybliżenie MFA