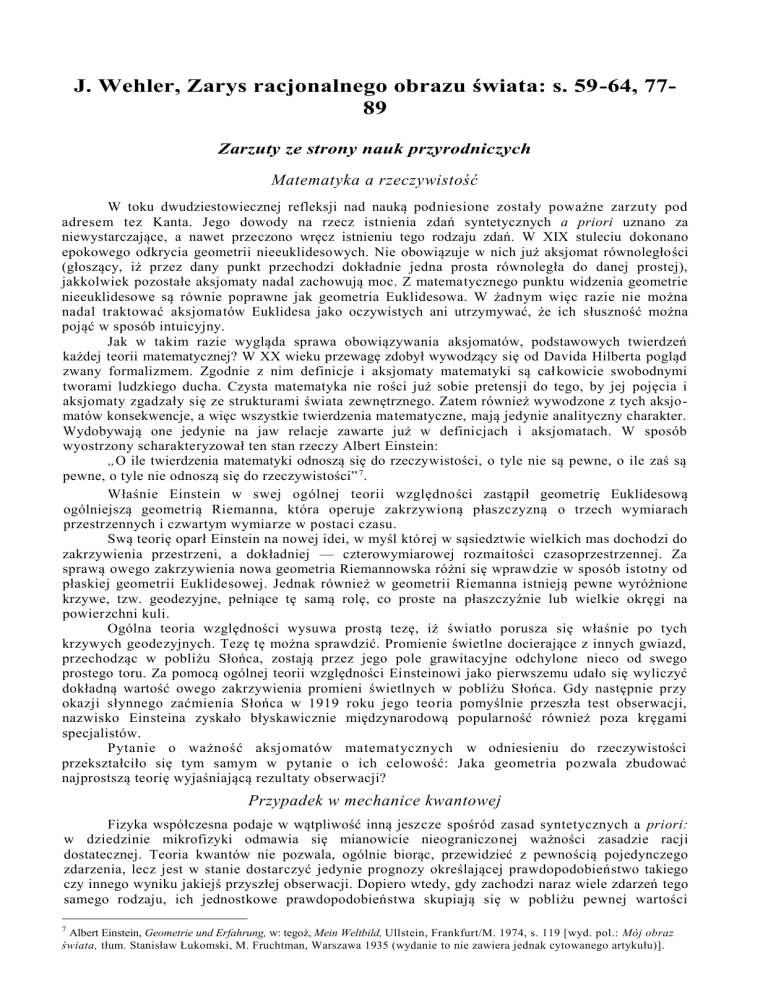

J. Wehler, Zarys racjonalnego obrazu świata: s. 59-64, 7789

Zarzuty ze strony nauk przyrodniczych

Matematyka a rzeczywistość

W toku dwudziestowiecznej refleksji nad nauką podniesione zostały poważne zarzuty pod

adresem tez Kanta. Jego dowody na rzecz istnienia zdań syntetycznych a priori uznano za

niewystarczające, a nawet przeczono wręcz istnieniu tego rodzaju zdań. W XIX stuleciu dokonano

epokowego odkrycia geometrii nieeuklidesowych. Nie obowiązuje w nich już aksjomat równoległości

(głoszący, iż przez dany punkt przechodzi dokładnie jedna prosta równoległa do danej prostej),

jakkolwiek pozostałe aksjomaty nadal zachowują moc. Z matematycznego punktu widzenia geometrie

nieeuklidesowe są równie poprawne jak geometria Euklidesowa. W żadnym więc razie nie można

nadal traktować aksjomatów Euklidesa jako oczywistych ani utrzymywać, że ich słuszność można

pojąć w sposób intuicyjny.

Jak w takim razie wygląda sprawa obowiązywania aksjomatów, podstawowych twierdzeń

każdej teorii matematycznej? W XX wieku przewagę zdobył wywodzący się od Davida Hilberta pogląd

zwany formalizmem. Zgodnie z nim definicje i aksjomaty matematyki są cał kowicie swobodnymi

tworami ludzkiego ducha. Czysta matematyka nie rości już sobie pretensji do tego, by jej pojęcia i

aksjomaty zgadzały się ze strukturami świata zewnętrznego. Zatem również wywodzone z tych aksjomatów konsekwencje, a więc wszystkie twierdzenia matematyczne, mają jedynie analityczny charakter.

Wydobywają one jedynie na jaw relacje zawarte już w definicjach i aksjomatach. W sposób

wyostrzony scharakteryzował ten stan rzeczy Albert Einstein:

„O ile twierdzenia matematyki odnoszą się do rzeczywistości, o tyle nie są pewne, o ile zaś są

pewne, o tyle nie odnoszą się do rzeczywistości” 7.

Właśnie Einstein w swej ogólnej teorii względności zastąpił geometrię Euklidesową

ogólniejszą geometrią Riemanna, która operuje zakrzywioną płaszczyzną o trzech wymiarach

przestrzennych i czwartym wymiarze w postaci czasu.

Swą teorię oparł Einstein na nowej idei, w myśl której w sąsiedztwie wielkich mas dochodzi do

zakrzywienia przestrzeni, a dokładniej — czterowymiarowej rozmaitości czasoprzestrzennej. Za

sprawą owego zakrzywienia nowa geometria Riemannowska różni się wprawdzie w sposób istotny od

płaskiej geometrii Euklidesowej. Jednak również w geometrii Riemanna istnieją pewne wyróżnione

krzywe, tzw. geodezyjne, pełniące tę samą rolę, co proste na płaszczyźnie lub wielkie okręgi na

powierzchni kuli.

Ogólna teoria względności wysuwa prostą tezę, iż światło porusza się właśnie po tych

krzywych geodezyjnych. Tezę tę można sprawdzić. Promienie świetlne docierające z innych gwiazd,

przechodząc w pobliżu Słońca, zostają przez jego pole grawitacyjne odchylone nieco od swego

prostego toru. Za pomocą ogólnej teorii względności Einsteinowi jako pierwszemu udało się wyliczyć

dokładną wartość owego zakrzywienia promieni świetlnych w pobliżu Słońca. Gdy następnie przy

okazji słynnego zaćmienia Słońca w 1919 roku jego teoria pomyślnie przeszła test obserwacji,

nazwisko Einsteina zyskało błyskawicznie międzynarodową popularność również poza kręgami

specjalistów.

Pytanie o ważność aksjomatów matematycznych w odniesieniu do rzeczywistości

przekształciło się tym samym w pytanie o ich celowość: Jaka geometria po zwala zbudować

najprostszą teorię wyjaśniającą rezultaty obserwacji?

Przypadek w mechanice kwantowej

Fizyka współczesna podaje w wątpliwość inną jeszcze spośród zasad syntetycznych a priori:

w dziedzinie mikrofizyki odmawia się mianowicie nieograniczonej ważności zasadzie racji

dostatecznej. Teoria kwantów nie pozwala, ogólnie biorąc, przewidzieć z pewnością pojedynczego

zdarzenia, lecz jest w stanie dostarczyć jedynie prognozy określającej prawdopodobieństwo takiego

czy innego wyniku jakiejś przyszłej obserwacji. Dopiero wtedy, gdy zachodzi naraz wiele zdarzeń tego

samego rodzaju, ich jednostkowe prawdopodobieństwa skupiają się w pobliżu pewnej wartości

Albert Einstein, Geometrie und Erfahrung, w: tegoż, Mein Weltbild, Ullstein, Frankfurt/M. 1974, s. 119 [wyd. pol.: Mój obraz

świata, tłum. Stanisław Łukomski, M. Fruchtman, Warszawa 1935 (wydanie to nie zawiera jednak cytowanego artykułu)].

7

średniej. Wówczas wartość ta opisuje całe zjawisko z dużą dokładnością, do jakiej przyzwyczajeni

jesteśmy w fizyce klasycznej.

Spróbujmy objaśnić to na przykładzie połowicznego rozpadu pierwiastków radioaktywnych.

Pierwiastek uran 238 ma czas połowicznego rozpadu równy 4,5 miliarda lat. Po upływie tego czasu

spośród początkowych 100 000 atomów uranu 238 rozpadowi ulega połowa, po kolejnych 4,5

miliarda lat — jedna czwarta, a po 17,5 miliarda lat — w sumie siedem ósmych, czyli 87 500

atomów. Jest to pewne twierdzenie teorii kwantów. Jednakże na pytanie, kiedy rozpadnie się dany

atom uranu 238, odpowiada ona: z prawdopodobieństwem równym 0,5 nastąpi to w ciągu następnych

4,5 miliarda lat. Teoria kwantów nie zna przyczyny, dla której jeden atom rozpadnie się w ciągu

najbliższej sekundy, inny zaś dopiero za miliardy lat.

Może się to zrazu wydać podobne do kalkulacji, na jakich opierają się firmy zajmujące się

ubezpieczeniem na życie, które przecież bardzo dokładnie znają oczekiwany średni czas życia

wszystkich osób ubezpieczonych, a zarazem nie wiedzą nic o długości życia danej jednostki. Jednak

w obu przypadkach powody owej nieokreśloności pojedynczego zdarzenia są całkowicie różne. W

przypadku atomów pierwiastków radioaktywnych nie ma mowy o procesie starzenia się, a wszystkie atomy są

nierozróżnialne. Niektórzy fizycy uważają, że ta nieznajomość terminu rozpadu pojedynczego atomu stanowi

brak teorii kwantowej, inni zaś — zwolennicy tzw. interpretacji kopenhaskiej — sądzą, iż jest ona wynikiem

nieokreśloności tkwiącej w naturze jąder atomowych, której przeto nie będzie w stanie usunąć również żadna

przyszła teoria. Charakteryzując procesy zachodzące w jądrze atomu radioaktywnego pierwiastka w wyniku

wyemitowania cząstki alfa Werner Heisenberg powiada:

„Teoria kwantów jest w stanie podać prawdopodobieństwo, z jakim na daną jednostkę czasu

cząstka alfa opuszcza jądro; nie potrafi jednak przewidzieć dokładnie momentu, w jakim to nastąpi: jest on

zasadniczo nieokreślony. Nie należy też zakładać, że kiedyś w przyszłości zostaną odkryte jakieś nowe

prawidłowości, które pozwolą nam dokładnie wyznaczyć ten moment”8.

W myśl tej radykalnej interpretacji mechaniki kwantowej zasada racji dostatecznej traci swą ważność.

Jednak nie wszyscy fizycy przyjęli taką interpretację. Wielu z nich uważa mechanikę kwantową za teorię

niepełną i oczekuje, że na głębszym poziomie znów stanie się możliwy opis deterministyczny. Spór ten toczy

się nieustannie od czasu ogłoszenia wykładni kopenhaskiej, a ostatnio wkroczył w stadium umożliwiające

pierwsze próby eksperymentalne.

Racjonalizm krytyczny

Jeżeli chodzi o problem uzasadnienia oraz wiedzy pewnej, opisane wyżej rezultaty matematyki i

fizyki dwudziestowiecznej prowadzą do następującej, destruktywnej konsekwencji: Ważność

twierdzeń fundamentalnych bynajmniej nie jest pewna; również naczelne zasady nauk można z

powodzeniem podawać w wątpliwość, niewykluczone zatem, że są one fałszywe. Człowiek nie

dysponuje żadną specjalną zdolnością poznawczą dostarczającą wiedzy pewnej. Wszelkie poznanie

podlega ciągłemu sprawdzaniu i krytyce. Dlatego też ogólne twierdzenia o świecie zewnętrznym są,

ściśle biorąc, jedynie hipotezami roboczymi.

Trylemat Münchhausena

Cytat z Ksenofanesa mówiący o niepewności na szej wiedzy jest dzisiaj równie aktualny

jak 2500 lat temu, w czasach greckiego oświecenia. Filozof Hans Albert charakteryzuje owe

daremne poszukiwania wiedzy pewnej za pomocą figury zwanej trylematem Münchhausena:

Wszelka próba ostatecznego uzasadnienia naszej wiedzy pociąga za sobą albo 1)

nieskończony regres, albo 2) błędne koło, albo 3} dogmatyczne przerwanie poszukiwań.

„Wiedzę” zdefiniowaliśmy wyżej jako „słuszne, uzasadnione przekonanie”. Przez ostateczne

uzasadnienie należy rozumieć takie uzasadnienie, którego nie sposób już rozsądnie kwestionować.

Uzasadnienie ostateczne kładłoby zatem kres łańcuchowi uzasadnień.

Gdy wobec każdego uzasadnienia stale pada ponowne pytanie „dlaczego?”, prowadzi to do

nieskończonego regresu. Z błędnym kołem mamy do czynienia wtedy, gdy twierdzenie B uzasadnia

się za pomocą twierdzenia A, a gdy z kolei pada żądanie uzasadnie nia A, przytacza się B. Nie zawsze

jednak jest to równie jawne jak w owym starym dowcipie: „Od czego pochodzi jajko? Od kury. A od

czego pochodzi kura? Od jajka”.

8

Werner Heisenberg, Atomforschung und Kausalgesetz, w: tegoż, Schritte über Grenzen, Piper, München 1971, s. 134.

Zdaniem Alberta nie tylko tezy Kościoła, a więc dogmaty w węższym sensie, należą do trzeciego

odgałęzienia trylematu Münchhausena, jakim jest przerwanie zabiegów uzasadniających. Pod tę kategorię

podpada również wszelkie uzasadnianie poprzez intuicję lub oczywistość. Skrajnym przykładem takiego

zawieszenia zasady dostatecznego uzasadnienia jest kosmologiczny dowód istnienia Boga, którym zajmiemy

się dokładniej w rozdziale 15. W dowodzie tym łańcuch przyczyn i skutków zostaje przecięty poprzez

przyjęcie pierwszej przyczyny, która — jako causa sui — wytwarza samą siebie. Dogmatyzację stanowi

również powoływanie się na sumienie jako instancję ostateczną. Znamieniem dogmatyzacji jest zawsze to, iż

jakieś określone uzasadnienie podawane jest jako pewne i nieodwołalne, a tym samym nie podlegające krytyce.

Hipoteza w miejsce ostatecznego uzasadnienia

Żaden z trzech członów trylematu Münchhausena nie jest pożądany. Dlatego też Albert, podobnie

jak zapoczątkowany przez Karla R. Poppera racjonalizm krytyczny, rezygnuje z idei ostatecznego uzasadnienia,

zastępując ją zasadą krytycznego sprawdzania hipotez. Hipotezy dotyczące świata zewnętrznego można

obalać, nie można ich jednak nigdy dowieść. W najlepszym razie zyskują one częściowe potwierdzenie, gdy

sprawdziły się w wielu przypadkach. Jednak nawet dobrze potwierdzona hipoteza nie jest uodporniona na

krytykę, również ona może pewnego dnia zawieść.

Granice poznania przyrody

Ignoramus - Ignorabimus

W roku 1872 fizjolog Emil Du Bois-Reymond wygłosił przed dorocznym zgromadzeniem

„Niemieckich przyrodników i lekarzy” odczyt O granicach poznania przyrody. Sformułował w nim

dwa pytania odnośnie do przyrody, by zakończyć następującym, słynnym zdaniem:

„Ignoramus... Ignorabimus”. — Nie wiemy tego... nigdy nie będziemy tego wiedzieć.

Na początku Du Bois-Reymond, porównując przyrodnika do zwycięskiego zdobywcy, określił

zasięg panowania nauk przyrodniczych. Jakkolwiek rozległy miałby się on okazać w przyszłości,

zawsze po obu końcach będzie mieć dwie nieprzekraczalne granice.

Dzisiaj słowa te czytamy jako dokument dziewiętnastowiecznego, mechanistycznego obrazu

świata. Osiągnął on wówczas szczyt swego znaczenia. Występował z roszczeniem do wyjaśniania

świata, zarazem jednak samokrytycznie wskazywał na swe granice.

Poznać przyrodę, znaczyło wówczas: sprowadzić wszystkie zjawiska do ruchu atomów,

dającego się obliczać wedle praw mechaniki Newtonowskiej. Wielkie znaczenie teorii Newtona

słusznie upatrywano w tym, iż za jej pomocą można obliczyć ruch ciała w dowolnym czasie, o ile

tylko znane jest jego dokładne położenie i prędkość w jakimś jednym momencie. W ten sposób na

podstawie znajomości chwili obecnej można zarówno przewidzieć przyszłość, jak i zrekonstruować

przeszłość.

Żaden człowiek, rzecz jasna, nie jest w stanie faktycznie zdobyć niezbędnych informacji o

aktualnych parametrach wszystkich atomów ani rozwiązać ta kiego mnóstwa Newtonowskich

równań różniczkowych. Trudności tej nie uważano jednak za przeszkodę za sadniczą. W przypadku

bowiem pewnego możliwego do ogarnięcia problemu, mianowicie mechaniki nieba, teoria ta odniosła

jeden ze swych największych triumfów. Obliczenia oparte na mechanice Newtonowskiej okazały się

tak precyzyjne, iż na podstawie różnicy pomiędzy zaobserwowanym położeniem planety Uran a jej

pozycją wynikającą z obliczeń wywnioskowano istnienie nieznanej wcześniej planety, która potem

została faktycznie odkryta na niebie. Był to Neptun, ósma planeta Układu Słonecznego.

Demon Laplace'a

Na początku XIX stulecia astronom i matematyk Pierre Laplace dla unaocznienia

mechanistycznego poglądu na świat posłużył się obrazem ducha, u którego ludzkie zdolności

poznawcze byłyby tak spotęgowane, iż posiadłby on faktycznie wiedzę o wszystkich atomach i

mógłby rozwiązać wszystkie równania ich ruchu. W ten sposób ów demon Laplace'a znałby całą

przeszłą i przyszłą historię świata.

Du Bois-Reymond postawił pytanie, czy owo osiągnięte przez demona Laplace'a doskonałe

poznanie przyrody miałoby jeszcze jakieś granice. Jakie zagadki pozostałyby bez odpowiedzi, jako

niesprowadzalne do kwestii ruchu atomów i nierozwiązywalne środkami mechaniki Newtonowskiej?

Nie należałoby do nich powstanie Ziemi; dałoby się je bowiem wyjaśnić za pomocą

mechanistycznej teorii ciepła jako wynik ochłodzenia wirującej kuli gazowej. Zagadką taką nie

byłoby też powstanie prostych form życia, jako wprawdzie niezwykle złożony, niemniej jednak,

zdaniem Du Bois-Reymonda, mechaniczny problem zachowania się układu atomów w stanie płynnej

równowagi. Niepojęte dla poznania przyrodniczego wydają się tylko dwie rzeczy: materia i siła z jednej

strony oraz świadomość z drugiej strony.

Sprzeczności atomizmu

Zgodnie z mechanistycznym obrazem świata cała materia składa się z mnóstwa atomów,

które z kolei same są już niezmienne i których liczba nie zmienia się w czasie. Atom wyobrażano

sobie w zasadzie na podobieństwo znacznie pomniejszonej stalowej kulki, absolutnie sztywnej i nie

dającej się już dalej dzielić. Ale wyobrażenie to prowadziło w ostatecznej konsekwencji do

sprzeczności: albo atom ma rozmiary przestrzenne, a wtedy może być niepodzielny tylko o tyle, o ile

spajają go siły wewnętrzne, tym samym jednak posiadałby jakąś strukturę wewnętrzną. Albo też atom

stanowi jedynie punktowy ośrodek sił, wtedy jednak nie posiadałby substancji materialnej, a w

świecie nie istniałaby żadna masa.

Sprzeczność ta, w którą wikła się konsekwentne myślenie atomistyczne, pokazuje, iż w

ostatecznym rachunku nie da się materii pomyśleć jako skupiska kul bilardowych. Du Bois-Reymond

poszedł jeszcze o krok dalej i spróbował zastanowić się nad źródłem tego paradoksu.

Ludzka potrzeba poznania zostaje zaspokojona tylko wtedy, gdy jesteśmy w stanie wyobrazić

sobie coś w sposób naoczny. Oto jednak wszystkie nasze wyobrażenia wywodzą się ze świata

codziennego doświadczenia. Wyobrażenia te przenosimy na świat atomów, ale:

„Nie zbliżamy się ani o krok do zrozumienia na tury rzeczy, w istocie bowiem jedynie

przenosimy w wyobraźni to, co jawi się w dziedzinie tego, co duże i widzialne, w dziedzinę tego, co

małe i niewidzialne. Tą drogą dochodzimy do fizykalnego pojęcia atomu. Gdy jednak w jakimś

punkcie arbitralnie przerywamy podział, jeżeli zatrzymujemy się przy domniemanych atomach

filozofów, które mają być już dalej niepodzielne, całkowicie sztywne, zarazem jednak same w sobie

niezdolne do oddziaływań i stanowiące jedynie centra sił, to wymagamy tym samym, by materia

taka, jaką sobie w ten sposób wyobraziliśmy, bez wprowadzania żadnej nowej zasady, sama z siebie

wyłaniała nowe, pierwotne własności, oświetlające jej prawdziwą istotę” 10.

Pochodzenie ruchu

Do pytania o adekwatny model materii dołącza Du Bois -Reymond pytanie o źródło jej ruchu.

Wprawdzie demon Laplace'a może przy użyciu mechaniki Newto nowskiej cofać się coraz dalej w

przeszłość począwszy od aktualnego układu atomów. Ale nawet on ni gdy nie odkryje pierwszej

przyczyny. Co wprawiło kiedyś atomy w ruch? Stary problem pochodzenia ruchu nie ma

mechanistycznego rozwiązania. Arystoteles upatrywał w tym dowód istnienia Boga jako „pierwszego

poruszyciela”.

Dla fizyki dziewiętnastowiecznej granicę mechanistycznego obrazu świata stanowiła

adekwatna koncepcja atomu i kwestia pochodzenia energii kinetycznej.

Elektrodynamika, teoria względności i teoria kwantów

Maxwella teoria pola

Często zapomina się o tym, że na „mechanistyczne” XIX stulecie przypadają także narodziny

całkiem innej teorii fizycznej. Obok mechaniki Newtonowskiej pojawiła się w XIX wieku druga,

samodzielna, a przy tym równie ważna teoria: elektrodynamika, sformułowana przez Jamesa

Maxwella w roku 1856. Jej dwa podstawowe równania mieszczą się w jednej linijce:

dF=0 oraz δF+j = 0

gdzie F oznacza siłę pola elektromagnetycznego, j natężenie prądu elektrycznego, a d i 8 — dwa

matematyczne operatory różniczkowe. Na podstawie tych równań można obliczyć wszystkie

zjawiska związane z prądem elektrycznym i magnetyzmem. Należy do nich m.in. przetwarzanie

prądu elektrycznego w ruch mechaniczny w silniku elektrycznym, jak też proces odwrotny —

wytwarzanie prądu za pomocą ruchu mechanicznego w prądnicy; obu procesom towarzyszy nie10

Emil Du Bois-Reymond, Über die Grenzen des Naturekennens. w: tegoż, Reden, Veit & Comp., Leipzig 1912, s. 449.

odłącznie powstawanie pola magnetycznego. Nowa teoria Maxwella połączyła zjawiska elektryczne i

magnetyczne, traktując je jako dwie strony jednego i tego samego fenomenu, który nazwano

elektromagnetyzmem. Elektrodynamika Maxwella posługuje się całkiem innym pojęciem

podstawowym niż pojęcie atomu mechaniki Newtonowskiej: pojęciem pola. A oto niektóre cechy pola:

— Nie posiada masy.

— Nie ma punktowej lokalizacji, lecz w całości wypełnia

daną przestrzeń.

— Bez żadnego materialnego nośnika może rozchodzić

się w próżni.

Ponieważ pole elektromagnetyczne rozchodzi się w sposób falowy, chętnie unaoczniane

bywa przez porównanie z rozchodzeniem się fal na powierzchni wody. Zarazem jednak wymienione

powyżej własności wskazują na ograniczenia tej analogii: W przypadku fali wodnej drgają poszczególne

cząsteczki wody, co jednak drga w przypadku fal elektromagnetycznych? A przecież pole

elektromagnetyczne nie jest żadną ciemną fantasmagorią. Cała technika telekomunikacyjna — radio,

telewizja, radar — opiera się na zdolności pola elektromagnetycznego do przekazywania informacji,

Również światło to nic innego jak mnóstwo fal elektromagnetycznych, których długość postrzegana

jest przez ludzki ośrodek wzroku jako kolor.

Szczególna teoria względności

Teoria Maxwella i jej wspaniałe potwierdzenie, jakim była możliwość przesyłania fal

elektromagnetycznych i ich odbioru, dostarczyła bodźca do całego szeregu prób znalezienia jakiegoś

nośnika również w przypadku tych fal. Były to próby nieudane. Koncepcja tzw. eteru jako owego

nośnika niczego nie wyjaśniała, lecz prowadziła jedynie do sprzeczności. W roku 1905 w pracy O

elektrodynamice ciał w ruchu Albert Einstein wyciągnął następujący wniosek z tych niepowodzeń: Nie

istnieje eter ani jako nośnik fal elektromagnetycznych, ani jako wyróżniony punkt odniesienia dla

wszystkich ruchów.

Treścią pracy Einsteina z 1905 roku jest szczególna teoria względności. Za jej najważniejszą

konsekwencję uważa się dzisiaj formułę wyrażającą równoważność masy i energii:

E = m·c 2

(Energia = masa • prędkość światła do kwadratu)

Gdyby udało się całą masę znaczka pocztowego przekształcić bez reszty w energię, to w myśl

formuły Einsteina otrzymałoby się energię ok. 3 miliardów kilowatogodzin. Wystarczyłaby ona do

rocznego zaopatrzenia małego miasta w prąd. Drobna cząstka energii tkwiącej w materii zostaje

uwolniona w trakcie rozszczepienia odpowiednich jąder atomowych, nieco większa część — w

trakcie syntezy jądrowej. Przetwarzanie materii w energię jest źródłem promieniowania

słonecznego, tym samym zaś podstawą prawie wszystkich form energii na Ziemi.

Reakcje syntezy i rozszczepiania jąder wyzwalają znacznie więcej energii niż konwencjonalne

spalanie. Wszelkie spalanie to proces utleniania, w trakcie którego materiał palny łączy się z

tlenem. Podobnie jak we wszystkich procesach chemicznych, dochodzi tu jedynie do

przemieszczenia się elektronów w powłokach atomowych, jądra zaś pozostają bez zmian. Są one

utrzymywane przez inne siły, znacznie większe niż elektryczne przyciąganie powłoki elektronowej.

Formuła równoważności masy i energii obaliła obowiązującą przez tysiąclecia zasadę

zachowania substancji. Od czasu Einsteina wiemy już, że masa może być wytwarzana i

unicestwiana.

Dokonuje się to w naszych czasach codziennie w wielkich akceleratorach cząstek

elementarnych. Gdy rozpędzone do wielkich prędkości cząstki elementarne wpadają na siebie,

powstają nowe cząstki, których masa jest niekiedy większa od masy cząstek wyjściowych: ta

dodatkowa masa pochodzi z energii ich ruchu.

Atomy tworzące materię zbudowane są z trzech rodzajów cząstek elementarnych: protonów i

neutronów tworzących jądra oraz elektronów tworzących powłoki atomowe. W tej konfiguracji są one

stabilne. Wolny neutron natomiast, nie związany wewnątrz jądra, nie jest stabilny, lecz po średnim

czasie nieco ponad 15 min. rozpada się na proton, elektron i jeszcze jedną cząstkę, zwaną neutrino.

Inne cząstki elementarne, jak np. obojętny pion, wypromieniowują już w ciągu ułamków sekundy,

przy czym ich masa ulega całkowitemu przekształceniu w energię bardzo przenikliwego promieniowania gamma.

Źródła teorii kwantów

Również światło jest promieniowaniem elektromagnetycznym. Powstaje ono w atomach.

Jeśli wyobrazić sobie atom jako pełne jądro, wokół którego krążą w znacznej odległości elektrony, to

z każdą orbitą związana jest pewna określona energia obiegających ją elektronów. Orbity o wyższej

energii znajdują się przy tym dalej od jądra. Podobnie jak satelitę Ziemi, również elektron można

poprzez nadanie mu większej prędkości umieścić na zewnętrznej orbicie, co osiąga się np.

dostarczając mu energii cieplnej. Wkrótce potem elektron opada z powrotem na swą orbitę

wewnętrzną, wypromieniowując nadmiarową energię w postaci światła. Otóż w myśl praw

elektrodynamiki Maxwella już dawno nie powinno być w ogóle żadnych krążących elektronów.

Każdy krążący ładunek elektryczny powinien bowiem stale i w sposób ciągły wypromieniowywać

energię i w rezultacie, na podobieństwo spadającego satelity, opaść po spiralnym torze w kierunku

centrum, tzn. jądra atomowego. Sprzeczności tej nie da się rozwiązać na gruncie teorii Maxwella, co

wskazuje na jej ograniczenia w dziedzinie mikrofizyki.

Spójna teoria wyjaśniająca fakt stabilności atomów oraz powstawanie promieniowania

elektromagnetycznego jest możliwa dopiero w ramach mechaniki kwantowej lub jej rozwinięcia w

postaci elektrodynamiki kwantowej. Za pomocą takich pojęć matematycznych, jak przestrzeń

Hilberta, wartość własna czy równanie Schrödingera, mechanika kwantowa nakreśliła model

odpowiadający na pytania dotyczące promieniowania elektromagnetycznego atomów, podobnie jak

czyni to teoria Newtona odnośnie do zagadnień mechanicznych w skali makrokosmosu. Równania

mechaniki kwantowej mają w prostych przypadkach rozwiązania jednoznaczne, w przypadkach zaś

bardziej skomplikowanych — przynajmniej przybliżone, tak iż wyniki można porównywać z danymi

doświadczalnymi.

Granice klasycznych pojęć

Kontrowersyjność mechaniki kwantowej tkwi nie w sformułowaniu jej matematycznych

równań, lecz w ich interpretacji za pomocą znanych pojęć fizyki klasycznej.

Zwieńczeniem długich dyskusji na ten temat było następujące zdanie Heisenberga:

„Elektron nie ma toru”.

Jak bowiem można by określić tor elektronu? Należałoby wielokrotnie zaobserwować jego

kolejne położenia, a następnie otrzymane punkty połączyć za pomocą krzywej. W celu obserwacji

należałoby naświetlać elektron pod mikroskopem i na podstawie odchylenia światła (np. w formie

błysku) określać jego położenie. Jednakże do takiej obserwacji nie wystarczyłby zwykły mikroskop,

operujący światłem widzialnym. Do obserwacji obiektów tak małych jak elektrony należałoby użyć

mikroskopu operującego znacznie bogatszym w energię promieniowaniem gamma. Heisenberg

obliczył, jak wielka musiałaby być energia promieniowania gamma użytego w jego myślowym

eksperymencie, i ustalił, że podczas naświetlania kwantami gamma elektron wskutek odrzutu uległby

odchyleniu w zupełnie niekontrolowanym kierunku lub zostałby wręcz wypchnięty z atomu. W ten

sposób próba określenia toru elektronu w atomie już przy pierwszym pomiarze spełzłaby na niczym.

Próba dokładnego pomiaru położenia zakłóciłaby w sposób niekontrolowany prędkość elektronu. Ten

odwrotny stosunek pomiędzy dokładnością pomiaru obu tych wielkości fizycznych Heisenberg

wyraził w swej zasadzie nieoznaczoności:

δx • δp h

Iloczyn niedokładności pomiaru położenia, Ax, oraz niedokładności pomiaru momentu pędu,

Ap, nie może być mniejszy niż stała Plancka

h = 1,05 • 10 –2 7 cm 2 • g • sec –1 .

Dokładniejszy pomiar położenia jest możliwy tylko za cenę mniejszej dokładności w

pomiarze momentu pędu, a tym samym prędkości. Pojęcia klasyczne, jak położenie czy prędkość, a

wraz z nimi pojęcie toru ruchu, dają się w mikrofizyce stosować jedynie w sposób ograniczony. Kto

wyobraża sobie atom jako pomniejszony układ planetarny (elektrony okrążające jądro), powinien

wiedzieć, że jest to jedynie analogia. Elektrony w atomie nie mają torów. Istnieją jedynie większe lub

mniejsze obszary, w których występują z dużym prawdopodobieństwem. Prawdopodobieństwa te

można obliczyć środkami mechaniki kwantowej.

Co oznacza dzisiaj poznawanie przyrody? Język matematyki

Gdy człowiek wykracza w swych eksperymentach poza obszar mezokosmosu, sięgając w świat

dużych prędkości lub małych odległości, wówczas przestają obowiązywać tradycyjne pojęcia i wyobrażenia.

Dotyczy to w równej mierze teorii względności, co mechaniki kwantowej. Poznawanie przyrody nie może już

zatem dłużej oznaczać jej rozumienia za pomocą modeli poglądowych. Jak jednak można wciąż jeszcze mówić o

przyrodzie, gdy zawodzą pojęcia zaczerpnięte z naoczności?

Pozostaje wtedy tylko jeden język, a jest nim matematyka. U początków filozofii

zachodnioeuropejskiej greccy filozofowie przyrody spekulowali na temat prazasady wszystkich rzeczy. Tales

powiedział: „Wszystko jest wodą”. U Anaksymenesa mamy zdanie: „Wszystko jest powietrzem”. Pitagoras

natomiast powiada:

„Całe niebo jest harmonią i liczbą”.

Nieco później Platon jako argument na rzecz regularnego kształtu cząstek elementarnych przytaczał

to, iż z matematycznego punktu widzenia jest to forma najpiękniejsza i najprostsza. Również i w XX wieku

poszukiwania trafnej teorii cząstek elementarnych wiążą się z poszukiwaniem właściwej symetrii. Harmonia symetria - liczba, oto idee przewodnie przyświecające dociekaniom przyrodniczym począwszy od koncepcji

presokratyków, skończywszy zaś na współczesnych teoriach cząstek elementarnych.

Pierwsze wskazanie na związek harmonii i liczby pochodzi zapewne z muzyki. W przypadku

instrumentu strunowego wysokość dźwięku zależy od długości swobodnie drgającej struny. Pitagorejczykom

przypisuje się odkrycie, iż powstające przy tym akordy harmoniczne odpowiadają pewnym ściśle

określonym, prostym stosunkom liczbowym długości strun. Np. stosunek oktawy, kwinty, kwarty i tercji do

wspólnej im podstawowej wysokości dźwięku wynosi odpowiednio 2:1, 3:2, 4:3 i 5:4.

Cóż znaczy dzisiaj poznawanie przyrody? Muszą w tym celu zostać spełnione dwa warunki:

— Trafne przewidywanie wyników wszystkich eksperymentów w danej dziedzinie.

— Istnienie jednolitej, prostej teorii tłumaczącej wiele różnorodnych zjawisk.

System geocentryczny Ptolemeusza pozwalał na obliczanie orbit planetarnych z dokładnością

nie mniejszą niż system heliocentryczny. Jednakże zasada, by każde odchylenie zaokrąglać dodając

nowe epicykle, stanowi jedynie rozwiązanie ad hoc, dzięki któremu system Ptolemejski daje się ex post

dopasować do wszelkich obserwacji: wystarczy po prostu wprowadzić kilka nowych parametrów.

W systemie heliocentrycznym natomiast można od czasów Newtona wyprowadzić orbity

planet z dwóch prostych praw, mianowicie z prawa ciążenia oraz z podstawowej zależności „siła =

masa • przyspieszenie”. Wprawdzie i tutaj dokładne wyliczenia są skompliko wane, a wyniki otrzymuje

się jedynie w drodze coraz większych przybliżeń. Jednakże podstawowe prawo jest proste. Obowiązuje

ono nie tylko w mechanice nieba, lecz w odniesieniu do wszelkich zjawisk przyciągania mas, np.

rzutu lub swobodnego upadku kamienia na Ziemi bądź na Księżycu.

Dwie najważniejsze teorie fizyczne XX wieku, teoria względności i teoria kwantów,

sformułowano w języku matematyki i zastosowano w nich rezultaty zaawansowanych badań

matematycznych. Liczne spośród ich podstawowych pojęć są nieobserwowalne. Dotyczy to zarówno

czterowymiarowej Riemannowskiej przestrzeni wszystkich zdarzeń w teorii względności, jak i przestrzeni Hilbertowskiej o nieskończonej liczbie wymiarów, obejmującej wszystkie stany — w teorii

kwantów.

Naoczność nie stanowi kryterium

Podstawowe pojęcia teorii przyrodniczej nie muszą być ani naocznie wyobrażalne, ani

bezpośrednio mierzalne. Muszą jedynie istnieć reguły określające, jak należy przekładać

obserwowane wielkości fizyczne na matematyczne wielkości teorii. Pomiarów dokonuje się więc

przy użyciu zegarów i liniałów lub np. obserwuje się promienie świetlne. Obserwowana droga

promienia świetlnego odpowiada linii geodezyjnej w matematycznym modelu ogólnej teorii

względności. Po dokonaniu obliczeń na modelu wyniki przekłada się z powrotem na wielkości

obserwowanie.

Obiegowy pogląd, iż „wszelkie myślenie jest antropomorficzne”, jest niesłuszny. Rozumie się

przezeń twierdzenie, że człowiek może myśleć jedynie za pomocą pojęć sporządzonych na ludzką

miarę i zaczerpniętych z doświadczeń życia codziennego. Jedynie w micie mamy do czynienia z

myśleniem antropomorficznym. Świat jego pojęć tworzą ludzkie doświadczenia, jak miłość,

zazdrość, panowanie, płodzenie czy narodziny.

Rzecz jasna, to człowiek wymyśla pojęcia matematyczne, za pomocą których opisujemy

mikro- i makro-kosmos. Nie tworzy ich jednak na swój własny obraz. Nie pochodzą one z tego

świata, który przeżywamy osobiście jako ludzie.

Na przykładzie eksperymentów w akceleratorach wysokich energii widać, jak wielki wkład

skomplikowanych technologii potrzebny jest do faktycznego przeprowadzenia eksperymentu z

cząstkami elementarnymi. A przy tym decydująca część eksperymentu — chwila, w której cząstki

reagują ze sobą — nie jest dostępna bezpośredniej obserwacji i musi być ex post rekonstruowana na

podstawie zapisów urządzeń pomiarowych. Ta interpretacja wyników pomiarów jest z kolei możliwa

jedynie w świetle pewnej już istniejącej teorii.

Humaniście sytuacja ta przypomni procedury stosowane w hermeneutyce. Przyrodnik

pomyśli raczej o maksymie Einsteina: Dopiero teoria rozstrzyga o tym, co zostaje zaobserwowane w

eksperymencie.

Koniec nauk przyrodniczych?

Aż do roku 1939 atom fizyczny pozostawał niepodzielny. Później odkryto zjawisko

rozszczepiania jąder, dzisiaj zaś rozważa się w fizyce kwestię, czy tworzące jądro protony i neutrony

same składają się zawsze z trzech kwarków. Oznaki tego, iż cząstki elementarne same posiadają

pewną strukturę wewnętrzną, pojawiły się dopiero wtedy, gdy zaczęto rozporządzać wystarczająco

wysokimi energiami, by móc powtórzyć na częściach składowych jądra te same, klasyczne eksperymenty, dzięki którym niegdyś rozwikłano strukturę atomu. W pierwotnej wersji teorii kwantów

protony traktowano zrazu jako cząstki bez struktury we wnętrznej i charakteryzowano je jedynie za

pomocą ich ładunku elektrycznego, masy i spinu.

Poznawanie przyrody nigdy nie oznacza jej ostatecznego poznania. Gdy badania wkraczają na

obszary wcześniej niedostępne dla eksperymentów, wówczas mogą wystąpić nowe zjawiska

dotychczas przez teorię nie uwzględniane. Poznawanie przyrody jest procesem. Czy proces ten

pewnego dnia dobiegnie końca, czy też będzie postępował coraz dalej w duchu wielkiej unifikacji, czy

też wreszcie rosnąca liczba szczegółowych wiadomości będzie prowadzić do coraz większego rozproszenia — na ten temat snuto w przeszłości diametralnie różne prognozy.

Max Planck opowiada o tym, w jaki sposób fizyk Philipp von Jolly odradzał mu jako młodemu

człowiekowi studiowanie fizyki — że mianowicie w nauce tej pozostaje do wypełnienia jedynie kilka

nieistotnych luk. Działo się to w ostatnim trzydziestoleciu XIX wieku, a więc przed narodzinami

teorii względności i teorii kwantów. Powinniśmy wyciągnąć naukę z tej historii i strzec się nowych

przepowiedni.