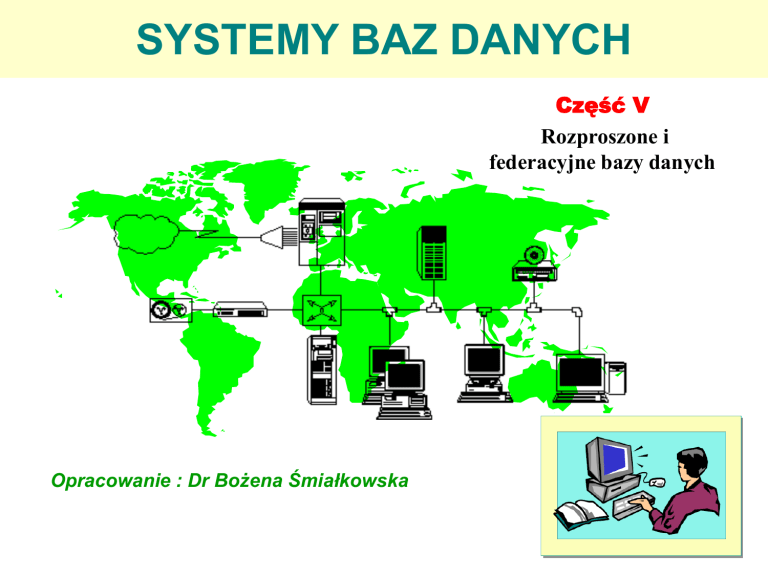

SYSTEMY BAZ DANYCH

Część V

Rozproszone i

federacyjne bazy danych

Opracowanie : Dr Bożena Śmiałkowska

Wprowadzenie do systemów

rozproszonych

Co to jest system rozproszony?

Systemem rozproszonym nazywamy taki system, w którym

przetwarzanie informacji odbywa się na wielu komputerach, często

znacznie oddalonych geograficznie (od kilku metrów do dziesiątków

tysięcy kilometrów). Przeciwieństwem jest system izolowany lub

scentralizowany.

Obecnie właściwie wszystkie systemy (poza domowymi komputerami) są

rozproszone. Ogromnym katalizatorem rozproszenia systemów jest

Internet. Komputer z Internetem można już uważać za system

rozproszony.

Projektowanie i własności systemów rozproszonych w dużej mierze są

takie same jak systemów scentralizowanych, ale istnieją także istotne

różnice, który specjalista inżynierii oprogramowania musi być świadomy.

Tendencja do budowy systemów rozproszonych jest pochodną rozbudowy

tanich, szybkich, uniwersalnych i niezawodnych sieci komputerowych.

Przykłady systemów rozproszonych: sieć bankomatów, system rezerwacji

biletów, system pracy grupowej, itd.

Co to jest system rozproszony?

Cztery najważniejsze problemy do

rozwiązania w systemach r.b.d.

Przezroczystość (transparency): traktowanie rozproszonych zasobów i usług

tak, jak gdyby były one wewnątrz przestrzeni adresowej jednego komputera.

Bezpieczeństwo: przeciwdziałanie losowym awariom oraz możliwościom atak

z zewnętrz.

Interoperacyjność (interoperability): umożliwienie współpracy

heterogenicznych platform, aplikacji, logik biznesowych i organizacji danych.

Efektywność: uzyskanie czasów przetwarzania akceptowalnych dla szerokiego

kręgu użytkowników rozproszonych aplikacji.

Przezroczystość

Redukcja złożoności przy pracy z rozproszonymi

zasobami danych i usług, polegająca na uwolnieniu

programisty od myślenia na temat położenia i organizacji

rozproszonych danych.

Przezroczystość ma bezpośrednie skutki dla czasu i

kosztu wytworzenia rozproszonej aplikacji, jej

przenaszalności i pielęgnacyjności.

Formy przezroczystości (1)

Przezroczystość położenia i dostępu: Uwolnienie

użytkowników od konieczności korzystania z informacji o

aktualnym położeniu geograficznym danych i usług.

Przezroczystość współbieżności: Umożliwienie wielu

użytkownikom jednoczesnego dostępu do danych i usług.

Przezroczystość skalowania: Umożliwienie dodawania

lub usuwania serwerów, danych i usług bez wpływu na

działanie aplikacji i pracę użytkowników.

Przezroczystość fragmentacji (podziału): automatyczne

scalanie obiektów lub kolekcji, których fragmenty są

przechowywane w różnych miejscach.

Formy przezroczystości (2)

Przezroczystość replikacji: Umożliwienie tworzenia i

usuwania kopii danych w innych miejscach

geograficznych ze skutkiem dla efektywności

przetwarzania.

Przezroczystość awarii: Umożliwienie nieprzerwanej

pracy większości użytkowników rozproszonej bazy

danych w sytuacji, gdy niektóre z jej węzłów lub linie

komunikacyjne uległy awarii.

Przezroczystość migracji: Umożliwienie przenoszenia

zasobów danych do innych miejsc bez wpływu na pracę

użytkowników.

Interoperacyjność

Krytyczny problem dla projektu bottom-up, czyli systemu

integrującego istniejące (spadkowe) niekompatybilne

(heterogeniczne) dane i usługi.

Interoperacyjność na poziomie transportu (transport-level

interoperability) jako podstawa wyższych form

interoperacyjności. Chodzi o umożliwienie fizycznej

komunikacji pomiędzy danymi i usługami, np. na gruncie

TCP/IP, HTTP, wspólnej pamięci, itp.

Interoperacyjność kontra przezroczystość

Konieczność poszukiwania kompromisowych rozwiązań na zasadzie tzw.

„wspólnego rozwiązania”.

Może być to łatwe: Dla danej populacji serwerów istnieje prosty model

kanoniczny powiązań inter-operacyjnych w jedną przezroczystą całość.

Może to być trudne: Jeżeli rozbieżności pomiędzy serwerami są duże, to

informacja o zawartości poszczególnych serwerów musi być

doprowadzona do programisty i do modelu kanonicznego. Jest to

problem złożony i nieprzezroczysty.

Zalety systemów rozproszonych cd..

Podział zasobów: system rozproszony pozwala dzielić zasoby sprzętowe

i programowe (pamięci dyskowe, drukarki, pliki, kompilatory, itd.)

pomiędzy wielu użytkowników pracujących na różnych komputerach

pracujących w sieci.

Otwartość: jest ona definiowana jako zdolność systemu do dołączania

nowego sprzętu, oprogramowania i usług. Otwarte systemy często mają tę

zdolność również w stosunku do w/w zasobów ulokowanych na

platformach sprzętowych i systemach operacyjnych dostarczanych przez

różnych dostawców.

Współbieżność: w systemie rozproszonym wiele procesów może działać

w tym samym czasie na różnych komputerach w sieci. Procesy te mogą

(jakkolwiek nie muszą) komunikować się podczas swego działania.

Skalowalność: Moc i możliwości przetwarzania może wzrastać w miarę

dodawania do systemu nowych zasobów, w szczególności komputerów.

W praktyce skalowalność jest często ograniczona poprzez przepustowość

sieci oraz (niekiedy) poprzez np. specyficzne protokoły wymiany

informacji. Niemniej skalowalność systemu rozproszonego jest

Zalety systemów rozproszonych (2)

Tolerancja błędów: Dostępność wielu komputerów oraz umożliwienie

zdublowania informacji (replikacje) oznacza, że rozproszony system jest

tolerancyjny w stosunku do pewnych błędów zarówno sprzętowych jak i

programowych. Np. awaria węzła komunikacyjnego powoduje

wygenerowanie innej trasy przepływu informacji.

Przezroczystość: Oznacza ukrycie przed użytkownikiem szczegółów

rozproszenia, np. gdzie ulokowane są zasoby lub jak są one fizycznie

zaimplementowane, pod jakim systemem pracują, itd. Przezroczystość

ma zasadnicze znaczenie dla komfortu działania użytkownika oraz dla

niezawodności budowanego oprogramowania. Niekiedy, np. dla celów

optymalizacyjnych, użytkownik może zrezygnować z pełnej

przezroczystości. Przykładem przezroczystości jest Internet: klikając w

aktywne pole na stronie WWW nie interesujemy się, gdzie znajduje się

odpowiadająca mu strona, oraz jak i na czym jest zaimplementowana.

Wady systemów rozproszonych

Złożoność: systemy rozproszone są trudniejsze do zaprogramowania i do

administrowania niż systemy scentralizowane. Zależą od własności sieci,

np. jej przepustowości i czasu transmisji, co utrudnia zaprojektowanie i

zrealizowanie wielu algorytmów i procesów przetwarzania.

Ochrona: Dla systemu scentralizowanego wystarcza w zasadzie strażnik

z karabinem. System rozproszony nie może być chroniony w ten sposób,

przez co może być narażony na różnorodne ataki (włamania, wirusy,

sabotaż, odmowa płatności, itd.) z wielu stron, które trudno

zidentyfikować.

Zdolność do zarządzania: jest ona utrudniona wskutek tego, że

konsekwencje różnych działań administracyjnych w systemie

rozproszonym są trudniejsze do zidentyfikowania. Podobnie z

przyczynami sytuacji anormalnych, w szczególności awarii.

Nieprzewidywalność: system rozproszony jest nieprzewidywalny w

swoim działaniu, ponieważ zakłócenia mogą być powodowane przez wiele

przyczyn: małą przepustowość i awarię łączy, awarię komputerów, zbyt

duże obciążenie danego serwera, lokalne decyzje administracji serwera,

Krytyczne zagadnienia projektowe dla

systemów rozproszonych

Identyfikacja zasobów: zasoby w systemie rozproszonym są podzielone

pomiędzy wiele komputerów, w związku z czym schematy ich nazywania

muszą być zaprojektowane tak, aby użytkownicy mogli zidentyfikować

interesujące ich zasoby. Przykładem takiego schematu jest URL (Uniform

Resource Locator) znany z WWW.

Komunikacja: może być zaprojektowana w sposób uniwersalny, na bazie

np. protokołu internetowego TCP/IP lub któregoś protokołu pochodnego

(ftp, http, itd.). Niektóre wymagania dotyczące szybkości, kosztu,

niezawodności lub bezpieczeństwa mogą prowadzić do specjalnych

technik komunikacyjnych.

Jakość obsługi: odzwierciedla wydajność systemu, jego dostępność i

niezawodność. Podlega ona wielu czynnikom, w szczególności,

przypisaniu zadań do procesorów, optymalności geograficznego podziału

danych, itd.

Architektura oprogramowania: opisuje ona w jaki sposób

funkcjonalności systemu są przypisane do logicznych i fizycznych

Popularne architektury rozproszenia

Klient-serwer: rozproszony system ma wyróżniony węzeł zwany

serwerem, oraz szereg podłączonych do niego węzłów zwanych klientami.

Związek nie jest symetryczny: serwer wykonuje usługi zlecane przez

klientów, nie może im odmówić i nie może im zlecić wykonanie usług.

Klient-multi-serwer: podobnie jak dla architektury klient-serwer, ale

istnieje wiele serwerów. Przykładem jest WWW.

Koleżeńska (peer-to-peer, P2P): wiele węzłów świadczy sobie wzajemne

usługi poprzez bezpośrednie połączenie; nie ma wyraźnego podziału na

usługodawców i usługobiorców. Przykładem jest Gnutella, NXOR, w

mniejszym stopniu Napster ma centralne sterowanie. Komercyjny buzz

dookoła P2P.

Architektura oparta na oprogramowaniu pośredniczącym

(middleware): nie występuje podział na klientów i serwery. Węzły

komunikują się poprzez specjalne oprogramowanie pośredniczące, które

zakłada wspólny (przezroczysty dla użytkowników) protokół

komunikacyjny. Przykładem jest CORBA (rozproszone obiekty),

.NET/COM/DCOM, Java Beens/RMI, SOAP, ...

Rozproszone a scentralizowane BD

Co to jest rozproszona baza danych?

distributed database

Termin ten jest powtarzany w wielu kontekstach, często bez przypisywania mu

konkretnego, technicznego znaczenia.

Czy to, że z pewnego systemu można dostać się do danych innego odległego

systemu jest wystarczającym wyróżnikiem rozproszonej bazy danych?

Dla wielu zastosowań cecha ta jest istotna, lecz

Rozproszona baza danych musi spełniać określone kryteria

dotyczące spójności, bezpieczeństwa, zintegrowania i wygody

użytkowników.

Możliwość dostania się do danych innego systemu (np. poprzez

pakiety oparte o standardy ODBC, JDBC, DCOM lub CORBA)

oznacza wyłącznie ustanowienie niezbędnej bazy technicznej. Fakt

ten nie przesądza jednak o tym, czy zachodzą dostateczne warunki

dla sprawnego, efektywnego oraz niezawodnego wykorzystywania

danych.

Podstawowe pojęcia związane z

rozproszeniem

Rozproszona baza danych: zbiór składający się z wielu logicznie

ze sobą powiązanych elementów bazy danych, oddalonych

geograficznie i połączonych ze sobą poprzez sieć komputerową.

System zarządzania rozproszoną bazą danych (SZRBD):

oprogramowanie umożliwiające połączenie rozproszonych

zasobów w jedną całość, utrzymanie spójność zasobów oraz

udostępnianie ich użytkownikom przy założeniu przezroczystości

rozproszenia.

Dane są przechowywane w wielu miejscach - węzłach sieci.

Rozproszona baza danych jest bazą danych, a nie kolekcją plików,

które mogą być indywidualnie przechowywane w każdym węźle

sieci komputerowej.

SZRBD posiada pełną funkcjonalność systemu zarządzania

scentralizowaną BD. Nie jest to system zarządzania rozproszonymi

plikami, ani też wyłącznie system przetwarzania transakcji.

Przykład rozproszonej bazy danych

Rozproszona baza danych dla linii lotniczych (biuro obsługi klienta w

Warszawie może dostać się do danych linii lotniczych w Sydney, Tokio,

Paryżu, i setkach innych miast).

Jeżeli w każdym miejscu organizacja bazy danych, środki manipulacji,

reguły dostępu, itd. byłyby inne, to praca byłaby bardzo utrudniona.

Zatem konieczne są:

standardy w zakresie połączenia (protokoły),

standardy w zakresie organizacji danych i dostępu do

danych,

moduły dla odwzorowania pewnej specyficznej bazy danych

na format oczekiwany przez danego klienta,

przezroczystość rozproszenia (a la CORBA),

zabezpieczenia przed niepowołanym dostępem.

Klasyfikacja rozproszonych baz danych

Klasyfikacja rozproszonych baz danych cd..

Systemy wielu baz danych

(multidatabases)

Niefederacyjne rozproszone BD

Jednorodne

BD

Rozproszone BD z

globalnym schematem

Federacyjne BD

Słabo skojarzone

(loosely coupled)

Niefederacyjne BD: brak autonomii.

Słabo skojarzone FBD: brak federacyjnego schematu i

zarządzania, operacje ad hoc, w zależności od aplikacji.

Ściśle skojarzone FBD: FSZBD jest odpowiedzialny za

zarządzanie całością federacji.

Ściśle skojarzone

(tightly coupled)

Pojedyncze

federacje

(pojedynczy

schemat)

Wielokrotne

federacje

(wiele

schematów)

Postulaty rozproszenia BD

Komunikacja w rozproszonych BD

Ważne cechy rozproszonych BD

Architektury rozproszonego przetwarzania: bazy danych oparte o

architekturę klient-serwer, bazy danych oparte o schemat globalny.

Federacyjne bazy danych - (przezroczyste) połączenie wielu

(relewantnych części) heterogenicznych i autonomicznych baz

danych w jedną całość.

Przetwarzanie transakcji w rozproszonych bazach danych;

globalne transakcje, lokalne transakcje, dwufazowe i trójfazowe

potwierdzenie (two-phase commit, 2PC).

Długie transakcje, wymagające osłabienia poziomu izolacji i

minimalizujące ryzyku utraty już wykonanej pracy.

Współdziałanie heterogenicznych, autonomicznych, rozproszonych

(Heterogeneous, Autonomous, Distributed, HAD) baz danych

(określane także jako współdziałanie multi baz danych,

multidatabase interoperability).

Główne problemy rozproszonych baz danych

Wieloaspektowa niezgodność i konflikty między

lokalnymi bazami danych z powodu:

Awarii,

Aktualizacji wielu źródeł i ogniw rozproszonego

środowiska,

Odniesienia danych do tej samej skali czasu

Tematy związane z rozproszonymi BD

Replikacje, czyli utrzymywanie kopii danych w wielu miejscach w

rozproszonych bazach danych.

Rozproszone przetwarzanie zapytań; optymalizacja zapytań w

sytuacji rozproszenia zasobów.

Systemy operacyjne dla podtrzymywania rozproszenia: OSF DCE i

inne systemy oparte o wołanie odległej procedury (Remote

Procedure Call, RPC).

Podtrzymywanie różnych form niewidoczności rozproszenia

(distribution transparency) dla programistów i klientów baz danych.

Standardy w zakresie rozproszenia: OMG CORBA, DCOM firmy

Microsoft, RMI i Java Beans, OpenDoc, ActiveX, SOAP/XML.

Pośrednicy (broker, ORB) wg standardu CORBA, np. Orbix,

Visibroker, ...

Tematy związane z rozproszonymi BD cd..

Środki wspomagające rozproszenie bazy danych i rozproszone

przetwarzanie zrealizowane w konkretnych systemach relacyjnych

(Oracle, Sybase, Ingres, i inne), post-relacyjnych lub obiektoworelacyjnych (Informix Universal Server, DB2 Universal Database,

Oracle8, UniSQL/X, OSMOS, OpenIngres, Sybase Adaptive Server

i inne) oraz obiektowych (Gemstone, Versant, O2, Objectivity/DB,

ObjectStore i inne).

Niezawodność, spójność, bezpieczeństwo i prywatność w

rozproszonych bazach danych.

Rozproszone bazy danych w sieciach Internet oraz Intranet.

Rozproszenie danych i przetwarzania w systemach pracy grupowej

oraz systemach zarządzania przepływem pracy.

Transakcje w rozproszonych BD

Rozproszone BD: relacyjne czy obiektowe?

Prace prowadzone nad rozproszonymi BD (w ciągu ostatnich 20-tu

lat), były oparte głównie o relacyjny model danych.

Zaletami modelu relacyjnego jest prosta, ujednolicona struktura

danych oraz prosta organizacja katalogów bazy danych.

W ostatnich latach obserwuje się odchodzenie od modelu

relacyjnego w stronę modeli obiektowych.

Złożoność samego problemu rozproszenia danych jest

prawdopodobnie niezależna od modelu danych.

Niektóre metody systemów relacyjnych związane z rozproszeniem

dają się przenieść na grunt systemów obiektowych.

Problemy nowe: metamodel (ontologia), przetwarzania zapytań.

W przeciągu najbliższych 10-ciu lat obiektowość będzie

odgrywać główną rolę w rozwijaniu koncepcji rozproszonych

baz danych, w różnych wariantach, np. XML/RDF.

Reguły rozproszenia

Replikacja

Fragmentaryzacja

Reguły rozproszonych baz danych(C.J.(1)

Date, 1987)

12 reguł: w praktyce spełnienie wszystkich jest trudne lub

niemożliwe. Jest to spekulacyjny ideał.

Autonomia lokalnych BD: lokalne dane powinny podlegać

lokalnym regułom własności i powinny być zarządzane lokalnie.

Dotyczy to funkcji związanych z bezpieczeństwem, integralnością i

reprezentacją wewnątrz pamięci. Wyjątki dotyczą sytuacji, kiedy

więzy integralności muszą obejmować jednocześnie wiele miejsc

oraz sytuacji, kiedy rozproszone transakcje muszą być sterowane

przez pewne zewnętrzne miejsce.

Brak podporządkowania przetwarzania do konkretnego

miejsca: uniknięcie wąskich gardeł dzięki decentralizacji

wszystkich funkcji rozproszonego SZBD.

Ciągłość funkcjonowania: Przestoje w wykonywaniu operacji nie

powinny być skutkiem dodania nowych miejsc, ich usunięcia ze

środowiska rozproszonej BD, dokonania zmian w meta-informacji

lub unowocześnienia wersji SZBD w pewnym indywidualnym

Reguły rozproszonych baz danych (2)

Niezależność od lokalizacji: Użytkownicy lub programy

aplikacyjne nie muszą wiedzieć, gdzie dane są fizycznie

przechowywane.

Niezależność od fragmentacji: Fragmenty jednego zbioru danych

mogą być przechowywane i zarządzane przez rozproszony SZBD

jako jedna całość, bez uświadamiania użytkowników lub aplikacji o

sposobie ich rozczłonkowania. Pożądaną własnością

rozproszonego SZBD jest to, aby w sposób automatyczny unikał

przetwarzania nierelewantnych fragmentów.

• Np. jeżeli grupa obiektów jest podzielona geograficznie ze względu na

atrybuty w ten sposób, że atrybuty A1...Am są w miejscu X, zaś

atrybuty Am+1...An są w miejscu Y, i konkretne zapytanie odwołuje się

wyłącznie do atrybutów A1...Am, należy pominąć odwołania do miejsca

Y podczas realizacji tego zapytania.

• Podobnie, fragmenty tej samej tabeli w różnych miejscach

rozproszonej bazy danych powinny być widocznej jako jedna tabela.

Reguły rozproszonych baz danych (3)

Niezależność od replikacji: Istnienie replik danych w wielu

miejscach, ich pojawianie się lub usuwanie nie powinno wpływać

na postępowanie użytkowników ani na poprawność bądź spójność

aplikacji.

Rozproszone przetwarzanie zapytań: System powinien

zapewniać sprawne przetwarzanie rozproszonych zapytań

umożliwiające zredukowanie zarówno czasu przetwarzania, jak i

obciążenia sieci transmisji danych.

Zarządzanie rozproszonymi transakcjami: Zasady zarządzania

transakcjami oraz sterowania współbieżnością powinny

obowiązywać dla operacji w rozproszonej bazie danych. Zasady te

włączają: wykrywanie i usuwanie zakleszczeń (deadlocks),

zarządzanie przekroczeniami dopuszczalnego czasu (timeout),

rozproszone protokóły potwierdzenia (commit) i odwracania

(rollback), oraz inne metody.

Niezależność od sprzętu: oprogramowanie rozproszonego SZBD

Reguły rozproszonych baz danych (4)

Niezależność od systemu operacyjnego: oprogramowanie

rozproszonego SZBD powinno pracować pod różnymi systemami

operacyjnymi.

Niezależność od sieci: Miejsca mogą być połączone poprzez

szeroką gamę środowisk sieciowych i komunikacyjnych. Modele

warstwowe istniejące dla współczesnych protokółów

komunikacyjnych (obowiązujące w większości obecnych systemów

informacyjnych, takich jak OSI 7, TCP/IP, warstwy SNA i DECnet)

zapewniają środki do osiągnięcia tego celu nie tylko dla

rozproszonych baz danych, lecz w ogólności dla systemów

informacyjnych.

Niezależność od SZBD: Powinno być możliwe przyłączenie do

rozproszonej bazy danych lokalnej bazy danych zarządzanej przez

dowolny lokalny SZBD.

Reguła: niezależność od centralnego miejsca

Rozproszona baza danych nie może zależeć od jednego,

centralnego miejsca odpowiedzialnego za całość

funkcjonowania.

• Zależność taka może "wkraść się" niepostrzeżenie, jako konsekwencja

pewnych (wydawałoby się drugorzędnych) decyzji projektowych, np.

powołanie jednego serwera nazw, lub rejestracja nowych miejsc

przyłączających się do rozproszonej bazy danych.

Zależność taka jest niekorzystna, gdyż:

• Centralne miejsce może stać się wąskim gardłem dla operacji na

danych

• Awaria centralnego miejsca powoduje awarię całej rozproszonej bazy

danych.

Dla niektórych zastosowań brak centralnego miejsca jest

niekorzystny:

• z powodu nadmiernego wzrostu obciążenia sieci związanego z

wymianą metadanych;

• z powodu zbyt niskiej wydajności (indeksy w jednym miejscu)

Nazwy elementów danych w rozproszonych BD

Problem nazywania i identyfikacji danych w rozproszonych BD

staje się znacznie bardziej trudny niż w scentralizowanych BD.

Kryteria zarządzania nazwami:

• 1. Każda dana, która ma być niezależnie identyfikowana w systemie

rozproszonym, musi mieć swoją unikalną nazwę (identyfikator).

• 2. Nazwa powinna zapewniać efektywne odszukanie lokalizacji danej.

• 3. Nazwa nie powinna utrudniać zmiany lokalizacji danej.

• 4. Każde lokalne miejsce w rozproszonej BD powinno powinno mieć

możliwość autonomicznego nadawania unikalnych nazw dla danych.

Centralny serwer nazw - nadaje wszystkie nazwy, udziela

informacji o lokalizacji nielokalnych danych na podstawie ich nazw:

• nie spełnia warunku 4,

• może powodować wąskie gardło dla transakcji,

• jest pojedynczym powodem awarii całości.

Rozwiązanie: prefiksowanie nazwy identyfikatorem miejsca trudności ze zmianą lokalizacji danych (przy zachowaniu

Pojęcia związane z

rozproszeniem

Główne aspekty rozproszenia baz danych (1)

Przezroczystość (transparency)

Rozproszony SZBD powinien podtrzymywać rozproszenie

danych przy założeniu odizolowania programisty/użytkownika

od większości aspektów rozproszenia.

Współdziałanie (interoperability)

Oznacza współpracę zbudowanych niezależnie od siebie

heterogenicznych systemów (heterogeneous systems).

Aspektem współdziałania jest przyłączenie do rozproszonej BD

starych systemów, tzw. spadkowych (legacy)

Przenaszalność (portability)

Własność języka programowania i jego kompilatorów/interpreterów

umożliwiająca przenoszenie programów na różne platformy.

Główne aspekty rozproszenia baz danych (2)

Autonomia (autonomy)

Lokalne bazy danych podlegają własnym lokalnym regułom. Tylko

określona część lokalnych zasobów i usług jest udostępniana na

zewnątrz.

Niezależność danych (data independence)

Możliwość projektowania, utrzymywania, udostępniania, zmiany nośników,

zmiany reprezentacji, itp. działań na danych niezależnie od programów,

które na nich operują.

Ontologia (ontology), często w kontekście "ontologia biznesowa"

Formalny opis wszystkich tych własności lokalnej bazy danych, które są

niezbędne do tego, aby projektant/programista mógł prawidłowo

zaprogramować nową aplikację (np. mobilnego agenta).

Niekiedy ontologia jest określana jako metadane.

Przezroczystość (1)

Rozproszona BD musi spełniać warunki komfortu pracy programistów,

administratorów i użytkowników, jak również niezawodności,

bezpieczeństwa danych, zwiększenie odporności na błędy

programistów. To oznacza konieczność redukcji złożoności przy pracy z

rozproszoną bazą danych, co jest określane jako „przezroczystość”.

Ma ona następujące formy:

Przezroczystość położenia: Umożliwienie jednorodnych metod

operowania na lokalnych i odległych danych. Tego warunku nie

spełnia np. system, w którym lokalna baza danych jest

obsługiwana przez pewien język 4GL, zaś odległa - przez

specjalny zestaw procedur (API).

Przezroczystość dostępu: Uwolnienie użytkowników od

konieczności(a niekiedy również uniemożliwienie) korzystania z

informacji o aktualnym położeniu danych.

Przezroczystość (2)

Przezroczystość współbieżności: Umożliwia wielu użytkownikom

jednoczesny dostęp do danych bez konieczności uzgodnień i

porozumiewania się, przy zapewnieniu pełnej spójności danych i

przetwarzania.

Przezroczystość skalowania: Umożliwienie dodawania nowych

elementów bazy danych bez wpływu na działanie starych aplikacji i

pracę użytkowników.

Przezroczystość replikacji: Umożliwienie tworzenia i usuwania

kopii danych w innych miejscach geograficznych z bezpośrednim

skutkiem dla efektywności przetwarzania, ale bez skutków dla

postaci programów użytkowych lub pracy użytkownika końcowego.

Przezroczystość wydajności: Umożliwienie dodawania nowych

elementów systemu komputerowego (np. serwerów, dysków) bez

wpływu na pracę większości użytkowników rozproszonej bazy

danych.

Przezroczystość (3)

Przezroczystość fragmentacji (podziału): automatyczne scalanie

obiektów, tabel lub kolekcji, których fragmenty są przechowywane

w różnych miejscach.

Przezroczystość awarii: Umożliwienie nieprzerwanej pracy

większości użytkowników rozproszonej bazy danych w sytuacji, gdy

niektóre z jej węzłów lub linie komunikacyjne uległy awarii.

Przezroczystość migracji: Umożliwienie przenoszenia zasobów

danych do innych miejsc bez wpływu na pracę użytkowników.

W praktyce spełnienie wszystkich wymienionych warunków jest

ideałem, który prawdopodobnie nie został zrealizowany w żadnym

ze znanych systemów.

Współdziałanie i heterogeniczność

interoperability, heterogeneity

Umożliwienie współdziałania heterogenicznych systemów

baz danych jest drugim ważnym aspektem rozproszenia.

Heterogeniczność jest nieodłączną cechą dużych sieci

komputerowych, takich jak Internet, WWW, sieci

intranetowych, rozproszonych baz danych, systemów

przepływu prac, zasobów WWW opartych na plikach HTML i

XML, itd.

Heterogeniczność (niejednorodność)

Np. system Intranetowy może składać się ze sprzętu:

•

•

•

•

•

komputerów klasy mainframe

stacji roboczych UNIX

komputerów PC pracujących pod MS Windows

komputerów Apple Macintosh

central telefonicznych, robotów, zautomatyzowanych linii

produkcyjnych

...włączać różnorodne protokoły komunikacyjne: Ethernet,

FDDI, ATM, TCP/IP, Novell Netware, protokoły oparte na

RPC,...

...bazować na różnych systemach zarządzania bazą

danych/dokumentów: Oracle,SQL Server, DB2, Lotus

Notes,....

...oraz wymieniać pomiędzy sobą niejednorodne dane,

podlegające różnym modelom danych, schematom,

Przyczyny heterogeniczności

Niezależność działania: wytwórcy systemów nie uzgadniają między sobą

ich cech. Standardy, o ile się pojawiają, są spóźnione, niekompletne i nie

przestrzegane w 100%.

Konkurencja: wytwórcy systemów starają się wyposażyć systemy w

atrakcyjne cechy, których nie posiadają konkurujące systemy

Różnorodność pomysłów: Nie zdarza się, aby było jedno rozwiązanie

dla złożonego problemu. Różne zespoły znajdują różne rozwiązania,

bazujące często na odmiennych celach i założeniach.

Efektywność finansowa i kompromisy: Wytwórcy oferują produkty o

różnej cenie, funkcjonalności i jakości, zgodnie z wyczuciem

potencjalnych potrzeb klientów, dostosowaniem się do ich portfela i

maksymalizacją swoich zysków.

Systemy spadkowe (legacy): Systemy, które dawno zostały wdrożone i

działają efektywnie, nie mogą być z tego działania wyłączone. Nie jest

możliwe (lub jest bardzo kosztowne) zastąpienie ich nowymi systemami.

Nowe systemy, o podobnym przeznaczeniu, posiadają inne założenia,

Przenaszalność

portability

Typy przenaszalności:

• Na poziomie składni, koncepcji języka i edukacji (np. SQL-92).

• Na poziomie kodu źródłowego (np. C++ (?), JDBC).

• Na poziomie interpretowanego kodu skryptowego lub pośredniego (np. Java).

• Na poziomie kodu binarnego (? - trudno podać przykład).

Przenaszalność wymaga precyzyjnej specyfikacji składni i

semantyki języka, oraz wyeliminowania z niego własności

specyficznych dla poszczególnych platform.

Wiele standardów nie spełnia kryterium przenaszalności z powodu

niedospecyfikowania i/lub nie spełniania standardu przez

wytwórców systemów.

Przenaszalność jest celem standardów SQL, CORBA oraz ODMG,

niekoniecznie celem już osiągniętym.

Przenaszalność realizuje kod pośredni języka Java, ale dotyczy to

funkcjonalności niskiego poziomu, np. nie dotyczy API do baz

danych.

Autonomia

autonomy

Autonomia lokalnej bazy danych w federacji baz danych oznacza, że:

Lokalne dane podlegają lokalnym priorytetom, regułom własności,

autoryzacji dostępu, bezpieczeństwa, itd. Lokalna baza danych może

odrzucić zlecenia przychodzące z federacji, o ile naruszają one lokalne

ograniczenia lub zbytnio obciążają czas procesora lub inne lokalne

zasoby.

Lokalna baza danych może udostępniać aplikacjom działającym na

federacji baz danych tylko określoną część swoich danych i usług.

Programiści tych aplikacji nie mają jakichkolwiek środków dostępu do

pozostałych danych i usług.

Włączenie lokalnej bazy danych do federacji nie może powodować

konieczności zmiany programów aplikacyjnych działających na lokalnej

BD.

Federacja może przetwarzać lokalne zasoby tylko poprzez interfejs

programowania aplikacji (API) specyficzny dla lokalnego systemu. Inne

metody (np. bezpośredni dostęp do plików) są niedozwolone.

Możliwa

jest pewna

autonomii.

autonomii

jest raczej

intuicyjne.

Federacja

nieskala

może

żądać odPojęcie

lokalnej

bazy danych

zmiany/rozszerzenia

Niezależność danych

data independence

Oznacza, że nie ma potrzeby zmiany kodu programów aplikacyjnych mimo

zmian organizacji lub schematów danych. Jest osiągana poprzez interfejsy

programistyczne umożliwiające dostęp do danych na odpowiednim poziomie

abstrakcji, gdy niewidoczne są szczegóły organizacji i implementacji danych.

Fizyczna niezależność danych: ukrycie detali organizacji

fizycznej i technik dostępu, dzięki czemu możliwa jest ich zmiana

bez wpływu na kod aplikacji.

Logiczna niezależność danych: umożliwienie niektórych zmian

schematu logicznego bez wpływu na kod aplikacji, np. dodanie

atrybutów do relacji, zmiana kolejności atrybutów, zmiana ich

typów, utworzenie nowych relacji, itd.

Ewolucja schematu (schema evolution): umożliwienie daleko

idących zmian schematu danych przy jednoczesnym utworzeniu

perspektyw (views) dla starych lub nowych danych. Perspektywy

mają umożliwić minimalną pracochłonność przy zmianach aplikacji

(idealistycznie).

Ontologia

ontology

W filozofii: nauka o bytach, teoria bytu, opis charakteru i struktury

rzeczywistości, specyfikacja konceptualizacji.

W sztucznej inteligencji: formalna specyfikacja (przy użyciu logiki

matematycznej) obiektów, pojęć i innych bytów, które istnieją w

pewnej dziedzinie, oraz formalna specyfikacja związków, które

pomiędzy tymi bytami zachodzą.

• Podejście sztucznej inteligencji jest naiwne.

• Np. Giełda Papierów Wartościowych: wiele tysięcy stron aktów

prawnych, zarządzeń, regulacji, itd. Jako (dożywotnia) kara dla

sztucznego (ćwierć-) inteligenta wypisującego bzdury na temat

"formalnej ontologii": niech to zapisze przy użyciu formuł rachunku

predykatów.

W biznesie (ontologia biznesowa, business ontology): wszystko to,

co projektanci systemów informatycznych powinni wiedzieć o

biznesie, aby poprawnie napisać aplikacje wspomagające ten

biznes. Wiedza ta powinna być formalnie zapisana. "Formalnie"

oznacza zwykle pewien standardowy i uzgodniony język, np.

Ontologia i metadane

Głównym celem prac na biznesową ontologią jest standardyzacja

następujących elementów:

• Gramatyki opisów poszczególnych bytów,

• Nazw i znaczeń nazw obowiązujących w ramach danego

biznesu (np. co oznaczają słowa "autor", "klient", "instrument",

"akcja", itd.),

• Ograniczeń związanych z opisywanymi bytami,

• Metadanych związanych z bytami (autor opisu, data stworzenia

opisu, data ostatniej aktualizacji, itd.),

• Dopuszczalnych operacji na bytach.

W tym zakresie zapis ontologii jest pewną meta-bazą danych, w

które ustala się zarówno strukturę samej bazy danych, jak i pewne

dodatkowe informacje (meta-atrybuty) będące podstawą

przetwarzania bazy danych.

Nieco inne podejście prezentuje standard RDF opracowany przez

W3C, gdzie ontologię reprezentują wyrażenia RDF.

Metadane

Metadane są kluczowe dla wielu rozproszonych aplikacji, ponieważ

umożliwiają rozpoznanie z zewnętrz własności lokalnego zasobu

danych

Ogólna definicja: są to dane o danych - co dane zawierają, jaką

mają budowę, jakie jest ich znaczenie, jakim podlegają

ograniczeniom, jak są zorganizowane, przechowywane,

zabezpieczane, udostępniane, itd.

Metadane są pewnym rozszerzeniem pojęcia schematu bazy

danych, albo też pewną implementacją tego schematu w postaci

katalogów.

Metadane przykrywają także informację niezależną od treści

samych danych, np. kiedy pewna dana została utworzona, w jakim

jest formacie, kto jest jej autorem, do kiedy jest ważna, itd.

Opisy danych zawarte w metadanych mają dwie podstawowe

zalety:

• Zawierają wspólne abstrakcje dotyczące reprezentacji danych, takie

jak format; ogólnie "wyciągają przed nawias" wszystkie wspólne

Klasyfikacja metadanych

Metadane niezależne od treści danych: lokacja danych, data

modyfikacji, typ kamery służącej do sporządzenia zdjęcia, itd.

Mimo, że nie składają się bezpośrednio na treść danych, mogą być

ważnym kryterium wyszukiwania.

Metadane zależne od treści danych: rozmiar dokumentu, liczba

kolorów, liczba wierszy, liczba kolumn w tabeli. Metadane zależne

od treści mogą być dalej podzielone na:

• Bezpośrednie metadane dotyczące treści, np. indeksy, klasyfikacje,

itd.

• Metadane opisujące treść: adnotacje o zawartości zdjęcia, np. opis

zapachu kwiatu przedstawionego na zdjęciu.

• Metadane niezależne od dziedziny biznesowej, której dotyczy treść,

np. definicje typu dokumentu HTML/SGML

• Metadane zależne od dziedziny biznesowej, np. schemat danych lub

opis ontologii biznesowej

Podział na dane i metadane nie jest do końca jasny i silnie zależy

od nastawienia projektanta i podziału zadań podczas redakcji treści

Protokół wymiany informacji

w rozproszonej BD

Protokół wymiany informacji pomiędzy rozproszonymi miejscami

musi uwzględniać:

• przesyłanie danych z jednego miejsca do drugiego miejsca

• przesyłanie zleceń (np. zapytań) do odległych miejsc celem

przetwarzania danych

• zwrotne przesyłanie wyników tych zleceń do zlecającego klienta

• automatyczną dystrybucję niektórych metadanych (np. schematu BD)

pomiędzy uczestników rozproszonej bazy danych.

• przesyłanie zapytań dotyczących metadanych

• przekazywanie wyników zapytań dotyczących metadanych do

pytającego

Aktualnie, protokoły takie istnieją w bardzo uproszczonej lub silnie

wyspecjalizowanej formie

• IIOP (Internet Inter-Orb Protocol) - bardzo uproszczony

• LDAP (Lightweight Directory Access Protocol) - silnie

wyspecjalizowany

Wiele ośrodków prowadzi prace badawcze nad uniwersalnymi

Migracje obiektów

Migracja: przemieszczanie się obiektów między węzłami sieci, przy czym

obiekty muszą być skojarzone (statycznie lub dynamicznie związane) ze

swoimi klasami i przechowywanymi w ramach tych klas metodami. Problemy:

Określenie jednostki migracji

Śledzenie obiektów

Utrzymywania porządku w katalogu systemu bazy danych

Okresowa kondensacja łańcuchów obiektów pośrednich

Przemieszczanie obiektów złożonych

Zapewnienie globalnej przestrzeni nazw

Zapewnienie właściwych mechanizmów zakresu i wiązania

Dostępność metod umożliwiających przetwarzanie obiektów

Jak dotąd, metody są najczęściej składowymi aplikacji, a nie bazy danych.

Konsekwencją jest to, że po przemieszczeniu obiektu aplikacja działająca w jego

nowym miejscu musi mieć wbudowane (powielone, skompilowane, zlinkowane)

metody do jego przetwarzania.

Oprogramowanie komponentowe

Komercyjny buzzword, niezrealizowane marzenie informatyków od 30 lat.

Oznacza technologie zmierzające do budowy standardów oraz

wspomagającego je oprogramowania, które pozwoliłoby na składanie

dużych aplikacji lub systemów z mniejszych standardowych części komponentów, na zasadzie podobnej do składania komputera z

podzespołów.

Inne terminy: mega-programming, programming-in-the-large.

Jako przykłady komponentowego podejścia wymienia się: OMG CORBA, OpenDoc firm

Apple, IBM i innych, technologia .NET/COM/DCOM, Java Beans i Enterprise Java Beans.

Komponenty odnoszą wiele sukcesów. Istnieją jednak problemy

utrudniające szerokie ich stosowanie, tj:

problemy z osiągnięciem akceptowalnej wydajności,

trudności w precyzyjnym a jednocześnie dostatecznie

abstrakcyjnym wyspecyfikowaniu interfejsów pomiędzy

komponentami,

dynamiczny postęp w informatyce, powodujący pojawianie się

coraz to nowych wymagań na interfejsy.

Obiektowość w systemach

rozproszonych

Obiektowość w rozproszonych bazach

danych

Obiektowość zakłada zwiększenie stopnia abstrakcji,

przystosowanie modeli realizacyjnych systemów informatycznych

do naturalnych konstrukcji i obrazów myślowych projektantów,

programistów i użytkowników.

Główny problem - opanowanie złożoności przy wytwarzaniu

oprogramowania.

Punktem zainteresowania twórców narzędzi informatycznych

stają się procesy myślowe zachodzące w umysłach osób

pracujących nad oprogramowaniem => modelowanie

pojęciowe.

Obiektowość przerzuca ciężar problemu z kwestii narzędziowej (jak

mam to zrobić?) na kwestię merytoryczną (co mam zrobić i po

co?).

Źródła złożoności projektu oprogramowania

Zespół projektantów

Dziedzina problemowa,

obejmująca ogromną liczbę

wzajemnie uzależnionych

aspektów i problemów.

Środki i technologie

informatyczne:

sprzęt, oprogramowanie, sieć,

języki, narzędzia, udogodnienia.

Oprogramowanie:

decyzje strategiczne,

analiza,

projektowanie,

konstrukcja,

dokumentacja,

wdrożenie,

szkolenie,

eksploatacja,

pielęgnacja,

modyfikacja.

podlegający ograniczeniom

pamięci, percepcji, wyrażania

informacji i komunikacji.

Potencjalni użytkownicy:

czynniki psychologiczne,

ergonomia, ograniczenia pamięci

i percepcji, skłonność do błędów

i nadużyć, tajność, prywatność.

Jak walczyć ze złożonością ?

Zasada dekompozycji:

rozdzielenie złożonego problemu na podproblemy, które można rozpatrywać i

rozwiązywać niezależnie od siebie i niezależnie od całości.

Zasada abstrakcji:

eliminacja, ukrycie lub pominięcie mniej istotnych szczegółów rozważanego

przedmiotu lub mniej istotnej informacji; wyodrębnianie cech wspólnych i

niezmiennych dla pewnego zbioru bytów i wprowadzaniu pojęć lub symboli

oznaczających takie cechy.

Zasada ponownego użycia:

wykorzystanie wcześniej wytworzonych schematów, metod,

komponentów projektu, komponentów oprogramowania, itd.

wzorców,

Zasada sprzyjania naturalnym ludzkim własnościom:

dopasowanie modeli pojęciowych i modeli realizacyjnych systemów do

wrodzonych ludzkich własności psychologicznych, instynktów oraz mentalnych

mechanizmów percepcji i rozumienia świata.

Modelowanie pojęciowe

Projektant i programista muszą dokładnie wyobrazić sobie problem

oraz metodę jego rozwiązania. Zasadnicze procesy tworzenia

oprogramowania zachodzą w ludzkim umyśle i nie są związane z

jakimkolwiek językiem programowania.

Pojęcia modelowania pojęciowego (conceptual modeling) oraz

modelu pojęciowego (conceptual model) odnoszą się procesów

myślowych

i

wyobrażeń

towarzyszących

pracy

nad

oprogramowaniem.

Modelowanie pojęciowe jest wspomagane przez środki

wzmacniające ludzką pamięć i wyobraźnię. Służą one do

przedstawienia rzeczywistości opisywanej przez dane, procesów

zachodzących w rzeczywistości, struktur danych oraz programów

składających się na konstrukcję systemu.

Perspektywy w modelowaniu pojęciowym

odwzorowanie

odwzorowanie

...

... ......

... ......

...

Percepcja

rzeczywistego

świata

Analityczny

model

rzeczywistości

... ...

... ...

...

...

... ...

... ...

Model

struktur danych

i procesów SI

Trwałą tendencją w rozwoju metod i narzędzi projektowania oraz

konstrukcji SI jest dążenie do minimalizacji luki pomiędzy

myśleniem o rzeczywistym problemie a myśleniem o danych i

procesach zachodzących na danych.

Przykład: pojęciowy schemat obiektowy w UML

Osoba

Nazwisko

Imię *

Adres *

Pracownik

Zawód *

0..*

PZ

1

Zatrudnienie

Wypłata *

0..*

Ocena *

FZ

Firma

Nazwa

1 Miejsce *

Nie więcej niż 10 sekund zastanawiania się, co ten diagram przedstawia

i jak jest semantyka jego elementów.

Potem można już programować np. w C++ lub Java.

Co otrzymamy po odwzorowaniu tego schematu na schemat relacyjny?

Schemat relacyjny

Firma(NrF, Nazwa)

Zatrudnienie(NrF, NrP)

Lokal(NrF, Miejsce)

Pracownik(NrP, NrOs)

Oceny(NrOceny, Ocena, NrF, NrP)

Dochód(NrDochodu, Wypłata, NrF, NrP)

Osoba(NrOs, Nazwisko)

Wyszkolenie(Zawód, NrP)

Imiona(NrOs, Imię)

Adresy(NrOs, Adres)

Jest to jedno z kilku możliwych rozwiązań.

Schemat relacyjny jest trudniejszy do odczytania i zinterpretowania przez

programistę. Będzie on musiał co najmniej 10 minut zastanawiać się, co ten

diagram reprezentuje i jaką semantykę mają atrybuty i zaznaczone powiązania.

Efektem jest zwiększona skłonność do błędów (mylnych interpretacji).

Skutki niezgodności modelu pojęciowego i

relacyjnego

Programy odwołujące się do schematu relacyjnego są dłuższe od programów

odwołujących się do schematu obiektowego (szacunkowo od 30% do 70%). Ma

to ogromne znaczenie dla tempa tworzenia oprogramowania, jego jakości,

pielęgnacyjności, itd. Programy te są też zwykle znacznie wolniejsze.

Mini przykład:

Podaj adresy pracowników pracujących w firmach zlokalizowanych w Radomiu

SBQL: (Firma where ”Radom” in Miejsce).FZ.Zatrudnienie.PZ.Pracownik.Adres

SQL:

select a.Adres

from Lokal as k, Zatrudnienie as z, Pracownik as p, Osoba as s, Adresy as a

where k.Miejsce = “Radom” and k.NrF = z.NrF and z.NrP = p.NrP

and p.NrOs = s.NrOs and s.NrOs =a.NrOs

Zapytanie w SQL jest znacznie dłuższe wskutek tego, że w SQL konieczne są

„złączeniowe” predykaty (takie jak k.NrF=z.NrF i następne) kojarzące

informację semantyczną "zgubioną" w relacyjnej strukturze danych.

Rozproszone obiektowe bazy danych

Problemy są podobne jak w przypadku rozproszonych relacyjnych

BD.

Nie jest jednak pewne czy do przetwarzania zapytań w tych

systemach będą się odnosić te same metody.

Problemy, różniące przetwarzanie zapytań w rozproszonych

obiektowych BD i w rozproszonych relacyjnych BD:

• Obiekty nie zawsze są implementowane jako "płaskie" zapisy.

• Obiekty mogą mieć referencje do obiektów zlokalizowanych w innych

węzłach sieci.

• Przetwarzanie zapytań może dotyczyć kolekcji złożonych obiektów

• Zapytania mogą mieć odwołania do metod.

Przetwarzanie zapytań w rozproszonych systemach obiektowych

jest tematem bardzo istotnym. Standard ODMG tym się nie

zajmuje.

Jak dotąd, w zakresie przetwarzania rozproszonych zapytań nie

rozwiązano podstawowych problemów koncepcyjnych.

Rozproszona obiektowa baza danych

Przedmiotem przetwarzania i wymiany informacji w obiektowej

rozproszonej bazie danych są obiekty. Zarządzanie rozproszonymi

obiektami ma na celu utrzymywanie spójności i przezroczystości

(niewidoczności) geograficznego

rozproszenia

obiektów.

Zapytanie

Aplikacja

użytkownika

użytkownika

Oprogramowanie

klient/serwer

Oprogramowanie

serwera

Oprogramowanie

serwera

Podsystem

komunikacyjny

Oprogramowanie

klient/serwer

Zapytanie

użytkownika

Oprogramowanie

klient/serwer

Aplikacja

użytkownika

Zapytanie

użytkownika

Zalety rozproszonych obiektów

Zgodność z logiką biznesu - bezpośrednia implementacja obiektów

biznesowych.

Umożliwienie projektantom opóźnienie decyzji - gdzie i jakie usługi

powinny być zapewnione.

Skalowalność aplikacji: mała zależność czasu reakcji systemu od

zwiększenia ilości danych, liczby użytkowników, liczby węzłów.

Dekompozycja aplikacji na małe elementy wykonawcze (obiekty,

metody,...).

Przyrostowe dodawanie/odejmowanie funkcjonalności (“płacę tylko za

to, czego używam”).

Podział zasobów i zbalansowanie obciążeń.

Współbieżność i asynchroniczne przetwarzanie.

Elastyczność zmian w oprogramowaniu (konserwacja), w

szczególności, przenoszenie obiektów i usług do innych miejsc.

Możliwość przyłączania aplikacji spadkowych (funkcjonujących

wcześniej jako scentralizowane).

Projektowanie rozproszonych

baz danych

Podejścia do projektowania rozproszonych

BD: top-down i bottom-up

Od ogółu do szczegółów:

top-down

bottom-up

Odgórne zaprojektowanie całej bazy danych,

z uwzględnieniem optymalizacji

przechowywanych danych, narzuconej przez

fakt geograficznego rozproszenia

producentów i konsumentów informacji

przechowywanej w bazie danych.

Od szczegółów do ogółu:

Zintegrowanie już istniejących (spadkowych)

lub zaprojektowanych lokalnych baz danych

w jedną globalną rozproszoną bazę danych.

Projektowanie: podejście top-down

Analiza

Model pojęciowy

scentralizowany

Analiza systemowa: rozpoznanie

wymagań, precyzowanie

kontekstu przyszłej bazy danych.

Projektowanie schematu

pojęciowego

Projektowanie struktury

logicznej

Model logiczny

scentralizowany

Modele logiczne

dla

poszczególnych

miejsc

Kryteria

rozproszenia

Kryteria rozproszenia są

związane z faktem fizycznego

rozproszenia źródeł i

odbiorców danych oraz

autonomii lokalnych baz

danych. Ustalają one decyzje,

które fragmenty projektu

pojęciowego będą

przechowywane w

poszczególnych miejscach, a

Dalsze fazy postępowania

w podejściu top-down

Określenie danych podlegających replikacjom (lokalnych kopii)

oraz strategii replikacji.

Zróżnicowanie logicznego schematu danych w zależności od

typu SZBD w poszczególnych miejscach.

Określenie lokalnych schematów dla poszczególnych miejsc.

Określenie danych autonomicznych dla poszczególnych

miejsc, nie uczestniczących w rozproszonej bazie danych; co

prowadzi do określenia schematu pojęciowego i logicznego dla

danych widzianych z zewnątrz.

Podział schematu logicznego: Wg różnych reguł związanych

na ogół z fizycznym ulokowaniem obiektów rzeczywistych

(np. osób zatrudnionych, sprzętu, co pociąga za sobą

odpowiedni podział schematu logicznego) lub też z fizycznym

ulokowaniem programów aplikacyjnych działających na tych

obiektach.

Fragmentacja

Najpopularniejszym modelem jest fragmentacja

pozioma, oznaczająca, że każdy serwer ma ten sam

schemat danych, ale inną populację danych.

• Sumowanie zbiorów danych w taki sposób, że informacja o

serwerach jest zbędna dla programisty/użytkownika.

Fragmentacja pionowa: podział obiektów na

fragmenty przechowywane w różnych miejscach.

• Musi być zapewniony sposób „sklejenia” całości obiektu z

fragmentów (np. NIP dla obywateli RP).

Przy integracji zasobów mogą pojawiać się

wyrafinowane kombinacje fragmentacji poziomej,

pionowej i replikacji (redundancji).

Podstawowe metody fragmentacji schematu

Fragmentacja pionowa oznacza przyporządkowanie

poszczególnych klas obiektów do poszczególnych miejsc, lub

rozbicie obiektów danej klasy na dwa lub więcej podobiektów,

przy czym takie podobiekty są przechowywane w różnych

miejscach.

Fragmentacja pionowa może oznaczać konieczność

odpowiedniego podziału informacji zawartych w klasach

obiektów oraz ustalenia środków podtrzymania

jednoznacznej tożsamości obiektów.

Fragmentacja pozioma oznacza rozbicie populacji obiektów

danej klasy na dwa lub więcej miejsc geograficznych.

Fragmentacja pozioma może być dokonywana na podstawie

różnych kryteriów, które często wiązane są z geograficznym

ulokowaniem obiektów rzeczywistych, lub też z

geograficznym ulokowaniem przetwarzania tych obiektów.

Fragmentacja pionowa relacyjnej bazy danych

Warszawa

Kutno

DC

DOSTAWCA_DANE

DNR NAZW

D1

D2

D3

D4

D5

Abacki

Bober

Czerny

Dąbek

Erbel

DNR CNR ILOŚĆ

STATUS

20

10

30

20

30

Sieć

Gdańsk

DOSTAWCA_MIASTO

DNR

D1

D2

D3

D4

D5

MIASTO

Lublin

Poznań

Poznań

Lublin

Radom

D1

D1

D1

D1

D1

D1

D2

D2

D3

D4

D4

D4

C1

C2

C3

C4

C5

C6

C1

C2

C2

C2

C4

C5

300

200

400

200

100

100

300

400

200

200

300

400

Fragmentacja pozioma relacyjnej bazy danych

DOSTAWCA

DNR NAZW

D2 Bober

D3 Czerny

Poznań

DC

DNR CNR ILOŚĆ

STATUS MIASTO

10 Poznań

30 Poznań

D2

D2

D3

C1

C2

C2

300

400

200

Lublin

DOSTAWCA

Sieć

DNR NAZW

STATUS MIASTO

D1 Abacki

D4 Dąbek

20 Lublin

20 Lublin

DC

DOSTAWCA

DNR NAZW

D5 Erbel

Radom

STATUS MIASTO

30 Radom

DNR CNR ILOŚĆ

D1

D4

D4

C6

C2

C4

100

200

300

Przykład fragmentacji poziomej

Radom

Klasa

Pracownik

Pracownik

Nowak

Pracownik

Kowalski

Obiekty Pracownik są

przechowywane zgodnie z

geograficznym położeniem

pracodawcy.

...

Kalisz

Sieć

Pracownik

Styka

Kielce

Pracownik

Malasa

Klasa

Pracownik

Pracownik

Zagórny.

...

Klasa

Pracownik

Pracownik

Malina

...

Fragmentacja pionowa obiektów Pracownik

Radom

Klasa danych

osobistych

Nowak

dane osobiste

Kowalski

dane osobiste

...

Kalisz

Sieć

Nowak

dane o ocenach

Kraków

Nowak

dane o zatrud.

Klasa danych o

zatrudnieniu

Kowalski

dane o zatrud.

...

Klasa danych o

ocenach

Kowalski

dane o ocenach

...

Fragmentacja danych

Inne fragmentacje danych w rozproszonej BD

Możliwe są inne, bardziej złożone fragmentacje danych, które łączą

fragmentacje pionowe, fragmentacje poziome oraz redundantne

dane (replikacje).

Bardziej złożone fragmentacje rodzą trudności z:

• zarządzaniem metadanymi: gdzieś muszą być ulokowane

informacje odnośnie tego w jaki sposób podzielone dane mają

być scalone w kompletne obiekty lub kolekcje w ramach

rozproszonej bazy danych. Jest to rola metadanych oraz

mechanizmu właściwej dystrybucji metadanych pomiędzy

uczestników rozproszonej bazy danych.

• przetwarzaniem zapytań: dekompozycja zapytania na podzapytania adresowane do poszczególnych miejsc staje się

znacznie bardziej kłopotliwa. Przesyłanie fragmentów obiektów

celem ich zmaterializowania po stronie klienta może być zbyt

kosztowne.

Bardziej złożone fragmentacje mogą być nie do uniknięcia w

rozproszonej bazie danych integrującej istniejące bazy danych

Replikacje

Replikacja jest kopią danych i usług na innym serwerze.

Replikacje mają na celu zwiększenie dostępności danych i

usług oraz ich ochronę przed zniszczeniem.

Przy integracji bottom-up replikacje (redundancje) są

często cechą nieuchronną i niepożądaną.

• Może występować redundancja danych o dowolnym stopniu

skomplikowania.

Replikacje i redundancje stanowią poważny problem dla

przezroczystości i operacji aktualizacji danych.

Projektowanie: podejście bottom-up

Podejście ad hoc: Budowa uniwersalnych lub specyficznych dla

danego zastosowania pomostów (gateways) umożliwiających

dostęp z danego systemu bazy danych do innych baz danych.

Pomost może (nie musi) zapewniać przezroczystość rozproszenia.

Podejście oparte o globalny schemat: Wszystkie składniki

rozproszonej BD są objęte jednym globalnym schematem,

jednakowym dla każdego miejsca i zapewniającym

przezroczystość rozproszenia. Istotną wadą podejścia opartego na

globalnym schemacie jest brak możliwości sterowania zakresem

autonomii każdego lokalnego systemu.

Federacyjna baza danych: Każda lokalna baza danych

zachowuje swoją autonomię, udostępniając tylko część danych dla

innych miejsc w RBD. Podejście federacyjne zakłada, że każda

lokalna baza danych jest widziana poprzez pewną perspektywę

(view), ukrywającą niektóre dane dla rozproszonych aplikacji.

Replikacja

Federacyjna BD tworzona metodą bottom-up

Aplikacje

globalne

Aplikacje

Aplikacjeglobalne

globalne

Schemat federacyjnej bazy danych

Perspektywa

Mediator

Osłona

Perspektywa

Mediator

Osłona

Schemat lokalny 1

Miejsce 1

Aplikacje

Aplikacje

Aplikacje

lokalne

lokalne

lokalne

Schemat lokalny 2

Miejsce 2

Baza

danych 1

Aplikacje

Aplikacje

Aplikacje

lokalne

lokalne

lokalne

Baza

danych 2

.....

Podejście federacyjne okazało się skuteczne ze względu na zapewnienie

autonomii, bezpieczeństwa i efektywności. Rodzi jednak dużo problemów, m.in.

z zapewnieniem jednolitej ontologii biznesowej, uniwersalnością aplikacji,

wydajnością, itd.

Architektury rozproszonych

baz danych

Architektura klient - serwer

Serwer - komputer (proces) oferujący określony rodzaj

usługi

Klient - komputer (proces) korzystający z usługi

Klient

Klient

Klient

Serwer

Klient

Architektura klient-serwer

Całość pracy wykonywanej przez system komputerowy jest

podzielona na dwie części:

wykonywaną po stronie klienta

(zwykle związaną z interakcją z

użytkownikiem)

Podstawowe

problemy:

wykonywaną po stronie serwera

(komunikacja, dostęp do bazy danych,

zarządzanie repozytoriami pamięci,

zarządzanie globalną przestrzenią

nazw)

Określenie mechanizmu komunikacji pomiędzy

klientem a serwerem.

Podział funkcji na te, które są wykonywane po stronie

klienta i te, które są wykonywane po stronie serwera

Określenie jednostki komunikacji klient - serwer

Heterogeniczne środowisko

w architekturze klient-serwer

Windows 95

Client

Windows NT

Client

UNIX

Client

Windows 95

or NT

Client

TCP/IP network

Windows NT Server

with repository on

SQLserver

UNIX Server

with repository on

Informix

Architektury serwerów w dostępie do bazy

danych

Serwer plików,

Serwer SQL,

Serwer obiektów,

Serwer stron.

Architektura z serwerem plików

klient

Aplikacja po stronie

klienta odwołuje się

do danych

umieszczonych w

pliku bazy danych

Zapotrzebowanie na

odczyt/zapis

danych w plikach

Odczytane dane z

plików bazy danych

serwer

Alokacja pamięci

WE/WY

obsługa plików z bazą

danych

Transfer plików

Protokół FTP (File Transfer Protocol)

Usługa FTP:

• kopiowanie plików z komputerów odległych do komputera

użytkownika

• kopiowanie plików z komputera użytkownika do komputerów

odległych

Dostęp do danych (ograniczony, system weryfikacji

użytkownika)

Środowisko pracy:

• tekstowe (program ftp w środowisku systemowym)

• graficzne (dedykowane aplikacji komercyjne, przeglądarki)

Procedura transferu plików

Podłączenie się do serwera odległego

Wejście użytkownika do systemu plików

Nawigacja w strukturze katalogów

Określenie rodzaju transferu

Pobranie/osadzenie plików

Zamknięcie połączenia

Typowe instrukcje usługi FTP

open - podłączenie się do serwera

user - wejście użytkownika do systemu (ftp, anonymous)

close - zamknięcie połączenia

dir - wyświetlenie zawartości katalogu na serwerze

cd - zmiana katalogu bieżącego na serwerze

lcd - zmiana katalogu bieżącego na komputerze klienta

bin - binarny rodzaj transferu

asc - znakowy rodzaj transferu

put - przesłanie pliku z komputera klienta do serwera

get - pobranie pliku z serwera

mput - przesłanie plików z komputera klienta do serwera

mget - pobranie plików z serwera

Architektura z serwerem SQL

Aplikacja klienta

zadaje zapytanie

SQL

Zarządzanie

kursorem

klient

Zapytanie SQL

Maszyna SQL

krotka

serwer

Architektura z serwerem stron

klient

aplikacja

Menadżer

obiektów

serwer

Pamięć

podręczna

stron

Menadżer

plików/indeksów

Menadżer stron

pamięci

podręcznej

Alokacja pamięci

WE/WY

strony

Pamięć

podręczna

obiektów

Pamięć

podręczna

stron

Menadżer Menadżer

stron pamięci dziennika

podręcznej blokowania

Architektura serwera stron

Aplikacja

Przedmiotem

zarządzania

są fizyczne

strony dyskowe

Interfejs

zapytaniowy

Optymalizacja

zapytań

Przeglądarka

obiektów

Interfejs

programistyczny

Zarządzanie obiektami

Zarządzanie plikami i indeksami

Zarządzanie kieszenią stron

strony

Zarządzanie zamkami

Zarządzanie składem

Zarządzanie kieszenią stron

Obiektowa

baza

danych

Architektura z serwerem obiektów

klient

serwer

Pamięć

podręczna

obiektów

Aplikacja

Menadżer

plików/indeksów

Menadżer

stron pamięci

odręcznej

Menadżer

obiektów

obiekty

Pamięć

podręczna

obiektów

Menadżer Menadżer

obiektów dziennika

blokowania

Alokacja pamięci

WE/WY

Pamięć

podręczna

stron

Architektura serwera obiektów

Aplikacja

Przedmiotem

zarządzania

są obiekty

Interfejs

zapytaniowy

Przeglądarka

obiektów

Interfejs

programistyczny

Zarządzanie obiektami

obiekty

Zarządzanie obiektami

Optymalizacja zapytań

Zarządzanie zamkami

Zarządzanie składem

Zarządzanie stronami i kieszeniami

Obiektowa

baza

danych

Reguły architektury klient-serwer (1)

Zachowanie autonomii serwera. Klienci powinni zachowywać

reguły wykorzystania serwera, nie powinni powodować jego

niedostępność (np. zamykać duże ilości danych), nie powinni

łamać ograniczeń integralności.

Zachowanie autonomii klienta. Klienci nie powinni zachowywać

się różnie w zależności od tego, czy serwer jest lokalny czy odległy.

Powinni być odizolowani od kwestii fizycznego ulokowania danych.

Wspomaganie dla aplikacji niezależnych od serwera.

Dostęp do własności (danych, usług) serwera. Klienci mogą

żądać od serwera wykonanie przewidzianych dla niego funkcji.

Wspomaganie dla bieżącego dostępu do danych. Dostęp ten

powinien być bezpośredni, bez pośrednictwa plików

przekazywanych do/od klienta.

Minimalny wpływ architektury K/S na wymagania dla klienta.

Oprogramowanie klienta w architekturze K/S nie powinno

wykazywać znacznego zwiększenia zapotrzebowania na RAM lub

Reguły architektury klient-serwer (2)

Kompletność opcji niezbędnych do połączenia. Oprogramowanie

klienta nie powinno zawierać kodu realizującego połączenie z

serwerem.Powinien to zapewniać serwer komunikacyjny.

Możliwość budowy lokalnych prototypów. Programista powinien mieć

możliwość budowy i testowania aplikacji K/S wyłącznie na stacji klienta.

Kompletność narzędzi użytkownika końcowego. Projektowanie

ekranów, generacja zapytań, itd. powinny być częścią środowiska.

Kompletność środowiska budowy aplikacji. Powinno przewidywać

możliwość łączenia się w sieci, dostęp do usług globalnych w zakresie

nazw, lokacji danych, itd.

Otwarte środowisko języka-gospodarza. Powinno zapewniać

możliwość użycia uniwersalnego języka programowania do budowy

aplikacji.

Szczególna troska o standardy. Im bardziej będą one przestrzegane,

tym mniej będzie późniejszych kłopotów ze współdziałaniem.

Przykład architektury SZBD typu klient-serwer

Aplikacja generująca transakcje

Aplikacja generująca transakcje

Zarządzanie

transakcjami

Zarządzanie

transakcjami

Zarządzanie

buforami

...

Zarządzanie

buforami

Zarządzanie zasobami

Zarządzanie zasobami

Klient 1

Klient n

Zarządzanie

siecią

Interfejs serwera

Zarządzanie

zasobami

Zarządzanie

transakcjami

Zarządzanie

logiem

Serwer

Zarządzanie

buforami

Zarządzanie

zamkami

Architektura klient-(multi) serwer (1)

Połączenia bezpośrednie:

k2

k3

k7

k1

s4

k4

k5

s1

k8

s3

s2

k9

k6

k10

k11

Architektura klient-(multi) serwer (2)

Połączenia poprzez sieć: nie ma bezpośrednich połączeń, zarówno serwery jak i

klienci są przyłączani w jednakowy sposób do wspólnej sieci komputerowej.

k2

k1

s4

k3

k9

k4

Sieć komputerowa

s1

k8

s3

k5

k6

s2

k7

Architektura trzywarstwowa i wielowarstowa

three-tier architecture

multi-tier architecture

Architektura klient-serwer podzielona na trzy

warstwy:

• interfejs użytkownika,

• logikę przetwarzania (reguły biznesu, logikę

biznesu)

Interfejs

użytkownika

• serwer (serwery) bazy danych.

Warstwy są zaprojektowane i istnieją niezależnie,

co ma duże znaczenie dla pielęgnacyjności

systemu ze względu na możliwość zmian w

dowolnej warstwie bez konieczności zmian w

pozostałych warstwach.

Często warstwy są zrealizowane na odrębnych

platformach: interfejs na MS Windows, logika

przetwarzania na serwerze aplikacji i baza

danych na serwerze bazy danych.

Środkowa warstwa może składać się z wielu

warstw, co jest określane jako architektura

Logika przetwarzania

Serwer

bazy

danych

Serwer

bazy

danych

Logiczna architektura oprogramowania

Architektura klient-serwer powinna odzwierciedlać logiczny podział

oprogramowania na części. Nie jest to tak istotne w systemie scentralizowanym.

Architektura trójwarstwowa:

cienki

klient

Warstwa prezentacyjna

(interfejs użytkownika)

gruby

klient

Warstwa przetwarzania

(logika biznesu)

Warstwa zarządzania

bazą danych

Staranne rozdzielenie tych warstw jest

bardzo istotne z punktu widzenia

tworzenia i modyfikowalności

oprogramowania. Dzięki temu

rozdzieleniu, możliwa jest np. poprawa

interfejsu użytkownika bez jakichkolwiek

interwencji w pozostałe warstwy

oprogramowania.

Zasada oddzielania aspektów

(separation of concerns principle,

E.Dijkstra)

Cienki i gruby klient

Terminy cienki klient (thin client) oraz gruby klient (fat client) odnoszą się do

mocy i jakości przetwarzania po stronie klienta w architekturze klient-serwer.

Model cienkiego klienta: klient posiada niezbyt wielką moc przetwarzania,

ograniczoną do prezentacji danych na ekranie. Przykładem jest klient w postaci

przeglądarki WWW.

Model grubego klienta: klient posiada znacznie bogatsze możliwości

przetwarzania, w szczególności może zajmować się nie tylko warstwą

prezentacji, lecz także warstwą przetwarzania aplikacyjnego (logiki biznesu).

Powyższy podział posiada oczywiście pewną gradację.

Model cienkiego klienta jest najczęstszym rozwiązaniem w sytuacji, kiedy

system scentralizowany jest zamieniany na architekturę klient-serwer. Wadą jest

duże obciążenie serwera i linii komunikacyjnych.

Model grubego klienta używa większej mocy komputera klienta do

przetwarzania zarówno prezentacji jak i logiki biznesu. Serwer zajmuje się tylko

obsługą transakcji bazy danych. Popularnym przykładem grubego klienta jest

bankomat. Zarządzanie w modelu grubego klienta jest bardziej złożone.

Architektury dwuwarstwowe

Uproszczone architektury trójwarstwowe z cienkim lub grubym klientem.

cienki

klient

Warstwa prezentacyjna

(interfejs użytkownika)

Warstwa przetwarzania

(logika biznesu) +

Warstwa zarządzania

bazą danych

Warstwa prezentacyjna

(interfejs użytkownika)

+ Warstwa przetwarzania

(logika biznesu)

gruby

klient

Warstwa przetwarzania

(logika biznesu) +

Warstwa zarządzania

bazą danych

W tym modelu przetwarzanie

(logika biznesu) jest dzielone

pomiędzy klienta i serwera.

Zaprojektowanie jej jest trudniejsze.

Przykład architektury K/S - sieć bankomatów

Bankomat

Bankomat

Serwer kont klientów banku

Monitor

Baza danych kont

tele-przetwarzania klientów banku

Bankomat

Bankomat

Oprogramowanie pośredniczące

organizujące komunikację z odległymi

klientami i szeregujące transakcje klientów

celem przetwarzania ich przez bazę danych.

Przykład architektury K/S - portal WWW

klient

interakcja

poprzez

HTTP

Serwer Web:

klient

klient

klient

generacja

dynamicznych stron

HTML dla klienta

+

zlecenia do bazy

danych

zapytania

SQL

wyniki

zapytań

SQL

Serwer bazy

danych:

wykonywanie

zapytań w SQL

3-warstwowa architektura aplikacji Web

Serwer Web

Sieć

Internet

Serwer aplikacji

Serwer bazy danych

HTTP

Baza

danych

Przeglądarka

Serwer

Baza

danych

2-warstwowa architektura aplikacji Web

Wiele warstw pośredniczących powoduje dodatkowe obciążenie.

Sieć

Internet

Serwer Web

Serwer aplikacji

Serwer bazy danych

HTTP

Baza

danych

Przeglądarka

Serwer

Baza

danych

Zastosowanie różnych architektur K/S

Dwuwarstwowa architektura K/S z cienkim klientem

• Systemy spadkowe (legacy), gdzie oddzielenie przetwarzania i zarządzania

danymi jest niepraktyczne.

• Aplikacje zorientowane na obliczenia, np. kompilatory, gdzie nie występuje lub

jest bardzo mała interakcja z bazą danych.

• Aplikacje zorientowane na dane (przeglądanie i zadawanie pytań) gdzie nie

występuje lub jest bardzo małe przetwarzanie.

Dwuwarstwowa architektura K/S z grubym klientem

• Aplikacje w których przetwarzanie jest zapewnione przez wyspecjalizowane

oprogramowanie klienta, np. MS Excel.

• Aplikacje ze złożonym przetwarzaniem (np. wizualizacją danych,

przetwarzaniem multimediów).

• Aplikacje ze stabilną funkcjonalnością dla użytkownika, użyte w środowisku z

dobrze określonym zarządzaniem.

Trzywarstwowa lub wielowarstwowa archiktektura K/S

• Aplikacje o dużej skali z setkami lub tysiącami klientów.

• Aplikacje gdzie zarówno dane jak i aplikacje są ulotne (zmienne).

• Aplikacje integrujące dane z wielu rozproszonych źródeł.

Architektura rozproszonych obiektów

W architekturze klient-serwer istnieje wyraźna asymetria pomiędzy

klientem i serwerem; w szczególności, nie występuje tam komunikacja

bezpośrednio pomiędzy klientami. Model taki dla wielu zastosowań jest

mało elastyczny i zapewnia zbyt małą skalowalność.

Architektura rozproszonych obiektów znosi podział na klientów i

serwery. Każde miejsce w rozproszonym systemie jest jednocześnie

klientem i serwerem.

Konieczne jest sprowadzenie wszystkich danych i usług do jednego

standardu.

Taki standard obejmuje:

• Model (pojęciowy i logiczny) danych i usług, który jest w stanie "przykryć"

wszystkie możliwe dane i usługi, które mogą kiedykolwiek pojawić się w

systemie rozproszonym;

• Specjalne oprogramowanie zwane pośrednikiem (broker), które akceptuje

wspólny model danych i usług umożliwiając ich udostępnienie dla dowolnych

miejsc w systemie rozproszonym.

• Specjalne oprogramowanie, zwane osłoną, adapterem lub mediatorem, które

Architektura klient-broker-serwer

Dostęp do odległych zasobów sieci komputerowej odbywa

się miedzy klientem (klientami) a serwerem (serwerami) nie

odbywa się bezpośrednio lecz za pomocą pośrednika

(brokera)

Pośrednik zapewnia przezroczystość do odległych

geograficznie zasobów,

Broker przedstawia wszystkie zasoby w postaci zbioru

obiektów, dzięki czemu możliwe jest ujednolicenie operacji

wykonywanych na zasobach, niezależnie od ich

implementacji i realizacji wewnętrznej,

Fizyczna lokalizacja obiektów nie jest istotna dla

użytkownika, gdyż położenie obiektów znane jest brokerowi,

Pośrednik otrzymuje zadanie od klienta, lokalizuje serwer z

potrzebnymi zasobami, przekazuje zlecenie oraz

przekazuje zwrotnie wynik zlecenia zrealizowanego przez

Architektura klient-broker-serwer

Host klienta

Host serwera

zlecenie

Wywołanie

operacji

Klient

Pośrednik (Broker)

wynik,

parametry WY

Obiekt

Architektura rozproszonych obiektów (2)

...

Aplikacja

napisana w

C++

Aplikacja na

relacyjnej

bazie danych

Aplikacja

na Lotus

Notes

Osłona 1

Osłona 2

Osłona 3

Pośrednik

Pośrednik

Pośrednik

Szyna oprogramowania (software bus)

Miejsce 1

Miejsce 2

Miejsce 3

...

Struktura logiczna rozproszonych obiektów

O3

O1

O2

Obiekty

Operacje na

obiektach

O7

O5

O9

O4

K1

O8

O6

K3

K2

K4

Szyna oprogramowania (software bus)

Aplikacje

A1

A2

A3

Szyna oprogramowania tworzy jedną przestrzeń obiektów. Obiekty te są dostępne dla

dowolnego miejsca poprzez operacje (zgrupowane w klasach). Miejsca i sposoby

implementacji obiektów są niewidoczne. Aplikacje korzystają z całej puli obiektów.

„Semistrukturalna” architektura aplikacji

internetowych

Przeglądarka

WWW

Narzędzia

wspomagające XML :

system autorski, itd.

Warstwa klienta

Przeglądarka

WWW

XML

XML

Serwer Web

Serwer aplikacji

Interakcja z aplikacjami poprzez

protokoły oparte na XML

Logiczna warstwa pośrednia

Baza danych w XML

(strukturalizowana)

Serwer integrujący XML,

serwer zapytań,

serwer hurtowni danych

XML

XML

XML

XML

Translatory formatów

z/do XML, pomosty

Zasoby danych

Obiektowo-relacyjna

baza danych

wspomagająca XML

Obiektowa baza

danych

wspomagająca XML

Dokumenty

Dokumenty

XML

XML

nana

Webie

Webie

Inne

Inne

dokumenty

dokumentynana

Webie:

Webie:HTML

HTML

Word,...

Word,...

Zasoby danych

pod OLE/DB

Standardy łączenia

rozproszonych zasobów

Standardy łączenia rozproszonych danych (1)

Open DataBase Connectivity (ODBC): standard [zdalnego]

dostępu do relacyjnych baz danych

• bazuje na Call Level Interface (CLI) opracowanym przez konsorcjum

X/Open

• definiuje API oraz cechy SQL które muszą być zapewnione na różnych

poziomach zgodności.

Java DataBase Connectivity (JDBC): analogiczny do ODBC

standard dla Java.

Standardy X/Open XA: definiują zarządzanie transakcjami ze

wspomaganiem protokołu 2PC.

OLE-DB: API podobne do ODBC, ale wspomagające źródła niebazodanowe, takie jak płaskie pliki.

• OLE-DB program może negocjować ze źródłem danych aby znaleźć

własności, które ono podtrzymuje.

• API jest podzbiorem SQL

Standardy łączenia rozproszonych danych (2)

ADO (Active Data Objects): łatwy interfejs do funkcji OLE-DB

Kilka standardów bazujących na XML dla E-commerce

• Np. RosettaNet (łańcuchy dostaw), BizTalk

• Definiują katalogi, opisy usług, faktury, zamówienia, itd.

• osłony XML są używane do eksportu informacji z relacyjnej BD do

XML

Resource Description Framework (RDF): specyfikacja ontologii dla

zasobów Web.

Simple Object Access Protocol (SOAP): bazujący na XML standard dla

zdalnego wołania procedur (RPC). SOAP jest mniej elastyczny i

uniwersalny w stosunku do CORBA, ale pozostaje pytanie, czy aż taka

elastyczność i uniwersalność jest potrzebna.

• Używa XML do zakodowania danych, HTTP jako protokołu

transportowego

• Dalsze standardy są oparte na SOAP dla specyficznych aplikacji, np.

OLAP i Data Mining (standardy Microsoft'u)

Standardy łączenia rozproszonych danych (3)

Object Data Management Group (ODMG) standard obiektowych

baz danych

• jest używany w projektach przyszłościowych związanych z

rozproszonymi lub federacyjnymi bazami danych, np. IRO/DB.

OMG CORBA (Common Object Request Broker Architecture) najbardziej uniwersalny standard obejmujący ogromną liczbę

aspektów. W szczególności, notacja UML jest jego składową.

Pakiety ORB (Object Request Broker) są oprogramowaniem

realizującym tę architekturą.

.NET/DCOM (Distributed Component Object Model) - standard

Microsoftu zintegrowany z systemami operacyjnymi Microsoftu.

Znacznie ograniczony w stosunku do standardu CORBA.

RMI (Remote Method Invocation) - oprogramowanie firmy Sun,

ograniczone w stosunku do standardu CORBA do oprogramowania

pisanego w Java. Java Beans i Enterprise Java Beans

wykorzystują RMI jako transport.

Replikacje

Replikacje

Technologia replikacji oznacza przechowywanie dwóch lub więcej

kopii danych (replik) w oddalonych geograficznie miejscach.

Cele:

Zwiększenie dostępności danych poprzez: