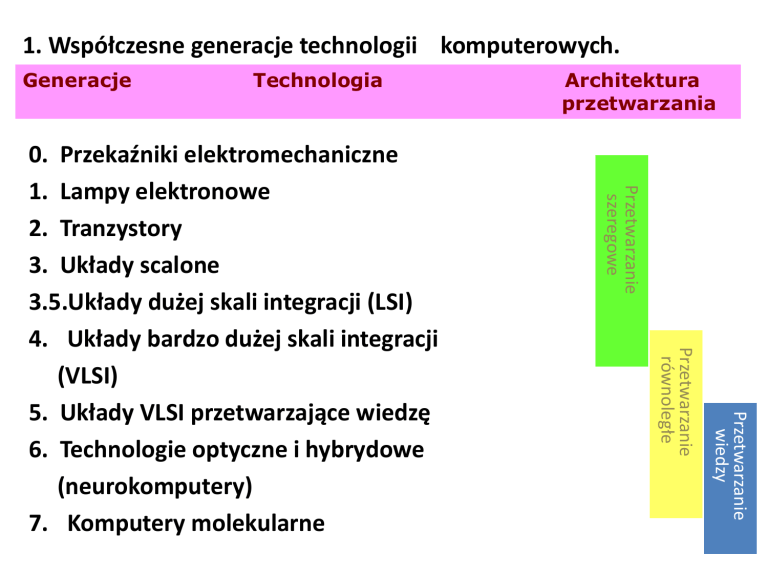

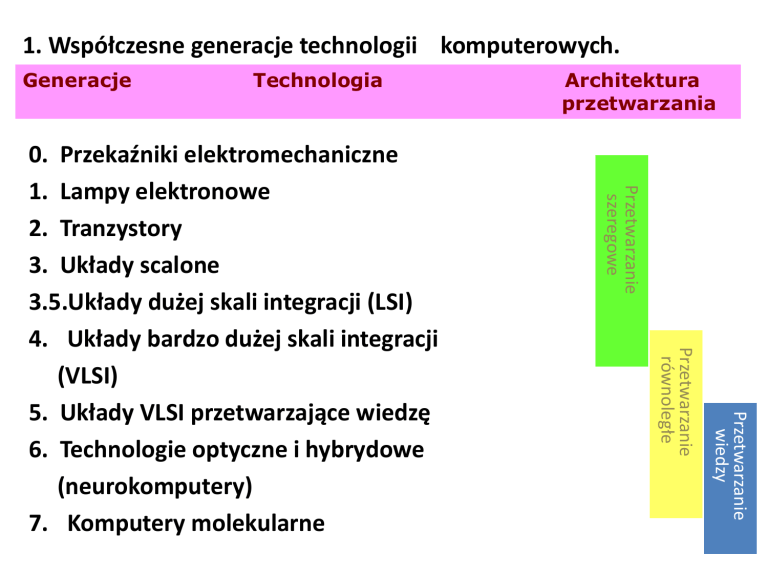

1. Współczesne generacje technologii komputerowych.

Generacje

Technologia

Przetwarzanie

szeregowe

Przetwarzanie

wiedzy

Przetwarzanie

równoległe

0. Przekaźniki elektromechaniczne

1. Lampy elektronowe

2. Tranzystory

3. Układy scalone

3.5.Układy dużej skali integracji (LSI)

4. Układy bardzo dużej skali integracji

(VLSI)

5. Układy VLSI przetwarzające wiedzę

6. Technologie optyczne i hybrydowe

(neurokomputery)

7. Komputery molekularne

Architektura

przetwarzania

17 . Aproksymacja lingwistyczna. Kwantowanie przestrzeni

wartości w rozmytych systemach ekspertowych.

Podstawą zdefiniowania zbioru wartości zmiennej

jest określenie tzw. terminów podstawowych

(pierwotnych).

Na ich podstawie tworzone mogą być zbiory rozmyte

opisujące terminy złożone, definiowane za pomocą

operatorów działań na zbiorach rozmytych oraz

modyfikatorów kształtu.

Proces kolejnego przekształcania terminów

pierwotnych, poprzez zastosowanie modyfikatorów,

tak aby wynikowy zbiór rozmyty w jak najlepszy

sposób opisywał modelowane pojęcie nazywamy

aproksymacją lingwistyczną.

17 b . Aproksymacja lingwistyczna. Kwantowanie przestrzeni

wartości w rozmytych systemach ekspertowych.

Typowym sposobem tworzenia terminów pierwotnych

dla poszczególnych zmiennych tworzonego systemu

jest równomierne kwantowanie przestrzeni wartości.

Polega ono na podzieleniu tej przestrzeni na określoną

liczbę zbiorów rozmytych o jednakowej szerokości.

Kwestia wyboru liczby i funkcji przynależności

terminów pierwotnych musi być przedmiotem

konsultacji budowniczego systemu z ekspertem.

W przypadku, gdy brak jest dostatecznej wiedzy dla

bezpośredniego określenia terminów pierwotnych,

możliwe jest otrzymanie funkcji przynależności na

podstawie analizy obserwacji zachowania

modelowanego systemu.

18. Proces defuzyfikacji we wnioskowaniu rozmytym.

Proces wnioskowania z wykorzystaniem reguł

rozmytych daje w wyniku rozmytą wartość zmiennej

wyjściowej. W wielu przypadkach niezbędna jest jej

zamiana na wartość dokładną. Wyznaczanie

dokładnej wartości zmiennej określonej za pomocą

zbioru rozmytego nazywamy wyostrzaniem lub

defuzyfikacją. Defuzyfikacja przeprowadzana jest

zwykle za pomocą jednej z dwóch metod: - środka

obszaru (metoda centroidu - COA), lub średniej

maksymalnej (MOM). Metoda COA polega na

znalezieniu środka ciężkości zbioru rozmytego;

metoda MOM natomiast polega na wyznaczeniu

środka obszaru o największej przynależności.

25. Rekurencyjne warianty Sztucznych Sieci Neuronowych.

W topologii sieci rekurencyjnych dopuszcza się

zastosowanie połączeń wstecznych.

Sygnał wyjściowy z dowolnej jednostki może być

przekazany również (bezpośrednio lub za

pośrednictwem innych neuronów) na jej wejście.

Stan neuronu staje się więc zależny nie tylko

od wartości sygnału wejsciowego, ale również

od przeszłego stanu dowolnej jednostki,

nie wykluczając tego właśnie neuronu.

Najprostszym przykładem jest tu modyfikacja

jednokierunkowej sieci typu wstecznej propagacji

przez dodanie w warstwie wejściowej

jednostek tzw. kontekstu.

27. Cztery podstawowe założenia idei Algorytmów Getycznych.

1.Rozwiązania zakodowane są w postaci łańcuchów binarnych

o stałej długości; natomiast populacja rozwiązań zachowuje

stałą liczność w całym algorytmie.

2.Krzyżowanie rozwiązań angażuje dwa rozwiązania

rodzicielskie, dając w efekcie dwa rozwiązania potomne,

w których zachowana jest pozycja bitów.

3.Selekcja rozwiązań wykorzystuje mechanizm koła ruletki;

przestrzegana jest przy tym zasada wymiany całej populacji

rozwiązań w kolejnych krokach algorytmu.

4.Prawdopodobieństwo mutacji wyraża prawdopodobieństwo

zdarzenia, że pozycja bitu w łańcuchu binarnym,

reprezentującym zakodowaną postać rozwiązania, w kolejnej

populacji, zostanie poddana przekształceniu zmiany wartości.

28. Podstawowe kroki typowego Algorytmu Genetycznego.

1. Losowe ustalenie populacji inicjującej algorytm.

2. Oszacowanie wartości funkcji przystosowania

dla wszystkich chromosomów, po zdekodowaniu

ich do formy dogodnej do oszacowania

i przydzieleniu wartości funkcji przystosowania

(dopasowania).

3. Dokonanie selekcji chromozomów rodzicielskich

dla następnej generacji.

4. Powtarzanie operacji: krzyżowania, mutacji,

oszacowania wartości funkcji przystosowania,

selekcji chromosomów rodzicielskich

dla kolejnych generacji, dopóki nie zostanie

spełnione kryterium zatrzymania algorytmu.

29. Strategie Ewolucyjne - istota i zastosowania.

Strategie ewolucyjne, są stosowane głównie do numerycznej

optymalizacji projektów inżynierskich.

Strategie ewolucyjne różnią się od algorytmów genetycznych

następującymi cechami:

- reprodukcja jest dokonywana w sposób deterministyczny,

- wprowadzono inną koncepcję mutacji,

- parametr charakteryzujący mutację wchodzi w skład

chromosomu i podlega również ewolucji, zatem strategia

ewolucyjna samoczynnie adaptuje własny parametr

wewnętrzny (cechy tej nie ma algorytm genetyczny),

-operator krosowania jest operatorem ubocznym i często nie

jest wykorzystywany.

Są one używane wszędzie tam, gdzie rozwiązanie trudno jest

przewidzieć albo gdy funkcja jest trudna do optymalizacji przy

użyciu metod klasycznych.

Zaletą takiego podejścia jest duża uniwersalność, a przy

rozwiązywaniu problemu nie wymaga się obecności eksperta.

30. Inteligentne Programowanie Ewolucyjne.

Programowanie ewolucyjne jest w swojej idei zbliżone do koncepcji

strategii ewolucyjnych. Obejmuje jednak bardziej złożone problemy

związane ze sztuczną inteligencją.

W programowaniu ewolucyjnym inteligentne zachowanie rozumiane

jest jako zdolność przewidywania relacji pomiędzy środowiskiem

a działaniem ukierunkowanym na określony cel.

Środowisko zostało w idei programowania ewolucyjnego

zasymulowane jako sekwencja symboli wziętych ze skończonego

alfabetu.

Praktyczną reprezentacją tego typu problemów jest model tak

zwanego automatu ze skończoną liczbą stanów.