Wyszukiwanie informacji w Internecie

Najczęściej wymienianą usługą internetową, z której korzysta większość internautów jest zwykle WWW czyli World

Wide Web, stworzone przez Timothy Bernersa-Lee w 1990 roku na potrzeby badaczy CERN. Dzięki niemu,

użytkownikami Internetu są dziś nie tylko naukowcy i studenci, jak było w pierwszym okresie działalności

ARPANETu, ale także zwykli ludzie, i dlatego tworzeniem stron internetowych zainteresował się biznes i

administracja.

W Internecie jest wiele cennych i potrzebnych informacji, ale z powodu ogromnej liczby stron WWW nie sposób jest

znaleźć czegokolwiek bez użycia wyszukiwarki lub katalogu. Pojawiło się zatem zapotrzebowanie na wymienione

narzędzia oraz na budowanie strategii pozycjonowania stron, szczególnie komercyjnych, czyli zapewnienia wysokiej

pozycji w wynikach wyszukiwarek i katalogów. Ostatnio jednak nawet używanie takich narzędzi nie przyspiesza

procesu efektywnego wyszukiwania w tak istotny sposób jak kiedyś. Dzieje się to z powodu istnienia oprócz

wartościowych, także niezbyt polecanych stron, stworzonych np. przez lub dla zwolenników zabronionych poglądów

jak faszyzm, wyznawców sekt, czy aprobujących groźne dla zdrowia choroby jak anoreksja, a także z powodu istnienia

stron tworzonych nie dla ludzi, a dla robotów wyszukiwarek internetowych (czyli tworzonych tylko i wyłącznie w celu

promocji innej strony w wyszukiwarce). Według badań Bluerank w 2008 roku aż 30% respondentów nie było w pełni

usatysfakcjonowanych wynikami wyszukiwania najpopularniejszej wyszukiwarki Google. Coraz częściej zatem to nie

tylko chęć zaoszczędzenia czasu skłania nas do użycia Google lub innego serwisu, ale w ogóle konieczność szukania

informacji np. o produktach i usługach. Wtedy ważna jest także możliwość zobaczenia w wyszukiwarce zdjęć

produktów, czy budynku firmy, możliwość znalezienia drogi dojazdu itp. Użytkownicy musza się jednak liczyć z tym,

że prawdopodobnie spędzą na wyszukiwaniu trochę czasu - bo nie wszystkie pokazane w wynikach odnośniki

poprowadzą na stronę, która w wyczerpujący sposób spełni ich oczekiwania, czyli znajdą na niej odpowiedź na swoje

zapytanie. Z tego powodu w wielu biznesowych przedsięwzięciach zatrudniani są profesjonalni brokerzy informacji

czyli infobrokerzy, którzy na zlecenie wyszukują potrzebnych danych. Powstała także koncepcja budowania

inteligentnych agentów do wyszukiwania informacji w Internecie, a twórca WWW Tim Berners Lee zaproponował

przebudowę istniejącego chaosu informacyjnego w sieć semantyczną nazywaną też Web 3.0.

Wyszukiwanie przed epoką Web 3.0

Przyjmuje się, że obecnie Internet składa się z milionów komputerów (według CIA World Factbook 2009 było ok. 575

mln). Trudno jest ustalić ile jest w sieci witryn, portali i stron – bowiem codziennie powstaje i znika ogromna ich

liczba, a nie wszystkie są zaindeksowane przez wyszukiwarki. Łatwiej określić jest katalogowaną przez ICANN liczbę

domen i serwerów, ale i ich liczba może dość szybko ulegać zmianie.

Według badań NEC Research Institute w 1999 roku istniało 800 milionów stron WWW. W 2002 roku wyszukiwarka

Google przechowywała w swoich bazach danych ponad 2 miliardy odnośników, a w 2005 roku było ich już 8

miliardów. Według Antonio Gulli i Allesio Signorini w 2005 roku wyszukiwarki indeksowały ponad 11,5 mld stron, z

czego około 9,36 mld przypadało na największe wtedy Google, Yahoo, MSN i Ask.

Oprócz wyszukiwarek w Internecie działają inne serwisy ułatwiające poszukiwanie informacji. Stosowane były i są

nadal także katalogi stron internetowych i metawyszukiwarki (multiwyszukiwarki).

Katalogi stron internetowych

Katalogi stron internetowych to serwisy moderowane ręcznie, których celem jest grupowanie tematyczne zbioru

adresów internetowych. Autorzy lub właściciele stron zgłaszają swoje strony do katalogów, zazwyczaj z krótkim

opisem, po czym, zwykle po przejrzeniu, strona zostaje wpisana na listę pod danym hasłem. Katalog stron jest strukturą

drzewiastą: witryny przypisane są, ze względu na swoją zawartość do poszczególnych kategorii, które dzielą się na

kategorie podrzędne.

Najpopularniejszy to Yahoo, a w Polsce katalogi portali Wirtualna Polska i Onet. Najbardziej istotnym jest katalog

Open Directory Project DMOZ http://www.dmoz.org, utworzony w 1998 roku jako directory.mozilla.org, moderowany

obecnie przez 75 tysięcy redaktorów. Dostęp do katalogu oraz zgłoszenia stron są w nim bezpłatne, ale z powodu

wysokich wymagań jedynie naprawdę wartościowe strony mają szansę zaistnieć w DMOZ.

W 1992 roku z inicjatywy Rafała Maszkowskiego powstał pierwszy katalog stron znajdujących się w polskim

internecie, późniejsze "Polskie Zasoby Sieciowe". Dane przedstawione były wówczas w postaci czystego ASCII. Rok

później w związku z rozprzestrzenieniem się standardu HTML katalog obsługiwał już linki hipertekstowe. "Polskie

Zasoby Sieciowe" zakończyły swoją działalność w roku 1997.

Wadą katalogów jest mała liczba zawartych w nich stron w porównaniu z innymi narzędziami oraz długi czas

aktualizacji. Powodem są ograniczone ludzkie możliwości. Strony internetowe powstają, znikają i zmieniają się, a

weryfikacja ich zawartości czy obecności wymaga ponownego odwiedzenia ich przez redaktora. Kolejną wadą jest

różna interpretacja kategorii: tę samą stronę dwie osoby mogą umieścić w różnych kategoriach, co może prowadzić do

nieporozumień. Na przykład strona poświęcona grze w szachy może zostać umieszczona przez redaktora katalogu w

kategorii sport, natomiast szukający tej strony będzie poszukiwał informacji na ten temat w kategorii gry.

Wyszukiwarki

Pierwszą funkcjonalną wyszukiwarką zawartości stron internetowych, posiadającą zaimplementowane funkcjonalności

robota śledzącego (nazwanego tu World Wide Web Wanderer - 4W) i indeksującego strony oraz wyposażonego w

zdolność przeszukiwania utworzonych indeksów, był uruchomiony w 1993 roku Wandex. Napisał go Matthew Gray,

wówczas pracownik MIT, obecnie Google. Wyszukiwarki to aplikacje tworzące automatycznie bazy danych o

witrynach, w ich skład wchodzą programy nazywane m.in. crawlerami, robotami, pająkami lub botami czyli roboty

internetowe pobierające i przeglądające dokumenty z sieci. Inny moduł wyszukiwarki odczytuje zapytanie użytkownika

i zwykle przeszukuje swoje bazy nazwane indeksami, które co jakiś czas są aktualizowane - po kolejnej turze pracy

robotów.

Roboty standardowych wyszukiwarek odwiedzają tylko te strony, do których prowadzą odnośniki z innych witryn oraz

te, które zostały zgłoszone do nich przez swoich autorów lub właścicieli.

Najważniejszymi algorytmami stosowanymi w wyszukiwarkach są algorytmy oceny relewancji dokumentu względem

szukanej frazy oraz algorytmy oceny zawartości strony. Często są strategiczną tajemnicą właściciela wyszukiwarki,

przesądzającą o jej skuteczności. Wiadomo o stosowaniu algorytmów: binarnych, ważenia częstością słów TF,

PageRank, In-degree, metody Robertsona i Sparcka-Jonesa (1997), metody Robertsona (1994), modelu Markova,

metody bazowej B, liczba wizyt (klikohit) i wielu innych.

Poprawę relewancji wyników wyszukiwania można uzyskać poprzez grupowanie (clustering), personalizację,

weryfikacja pisowni, tzw. stop-words – czyli stop listy oraz tezaurus, czyli podpowiedzi.

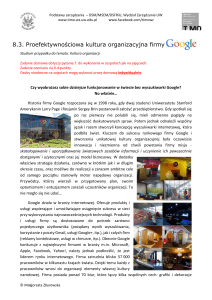

Google to najpopularniejsza wyszukiwarka na świecie. Została stworzona przez Larry’ego Page'a oraz Sergeya Brina w

1996 roku, w ramach ich projektu studenckiego na Uniwersytecie Stanford. W 1998 roku założyli firmę Google Inc.

Słowo "googol" to liczba 10100. Pierwszy użył tego terminu amerykański matematyk, Edward Kasner, zainspirowany

dźwiękami wydawanymi przez jego bratanka Miltona Sirotta. Wyszukiwarka Google jako pierwsza wprowadziła

możliwość przeszukiwania nie tylko stron HTML, ale także dokumentów zapisanych w formacie PDF, a później DOC,

arkuszy Excel, prezentacji PowerPoint, plików RTF i postscriptowych (.PS). Można również przeszukiwać grafiki

(JPG, GIF), filmy, grupy dyskusyjne oraz katalogi. Graficzne wybrane źródła pokazywane są obecnie od razu razem z

wynikami SERP (search engine results page - strona z wynikami wyszukiwania).

Wraz z rozwojem firmy, Google zaczęło poszerzać listę swoich usług, dołączyło pocztę elektroniczną, albumy zdjęć,

aplikacje biurowe, Google Analytics i wiele innych. Jedną z ostatnich nowości jest Google Instant, czyli domyślanie się

o co chce zapytać użytkownik – poprzez pokazywanie listy propozycji ciągu dalszego wpisywane zapytania.

Dziś Google to finansowy gigant. W 2005 roku przychody firmy sięgnęły 6,1 mld USD, a zysk wyniósł 2 mld. Google

odnotował w pierwszym kwartale 2006 roku 79% wzrost przychodów w porównaniu z pierwszym kwartałem 2005

roku. Po latach kryzysu, w pierwszym kwartale 2010 roku przychody firmy wzrosły o 37% i wyniosły 1,96 miliarda

dolarów.

Polska strona http://www.ranking.pl/ ocenia popularność m.in. wyszukiwarek. Ranking obliczany jest na podstawie

procentowej liczby wizyt na polskich witrynach dokonanych z wyszukiwarek uczestniczących w badaniu

GemiusTraffic.

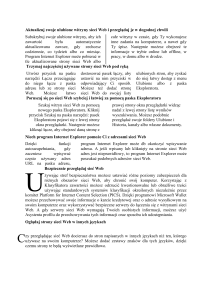

lp Wyszukiwarki29.XI.2010 - 22.XI.2010 - 15.XI.2010

silniki

5.XII.2010

28.XI.2010

21.XI.2010

1

Google

97,20%

97,57%

97,74%

2

NetSprint

1,39%

1,14%

1,17%

3

MSN

0,72%

0,72%

0,72%

W 2006 roku w podobnym okresie pierwsze było Google, Morfeo i NetSprint, MSN, Szukacz, Yahoo i Altavista. Jak

widać konkurencyjne wyszukiwarki nie zagrażają pozycji Google, co zauważa się nie tylko w Polsce. Nie mniej ciągle

na rynku powstają nowe, jedną z nich była europejska inicjatywa ograniczenia dominacji USA w Internecie Quaero

(łac. szukam) czyli projekt europejskiej wyszukiwarki internetowej prowadzony przez firmy Thomson, France

Telecom, Siemens AG, Thales, Bertin Technologies, Exalead, Jouve, LTU, Vecsys, Empolis, a wspomagany przez

instytuty naukowe Inria, Inra, CNRS, Clips Imag, RWTH Aachen, Uniwersytet Karlsruhe.

Mimo wciąż dołączanych funkcjonalności, zapytania do baz są nadal poza zasięgiem wyszukiwarek. Google i każda

inna wyszukiwarka znajdzie tylko stronę główną np. z rozkładem jazdy, ale nie da sobie rady z wypełnieniem

formularza i zadaniem pytania o konkretne połączenie.

To zadanie mogą wykonać przyszłe wyszukiwarki semantyczne lub agenty.

Metawyszukiwarki i metabazy

Metawyszukiwarki (Meta-Search Engines) to serwisy internetowe, które nie posiadają własnej bazy danych, ale potrafią

wysłać zadane zapytanie do kilku lub kilkunastu samodzielnych wyszukiwarek, odebrać od nich wyniki i przedstawić je

w przejrzystej formie. Wadą metawyszukiwarek jest brak dostępu do specyficznych zapytań złożonych jakie dają

zwykłe wyszukiwarki. Zaletą zaś jest to, że można zadać jedno pytanie do kilku serwisów przy odwiedzeniu tylko

jednego. Zaoszczędza to czas i daje możliwość przeszukania większej części zasobów Internetu. Niektóre

metawyszukiwarki opracowują otrzymaną listę wyników: usuwają powtarzające się adresy i te, które już nie istnieją, a

są jeszcze zapisane w bazie wyszukiwarek. Dodatkowo mogą sortować na różne sposoby wyświetloną listę.

Przykładami matawyszukiwarek są:

Ixquick http://www.ixquick.com (w wielu wersjach językowych również w polskiej),

Metacrawler http://www.metacrawler.com ,

Yippy http://www.yippy.com (dawniej Clusty), Dogpile http://www.dogpile.com,

Pandia Metasearch http://www.pandia.com/metasearch/index.html, Copernic http://find.copernic.com.

Niektóre ujawniają z jakich zwykłych wyszukiwarek korzystają w pierwszej kolejności, np. Pandia z Yahoo!, MSN,

AlltheWeb, Ask.com, Wisenut, Dogpile wyszukuje z Google, Yahoo, Bing i Ask, a Yippy z Ask, Open Directory

(DMOZ), Gigablast i innych.

W dotarciu do mało znanych lub głębiej schowanych zasobów sieci pomagają specjalistyczne serwisy jak metabazy

czyli zbiory wydobytych z sieci baz danych dotyczących różnych obszarów wiedzy, albo też serwisy przeszukujące

określony obszar sieci, koncentrujące się na jednej tylko dziedzinie.

Complet Planet http://www.completeplanet.com to metabaza, która daje dostęp do 70 tysięcy baz danych i serwisów

wyszukiwawczych. Można do nich dotrzeć poprzez katalog tematyczny albo na skróty - po słowie kluczowym. Inny

serwis to Infomine http://infomine.ucr.edu adresowany do środowiska akademickiego, powstał z inicjatywy

pracowników kilku amerykańskich uczelni i bibliotek uniwersyteckich (m.in. University of California i University of

Detroit). Gromadzi w swoim katalogu wartościowe materiały przydatne naukowcom i studentom. Są to bazy danych,

elektroniczne biuletyny, książki, artykuły, archiwa list elektronicznych, dotyczące poszczególnych nauk, np. medycyny,

nauk humanistycznych, matematycznych itp. Bubl Link http://bubl.ac.uk/ to z kolei brytyjski katalog rzeczowy,

indeksujący zasoby o charakterze akademickim, jak książki i czasopisma elektroniczne, repozytoria tematyczne,

katalogi biblioteczne online. Można tu wyszukiwać według tematu bądź rodzaju źródła.

Invisible Web

Duża część materiałów znajdujących się w Internecie była kiedyś niedostępna bo "niewidzialna" dla wyszukiwarek z

powodu np. formatu pliku. Pierwotnie nawet Google wyszukiwało informacje tyko ze stron HTML, z czasem jednak

ulepszano algorytmy i obecnie znajdowane są dokumenty DOC, PDF i inne dokumenty tekstowe.

Według NEC Research Institute w 1999 roku wyszukiwarki indeksowały tylko 16% wszystkich stron WWW. Powstały

zatem terminy „ukryta sieć” (ang Invisible Web) lub głęboka sieć (ang Deep Web) odnoszące się do zasobów Internetu,

do których nie docierają standardowe wyszukiwarki.

Według Chrisa Shermana i Gary Price'a Invisible Web to dostępne w sieci strony, pliki czy inne informacje, których z

przyczyn technicznych bądź innych ograniczeń, nie indeksują wyszukiwarki. W innej definicji Michaela Bergmana

Deep Web to strony internetowe tworzone dynamicznie jako wynik specjalistycznych wyszukiwań w bazach danych.

Zatem oprócz nieindeksowanych stron i dokumentów tekstowych w innych formatach niż HTML, były to dokumenty

graficzne, muzyczne, strony we Flash, arkusze kalkulacyjne, bazy danych (publicznie dostępne - bazy danych

komercyjne powinny być z założenia elementem ukrytej sieci), strony generowane dynamicznie (PHP, ASP), większość

stron instytucjonalnych lub płatnych, które wymagały wcześniejszej rejestracji, strony do których nie prowadzą

odsyłacze, strony wyłączone z procesu indeksacji przez twórców (poprzez umieszczenie w kodzie strony meta-tagu

robots lub poprzez utworzenie pliku robots.txt w określonym katalogu serwera WWW).

Powstawać zaczęły wyszukiwarki zaprojektowane do przeszukiwania ukrytych zasobów sieci, np. Incywincy

http://www.incywincy.com przeglądająca strony internetowe, jak też wykorzystująca wyszukiwarki,

metawyszukiwarki, formularze i katalogi.

Co pewien czas publikowane były szacunki porównujące oba obszary sieci: widzianej przez wyszukiwarki (Surface

Web) i sieci ukrytej. Większość z materiałów cytuje badania Michaela Bergmana z 2001 roku, według których sieć

niewidzialna była wtedy nawet ok. 400-550 razy większa niż zasoby Surface Web i liczyła ok. 550 mld dokumentów.

Aż 95% zasobów ukrytych było dostępnych bezpłatnie, ponad połowę stanowiły tematyczne bazy danych. Szacunki te

podważył w 2005 roku Dirk Lewandowski.

Dane te i tak z pewnością do dziś uległy zmianie, wyszukiwarki bowiem zaczęły wkraczać w niewidzialną część sieci,

wzbogacały się o możliwości przeszukiwania tekstów zapisanych w różnych formatach i dziś znajdują już pliki PDF,

DOC, a nawet pliki graficzne, filmy i podcasty. Można zatem skonstatować, że za sprawą ulepszonych algorytmów tzw.

głęboki Internet wypłynął na wierzch i już jest widziany w wynikach wyszukiwarek.

Wyszukiwanie w czasach zbyt mocnej promocji strony

Dlaczego, mimo ciągłego ulepszania algorytmów, wyszukiwanie nie daje często dobrych wyników? Przyczyną często

jest nieetyczne pozycjonowanie, czyli działania nie zgodne z wytycznymi IAB lub regulaminami wyszukiwarek. Ich

właściciele chcieliby, aby klienci, czyli użytkownicy Internetu poszukujący informacji, uzyskiwali dobre wyniki, czyli

odpowiadające na ich zapytania i tym samym byli zadowoleni z serwisu.

Większość współczesnych wyszukiwarek wyszukuje informacje za pomocą słów kluczowych. Po wprowadzeniu

szukanej frazy wyszukiwarka wyświetla listę linków do stron, które dane wyrażenie zawierają. To zaś, która strona

znajdzie się najwyżej zależy od liczby słów kluczowych w tekście, ich miejsca na stronie, a także od tego czy słowa

zawierają odnośniki do stron z dodatkowymi informacjami. W rezultacie bardzo często na szczycie SERP pojawiają się

linki do witryn, które nie spełniają oczekiwań szukającego, ale są dobrze wypozycjonowane przez ich twórców, którzy

w celu polepszenia pozycji strony w wynikach wyszukiwarek wstawiają np. ukryty tekst.

Gdy zorientowano się, że wyszukiwarki indeksują strony linkowane, zaczęły powstawać tw. farmy linków, czyli strony

zawierające tylko odnośniki do innych stron. Algorytmy wyszukiwarek zaczęły jednak identyfikować tego typu

serwisy. Pojawiły się wtedy strony z unikalnym, ale nie zawsze merytorycznie poprawnym tekstem, generowane tylko i

wyłącznie w celu linkowania. To tzw. zaplecze pozycjonerskie, tworzone najczęściej w sposób zupełnie przypadkowy

lub automatycznie przez programy, czasami poprzez powielanie swoich lub cudzych tekstów, rzadziej tworzone przez

wynajętych pracowników - ale nie pielęgnowane i tracące często swoją aktualność. Jest to zatem tylko i wyłącznie

mnożenie liczby stron (bytów) nieużytecznych dla użytkowników sieci szukających informacji, zatem jest to SPAM.

Nie ma badań oceniających liczbę takich stron, są jednak źródła wskazujące, że do pozycjonowania jednej strony

tworzonych jest co najmniej kilkadziesiąt innych, zatem mogą stanowić duży procent wszystkich i

prawdopodobieństwo, że użytkownik wyszukiwarki trafi na jedną z nich jest dość duże. Gorzej jeśli nie uzna jej za

mało wartościową i skorzysta z zawartych w niej informacji. Twórcy lub zarządcy zaplecza manipulują zatem

wynikami wyszukiwania, stąd tego typu działania są tępione przez właścicieli wyszukiwarek. Google w 2007 roku

ogłosiło, że strony zaplecza będą zwalczane, zastrzegło sobie możliwość ograniczenia mocy odnośników

umieszczonych na stronach z unikalną treścią, w przypadku wykrycia, iż funkcjonują one jedynie w celu

pozycjonowania.

Firmy lub osoby zajmujące się pozycjonowaniem tworzą także katalogi, które znacznie odbiegają od idei katalogu

Yahoo czy DEMOZ. Są to strony zbudowane z gotowych skryptów np. QlWeb, mające na celu linkowanie, często

odpłatnie dla wszystkich zgłaszających swoje strony - bez weryfikacji co zawierają. Od pewnego czasu takie katalogi

mają jednak znikomą wartość nawet dla osób zajmujących się pozycjonowaniem. Programy wyszukiwarek wzbogacono

bowiem o algorytmy wykrywające i ignorujące katalogi oparte o QlWeb, Freeglobes, Mini, Scuttle i inne popularne

skrypty. W ich miejsce zaczęły pojawiać się katalogi typu presell pages różniące się od poprzednich tym, iż

przypominają blog lub CMS. Starają się naśladować sytuację linkowania naturalnego, kiedy osoba (blogger) opisuje w

swoim wpisie np. jakąś firmę, produkt bądź zjawisko, umieszczając w tekście linki prowadzące do stron powiązanych z

poruszanym tematem.

Wzrastającą liczbę serwisów typu presell pages zauważyło Google, i w komunikatach publikowanych w 2007 roku

zasygnalizowało, że skoro mają one na celu jedynie przekazywanie mocy w postaci linków wychodzących, nie służą w

żaden sposób internautom. Nie jest to zatem forma promocji akceptowana przez wyszukiwarki, bo jej efektem jest

również manipulacja użytkowników wyszukiwarek.

Wyszukiwanie w sieci semantycznej

Pod koniec XX wieku rozpoczęto prace nad projektem Tima Bernersa Lee: Semantic Web (sieć semantyczna nazywana

też Web 3.0), który ma przyczynić się do utworzenia i rozpowszechnienia standardów opisywania treści w Internecie w

sposób, który umożliwiłby maszynom i programom (np. robotom wyszukiwarek, autonomicznym agentom)

przetwarzanie informacji w sposób odpowiedni do ich znaczenia. Czas sieci semantycznej według prognoz Nova

Spivak miał się zacząć w 2010 roku (Spivak, 2007). Czy tak się stało? Istnieją już strony stosujące standardy RDF (ang.

Resource Description Framework) czy OWL (ang. Ontology Web Language), ale Web 3.0 naprawdę stanie się

rzeczywistością, gdy wszystkie strony dostosują się do nowych norm, bowiem wtedy budowane obecnie aplikacje jak

np. wyszukiwarki semantyczne, będą działać tak, jak tego oczekują zwolennicy nowej struktury sieci WWW.

Idea sieci semantycznej polega na wykorzystaniu już istniejącego protokołu do takiego sposobu przetwarzania

informacji, który umożliwi powiązanie znaczeń między wyrazami, a nie tylko wykorzystanie słów kluczowych. Chodzi

więc o semantykę, którą sieć może zrozumieć analizując strukturę stron. Obecnie strony są przygotowywane dla ludzi, a

mało zrozumiałe dla programów. Spójrzmy na fragment strony przychodni rehabilitacyjnej:

<h1>Cenrtum rehabilitacyjne/<h1>

Witamy na stronie centrum rehabilitacyjnego.

Nasi pracownicy to dyplomowani rehabilitanci: Jan Kowalski i Adam Nowak oraz dyplomowana

pielęgniarka Krystyna Wiśniewska.

Odczuwasz ból? Przyjdź koniecznie.

<h2> Godziny przyjęć:</h2>

Pon 11.00– 19.00 <br>

Wt 11.00– 19.00 <br>

Śr 11.00– 19.00 <br>

Czw 11.00– 19.00 <br>

Pt 11.00– 19.00 <br>

Informacje podane na tak zdefiniowanej stronie będą wystarczające dla człowieka, ale program nie będzie potrafił np.

zidentyfikować, kto jest rehabilitantem, a kto pielęgniarką. Zaproponujmy zatem reprezentację wiedzy bardziej

dogodną dla komputera.

<firma>

<oferowaneleczenie >rehabilitacja</oferowaneleczenie>

<nazwafirmy>centrum rehabilitacji</nazwafirmy>

<personel>

<rehabilitant> Jan Kowalski</rehabilitant>

<rehabilitant> Adam Nowak</rehabilitant>

<pielegniarka> Krystyna Wiśniewska</pielegniarka>

<personel>

</firma>

Informacje przekazywane w ramach sieci wymagają nie tylko danych, ale także informacji o nich tzw. metadanych,

czego przykład widać powyżej. Zapis metadanych składa się ze zbioru atrybutów niezbędnych do opisu zasobu.

Istotną rolę w tworzeniu semantycznego Internetu, a szczególnie reprezentacji wiedzy, odgrywają ontologie. Ontologia

stanowi wspólny zbiór twierdzeń sformułowanych przy pomocy istniejących standardów np. w XML czy/i RDF, który

opisuje i definiuje relacje między pojęciami i wyznacza reguły wnioskowania. To właśnie dzięki ontologiom komputery

są w stanie zrozumieć semantyczną zawartość dokumentów w sieci. Ontologie są tworzone przy pomocy

specjalizowanych języków, takich jak: OWL, SHOE, OIL, DAML. Ontologie zwiększają możliwości sieci pod

wieloma względami. Najprostszy sposób ich wykorzystania to precyzyjniejsze przeszukiwanie sieci np. wyszukiwarka

wybierze tylko te strony, na których występuje dane pojęcie, ale w ściśle zdefiniowanym znaczeniu, a nie słowo

kluczowe, które jest przecież często wieloznaczne.

Wprowadzanie metaopisów do kodu stron internetowych wydaje się odległą przyszłością, np. z powodu niechęci

webmasterów i braku widocznych korzyści wynikających z dodawania metadanych. Dopóki nie ma wielu aplikacji

Web 3.0 nie wszyscy rozumieją, że ułatwi to przetwarzanie informacji. Kiedy wszystkie dane w Internecie opatrzone

zostaną metadanymi, czyli zaczną rozumieć je algorytmy, użytkownicy sieci będą masowo korzystać z usług osobistych

agentów, które mogą poszukiwać informacji i na ich życzenie podejmować decyzje: wybierać połączenia

komunikacyjne, rezerwować hotele, a nawet negocjować ceny.

Sieć semantyczna staje się rzeczywistością dzięki aplikacjom, które ją wykorzystują i wspierają - takim jak np.

wyszukiwarki semantyczne. Zalicza się do nich wyszukiwarki analizujące znaczenie indeksowanych dokumentów

(Hakia, Bing - dawniej Powerset, Google Squared) oraz wyszukiwarki przeszukujące zasoby sieci semantycznej czyli

zawartość plików RDF oraz modeli interpretacji danych, czyli ontologii zapisanej w OWL (np. Swoogle, Sindice,

Falcons, Watson)- obie działają inaczej i pełnią inną rolę w poszukiwaniu informacji.

Wyszukiwarki analizujące znaczenie

Wyszukiwarki tego typu przeszukują zawartość znaczeniową stron WWW w oparciu o semantyczną i gramatyczną

analizę języka dokumentu. Niezwykle trudne jest przełożenie języka naturalnego na język zrozumiały dla algorytmu. W

tym celu stosują metody sztucznej inteligencji - NLP (Natural Language Processing) oraz algorytmy heurystyczne.

Dużym problemem są tu trudności związane z analizą wyrażeń języka naturalnego, ich wieloznaczność, specyfika

języka itp. nie tylko w treści dokumentów, ale także w zapytaniach, gdyż wiele wyszukiwarek akceptuje zapytania w

języku naturalnym. To właśnie ma być elementem nowego modelu przeszukiwania i wykorzystywania zasobów

Internetu.

Wyszukiwarki analizujące znaczenie przeszukując strony WWW tworzą własną bazę ontologii. Dzięki temu

dostarczane będą bardziej relewantne wyniki, przedstawione w bardziej odpowiadającej zapytaniu hierarchii.

Nie ma jeszcze w pełni funkcjonalnych przykładów wyszukiwarek tego typu, najbardziej chwalona jest uruchomiona w

2009 roku Wolfram Alpha, która nie wyświetla w odpowiedzi adresów stron powiązanych z zapytaniem, lecz

udostępnia konkretne dane. Można je zapisać w formacie PDF. Jedną, która wcześniej wniosła dużo w rozwój

semantycznych wyszukiwarek był Powerset, kupiony w 2008 roku przez Microsoft i rozwijany obecnie od 2009 roku

jako Bing. W 2004 roku powstała Hakia, która podaje jako wyniki posegregowane linki w grupach Web, News, Blogs,

Credible Sources, Video oraz Images. Kategoryzacji wyników dokonuje także wyszukiwarka Yebol.com, akceptująca

również zapytania w języku naturalnym. Google Sqared pokazuje wyniki w postaci danych zawartych w tabelach, które

można wyeksportować do formatu CSV lub arkusza kalkulacyjnego Google. Wskazując komórki tabeli zobaczyć

można źródła zdobytych danych - na razie bardzo często jest to różnie oceniana, jeśli chodzi o wiarygodność,

Wikipedia. Także głównie na niej opierają się wyniki inne wyszukiwarki semantyczne np. Bing (Powerset).

Wszystkie projekty są potencjalnymi konkurentami tradycyjnego Google, bardo często ich premiery reklamowane były

w taki sposób np. Bing Microsoft w maju 2009 roku.

Pojawiły się także polskie przykłady, np. już nie istniejący Szuku.pl, Hippisek.pl, który bazę wiedzy buduje głównie w

oparciu o serwisy tvn24 oraz pudelek.pl, oraz aktywny KtoCo http://www.ktoco.pl (od 2009 roku). Celem jego

działania, nie jest tylko odnajdywanie linków, lecz udzielenie precyzyjnych odpowiedzi. Pytania do niego można

formułować w języku naturalnym, również w takiej formie podawane są odpowiedzi: cytaty pochodzące ze stron

internetowych.

KtoCo korzysta ze zbudowanej przez jego wydawcę bazy ontologii, zawierającej w momencie uruchomienia serwisu w

2009 roku ponad 800 tysięcy faktów i uwzględniającej powiązania semantyczne istniejące pomiędzy nimi.

Wyszukiwarki przeszukujące zawartość sieci semantycznej

Wyszukiwarki przeszukujące zawartość sieci semantycznej nie analizują znaczenia stron WWW, lecz przeszukują opisy

dokonane przez twórców dokumentów i odwołania do ontologii wskazanych w nagłówkach plików RDF. Oglądają

zatem reprezentację semantyczną dokumentu, nie dokonują zaś przekładu jego treści. Pozwolą zatem lepiej

wyselekcjonować dokumenty zawierające podane terminy w określonej kategorii, dzięki czemu na liście wyników

użytkownik nie dostanie odnośników do dokumentów, które będą zupełnie bezwartościowe. Obecnie jedną z przyczyn

niezbyt poprawnego działania wyszukiwarek przeszukujących sieć semantyczną jest mała liczba stron opisanych

metadanymi. Najlepiej działającymi obecnie są Swoogle (utworzony w 2004 roku w projekcie Uniwersytetu Baltimore,

10 tys. ontologii), Sindice, Falcon, SWSE oraz Watson. Wyniki jakie z nich uzyskamy są mało czytelne dla ludzi, bo

zawierają linki do dokumentów RDF lub OWL i dedykowane są dla algorytmów np. agentów.

Wszystkie wyszukiwarki semantycznych działaj w fazie testów, w wersji beta lub jako prototypy aplikacji. Niestety nie

działają jeszcze poprawnie.

Formułowanie zapytań do wyszukiwarek Web 1.0

Różne wyszukiwarki dysponują różnymi rodzajami zapytań, jednak pewne zasady są wspólne dla wszystkich narzędzi

wyszukujących. Ich znajomość przyspieszy wyszukiwanie właściwych treści. Przedstawione zapytania niejednokrotnie

można ze sobą łączyć co daje jeszcze lepsze efekty.

Wyszukiwanie według słów kluczowych

Najprostszym sposobem zadawania pytania jest wpisanie poszukiwanego wyrazu lub wyrazów określających pożądaną

przez nas informację. Wyszukiwarka lub katalog wyświetli nam listę stron, które zawierają poszukiwane słowo lub

słowa, np słowo programista. Może to jednak spowodować wyświetlenie listy zawierającej ponad 1000 adresów, której

przejrzenie może stać się czasochłonne.

W takim przypadku niektóre szperacze pozwalają na przeszukanie otrzymanych wyników poprzez sformułowanie

dodatkowego pytania do bazy, co umożliwi zmniejszenie liczby otrzymanych stron i dokładniejsze wyniki

wyszukiwania. Na przykład gdy poszukujemy stron internetowych szkół wyższych. Na pytanie szkoły baza

wyszukiwarki zwróci nam bardzo dużą listę adresów. Dzięki możliwości przeszukania otrzymanych wyników zadajemy

ponowne pytanie wyższe, ograniczając w ten sposób liczbę otrzymanych wyników.

Można podać wiele słów kluczowych, ale nie należy przesadzać z ich liczbą i podać je w dobrej kolejności. Wyniki

wyszukiwania programowanie komputerów, będą inne niż komputerów programowanie. Niektóre narzędzia i tak nie

„czytają” długich zapytań, np. Google bierze pod uwagę tylko 10 słów i ignoruje pewne typowe wyrazy (na przykład

angielskie „the” i „and”), a także niektóre pojedyncze cyfry i litery, ponieważ spowalniają one wyszukiwanie, nie

zapewniając lepszych wyników. Google informuje szczegółowo o wykluczonych często używanych wyrazach na

stronie wyników pod polem wyszukiwania. Ważna jest kolejność podawanych wyrazów.

Wyszukiwanie frazy

Wpisanie do wyszukiwarki dwóch słów np. program nauczania spowoduje wyświetlenie stron zawierających słowo

program i witryn zawierających wyraz nauczania oraz tych, które zawierają oba słowa. Gdy oba wyrazy umieścić w

cudzysłowie, otrzymamy listę zawierającą adresy stron, które w swoim tekście posiadają dwa słowa obok siebie i to w

pożądanej kolejności.

Wyszukiwanie rozmyte

Wyszukiwanie rozmyte polega na uwzględnieniu różnych form danego wyrazu. W pytaniu podajemy początek wyrazu

pozostałą część zastępujemy znakiem ? lub *. Znak ? zastępuje tylko jedną literę, zaś * zastępuje większą liczbę

znaków. Jak widać w podanym przykładzie szukamy ogólnie stron na temat poczty. Jednak gdy wpiszemy słowo poczta

to wyszukiwarka wyświetli nam adresy stron zawierających wyraz poczta, a pominie strony zawierające wyrazy poczty,

pocztowy itp.

W Google znak „~” oznacza synonim, czyli np. wpisując ~program znajdziemy w wynikach również słowo software.

Konieczność występowania wyrazu lub nie

Inną możliwość dają nam dwa znaki + i – koniecznie ze spacją przed znakiem. Pierwszy wymusza wyświetlenie stron,

które muszą zawierać wyraz poprzedzony +. Drugi zaś wyklucza strony zawierające dane słowo. Czasem przydaje się,

gdy słowo ma kilka znaczeń. Np. gdy szukamy informacji o protokołach sieciowych możemy podać zapytanie: protokół

–dyplomacja. A zapytanie Wojna Światowa +I zapewni nam informacje o I Wojnie.

Operatory zaawansowane

Zastosowanie ich da nam ograniczanie wyników wyszukiwania do stron z określonych krajów lub domen. Domenę

można określić dodając do wyszukiwanego hasła operator ,,site” Operator ten działa w przypadku domen sieciowych i

domen najwyższego poziomu. Przykłady: music site:pl, lemur site:org, rekrutacja site:edu.pl, ranking site:google.com

Możemy jeszcze ograniczać:

miejsce strony gdzie mają się znajdować wyszukiwane hasła – w tytule lub w jej adresie URL: intitle:"Podstawy

informatyki", allintitle:Podstawy informatyki, inurl: algorytmy struktury, allinurl: algorytmy struktury

typ pliku

filetype:pdf OR filetype:ppt "boolean searching"

link wewnątrz dokumentu

link: ki.uni.lodz.pl

Bibliografia

Alesso H. P., Smith C. Thinking on the Web: Berners-Lee, Gödel, and Turing, Wiley-Interscience, 2008

Antoniou G., Van Harmelen F. A semantic Web primer, The MIT Press, 2008

Bergman M. K., The Deep Web: Surfacing Hidden Value, "Journal of Electronic Publishing", Volume 7, Issue 1,

08.2001

Berners-Lee T., Hendler J., Lassila O., The Semantic Web: A new form of Web content that is meaningful to computers

will unleash a revolution of new possibilities, "Scientific American" 05/2001

Breitman K., Casanova M., Truszkowski W., Semantic Web: concepts, technologies and applications, Springer 2007

Gontar B., Papińska-Kacperek J. Semantyczne wyszukiwarki internetowe, w: ACTA UNIVERSITATIS LODZIENSIS.

FOLIA OECONOMICA, Uniwersytet Łódzki, 2011

http://dspace.uni.lodz.pl:8080/xmlui/bitstream/handle/123456789/803/165-179.pdf?sequence=1

Gulli A. Signorini A. The indexable web is more than 11.5 billion pages, Proceeding WWW 2005

Kashyap V., Bussler C., Moran M. The Semantic Web: semantics for data and services on the Web, Springer, 2008

Lewandowski D. Web searching, search engines and Information Retrieval, Information Services & Use 25(2005)3

Lewandowski D. Mayr P. Exploring the Academic Invisible Web, Library Hi Tech, 24 (2006) 4. pp. 529-539

Papińska-Kacperek J. Wyszukiwanie informacji w internecie, materiały dla studentów 2006

http://www.ki.uni.lodz.pl/~jpapkac/podstawy/wyszukiwanie.pdf

Papińska-Kacperek J. Gontar B. Wyszukiwarki semantyczne, w: Wiedza i komunikacja w innowacyjnych organizacjach,

Katowice, red. M. Pańkowska, Wydawnictwo UE, Katowice, 2011, s. 134-149

Sherman C., Price G. The invisible Web: uncovering information sources search engines can't see Information Today,

Inc, 2001

Społeczeństwo informacyjne, red. Papińska-Kacperek J., PWN 2008

Wyniki wyszukiwania Google a satysfakcja użytkowników, raport http://www.bluerank.pl/pdfs/Raport%20%20wyniki%20wyszukiwania%20Google%20a%20satysfakcja%20uzytkownikow.pdf 2008