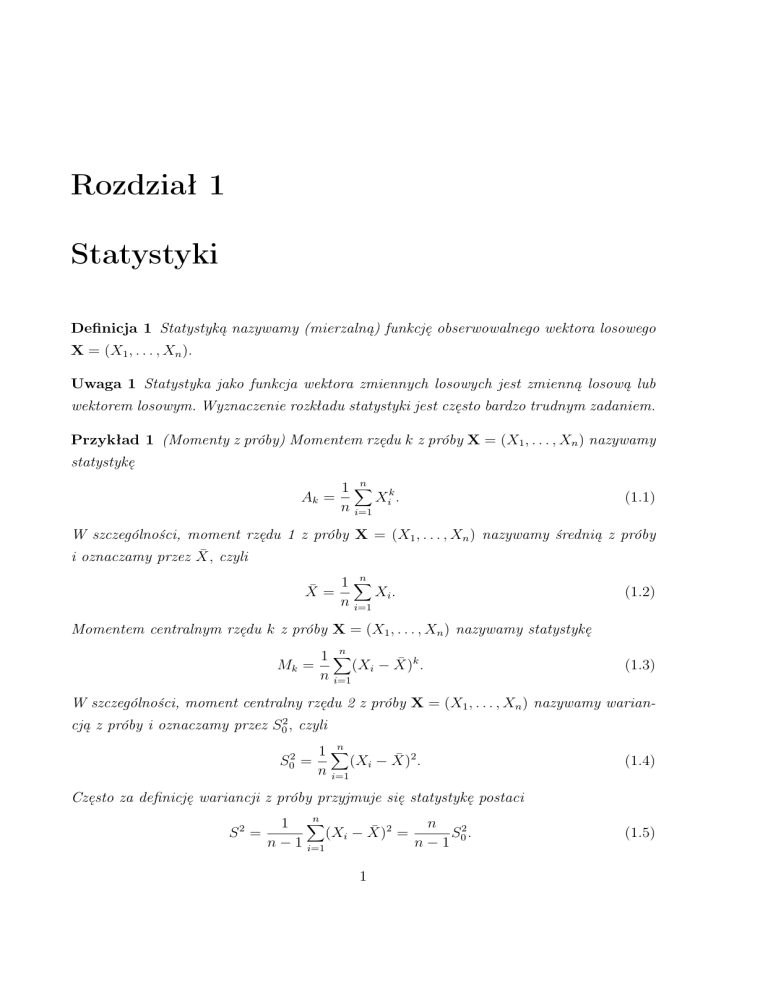

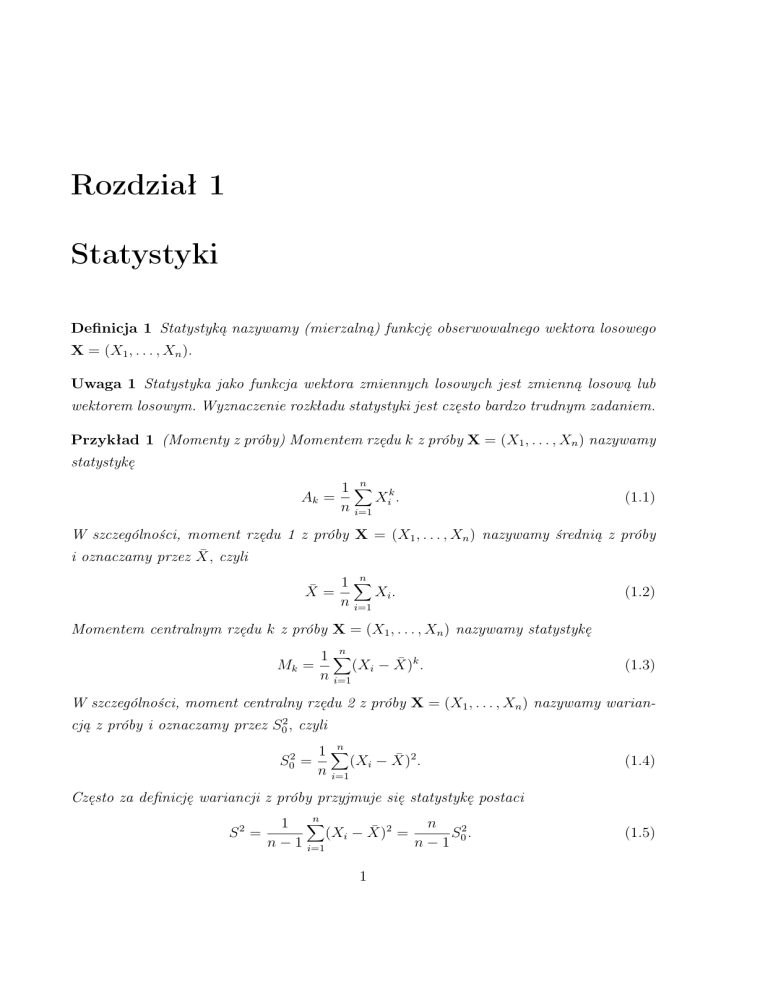

Rozdział 1

Statystyki

Definicja 1 Statystyką nazywamy (mierzalną) funkcję obserwowalnego wektora losowego

X = (X1 , . . . , Xn ).

Uwaga 1 Statystyka jako funkcja wektora zmiennych losowych jest zmienną losową lub

wektorem losowym. Wyznaczenie rozkładu statystyki jest często bardzo trudnym zadaniem.

Przykład 1 (Momenty z próby) Momentem rzędu k z próby X = (X1 , . . . , Xn ) nazywamy

statystykę

n

1∑

Ak =

Xik .

n i=1

(1.1)

W szczególności, moment rzędu 1 z próby X = (X1 , . . . , Xn ) nazywamy średnią z próby

i oznaczamy przez X̄, czyli

X̄ =

n

1∑

Xi .

n i=1

(1.2)

Momentem centralnym rzędu k z próby X = (X1 , . . . , Xn ) nazywamy statystykę

Mk =

n

1∑

(Xi − X̄)k .

n i=1

(1.3)

W szczególności, moment centralny rzędu 2 z próby X = (X1 , . . . , Xn ) nazywamy wariancją z próby i oznaczamy przez S02 , czyli

S02

n

1∑

=

(Xi − X̄)2 .

n i=1

(1.4)

Często za definicję wariancji z próby przyjmuje się statystykę postaci

S2 =

n

1 ∑

n

S 2.

(Xi − X̄)2 =

n − 1 i=1

n−1 0

1

(1.5)

Twierdzenie 1 Jeżeli X = (X1 , . . . , Xn ) jest próbą z rozkładu normalnego N (µ, σ 2 ), to

(i) średnia X̄ z próby X ma rozkład normalny N (µ, σ 2 /n);

(ii) (n − 1)S 2 /σ 2 ma tzw. rozkład χ2 o n − 1 stopniach swobody;

(iii) zmienne losowe X̄ i S 2 są niezależne;

(iv) zmienna losowa

X̄ √

n

S

ma tzw. rozkład t-Studenta o n − 1 stopniach swobody.

Przykład 2 (Statystyki pozycyjne) W praktyce duże znaczenie mają tzw. statystyki pozycyjne z próby X = (X1 , . . . , Xn ). Statystykę Xi:n , której wartość jest równa i-tej co do

wielkości wartości w uporządkowanym rosnąco ciągu zmiennych losowych X1 , . . . , Xn nazywamy i-tą statystyką pozycyjną. Najczęściej wyznacza się pierwszą statystyką pozycyjną

(minimum), która jest postaci

X1:n = min{X1 , . . . , Xn }

(1.6)

oraz n-tą statystyką pozycyjną (maksimum), która jest postaci

Xn:n = max{X1 , . . . , Xn }.

2

(1.7)

Rozdział 2

Estymacja parametryczna

Estymacja parametryczna jest formą wnioskowania statystycznego, której zadaniem jest

oszacowanie nieznanych parametrów, bądź ich funkcji, na podstawie obserwacji realizacji

x obserwowalnego wektora losowego X o rozkładzie zależnym od tych parametrów.

W teorii estymacji wyróżniamy dwa podejścia: estymację punktową i estymację poprzez podanie tzw. zbioru ufności. W przypadku, gdy szacowany parametr jest parametrem rzeczywistym, w tym drugim podejściu, najczęściej konstruuje się tzw. przedział

ufności i estymację tego typu nazywamy estymacją przedziałową.

2.1

Estymacja punktowa

Definicja 2 Estymatorem parametru ϑ nazywamy statystykę ϑ̂ = T (X1 , . . . , Xn ), której

wartość, dla konkretnej realizacji (x1 , . . . , xn ) wektora losowego X = (X1 , . . . , Xn ), przyjmujemy za ocenę nieznanego parametru ϑ.

Otrzymaną na podstawie jednej konkretnej realizacji x wektora losowego X wartość estymatora ϑ̂ nazywamy oceną (oszacowaniem) nieznanego parametru ϑ.

2.1.1

Metody wyznaczania estymatorów

Istnieje szereg metod wyznaczania estymatorów punktowych. Do najczęściej stosowanych

zaliczamy: metodę momentów, metodę największej wiarogodności, metodę najmniejszych

kwadratów, metodę kwantyli, metodę podstawiania dystrybuanty empirycznej, metodę

podstawiania częstości, uogólnioną metodę momentów, metodę najmniejszej odległości,

metodę funkcji estymujących. W dalszej części wykładu omówimy dwie pierwsze metody

z wyżej wymienionych.

3

Metoda momentów

Metoda momentów polega na przyrównaniu pewnej liczby (najczęściej kolejnych) momentów z próby do odpowiednich momentów rozkładu, które są funkcjami nieznanych

parametrów. Wykorzystujemy tyle momentów ile jest parametrów do oszacowania i rozwiązując otrzymany układ równań ze względu na ϑ, uzyskujemy oceny tych parametrów.

Na przykład niech ϑ = (ϑ1 . . . , ϑk ) będzie nieznanym parametrem, który chcemy estymować na podstawie obserwacji x próby X = (X1 . . . , Xn ). Niech Aj =

1

n

∑n

i=1

Xij oznacza

moment rzędu j z próby X, a mj = E(X1j ) – moment rzędu j obserwowalnych zmiennych

losowych X1 , . . . , Xn (wektor X jest próbą, zatem zmienne losowe X1 , . . . , Xn mają ten

sam rozkład, więc E(X1j ) = . . . = E(Xnj )). Wówczas rozwiązując układ równań

A (X)

1

···

A (X)

k

=

m1 (ϑ1 , . . . , ϑk )

··· ···

=

mk (ϑ1 , . . . , ϑk )

ze względu na ϑ1 , . . . , ϑk , uzyskamy estymator ϑ̂ metodą momentów (MM) parametru ϑ.

Metoda momentów jest często bardzo prosta w użyciu, co pokazuje następujący przykład.

Przykład 3 Niech X = (X1 . . . , Xn ) będzie próbą z rozkładu Poissona P(λ) z parametrem

λ, który chcemy estymawać. W tym przypadku nieznany parametr jest jednowymiarowy

(k = 1) i do wyznaczenia estymatora parametru λ wystarczy przyrównać jeden moment

z próby do odpowiedniego momentu rozkładu Poissona. Wiadomo, że wartość oczekiwana

E(X) w rozkładzie Poissona jest równa λ, zatem m1 = λ i po przyrównaniu tego momentu

do odpowiedniego momentu z próby, czyli A1 = X̄, otrzymujemy równanie

X̄ = λ,

którego właściwie nawet nie musimy rozwiązywać (ze względu na λ). Estymatorem parametru λ w rozkładzie Poissona, uzyskanym metodą momentów, jest zatem λ̂ = X̄.

Zauważmy jednak, że do wyznaczenia estymatora parametru λ w rozkładzie Poissona

możemy również wykorzystać momenty centralne i przyrównać na przykład moment centralny rzędu 2 z próby do momentu centralnego rzędu 2 rozkładu. Stąd mamy równanie

M2 = S02 =

n

1∑

(Xi − X̄)2 = E[X1 − E(X1 )]2 = Var(X1 ) = λ

n i=1

i otrzymujemy drugi estymator parametru λ, uzyskany metodą momentów, postaci λ̂ = S02 .

4

Z powyższego przykładu widać, że metoda momentów może prowadzić do różnych

estymatorów nieznanego parametru i to jest jedną z jej wad.

Przykład 4 Niech X = (X1 . . . , Xn ) będzie próbą z rozkładu normalnego N (µ, σ 2 , gdzie

µ ∈ R i σ > 0 są nieznanymi parametrami, które chcemy oszacować. Przyrównując pierwszy moment zwykły rozkładu N (µ, σ 2 , czyli µ, do momentu rzędu 1 z próby X, czyli X̄,

oraz drugi moment centralny rozkładu N (µ, σ 2 , czyli σ 2 , do momentu centralnego rzędu 2

z próby X, czyli S02 , otrzymujemy następujące estymatory nieznanych parametrów µ i σ

µ̂ = X̄, σ̂ = S0 .

Metoda największej wiarogodności

Niech X = (X1 , . . . , Xn ) będzie obserwowalnym wektorem losowym o rozkładzie, który

zależy od niezananego parametru ϑ = (ϑ1 , . . . , ϑk ) ∈ Θ. W przypadku, gdy wektor losowy

X jest typu ciągłego, oznaczmy przez f gęstość jego rozkładu, natomiast, gdy jest on

typu dyskretnego, oznaczmy przez p jego funkcję prawdopodobieństwa. Zauważmy, że

z założenia, że rozkład wektora losowego X zależy od nieznanego parametru ϑ, f lub p są

funkcjami nie tylko obserwacji x, ale również parametru ϑ. Fakt ten będziemy zaznaczać,

podając nieznany parametr w indeksie funkcji f lub p następująco: fϑ (x) lub pϑ (x).

Definicja 3 Funkcją wiarogodności obserwowalnego wektora losowego X nazywamy funkcję gęstości lub funkcję prawdopodobieństwa wektora X, traktowaną jako funkcję parametru

ϑ przy ustalonej wartości realizacji x. Funkcję wiarogodności oznaczamy przez L(ϑ; x).

Przykład 5 Niech X = (X1 . . . , Xn ) będzie próbą z rozkładu Poissona P(λ) z parametrem

λ. Rolę niezanego parametru ϑ pełni w tym przypadku parametr λ, k = 1 i Θ = (0, ∞).

Funkcja prawdopodobieństwa pλ wektora losowego X jest w tym przypadku postaci

pλ (x1 , . . . , xn ) =

n

∏

λx i

i=1

xi !

λ

∑n

exp(−λ) = ∏n

i=1

i=1

xi

xi !

exp(−nλ),

gdzie xi ∈ {0, 1, 2, . . .}, i = 1, . . . , n. Zatem funkcja wiarogodności L jest postaci

λ

∑n

L(λ; x1 , . . . , xn ) = ∏n

i=1

i=1

xi

xi !

exp(−nλ),

(2.1)

gdzie argumentem jest λ ∈ (0, ∞), natomiast x1 , . . . , xn traktowane są jako znane realizacje zmiennych losowych odpowiednio X1 , . . . , Xn .

5

Definicja 4 Oszacowaniem parametru ϑ, uzyskanym metodą największej wiarogodności,

nazywamy wartość ϑ̂, która spełnia następującą równość

L(ϑ̂; x1 , . . . , xn ) = max L(ϑ; x1 , . . . , xn ),

θ∈Θ̄

gdzie Θ̄ oznacza domknięcie zbioru Θ.

Uwaga 2 Dla konkretnej realizacji x obserwowalnego wektora losowego X może nie istnieć maksimum funkcji wiarogodności i w konsekwencji może nie istnieć oszacowanie

największej wiarogodności parametru ϑ. Można również podać przykłady, w których dla

konkretnej realizacji x obserwowalnego wektora losowego X istnieje nieskończenie wiele

wartości, dla których funkcja wiarogodności L przyjmuje wartość największą. Ponadto,

w praktyce, często oszacowanie największej wiarogodności możemy wyznaczyć jedynie numerycznie.

W celu wyznaczenia oszacowania największej wiarogodności parametru ϑ = (ϑ1 , . . . , ϑk )

należy wyznaczyć maksimum funkcji wiarogodności L na zbiorze Θ̄. Jeżeli funkcja L jest

różniczkowalna ze względu na ϑi , i = 1, . . . , k, to punktami podejrzanymi o ekstremum

funkcji L są rozwiązania układu równań wiarogodności postaci

∂L

= 0,

∂ϑi

i = 1, . . . , k. Funkcja wiarogodności jest najczęściej iloczynem funkcji zależnych od θ

i wyznaczenie pochodnej iloczynu, a następnie szukanie jej miejsc zerowych może być

trudnym zadaniem. Możemy jednak uprościć zadanie wyznaczenia maksimum funkcji L.

Korzystając z tego, że logarytm jest funkcją ściśle rosnącą, mamy, że funkcja L i funkcja

l := ln L mają maksima w tych samych punktach. W wielu przypadkach dużo prościej

wyznacza się pochodną funkcji l niż pochodną funkcji L. Równania postaci

∂l

= 0,

∂ϑi

i = 1, . . . , k, również nazywamy równaniami wiarogodności.

Przykład 6 W przypadku obserwacji próby z rozkładu Poissona P(λ) z parametrem λ,

funkcja wiarogodności jest postaci (2.1). W celu wyznaczenia oszacowania największej wiarogodności prametru λ, wyznaczymy maksimum funkcji wiarogodności L. Funkcja L jest

funkcją różniczkowalną ze względu na λ, ale jak widać, prościej będziemy mogli wyznaczyć

pochodną i miejsca zerowe pochodnej funkcji l = ln L, która jest w tym przypadku postaci

l(λ; x1 , . . . , xn ) = ln(λ)

n

∑

i=1

6

xi − ln(

n

∏

i=1

xi !) − nλ.

(2.2)

Równanie wiarogodności jest w tym przypadku postaci

∑n

′

i=1

l (λ; x1 , . . . , xn ) =

λ

xi

− n = 0.

Rozwiązaniem równania wiarogodności (2.2) jest λ̂ =

∑n

i=1

(2.3)

xi /n = x̄ i l′′ (λ̂) < 0, czyli λ̂

jest maksimum funkcji l i również L i jest zatem oszacowaniem największej wiarogodności

parametru λ.

2.1.2

Własności estymatorów

Dla danego parametru ϑ można utworzyć wiele estymatorów ϑ̂, ale pożądane jest by

charakteryzowały go pewne narzucone z góry własności optymalności. Do takich własności

zaliczamy:

• nieobciążoność,

• efektywność,

• zgodność.

Definicja 5 Estymator T = ϑ̂ nazywamy estymatorem nieobciążonym parametru ϑ, jeżeli

dla każdego θ ∈ Θ jego wartość oczekiwana jest równa szacowanemu parametrowi θ, tzn.

Eϑ (T ) = ϑ, ∀θ ∈ Θ.

Przykład 7 Średnia X z próby X = (X1 , . . . , Xn ) jest nieobciążonym estymatorem wartości oczekiwanej ϑ = E(Xi ).

Przykład 8 Wariancja S 2 z próby X = (X1 , . . . , Xn ) jest nieobciążonym estymatorem

wariancji σ 2 = E(X − EX)2 .

Definicja 6 Niech T1 i T2 będą dwoma nieobciążonymi estymatorami parametru ϑ. Jeżeli Var(T1 ) ¬ Var(T2 ), dla każdego θ ∈ Θ, to mówimy, że estymator T1 jest lepszy od

estymatora T2 .

Definicja 7 Estymator T = ϑ̂ nazywamy estymatorem najefektywniejszym parametru ϑ,

jeżeli jest niebciążony i jeżeli dla dowolnego estymatora nieobciążonego T1 , V arθ (T ) ¬

V arϑ (T1 ) dla każdego θ ∈ Θ. Estymator najefektywniejszy nazywany jest często estymatorem najlepszym.

7

Przykład 9 Jeżeli X1 , . . . , Xn jest próbą z rozkładu normalnego N (µ, σ 2 ), to średnia z

próby X i wariancja z próby S 2 są najlepszymi estymatorami odpowiednio µ i σ 2 .

Definicja 8 Estymator T = ϑ̂ nazywamy estymatorem zgodnym, jeżeli dla każdego dodatniego ϵ spełniony jest warunek

lim P (| T − ϑ |> ϵ) = 0.

n→∞

2.2

Estymacja przedziałowa

Niech X = (X1 , . . . , Xn ) będzie obserwowalnym wektorem losowym z rozkładu Pϑ , gdzie

ϑ ∈ Θ ⊆ R jest nieznanym parametrem, który chcemy oszacować. Metody estymacji

punktowej pozwalają uzyskiwać oceny punktowe nieznanych parametrów, przy czym na

ich podstawie nie potrafimy odpowiedzieć na pytanie jaka jest dokładność uzyskanej oceny.

Estymacja przedziałowa jest sposobem estymacji dającym możliwość oceny tej dokładności i polega na podaniu tzw. przedziałów ufności dla nieznanych parametrów (bądź funkcji

tych parametrów) danego rozkładu.

Definicja 9 Niech X = (X1 , . . . , Xn ) będzie obserwowalnym wektorem losowym o rozkładzie Pϑ , ϑ ∈ Θ ⊆ R. Przedziałem ufności dla parametru ϑ na poziomie ufności 1 − α,

0 < α < 1, w oparciu o wektor X, nazywamy losowy przedział (TL , TU ) spełniający następujące warunki:

• jego końce TL = TL (X), TU = TU (X) są funkcjami wektora X = (X1 , . . . , Xn ) i nie

zależą od szacowanego parametru ϑ i innych nieznanych parametrów, jeżeli takie

występują w modelu,

• prawdopodobieństwo pokrycia przez ten przedział nieznanego parametru ϑ wynosi co

najmniej 1 − α, dla każdego ϑ ∈ Θ, tzn.

Pϑ (TL (X) < ϑ < TU (X)) ­ 1 − α, ∀θ ∈ Θ.

2.2.1

Metody wyznaczania przedziałów ufności

Istnieje kilka metod konstrukcji przedziałów ufności. Jedna z nich polega na wykorzystaniu

tzw. funkcji centralnych (wiodących, estymujących).

Definicja 10 Niech X = (X1 , . . . , Xn ) będzie obserwowalnym wektorem losowym o rozkładzie Pϑ . Funkcję Q(X, ϑ) nazywamy funkcją centralną (wiodocą lub estymującą) dla

parametru ϑ, jeżeli jej rozkład prawdopodobieństwa nie zależy od ϑ.

8

Przykład 10 Niech X = (X1 , . . . , Xn ) będzie próbą z rozkładu normalnego N (µ, σ02 ),

gdzie µ ∈ R jest nieznanym parametrem, a σ0 znaną liczbą dodatnią. Niech

Q(X, µ) =

√

n(X − µ)/σ0 ,

(2.4)

1 ∑n X . Można pokazać, że funkcja Q(X, µ) ma rozkład normalny N (0, 1),

gdzie X = n

i

i=1

niezależny od nieznanego parametru µ. Jest więc ona funkcją centralną dla parametru µ.

Przykład 11 Niech X = (X1 , . . . , Xn ) będzie próbą z rozkładu normalnego N (µ, σ 2 ),

gdzie µ0 jest znane, a σ ∈ R+ jest nieznanym parametrem. Niech

S12

n

1∑

=

(Xi − µ0 )2 .

n i=1

Można pokazać, że funkcja

Q(X, σ 2 ) = nS12 /σ 2

(2.5)

ma rozkład χ2 z n stopniami swobody, niezależny od nieznanego parametru σ 2 . Jest więc

ona funkcją centralną dla parametru σ 2 .

Przykład 12 Niech X = (X1 , . . . , Xn ) będzie próbą z rozkładu normalnego N (µ, σ 2 ),

gdzie µ ∈ R i σ ∈ R+ są nieznanymi parametrami. Niech

1 ∑n X oraz S 2 = 1 ∑n (X − X)2 .

X=n

i

i=1

n − 1 i=1 i

Można pokazać, że funkcja

Q(X, µ) =

√

n(X − µ)/S

(2.6)

ma rozkład t Studenta z n − 1 stopniami swobody, niezależny od nieznanego parametru

µ i również niezależny od nieznanego parametru σ. Jest więc ona funkcja centralną dla

parametru µ.

Również można pokazać, że funkcja

Q(X1 , . . . , Xn , σ 2 ) =

√

n − 1S 2 /σ 2

(2.7)

ma rozkład χ2 z n − 1 stopniami swobody, niezależny od σ 2 i również niezależny od nieznanego parametru µ. Jest więc ona funkcją centralną dla parametru σ 2 .

9

Załóżmy teraz, że dysponujemy funkcją centralną Q(X, ϑ) dla parametru ϑ. Przedział

ufności dla parametru ϑ konstruuje się w następujący sposób. Wybieramy liczby a i b tak,

aby spełniały równość

Pϑ (a ¬ Q(X, ϑ) ¬ b) ­ 1 − α,

dla każdego ϑ ∈ Θ i zadanego α. W przypadku, gdy Q(X, ϑ) jest funkcją ciągłą i ściśle

monotoniczną parametru ϑ, to nierówność a ¬ Q ¬ b jest równoważna nierówności

TL (X, a, b) ¬ ϑ ¬ TU (X, a, b).

Stąd TL (X, a, b) oraz TU (X, a, b) są odpowiednio dolnym i górnym końcem 100(1 − α)%

przedziału ufności dla parametru ϑ. Jeżeli x = (x1 , . . . , xn ) jest realizacją obserwowalnego

wektora losowego X = (X1 , . . . , Xn ), to przedział

[TL (x, a, b), TU (x, a, b)]

nazywamy realizacją przedziału ufności dla parametru ϑ lub 100(1 − α)% oceną przedziałową parametru ϑ.

W konkretnym problemie funkcja centralna może nie istnieć lub może istnieć kilka

takich funkcji. W tym drugim przypadku należy wybrać funkcję optymalną ze względu na

pewne kryteria (np. długość przedziału ufności, który przy wykorzystaniu danej funkcji

otrzymamy). Często wybiera się funkcje centralne będące funkcjami statystyk dostatecznych, czy też optymalnych estymatorów punktowych. Przy konstrukcji przedziału ufności

oprócz problemu wyboru funkcji centralnej natrafiamy również na problem wyboru stałych a i b. Często, gdy dysponujemy już konkretną funkcją centralną, stałe a i b możemy

wybrać na nieskończenie wiele sposobów. Wówczas przy ich wyborze też powinniśmy kierować się spełnieniem pewnych kryteriów optymalności. Przykładem takiego kryterium

jest długość przedziału ufności lub wartość oczekiwana jego długości.

2.2.2

Przedziały ufności dla wartości średniej

Model I Populacja generalna ma rozkład normalny N (µ, σ 2 ). Wartość średnia µ jest

nieznana, odchylenie standardowe σ0 w populacji jest znane. Z populacji tej pobrano próbę

o liczebności n elementów, wylosowanych niezależnie. Korzystając z funkcji centralnej

Q(X, µ), określonej wzorem (2.4), otrzymujemy następujące granice ufności dla parametru

µ na poziomie ufności 1 − α

σ0

σ0

TL = X − z(1 − α2 ) √ , TU = X − z(α1 ) √ ,

n

n

10

gdzie z(p) oznacza kwantyl rzędu p standardowego rozkładu normalnego oraz α1 +α2 = α.

Można pokazać, że przyjmując α1 = α2 = α/2, otrzymamy najkrótszy przedział ufności

dla parametru µ w klasie przedziałów ufności na poziomie ufności 1 − α, skonstruowanych

przy użyciu funkcji centralnej określonej wzorem (2.4). Także w praktyce przyjmuje się

najczęściej następujące granice przedziału ufności dla parametru µ w rozkładzie normalnym, gdy σ0 jest znane

σ0

σ0

TL = X − z(1 − α/2) √ , TU = X + z(1 − α/2) √ .

n

n

√

Długość tego przedziału jest nielosowa i wynosi L = 2z(1 − α/2)σ0 / n.

(2.8)

Model II Populacja generalna ma rozkład normalny N (µ, σ 2 ). Nieznana jest zarówno

wartość średnia µ, jak i odchylenie standardowe σ w populacji. Z populacji tej pobrano

małą próbę o liczebności n elementów, wylosowanych niezależnie. Korzystając z funkcji

centralnej Q(X, µ), określonej wzorem (2.6), otrzymujemy następujące granice ufności dla

parametru µ na poziomie ufności 1 − α

S

S

TL = X − tn−1 (1 − α2 ) √ , TU = X + tn−1 (α1 ) √ ,

n

n

gdzie tn−1 (p), oznacza kwantyl rzędu p rozkładu Studenta z n − 1 stopniami swobody

oraz α1 + α2 = α. Można pokazać, że przyjmując α1 = α2 = α/2, otrzymamy przedział

ufności dla parametru µ o najmniejszej oczekiwanej długości w klasie przedziałów ufności

na poziomie ufności 1 − α, skonstruowanych przy użyciu funkcji centralnej określonej

wzorem (2.6). Także w praktyce przyjmuje się najczęściej następujące granice przedziału

ufności dla parametru µ w rozkładzie normalnym, gdy σ nie jest znane

S

S

TL = X − tn−1 (1 − α/2) √ , TU = X + tn−1 (1 − α/2) √ .

n

n

√

Długość tego przedziału jest losowa i wynosi L = 2tn−1 (1 − α/2)S/ n.

Model III Populacja generalna ma rozkład normalny N (µ, σ 2 ), bądź dowolny inny

rozkład o średniej µ i skończonej wariancji σ 2 (nieznanej). Z populacji tej pobrano do

próby n niezależnych obserwacji, przy czym rozmiar n próby jest duży. Wówczas można

pokazać, że zmienna losowa

Q(X, µ) =

√

n(X − µ)/S

ma w przybliżeniu standardowy rozkład normalny. Korzystając z tego faktu dolna TL

i górna TU granica przedziału ufności dla wartości oczekiwanej µ na poziomie ufności

równym w przybliżeniu 1 − α wyraża się wzorem (2.8) jak w modelu I, w którym zamiast

σ przyjmujemy wartość odchylenia standardowego S obliczonego z próby. Długość tego

√

przedziału jest losowa i wynosi L = 2z(1 − α/2)S/ n.

11

2.2.3

Przedziały ufności dla wariancji

Model I Populacja generalna ma rozkład normalny N (µ0 , σ 2 ). Odchylenie standardowe

σ w populacji nie jest znane, wartość średnia µ0 jest znana. Z populacji tej pobrano próbę

o liczebności n elementów, wylosowanych niezależnie. Korzystając z funkcji centralnej

Q(X, σ), określonej wzorem (2.5), otrzymujemy następujące granice ufności dla parametru

σ 2 na poziomie ufności 1 − α

TL =

nS12

nS12

,

T

=

,

U

χ2n (1 − α2 )

χ2n (α1 )

(2.9)

gdzie χ2n (p) oznacza kwantyl rzędu p rozkładu χ2n z n stopniami swobody oraz α1 +α2 = α.

W praktyce przyjmuje się najczęściej α1 = α2 = α/2. Długość otrzymanego w ten sposób

przedziału ufności jest losowa i wynosi nS12 [1/χ2n (α/2) − 1/χ2n (1 − α/2)].

Model II Populacja generalna ma rozkład normalny N (µ, σ 2 ) o nieznanych parametrach µ i σ. Z populacji tej wylosowano niezależnie do próby n elementów (n jest małe, tj.

n < 30). Korzystając z funkcji centralnej Q(X, σ), określonej wzorem (2.7), otrzymujemy

następujące granice ufności dla parametru σ 2 na poziomie ufności 1 − α

TL =

(n − 1)S 2

(n − 1)S 2

,

T

=

,

U

χ2n−1 (1 − α2 )

χ2n−1 (α1 )

(2.10)

gdzie χ2n−1 (p) oznacza kwantyl rzędu p rozkładu χ2n−1 z n − 1 stopniami swobody oraz

α1 + α2 = α. W praktyce przyjmuje się najczęściej α1 = α2 = α/2. Długość otrzymanego

w ten sposób przedziału ufności jest losowa i wynosi nS 2 [1/χ2n−1 (α/2) − 1/χ2n−1 (1 − α/2)].

Model III Populacja generalna ma rozkład normalny N (µ, σ 2 ), bądź dowolny inny

rozkład o średniej µ i skończonej wariancji σ 2 . Z populacji tej pobrano do próby n niezależnych obserwacji, przy czym rozmiar n próby jest duży. Wówczas można pokazać, że

zmienna losowa

√

Q(X, σ) =

2(n − 1)S/σ −

√

2n − 3

ma w przybliżeniu standardowy rozkład normalny. Korzystając z tego faktu dolna TL

i górna TU granica przedziału ufności dla odchylenia standardowego σ na poziomie ufności

równym w przybliżeniu 1 − α wyraża się następującym wzorem

√

√

√

√

TL = S 2n − 2/(z(1 − α2 ) + 2n − 3), TU = S 2n − 2/(z(α1 ) + 2n − 3), (2.11)

gdzie z(p) oznacza kwantyl rzędu p standardowego rozkładu normalnego oraz α1 +α2 = α.

12

Uwaga 3 Przedziały ufności na poziomie ufności 1 − α dla odchylenia standardowego σ

w modelu I i w modelu II otrzymujemy pierwiastkując granice ufności określone odpowiednio wzorami (2.9) i (2.10). Natomiast przedziały ufności na poziomie ufności 1 − α dla

wariancji σ 2 w modelu III otrzymujemy podnosząc do kwadratu granice ufności określone

wzorem (2.11).

2.2.4

Przedziały ufności dla prawdopodobieństwa sukcesu

Niech X = (X1 , . . . , Xn ) będzie próbą z rozkładu dwumianowego B(1, p), gdzie p ∈ (0, 1)

jest nieznanym parametrem. Oznaczmy X =

∑n

i=1

Xi . Wiadomo, że X ma rozkład B(n, p).

Na podstawie obserwacji zmiennej losowej X chcemy skonstruować przedział ufności, na

poziomie ufności 1 − α, dla parametru p. Granice ufności TL i TU będą zatem funkcjami

X, n i α takimi, że

Pp (TL (X, n, α) < p < TU (X, n, α)) ­ 1 − α.

Istnieje wiele metod konstrukcji przedziałów ufności dla parametru p (zobacz np. Blyth

i Still, 1983). Najczęściej metody te są dzielone na dwie grupy: przedziały ufności w

przypadku, gdy rozmiar n próby jest “mały” oraz przedziały ufności w przypadku, gdy

rozmiar próby jest “duży”.

Przypadek małego rozmiaru próby

Oznaczmy przez Beq (a, b) kwantyl rzędu q rozkładu beta z parametrami a, b. Dolna granica

przedziału ufności Cloppera-Pearsona dla parametru p, na poziomie ufności 1 − α jest

postaci

0,

TL (X) =

Be

gdy X = 0,

α/2 (X, n

− X + 1), gdy X ̸= 0,

natomiast górna granica przedziału ufności wyraża się wzorem

1,

TL (X) =

Be

gdy X = n,

1−α/2 (X

+ 1, n − X), gdy X ̸= n.

Powyższe przedziały ufności zostały zaproponowane przez Cloppera-Pearsona w roku

1934. Posiadają one wiele pożądanych własności, ale charakteryzują się dość dużą oczekiwaną długością i z tego powodu były modyfikowane w różny sposób.

13

Przypadek dużego rozmiaru próby

W przypadku, gdy rozmiar n próby X jest duży, przy wyznaczaniu przedziałów ufności

dla parametru p możemy skorzystać z następującej aproksymacji

√

n(p̂ − p)

√

∼ N (0, 1)

p̂(1 − p̂)

(2.12)

lub

√

n(p̂ − p)

√

p(1 − p)

∼ N (0, 1),

(2.13)

gdzie p̂ = X/n.

Korzystając z aproksymacji (2.12), otrzymujemy następujące granice ufności

√

TL (X, n, α) = p̂ − c p̂(1 − p̂)

(2.14)

i

√

TU (X, n, α) = p̂ + c p̂(1 − p̂),

(2.15)

gdzie

c=

z(1 − α/2)

√

,

n

(2.16)

i z(1−α/2) jest kwantylem rzędu 1−α/2 standardowego rozkładu normalnego. Natomiast

korzystając z aproksymacji (2.13) otrzymujemy następujące granice ufności

√

TL (X, n, α) =

2p̂ + c2 − c c2 + 4p̂(1 − p̂)

2(1 + c2 )

,

(2.17)

,

(2.18)

√

TU (X, n, α) =

2.2.5

2p̂ + c2 + c c2 + 4p̂(1 − p̂)

2(1 + c2 )

Przedziały ufności dla różnicy dwóch prawdopodobieństw

sukcesu

Istnieje co najmniej jedenaście metod konstrukcji przedziałów ufności dla różnicy dwóch

prawdopodobieństw sukcesu (zobacz np. Newcombe, 1998 i Prendergast, 2014).

14