Wprowadzenie do sieci

Wiadomości podstawowe

W swojej działalności człowiek eksploatuje różne sieci, np. kolejową, Z czego składa się

lotniczą, pocztową, a zwłaszcza drogową. Sieci te służą do transportu sieć?

ludzi, towarów lub wiadomości. Sieć komputerowa służy do

przesyłania (transmisji) informacji, która może mieć charakter

multimedialny (składać się z tekstów, obrazów i głosu). Przesyłanie

w sieci komputerowej odbywa się z bardzo dużymi szybkościami

(przepływnościami), co jest osiągane dzięki zastosowaniu techniki

elektronicznej oraz oprogramowania komputerowego i może mieć

zasięg od lokalnego do ogólnoświatowego (np. sieć Internet).

Informacja w sieci komputerowej, zanim zostanie przesłana do

miejsca przeznaczenia, znowu podobnie jak w wypadku innych sieci,

jest "pakowana" w pewnego rodzaju "kontenery sieciowe", zwane

jednostkami danych (Data Units). W węzłach (na skrzyżowaniach) każdej sieci, także

komputerowej, podejmowane są decyzje o dalszej trasie ruchu kontenera sieciowego. W tym

miejscu zachęcam do krótkiej analizy rysunku, na którym pokazano podobieństwo sieci

komputerowej do innych rodzajów sieci. Uświadomienie sobie tych analogii może ułatwić

zrozumienie mechanizmów pracy sieci komputerowej.

Co to jest intersieć?

Intersieć składa się z wielu sieci najczęściej połączonych routerami (routers), pełniących rolę

urządzeń kierujących pakiety między sieciami.

Sieci w intersieci mogą być także łączone innymi urządzeniami intersieciowymi, na przykład

mostami (bridges). W intersieci każda sieć musi mieć swój unikatowy adres, a w ramach

danej sieci - każda stacja sieciowa.

Wyraźnie rozróżniajmy dwa pojęcia: sieć (Network) i intersieć (Internetwork). Pozwoli to

uniknąć nieporozumień wynikających z tego, że w języku polskim zarówno sieć, jak i

intersieć są nazywane siecią (po prostu intersieć jest większą, bardziej złożoną siecią).

Jak i dlaczego doszło do powstania intersieci?

Ćwierć wieku temu w pierwszych sieciach komputerowych

stosowano duże komputery (Mainframes) oraz podłączone do nich

terminale (Terminals). Rozwiązania takie były używane przez

amerykańskie firmy IBM (system SNA - Systems Network

Architecture) i DEC (system DNA - Digital Network Architecture).

Znaczenie tych systemów staje się dzisiaj coraz mniejsze.

Z czego składa się

intersieć?

Sieci lokalne - LAN (Local Area Networks) - pojawiły się po

uruchomieniu masowej produkcji i upowszechnieniu zastosowań

komputerów personalnych PC (Personal Computers). Sieci LAN

umożliwiały wymianę zbiorów informacji (Files) i komunikatów (Messages) między

użytkownikami znajdującymi się na niewielkim obszarze geograficznym, a także wspólne

użytkowanie zasobów (Shared Resources), np. serwerów zbiorów (File Servers).

Sieci rozległe - WAN (Wide Area Networks) - łączą ze sobą oddzielne sieci LAN używając

do tego celu zwykłych sieci telefonicznych lub innych mediów. W ten sposób sieci WAN

łączą ze sobą geograficznie oddalonych użytkowników.

Coraz częściej są stosowane szybkie sieci LAN (High speed LANs) i przełączane intersieci

(Switched Internetworks) przede wszystkim dlatego, że - pracując z dużymi

przepływnościami - umożliwiają realizację takich zastosowań jak tele- i wideokonferencje.

Można zatem wyróżnić trzy główne przyczyny powstania intersieci:

1. Izolowane sieci LAN uniemożliwiały elektroniczną komunikację użytkowników

pracujących w różnych biurach lub wydziałach tej samej instytucji.

2. Powielanie zasobów, rozumiane jako potrzeba dostarczania takich samych modułów

sprzętowych i programowych, instalowanych w każdym biurze lub wydziale i posiadających

swoje oddzielne zespoły specjalistów.

3. Brak systemu zarządzania siecią, co uniemożliwiałoby centralne zarządzanie siecią i

wyszukiwanie uszkodzeń.

Model OSI

Model OSI (Open Systems Interconnection) opisuje sposób

Model OSI

przepływu informacji między aplikacjami software'owymi w jednej

stacji sieciowej a software'owymi aplikacjami w innej stacji sieciowej

przy użyciu kabla sieciowego. Model OSI jest modelem

koncepcyjnym, skomponowanym z siedmiu warstw, z których każda

opisuje określone funkcje sieciowe. Model został opracowany przez

ISO (International Standardization Organization) w 1984 r. i w

zasadzie powinien być znany przez każdego, kto zajmuje się sieciami

komputerowymi. Model OSI dzieli zadanie przesyłania informacji między stacjami

sieciowymi na siedem mniejszych zadań składających się na poszczególne warstwy. Zadanie

przypisane każdej warstwie ma charakter autonomiczny i może być implementowane

niezależnie.

Wprowadzenie do sieci

24-10-2001

Co to są protokoły komunikacyjne?

Należy wyraźnie zaznaczyć, że model OSI jest tylko ogólnym modelem koncepcyjnym

komunikacji między stacjami podłączonymi do sieci. Model OSI nie określa szczegółowych

metod komunikacji. Mechanizmy rzeczywistej komunikacji są określone w formie

protokołów komunikacyjnych (Communication Protocols).

Protokołem komunikacyjnym nazywamy zbiór formalnych reguł i konwencji szczegółowo

określających mechanizmy wymiany informacji między stacjami połączonymi medium

transmisyjnym (kablem sieciowym).

Protokół realizuje funkcje jednej lub wielu warstw modelu OSI. Zwracamy uwagę, że

istniejąca obecnie bardzo duża liczba różnych protokołów komunikacyjnych utrudnia często

zorientowanie się w mechanizmach działania sieci. Pomocne może okazać się uświadomienie

sobie podziału wszystkich protokołów komunikacyjnych na następujące klasy:

1. Protokoły sieci lokalnych LAN (LAN Protocols).

2. Protokoły sieci rozległych WAN (WAN Protocols).

3. Protokoły trasowania (Routing Protocols).

4. Protokoły sieciowe (Network Protocols).

Protokoły sieci lokalnych obsługują funkcje dwóch najniższych warstw modelu OSI (warstw

Fizycznej i Łącza danych). Protokoły sieci rozległych obsługują funkcje trzech najniższych

warstw modelu OSI (Fizycznej, Łącza danych i Sieciowej) i definiują komunikację przez

różne media stosowane w sieciach rozległych. Protokoły trasowania, obsługujące warstwę

Sieciową modelu OSI, są odpowiedzialne za określanie tras przepływu pakietów. Protokoły

sieciowe to zbiory wielu różnych protokołów obsługujących wyższe warstwy modelu OSI

(np. AppleTalk, DECnet, SNA, IP, IPX).

Jak odbywa się komunikacja między stacjami sieciowymi według modelu OSI?

Informacja przesyłana z aplikacji programowej w jednej stacji sieciowej (np. A) do aplikacji

software'owej w innej stacji sieciowej (np. B) musi przejść każdą warstwę modelu OSI w obu

stacjach.

Na przykład w sytuacji, gdy stacja sieciowa A, mając do przesłania aplikację programową do

stacji B, sprawia, że program aplikacyjny w stacji A wysyła swoje informacje do warstwy

Aplikacja (warstwa 7). Warstwa Aplikacja przesyła następnie informację do warstwy

Prezentacja (warstwa 6), która przesyła informację do warstwy Sesja (warstwa 5) itd., aż do

warstwy Fizycznej (warstwy 1). W warstwie Fizycznej informacja zostaje przekazana do

medium, po którym dociera do stacji sieciowej B. Tutaj warstwa Fizyczna stacji B odbiera

informację i przekazuje ją do warstwy Łącza danych (warstwa 2), która przesyła ją do

warstwy Sieciowej (warstwa 3) itd., aż do warstwy Aplikacja (warstwa 7) w stacji sieciowej

B. Na zakończenie tego procesu warstwa Aplikacja stacji B przesyła informację do

odbiorczego programu aplikacyjnego w celu zakończenia procesu komunikacji.

Proces wymiany informacji w modelu OSI

Warstwy modelu OSI używają różnych form informacji sterujących

służących do komunikowania się równorzędnych warstw różnych

stacji sieciowych. Wspomniane informacje sterujące zawierają

żądania i instrukcje wymieniane między równorzędnymi warstwami

modelu OSI.

Jak warstwy modelu

OSI współpracują ze

sobą?

Informacje sterujące mogą mieć jedną z dwóch form: nagłówka

lub końcówki. Nagłówek jest przedrostkiem dodawanym do

informacji przesyłanej "w dół", począwszy od najwyższej warstwy.

Końcówka zaś jest uzupełnieniem informacji przesyłanej "w dół", począwszy od warstwy

najwyższej.

Nagłówki, końcówki i dane są pojęciami zależnymi od warstwy, w

Kapsułkowanie w

której analizowana jest jednostka informacji. Na przykład w warstwie procesie wymiany

Sieciowej jednostka informacji składa się z nagłówka warstwy 3 i

informacji

danych. W warstwie Łącza danych cała informacja przesyłana w dół

przez warstwę Sieciową (nagłówek warstwy Sieciowej i dane) jest

traktowana jako dane.

Inaczej mówiąc, porcja danych jednostki informacyjnej w konkretnej warstwie modelu OSI

może zawierać nagłówki, końcówki i dane pochodzące ze wszystkich wyższych warstw. Jest

to znane pod nazwą kapsułkowania.

Proces wymiany informacji między warstwami modelu OSI

Wymiana informacji następuje między równorzędnymi warstwami modelu OSI. Każda

warstwa w stacji nadawczej dodaje informacje sterujące (nagłówki i/lub końcówki) do

danych, a każda warstwa w stacji odbiorczej analizuje i usuwa z tych danych informacje

sterujące.

Jeśli stacja A ma w aplikacji software'owej dane do przesłania do stacji B, to dane te są

przekazane do warstwy Aplikacja. Warstwa Aplikacja w stacji A komunikuje o tym dowolną

informację sterującą wymaganą przez warstwę Aplikacja w stacji B przez dodanie nagłówka

do danych. Wynikowa jednostka informacji (nagłówek i dane) zostaje przesłana do warstwy

Prezentacja, która dodaje swój własny nagłówek, zawierający informację sterującą

przeznaczoną dla warstwy Prezentacja w stacji B. Rozmiar jednostki informacji zwiększa się,

ponieważ w każdej warstwie dodawany jest nowy nagłówek (a czasem także końcówka)

zawierający informację sterującą przeznaczoną dla równorzędnej warstwy w stacji B.

Warstwa Fizyczna stacji A całą jednostkę informacji przekazuje do medium sieciowego.

Wprowadzenie do sieci

24-10-2001

Warstwa Fizyczna w stacji B odbiera jednostkę informacyjną i przekazuje ją do warstwy

Łącza danych. Warstwa ta odczytuje następnie informacje sterujące zawarte w nagłówku,

przygotowane przez warstwę Łącza danych w stacji A. Następnie nagłówek zostaje usunięty,

a pozostała zawartość jednostki informacji zostaje przekazana do warstwy Sieciowej. Każda

warstwa realizuje taką sama czynność: odczytuje nagłówek przynależny tej warstwie,

następnie usuwa go, a pozostałą jednostkę informacji przekazuje do następnej, wyższej

warstwy. Po zrealizowaniu takiego zadania przez warstwę Aplikacja dane są przekazane do

oprogramowania użytkowego w stacji B w formie, w jakiej zostały wysłane przez aplikacje w

stacji A.

Formaty informacji przesyłanych w sieci

W sieci (lub intersieci) przesyłane są dane oraz informacje sterujące. Jedne i drugie mogą

przyjmować różne formaty. Warto zwrócić uwagę na to, że nazwy tych formatów, zarówno w

literaturze, jak i w praktyce, nie zawsze są używane konsekwentnie i, co gorsze, czasami

zamiennie, co może powodować spore nieporozumienia.

Ramka, pakiet, komórka, datagram, segment, komunikat to formy (formaty) informacji

przesyłane w sieci (lub intersieci):

Ramka (Frame) to jednostka informacji, której źródłem i

Struktura ramki

przeznaczeniem jest warstwa Łącza danych (warstwa 2) modelu OSI.

Ramka składa się z trzech elementów:

1. Nagłówka warstwy Łącza danych,

2. Danych warstwy wyższej,

3. Końcówki warstwy Łącza danych.

Nagłówek i końcówka zawierają informację sterującą przeznaczoną dla warstwy Łącza

danych w stacji odbiorczej. Można powiedzieć, że dane z wyższej warstwy są otoczone

(kapsułkowane) przez nagłówek i końcówkę warstwy Łącza danych. Przedstawiony tu format

ramki ma charakter ogólny; każda technologia sieciowa (np. Ethernet, Token Ring, FDDI) ma

swój specyficzny format ramki, przedstawiony szczegółowo przy opisie tych technologii.

Pakiet (Packet) to jednostka informacji, której źródłem i

przeznaczeniem jest warstwa Sieciowa (warstwa 3) modelu OSI.

Pakiet składa się z trzech elementów:

1. Nagłówka warstwy Sieciowej,

2. Danych warstwy wyższej,

3. Końcówki warstwy Sieciowej.

Struktura pakietu

Nagłówek i końcówka zawierają informację sterującą przeznaczoną dla warstwy 3 w stacji

odbiorczej. Można powiedzieć, że dane z wyższej warstwy są otoczone (kapsułkowane) przez

nagłówek i końcówkę warstwy 3.

Komórka (Cell) to jednostka informacji złożona z dwóch elementów: Struktura komórki

1. Nagłówka komórki o długości 5 bajtów,

2. Danych komórki o długości 48 bajtów.

Komórka ma zawsze stałą długość 53 bajtów i odnosi się do warstwy

Łącza danych (warstwa 2) modelu OSI. Komórki są używane w sieciach technologii ATM

(Asynchronous Transfer Mode) i SMDS (Switched Multimegabit Data Service).

Datagram, segment, komunikat

Datagram jest jednostką informacji, której źródłem i przeznaczeniem jest warstwa Sieciowa

(warstwa 3) modelu OSI, używająca bezpołączeniowej obsługi sieci.

Segment jest jednostką informacji, której źródłem i przeznaczeniem jest warstwa

Transportowa modelu OSI.

Komunikat jest jednostką informacji, której źródłem i przeznaczeniem jest zwykle warstwa

Aplikacji.

Hierarchiczna organizacja sieci komputerowej

Współczesne, coraz większe sieci komputerowe są zwykle zorganizowane hierarchicznie, co

ułatwia ich zarządzanie, zwiększa elastyczność w razie modyfikacji i redukuje zbędny ruch.

Dlatego Międzynarodowa Organizacja Standaryzacyjna ISO (International Organization for

Standardization) sprecyzowała cztery pojęcia dla określania różnych części hierarchicznej

struktury sieciowej. Są to:

System końcowy ES (End System),

System pośredniczący IS (Intermediate System),

Obszar A (Area),

System autonomiczny AS (Autonomous System).

System końcowy ES to urządzenie, często zwane stacją sieciową, nie wykonujące funkcji

zmiany kierunku przepływu informacji, a w szczególności trasowania. Typowymi

urządzeniami należącymi do klasy ES są terminale, personalne lub sieciowe komputery i

drukarki.

System pośredniczący IS to urządzenie zmieniające kierunek przepływu informacji w sieci;

należą tu takie urządzenia jak routery (Routers), przełączniki (Switches) i mosty (Bridges).

Wprowadzenie do sieci

24-10-2001

Obszarem A nazywamy grupę logiczną sieciowych segmentów i związane z nimi urządzenia.

Obszary są częściami systemów autonomicznych. System autonomiczny AS jest zbiorem

sieci znajdujących się pod działaniem wspólnego systemu zarządzającego i mającego wspólną

strategię trasowania. Systemy autonomiczne czasem nazwane są segmentami.

Połączeniowe i bezpołączeniowe usługi sieciowe

Protokoły i obsługiwany przez nie ruch danych w sieci mogą mieć charakter połączeniowy

lub bezpołączeniowy. W połączeniowej obsłudze danych używana jest trasa (ścieżka) między

stacją nadawczą a stacją odbiorczą, utworzona tylko na czas trwania transmisji. W obsłudze

bezpołączeniowej dane przepływają przez połączenie ciągle istniejące.

W usłudze połączeniowej można wyróżnić trzy fazy:

1. Budowa połączenia,

2. Przesyłanie danych,

3. Likwidacja połączenia.

W wyniku budowy połączenia zostaje utworzona pojedyncza ścieżka między stacją nadawczą

a stacją odbiorczą. Zasoby sieciowe powinny mieć rezerwę pozwalającą na zapewnienie

realizacji usługi, np. zagwarantowaną szybkość przesyłania danych.

W fazie przesyłania dane są transmitowane przez utworzoną ścieżkę w sposób sekwencyjny.

Dane docierają do stacji odbiorczej w kolejności ich wysyłania przez stację nadawczą.

W fazie likwidacji połączenia utworzone połączenie ulega przerwaniu. Dalsza transmisja

między stacjami nadawczą i odbiorczą musi być ponownie poprzedzona fazą budowy

połączenia.

Usługę połączeniową charakteryzują dwie istotne wady w porównaniu z usługą

bezpołączeniową:

Statyczny wybór ścieżki,

Statyczna rezerwacja zasobów sieciowych.

Statyczny wybór ścieżki jest kłopotliwy, ponieważ oznacza potrzebę przesyłania całego ruchu

przez tę samą statyczną trasę; uszkodzenie jej w dowolnym miejscu powoduje zerwanie

całego połączenia. Statyczna rezerwacja zasobów sieciowych stwarza kłopoty, ponieważ

wymaga gwarantowanej szybkości transmisji oraz zaangażowania zasobów sieciowych, z

których nie mogą korzystać inni użytkownicy sieci.

Należy jednak podkreślić, że połączeniowa usługa jest bardzo przydatna w aplikacjach nie

tolerujących opóźnień. Na przykład zastosowania wymagające przesyłania głosu i obrazu są

oparte na usługach połączeniowych.

W usłudze bezpołączeniowej nie buduje się jedynej ścieżki między stacją nadawczą i

odbiorczą, pakiety do stacji odbiorczej mogą docierać w innej kolejności niż są wysyłane

przez stację nadawczą, ze względu na to, że mogą być przesyłane różnymi trasami. W usłudze

bezpołączeniowej dane przepływają przez trwałe połączenia między węzłami sieci, a każdy

pakiet jest obsługiwany indywidualnie i niezależnie od innych pakietów danego komunikatu.

Jest to możliwe pod warunkiem, że każdy pakiet jest kompletnie zaadresowany, to znaczy, że

każdy z nich ma swój adres stacji nadawczej i stacji odbiorczej.

Usługa bezpołączeniowa ma dwie zalety:

dynamiczną selekcję ścieżki (trasy),

dynamiczny przydział pasma.

Dynamiczna selekcja ścieżki umożliwia trasowanie z pominięciem uszkodzonego miejsca w

sieci dzięki sterowaniu przepływem odnoszącym się do każdego pakietu z osobna.

Dynamiczny przydział pasma jest bardzo efektywny, ponieważ pasmu nie przydziela się

zasobów, jeśli nie są one używane.

Usługi bezpołączeniowe są zalecane przy transmisji danych w aplikacjach tolerujących pewne

opóźnienia i powtórzenia.

Adresowanie w sieci komputerowej

Aby w sieci mogła poprawnie przebiegać transmisja informacji, interfejs każdego urządzenia

lub grupy urządzeń musi mieś swój unikatowy adres. Mechanizmy adresowania są zależne od

protokołu sieciowego i warstwy w modelu OSI. Można wyróżnić trzy zasadnicze typy

adresów:

Adresy warstwy 2 (Łącza danych) modelu OSI,

Adresy MAC (Media Access Control),

Adresy warstwy 3 (Sieciowej) modelu OSI.

Adres warstwy 2 modelu OSI jednoznacznie identyfikuje każde połączenie urządzenia z

siecią. Jest także często nazywany fizycznym adresem (Hardware Address).

Stacje sieciowe (systemy końcowe ES) mają zwykle tylko jedno fizyczne połączenie z siecią,

co oznacza, że mają tylko jeden adres warstwy 2 modelu OSI. Natomiast routery i inne

urządzenia intersieciowe mają zwykle wiele połączeń z siecią i w konsekwencji wiele

adresów warstwy 2 modelu OSI.

Stacja sieciowa ma

zwykle jeden adres

warstwy 2. Routery

mają wiele adresów

warstwy 2

Wprowadzenie do sieci

24-10-2001

Adresy MAC (Media Access Control) są podzbiorem adresów warstwy 2 modelu OSI. Adres

MAC ma długość 48 bitów i jest pokazany na rysunku Fizyczny adres... w postaci 12 cyfr

hexadecymalnych. Składa się z dwóch podstawowych części: w pierwszej z nich zapisany jest

kod producenta karty sieciowej, przydzielany przez IEEE (Institute of Electrical and

Electronic Engineers), a w drugiej - unikatowy adres karty sieciowej tego producenta. W

dolnej części rysunku pokazano adres rozgłoszeniowy (Broadcast Address) karty Ethernet,

używany przy stosowaniu protokołu ARP do automatycznego odszukiwania adresów

fizycznych stacji sieciowych i routerów. Adresem rozgłoszeniowym jest 48 jedynek

zapisanych w sześciu bajtach adresu.

Adresy warstwy Sieciowej zwykle należą do hierarchicznej

przestrzeni adresowej i są także nazywane adresami wirtualnymi lub

logicznymi. Bardzo ważna jest zależność między adresami warstwy

sieciowej a urządzeniami sieciowymi.

Fizyczny adres

Ethernet HA

(Hardware Address)

Przestrzenie adresowe: hierarchiczna i płaska

W intersieci przestrzeń adresowa zwykle przyjmuje jedną z dwóch

form: hierarchiczną lub płaską.

Hierarchiczna przestrzeń adresowa jest zorganizowana z myślą o

podgrupach, z których każda kolejna zawęża adres aż do wskazania

pojedynczego urządzenia.

Płaska przestrzeń adresowa odnosi się do jednej grupy.

Adresowanie hierarchiczne cechuje wiele zalet w porównaniu do

adresowania płaskiego, np. sortowanie adresów jest znacznie

uproszczone przez stosowanie operacji porównania.

Router dla każdego

interfejsu fizycznego

ma jeden adres

warstwy sieciowej dla

każdego

obsługiwanego

protokołu warstwy

sieciowej

Przydzielanie adresów

Można wyróżnić trzy sposoby przydziału adresów:

Statyczny,

Dynamiczny,

Adresy przydziela serwer.

Adresy statyczne przydziela administrator sieci stosownie do

Różnice między

wcześniej przyjętego planu adresacji. Adres statyczny pozostaje

hierarchiczną a płaską

niezmienionym aż do momentu zdecydowania o tym przez

przestrzenią adresową

administratora sieci. Adresy dynamiczne są przydzielane

urządzeniom w momencie podłączenia ich do sieci przez działanie

pewnych specyficznych protokołów. Dowolne urządzenie używające

dynamicznego adresowania często ma inny adres po każdym

podłączeniu urządzenia do sieci. Adresy przydzielane przez serwer są

ponownie przydzielane po uprzednim odłączeniu urządzenia od sieci, a następnie jego

podłączeniu.

Adresy i nazwy

Urządzenia zainstalowane w sieci mają adresy z nimi związane. Nazwy są niezależne od

lokalizacji i związane z urządzeniem, nawet jeśli urządzenie to zostaje przeniesione do innego

miejsca (np. z budynku do budynku). Adresy niezależne od lokalizacji nie zmieniają się, gdy

urządzenie zmienia lokalizację (chociaż adresy MAC należą do wyjątków).

Sterowanie przepływem w sieci

Sterowanie przepływem polega na zapobieganiu przeciążaniu sieci

przez unikanie nadmiaru informacji napływających do stacji

odbiorczej ze stacji nadawczej. Istnieje wiele przyczyn powodujących

przeciążanie sieci, np. bardzo szybki komputer może generować

informację z szybkością większą niż przepływność sieci lub stacja

odbiorcza jest zbyt wolna, by szybko napływającą informację odebrać

i przetworzyć.

Najważniejsze

instytucje prowadzące

standaryzację w

dziedzinie sieci

komputerowych

Są trzy metody zapobiegania przeciążeniom sieci komputerowej:

Buforowanie,

Transmisja komunikatów ograniczania szybkości transmisji stacji nadawczej,

Generowanie okien (Windowing).

Buforowanie polega na chwilowym zapamiętywaniu nadmiaru informacji w pamięci

(buforze) do czasu, kiedy będzie mogła być przetworzona. Okazjonalne "przepełnienia"

danych są skutecznie obsługiwane przez mechanizm buforowania. Jeśli jednak

"przepełnienia" są zbyt intensywne, mechanizm buforowania może zawieść i następuje

"odrzucenie" niektórych datagramów.

Wprowadzenie do sieci

24-10-2001

Komunikaty ograniczające szybkość transmisji stacji nadawczej zapobiegają nadmiarom

występującym w buforach stacji odbiorczych. Dzieje się to w ten sposób, że stacja odbiorcza

wysyła komunikat do stacji nadawczej żądający zmniejszenia szybkości jej transmisji.

Początkowo stacja odbiorcza zaczyna odrzucać przyjmowane dane, w miarę jak następuje

przepełnianie buforów, po czym rozpoczyna wysyłanie komunikatu (żądającego zmniejszenia

szybkości pracy) do stacji nadawczej z szybkością jednego komunikatu na jeden pakiet.

Stacja odbiorcza, odbierając komunikaty żądające zmniejsza szybkości, wykonuje te

polecenia aż do momentu, kiedy przestanie odbierać komunikaty. Wtedy stacja nadawcza

stopniowo zaczyna zwiększać szybkość transmisji, ale tak by nie dopuścić do ponownego

przyjmowania komunikatów.

Generowanie okien jest mechanizmem sterowania przepływem, w którym stacja nadawcza

wymaga potwierdzenia przez stację odbiorczą faktu przetransmitowania pewnej liczby

pakietów. Jeśli okno ma np. "szerokość pięć", to stacja nadawcza żąda potwierdzenia po

przesłaniu pięciu pakietów. Mechanizm działa w następujący sposób:

Po odbiorze pięciu pakietów stacja odbiorcza wysyła potwierdzenie do stacji nadawczej,

stacja nadawcza odbiera potwierdzenie i wysyła pięć pakietów więcej. Jeśli stacja odbiorcza

nie odbiera jednego lub więcej pakietów z jakiegoś powodu, to nie odbiera ona wystarczającej

liczby pakietów, aby wysłać potwierdzenie. Po tym fakcie stacja nadawcza retransmituje

pakiety ze zmniejszoną szybkością.

Zasady kontroli błędów w sieci

Informacja przesyłana w sieci między stacją nadawczą i odbiorczą może ulec zniekształceniu

lub zniszczeniu. Dlatego wymyślono mechanizmy sprawdzania błędów (Error-checking) na

różnych poziomach modelu OSI.

Najpowszechniej stosowanym z nich jest kodowanie nadmiarowe CRC (Cyclic Redundancy

Check), wykrywające i usuwające informacje zniekształcone. CRC jest skomplikowaną

procedurą dopisywania do transmitowanego bloku danych pozycji kontrolnych wg reguły

kodowania. Na podstawie tych bitów odbiornik jest w stanie wykryć błędy powstające

podczas transmisji, a w pewnych przypadkach nawet je skorygować. Funkcje korekcji błędów

są realizowane przez protokoły wyższych warstw (np. powtórzenie transmisji). Wartość CRC

jest obliczana w stacji nadawczej. Stacja odbiorcza porównuje tę wartość z wartością

obliczoną w stacji odbiorczej w celu stwierdzenia, czy w czasie transmisji wystąpił błąd. Na

początku stacja nadawcza wykonuje cały szereg obliczeń na zawartości pakietu

przeznaczonego do przesłania. Następnie obliczone wartości uzupełniają pakiet, który jest

wysyłany przez stację nadawczą do stacji odbiorczej, która również wykonuje obliczenia na

zawartości otrzymanego pakietu, po czym porównuje ją z zawartością pakietu. Jeśli wartości

są równe, to uznaje się, że pakiet został przetransmitowany poprawnie, przy wartościach

różnych - pakiet zawiera błędy i zostaje usunięty.

Wstępne wiadomości o LAN

Powszechnie używany skrót LAN (Local Area Network) oznacza lokalną sieć komputerową,

obejmującą swoim zasięgiem stosunkowo mały obszar geograficzny i łączącą ze sobą stacje

sieciowe (stacje robocze, komputery personalne, komputery sieciowe, serwery, drukarki i

inne urządzenia). LAN umożliwiają współdzielony dostęp wielu użytkowników do tych

samych urządzeń i aplikacji, wymianę plików między użytkownikami oraz komunikację

między użytkownikami za pośrednictwem poczty elektronicznej i innych aplikacji.

Obecnie są stosowane trzy podstawowe technologie sieci LAN:

Ethernet/IEEE 802.3,

Token-Ring/IEEE 802.5,

FDDI (Fiber Distributed Data Interface).

Sieci LAN powinny spełniać trzy istotne wymagania: możliwie dużej Sieć LAN a model OSI

przepływności (szybkości), skalowalności i wysokiej niezawodności.

Metody dostępu do medium transmisyjnego

Dowolna stacja może rozpocząć transmisję w sieci tylko wtedy, gdy

medium (np. miedziany 4-parowy kabel sieciowy) nie jest zajęte

przez inną transmisję. Mechanizm kontrolujący stan medium i

uruchamiania transmisji nazywamy metodą dostępu do medium.

Protokoły LAN używają jednej z dwóch metod dostępu do medium:

CSMA/CD (Carrier Sense Multiple Access Collision Detect) -wielodostęp z rozpoznaniem

stanu kanału i wykrywaniem kolizji,

Token Passing (Token Passing) - wielodostęp z przekazywaniem uprawnień.

W metodzie dostępu CSMA/CD stacje sieciowe konkurują między sobą o dostęp do medium.

Przykładami technologii używających metody dostępu CSMA/CD są: Ethernet, IEEE 802.3

i 100Base-T.

Wprowadzenie do sieci

24-10-2001

W metodzie dostępu Token Passing stacje sieciowe uzyskują dostęp do medium w zależności

od tego, gdzie aktualnie znajduje się token (specjalna ramka sterująca). Przykładami

technologii sieciowych, w których stosuje się metodę dostępu Token Passing, są Token-Ring

(IEEE 802.5) i FDDI.

Sposoby transmisji i adresowania w LAN

Wyróżnia się trzy sposoby transmisji i adresowania w LAN:

Transmisja pojedyncza Unicast,

Transmisja grupowa Multicast,

Transmisja rozgłoszeniowa Broadcast.

Transmisje: Unicast,

Multicast i Broadcast

W transmisji Unicast pojedynczy pakiet jest wysyłany przez stację

nadawczą do stacji odbiorczej. Przedtem jednak stacja nadawcza

adresuje pakiet używając adresu stacji odbiorczej. Po zaadresowaniu

pakiet jest wysyłany do sieci, w której "przepływa" do stacji

odbiorczej.

W transmisji Multicast pojedynczy pakiet danych jest kopiowany i

wysyłany do grupy stacji sieciowych (określonej przez adres

multicast). Przedtem jednak stacja nadawcza adresuje pakiet

używając adresu multicast. Po zaadresowaniu pakiet jest wysyłany do

sieci, gdzie jest kopiowany; każda kopia pakietu jest wysyłana do

wszystkich stacji należących do grupy adresów multicast.

W transmisji Broadcast pojedynczy pakiet jest kopiowany i

wysyłany do wszystkich stacji sieciowych. W tym typie transmisji stacja nadawcza adresuje

pakiet używając adresu broadcast. Następnie pakiet jest wysyłany do sieci, gdzie jest

kopiowany; kopie są wysyłane do wszystkich stacji sieciowych .

Topologie sieci LAN

Topologia LAN określa sposób wzajemnego połączenia stacji w sieci.

Wyróżnia się cztery najczęściej stosowane topologie LAN:

Szynowa (Bus),

Pierścieniowa (Ring),

Gwiaździsta (Star),

Drzewiasta (Tree).

Topologie: szynowa

(Bus), pierścieniowa,

gwiaździsta i

drzewiasta

Wymienione topologie są strukturami logicznymi i technicznie nie

muszą być w taki sposób zorganizowane. Na przykład logicznie

rozumiane topologie szynowa i pierścieniowa są zorganizowane jako

gwiazda fizyczna.

W topologii szynowej pakiet wysyłany przez dowolną stację sieciową

dociera, za pośrednictwem medium, do wszystkich stacji sieciowych.

W sieciach Ethernet/IEEE 802.3, włącznie z 100Base-T, jest

stosowana topologia szynowa.

Topologia pierścieniowa jest strukturą, w której stacje sieciowe są

podłączone do okablowania tworzącego pierścień. Topologię

pierścienia stosuje się w technologiach Token Ring/IEEE 802.5 i

FDDI.

W topologii gwiaździstej kable sieciowe są połączone w jednym

wspólnym punkcie, w którym znajdują się hub lub przełącznik.

Topologia drzewiasta jest strukturą podobną do topologii szynowej, z tą różnicą, że są tu

możliwe gałęzie z wieloma węzłami.

Urządzenia aktywne LAN

Sieci LAN buduje się z biernych i aktywnych urządzeń sieciowych. Bierne urządzenia

sieciowe to komponenty systemów okablowania strukturalnego.

Do aktywnych urządzeń sieci LAN należą:

Regeneratory (Repeaters),

Huby,

Mosty,

Przełączniki LAN,

Rozszerzacze LAN.

Regenerator (koncentrator) jest urządzeniem pracującym w warstwie fizycznej modelu OSI,

stosowanym do łączenia segmentów kabla sieciowego. Łączący wiele kabli regenerator

logicznie jest traktowany jak jeden kabel sieciowy. Po prostu regenerator, odbierając sygnały

z jednego segmentu sieci, wzmacnia je, poprawia ich parametry czasowe i przesyła do innego

segmentu. W rezultacie zabiegi te regenerują (stąd nazwa) sygnały zniekształcone długimi

kablami i dużą liczbą podłączonych urządzeń. Liczby regeneratorów i segmentów są

ograniczone.

Wprowadzenie do sieci

24-10-2001

Hub jest urządzeniem pracującym również w warstwie fizycznej. Jest czasami określany jak

wieloportowy regenerator. Hub służy do tworzenia fizycznej gwiazdy przy istnieniu logicznej

szyny lub pierścienia.

Rozszerzacz LAN to wielowarstwowy przełącznik zdalnego dostępu, podłączony do

głównego routera. Rozszerzacze LAN przesyłają ruch z wszystkich standardowych

protokołów warstwy sieciowej (np. IP, IPX, AppleTalk) i filtrują go zależnie od adresów

MAC lub typu protokołu warstwy Sieciowej modelu OSI (warstwa 3). Rozszerzacze LAN

dobrze spełniają funkcję skalowania sieci, ponieważ główny router odfiltrowuje niepożądane

pakiety typu broadcast i multicast. Rozszerzacze LAN nie zapewniają ani segmentowania, ani

nie służą do budowy zapór ogniowych.

Wstępne wiadomości o sieciach rozległych WAN

WAN (Wide Area Network) jest siecią transmisji danych obejmującą

swoim zasięgiem stosunkowo duży obszar geograficzny, często

używającą środków transmisji będących w dyspozycji towarzystw

telekomunikacyjnych. Technologie sieci WAN funkcjonują w trzech

najniższych warstwach modelu OSI: Fizycznej, Łącza danych i

Sieciowej.

Technologie WAN

działają w trzech

najniższych warstwach

modelu OSI

Łącze Punkt-Punkt

Łącze Punkt-Punkt zapewnia pojedyncze, zawczasu zestawione

połączenie komunikacyjne między siedzibą użytkownika a siecią odległą, z użyciem sieci

operatora, na przykład sieci telefonicznej.

Łącza Punkt-Punkt znane są także pod nazwą linii dzierżawionych, ponieważ ich trasa

(ścieżka) jest stała i określona dla każdej zdalnej sieci dostępnej przez zasoby sieci operatora.

Operator sieci rezerwuje łącza Punkt-Punkt na prywatne cele użytkownika. Łącza te

umożliwiają dwa typy transmisji: transmisję datagramów skomponowanych z indywidualnie

adresowanych ramek oraz transmisję strumienia danych, dla którego sprawdzanie adresów

odbywa się tylko raz.

Przełączanie obwodów

Stosowane w sieciach WAN przełączanie obwodów polega na zestawianiu, utrzymywaniu i

rozłączaniu fizycznego obwodu przez sieć operatora dla każdej sesji komunikacyjnej.

Przełączanie obwodów obsługuje dwa typy transmisji: transmisję datagramów, na które

składają się indywidualnie zaadresowane ramki, i transmisję strumienia danych, dla których

następuje tylko jednokrotne sprawdzenie adresu. Przełączanie obwodów jest szeroko

stosowane w sieciach telefonicznych. ISDN jest typowym przykładem przełączania

obwodów.

Przełączanie pakietów

Stosowane w sieciach WAN przełączanie pakietów polega na

współdzieleniu przez urządzenia sieciowe łącza Punkt-Punkt

przeznaczonego do transportu pakietów między stacją nadawczą a

stacją odbiorczą, poprzez sieć operatora. Dla współdzielenia

obwodów przez urządzenia sieciowe używa się statystycznej

multipleksacji. ATM, Frame Relay, SMDS (Switched Multimegabit

Data Service) i X.25 to przykłady technologii przełączania pakietów

w sieciach WAN.

Mechanizm

przełączania pakietów

przesyła pakiety przez

sieć operatora

Obwody wirtualne w sieci WAN

Obwodem wirtualnym (Virtual Circuit) nazywamy obwód logiczny utworzony dla

zapewnienia niezawodnej komunikacji między dwoma urządzeniami sieciowymi.

Rozróżniamy dwa typy obwodów wirtualnych:

Przełączane obwody wirtualne SVC (Switched Virtual Circuits),

Stałe obwody wirtualne PVC (Permanent Virtual Circuit).

SVC to obwody wirtualne zestawiane dynamicznie na żądanie oraz rozłączane po

zakończeniu transmisji. Komunikacja przez obwód SVC składa się z trzech faz: 1.

Zestawienie obwodu, 2. Transmisja danych, 3. Rozłączanie obwodu.

Faza zestawiania obwodu polega na tworzeniu obwodu między stacją nadawczą a stacja

odbiorczą. Transmisja danych polega na ich przesyłaniu (przez obwód wirtualny) między

stacją nadawczą a odbiorczą. Rozłączenie obwodu powoduje zakończenie jego

funkcjonowania.

Obwody wirtualne SVC są używane w sytuacjach, gdy transmisja danych między stacjami

odbywa się sporadycznie. Jest to głównie związane z tym, że w obwodzie SVC zwiększa się

szerokość pasma w fazie zestawiania obwodu i w fazie jego rozłączania oraz zmniejsza koszt

związany ze stałą dostępnością obwodu wirtualnego.

Obwód PVC jest zestawiany na stałe i pracuje tylko w trybie transmisji danych. Obwód PVC

jest stosowany w sytuacjach, gdy transmisja między stacjami jest stała. PVC zmniejsza

szerokość pasma związanego z zestawianiem i rozłączaniem obwodu wirtualnego, zwiększa

natomiast koszt w związku ze stałą dostępnością obwodu wirtualnego.

Wprowadzenie do sieci

24-10-2001

Produkty sprzętowe stosowane w sieciach WAN

W sieciach WAN stosuje się wiele różnych produktów sprzętowych. Do typowych należą:

przełączniki WAN, serwery dostępowe, modemy, urządzenia CSU/DSU i adaptery terminali

ISDN. Ponadto stosowane są routery, przełączniki ATM i multipleksery.

Przełącznik WAN jest wieloportowym urządzeniem intersieciowym stosowanym do

przełączania ruchu w sieciach, takich jak Frame Relay, X.25 i SMDS (Switched Multimegabit

Data Service), działającym w warstwie 2 modelu OSI.

Serwer dostępowy gra rolę punktu koncentrującego połączenia "do sieci" i "od sieci".

Modem jest urządzeniem, które interpretując sygnały cyfrowe i analogowe, umożliwia

przesyłanie danych przez zwykłą linię telefoniczną. Modem usytuowany przy stacji

nadawczej zamienia sygnały cyfrowe na formę wygodną do transmisji przez linię analogową,

podczas gdy modem znajdujący się przy stacji odbiorczej sygnały analogowe ponownie

zamienia na formę cyfrową.

Urządzenie CSU/DSU (Channel Service Unit/Data Service Unit) jest urządzeniem

dopasowującym fizyczny interfejs urządzenia DTE (Data Terminal Equipment), np. interfejs

terminala, do interfejsu urządzenia DCE (Data Communications Equipment), np. interfejs

przełącznika. Urządzenie CSU/DSU ponadto zapewnia impulsy czasowe niezbędne dla

komunikacji między tymi urządzeniami.

Adapter terminala ISDN jest urządzeniem zapewniającym połączenia interfejsu BRI (Basic

Rate Interface) z innymi interfejsami, np. EIA/TIA-232. W istocie adapter terminala jest

modemem ISDN.

Ogólne zasady mostowania i przełączania

Do czego służą mosty i przełączniki?

Mosty i przełączniki to ważne sprzętowe składniki sieci komputerowej. Działają w warstwie

Łącza danych (warstwa 2) modelu OSI. Mosty pojawiły się na początku lat osiemdziesiątych i

wtedy służyły do łączenia sieci jednorodnych (homogenicznych). Ostatnio zdefiniowano i

przyjęto standardy określające proces mostowania również między sieciami pracującymi w

różnych technologiach.

Obecnie wyróżnia się kilka rodzajów mostowania:

Mostowanie przezroczyste (Transparent Bridging), stosowane głównie w sieciach

Ethernet;

Mostowanie wg trasy źródłowej (Source-Route Bridging), spotykane przede wszystkim w

sieciach Token Ring;

Mostowanie translacyjne (Translational Bridging), zapewniające tłumaczenie formatów i

zasad przejścia między różnymi mediami (zwykle Ethernet i Token Ring);

Mostowanie przezroczyste wg trasy źródłowej (Source-Route Transparent Bridging)

używające zarówno algorytmów mostowania przezroczystego, jak i mostowania wg trasy

źródłowej dla zapewnienia komunikacji w instalacjach mieszanych Ethernet/Token Ring.

Mostowanie i przełączanie to funkcje dwóch najpopularniejszych urządzeń sieciowych:

mostów i przełączników. Znajomość ogólnych zasad mostowania (Bridging) i przełączania

(Switching) ułatwia zrozumienie reguł funkcjonowania sieci komputerowej.

Należy podkreślić, że w obecnie projektowanych sieciach dominuje technologia przełączania.

Przełączniki są lepsze niż mosty - zapewniają wyższą przepustowość, większą gęstość

portów, niższą cenę za port. Umożliwiają także trasowanie, uzupełniając funkcje routerów.

Charakterystyka urządzeń warstwy 2

Mechanizmy mostowania i przełączania są realizowane w warstwie 2 modelu OSI, która

steruje przepływem danych, obsługuje błędy transmisji, zapewnia fizyczne (w odróżnieniu od

logicznego) adresowanie oraz dostęp do fizycznego medium sieci. Funkcje te mosty realizują

przez używanie specyficznych dla każdej technologii protokołów, np. Ethernet, Token Ring

czy FDDI.

Mosty i przełączniki są urządzeniami stosunkowo prostymi. Analizują one napływające ramki

i decydują o ich sposobie transportu do stacji odbiorczej. W pewnych wypadkach

(mostowanie wg trasy źródłowej) cała ścieżka do stacji odbiorczej jest pamiętana w każdej

ramce. W innych przypadkach (mostowanie przezroczyste) ramki są transportowane między

kolejnymi mostami w kierunku stacji odbiorczej na zasadzie "najtańszej" ścieżki.

Procesy mostowania i przełączania są przezroczyste w wyższych warstwach modelu OSI.

Oznacza to, że ani mosty, ani przełączniki nie muszą sprawdzać informacji w wyższych

warstwach i w związku z tym szybko przesyłają ruch należący do dowolnego protokołu. Nie

ma zatem nic niezwykłego w tym, gdy most przesyła ruch AppleTalk, DECnet, TCP/IP i

innych protokołów między dwiema lub wieloma sieciami. Jest to

istotna zaleta mostów.

Przełącznik LAN

Mosty mogą również filtrować ramki na podstawie zawartości ich

może łączyć segmenty

pól. Na przykład, most może być zaprogramowany tak, aby nie

Ethernet 10 Mb/s z

przepuszczać żadnej ramki pochodzącej z określonej sieci. Filtry

segmentami Ethernet

mogą być również bardzo pomocne w likwidowaniu niepożądanych 100 Mb/s

pakietów typu broadcast czy multicast.

Dzieląc duże sieci na autonomiczne jednostki, mosty i przełączniki

zapewniają wiele udogodnień. Przede wszystkim zmniejszają ruch

między połączonymi segmentami. Most lub przełącznik pracuje też

jako zapora ogniowa (firewall) chroniąc sieć przed intruzami

mogącymi ją uszkodzić. Mosty i przełączniki umożliwiają rozbudowę

sieci LAN.

Wprowadzenie do sieci

24-10-2001

Pomimo że mosty i przełączniki charakteryzuje wiele wspólnych cech, różnią się one między

sobą. Przełączniki zwykle są znacznie szybsze niż mosty, ponieważ przełączanie jest

realizowane sprzętowo.

Typy przełączników

Przełączniki będąc urządzeniami warstwy Łącza danych - podobnie jak mosty - łączą wiele

fizycznych segmentów LAN w jedną większą sieć. Ponadto, znowu podobnie do mostów,

przełączniki transportują ruch opierając się na adresach MAC. Działanie przełączników jest

jednak bardzo szybkie, ponieważ proces przełączania jest realizowany sprzętowo.

Można wyróżnić następujące rodzaje przełączników:

Przełączniki ATM,

Przełączniki LAN,

Przełączniki WAN.

Wstępne wiadomości o trasowaniu

Trasowanie (Routing) jest mechanizmem kierowania i przenoszenia informacji w intersieci,

od stacji nadawczej (Source) do stacji odbiorczej (Destination). Na tej drodze informacja musi

przejść przez co najmniej jeden element pośredniczący, którym może być most lub router. Na

pierwszy rzut oka trasowanie i mostowanie to mechanizmy bardzo podobne. Tak jednak nie

jest - różnią się one istotnie.

Zasadnicza różnica polega na tym, że mostowanie realizowane jest w warstwie 2 modelu OSI

(warstwa Łącza danych), a trasowanie w warstwie 3 (Sieciowa). Mostowanie i trasowanie

korzystają więc z różnych informacji w procesie przenoszenia danych od stacji nadawczej do

stacji odbiorczej, a to sprawia, że ich funkcje są realizowane w różny sposób.

Nauka zdefiniowała funkcje i zadania trasowania już ponad 20 lat temu. Technicznie i

komercyjnie mechanizm trasowania zaczęto stosować jednak dopiero w połowie lat 80.

Przyczyną tego była prostota i jednorodność technologiczna sieci lat 70. (trasowanie było

zbyteczne). Dopiero niedawno popularne stały się duże intersieci. Stąd obecne wielkie

zainteresowanie mechanizmami trasowania.

Dwie podstawowe funkcje trasowania

Proces trasowania można sprowadzić do dwóch zasadniczych funkcji:

1. Wyznaczenie optymalnych tras (ścieżek) między stacją nadawczą i stacją odbiorczą.

2. Transport grup informacji (pakietów) przez intersieć, często nazywany przełączaniem.

Wyznaczanie trasy należy do zadań trudnych, a przełączanie pakietów jest stosunkowo proste.

Wyznaczanie optymalnej trasy

Przy określaniu optymalnej trasy algorytmy trasowania używają

standardowej miary trasowania, np. długości ścieżki.

Tablica trasowania

Przy określaniu optymalnej trasy między stacją nadawczą a stacją

odbiorczą algorytmy trasowania tworzą tablice trasowania (Routing

Tables), przechowujące informacje o trasach przesyłania pakietów.

Informacje o trasach są różne, zależnie od stosowanego algorytmu

routingu.

Istotny jest związek stacja odbiorcza/następny hop, informujący router o tym, że do

określonej stacji odbiorczej można optymalnie dotrzeć wysyłając pakiet do routera

reprezentującego następny hop. W sytuacji gdy router odbiera przychodzący pakiet, sprawdza

adres stacji odbiorczej i usiłuje skojarzyć ten adres z następnym hop. Tablice trasowania

mogą zawierać także inne informacje, takie jak zalety trasy. Routery porównują miary tras w

celu wyboru trasy optymalnej; miary te różnią się zależnie od użytego algorytmu trasowania.

Routery komunikują się między sobą i pamiętają zawartości swoich tablic trasowania w

czasie transmisji różnych komunikatów. Jednym z nich jest komunikat aktualizacji trasowania

(Routing Update), składający się w całości lub w części z zawartości tablicy trasowania. Dany

router - na podstawie analizy komunikatów aktualizacji trasowania, pochodzących od

wszystkich pozostałych routerów - może budować szczegółowy obraz topologii sieci. Innym

komunikatem, przesyłanym między routerami, jest stan łącza (Link-State Advertisement).

Również ten komunikat może być użyty do budowy kompletnej topologii sieci po to, by

umożliwić routerom określenie optymalnych tras między stacjami nadawczymi a

odbiorczymi.

Przełączanie

Algorytmy przełączania to mechanizmy stosunkowo proste i są w

Trasa pakietu od stacji

zasadzie takie same dla większości protokołów trasowania. W

nadawczej do stacji

większości wypadków stacja nadawcza decyduje o wysłaniu pakietu odbiorczej

do stacji odbiorczej. Stacja nadawcza, dysponując adresem routera,

wysyła pakiet pod jego fizyczny adres MAC (Media Access Control)

wraz z adresem logicznym (np. protokołu IP - warstwa Sieciowa)

stacji odbiorczej.

Po otrzymaniu pakietu router stwierdza, czy potrafi transportować

pakiet do następnego hop. Jeśli router nie może tego zrobić, to zwykle

pakiet zostaje stracony. Jeśli router wie, jak transportować pakiet, to

zmienia fizyczny adres, tak by osiągnąć następny hop, po czym

transmituje pakiet.

Wprowadzenie do sieci

24-10-2001

Hop - termin opisujący przemieszczanie pakietu danych między dwoma routerami.

Hop count - miara trasowania używana do pomiaru odległości między stacją nadawczą i

odbiorczą.

W szczególnym przypadku następny hop może być stacją odbiorczą.

Jeśli tak nie jest, to znaczy, że następnym hop jest router, który realizuje proces decyzyjny. W

miarę jak pakiet przesuwa się w sieci, jego adres fizyczny zmienia się, natomiast jego adres

logiczny nie ulega zmianie.

Warto podkreślić, że ISO opracowała terminologię związaną z hierarchiczną organizacją

sieci, bardzo użyteczną przy opisie omawianego procesu. Przypomnijmy, urządzenia bez

możliwości przesyłania pakietów między sieciami nazywane są stacjami sieciowymi lub

urządzeniami końcowymi ES (End Systems), z kolei urządzenia mające takie możliwości

nazywa się systemami pośredniczącymi IS (Intermediate Systems). Urządzenie IS można

dalej dzielić na komunikujące się w ramach domeny (Intradomain IS) oraz komunikujące się

w ramach domeny i między domenami (Interdomain IS). Domena trasowania to część

intersieci będącej pod wspólnym zarządem, to znaczy regulowana przez określony zestaw

reguł administracyjnych. Domeny trasowania są także zwane autonomicznymi systemami AS

(Autonomous Systems). Przy pewnych protokołach domeny trasowania mogą być dzielone na

obszary trasowania (Routing Areas), ale mimo to protokoły trasowania intradomenowego

(Intradomain Routing) są ciągle stosowane do przełączania wewnątrz i między obszarami.

Algorytmy trasowania

Algorytmy trasowania są różne pod względem wielu parametrów. Po pierwsze zróżnicowanie zależy od celów określonych przez konstrukcję algorytmu. Po drugie - istnieją

różne typy algorytmów trasowania i każdy z nich ma inny wpływ na sieć i zasoby routerów.

Wreszcie po trzecie - algorytmy trasowania używają różnych miar mających wpływ na

obliczenie trasy optymalnej.

Cele wyznaczone przez konstrukcję algorytmów trasowania

Konstrukcje algorytmów trasowania spełniają jeden lub więcej celów spośród następującego

zbioru możliwości:

optymalizacja,

prostota,

odporność i stabilność,

szybka konwergencja,

elastyczność.

Optymalizacja odnosi się do możliwości algorytmu trasowania co do wyboru najlepszej trasy,

a to zależy od przyjętej do obliczeń miary trasowania i wagi przypisanej poszczególnym

miarom. Na przykład jeden algorytm może używać liczby hop i opóźnień, ale w kalkulacjach

waga związana z opóźnieniami może być większa. Oczywiście protokoły trasowania muszą

dokładnie definiować algorytmy kalkulacji miar.

Algorytmy trasowania powinny być zaprojektowane tak, by były możliwie najprostsze.

Inaczej mówiąc, algorytm trasowania musi mieć bardzo efektywnie zaprojektowaną warstwę

funkcjonalną przy minimalnych nakładach na oprogramowanie i eksploatację. Efektywność

jest szczególnie ważna w sytuacji, gdy oprogramowanie algorytmu trasowania musi działać

na komputerze z ograniczonymi zasobami sprzętowymi.

Algorytmy trasowania muszą być odporne i stabilne, co oznacza ich poprawne działanie

nawet w niezwykłych okolicznościach i trudnych do przewidzenia warunkach, np. przy

uszkodzeniach sprzętu czy niewłaściwej eksploatacji. Routery pracujące w punktach

stykowych sieci mogą powodować poważne kłopoty w razie uszkodzenia. Dlatego

najlepszymi algorytmami trasowania okazują się te, które wytrzymały próbę czasu i okazały

się stabilne w różnych warunkach pracy sieci.

Ponadto algorytmy trasowania muszą charakteryzować się krótkim czasem konwergencji.

Konwergencja jest procesem uzgadniania optymalnych tras między wszystkimi routerami w

sieci. Jeśli wydarzenia w sieci powodują naprzemian zanikanie lub dostępność tras, to routery

obwieszczają ten fakt rozgłaszając komunikaty aktualizujące, przenikające całą sieć,

stymulujące ponowną kalkulację optymalnych tras i uzgodnienie tych tras. Algorytmy o

długim czasie konwergencji mogą powodować powstawanie pętli trasowania, a nawet zaniki

pracy sieci.

Algorytmy trasowania powinny być ponadto elastyczne, co oznacza, Pętle trasowania

iż powinny szybko i dokładnie dostosowywać się do różnorodnych

okoliczności występujących w sieci. Jeśli np. segment sieci ulega

uszkodzeniu, to algorytmy trasowania powinny szybko określić

następną optymalną trasę dla wszystkich routerów normalnie

obsługujących omawiany segment. Algorytmy trasowania mogą być

tak programowane, by adaptować m.in. zmiany w szerokości pasma,

rozmiarze kolejki routerów i opóźnieniu wprowadzanemu przez sieć.

Typy algorytmów trasowania

Rozróżnia się następujące typy algorytmów trasowania:

statyczne i dynamiczne,

jednościeżkowe i wielościeżkowe,

płaskie i hierarchiczne,

z inteligencją stacji i z inteligencją routera,

intradomenowe i interdomenowe,

działające według stanu łącza i na podstawie wektora odległości.

Wprowadzenie do sieci

24-10-2001

Statyczne i dynamiczne algorytmy trasowania

Przed rozpoczęciem trasowania statyczne algorytmy wymagają od administratora sieci

wpisywania zawartości tabel routerów, będących odwzorowaniem topologii sieci.

Odwzorowania te mogą być zmienione również tylko przez administratora sieci. Algorytmy

używające statycznych routerów są stosukowo proste w swojej konstrukcji i pracują

poprawnie w sieciach małych o prostej architekturze.

Ponieważ statyczne systemy trasowania nie mogą reagować na zmiany w sieci, to generalnie

nie są one przydatne do stosowania w sieciach dużych, gdzie zmiany następują praktycznie

ciągle. Dlatego większość obecnie stosowanych algorytmów trasowania to algorytmy

dynamiczne, dostosowujące się do zmiennych warunków występujących w sieci, na drodze

analizy aktualizujących komunikatów trasowania. W wypadku, gdy aktualizujący komunikat

trasowania wskazuje, że w sieci wystąpiły zmiany, oprogramowanie trasujące ponownie

oblicza trasy i wysyła do routerów nowe komunikaty aktualizujące. W ślad za tym

komunikaty, przenikając przez sieć, stymulują routery do uruchomienia algorytmów

trasowania i zmieniają ich tablice trasowania.

Jednościeżkowe i wielościeżkowe algorytmy trasowania

Niektóre protokoły trasowania wspierają tworzenie wielościeżkowych tras między stacją

nadawczą i odbiorczą. Algorytmy realizujące taki mechanizm zezwalają na przemieszczanie

ruchu przez wiele linii. Zaleta algorytmów wielościeżkowych jest oczywista: zapewniają one

większą przepustowość i niezawodność.

Płaskie i hierarchiczne algorytmy trasowania

Niektóre algorytmy trasowania operują w płaskiej przestrzeni, inne zaś używają hierarchii

trasowania. W systemie płaskim wszystkie routery są równoprawne względem siebie. W

systemie hierarchicznym niektóre routery tworzą kręgosłup trasowania. Pakiety z routerów

nie tworzących kręgosłupa wędrują do routerów w kręgosłupie trasowania, przez który

przepływają do obszaru, w którym znajdują się stacje odbiorcze.

Systemy trasowania często wyznaczają logiczne grupy stacji sieciowych, zwane domenami,

systemami autonomicznymi lub obszarami. W systemach hierarchicznych pewne routery w

domenie mogą komunikować się z routerami z innych domen, inne zaś mogą komunikować

się z routerami w ramach ich własnej domeny. W sieciach bardzo dużych mogą istnieć

dodatkowe poziomy hierarchii, z routerami na najwyższym poziomie, tworzącymi

wspomniany kręgosłup trasowania.

Podstawową zaletą trasowania hierarchicznego jest to, że odwzorowuje ono organizację firmy

lub instytucji. Większość komunikacji przebiega w małych grupach firmowych (domenach).

Ponieważ intradomenowe routery muszą mieć tylko informację o routerach w swojej

domenie, to ich algorytmy trasowania mogą być uproszczone, a co za tym idzie - ruch

aktualizujący może zostać również zredukowany.

Algorytmy trasowania z inteligencją stacji i routera

W niektórych algorytmach trasowania zakłada się, że stacja nadawcza będzie określać całą

trasę. Trasowanie takie jest nazywane trasowaniem źródłowym (Source Routing). W

systemach trasowania źródłowego routery pracują jak urządzenia z mechanizmem pamiętaj i

transportuj, przesyłając pakiety do następnego routera.

W innych algorytmach zakłada się, że stacje nic nie wiedzą o routerach. W tych wypadkach

routery określają trasę w intersieci opierając się na własnych kalkulacjach. Mówimy, że w

pierwszej metodzie stacje sieciowe mają inteligencję trasowania, a w metodzie drugiej

inteligencję trasowania mają routery.

Intradomenowe i interdomenowe algorytmy trasowania

Niektóre algorytmy pracują tyko wewnątrz domen, inne zaś wewnątrz domen i między

domenami. Natura tych algorytmów jest różna. To dlatego optymalny algorytm

intradomenowy jest niekoniecznie optymalny jako algorytm interdomenowy.

Algorytmy działające według stanu łącza i na podstawie wektora odległości

Algorytmy działające według stanu łącza (pierwszą trasą jest trasa najkrótsza - Shortest

Path First) przesyłają informację trasowania do wszystkich węzłów w intersieci. Jednak każdy

router przesyła tylko porcję tabeli trasowania opisującej stan swoich łączy.

Algorytmy działające na podstawie wektora odległości (znane także jako algorytmy

Bellmana-Forda) zwracają się do każdego routera w celu przesłania całych lub częściowych

swoich tablic trasowania, ale tylko do swoich sąsiadów. W istocie algorytmy działające

według stanu łącza wysyłają aktualizacje w mniejszych porcjach wszędzie, a algorytmy

działające na podstawie wektora odległości wysyłają większe porcje aktualizacji tylko do

routerów sąsiednich.

Algorytmy działające na podstawie stanu łącza dokonują konwergencji szybciej i dlatego są

mniej podatne na powstawanie pętli trasowania niż algorytmy działające na podstawie

wektora odległości. Z drugiej strony - algorytmy działające na podstawie stanu łącza

potrzebują więcej mocy procesora i więcej pamięci niż algorytmy działające na podstawie

wektora odległości. Dlatego algorytmy działające na podstawie stanu łącza mogą być droższe

w implementacji i użytkowaniu. Mimo różnic oba typy algorytmów spełniają swoje zadania w

wielu okolicznościach.

Wprowadzenie do sieci

24-10-2001

Miary trasowania

Tabele trasowania zawierają informacje używane przez programowanie w celu wybrania

najlepszej trasy. Powstaje pytanie, jak tabele trasowania są zbudowane? Co stanowi specyfikę

informacji zawartej w tabelach? W jaki sposób algorytmy trasowania decydują o tym, że

jedna trasa jest preferowana bardziej niż inna?

Algorytmy trasowania używają wielu różnych miar do określania najlepszej trasy.

Zaawansowane algorytmy trasowania mogą przy selekcji trasy opierać się na wielu miarach,

tworząc z nich miarę wypadkową (hybrydową). Rozróżnia się obecnie następujące miary

trasowania:

długość ścieżki,

niezawodność,

opóźnienie,

szerokość pasma,

obciążenie,

koszt komunikacji.

Długość ścieżki jest najczęściej używaną miarą trasowania. Niektóre protokoły trasowania

zezwalają administratorowi sieci na arbitralne przypisywanie kosztów każdemu łączu

sieciowemu. W takim wypadku koszt ścieżki jest sumą kosztów związanych z każdym łączem

składającym się na ścieżkę. Inne protokoły trasowania natomiast używają miary hop count,

rozumianej jako liczba przejść pakietu przez urządzenia intersieciowe - np. routery - od stacji

nadawczej do stacji odbiorczej.

Niezawodność, w kontekście algorytmów trasowania, odnosi się do skuteczności każdego

łącza (określanego liczbą przekłamanych bitów). Niektóre łącza mogą ulegać uszkodzeniom

częściej od innych. Po uszkodzeniu sieci niektóre łącza można naprawić szybciej i prościej

niż inne.

Opóźnienie trasowania oznacza czas potrzebny do przesłania pakietu od stacji nadawczej do

stacji odbiorczej w intersieci. Opóźnienie zależy od wielu czynników, m.in. od szerokość

pasma, jakim dysponują pośredniczące łącza sieciowe, przeciążenia wszystkich

pośredniczących łączy oraz fizycznej drogi, którą musi przepłynąć informacja. Jak widać, na

opóźnienie składa się wiele różnych zmiennych, dlatego miara ta jest ważna i popularna.

Szerokość pasma odnosi się do dostępnej pojemności ruchu w określonym łączu.

Obciążenie to stopień zajętości zasobu sieciowego, np. routera. Obciążenie zależy od wielu

czynników, np. stopnia wykorzystania procesora czy liczby pakietów przetwarzanych w

czasie jednej sekundy.

Koszt komunikacji jest ważną miarą trasowania, przede wszystkim dlatego, że niektóre firmy

nie dbają o wydajność. Nawet wtedy, gdy opóźnienia są duże, przesyłają pakiety przez własne

linie zamiast korzystać z sieci publicznych, za które się płaci tylko w czasie ich używania.

Ogólne zasady zarządzania sieciami

Pojęcie zarządzanie siecią często ma inne znaczenia dla różnych specjalistów. Niekiedy jest

ono interpretowane jako monitorowanie sieci z użyciem analizatora protokołów sieciowych.

Innym razem przywodzi na myśl rozproszoną bazę danych, automatyczne zbieranie danych o

urządzeniach sieciowych czy wreszcie wysokowydajne stacje robocze wyświetlające na

swoich ekranach schematy zmian w topologii lub zmian w ruchu pakietów w rozpatrywanej

sieci.

Zarządzanie siecią to usługa angażująca wiele różnych narzędzi, aplikacji i urządzeń

wykorzystywanych przez specjalistów ze służby administratora sieci w trakcie monitorowania

i utrzymywania sieci w stanie poprawnej pracy.

Pierwsze pozytywne wyniki ekonomiczne stosowania sieci komputerowych na początku lat

80. spowodowały rozwój nowych technologii i urządzeń sieciowych oraz wzrost liczby

użytkowników w sieciach już istniejących. W wyniku tego procesu w połowie, a zwłaszcza

pod koniec lat 80. pojawiły się pierwsze kłopoty związane z zastosowaniem różnych

technologii i urządzeń sieciowych, często niekompatybilnych względem siebie. Rosnące

liczebnie zespoły specjalistów, angażowane do usuwania tych problemów, dodatkowo

pogłębiały kryzys. Doprowadziło to do silnego zapotrzebowania na zautomatyzowany system

zarządzania siecią komputerową.

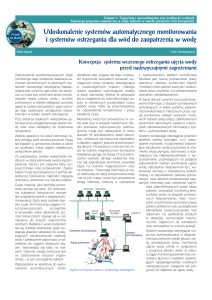

Architektura zarządzania siecią

Większość używanych obecnie systemów zarządzania siecią opiera się na typowej

architekturze pokazanej na rysunku. Stacje sieciowe (systemy komputerowe, komputery PC i

NC oraz inne urządzenia sieciowe) są nadzorowane przez oprogramowanie umożliwiające im

wysyłanie alarmów w sytuacjach wystąpienia nieprawidłowości (np. w wypadku

przekroczenia zadanych przez użytkownika wartości progowych). Alarmy są przyjmowane

przez program menedżer, rezydujący w centralnej stacji zarządzającej i inicjujący takie akcje,

jak powiadamianie operatora, zamknięcie systemu lub próba

automatycznej naprawy systemu.

Typowa architektura

Program menedżer może ponadto odpytywać (Polling) stacje

systemu zarządzania

sieciowe w celu sprawdzenia wartości pewnych zmiennych.

siecią

Odpytywanie może być automatyczne lub zainicjowane przez

użytkownika; w obu wypadkach rezydujące w urządzeniach

sieciowych moduły programowe - zwane agentami - udzielają

odpowiedzi na te zapytania. W urządzeniach sieciowych ponadto

rezydują moduły baz danych do zarządzania MIB (Management

Information Base), przechowujące informacje o tych obiektach.

Znormalizowanym mechanizmem zbierania, przesyłania i pamiętania informacji

zarządzających jest protokół zarządzania siecią. Najpopularniejszymi z nich są: protokół

SNMP (Simple Network Management Protocol) i protokół CMIP (Common Management

Information Protocol). Elementy proxy dostarczają informacji zarządzającej na rzecz innych

jednostek.

Wprowadzenie do sieci

24-10-2001

Model zarządzania siecią według ISO

ISO wniosło wielki wkład w opracowanie standardów sieci komputerowych. Model

opracowany przez tę organizację jest bardzo przydatny do tego, aby zrozumieć istotne funkcje

systemu zarządzania. Składa się on z pięciu podstawowych części:

zarządzanie wydajnością,

konfiguracją,

sprawozdawczością,

uszkodzeniami,

bezpieczeństwem.

Zarządzanie wydajnością

Celem zarządzania wydajnością jest pomiar i kontrola parametrów sieci. Umożliwia to

utrzymywanie wydajności na akceptowanym poziomie. Przykładami tej funkcji systemu

zarządzającego są: przepustowość sieci, czasy odpowiedzi oraz stopień użytkowania

poszczególnych części sieci.

Zarządzanie wydajnością można sprowadzić do trzech podstawowych kroków:

1. Gromadzenie danych w formie zmiennych, interesujących administratora sieci.

2. Analiza danych w celu określenia normalnej pracy sieci.

3. Określenie progu wartości dla każdej zmiennej tak, by jego przekroczenie oznaczało

problem występujący w sieci, którym trzeba się zająć.

Jednostki zarządzające, rezydujące w poszczególnych urządzeniach sieciowych, w sposób

ciągły monitorują zmienne. Jeśli zadany próg zostaje przekroczony, to jest generowany alarm,

wysyłany następnie do systemu zarządzania siecią.

Zarządzanie konfiguracją

Celem zarządzania konfiguracją sieci jest monitorowanie sieci i systemowych informacji

konfiguracyjnych w taki sposób, że działanie różnych wersji elementów sprzętowych i

programowych może być śledzone i nadzorowane. Każde urządzenie sieciowe ma wiele

wersji informacji z nim związanych, np. NetWare wersja 4.1.

Podsystemy zarządzania konfiguracją pamiętają te informacje w bazie danych. Przy

pojawieniu się problemu baza danych jest przeszukiwana, aby wspomóc proces rozwiązania

problemu.

Zarządzanie sprawozdawczością

Celem zarządzania sprawozdawczością jest pomiar parametrów użytkowych sieci, które mogą

być regulowane w odniesieniu do pojedynczego użytkownika lub grupy użytkowników.

Regulacja taka minimalizuje problemy sieci i ułatwia użytkownikom dostęp do sieci.

Pierwszym krokiem w zarządzaniu sprawozdawczością jest pomiar wykorzystania wszystkich

ważnych zasobów sieciowych. Analiza tych rezultatów umożliwia wgląd w bieżące parametry

użytkowe, które mogą być teraz zanotowane. Pewne korekty mogą być oczywiście potrzebne

dla osiągnięcia optymalnych warunków dostępu. Od tego momentu poczynając, pomiary

intensywności użycia zasobów sieci mogą być związane z billingiem.

Zarządzanie uszkodzeniami

Celem zarządzania uszkodzeniami jest detekcja uszkodzeń sieci i powiadamianie

użytkowników o ich wystąpieniu. Ponieważ uszkodzenia mogą powodować nieakceptowalną

degradację pracy sieci, zarządzanie uszkodzeniami jest - być może - najszerzej

implementowanym elementem zarządzania siecią według ISO.

Zarządzanie uszkodzeniami umożliwia określenie symptomów uszkodzenia sieci oraz

izolowanie występującego problemu. Potem problem jest definiowany, a rozwiązanie

testowane. Na koniec detekcja i rozwiązanie problemu zostają zapamiętane.

Zarządzanie bezpieczeństwem

Celem zarządzania bezpieczeństwem jest sterowanie dostępem do zasobów sieci, tak by

uniknąć degradacji pracy sieci, a w szczególności, by dostęp do zasobów sieci był niemożliwy

bez właściwej autoryzacji. Na przykład, podsystem zarządzania bezpieczeństwem,

monitorując logowanie się użytkowników do zasobów sieci, może nie zezwalać na dostęp

tym, którzy nie używają właściwych kodów dostępu.

Podsystem zarządzania bezpieczeństwem dzieli niejako sieć na dwie części: autoryzowaną i

nie autoryzowaną. Użytkownicy zajmujący w hierarchii pracowników firmy niskie szczeble

mają zwykle bardzo ograniczony dostęp do zasobów sieci.

Podsystem zarządzania bezpieczeństwem realizuje wiele funkcji. Identyfikuje ważne zasoby

sieci i określa relacje między nimi a zbiorami użytkowników. Ponadto monitoruje punkty

dostępu do ważnych zasobów sieciowych.