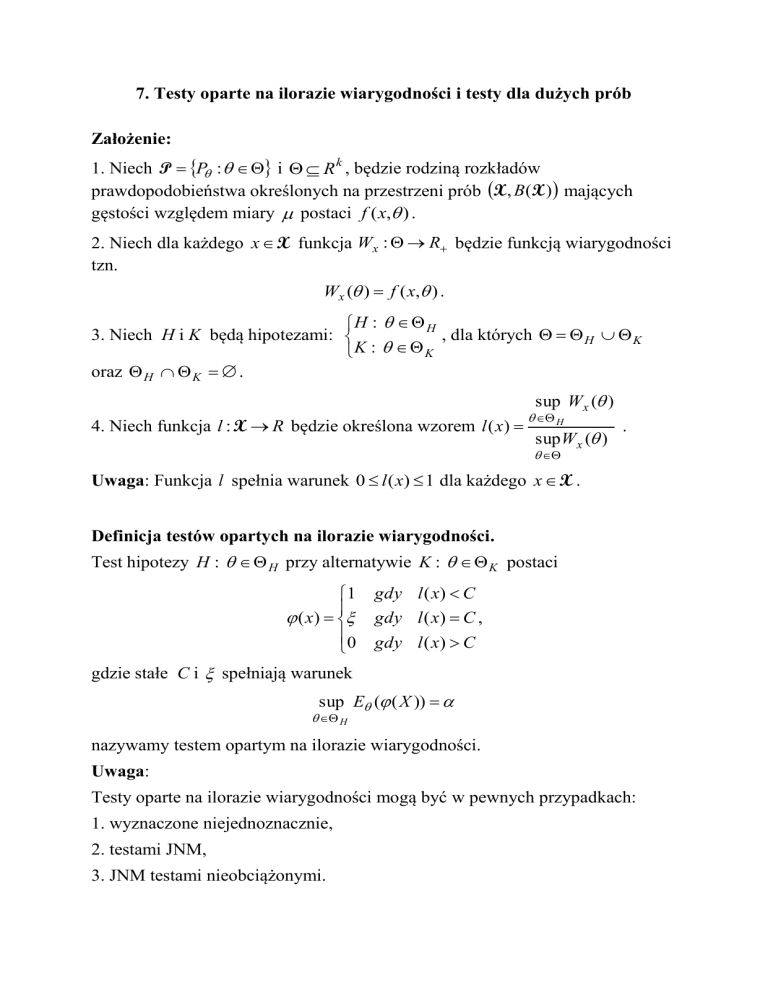

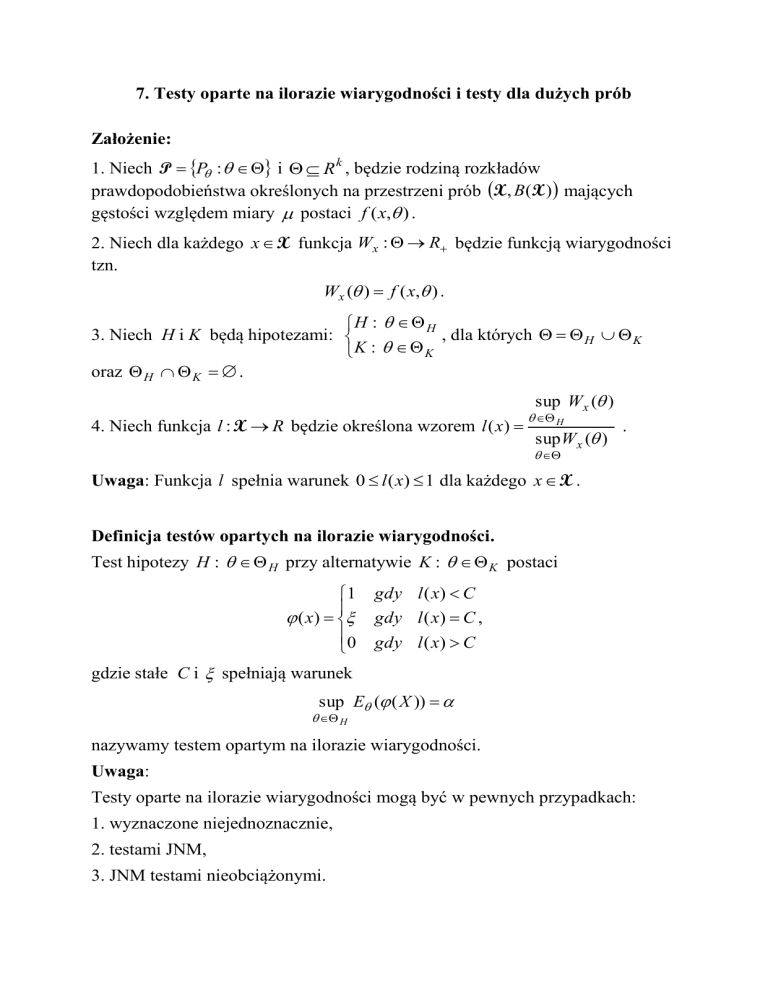

7. Testy oparte na ilorazie wiarygodności i testy dla dużych prób

Założenie:

1. Niech P P : i R k , będzie rodziną rozkładów

prawdopodobieństwa określonych na przestrzeni prób X , B(X ) mających

gęstości względem miary postaci f ( x, ) .

2. Niech dla każdego x X funkcja Wx : R będzie funkcją wiarygodności

tzn.

Wx ( ) f ( x, ) .

H : H

3. Niech H i K będą hipotezami:

, dla których H K

K : K

oraz H K .

sup W x ( )

4. Niech funkcja l : X R będzie określona wzorem l ( x)

H

sup Wx ( )

.

Uwaga: Funkcja l spełnia warunek 0 l ( x) 1 dla każdego x X .

Definicja testów opartych na ilorazie wiarygodności.

Test hipotezy H : H przy alternatywie K : K postaci

1

( x)

0

gdy l ( x) C

gdy l ( x) C ,

gdy l ( x) C

gdzie stałe C i spełniają warunek

sup E ( ( X ))

H

nazywamy testem opartym na ilorazie wiarygodności.

Uwaga:

Testy oparte na ilorazie wiarygodności mogą być w pewnych przypadkach:

1. wyznaczone niejednoznacznie,

2. testami JNM,

3. JNM testami nieobciążonymi.

W niektórych przypadkach powstają trudności z wyznaczeniem rozkładów

statystyk potrzebnych do określenia stałych C i , a więc określenia testu.

W takich przypadkach możemy wyznaczyć przybliżenia tych stałych

korzystając z rozkładów granicznych odpowiednich statystyk.

Twierdzenie 8.1 o rozkładzie statystyki l (X ) .

Niech X(n) będzie próbą rozmiaru n z rozkładu o gęstości f ( x, ) spełniającej

warunki:

1. f ( x, ) 0 p.w. P P : R ,

f (x, ) 2 f ( x, ) 3 f ( x, )

2. istnieją pochodne

,

,

dla każdego i p.w.

2

3

oraz

d

f(x, )

log f(x, )

f(x, )d ( x)

d ( x) E

0 ,

d X

X

d2

d 2 X

f(x, )d ( x)

X

2 f(x, )

2

d ( x) 0 ,

3. istnieje i jest dodatnia całka

log f(x, )

f(x, )d ( x) dla każdego ,

X

2

4. dla każdego i p.w. dla każdego x X

3 log f ( x, )

3

M ( x) i E ( M ( X )) M 0 ,

gdzie M 0 nie zależy od .

Wtedy jeżeli istnieje jednoznacznie p.w. wyznaczony estymator

wiarygodności parametru , to

lim P 0 2 log l ( X

n

Wniosek.

( n)

1

) u

2

u

x

1

x

2 e 2 dx .

0

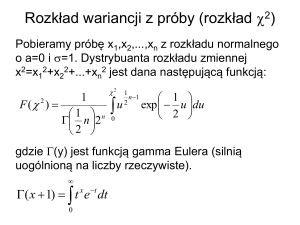

Dla hipotezy H : 0 granicznym rozkładem statystyki 2 log l ( X (n ) ) jest

rozkład 2 (1) .

Testy dla dużych prób

Twierdzenie 8.2 (Pearsona).

Jeżeli wektor losowy Y Y1 ,...,Yk T ma rozkład wielomianowy w(n, p) , gdzie

p p1 ,..., pk T , p j 0 , p1 ... pk 1 , to granicznym rozkładem

prawdopodobieństwa zmiennej losowej

k

(Y j np j ) 2

j 1

np j

jest rozkład 2 (k 1) .

Rozkład wielomianowy:

Wektor losowy X o wartościach w przestrzeni R k ma rozkład wielomianowy

w(n, p) , jeżeli ma funkcję gęstości względem miary liczącej punkty postaci:

f ( x)

n!

p1x1 p2x 2 ... pkx k ,

x1! x2 !....xk !

gdzie:

1, xi 0,1,...,n dla i 1,...,k oraz x1 x2 ... xk n ,

2. 0 pi 1 dla i 1,...,k oraz p1 p2 ... pk 1 .

Własności:

1. E ( X) np ,

2. V (X) ij , gdzie

ij npi p j i ii npi (1 pi )

dla i, j 1,2,...,k .

3. det(V ( X)) 0 ,

4. w(n, p) jest rozkładem sumy n niezależnych wektorów o rozkładach w(1, p) .

5. w(n, p) jest rozkładem liczebności pojawień zdarzeń wzajemnie

wyłączających się B1 ,..., Bk w n niezależnych powtórzeniach, przy czym każde

pojawia się odpowiednio z prawdopodobieństwem p1 , p2 ,..., pk .

Zastosowanie twierdzenia Pearsona.

1. Niech P P , gdzie P jest rodziną rozkładów na prostej R.

2. Testujemy hipotezy

H : P P0

.

K : P P0

3. Rozbijamy R na sumę rozłącznych przedziałów:

A1 (, a1 ) , A2 [a1 , a2 ) , … , Ak 1 [ak 2 , ak 1 ) , Ak [ak 1 , )

tak, aby prawdopodobieństwa

p10 P0 ( A1 ) , p20 P0 ( A2 ) , … , pk0 P0 ( Ak )

były dodatnie.

n

4. Określamy zmienne Y j I A j ( X i ) dla j 1,...,k .

i 1

Wniosek: Przy prawdziwej hipotezie H wektor losowy Y Y1 ,...,Yk T ma

T

rozkład wielomianowy w( n, p 0 ) , gdzie p 0 p10 ,..., pk0 .

Wniosek: Test dla którego obszar krytyczny określony jest wzorem

k ( y np 0 ) 2

j

j

2

(

k

1

)

y :

1

0

np

j 1

j

H : P P0

jest testem do testowania hipotez

na poziomie w przybliżeniu

K

:

P

P

0

równym .

Wniosek o nazwach i zapisie próby:

n

1. Zmienne Y j I A j ( X i ) dla j 1,...,k oznaczają ilości zmiennych w

i 1

próbie, których wartości należą do zbioru A j .

2. Wyznaczenie przedziałów A j przez przyjęcie liczb a1 ,..., a k nazywamy

grupowaniem obserwacji.

3. Na mocy 2 wartości y j zmiennych Y j nazywamy liczebnościami

empirycznymi pogrupowanych obserwacji i często oznaczamy przez n j .

4. Wartości np 0j nazywamy liczebnościami hipotetycznymi lub teoretycznymi

pogrupowanych obserwacji.

5. Wartości p 0j możemy obliczać przy pomocy dystrybuanty F rozkładu P0

p 0j F (a j ) F (a j 1 ) .

5. Pogrupowaną próbę wygodnie jest zapisać w postaci tabeli:

a j 1 a j n j

a1

n1

a1 a2

n2

……

…

ak 1

nk

sumy

nazywanej szeregiem rozdzielczym przedziałów klasowych.

6. W konsekwencji test możemy zapisać w postaci statystyki

k

(n j np0j ) 2

j 1

np0j

2

i obszaru krytycznego

S1 2 : 2 2 (k 1)1 .

Ograniczenia dla testu.

Test wymaga znajomości prawdopodobieństw

p10 P0 ( A1 ) , p20 P0 ( A2 ) , … , pk0 P0 ( Ak ) ,

czyli hipoteza zerowa musi precyzować rozkład P0 , np. H : P N (2,1) ,

a w praktyce potrzebny jest test do weryfikacji hipotezy H : P N (m, 2 ) .

Uogólnienie twierdzenia Pearsona.

Ogólny problem w badaniu zgodności polega na sprawdzeniu, czy w rozkładzie

wielomianowym prawdopodobieństwa są danymi funkcjami pewnej mniejszej

liczby parametrów, przy czym wartości tych parametrów nie są znane.

Twierdzenie uogólnione Pearsona.

Jeżeli

1. wektor losowy Y Y1 ,...,Yk T ma rozkład wielomianowy w(n, p) , gdzie

p p1 ,..., pk T , p j 0 , p1 ... pk 1 ,

2. p j p j (1 ,..., q ) 0 są danymi funkcjami zależnymi od q nieznanych

parametrów,

3. każda z funkcji p j (1 ,..., q ) ma ciągłe pierwsze i drugie pochodne

cząstkowe względem j dla j 1,...,q ,

p j

4. macierz

jest rzędu q dla prawdziwych wartości parametru

i

θ (1 ,..., q )T ,

5. θˆ (ˆ1 ,...,ˆq )T jest estymatorem największej wiarygodności po zgrupowaniu

obserwacji,

to statystyka

k

2

j 1

Y j np j (θˆ )2

np j (θˆ )

ma asympotycznie rozkład 2 (k q 1) .

Uwagi o stosowalności uogólnionego twierdzenia Pearsona:

1. Liczebność próby duża – n 40 .

2. Ilość grup - k 5 .

3. Ilość obserwacji w grupie - n j 8 lub/i liczebność teoretyczna - np j 5 .

Twierdzenie Kołmogorowa.

Niech X 1 , X 2 ,... będą niezależnymi zmiennymi losowymi o jednakowym

rozkładzie z ciągłą dystrybuantą F , a Fn niech oznacza dystrybuantę

empiryczną z próby X ( X 1 , X 2 ,..., X n ) .

Wtedy

lim P : n sup Fn (u, X( )) F (u ) y

n

uR

.

gdy y 0

0

(1) k exp(2k 2 y 2 ) gdy y 0

k

Test Kołmogorowa.

Twierdzenie to jest podstawą następującego testu zgodności :

Niech:

H : P P0

1.

,

K : P P0

2. F0 oznacza dystrybuantę rozkładu P0 ,

3. Dn ( X) sup Fn (u, X) F0 (u ) ,

uR

Wtedy za obszar krytyczny testu przyjmujemy

S1 x : Dn (x) c.

Uwaga.

1. Dla małych n rozkład statystyki Dn jest stablicowany.

2. Dla dużych n możemy wykorzystać twierdzenie graniczne Kołmogorowa.

Stałą c wyznaczamy wtedy z warunku K (c n ) 1 , gdzie K jest

stablicowaną dystrybuantą rozkładu Kołmogorowa.

3. Gichman wykazał, że jeżeli parametry rozkładu z hipotezy zerowej szacujemy

z próby, to twierdzenie Kołmogorowa nie jest spełnione.

4. W praktyce jednak mimo uwagi 2 stosuje się ten test przy bardzo dużej

liczebności próby.

Test Kołmogorowa-Smirnowa.

Twierdzenie Smirnowa.

Niech X 1 , X 2 ,... i Y1 , Y2 ,... będą niezależnymi zmiennymi losowymi o

jednakowym rozkładzie z ciągłą dystrybuantą F , a Fn i Gn niech oznaczają

dystrybuanty empiryczne z prób X ( X 1 , X 2 ,..., X n ) Y (Y1 , Y2 ,...,Yr ) .

Wtedy

nr

lim P

sup Fn (u, X) Gr (u, Y) z K ( z ) ,

n n r uR

r

gdzie K jest dystrybuantą rozkładu Kołmogorowa.

Twierdzenie to jest podstawą następującego testu zgodności sprawdzającego,

czy próby pochodzą z tego samego rozkładu.

Niech:

H : F G

1.

,

K

:

F

G

2. Dn, r ( X, Y) sup Fn (u, X) Gr (u, Y) ,

uR

Wtedy za obszar krytyczny testu przyjmujemy

S1 (x, y) : Dn, r (x, y) c.

Uwaga.

1. Dla małych n i r rozkład statystyki Dn, r jest stablicowany.

2. Dla dużych n i r możemy wykorzystać twierdzenie graniczne Smirnowa,

stałą wyznaczyć korzystając z rozkładu Kołmogorowa K .

Test Kołmogorowa-Lillieforsa.

Gdy parametry rozkładu z hipotezy zerowej szacujemy z próby, twierdzenie

Kołmogorowa nie jest spełnione (uwaga 3 przy teście Kołmogorowa) powstał

test poprawiony przez Lillieforsa.

Test Lilieforsa służy do badania normalności rozkładu z parametrami

szacowanymi z próby :

Niech:

2

H : P N (m, )

1.

,

2

K

:

P

N

(

m

,

)

2. Z i - oznacza standaryzowane elementy próby, gdzie za oceny parametrów

przyjęto najlepsze oceny nieobciążone,

3. niech oznacza dystrybuantę rozkładu N(0,1), a Fn (z) dystrybuantę

empiryczną dla próby Z i ,

4. Ln max Fn ( zi ) ( zi ) ; Fn ( zi ) ( zi 1 ) ,

i

Wtedy za obszar krytyczny testu przyjmujemy

S1 x : Ln Lkrytyczne .

Uwaga.

1. Dla małych n wartości krytyczne Lkrytyczne są stablicowane.

2. Dla dużych n możemy wykorzystać proste wzory aproksymacyjne.