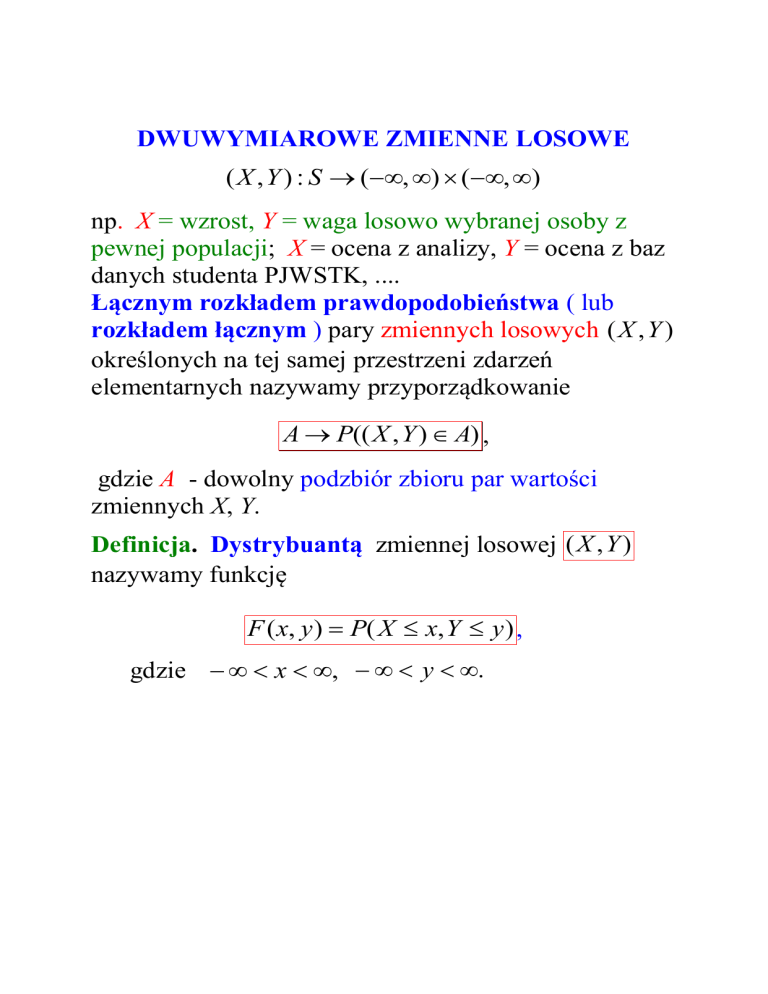

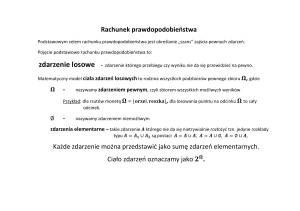

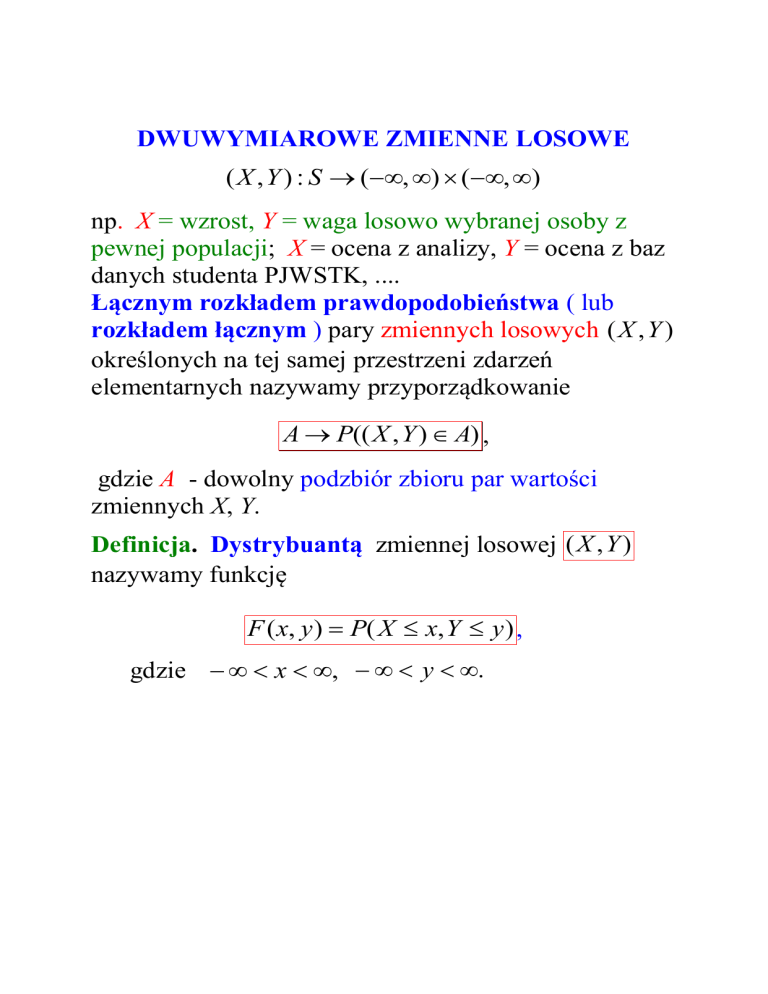

DWUWYMIAROWE ZMIENNE LOSOWE

( X , Y ) : S (, ) (, )

np. X = wzrost, Y = waga losowo wybranej osoby z

pewnej populacji; X = ocena z analizy, Y = ocena z baz

danych studenta PJWSTK, ....

Łącznym rozkładem prawdopodobieństwa ( lub

rozkładem łącznym ) pary zmiennych losowych ( X , Y )

określonych na tej samej przestrzeni zdarzeń

elementarnych nazywamy przyporządkowanie

A P(( X , Y ) A) ,

gdzie A - dowolny podzbiór zbioru par wartości

zmiennych X, Y.

Definicja. Dystrybuantą zmiennej losowej ( X , Y )

nazywamy funkcję

F ( x, y) P( X x, Y y) ,

gdzie x , y .

Twierdzenie. Łączny rozkład prawdopodobieństwa

zmiennej losowej ( X , Y ) określony jest jednoznacznie

przez jej dystrybuantę.

ZMIENNE DYSKRETNE

Funkcja prawdopodobieństwa ( łącznego )

dwuwymiarowej zmiennej losowej dyskretnej:

f ( x, y) P( X x, Y y) .

Własności:

(i)

f ( x, y) 0 , dla dowolnej pary wartości ( x, y) ,

(ii)

f ( x, y ) 1,

x y

(iii)

(iv)

P(( X , Y ) A)

f ( x, y ) ,

( x , y ) A

F ( x, y ) f ( s , t ) .

s x t y

Przykład. W każdym z dwóch etapów teleturnieju

można otrzymać 0, 1, lub 2 punkty. Niech zmienne

losowe X, Y oznaczają liczby punktów uzyskane w

etapie I i II, odpowiednio, przez losowo wybranego

uczestnika. Funkcję prawdopodobieństwa łącznego

określa tabela:

Y

X

0

1

2

0,5

0,05

0,01

0,2

0,1

0,06

0,02

0,03

A

0

1

2

Znaleźć:

(a) f (2,2) P( X 2, Y 2) ,

(b) P(Y 2) ,

(c) F (1,1) .

2

(a)

2

f ( x, y ) = 1. Stąd

x 0 y 0

f (2,2) = A = 1 – ( 0,5 + 0,05 + 0,01 + 0,2 + 0,1 +

+ 0,06 + 0,02 + 0,03 ) = 1 – 0,97 = 0,03.

2

(b) P(Y 2) P( X x, Y 2) =

x 0

f (0,2) f (1,2) f (2,2) = 0,01 + 0,06 + 0,03 = 0,1.

(c) F (1,1) = P( X 1, Y 1) =

= f (0,0) f (0,1) f (1,0) f (1,1) =

= 0,5 + 0,05 + 0,2 + 0,1 = 0,85.

ZMIENNE CIĄGŁE

Zmienna losowa ( X , Y ) jest dwuwymiarową ciągłą

zmienną losową, jeśli jej łączny rozkład prawdopodobieństwa określony jest przez funkcję gęstości łącznej

( łączną gęstość prawdopodobieństwa ), taką że

(i)

f ( x, y) 0

(ii)

f ( x, y )dxdy 1

(iii)

P(( X , Y ) A) f ( x, y )dxdy

A

W szczególności dla A (, x] (, y] :

x

y

F ( x, y ) = P( X x, Y y ) f ( s, t )dtds .

2

f ( x, y )

F ( x, y ) , x , y .

xy

Przykład. Zmienna losowa ( X , Y ) ma ( łączną )

gęstość prawdopodobieństwa

x y

f ( x, y )

gdy

0

0 x 1,0 y 1

przeciwnie

Obliczyć

0, 5 1

P( X 0,5, Y 0,25) = ( x y )dydx =

0 0, 25

0, 5

2

1

(

xy

y

/

2

)

0, 25 dx =

0

0,5

( x 0,5 0,25x 0,625 / 2)dx =

0

.

0,5

x2

0

,

75

0

,

1775

x

0,09375 0,08875 0,005.

2

0

ROZKŁADY BRZEGOWE

Niech ( X , Y ) będzie dwuwymiarową zmienną losową o

rozkładzie prawdopodobieństwa określonym przez

funkcję f ( x, y) (= funkcja prawdopodobieństwa lub

gęstość ).

Rozkład brzegowy = rozkład prawdopodobieństwa

zmiennej losowej X lub zmiennej losowej Y.

(a) dla dyskretnych zmiennych X, Y , brzegowe

funkcje prawdopodobieństwa są postaci

f X ( x ) P ( X x ) f ( x, y )

y

fY ( y ) P(Y y ) f ( x, y )

x

(b) dla ciągłych zmiennych X, Y , brzegowe gęstości

są postaci

f X ( x) f ( x, y )dy

fY ( y ) f ( x, y )dx .

D. (a)

f X (x) P( X x) P( X x, Y y}) =

y

P ( X x, Y y ) f ( x, y ) .

y

(b)

y

FX ( x) P( X x) = P( X x, Y ) =

x

f ( s, t )dtds . Stąd

d

f X (x)

FX (x) = f ( x, t ) dt .

dx

Przykład. Dwuwymiarowa zmienna losowa ( X , Y )

ma gęstość

3( x y ) 2 / 8

f ( x, y )

0

1 x 1,1 y 1

gdy

przeciwnie

Znaleźć gęstość zmiennej losowej X.

Niech 1 x 1 .

31

f X ( x) f ( x, y )dy = ( x y ) 2 dy

8 1

31 2

2

( x 2 xy y )dy =

8 1

1

3 2 1

3 2

=

x .

[ x y xy 2 y 3 / 3]

4

4

1

8

(3x 2 1) / 4

gdy

f X ( x)

0

1 x 1

.

przeciwnie

Gęstość zmiennej losowej Y ma identyczną postać.

ROZKŁADY WARUNKOWE

(a) Niech ( X , Y ) będzie dyskretną zmienną losową

mającą funkcję prawdopodobieństwa f ( x, y) .

Niech y – ustalone oraz fY ( y ) 0 .

Rozkład warunkowy zmiennej losowej X pod

warunkiem, że Y = y określa warunkowa funkcja

prawdopodobieństwa:

f ( x y) =

f ( x y) =

f ( x, y )

, x – dowolna wartość zmiennej X.

fY ( y )

P ( X x, Y y )

P( X x Y y ) =

P (Y y )

funkcja prawdopodobieństwa WARUNKOWEGO

zmiennej X pod warunkiem, że zmienna Y przyjęła

wartość y.

Analogicznie:

f ( y x) =

Notacja:

f ( x, y )

= P(Y y X x) , gdzie f X ( x) 0 .

f X ( x)

f ( x y) f X Y ( x y)

f ( y x) fY X ( y x)

(b) Niech ( X , Y ) będzie ciągłą zmienną losową o

łącznej gęstości f ( x, y) .

Niech y – ustalone oraz fY ( y ) 0 .

Warunkową gęstością prawdopodobieństwa zmiennej

losowej X pod warunkiem, że Y y nazywamy funkcję

f ( x y) =

f ( x, y )

, x .

fY ( y )

Przykład. (kontynuacja)

1 x 1,1 y 1

3( x y ) 2 / 8

gdy

f ( x, y )

przeciwnie

0

1 y 1

(3 y 2 1) / 4

fY ( y )

gdy

przeciwnie

0

Niech 1 y 1 - ustalone.

3( x y ) 2

3( x y ) 2 / 8

f ( x y) =

=

dla x [1,1]

2

2

6y 2

(3 y 1) / 4

f ( x y ) = 0 dla

x [1,1].

Uwaga. Analogicznie określamy rozkład warunkowy

zmiennej losowej Y pod warunkiem X = x. Zatem

f ( y x) =

f ( x, y )

, gdzie y – dowolna wartość Y,

f X ( x)

x - ustalone, takie że f X ( x) 0 .

Notacja: f ( y x) fY X ( y x) ,

f ( x y) f X Y ( x y)

Przykład. (kontynuacja)

(a) Znaleźć rozkład brzegowy zmiennej Y, liczby

punktów uzyskanych w II etapie teleturnieju przez

losowo wybranego uczestnika.

(b) Wyznaczyć rozkład warunkowy Y pod warunkiem,

że w I etapie uzyskano 2 punkty, tzn. X = 2.

Y

X

0

1

2

0,5

0,05

0,01

0,2

0,1

0,06

0

1

0,02

0,03

0,03

2

(a) fY ( y ) = f (0, y) f (1, y) f (2, y) . Stąd

Y

fY ( y )

(b) f ( y 2) =

0

0,72

1

0,18

2

0,1

f ( 2, y )

= ?

f X ( 2)

f (0 2) = fY X (0 2) = f (2,0) / f X (2) =

= 0,02/(0,02 + 0,03 + 0,03) =1/4,

f (1 2) = fY X (1 2) = f (2,1) / f X (2) =

=

0,03/0,08 = 3/8,

f (2 2) = fY X (2 2) = f (2,2) / f X (2) =

= 0,03/0,08 = 3/8.

Niezależne zmienne losowe

Definicja. Niech ( X , Y ) będzie dwuwymiarową

zmienna losową o dystrybuancie F ( x, y ) oraz

dystrybuantach brzegowych FX (x), FY ( y ) ,

x, y (, ) . Zmienne losowe X, Y są niezależne,

jeśli

F ( x, y ) FX ( x) FY ( y ) ,

dla wszystkich wartości x, y.

Twierdzenie. Zmienne losowe X, Y są niezależne

wtedy i tylko wtedy gdy

f ( x, y ) f X ( x ) f Y ( y ) ,

dla wszystkich wartości x, y.

Wniosek. Poniższe warunki są równoważne:

(i) Zmienne losowe X, Y są niezależne.

(ii) f ( x y ) f X ( x) , x , dla wszystkich y,

takich że fY ( y ) 0 .

(iii) f ( y x) fY ( y ) , y , dla wszystkich x,

takich że f X ( x) 0 .

Przykład. ( kontynuacja )

Czy liczby punktów uzyskane w I i II etapie

teleturnieju przez losowo wybranego uczestnika są

niezależnymi zmiennymi losowymi ?

y

0

1

2

f X (x )

x

0

0,5

0,05

0,01 0,56

1

0,2

0,1

0,06 0,36

2

0,02

0,03

0,03 0,08

fY ( y ) 0,72

0,18

0,1

f X (0) f (0,0) f (0,1) f (0,2) = 0,5 + 0,05 +

+ 0,01 = 0,56.

fY (0) f (0,0) f (1,0) f (2,0) = 0,5 + 0,2

+ 0,02 = 0,72.

Stąd

f (0,0) 0,5 0,56 0,72 f X (0) fY (0) ,

Zmienne losowe X , Y są zależne.

Przykład. ( kontynuacja ). Czy X, Y są niezależnymi

zmiennymi losowymi, jeśli ich łączna gęstość ma

postać:

3( x y ) 2 / 8

f ( x, y )

0

gdy

1 x 1,1 y 1

przeciwnie

Dla ( x, y) [1,1] [1,1] :

f X ( x) (3x 2 1) / 4 oraz fY ( y) (3 y 2 1) / 4 .

f ( x, y ) f X ( x ) f Y ( y ) .

Stąd X, Y są zależnymi zmiennymi losowymi.

Przykład. Czasy poprawnej pracy dwu podzespołów są

niezależnymi zmiennymi losowymi X, Y o rozkładach

wykładniczych z parametrami 1 , 2 , odpowiednio.

Średnie czasy pracy podzespołów wynoszą 1000

(godzin ) i 1200 ( godzin ). Obliczyć

prawdopodobieństwo zdarzenia takiego, że każdy

podzespół nie ulegnie awarii przed upływem 1500

godzin.

E ( X ) 1 / 1 1000 (godz.),

E (Y ) 1 / 2 1200 (godz.)

Stąd 1 1 / 1000 (1/godz.) 2 1 / 1200 (1/godz.).

P( X 1500, Y 1500) = P( X 1500) P(Y 1500) =

e 11500 e 2 1500 = e 1500 / 1000 e 1500 / 1200 =

= 0,2231 0,2865 = 0,0639.

Wartość oczekiwana. Kowariancja.

E[ g ( X , Y )] = g ( x, y) f ( x, y) ,

x y

gdy X, Y są dyskretne,

E[ g ( X , Y )] = g ( x, y ) f ( x, y )dxdy ,

gdy X, Y są ciągłe.

Uwaga. Dla g ( X , Y ) X lub g ( X , Y ) Y

otrzymujemy wartości oczekiwane brzegowych

zmiennych losowych X lub Y, gdyż

(a) w przypadku dyskretnym

E (X ) = xf ( x, y ) = x f ( x, y ) = xf X ( x) X .

x y

x

x

y

E (Y ) = yf ( x, y) = y f ( x, y ) = yfY ( y ) Y

x y

y

x

y

(b) w przypadku ciągłym

E (X ) = xf ( x, y )dxdy = x f ( x, y )dy dx

= xf X ( x)dx X .

Analogicznie otrzymujemy

E (Y ) yf ( x, y )dxdy yfY ( y )dy = Y .

Stwierdzenie. Niech c będzie dowolną stałą, a

g ( X , Y ) , g1 ( X , Y ) , g 2 ( X , Y ) zmiennymi losowymi

jednowymiarowymi. Wówczas

E[cg ( X , Y ) cE[ g ( X , Y )] ,

E[ g1 ( X , Y ) g 2 ( X , Y )] E[ g1 ( X , Y )] E[ g 2 ( X , Y )] .

Stwierdzenie. Jeśli zmienne losowe X, Y są niezależne,

to

E ( XY ) E ( X ) E (Y ) .

D. Niezależność zmiennych jest równoważna

f ( x, y ) f X ( x) fY ( y ) . Stąd i z definicji wartości

oczekiwanej mamy

(a) (zmienne dyskretne )

E[ g ( X , Y )] = g ( x, y) f ( x, y) .

x y

E ( XY ) = xyf ( x, y ) = xyf X ( x) fY ( y ) =

x y

x y

xf X ( x) yfY ( y ) = yfY ( y ) xf X ( x) =

x

y

y

x

E (Y ) E ( X ) E ( X ) E (Y ) .

(b) (zmienne ciągłe) Dowód analogiczny - Sumowanie

należy zastąpić całkowaniem.

Definicja. Niech X i Y będą zmiennymi losowymi o

łącznej funkcji prawdopodobieństwa ( gęstości )

f ( x, y) . Kowariancją zmiennych X i Y nazywamy

liczbę:

XY E[( X X )(Y Y )].

Uwaga.

Z definicji XY oraz E[ g ( X , Y )] , przyjmując

g ( x, y ) ( x X )( y Y ) , otrzymujemy wzory:

XY ( x X )( y Y ) f ( x, y) ,

x y

gdy X, Y są dyskretne

XY ( x X )( y Y ) f ( x, y )dxdy ,

gdy X, Y są ciągłe.

Notacja: Zamiast XY często piszemy Cov (X,Y).

Interpretacja. Kowariancja określa pewną

współzależność między zmiennymi losowymi:

(a) Jeśli „dużym” wartościom zmiennej X

przewyższającym X towarzyszą zwykle „duże”

wartości zmiennej Y przewyższające Y , a wartościom

X mniejszym od X towarzyszą zwykle wartości Y

mniejsze od Y , to XY > 0.

(b) Jeśli wartościom zmiennej X większym od X

towarzyszą zwykle wartości Y mniejsze od Y

wartościom X mniejszym od X towarzyszą zwykle

wartości Y większe od Y , to XY < 0.

Stwierdzenie. Cov(X,Y) = E ( XY ) X Y .

D. Cov(X,Y) = E[( X X )(Y Y )] =

= E ( XY XY Y X X Y ) =

= E ( XY ) E ( XY ) E (Y X ) X Y =

= E ( XY ) X Y .

Notacja: Zamiast XY często piszemy Cov (X,Y).

Twierdzenie. Jeśli zmienne losowe X i Y są

niezależne, to

Cov(X,Y) = 0.

D.

Dla niezależnych zmiennych losowych

E ( XY ) E ( X ) E (Y ) . Stąd oraz wzoru na

kowariancję mamy:

Cov(X,Y) = E ( XY ) X Y =

= E ( X ) E (Y ) X Y = 0.

Uwaga. Twierdzenie odwrotne nie jest na ogół

prawdziwe.

Twierdzenie. Dla dowolnych stałych a, b

Var( aX bY ) =

a 2 Var(X) + b 2 Var(Y) + 2 ab Cov(X,Y).

D.

E{ (aX bY ) (a X bY )2 } =

E{ a( X X ) b(Y Y )2 } = E{ a( X X ))2 }

+ E 2ab( X X )(Y Y ) + E{ b(Y Y )2 } =

= a 2 Var(X) + 2abCov(X,Y) + b 2 Var(Y).

c.k.d.

Wniosek. Jeśli zmienne losowe X i Y są niezależne,

to

Var( aX bY ) = a 2 Var(X) + b 2 Var(Y).

Definicja. Współczynnikiem korelacji między

zmiennymi losowymi X i Y nazywamy liczbę:

Cov( X , Y )

.

Var ( X ) Var (Y )

Zadanie. Zmienna losowa ( X , Y ) ma rozkład ciągły o

gęstości

0 x y 1

Cy

f ( x, y )

dla

.

przeciwnie

0

a) Wyznaczyć stałą C.

b) Obliczyć kowariancję pomiędzy zmiennymi X, Y.

c) Czy zmienne losowe X, Y są niezależne ?

1

1

1

0

x

0

2

a) f ( x, y )dxdy = dx Cydy = C y / 2

1 1

x dx =

1

x2

= C dx = C ( 1/2 - 1/6 ) = 1. Stąd C = 3.

2

0 2

1

1

0

x

b) E ( X ) xf ( x, y )dxdy = xdx 3 ydy =

x2 x4 1

x x3

= 3 x y / 2 dx = 3 dx = 3 =

x

2

8 0

0 2

0

4

1

2

1

1

= 3/8

1

1

0

x

E (Y ) = yf ( x, y )dxdy = dx 3 y 2 dy =

11

x3

= 3 dx =

3

03

x4 1

x = 1 – 1/4 = 3/4

4 0

1

1

0

x

E ( XY ) = xyf ( x, y )dxdy = xdx 3 y 2 dy =

1

xdx = 3 x(1 x )dx = 3( x

=3 x y

0

3

1

1

3

2

0

1

/ 2 x 5 / 5) =

0

= 0,9

Cov(X,Y) = 0,9 – (3/8)(3/4) = 99/160.

(c) Cov(X,Y) 0, więc zmienne nie są niezależne, tzn.

są zależne.

Przykład (kontynuacja )

y

0

1

?

2

f X (x )

x

0

0,5

0,05

0,01 0,56

1

0,2

0,1

0,06 0,36

2

0,02

0,03

0,03 0,08

fY ( y ) 0,72

0,18

0,1

E (X ) = x f ( x, y ) = 0 0,56 + 1 0,36 + 2 0,08 =

x y

0,52.

E (Y ) = y f ( x, y ) = 0 72 + 1 0,18 + 2 0,1 =

x y

0,38.

E ( XY ) = xyf ( x, y ) = 0 + 0 + 0 + 0 + 1 1 0,1 +

x y

+ 1 2 0,06 + 2 1 0,03 + 2 2 0,03 = 0,4

Cov(X,Y) = 0,4 – 0,52 0,38 = 0,2024.

E ( X 2 ) 12 0,36 + 2 2 0,08 = 0,68.

E (Y 2 ) 12 0,18 + 2 2 0,1 = 0,58.

Var(X) = E ( X 2 ) [ E ( X )]2 = 0,68 0,52 2 = 0,4096.

Var(Y) = E (Y 2 ) [ E (Y )]2 = 0,58 0,38 2 0,4356.

0,2024

0,4096 0,4356

0,47916.

Własności współczynnika korelacji

(i)

(ii)

1 1

Jeśli a i b są stałymi, oraz jeśli

Y = a + bX,

to

1

gdy

1

b0

b0

(iii) Jeśli 1, to między zmiennymi losowymi X, Y

istnieje liniowa zależność funkcyjna.

(iv) Jeśli zmienne losowe X i Y są niezależne, to

0.

Interpretacja. Współczynnik korelacji jest miarą

zależności liniowej między zmiennymi losowymi.

Dwuwymiarowy rozkład normalny

Zmienna losowa ( X , Y ) ma dwuwymiarowy rozkład

normalny, jeśli ma gęstość postaci:

f ( x, y )

1

q

(

x

,

y

)

exp

,

2

2 X Y

2(1 )

1

gdzie

q ( x, y )

( x X )2

X2

2

( x X )( y Y )

XY

( y Y ) 2

y2

x , y , stałe X , Y , spełniają

warunki X > 0, Y > 0, 1 1.

Notacja: ( X , Y ) ~ N ( X , Y , X , Y , )

Twierdzenie. Jeśli ( X , Y ) ~ N ( X , Y , X , Y , ) , to

(i)

X ~ N ( X , X ) ,

Y ~ N ( Y , Y ) .

,

(ii)

Cov(X,Y) = .

(iii) X, Y są niezależne wtedy i tylko wtedy gdy = 0.

Twierdzenie. Zmienna losowa (X,Y) ma

dwuwymiarowy rozkład normalny wtedy i tylko wtedy

gdy zmienna losowa aX + bY ma rozkład normalny, a, b

są dowolnymi stałymi.

Zadanie. Niech zmienna losowa X oznacza dzienną

wartość sprzedaży ( w 100 zł. ) dyskietek a zmienna

losowa Y dzienną wartość sprzedaży papieru

kserograficznego ( w 100 zł.). Wiadomo, że

dwuwymiarowa zmienna losowa ( X , Y ) ma rozkład

normalny o parametrach: X 5 , Y 6 , X 0,5 ,

Y 0,2 0,1. (a) Obliczyć średnią łączną wartość

sprzedaży w ciągu 10 dni, jeśli wartości sprzedaży obu

artykułów w kolejnych dniach są niezależnymi

zmiennymi losowymi o rozkładach takich jak rozkład

zmiennej ( X , Y ) . (b) Obliczyć prawdopodobieństwo, że

łączna wartość sprzedaży w ciągu 10 dni przekroczy

10000 zł.

(a) Łączna wartość sprzedaży:

S10 ( X1 Y1 ) ... ( X10 Y10 ) .

E(S10 ) 10 [ E ( X ) E(Y )] 10(5 6) 110(100 zł.)

Średnia łączna wartość sprzedaży to 11000 zł.

Var( S10 ) = 10 Var(X +Y) = 10 [Var(X) + Var(Y) +

2Cov(X,Y)] = 10( 0,52 0,22 2 0,1 0,5 0,2) =

= 30 (100 2 zł. ).

(b) S10 ~ N (110, 30) . Zatem po standaryzacji

S10 110

~ N (0,1) , skąd

30

S10 110 100 110

P

=

P( S10 100)

=

30

30

P( Z 1,8257) = 1 (1,8257) = 1 –[ 1 (1,8257) ]

= (1,8257) = 0,966.

CIĄGI ZMIENNYCH LOSOWYCH

Niech X1, X 2 ,..., X n będą zmiennymi losowymi

określonymi na tej samej przestrzni zdarzeń

elementarnych S .

F ( x1, x2 ,..., xn ) = P( X1 x1, X 2 x2 ,..., X n xn ) =

dystrybuanta wektora losowego ( X1, X 2 ,..., X n ).

f ( x1, x2 ,..., xn ) = funkcja prawdopodobieństwa

łącznego lub funkcja gęstości łącznej wektora losowego

( X1, X 2 ,..., X n ).

Definicja. Zmienne losowe X1, X 2 ,..., X n są niezależne,

jeśli

F ( x1, x2 ,..., xn ) = FX 1 ( x1 ) FX 2 ( x2 ) ... FX n ( xn ) ,

gdzie FX i ( x i ) P( X i xi ) , i = 1,2,...,n.

Definicja.

E[ g ( X1, X 2 , , , , X n )] =

... g ( x1 , x2 ,..., xn ) f ( x1 , x2 ,..., xn ) ,

x1 x 2

lub

xn

... g ( x1 , x2 ,..., x n ) f ( x1 , x2 ,..., xn )dx1dx2 ...dxn .

Stwierdzenie.

E (a1 X1 a2 X 2 ... an X n ) =

a1E ( X1 ) a2 E ( X 2 ) ... an E ( X n ) .

1 n

Wniosek. Niech X X i , E ( X i ) , i = 1,2,..,n.

n i 1

E( X ) = .

1

D. W stwierdzeniu trzeba przyjąć ai , i = 1,2,..,n.

n

Stwierdzenie. Jeśli X1, X 2 ,..., X n są niezależnymi

zmiennymi losowymi, to

Var (a1 X1 a2 X 2 ... an X n ) =

a12 Var( X 1 ) + a2 2 Var( X 2 ) + ... + a n 2 Var( X n ).

1

W szczególności, jeśli Var( X i ) = 2 oraz ai ,

n

i = 1,2,..,n, to

2

Var( X ) =

.

n

Przykład. Dokonujemy n jednakowych, niezależnych

doświadczeń Bernoulli’ego o prawdopodobieństwie

sukcesu p, 0 p 1. Znaleźć wartość oczekiwaną i

wariancję zmiennej losowej Y będącej liczbą sukcesów.

Niech X i 1, gdy sukces w i-tym doświadczeniu,

X i 0, gdy porażka w i-tym doświadczeniu. Wówczas

X1, X 2 ,..., X n są niezależnymi zmiennymi losowymi o

funkcjach prawdopodobieństwa:

f X i (1) p , f X i (0) 1 p .

Stąd:

E ( X i ) p , Var( X i ) = p(1 p) .

Liczba sukcesów =

Y X1 X 2 ... X n .

E (Y ) = E ( X1 X 2 ... X n ) =

E ( X1 ) E ( X 2 ) ... E ( X n ) = np .

Var(Y) =

Var( X 1 ) + Var( X 2 ) + ... + Var( X n ) = np(1 p)

Definicja. Prostą próbą losową o liczności n

nazywamy ciąg niezależnych zmiennych losowych

X1, X 2 ,..., X n określonych na przestrzeni zdarzeń

elementarnych S i takich, że każda ze zmiennych ma

taki sam rozkład.

Twierdzenie. ( CENTRALNE TWIERDZENIE

GRANICZNE)

Niech X1, X 2 ,..., X n będzie prostą próbą losową z

rozkładu o średniej i wariancji 2 . Wówczas dla

dużych liczności próby n rozkład prawdopodobieństwa

standaryzowanej średniej ( = standaryzowanej sumy

X1 X 2 ... X n ) jest bliski standardowemu

rozkładowi normalnemu N (0,1) , dokładniej

X

b) P(a Z b) (b) (a),

/ n

przy n . Równoważnie rozkład średniej X jest

bliski rozkładowi normalnemu N ( , / n ) .

P(a

Przykład. Załóżmy, że rozkład codziennego dojazdu do

pracy jest w przybliżeniu rozkładem jednostajnym na

przedziale [0,5 godz., 1 godz. ] i że czasy dojazdów w

różne dni są niezależne. Obliczyć przybliżone

prawdopodobieństwo zdarzenia, że średni dzienny

dojazd w ciągu 30 dni przekroczy 0,8 godz.

Niech X i oznacza czas dojazdu w i-tym dniu ,

i 1,2,...,30 .

0,5 1 3

,

2

4

(1 0,5) 2 1

2

Var ( X i )

.

12

48

E( X i )

3

1 / 48

= 0,00069.

E ( X ) , Var ( X )

4

30

P ( X 0,8) = P(

X 3/ 4

0,8 3 / 4

)

1 /(30 48)

1 /(30 48)

P( Z 1,89) 0,03.