Rozdział 1

Gry niekooperacyjne w postaci

strategicznej

Zacznijmy od odpowiedzenia sobie na pytanie – czym będziemy się zajmować na tym

kursie. Otóż teoria gier zajmuje się wszystkimi sytuacjami, w których istnieje kilka podmiotów, podejmujących decyzje, które wpływają na interesy nie tylko ich samych, ale

także pozostałych. W związku z tym nie mogą podejmować tych decyzji tak, jakby sytuacja wokół była już znana (dopasowując się tylko do niej) – muszą zastanowić się,

co zrobią w tej sytuacji inni (i czy nasza decyzja nie zmieni decyzji tych „innych”) –

w związku z tym analiza musi być bardziej złożona. Żeby dojść do tego, w jaki sposób

takie sytuacje opisywać w sposób ścisły, spróbujmy zobaczyć na prostym przykładzie,

co do takiego opisu będzie potrzebne.

Przykład: Rozważmy sobie taką sytuację: mamy plażę oraz dwóch sprzedawców lodów

(piwa, innych napojów chłodzących), którzy zastanawiają się, gdzie wzdłuż plaży ulokować swoje sklepiki. Każdy z nich sprzedaje produkty podobnej jakości, więc mogą

zakładać, że plażowicze będą zawsze kupować w tej z budek, do której będą mieli bliżej.

Dodatkowo wiedzą, że zainteresowanie ich asortymentem jest odwrotnie proporcjonalne

do odległości od najbliższej budki. No i oczywiście każdy z nich stara się zarobić jak

najwięcej.

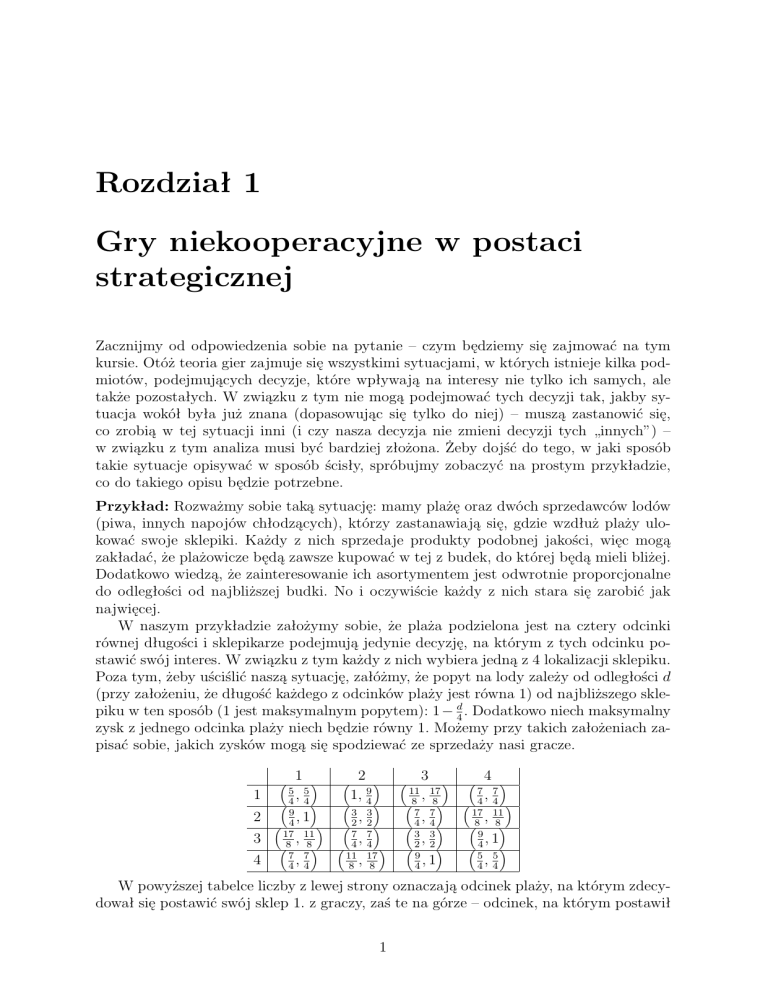

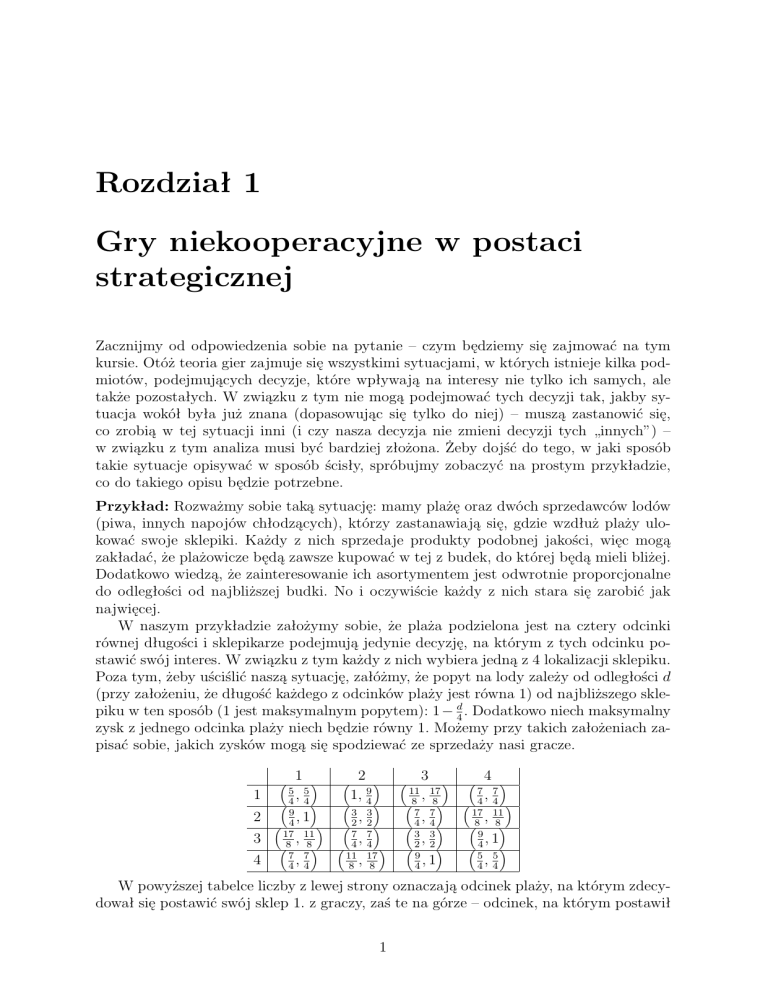

W naszym przykładzie założymy sobie, że plaża podzielona jest na cztery odcinki

równej długości i sklepikarze podejmują jedynie decyzję, na którym z tych odcinku postawić swój interes. W związku z tym każdy z nich wybiera jedną z 4 lokalizacji sklepiku.

Poza tym, żeby uściślić naszą sytuację, załóżmy, że popyt na lody zależy od odległości d

(przy założeniu, że długość każdego z odcinków plaży jest równa 1) od najbliższego sklepiku w ten sposób (1 jest maksymalnym popytem): 1 − d4 . Dodatkowo niech maksymalny

zysk z jednego odcinka plaży niech będzie równy 1. Możemy przy takich założeniach zapisać sobie, jakich zysków mogą się spodziewać ze sprzedaży nasi gracze.

1

2

3

4

1 5 5

,

4 4

9

,1

4

17 11

,

8 8

7 7

,

4 4

2 1, 49

3

,

2

7

,

4

11

,

8

3

2

7

4 17

8

3 11 17

,

8 8

7 7

,

4 4

3 3

,

2 2

9

,1

4

4 7 7

,

4 4 17 11

,

8 8

9

,1

4 5 5

,

4 4

W powyższej tabelce liczby z lewej strony oznaczają odcinek plaży, na którym zdecydował się postawić swój sklep 1. z graczy, zaś te na górze – odcinek, na którym postawił

1

swój sklep 2. z graczy. Liczby w nawiasach to zysk odpowiednio pierwszego i drugiego

gracza.

Ten przykład w zasadzie już nam pokazuje, w jaki sposób możemy opisać taką sytuację konfliktową – potrzebne nam są trzy obiekty: zbiór możliwych wyborów pierwszego

gracza (tu {1, 2, 3, 4}), zbiór wyborów drugiego gracza (w naszej grze taki sam) oraz

tabelka (macierz) wypłat graczy. W ten sposób dostajemy obiekt, który w literaturze

teoriogrowej nazywa się grą dwumacierzową (dwu-, bo tak naprawdę mamy dwie macierze – wypłat pierwszego i drugiego gracza).

Gry dwumacierzowe

Grą dwumacierzową nazywamy czwórkę:

• X = {1, 2, . . . , m} – zbiór strategii gracza 1.,

• Y = {1, 2, . . . , n} – zbiór strategii gracza 2,

• A = [aij ]m×n – macierz wypłat gracza 1.,

• B = [bij ]m×n – macierz wypłat gracza 2.

(Oczywiście, wypłaty graczy mogą być czysto subiektywne, i mówią o tym, co dany gracz

myśli o danej sytuacji, a nie muszą oznaczać jakichś konkretnych wypłat, które jeden z

graczy wypłaca drugiemu, lub ktoś trzeci (Pan Bóg) wypłaca graczom).

Teraz powróćmy do naszego przykładu i zastanówmy się, co moglibyśmy uznać za

rozwiązanie dla takiej gry (oczywiście rozwiązaniem musi być para strategii 1. i 2. gracza). Czy może nim być na przykład układ strategii (1, 1)? Nie - bo jeśli obaj gracze

ulokują swoje sklepy ne pierwszym odcinku, to któryś z nich (np. pierwszy) stwierdzi,

że bardziej opłaca mu się przenieść swój sklep na 3. odcinek (i w ten sposób powiększyć

). Czy w takim razie ten nowy układ strategii ((3, 1)) będzie

swoją wypłatę z 45 do 17

8

rozwiązaniem? Znowu nie, bo teraz 2. z graczy przeniesie swój interes na 2. odcinek, zyskując 83 . Tym razem jednak dochodzimy do takiej pary strategii, że żaden z graczy nie

będzie próbował przenosić swojej budki, bo każdy z nich na tym straci. A więc rozwiązaniem jest (3, 2), i w dodatku potrafimy powiedzieć, dlaczego właśnie to jest rozwiązanie

(bo żaden z graczy nie będzie próbował go zmienić).

Formalnie to, co teraz opisaliśmy, można zapisać następująco:

Definicja: Rozwiązaniem dla gry dwumacierzowej zdefiniowanej przez macierze A i B

wymiaru m × n jest tzw. równowaga w sensie Nasha, tzn. taka para strategii (i∗ , j ∗ ), że

ai∗ j ∗ ­ aij ∗ dla każdego i ¬ m oraz bi∗ j ∗ ­ bi∗ j dla każdego j ¬ n.

(Nietrudno zauważyć, że w „naszej” grze są dwie równowagi: (3, 2) i (2, 3)).

Niestety, jak się okazuje, tak zdefiniowane rozwiązanie ma pewne wady, które obrazują trzy najbardziej znane przykłady gier dwumacierzowych.

Przykład 1 (Papier, nożyce, kamień): Tę grę wszyscy znają – do wyboru są trzy startegie: papier, nożyce i kamień – kamień bije nożyce, nożyce biją papier, a papier bije

kamień. Jeśli za wypłaty wygrywającego przyjmiemy sobie 1, a za wypłaty przegrywającego −1 (jeśli mamy remis, wypłaty obu będą równe 0), to macierzami wypłat w tej

grze będą:

0 −1

1

0

1 −1

0 −1

0

1

A= 1

B = −1

.

−1

1

0

1 −1

0

2

Jak nietrudno zauważyć, ta gra równowagi nie ma, czyli istnieją gry (i jest ich nawet

bardzo dużo), które nie mają rozwiązania.

Przykład 2: Mamy parę, która chce spędzić razem wieczór, tylko zastanawiają się –

jak. Kanoniczna wersja tej historyjki jest taka , że Pani chce iść na balet, Pan na boks.

Niestety nie umówili się, gdzie mają iść, a właśnie padła sieć i nie są w stanie się w

żaden sposób skontaktować. Jeśli nie skoordynują miejsc, w które się wybiorą – nici ze

wspólnego wieczoru i obie strony będą na tym stratne. Jeśli spotkają się na balecie, Pani

będzie wniebowzięta, Pan jakby mniej, ale na pewno skorzysta z profitów, jakie niesie

za sobą wspólnie spędzony wieczór. W drugą stronę podobnie. Macierze wypłat graczy

w tej grze będą wyglądały tak:

"

A (Pani) =

4 0

0 1

#

"

B (Pan) =

1 0

0 4

#

.

Ta gra ma dwie równowagi: (boks,boks) i (balet, balet)

Co z tego przykładu wynika?

1. Może istnieć wiele różnych równowag Nasha ze znacząco różnymi wypłatami. Może

się zdarzyć, że jedna równowaga jest bardziej opłacalna dla jednego z graczy, a inna

dla drugiego.

2. Strategii w różnych równowagach nie można między sobą wymieniać. Bez uzgodnienia, która równowaga będzie grana, nie da się racjonalnie wybrać strategii do

gry.

3. Wiedząc, jaki jest zbiór równowag Nasha w danej grze, nie potrafimy powiedzieć,

jak będą zachowywać się gracze (nawet przy założeniu, że grają racjonalnie.)

Przykład 3 (dylemat więźnia – najbardziej znany przykład w teorii gier): Historyjka

jest taka: dwóch więźniów podejrzanych o jakieś przestępstwo, jest przesłuchiwanych w

oddzielnych pokojach. Są winni, ale każdy z nich zastanawia się, czy się przyznać, czy

nie. Jeśli się przyzna (zrzucając przy okazji większość winy na drugiego), a drugi więzień

będzie szedł w zaparte, pierwszy może liczyć na to, że dostanie wyrok w zawiasach, ale

kosztem wspólnika. Jeśli żaden się nie przyzna, to głównej winy nikt im nie udowodni, ale

przymkną ich na rok za to, co są w stanie im udowodnić bez współpracy żadnego z nich.

Jeśli przyznają się obaj, sąd nie uwerzy w ich skruchę, ale odpowiedzialnością obarczy

w tym samym stopniu, i dostaną wyrok nieco niższy niż ten, który się nie przyzna, a

cała wina zostanie jemu przypisana. Macierze wypłat w tej grze wyglądają tak:

"

A=

−5 0

−10 −1

#

"

B=

−5 −10

0

−1

#

.

Ta gra posiada dokładnie jedną równowagę – obaj się przyznają. Problem w tym, że

gdyby obaj odstąpili od równowagi, zyskaliby na tym.

A wniosek z tego przykładu taki, że równowaga nie musi dawać optymalnych wypłat

w grze. Jeśli osiągnięcie takich wypłat wiąże się z kooperacją, nie będzie to równowaga.

Czy te wymienione wady oznaczają, że równowaga Nasha jest złym rozwiązaniem?

Nie – w przypadku wad widocznych w dwóch ostatnich przykładach, to nie są wady

rozwiązania – ludzie naprawdę w tego typu sytuacjach postępują w taki (zdawałoby się,

3

nieoptymalny) sposób jak w ostatnim przykładzie, też mają problemy z wyborem sposobu postępowania, jeśli nie ma między nimi komunikacji itp. Pozostaje ostatni problem

– możliwość nieistnienia rozwiązania Nasha. Ten problem da się jednak usunąć. Pomysł

tego, jak to zrobić pochodzi od twórcy teorii gier – Johna von Neumanna. Wymyślił

on mianowicie, że gracze, zamiast wskazywać konkretną kolumnę albo konkretny wiersz

macierzy wypłat, mogą wybierać rozkład prawdopodobieństwa, zgodnie z którym ma

być wylosowana ich strategia. W ten sposób zbiór strategii graczy zostanie znacząco

powiększony, i dzięki temu będzie łatwiej o równowagę w takiej grze. Formalnie takie

uogólnienie zapisujemy następująco:

Rozszerzenie mieszane gry dwumacierzowej

Niech, jak poprzednio, X = {1, . . . , m}, Y = {1, . . . , n} będą odpowiednio zbiorami

wierszy i kolumn macierzy wypłat graczy A i B. Za zbiory strategii graczy przyjmujemy

P (X) i P (Y ) (gdzie P (A) oznacza zbiór rozkładów prawdopodobieństwa na zbiorze A).

Elementy µ ∈ P (X) oraz σ ∈ P (Y ) będziemy nazywać strategiami mieszanymi graczy

(w odróżnieniu od elementów X i Y , które nazywamy strategiami czystymi), a wypłaty

graczy definiujemy następująco:

u1 (µ, σ) =

XX

i

aij µi σj ,

u2 µ, σ) =

j

XX

i

bij µi σj ,

j

gdzie µi to prawdopodobieństwo wylosowania i z rozkładu µ, a σj – prawdopodobieństwo

wylosowania j z σ (czyli wypłaty są wartościami oczekiwanymi wypłat w oryginalnej

grze dwumacierzowej, jeśli gracze losują swoje strategie zgodnie z rozkładami µ i σ).

Przypomnijmy sobie teraz przykład gry, która nie miała równowagi w strategiach

czystych. Tym przykładem były „Papier, nożyce i kamień”, z macierzami wypłat

0

1 −1

0

1

B = −1

.

1 −1

0

0 −1

1

0 −1

A= 1

−1

1

0

Nietrudno zauważyć, że tutaj równowagą w strategiach mieszanych będzie µ∗ =

1 1 1

, ,

3 3 3

i σ ∗ = 31 , 31 , 13 . (Jest tak, ponieważ u1 (µ∗ , σ ∗ ) = 0 i jednocześnie dla dowolnej innej

strategii 1. gracza, µ = (µ1 , µ2 , µ3 ), również u1 (µ, σ ∗ ) = 0, więc gracz 1. nie będzie

miał powodu do zmiany swojej strategii; podobnie (a nawet dokładnie tak samo) jest w

przypadku 2. gracza).

Oczywiście zastosowanie strategii mieszanych ma swoje wady – przede wszystkim

zakłada nie wprost, że gra będzie rozgrywana wielokrotnie (bo inaczej trudno byłoby w

praktyce używać rozkładów prawdopodobieństwa jako strategii – przy jednej rozgrywce

ta strategia byłaby zawsze jakąś konkretną strategią czystą). Jednak zysk, jaki pojawia

się w zamian, jest potężny – nie tylko „Papier, nożyce i kamień”, ale każda gra dwumacierzowa będzie miała w strategiach mieszanych równowagę. Mniej więcej to udowodnił

Nash.

Twierdzenie 1.1 Każda gra dwumacierzowa posiada równowagę w sensie Nasha.

Nie będziemy dowodzić tego twierdzenia. Udowodnimy twierdzenie trochę ogólniejsze,

które za chwilkę podam (czyli to, co naprawdę udowodnił Nash; potem pokażemy, dlaczego twierdzenie dla gier dwumacierzowych z tej ogólniejszej wersji wynika). Żeby je

podać, zdefiniuję ogólnie, co nazywamy grą niekooperacyjną.

4

Definicja 1.1 n-osobową grą niekooperacyjną nazwiemy Γ = (X1 , . . . , Xn , u1 , . . . , un ),

gdzie Xi – (niepuste) zbiory strategii poszczególnych graczy, ui : X1 × · · · × Xn → R

– ograniczone funkcje wypłaty poszczególnych graczy. Gracze wybierają niezależnie od

siebie odpowiednio x1 ∈ X1 , x2 ∈ X2 , . . . , xn ∈ Xn , w wyniku czego gracz k-ty otrzymuje

uk (x1 , . . . , xn ).

W powyższej definicji nie precyzujemy, czy Xi są zbiorami strategii czystych, czy mieszanych. Pokażemy, że przy pewnych założeniach na te zbiory, oraz na funkcje wypłaty

graczy, gra będzie posiadała równowagę w strategiach należących właśnie do tych zbiorów.

Definicja 1.2 Równowagą w sensie Nasha w grze Γ zdefiniowanej powyżej nazwiemy

układ strategii x∗ = (x∗1 , . . . , x∗n ) takich, że dla każdego gracza i oraz yi ∈ Xi mamy

ui (x∗ ) ­ ui ((x∗1 , . . . , x∗i−1 , yi , x∗i+1 , . . . , x∗n )).

Oznacza to, jak poprzednio, że pojedynczemu graczowi nie opłaca się odstąpić od równowagi, gdy inni pozostają przy swoich strategiach x∗i .

Prawdziwe będzie następujące twierdzenie:

Twierdzenie 1.2 (Nash, 1950) Załóżmy, że każdy ze zbiorów Xi jest zwartym wypukłym

podzbiorem Rk . Załóżmy ponadto, że dla każdego i funkcja ui jest ciągła na X1 ×· · ·×Xn

oraz jest wklęsła względem i-tej zmiennej, przy ustalonych pozostałych zmiennych. Wtedy

gra Γ, określona przez zbiory Xi i funkcje ui , posiada równowagę Nasha.

Uwaga 1.1 Dla tych, którzy nie wiedzą – podzbiór przestrzeni metrycznej nazywamy

zwartym, jeśli każdy ciąg elementów tego zbioru posiada podciąg zbieżny. W Rk zbiór

jest zwarty iff jest domknięty i ograniczony.

Zanim przejdziemy do dowodu tej uogólnionej wersji twierdzenia Nasha, sformułujemy twierdzenie, które będzie punktem wyjściowym dla tego dowodu.

Twierdzenie 1.3 (Twierdzenie Kakutaniego o punkcie stałym) Niech S będzie zwartym

wypukłym podzbiorem Rk i niech ψ będzie operatorem przyporządkowującym każdemu

s ∈ S zwarty, wypukły podzbiór S, o wykresie domkniętym, (tzn. jeśli xn ∈ S, xn → x0 ,

yn ∈ ψ(xn ), yn → y0 , to y0 ∈ ψ(x0 )). Istnieje wtedy takie x∗ , że x∗ ∈ ψ(x∗ ) (punkt stały

multifunkcji ψ).

Tak naprawde chętnie przeprowadziłbym dowód też tego twierdzenia, żeby wychodzić

od faktów przez Państwa znanych, ale to wymagałoby wprowadzenia ileś dodatkowej

teorii (sympleks, współrzędne barycentryczne, podział symplicjalny, twierdzenie Brouwera o punkcie stałym), w związku z tym twierdzenie Kakutaniego będę traktował

jako punkt wyjściowy, natomiast osobom zainteresowanym dowodem tego twierdzenia

polecam przeczytanie XX rozdziału „Wstępu do teorii mnogości i topologii” Kuratowskiego (Sympleks i jego własności). Wtedy poniższy dowód powinien być zrozumiały.

Dowód tw Kakutaniego:1 Bez straty ogólności możemy założyć, że S jest sympleksem.

Niech {πµ } będzie ciągiem rozbić symplicjalnych sympleksu S, takich że średnica każdego

sympleksu z πµ nie przekracza δµ i δµ → 0.

1

Tego nie było na wykładzie

5

Zdefiniujmy ψ µ : S → S w następujący sposób: jeśli x jest wierzchołkiem sympleksu z πµ ,

to za ψ µ (x) przyjmujemy dowolne s ∈ ψ(x), a następnie przedłużamy ψ µ liniowo na każdy

P

P

z sympleksów rozbicia, tzn. jeśli x = k+1

λj = 1, gdzie {x1 , . . . , xk+1 } —

j=1 λj xj , λi ­ 0,

Pk+1

µ

wierzchołki ustalonego sympleksu z πµ , to ψ (x) = j=1 λj ψ µ (xj ). Tak zdefiniowane ψ µ jest

ciągłe, a zatem na mocy twierdzenia Brouwera ma punkt stały, który możemy oznaczyć przez

xµ . Ponadto

xµ =

k+1

X

j=1

λµj xµj ,

k+1

X

λµj = 1, λµj ­ 0.

j=1

Ze zwartości S można założyć bez straty ogólności, że xµi , λµi , ψ µ (xµi ) są zbieżne przy µ → ∞;

xµi oraz xµ mają tę samą granicę x∗ ∈ S. Niech limµ λµj = λ∗j , a limµ ψ µ (xµj ) = ηj∗ .

P µ µ µ

P ∗ ∗

Mamy xµ = ψ µ (xµ ) =

λj ψ (xj ). Wtedy x∗ =

λj ηj , a z własności, które spełnia ψ

wynika, że ηj∗ ∈ ψ(x∗ ) dla każdego j. Stąd x∗ ∈ ψ(x∗ ), bo ψ(x∗ ) jest wypukły, a więc x∗ jest

szukanym punktem zbioru S. Dowód tw. Nasha: Idea tego dowodu polega na tym, żeby skonstruować odwzorowanie, które będzie miało punkt stały wtedy i tylko wtedy, gdy gra posiada równowagę

Nasha. Wtedy sprawdzimy, że to odwzorowanie spełnia założenia twierdzenia Kakutaniego, zatem ma punkt stały, a gra ma równowagę. Dowód twierdzenia przeprowadzimy

dla przypadku, gdy jest dwóch graczy. Ta zmiana upraszcza jedynie notację, natomiast

dowód w ogólnym przypadku nie jest ani trochę bardziej skomplikowany.

Niech:

B1 (y) = {a ∈ X1 : u1 (a, y) = max u1 (x, y)},

x∈X1

B2 (x) = {b ∈ X2 : u2 (x, b) = max u2 (x, y)}.

y∈X2

Zbiór B1 (y) interpretujemy jako zbiór najlepszych odpowiedzi 1. gracza na strategię y

drugiego. Podobną interpretację ma zbiór B2 (x). Jeśli teraz zdefiniujemy sobie multifunkcję

F (x, y) = B1 (y) × B2 (x),

to to będzie to odwzorowanie, którego szukamy, bo ewentualny punkt stały takiego

odwzorowania (x∗ , y ∗ ) ∈ F (x∗ , y ∗ ) będzie miał taką własność, że x∗ będzie najlepszą

odpowiedzią na strategię y ∗ i na odwrót, czyli to będzie równowaga Nasha.

Sprawdźmy zatem, czy spełnione są założenia twierdzenia Kakutaniego.

1. Multifunkcja F jest zdefiniowana na zbiorze U = X1 × X2 , który jest zwarty. To

można uzasadnić na wiele sposobów (wyciągając podciąg zbieżny z jednej współrzędnej, a potem z niego podciąg zbieżny po drugiej, lub mówiąc, że produkt

zbiorów domkniętych i ograniczonych też ma tę własność). Jest też wypukły jako

produkt zbiorów wypukłych.

2. Zbiory B1 (y) (B2 (x)) są zawsze niepuste, bo każda funkcja ciągła na zbiorze zwartym osiąga swoje supremum na tym zbiorze.

3. Funkcja u1 (·, y) jest wklęsła dla każdego y ∈ X2 , stąd jeśli dla ustalonego y osiąga

ona maksimum dla x1 oraz x2 , to musi osiągać je także dla kombinacji wypukłych

tych punktów, a to oznacza, że dla każdego y, zbiór B1 (y) jest wypukły. Podobnie

można uzasadnić wypukłość B2 (x). Ponieważ iloczyn kartezjański dwóch zbiorów

wypukłych też jest wypukły, to F (x, Y ) jest zbiorem wypukłym dla dowolnych x

i y.

6

4. Weźmy teraz dowolny ciąg {xi } elementów zbioru B1 (y) dla dowolnego ustalonego

y, zbieżny do pewnego x. Ponieważ funkcja u1 jest ciągła, to x też należy do B1 (y).

Zatem zbiór ten jest domknięty. Jako podzbiór X1 jest także ograniczony, a zatem

zwarty. Podobnie pokazujemy, że B2 (x) są zbiorami zwartymi. Oczywiście F (x, y),

jako iloczyn kartezjański zbiorów zwartych, jest dla dowolnych x i y także zbiorem

zwartym (patrz punkt 1.).

5. Domkniętość wykresu. Znowu (bez utraty ogólności) ograniczymy się do jednej

współrzędnej. Załóżmy nie wprost, że wykres B1 nie jest domknięty, czyli istnieje

ciąg {(xn , yn )} zbieżny do (x, y) taki, że xn ∈ B1 (yn ), ale x 6∈ B1 (y). Pierwsza z

tych równości oznacza, że

u1 (a, yn ) ¬ u1 (xn , yn ) ∀a ∈ X1 ,

ale ponieważ u1 jest ciągła, więc prawdziwe musi być także

u1 (a, y) ¬ u1 (x, y) ∀a ∈ X1 ,

co jest równoważne x ∈ B1 (y) – sprzeczność. Czyli wykres naszego odwzorowania

jest domknięty.

A zatem wszystkie założenia twierdzenia Kakutaniego są spełnione, więc gra Γ posiada

równowagę Nasha. Uwaga 1.2 Ktoś mógłby się zapytać, jaki sens ma udowadnianie twierdzenia, korzystając z innego twierdzenia, którego słuchacze nie znają. Otóż głównym celem przedstawienia tutaj tego dowodu jest pokazanie jego ogólnego schematu, bo właściwie wszystkie

twierdzenia o istnieniu równowagi Nasha udowadnia się według tego schematu. Innymi

słowy, żeby była szansa na to, że dla jakiegoś typu gier, przy jakichś założeniach, gra

będzie musiała posiadać równowagę, to przy podobnych założeniach, dla takich samych

przestrzeni, powinno być prawdziwe twierdzenie o punkcie stałym.

Wniosek 1.1 Twierdzenie Nasha dla gier dwumacierzowych wynika z powyższego twierdzenia w następujący sposób:

Niech X1 = P (W ), gdzie W = {1, . . . , m} – zbiór wierszy macierzy, a X2 = P (K),

gdzie K = {1, . . . , n} – zbiór kolumn. Dowolny rozkład prawdopodobieństwa µ =

P

(µ1 , . . . , µm ) ∈ P (W ) jest układem m liczb spełniających warunki i µi = 1, µi ­ 0

∀i. Zbiór takich µ jest wypukłym i zwartym podzbiorem Rm . Podobnie w przypadku

zbioru strategii mieszanych 2. gracza. Z kolei wypłata gracza 1. (podobnie z wypłatą 2.),

P P

gdy używane są strategie µ i σ, u1 (µ, σ) = i j Aij µi σj jest funkcją liniową (właściwie

afiniczną) względem µ i σ z osobna; taka funkcja jest też w szczególności ciągła i wklęsła

względem µ i σ z osobna.2 A zatem spełnione są założenia udowodnionego przez nas

uogólnionego twierdzenia Nasha, i gra posiada równowagę w strategiach z X1 i X2 , czyli

strategiach mieszanych w wyjściowej grze dwumacierzowej.

2

Na wykładzie usiłowałem pokazać, że jest wklęsła względem obu zmiennych naraz, co oczywiście

nie jest prawdą, dlatego nic z tego nie wyszło. Natomiast w twierdzeniu Nasha nie ma założenia o

wklęsłości funkcji wypłaty względem strategii obu graczy, tylko o wklęsłości wypłaty każdego gracza

względem jego własnej strategii, a względem dowolnej pojedynczej zmiennej ta wypłata jest wklęsła,

bo jest liniowa.

7