Entropia w klasyfikacji

Quadratic Renyi’s Entropy: zastosowania w klasyfikacji

Wojciech Czarnecki

Jacek Tabor

GMUM

Kraków 2014

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

1 / 34

1

Motywacja

Teoria informacji

Estymacja rozkładu

2

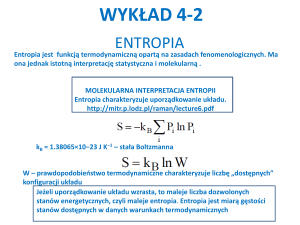

Teoria Informacji

Wyprowadzenie entropii

Własności klasycznej entropii

Średnie

Entropia Renyi’ego

3

Statystyka

Rozkład normalny

Metoda najwiekszej

˛

wiarygodności

Estymacja jadrowa

˛

Cauchy-Schwarz Divergence

4

Główny cel

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

2 / 34

Motywacja

Teoria informacji

Po co nam teoria informacji (entropia)?

[J. Principe „Information Theoretic Learning”]:

The common problem faced by many data processing professionals is HOW

TO BEST EXTRACT THE INFORMATION CONTAINED IN DATA . ... Data hides,

either in time structure or in spatial redundancy, important clues to answer the

information-processing questions we pose. ... Therefore the pressure to

DISTILL INFORMATION from data will mount at an increasing pace in the future,

and old ways of dealing with this problem will be forced to evolve and adapt to

the new reality.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

3 / 34

Motywacja

Teoria informacji

Gdzie sie˛ stosuje?

kodowanie i kompresja (Shannon, Huffman, etc)

Rissanen: MDLP (minimum description length principle) – konstrukcja

modeli

klastrowanie (Google/entropy clustering/: około 7 750 000 wyników,....,

CEC)

klasyfikacja (decision trees)

EM (expectation maximization)

ICA (independent component analysis)

W zasadzie w każdej działce nauczania maszynowego teoria informacji

znajduje zastosowania.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

4 / 34

Motywacja

Teoria informacji

Podstawowe hasła które sie˛ pojawia˛

teoria informacji

entropia Shannona h

entropia krzyżowa H ×

dywergencja Kullbacka-Leiblera DKL

joint entropy H(X , Y )

mutual information I

entropia Renyi’ego

Cross Information Potential (ip× )

dywergencja Cauchy’ego-Schwarza DCS

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

5 / 34

Motywacja

Estymacja rozkładu

Mamy wylosowana˛ próbk˛e, i na podstawie tej próbki chcemy mieć pojecie

˛

o

prawdziwym rozkładzie (umiejetność

˛

generowania z prawdziwego rozkładu).

Przydaje sie˛ w:

kompresja danych (do kompresji, potrzebujemy mieć prawd.)

generowanie nowych danych z o tym samym rozkładzie (uczenie sieci,

ekonomia - przeprowadzanie symulacji: Iwona Żerda)

głebokie

˛

nauczanie (Algorytm Gibbsa-Hastingsa: Igor)

Metoda weryfikacyjna: five-fold technique (uczymy sie˛ na podstawie zbioru

uczacego

˛

czegoś o danych, i sprawdzamy czy nauczyliśmy sie˛ dobrze

weryfikujac

˛ wnioski na zbiorze testujacym).

˛

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

6 / 34

Motywacja

Estymacja rozkładu

Podstawowe hasła które sie˛ pojawia˛

histogram

estymacja jadrowa

˛

(kernel estimation)

kernel width

metoda najwiekszej

˛

wiarygodności

gaussian mixture models

EM (expectation maximization)

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

7 / 34

Teoria Informacji

Wyprowadzenie entropii

Wyprowadzenie Entropii I: entropia Shannona

Shannon: lata 50 poprzedniego wieku.

[T. Cover „Elements of Information Theory”]

Mamy alfabet źródłowy S (o mocy m) i alfabet kodowy A = {0, 1}. Chcemy

przesłać tekst napisany w alfabecie źródłowym, ale nasz kanał informacyjny

pozwala na przesyłanie tylko A. Czyli chcemy każdy element z S wyrazić za

pomoca˛ słów z A∗ (niepuste słowa o skończonej długości).

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

8 / 34

Teoria Informacji

Wyprowadzenie entropii

Wyprowadzenie Entropii I: entropia Shannona

Shannon: lata 50 poprzedniego wieku.

[T. Cover „Elements of Information Theory”]

Mamy alfabet źródłowy S (o mocy m) i alfabet kodowy A = {0, 1}. Chcemy

przesłać tekst napisany w alfabecie źródłowym, ale nasz kanał informacyjny

pozwala na przesyłanie tylko A. Czyli chcemy każdy element z S wyrazić za

pomoca˛ słów z A∗ (niepuste słowa o skończonej długości).

Definicja

Przez funkcje˛ kodujac

˛ a˛ (kodowanie) rozumiem dowolna˛ funkcje˛ ϕ : S → A∗ .

Kodowanie nazywamy nieosobliwym jeżeli jest iniektywne, to znaczy jeżeli

dwa różne elementy kodowane sa˛ różnymi kodami (słowamu). Jeżeli mamy

wiele, to wtedy oddzielamy znakiem specjalnym (zazwyczaj przecinkiem,

spacja˛ badź

˛ średnikiem). Ale to nie jest wygodne, bo musimy używać

dodatkowego symbolu.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

8 / 34

Teoria Informacji

Wyprowadzenie entropii

Definicja

Rozszerzenie kodu to odwzorowanie ϕ : S ∗ → A∗ dane wzorem

ϕ(s1 s2 . . . sk ) := ϕ(s1 )ϕ(s2 ) . . . ϕ(sk ).

Kodowanie (kod) jest jednoznacznie dekodowalne jeżeli jego rozszerzenie

jest nieosobliwe. Innymi słowy, kodowanie jest nieosobliwe, jeżeli majac

˛ słowo

w = w1 w2 . . . wK (gdzie wi to słowa kodowe) możemy jednoznacznie

odzyskać jego rozkład na w1 ; w2 ; . . . ; wk (przykład: kody prefiksowe).

Pytanie, jeżeli mamy dany alfabet, i chcemy zrealizować kod o zadanej

długości - kiedy nam sie˛ uda?

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

9 / 34

Teoria Informacji

Wyprowadzenie entropii

Definicja

Rozszerzenie kodu to odwzorowanie ϕ : S ∗ → A∗ dane wzorem

ϕ(s1 s2 . . . sk ) := ϕ(s1 )ϕ(s2 ) . . . ϕ(sk ).

Kodowanie (kod) jest jednoznacznie dekodowalne jeżeli jego rozszerzenie

jest nieosobliwe. Innymi słowy, kodowanie jest nieosobliwe, jeżeli majac

˛ słowo

w = w1 w2 . . . wK (gdzie wi to słowa kodowe) możemy jednoznacznie

odzyskać jego rozkład na w1 ; w2 ; . . . ; wk (przykład: kody prefiksowe).

Pytanie, jeżeli mamy dany alfabet, i chcemy zrealizować kod o zadanej

długości - kiedy nam sie˛ uda?

Twierdzenie (Nierówność Krafta)

Alfabet źródłowy S o m elementach, da sie˛ zakodować jednoznacznie

dekodowalnie za pomoca˛ słów zbudowanych z A = {0, 1} o długościach

l1 , . . . , lm wtw. gdy

m

X

2−li ≤ 1.

i=1

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

9 / 34

Teoria Informacji

Wyprowadzenie entropii

Wartość oczekiwana długości słowa – definicja

entropii

Załóżmy, że mamy rozkład prawdopodobieństwa na S = {s1 , . . . , sm }, czyli

litera si pojawia sie˛ z prawdopodobieństwem pi = p(si ) (zakładamy

dodatkowo, że źródło ma brak pamieci,

˛ to znaczy, że to co pojawi sie˛

nastepne

˛

nie zależy od tego co pojawiło sie˛ poprzednio).

Chcemy kodować zużywajac

˛ statystycznie/średnio minimalna˛ ilość pamieci.

˛

Załóżmy, że mamy dany alfabet kodujacy

˛ A i iniektywna˛ funkcje˛ kodujac

˛ a˛

ϕ : S → A∗ (przyjmujemy li to długość słowa ϕ(si )).

Wartość średnia (oczekiwana) długości słowa kodujacego

˛

jest oczywiście

dana wzorem

X

L :=

p i li .

i

Pytanie jak dobrać wartości li by minimalizować wartość oczekiwana˛ ilości

pamieci.

˛

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

10 / 34

Teoria Informacji

Wyprowadzenie entropii

Ponieważ na podstawie nierówności Krafta wiemy jakie długości sa˛

dopuszczalne, dostajemy problem minimalizacji

X

L(l1 , . . . , ln ) :=

p i li

i

przy warunku

X

2−li ≤ 1.

i

Zapominamy o tym, że sa˛ całkowite (dostaniemy przybliżenie), i wtedy

możemy zwiekszyć

˛

L zakładajac

˛ równość. Otrzymaliśmy wiec

˛ nastepuj

˛ acy

˛

problem:

Problem (Problem optymizacyjny)

Znaleźć minimum

L(r1 , . . . , rn ) :=

X

p i ri

i

przy warunku

P

i

2−ri = 1.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

11 / 34

Teoria Informacji

Wyprowadzenie entropii

Dowód.

Rozwiazanie:

˛

wykorzystamy metode˛ mnożników Lagrange’a:

X

X

J(r1 , . . . , rn ; λ) =

pi ri + λ(

2−ri − 1).

i

i

Różniczkujac

˛ dostajemy

∂J

= pi − λ2−ri ln 2,

∂ri

i przyrównujac

˛ do zera dostajemy

2−ri = pi /(λ ln 2).

Podstawiajac

˛ do warunku na λ, dostajemy λ = 1/ ln 2, czyli

pi = 2−ri ,

dajac

˛ optymalne kody dla r̄i = − log2 pi i wartość oczekiwana˛ długości słowa

kodujacego

˛

X

X

pi r̄i = −

pi log2 pi .

i

Wojciech Czarnecki, Jacek Tabor (GMUM)

i

Entropia w klasyfikacji

Kraków 2014

12 / 34

Teoria Informacji

Wyprowadzenie entropii

Definicja Entropii Shannona

Definicja (Definicja Entropii Shannona)

W konsekwencji dostajemy definicje˛ entropii dla ciagu

˛ prawdopodobieństw

(pi )

X

H((pi )i ) :=

−pi log2 pi .

i

Rysunek: Entropia dla p, 1 − p.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

13 / 34

Teoria Informacji

Własności klasycznej entropii

Zdarzenia warunkowe

Niech K oznacza zbiór indeksów. Załóżmy, że źródło wysyła litery

S = (sk )k ∈K z prawdopodobieństwami (pk )k ∈K .

Dla podzbioru L ⊂ K rozpatrujemy zdarzenie polegajace

˛ na tym, że wiemy, że

zaszło zdarzenie SL odpowiadajacemu

˛

któremuś z indeksów z L (czyli

wylosowaliśmy która˛ z liter (sl )l∈L ).

Prawdopodobieństwo tego, że wylosowaliśmy

któraś

˛ z literek o indeksie l ∈ L

P

(zaszło L) to oczywiście p(L) = l∈L pl .

Prawdopodobieństwo wylosowania literki l (o ile wiemy, że zaszło L –

prawdopodobieństwo warunkowe) wynosi pl /p(L).

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

14 / 34

Teoria Informacji

Własności klasycznej entropii

Zdarzenia warunkowe

Niech K oznacza zbiór indeksów. Załóżmy, że źródło wysyła litery

S = (sk )k ∈K z prawdopodobieństwami (pk )k ∈K .

Dla podzbioru L ⊂ K rozpatrujemy zdarzenie polegajace

˛ na tym, że wiemy, że

zaszło zdarzenie SL odpowiadajacemu

˛

któremuś z indeksów z L (czyli

wylosowaliśmy która˛ z liter (sl )l∈L ).

Prawdopodobieństwo tego, że wylosowaliśmy

któraś

˛ z literek o indeksie l ∈ L

P

(zaszło L) to oczywiście p(L) = l∈L pl .

Prawdopodobieństwo wylosowania literki l (o ile wiemy, że zaszło L –

prawdopodobieństwo warunkowe) wynosi pl /p(L).

W konsekwencji, średnia długość kodu przypadajac

˛ a˛ na kodowanie którejś z

liter o indeksie z L wynosi

H(SL ) :=

X

l∈L

Wojciech Czarnecki, Jacek Tabor (GMUM)

−

pl

log2 pl .

p(L)

Entropia w klasyfikacji

Kraków 2014

14 / 34

Teoria Informacji

Własności klasycznej entropii

Uśrednianie informacji

Przypominam: Ś REDNIA ARYTMETYCZNA . p1 procent pracowników załogi

zarabia r1 , ... , pk procent zarabia zarabia rk . Średnie zarobki r

wynosza˛

r = p1 r1 + . . . + pk rk .

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

15 / 34

Teoria Informacji

Własności klasycznej entropii

Uśrednianie informacji

Przypominam: Ś REDNIA ARYTMETYCZNA . p1 procent pracowników załogi

zarabia r1 , ... , pk procent zarabia zarabia rk . Średnie zarobki r

wynosza˛

r = p1 r1 + . . . + pk rk .

Jeżeli mamy rozbicie K na sume˛ rozłaczn

˛ a˛ zdarzeń L1 , . . . , Lk , to możemy

rozpatrzyć średnia˛ długość kodu H(SLi ) użyta˛ do kodowania przy zdarzeniu

Li . Widać, że całkowita ilość informacji (długość kodu) H(S) jest średnia˛

arytmetyczna˛ ilości informacji niesionej przez poszczególne zdarzenia:

H(S) = p(L1 ) · H(SL1 ) + . . . + p(Lk ) · H(SLk ).

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

15 / 34

Teoria Informacji

Własności klasycznej entropii

Informacja niesiona przez zdarzenia niezależne

Zajmijmy sie˛ teraz iloczynem kartezjańskim dwóch rozkładów. Majac

˛ rozkłady

p = (p1 , . . . , pn ) (odpowiada zdarzeniu P) i q = (q1 , . . . , qk ) (odpowiada

zdarzeniu Q), rozkład prawdopodobieństwa zdarzenia (P, Q) (przy założeniu

niezależności tych zdarzeń) jest dany wzorem

(pi · qj )i,j .

Oznaczam ten rozkład wzorem P ∗ Q

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

16 / 34

Teoria Informacji

Własności klasycznej entropii

Informacja niesiona przez zdarzenia niezależne

Zajmijmy sie˛ teraz iloczynem kartezjańskim dwóch rozkładów. Majac

˛ rozkłady

p = (p1 , . . . , pn ) (odpowiada zdarzeniu P) i q = (q1 , . . . , qk ) (odpowiada

zdarzeniu Q), rozkład prawdopodobieństwa zdarzenia (P, Q) (przy założeniu

niezależności tych zdarzeń) jest dany wzorem

(pi · qj )i,j .

Oznaczam ten rozkład wzorem P ∗ Q

Okazuje sie,

˛ że informacja wnoszona przez przypadek gdy zaszła para

zdarzeń (przy założeniu ich niezależności), jest równa sumie informacji

wnoszonej przez każde z tych zdarzeń z osobna:

H(P ∗ Q) = H(P) + H(Q).

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

16 / 34

Teoria Informacji

Średnie

Sposób uśredniania informacji

Ś REDNIA ARYTMETYCZNA . p1 procent załogi zarabia r1 , ... , pk procent

zarabia rk . Średnie zarobki r wynosza˛

r = p1 r1 + . . . + pk rk .

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

17 / 34

Teoria Informacji

Średnie

Sposób uśredniania informacji

Ś REDNIA ARYTMETYCZNA . p1 procent załogi zarabia r1 , ... , pk procent

zarabia rk . Średnie zarobki r wynosza˛

r = p1 r1 + . . . + pk rk .

Ś REDNIA HARMONICZNA . p1 procent drogi jedziemy z predkości

˛

a˛ r1 , ... , pk z

rk . Wtedy średnia predkość

˛

r na trasie wynosi

r = 1/(p1 /r1 + . . . + pk /rk ).

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

17 / 34

Teoria Informacji

Średnie

Sposób uśredniania informacji

Ś REDNIA ARYTMETYCZNA . p1 procent załogi zarabia r1 , ... , pk procent

zarabia rk . Średnie zarobki r wynosza˛

r = p1 r1 + . . . + pk rk .

Ś REDNIA HARMONICZNA . p1 procent drogi jedziemy z predkości

˛

a˛ r1 , ... , pk z

rk . Wtedy średnia predkość

˛

r na trasie wynosi

r = 1/(p1 /r1 + . . . + pk /rk ).

Ś REDNIA POT EGOWA

˛

RZ EDU

˛

3. Mamy p1 procent kuleczek z plasteliny o

promieniu r1 , ... , pk procent kuleczek o promieniu rk . Zlepiamy te kulki razem

i lepimy taka˛ sama˛ sumaryczna˛ ilość kuleczek, ale o jednakowym promieniu

r . Wtedy

r = (p1 r13 + . . . + pk rk3 )1/3 .

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

17 / 34

Teoria Informacji

Średnie

Bardziej abstrakcyjne spojrzenie

Wszystkie powyższe średnie można uzyskać biorac

˛ funkcje˛ g i

rozpatrujac

˛

g −1 (p1 g(r1 ) + . . . + pk g(rk )).

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

18 / 34

Teoria Informacji

Średnie

Bardziej abstrakcyjne spojrzenie

Wszystkie powyższe średnie można uzyskać biorac

˛ funkcje˛ g i

rozpatrujac

˛

g −1 (p1 g(r1 ) + . . . + pk g(rk )).

A RYTMETYCZNE : g(r ) = r

H ARMONICZNA : g(r ) = 1/r

P OT EGOWA

˛

RZ EDU

˛

3: g(r ) = r 3

W pewnym sensie jest to jedyna „naturalna” metoda generowania

średnich.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

18 / 34

Teoria Informacji

Entropia Renyi’ego

Wyprowadzenie Entropii Renyi’ego

Szukamy teraz takich średnich g i funkcji entropii HR by zachodziły dwa

warunki.

1. Informacja niesiona przez całe zdarzenie jest równa średniej informacji

niesionej przez poszczególne zdarzenia:

HR (S) = g −1 p(L1 ) · g(HR (SL1 )) + . . . + p(Lk ) · g(HR (SLk )) .

2. Informacja niesiona przez pare˛ zdarzeń niezależnych jest suma˛ informacji

niesionych przez każde z tych zdarzeń:

HR (P ∗ Q) = HR (P) + HR (Q).

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

19 / 34

Teoria Informacji

Entropia Renyi’ego

Definicja Entropii Renyi’ego

Renyi pokazał, że jedyne rozwiazanie

˛

powyższego (modulo transformacje

afiniczne które nie zmieniaja˛ wartości średniej) jest dane przez

gα (x) =

2(α−1)x − 1

dla α 6= 1,

(α − 1) ln 2

g1 (x) = x.

RYSUNEK.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

20 / 34

Teoria Informacji

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia Renyi’ego

Entropia w klasyfikacji

Kraków 2014

21 / 34

Teoria Informacji

Entropia Renyi’ego

W konsekwencji w naturalny sposób otrzymujemy:

Definicja (Entropia Renyi’ego rz˛edu α)

Dla α 6= 1 kładziemy

Hα (p1 , . . . , pk ) =

X

1

log(

piα ).

1−α

i

Dla α = 1 kładziemy

Hα (p1 , . . . , pk ) =

X

−pi log(pi ).

i

Łatwo pokazać, że Hα (P) → H1 (P) = H(P) przy α → 1.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

22 / 34

Teoria Informacji

Entropia Renyi’ego

Przykład zastosowania

Drzewa decyzyjne.

[T. Maszczyk, W. Duch „Comparison of Shannon, Renyi and Tsallis Entropy

used in Decision Trees”, Artificial Intelligence and Soft Computing–ICAISC

2008, Springer]

Porównania stosowania różnych entropii w drzewach decyzyjnych. Okazuje

sie,

˛ że przydaja˛ sie˛ różne (cytat skrócony):

For the Colon dataset peak accuracy is achieved for Renyi entropy with α = 2, with

specificity (accuracy of the second class) significantly higher than for the Shannon

case, and with smaller variance. For DLBCL Renyi entropy with α in the range

1.1 − 1.3 give the best results, improving both specificity and sensitivity of the

Shannon measure. For the Leukemia data best Renyi result for α = −0.1, around

88.5 ± 2.4 is significantly better than Shannon’s 81.4 ± 4.1.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

23 / 34

Teoria Informacji

Entropia Renyi’ego

Entropia różniczkowa

Przechodzac

˛ w definicji entropii, analogicznie jak w całce Riemanna, do

granicy, otrzymujemy pojecie

˛

entropii różniczkowej dla rozkładu

prawdopodobieństwa o gestości

˛

f (x).

Definicja (Entropia różniczkowa Renyi’ego rz˛edu α)

Dla α 6= 1 kładziemy

Hα (f ) =

1

log(

1−α

Z

f (x)α dx).

Dla α = 1 kładziemy

Z

Hα (f ) =

Wojciech Czarnecki, Jacek Tabor (GMUM)

−f (x) log(f (x))dx.

Entropia w klasyfikacji

Kraków 2014

24 / 34

Statystyka

Rozkład normalny

Zaczynamy statystyk˛e

Główny rozkład w statystyce to rozkład normalny N(m, σ 2 ), gdzie m to

wartość średnia, a σ 2 wariancja. Gestość:

˛

N(m, σ 2 ) = √

Wojciech Czarnecki, Jacek Tabor (GMUM)

1

2πσ

exp(−

Entropia w klasyfikacji

(x − m)2

).

2σ 2

Kraków 2014

25 / 34

Statystyka

Rozkład normalny

Entropia dla rozkładu normalnego

Entropia Renyi’ego rozkładu normalnego:

Z

1

1

(x − m)2 2

Hα (N(m, σ )) =

log

) .

exp(−

1−α

(2πσ 2 )α

2σ 2 /α

Cz˛esty trik polega na wykorzystaniu tego, że rozkład normalny całkuje sie˛ do

jedynki.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

26 / 34

Statystyka

Rozkład normalny

Entropia dla rozkładu normalnego

Entropia Renyi’ego rozkładu normalnego:

Z

1

1

(x − m)2 2

Hα (N(m, σ )) =

log

) .

exp(−

1−α

(2πσ 2 )α

2σ 2 /α

Cz˛esty trik polega na wykorzystaniu tego, że rozkład normalny całkuje sie˛ do

jedynki.

PRZEPROWADZIĆ WYPROWADZENIE NA TABLICY.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

26 / 34

Statystyka

Metoda najwiekszej

˛

wiarygodności

Maximum likelihood estimation (MLE)

Zakładamy, że mamy dwa rozkłady f i g, i mamy zbiór danych

X = (x1 , . . . , xn ). Pytamy sie,

˛ jak sprawdzić który z tych rozkładów bardziej

„pasuje” do naszego zbioru danych?

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

27 / 34

Statystyka

Metoda najwiekszej

˛

wiarygodności

Maximum likelihood estimation (MLE)

Zakładamy, że mamy dwa rozkłady f i g, i mamy zbiór danych

X = (x1 , . . . , xn ). Pytamy sie,

˛ jak sprawdzić który z tych rozkładów bardziej

„pasuje” do naszego zbioru danych?

Idea jest bardzo prosta: wybieramy ten rozkład któremu „łatwiej” byłoby

wylosować nasze dane. W tym celu porównujemy

f (x1 ) · . . . · f (xn ) oraz g(x1 ) · . . . · g(xn ).

Zwyczajowo aby pozbyć sie˛ iloczynu, logarytmujemy:

log f (x1 ) + . . . + log f (xn ) oraz log g(x1 ) + . . . + log g(xn ).

I wybieramy ten rozkład, który ma wieksz

˛

a˛ wartość. Na tej idei oparte jest w

szczególności EM (expectation maximization).

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

27 / 34

Statystyka

Metoda najwiekszej

˛

wiarygodności

MLE: podejście teorio-informatyczne

Zakładamy, że mamy dwa rozkłady f i g, i mamy zbiór danych

X = (x1 , . . . , xn ). Pytamy sie,

˛ jak sprawdzić który z tych rozkładów bardziej

„pasuje” do naszego zbioru danych?

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

28 / 34

Statystyka

Metoda najwiekszej

˛

wiarygodności

MLE: podejście teorio-informatyczne

Zakładamy, że mamy dwa rozkłady f i g, i mamy zbiór danych

X = (x1 , . . . , xn ). Pytamy sie,

˛ jak sprawdzić który z tych rozkładów bardziej

„pasuje” do naszego zbioru danych?

Idea jest bardzo prosta: wybieramy ten rozkład któremu „łatwiej” byłoby

skompresować nasze dane.

Pamietamy

˛

z wyprowadzenia entropii, że optymalna długość kodu przy

kodowaniu punktu x to − log f (x). W konsekwencji porównujemy

− log f (x1 ) − . . . − log f (xn ) oraz − log g(x1 ) − . . . − log g(xn ).

I wybieramy ten rozkład, dla którego powyższa wartość jest mniejsza. Na tej

zasadzie jest na przykład zbudowany CEC.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

28 / 34

Statystyka

Estymacja jadrowa

˛

Estymacja jadrowa

˛

[B. Silverman: Density Estimation for Statistics]

Mamy zbiór danych X ⊂ R. I teraz nie chcemy wybrać z jakiegoś z góry

wybranego zbioru rozkładów (nie mamy pewności/zaufania, czy akurat tego

typu rozkład tam sie˛ bedzie

˛

znajdował).

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

29 / 34

Statystyka

Estymacja jadrowa

˛

Estymacja jadrowa

˛

[B. Silverman: Density Estimation for Statistics]

Mamy zbiór danych X ⊂ R. I teraz nie chcemy wybrać z jakiegoś z góry

wybranego zbioru rozkładów (nie mamy pewności/zaufania, czy akurat tego

typu rozkład tam sie˛ bedzie

˛

znajdował).

Pomysł estymacji jadrowej

˛

jest bardzo prosty, zastepujemy

˛

każdy punkt xi z

X = (x1 , . . . , xn ) „waskim”

˛

rozkładem normalnym wycentrowanym w punkcie

xi

N(xi , σ 2 )

i uśredniamy/sumujemy po wszystkich punktach z X :

n

1 X

N(xi , σ 2 ).

|X |

i=1

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

29 / 34

Statystyka

Estymacja jadrowa

˛

Estymacja jadrowa

˛

[B. Silverman: Density Estimation for Statistics]

Mamy zbiór danych X ⊂ R. I teraz nie chcemy wybrać z jakiegoś z góry

wybranego zbioru rozkładów (nie mamy pewności/zaufania, czy akurat tego

typu rozkład tam sie˛ bedzie

˛

znajdował).

Pomysł estymacji jadrowej

˛

jest bardzo prosty, zastepujemy

˛

każdy punkt xi z

X = (x1 , . . . , xn ) „waskim”

˛

rozkładem normalnym wycentrowanym w punkcie

xi

N(xi , σ 2 )

i uśredniamy/sumujemy po wszystkich punktach z X :

n

1 X

N(xi , σ 2 ).

|X |

i=1

Pomysł okazuje sie˛ być bardzo fajny, tylko powstaje naturalne pytanie jak

dobrać „window width” σ? MATHEMATICA.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

29 / 34

Statystyka

Estymacja jadrowa

˛

Wzór Silvermana

Wzór Silvermana dla estymacji jadrowej

˛

dla grupy danych

X = (x1 , . . . , xn ) ⊂ R:

σopt = (4/3)1/5 n−1/5 σX .

Wzór powyższy jest optymalny w sytuacji gdy dane pochodza˛ z rozkładu

normalnego. Ogólnie optymalna może być inna szerokość jadra,

˛

ale

zazwyczaj okazuje sie,

˛ że dla danych realnych (które moga˛ być wiecej

˛

niż

jedno-modalne – PRZYKŁAD), wartość ta bedzie

˛

mniejsza niż wskazuje wzór

Silvermana.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

30 / 34

Statystyka

Estymacja jadrowa

˛

Klatwa

˛

wymiarowości

Okazuje sie,

˛ że to samo można robić w wielu wymiarach. I jest to realne do

wykonania w R2 , R3 . W wyższych wymiarach działa klatwa

˛

wymiarowości,

która (upraszczajac)

˛ mówi, że wszystkie punkty w zbiorze sa˛ maksymalnie

odległe jak to możliwe.

Precyzyjniej, jak mamy wylosowane punkty losowe z kostki [0, 1]D , to dla

dużych D odległość miedzy

˛

tymi punktami jest bliska maksymalnej

dopuszczalnej odległości.

W konsekwencji najbardziej wiarygodne jest dokonywanie estymacji gestości

˛

w sytuacjach nisko-wymiarowych.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

31 / 34

Statystyka

Wojciech Czarnecki, Jacek Tabor (GMUM)

Estymacja jadrowa

˛

Entropia w klasyfikacji

Kraków 2014

32 / 34

Statystyka

Cauchy-Schwarz Divergence

Cauchy-Schwarz Divergence

Pojecie

˛

zbliżone do dywergencji Kullbacka-Leiblera, ale dla entropii

Renyi’ego. Mierzy na ile dwa rozkłady sa˛ sobie bliskie.

Definicja:

Z

DCS (f , g) := log

f 2 + log

Z

g 2 − 2 log fg ∈ [0, ∞].

Jeżeli 0, to f = g.

Chcemy zmaksymalizować. Zanalizujmy poszczególne czynniki:

R

kiedy sie˛ maksymalizuje f 2 : jak f jest możliwie skupione,

R

kiedy sie˛ minimalizuje fg: jak f i g sa˛ prostopadłe (maja˛ rozłaczne

˛

supporty).

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

33 / 34

Główny cel

CEL

Co chcemy zrobić:

Mamy dane X , Y ⊂ RD . Szukamy takiej prostej (rozpietej

˛ na v ∈ S), aby po

zrzutowaniu danych na nia˛ dywergencja Cauchy’ego-Schwarza (po estymacji

jadrowej)

˛

DCS ([Xv ], [Yv ]).

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

34 / 34

Główny cel

CEL

Co chcemy zrobić:

Mamy dane X , Y ⊂ RD . Szukamy takiej prostej (rozpietej

˛ na v ∈ S), aby po

zrzutowaniu danych na nia˛ dywergencja Cauchy’ego-Schwarza (po estymacji

jadrowej)

˛

DCS ([Xv ], [Yv ]).

Po co:

Mamy nadzieje,

˛ że bedzie

˛

dawało dobre efekty klasyfikacyjne,

wizualizacyjne.

Wojciech Czarnecki, Jacek Tabor (GMUM)

Entropia w klasyfikacji

Kraków 2014

34 / 34