Wojciech Międlar

Topologie sieci komputerowych - część 1

1

Topologie sieci komputerowych

Wojciech Międlar - student trzeciego roku Informatyki i Ekonometrii (trybu zaocznego)

w Wyższej Szkole Informatyki i Zarządzania z siedzibą w Rzeszowie.

Wprowadzenie ...

Dynamiczny postęp w dziedzinie informatyki, jaki można zaobserwować od kilkunastu lat sprawił, że

normą stało się łączenie komputerów znajdujących się np. w jednym pomieszczeniu w złożoną

strukturę czyli w sieć komputerową. Dzięki takiemu zabiegowi użytkownicy poszczególnych

komputerów mają dostęp do nowych, do tej pory niedostępnych możliwości. Mogą udostępniać

zasoby swoich dysków, korzystać wspólnie z urządzeń zewnętrznych takich jak drukarka czy ploter

lub mieć dostęp do wspólnych baz danych. Ideą, dla której powstała pierwsza sieć komputerowa było

przesyłanie i współdzielenie informacji.

Praca sieci polega na dzieleniu takiej informacji na tzw. pakiety (bloki) a następnie na przesłaniu tak

spreparowanej informacji pomiędzy nadawcą a odbiorcą. Informacje od nadawcy do adresata mogą

wędrować różnymi drogami i w różnej kolejności. Wybór trasy wędrówki pakietu od nadawcy do

adresata uzależniony jest od rodzaju użytego protokołu, czyli zbioru formalnych zasad przesyłania

informacji (danych) w sieci komputerowej. W oparciu o użyty protokół urządzenia sieciowe analizują

informacje, sterują transmisją, badają jej poprawność po to by w końcu ustalić algorytm realizacji

drogi przesyłu.

W każdej sieci komputerowej pracują terminale, stacje robocze lub serwery, będące urządzeniami

wymieniającymi informacje. Rodzaj urządzeń włączonych do sieci odpowiadać musi jej przeznaczeniu.

Istotną rolę odgrywa tu również obszar, jaki swoim zasięgiem działania pokrywa sieć. Dlatego istnieje

podział sieci wg. tego kryterium.

Sieci lokalne (LAN) – połączone komputery mogą przesyłać między sobą informacje z dużą

prędkością. Medium transmisyjne w tego typu sieciach zapewnia poprawną komunikację komputerów,

które mogą znajdować się maksymalnie kilka kilometrów od siebie. Medium transmisyjnym w takich

sieciach jest najczęściej kabel typu Ethernet lub światłowód. Skrót pochodzi od anglojęzycznego Local

Area Network. Średnica tych sieci zawiera się w przedziale od kilku metrów do kilku kilometrów.

Najczęściej pracują one z szybkością 10 Mbps[1] 1. Sieci LAN zakładane obecnie niejednokrotnie mają

znaczne rozmiary i z tego względu klasyfikowane są jako sieci kampusowe.

Sieci metropolitalne (MAN) – są to większe sieci LAN. Swoim zasięgiem obejmują większy obszar

geograficzny i mają większą przepustowość niż sieci LAN. Waha się ona on kilku kbps do kilku Gbps.

Średnica tych sieci może mieć od kilku do kilkuset kilometrów. Zadaniem tych sieci jest łączenie ze

sobą sieci lokalnych.

Sieci rozległe (WAN) – buduje się wszędzie tam gdzie istnieje potrzeba poprawnego przesyłu

danych bez względu na odległość dzielącą nadawcę z odbiorcą informacji.

Każdy wynalazek obarczony może być pewnymi błędami, które można usunąć ale dopiero w procesie

jego eksploatacji. Podobnie było i jest z sieciami komputerowymi. We wczesnym okresie rozwoju sieci

pojawił się problem połączenia sprzętu różnych producentów i komputerów o mniejszych i większych

mocach obliczeniowych. To wymusiło sytuację w której zrodziła się potrzeba utworzenia standardów

dotyczących infrastruktury połączeń. Nadzór nad tym standardem objęła Międzynarodowa Organizacja

Normalizacyjna (ISO – International Organization for Standarization). Powstał model sieci otwartych

(Open System Interconnection). Od momentu wprowadzenia tego standardu wszystkie nowe

technologie sieciowe są tak projektowane by były w pełni z nim zgodne. Model OSI składa się z 7

warstw, z których każda pełni ściśle określone funkcje i dzieli procesy zachodzące podczas sesji

komunikacyjnej na siedem funkcjonalnych warstw. Warstwy te zorganizowane są według naturalnej

sekwencji zdarzeń zachodzących podczas sesji komunikacyjnej. Jednym z celów stawianych sieciom

komputerowym jest łączenie istniejących systemów. Dzięki temu można korzystać z mocy

obliczeniowej wielu stosunkowo tanich maszyn zamiast kupowania jednego drogiego superkomputera.

W ten sposób można łączyć ze sobą mikroprocesory mniejszych stacji w celu zastąpienia pracy

dużego komputera. Poza tym jedna aplikacja może być dostępna dla wielu użytkowników. Jest to

szczególnie pomocne przy pracy nad dużymi projektami, podczas której współpracownicy korzystają

ze wspólnych plików, dysków, drukarek i innych urządzeń zainstalowanych w sieci. Poza

przetwarzaniem rozproszonym sieć buduje się np. wtedy gdy zachodzi potrzeba korzystania z jednej

1

Szybkość transmisji wyrażana jest w jednostkach bps. 1 bps=1 bit na sekundę (ang. bit per second)

Wojciech Międlar

Topologie sieci komputerowych - część 1

2

bazy, która na bieżąco aktualizowana jest przez wielu użytkowników. Systemy takie spotkać można

każdego dnia między innymi w szpitalach i bankach.

Geneza i rozwój sieci komputerowych

Czym jest sieć komputerowa ?

Sieć jest zespołem urządzeń transmisyjnych takich jak karta sieciowa, koncentrator czy mostek, które

połączone są ze sobą medium transmisyjnym czyli kablem, światłowodem, łączem na podczerwień

(IrDA) lub radiowo i pracują pod kontrolą odpowiedniego oprogramowania tzw. sieciowego systemu

operacyjnego. Zadaniem sieci jest przesyłanie i wymiana danych przy użyciu odpowiedniego protokołu

transmisyjnego np.: TCP/IP lub IPX, pomiędzy poszczególnymi stacjami roboczymi, czyli komputerami

które tworzą sieć. Początki sieci sięgają jeszcze lat 70 XX wieku gdy powstała pierwsza sieć o nazwie

AlochaNET. Idea przyświecająca jej powstaniu sprowadzała się do transmisji informacji które miały

postać ramek. Nadawca wysyłał ramkę a następnie czekał na potwierdzenie odebrania owej ramki od

odbiorcy. Po jej otrzymaniu cała procedura zaczynała się od nowa. Niestety ze względu na dużą liczbę

kolizji (każde z urządzeń mogło wysłać wiadomość w tym samym czasie) sieć ta była bardzo wolna i

właśnie z powodu kolizji nie nadawała się do zaawansowanych zastosowań. Przełomowym momentem

w procesie powstawania standardu sieci było opracowanie przez Roberta Metcalfe’a i Davida Boggs'a

sieci Ethernet. Oparta była ona na kablu koncentrycznym. Kolejnym etapem było przedstawienie tego

pomysłu na "National Computer Conference" która miała miejsce w 1976 roku. Specyfikacja w sensie

formalnym została opracowana i opublikowana dopiero w roku 1980 przez firmę Xerox, ale podstawy

standardu tworzyło równolegle trzech potentatów ówczesnego rynku, tzn. firmy: IBM, Xerox oraz

Intel. W 1985 sieć Ethernet została zaakceptowana przez "Institute of Electrical and Electronics

Engineers", ustanawiając normę IEEE 802.3. Od tego czasu popularność sieci Ethernet (dzięki

szerokiemu zastosowaniu jej w przemyśle) bardzo wzrosła uzyskując dzisiejszą rangę. Można nawet

pokusić się o twierdzenie. że wniosła ona istotny wkład w postęp oraz dzisiejszy standard życia.

Omawiając temat topologii sieci należy przytoczyć kilka istotnych dat z życia sieci.

Historia sieci

Lata 60-te

Izolowane systemy komputerowe.

1969

ARPANET - Advanced Research Project Agency Network

1978

UUCP - UNIX to UNIX copy.

1979

USENET - Users Network.

1981

CSNET - Computer Science Network.

1981

BITNET - Because It's Time Network

1983

FidoNet.

1983

Internet (TCP/IP)

1984

NSFNET - National Science Foundation Network.

1987

OSI - Open System Interconnection.

1988

GOSIP - Government OSI Profile.

Początkowo każdy z komputerów pracował jako autonomiczna, odrębna jednostka. Przenoszenie

danych pomiędzy komputerami odbywało się za pomocą magnetycznych nośników danych takich jak

dyskietki czy taśmy. Do pewnego stopnia było to wykonalne. Problem zaczynał się w momencie

natychmiastowej potrzeby przesłania ważnych danych do innego komputera oddalonego o np.

kilkadziesiąt kilometrów. Właśnie w tym celu połączono kilka komputerów ze sobą

tworząc sieć. Graficznie ewaluowanie sieci przedstawić można tak:

1. Izolowane systemy

2. Pierwsze sieci

komputerowe

3. Sieć globalna

Rys.1 Rozwój sieci

Wojciech Międlar

Topologie sieci komputerowych - część 1

3

Na początku sieci komputerowe funkcjonowały jako oddzielne formy połączeń, które jednocześnie

stanowiły integralną część rozwiązań głównie dla celów obliczeniowych. W skład standardowej

konfiguracji wchodziły terminale, które połączone były sprzętowo z kontrolerami urządzeń. Kontrolery

te umożliwiały wielodostęp do urządzeń komunikacyjnych, a te z kolei pozwalały na przyłączanie

innych urządzeń do sieci głównej. Sercem systemu był tzw. procesor czołowy, który umożliwiał wielu

urządzeniom komunikacyjnym współdzielenie pojedynczego kanału dostępu do sieci. Dlatego

ówczesne programy sieciowe funkcjonowały jedynie w środowisku obsługiwanym przez pojedynczy

system operacyjny, który mógł działać jedynie na urządzeniu jednego producenta. W wyniku takiej

sytuacji terminale użytkowników i urządzenia za pomocą których były one przyłączane do sieci także

musiały stanowić część zintegrowanego rozwiązania konkretnego producenta.

Wówczas zaistniała potrzeba podniesienia wydajności pracy

zintegrowanych w ten sposób rozwiązań systemowych.

Naukowcy z centrum badawczego firmy Xerox w Palo Alto

(Palo Alto Research Center), usprawnili sposób współdzielenia

plików i danych pomiędzy swoimi stacjami roboczymi. Do tej

pory udostępnianie danych realizowane było przy użyciu

dyskietek. Było to czasochłonne i nieporęczne. Rozwiązanie

opracowane w firmie Xerox polegało na utworzeniu pierwszej

tzw. sieci lokalnej LAN (Local Area Network), która otrzymała

nazwę Ethernet. Sieć funkcjonowała w oparciu o protokoły

współdziałania międzysieciowego wyższych warstw. Jej

możliwości rynkowe zostały dość szybko wykorzystane:

pierwotny Ethernet, obecnie znany pod nazwami: Ethernet

Parc lub Ethernet I, został zastąpiony przez jego nieco

udoskonaloną wersję - DIX Ethernet, zwaną również Ethernet

II. Autorzy tego opracowania firma Xerox, Digital oraz Intel

ustaliły wspólnie "standardy" sieciowe, do przestrzegania

których zobowiązały się przy produkcji jej elementów

składowych.

Rys. 2 Sprzętowy dostęp do sieci mainframe[1]

Powszechną konfiguracją stosowaną dawniej było sprzętowe połączenie terminali z kontrolerami

urządzeń. Kontrolery te umożliwiały wielodostęp do urządzeń komunikacyjnych, które z kolei

pozwalały na przyłączenie urządzeń do sieci głównej (mainframe). Wszelkie programy pracowały

jednak tylko w środowisku, które obsługiwał jeden system operacyjny. W konsekwencji terminale

użytkowników oraz urządzenia, dzięki którym były one przyłączane do sieci musiały być częścią

zintegrowanego rozwiązania jednego

producenta. Było to uciążliwe. Wtedy to

nastąpiły dwie ogromne zmiany.

Pierwszą z nich było pojawienie się pierwszych

komputerów klasy PC. Komputer, który do tej

pory zajmował sporych rozmiarów pokój, nagle

z powodzeniem mieścił się na biurku.

Drugą natomiast stanowiło poprawienie

wydajności pracy poprzez usprawnienie

współdzielenia plików między już inteligentnymi

stacjami roboczymi.

Rys. 3 Wczesny szkic sieci Ethernet autorstwa dr Roberta Metcalfe’a.

W zasadzie za początek sieci przyjmuje się pierwsze próby, które uwieńczone zostały stworzeniem

sieci o nazwie Ethernet. Historia Ethernetu zaczęła sie w 1970 roku, kiedy to firma XEROX stworzyła

prototyp sieci komputerowej. Pierwsza sieć będąca podstawą Ethernetu została zaprojektowana w

1976 r przez dr. Robert M. Metcalfe. Została ona zaprezentowana na konferencji National Computer

Conference w czerwcu tego roku.

W 1980 roku firmy Digital Equipment Corporation (DEC), Intel i Xerox zaczęły promocję

jednopasmowej sieci komputerowej na kablu koncentrycznym przy użyciu metody dostępu CSMA/CD i

opublikowały "Blue Book Standard" dla wersji I Ethernetu. Ten standard został rozszerzony w 1985 r

do wersji ETHERNET II.

Wojciech Międlar

Topologie sieci komputerowych - część 1

4

Model referencyjny OSI

W niedługim czasie po pojawieniu się pierwszych sieci nastąpił ich burzliwy rozwój. Wzrastała ilość

komputerów włączanych do sieci oraz odległości pomiędzy nimi. Na rynku pojawiały się nowe firmy

oferujące własne rozwiązania i technologie. Sytuacja ta wymusiła stworzenie pewnego wzorca zgodnie

z którym bez konfliktów

można by było łączyć ze sobą

sprzęt różnych producentów.

Taki standard powstał pod

kontrolą Międzynarodowej

Organizacji Normalizacyjnej

(ISO – International

Organization for

Standarization)

i nosi miano modelu OSI

(Open System

Interconnection). Wszystkie

nowe rozwiązania zmierzają

w kierunku zapewnienia pełnej

zgodności z tym standardem.

Rys. 4 Model referencyjny OSI.

Model OSI składa się z 7 warstw, z których każda pełni ściśle określone funkcje.

Warstwa 1-fizyczna: jej zadaniem jest właściwy dobór elektrycznych parametrów połączenia takich

jak napięcie czy długość fali. W warstwie tej przesyłane są strumienie bitów. Tu

odbierane są ramki danych z warstwy 2, i przesyłane są one szeregowo bit po bicie.

Warstwa ta „widzi” dane jako jedynki i zera.

Warstwa 2-łącza: jej zadaniem jest złożenie informacji w tzw. ramki. W tej warstwie pracują np.

karty sieciowe Ethernet. Odpowiedzialna jest ona za końcową zgodność przesyłanych

danych. Tu składane są strumienie binarne i umieszczane są w ramkach.

Warstwa 3-sieci: odpowiada za określenie trasy pomiędzy nadawcą a odbiorcą. Brak tu

mechanizmów kontroli i korekcji błędów. Posiada własną architekturę trasowania

niezależną od adresowania fizycznego. Jeśli sieć podzielona jest na segmenty przy użyciu

router’a korzystanie z tej warstwy jest obowiązkowe. Protokoły trasowane to: IP, IPX,

AppleTalk..

Warstwa 4-transportowa: jej rola zaczyna się po odebraniu informacji przez komputer docelowy

bądź inne urządzenie sieciowe. Jej zadaniem jest uszeregowanie odebranej informacji w

odpowiedniej kolejności i skierowanie jej do aplikacji która będzie umiała ją obsłużyć.

Warstwa ta potrafi także wykrywać pakiety odrzucone przez router i generować żądanie

ich ponownej transmisji.

Warstwa 5-sesji: przeznaczona jest dla użytkownika i jego procesów. W tej warstwie działają

programy, z których bezpośrednio korzystają użytkownicy.

Jak nazwa wskazuje czuwa ona nad przebiegiem komunikacji podczas połączenia dwóch

komputerów. Warstwa ta określa charakter połączenia: jedno lub dwukierunkowy.

Warstwy: 6-prezentacji: odpowiada za sposób kodowania wszelkich danych i ewentualna translacje

pomiędzy niezgodnymi schematami kodowania.

Warstwa 7-aplikacji: pełni rolę interfejsu pomiędzy dana aplikacja a usługami sieciowymi. Inicjuje

ona sesje komunikacyjne.

Pomimo faktu, że na model OSI składa się 7 warstw, to dana sesja komunikacyjna nie musi wcale

wykorzystywać wszystkich siedmiu. Pionowa orientacja modelu odzwierciedla przebieg procesów i

danych. Każda z warstw posiada interfejsy warstw sąsiednich. Komunikacja możliwa jest wtedy, gdy

komputery przesyłają dane, instrukcje, adresy etc. Między odpowiednimi warstwami.

Topologia typu gwiazda

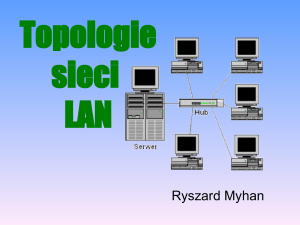

Połączenie sieci LAN o topologii gwiazdy z przyłączonymi do niej urządzeniami rozchodzą się z

jednego, wspólnego punktu, którym jest serwer lub koncentrator. Każde urządzenie przyłączone do

sieci w topologii gwiazdy może uzyskiwać bezpośredni i niezależny od innych urządzeń dostęp do

nośnika. W tym celu urządzenia te muszą współdzielić dostępne szerokości pasma koncentratora.

Sposób połączenia przedstawia poniższy rysunek.

Wojciech Międlar

Topologie sieci komputerowych - część 1

5

Istnieją dwa rodzaje topologii typu gwiazda:

aktywne (sygnał w koncentratorze jest regenerowany lub wzmacniany)

bierne (cały transfer w sieci przechodzi poprzez hub, z którego sygnał może być nadawany do

kilku lub do wszystkich węzłów.

Topologie gwiazdy stały się dominującym we współczesnych sieciach LAN rodzajem topologii. Są one

elastyczne, skalowalne i stosunkowo tanie w porównaniu z bardziej skomplikowanymi sieciami LAN o

ściśle regulowanych metodach dostępu. Główną zaletą topologii gwiazdy jest to, że sieć może działać

nawet, gdy jeden lub kilka komputerów ulegnie awarii. Ponieważ każdy komputer jest połączony tylko

z koncentratorem, w wypadku awarii tego komputera dane mogą być przesyłane przez koncentrator

pomiędzy pozostałymi komputerami. Podstawową wadą tego rozwiązania jest to, że w wypadku awarii

centralnego koncentratora cała sieć przestaje działać. Ponieważ cały ruch w sieci jest obsługiwany

przez koncentrator, największe znaczenie ma odpowiednie zabezpieczenie tego komputera.

Zalety topologii typu gwiazda:

Sieć może działać nawet, gdy jeden lub

kilka komputerów ulegnie awarii.

Sieć jest elastyczna i skalowalna

Łatwość monitoringu, konserwacji,

wykrywania i lokalizacji kolizji

Wady topologii typu gwiazda:

Stosunkowo wysoki koszt spowodowany

jest dużą ilością kabla potrzebnego do

podłączenia każdego z węzłów

W wypadku awarii elementu centralnego

jakim jest koncentrator sieć nie działa

Metody dostępu do medium transmisyjnego w sieciach LAN

W każdej sieci istnieją mechanizmy regulujące dostęp do nośnika. Dostęp ten realizowany jest przez

warstwę 2 referencyjnego modelu OSI czyli przez warstwę danych. Istnieją 4 sposoby regulowania

dostępu do nośnika w sieciach lokalnych:

rywalizacja

przesyłanie tokenu

priorytet żądań

przełączanie

Dostęp do nośnika na zasadzie rywalizacji jest bardzo często stosowany w sieciach LAN które używają

rywalizacji jako podstawy do przyznania prawa do transmisji. Urządzenia sieciowe rywalizują ze sobą

o dostępne pasmo szerokości i tworzą tzw. domenę kolizji. Metoda ta przyjęta została w wielu

wersjach sieci Ethernet. Najbardziej znanymi z nich są:

- Ethernet II, znany też pod nazwą DIX Ethernet

- IEEE 802.3 - 10 Mbps Ethernet (CSMA/CD 2)

- IEEE 802.3 – 100 Mbps Fast Ethernet

- IEEE 802.3z - 2 Gpbs Gigabit Fast Ethernet

Początek sieci Ethernet był taki, że został on stworzony jako prowizoryczny mechanizm mający za

zadanie pomoc naukowcom w odkrywaniu nowych technologii. Pomysł przeszedł jednak oczekiwania i

stał się jedną z najbardziej wartościowych i trwałych technologii. Pierwotnie Ethernet funkcjonował

jako sieć lokalna utworzona przez naukowców w centrum badawczym firmy Xerox w Palo Alto i jako

taki nie miał być nigdy technologią mającą za zadanie podbój rynków informatychnych. Jego działanie

oparte było na odpowiedniej wielkości ramkach i lepiej zdefiniowanych protokołach warstwysieci i

transportu. Ethernet był siecią półdupleksową w której urządzenia połączone były grubym kablem

koncentrycznym.. Prędkość przesyłania sygnału sięgała 10 Mbps. Obecnie sieć tego typu nosi nazwę

PARC Ethernet lub Ethernet 1. Poznawszy możliwości Ethernetu jej twórcy docenili potencjał tej

technologii. Pozyskali partnerów w celu wprowadzenia jej na rynek. Były nimi firmy Intel oraz DEC

(Digital Equipment Corporation). Firmy te wspólnie ulepszyły pierwowzór Ethernetu, któremu nadano

nazwę Ethernet II używaną wymiennie z DIX Ethernet. Niestety nie stał się on standardem otwartym

ponieważ kontrolowany był przez jego głównych twórców.

2

CSMA/CD ang. Carier Sense Multiple Access/Collision Detection - wielodostęp do łącza sieci z badaniem stanu

kanału i wykrywaniem kolizji. W lutym 1980r instytut IEEEE wziął na siebie odpowiedzialność przekształceni

rozwijającego się Ethernetu w prawdziwy standard otwarty. Celem tego przedsięwzięcia było utworzenie

standardów dla sieci LAN i WAN. Uruchomiono projekt 802 z wieloma podkomisjami i grupami roboczymi.

Projekt 802 rozbił sieć na składniki funkcjonalne oraz pogrupował je w logiczne następujące po sobie warstwy.

Wojciech Międlar

Topologie sieci komputerowych - część 1

6

Rywalizacja

Dostęp na zasadzie rywalizacji to stosunkowo prosty sposób dostępu do nośnika ponieważ nie posiada

scentralizowanych mechanizmów zarządzających tym procesem. Po prostu każde urządzenie sieciowe

bierze na siebie zadanie samodzielnego przeprowadzenia transmisji. Każdorazowo przed przesłaniem

informacji, urządzenie sprawdza czy kanał

transmisyjny jest wolny. Jeśli kanał jest zajęty,

próba transmisji zostaje porzucona na ściśle

określony czas, po którym zostaje ponownie

podjęta.

Rys. 14 Transmisja pasmem podstawowym

Stosując tą metodę nośniki transmisji mogą jednocześnie

obsługiwać tylko jeden sygnał, który zajmuje całą dostępną

szerokość pasma transmisyjnego. Jest to transmisja w tzw.

paśmie podstawowym i oznacza komunikację z

wykorzystaniem tylko jednego kanału. Implikacją tego

stanu rzeczy jest:

- w danej chwili tylko jedno urządzenie może przesyłać

dane

- urządzenie może prowadzić odbiór lub nadawanie, ale

nigdy obie te czynności nie występują jednocześnie (tzw.

półdupleks)

W sieci, która wykorzystuje półdupleks tylko jedno

urządzenie może w określonej chwili przesyłać dane.

Pozostałe urządzenia muszą czekać i nasłuchiwać stanu

kanału transmisji co obrazuje poniższy rysunek.

Rys. 15 Półdupleksowa transmisja w paśmie podstawowym.

Innym trybem pracy sieci w kontekście przesyłania informacji jest pełny dupleks. Polega on na tym,

że dostępna szerokość pasma podzielona jest na odrębne kanały. W celu wyodrębnienia osobnego

kanału można użyć poszczególnych

przewodów kabla wielożyłowego. W

sieciach LAN typowy dupleks

realizowany jest dzięki technologii

przełączania. Dzięki niemu urządzenia

sieciowe mogą jednocześnie dane

wysyłać i je odbierać.

Omawiając metody rywalizacji dostępu

wymienić należy dwie główne:

a) z wykrywaniem kolizji

(CSMA/CD–Carier Sense Multiple

Access/Collision Detection)

b) z unikaniem kolizji

(CSMA/CA-Carier Sense Multiple

Access/Collision Avoidance)

Sieciowa transmisję z wykrywaniem

kolizji przedstawić można w

uproszczeniu wg. poniższego schematu

blokowego.

Rys. 16 Transmisja z wykrywaniem kolizji.

Stacja sprawdza czy ktoś już nadaje. Jeśli tak, czeka aż skończy. Stacja zaczyna nadawać cały czas

sprawdzając czy ktoś inny nie nadaje jednocześnie z nią. Jeśli nie, to może nadawać dalej. W

przypadku gdy ktoś nadawał (wykryto kolizję), przerywa nadawanie i odczekuje losowy odcinek

czasu. Potem zaczyna nadawać od początku.

Transmisja w sieci z unikaniem kolizji może być zrealizowana poprzez zgłoszenia żądania transmisji.

Algorytm działania takiej sieci wygląda następująco:

Wojciech Międlar

Topologie sieci komputerowych - część 1

7

Stacja sprawdza czy ktoś już nadaje. Jeśli tak czeka aż skończy. Jeśli nie, sprawdza czy od ostatniego

żądania transmisji opłynął czas T. Jeśli nie, powtarza sprawdzenia. Jeśli upłynął stacja zgłasza żądanie

transmisji i czeka przez ustalony czas T (jednakowy dla wszystkich stacji w danej sieci) nasłuchując

czy ktoś inny nie zgłosił żądania. Jeżeli stwierdzi inne żądanie, czeka losowy odcinek czasu i zaczyna

procedurę od początku.

Jeśli nie, zaczyna

nadawanie.

Inną metodą jest tzw.

przepytywanie.

Wyróżnione urządzenie

np. serwer cyklicznie

wysyła do innych stacji w

sieci pytanie, czy te mają

coś do wysłania. W

topologii gwiazdy

urządzeniem

przepytującym może być

hub.

Rys.17 Transmisja z unikaniem kolizji

Przesyłanie tokenu

Kolejną metodą dostępu do medium transmisji jest

dostęp na zasadzie pierścienia w sieciach FDDI 3.

Charakterystyczny zjawiskiem w sieciach LAN które

oparte są na topologii pierścienia jest przesyłanie

tokenu. Istnieją różne wersje sieci FDDI oraz Token

Ring. Token Ring jest specjalną ramką która

przesyłana jest w jednym kierunku do kolejnych

urządzeń wchodzących w skład pierścienia. Token

przesłany może być jedynie wtedy gdy sieć jest wolna.

Ramka tokenu ma długość kilku oktetów i zawiera

specjalny wzór bitów. Wzór ten ulega zmianie w celu

zmiany tokenu w sekwencję początku ramki. Jest to

informacja dla urządzeń znajdujących się w dalszej

części pierścienia, która mówi, że otrzymana ramka

jest ramką danych. Po sekwencji początku ramki

umieszczone są adresy nadawcy i odbiorcy. Token

decyduje o dostępie do nośnika co przedstawia

poniższy rysunek.

Rys.18 Sekwencyjne przekazywanie tokenu po drodze okrężnej.

Urządzenia Token Ring nie mogą nadawać niczego bez tokenu. Podstawowy token służy dwóm celom:

- jest używany do przyznawania przywilejów dostępu.

- podstawowa ramka tokenu jest przekształcana w nagłówki różnych, specjalnych ramek.

W rzeczywistości każda funkcja (w tym także przesyłanie danych) wymaga ramki o określonej

strukturze. Token Ring obsługuje następujące rodzaje ramek:

- Ramkę Token

- Ramkę danych

- Ramkę danych LLC

- Ramki zarządzania MAC

- Ramkę przerwania

3

FDDI-Fiber Distributed Data Interface –Interfejs Danych Przesyłanych Światłodowo. Standard znormalizowany w

połowie lat 80-tych jako specyfikacja ANSI X3T9.5. Cechuje ją solidność i niezawodność oraz szybkość

transmisji na poziomie 100 Mbps a także dwa przeciwbieżne pierścienie wykorzystujące kable światłowodowe.

Rozpiętość pierścienia dochodzić może do 200 km.

Wojciech Międlar

Topologie sieci komputerowych - część 1

8

Idea przekazywania znacznika (token passing) nie jest nowa. Metoda ta jest naturalną dla topologii

pierścienia, a innych topologiach pojawia się problem z określeniem kolejności w jakiej znacznik ma

obiegać stacje. Algorytm działania sieci z przekazywaniem znacznika w topologii magistrali lub

gwiazdy jest mniej więcej taki:

Stacja otrzymuje znacznik, wysyła dane do adresata i przekazuje znacznik następnej stacji.

W sieci o topologii pierścienia przedstawia się to trochę bardziej skomplikowanie.

Przyjmijmy kierunek przepływu danych taki jak na rondzie, czyli stacja odbiera z lewej i wysyła w

prawo. Stacja odbiera dane od lewego sąsiada, sprawdza czy jest to znacznik. Jeśli tak, to wysyła

swoje dane do prawego i czeka. Jeśli były to dane to sprawdza czy były one wysłane przez nią samą.

Jeśli tak, wysyła znacznik do prawego sąsiada. Jeśli nie przekazuje otrzymane dane do prawego

sąsiada. Najbliższą analogią jest "głuchy telefon". Oczywiście dochodzi jeszcze sprawdzenie

poprawności transmisji itp. Nie zmienia to jednak ogólnej zasady działania.

Niezależnie od topologii interesującym problemem jest co zrobić jeśli znacznik zaginął lub kto ma

wysłać pierwszy znacznik w chwili uruchomienia sieci.

Priorytet żądań

Metoda ta wykorzystywana jest w sieciach zgodnych ze specyfikacją http://www.ieee.org/IEEE 802.124

100 Mbps w których dostęp przyznawany jest cyklicznie. Sieć VG-Any-LAN umożliwia łączenie ramek

o formatach FDDi oraz Token Ring. Niewątpliwą zaletą tej sieci jest stosunkowo duża jej niezależność

od rodzaju zastosowanego nośnika. Jest to możliwe dzięki zastosowaniu czterech par nieekranowanej

skrętki dwużyłowej kategorii 3, nieekranowanej skrętki kategorii 5, ekranowanej skrętki kategorii 5

oraz kabla światłowodu o średnicy 62,5 mikrona. Sieć tego typu daje możliwość uzyskania

priorytetów, tzn. pozwala pakietom krytycznym na uzyskanie w razie potrzeby odpowiedniej

szerokości pasma.

Sieci VG-Any-LAN mają też swoje ograniczenia. Wymagają one użycia aż czterech par skrętki

dwużyłowej. Użytkownik dotychczasowego okablowania 10Base-T zmuszony będzie do ponownego

okablowania swoich stacji. Poza tym technologia ta nie współpracuje z popularnym „czystym

Ethernetem” ponieważ używa innej metody dostępu do nośnika.

Metodę pracy sieci standardu 802.12 przedstawić można w następujący sposób:

centralny wzmacniak (koncentrator) regularnie sprawdza stan portów przyłączonych do niego.

Wykonywane jest to w kolejności portów w celu sprawdzenia które z nich zgłaszają żądanie

transmisji. Po rozpoznaniu zgłoszenia koncentrator określa jego priorytet - normalny lub wysoki.

Wprowadzenie priorytetów umożliwia na uprzywilejowany dostęp do nośnika procesom które muszą

być obsłużone w określonym czasie. Każdy port, który nie przeprowadza transmisji przesyła sygnał

nośny (informację, że jest wolny). Sygnał ten usuwany jest przez wzmacniak w chwili wybrania

urządzenia jako kolejnego do rozpoczęcia transmisji. Wzmacniak informuje także pozostałe stacje, że

mogą odebrać wiadomość przychodzącą oraz

kontroluje działanie domeny priorytetów

Przełączanie

Przełącznik jest urządzeniem pracującym w warstwie

łącza danych 5. Często bywa on nazywany

wieloportem. Pracując „uczy się” adresów sterowania

dostępem do nośnika i przechowuje je w specjalnej

wewnętrznej tablicy zwanej tablicą wyszukiwania.

Pomiędzy nadawcą a odbiorcą ramki tworzone są

tymczasowe ścieżki przełączane (tzw. komutowane) a

potem ramki przesyłane są właśnie wzdłuż tych

ścieżek. Typową sieć lokalną opartą o topologię

przełączaną obrazuje poniższy rysunek.

Rys. 19 Sieć LAN o topologii przełączanej (komutowanej).

Standard 802.12 należy do grupy 802 dotyczącej technologii sieci lokalnych (LAN). Specyfikacja 802.12 określa

własną strukturę szkieletu, fizyczne nośniki transmisji oraz metodę dostępu do nich.

5

Jest to druga warstwa referencyjnego siedmiowarstwowego modelu OSI.

4