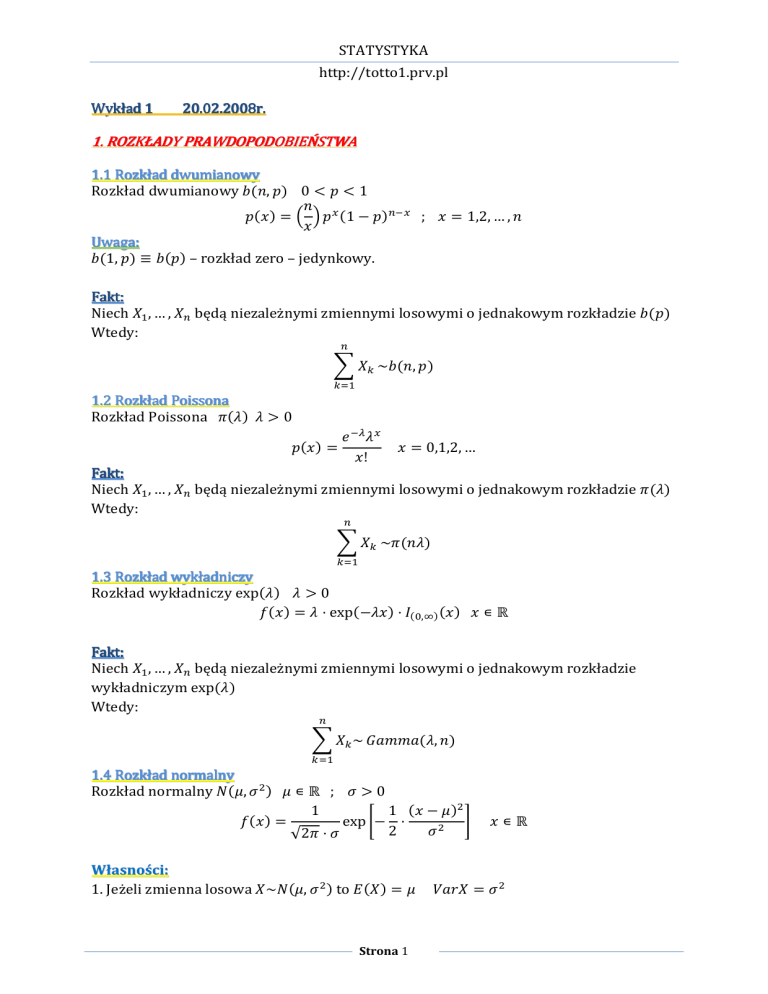

STATYSTYKA

Wykład 1

http://totto1.prv.pl

20.02.2008r.

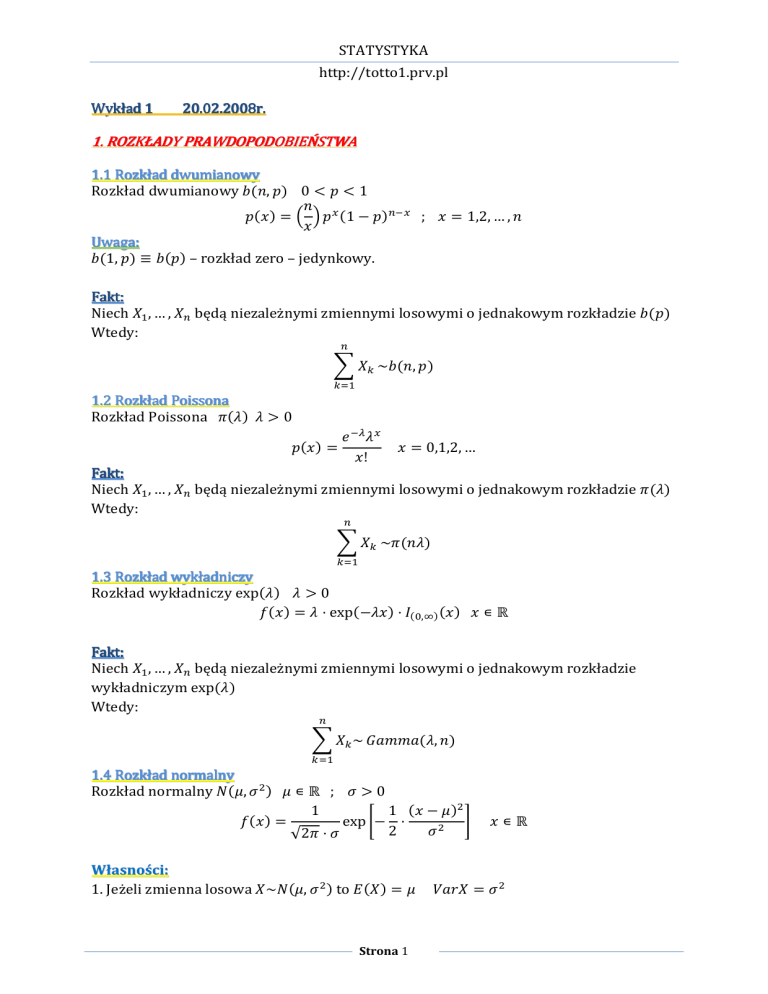

1. ROZKŁADY PRAWDOPODOBIEŃSTWA

1.1 Rozkład dwumianowy

Rozkład dwumianowy $%&, () 0 * ( * 1

&

(%+) , - . ( / %1 0 ()12/ ; + , 1,2, … , &

+

Uwaga:

$%1, () 8 $%() – rozkład zero – jedynkowy.

Fakt:

Niech AB , … , A1 będą niezależnymi zmiennymi losowymi o jednakowym rozkładzie $%()

Wtedy:

1

I AJ ~$%&, ()

JKB

1.2 Rozkład Poissona

Rozkład Poissona M%N) N O 0

(%+) ,

P 2Q N/

+!

+ , 0,1,2, …

Fakt:

Niech AB , … , A1 będą niezależnymi zmiennymi losowymi o jednakowym rozkładzie M%N)

Wtedy:

1

I AJ ~M%&N)

JKB

1.3 Rozkład wykładniczy

Rozkład wykładniczy exp%N) N O 0

V%+) , N W exp%0N+) W X%Y,Z) %+) + [ \

Fakt:

Niech AB , … , A1 będą niezależnymi zmiennymi losowymi o jednakowym rozkładzie

wykładniczym exp%N)

Wtedy:

1

I AJ ~ ]^__^%N, &)

JKB

1.4 Rozkład normalny

Rozkład normalny a%b, c d ) b [ \ ; c O 0

1

1 %+ 0 b)d

V%+) ,

exp f0 W

g

2

cd

√2M W c

Własności:

1. Jeżeli zmienna losowa A~a%b, c d ) to i%A) , b

Strona 1

+[\

j^kA , c d

STATYSTYKA

http://totto1.prv.pl

2. Jeżeli l jest dystrybuantą zmiennej losowej A o rozkładzie a%b, c d ) to:

+0b

.

l%A) , m c

gdzie m%n) ,

p P

√do 2Z

B

u

2

qr

r

st – dystrybuanta rozkładu a%0,1)

3. Jeżeli A~a%b, c d ) oraz v , ^A w $ to v~a%^b w $, ^d c d )

4. Jeżeli AB , … , A1 są niezależnymi zmiennymi losowymi o rozkładach a%bJ , cJd ) x ,

1, … , & odpowiednio oraz zmienna losowa:

1

Wtedy:

v , I ^J AJ

^J y 0

JKB

1

1

v~a zI ^J bJ , I ^Jd cJd {

JKB

JKB

Przykład 1:

Niech AB , … , A1 będą niezależnymi zmiennymi losowymi o jednakowym rozkładzie

a%b, c d )

Rozważmy zmienną losową:

A , ∑1JKB AJ – średnia arytmetyczna

B

1

Mamy:

Zatem na podstawie własności 4.:

1

Ponadto niech:

Wtedy:

Stąd:

1

1

A , I AJ

&

1

JKB

1

1 d d

cd

A~a zI b , I c { , a b,

&

&

&

JKB

JKB

t,

t,

A0b

√&

c

√&

√&b

·A0

c

c

√&

√&b & c d

t~a b 0

, · , a%0,1)

c

c cd &

Definicja:

Ciąg zmiennych losowych %A1 ) nazywamy asymptotycznie normalnym

a%^1 , $1d ) $1 O 0, gdy ciąg zmiennych losowych:

A1 0 ^1

$1

jest zbieżny według rozkładu do zmiennej losowej o rozkładzie normalnym a%0,1)

Strona 2

STATYSTYKA

http://totto1.prv.pl

Twierdzenie 1 %Centralne tw. graniczne Linderberga – Levy’ego):

Niech AB , … , A1 będzie ciągiem niezależnych zmiennych losowych o jednakowym

rozkładzie z wartością oczekiwaną b i skończoną dodatnią wariancją c d .

Wtedy ciąg średnich %A1 ), gdzie A1 , 1 ∑1JKB AJ

jest asymptotycznie normalny a -b,

B

r

d

.

Twierdzenie 2:

Niech ciąg zmiennych losowych %A1 ) będzie asymptotycznie normalny a%b, c1d ) przy

czym c1 0 gdy & ∞ oraz niech : \ \ będzie funkcją różniczkowalną w

punkcie b i %b) y 0

Wtedy ciąg zmiennych losowych %A1 ) jest asymptotycznie normalny

a%%b), %b)d c1 )

Przykład 2:

Niech %A1 ) będzie ciągiem niezależnych zmiennych losowych o rozkładzie M%N)

Wtedy:

N

A1 ~a N,

&

Niech w twierdzeniu 2: A1 8 A1

Mamy: c1d , 1 0

Q

&∞

Ponadto: %+) , √+ ; %+) , d

Zatem:

Stąd:

B

√/

%N) ,

1

2√N

O0

1 dN

1

)

%A1 8 A1 ~a √N ,

, a √N ,

4&

2√N &

1.5 Rozkład chi – kwadrat

Rozkład chi – kwadrat d %&) ; & , 1,2, …

Definicja:

Niech AB , … , A1 będą niezależnymi zmiennymi losowymi o jednakowym rozkładzie

a%0,1). Mówimy, że ABd w Add w w A1d ma rozkład chi – kwadrat z & stopniami swobody.

Fakt:

Strona 3

STATYSTYKA

http://totto1.prv.pl

V%+) ,

1

1

+d

1

&

d

2 - .

2

2B

/

· P 2d · X%Y,Z) %+) + [ \

Twierdzenie 3 %Fishera):

Niech AB , Ad , … , A1 ) %& O 1) będą niezależnymi zmiennymi losowymi o jednakowym

rozkładzie a%b, c d ).

Wtedy zmienne losowe:

1

1

A , I AJ

&

JKB

są niezależne oraz:

Wykład 2

cd

&

A~a b ,

27.02.2008r.

1

1

d

,

IAJ 0 AJ

&01

;

d

JKB

%& 0 1) d

~ d %& 0 1)

cd

Lemat:

Niech A , %AB , Ad , … , A1 ) , gdzie AB , Ad , … , A1 są niezależne i mają jednakowe rozkłady

a%b, c d ). Ponadto niech:

v , %vB , … , v1 ) , A

przy czym , %^/ ) jest macierzą ortogonalną rozmiaru & &

Wtedy vB , … , v1 są niezależne i mają rozkłady ab, ∑1KB ^J , c d , x , 1,2, … , &

Dowód tw. 3:

Konstruujemy macierz w następujący sposób:

1) pierwszy wiersz -

B

√1

,…,

B

√1

.

2) pozostałe wyznaczamy tak, aby otrzymać macierz ortogonalną

v , %vB , … , v1 ) , A A , %AB , Ad , … , A1 )

Mamy:

1. vB , … , v1 są niezależne

2. vB ,

B

√1

AB w

B

√1

3. Dla x , 2, … , &

4.

ABd

Add

w

Zatem

Ad w w

B

√1

A1 ,

i%vB ) , b √&

1

B

√1

1

∑1JKB AJ , √& A

i%vJ ) , b I ^J , b√& I

w w

A1d

KB

,

vBd

1

j^k%vB ) , c d

√&

KB

^J , b √& I ^B ^J , 0

j^k%vJ ) , c

w w v1d

Strona 4

1

d

KB

STATYSTYKA

http://totto1.prv.pl

1

%& 0 1) , IAJ 0 A ,

d

JKB

,

d

1

I AJd

JKB

1

I AJd

JKB

0 2&A

Ponadto:

0 2A I AJ &A

¡

JKB

d

1

d

1¢

1

1

d

d

d

d

w &A , I AJ 0 &A , I vJ 0 vB , I vJd

JKB

JKB

JKd

B

B

1

d

d

∑

A,

,

v są niezależne/

12B JKd J

√1

d

Stąd zmienna losowa

1

1

1 d

cd

A~a b√&, c , a b,

&

&

√&

%& 0 1) d ∑1JKB vJd

vJd

,

,

I

, I ¤Jd

cd

cd

cd

Mamy:

¤J ~a

¤B , … ¤1 0 niezależne

Czyli:

1

JKd

1

JKd

1

1

· 0, d c d , a%0,1) x , 2, … , &

d

c

c

%& 0 1) d

~ d %& 0 1)

cd

Fakt:

Niech zmienna losowa A~M%N)

Wtedy

l¢ %x) , 1 0 l¥ %2N) x , 1,2, …

gdzie

v~ d 2%x w 1)

Dowód %szkic):

1 0 l¥ %2N) , 1 0 ¦

J

dQ

Y

,I

ªKY

+

1

+

1 Q J 2u

,n

J

+ exp -0 . s+ , © 2

© , 1 0 ¦ n P sn

2J§B ¨

%x

w¨¡

1)

2

x! Y

¨ ¨

s+ , 2sn

J!

P 2Q Nª

, l¢ %x)

«!

1.6 Rozkład ­ 0 studenta

Rozkład n 0 studenta n%&)

& , 1,2, …

Definicja:

Niech A~a%0,1) oraz v~ d %&) będą niezależnymi zmiennymi losowymi. Mówimy, że

zmienna losowa

Strona 5

STATYSTYKA

http://totto1.prv.pl

A

1 v

&

ma rozkład n 0 Studenta z & stopniami swobody.

Fakt:

1§B

&w1

d 2 d

.

+

2

V%+) ,

+[\

& 1 w &

√&M · -2.

-

Fakt:

Niech %V1 ) będzie ciągiem gęstości zmiennych losowych A1 o rozkładzie n%&)

Wtedy:

1

+d

®/[\ : lim V1 %+) , ¯%+) ,

exp 0

1\

2

√2M

Przykład 3:

Niech AB , … , A1 będą niezależnymi zmiennymi losowymi o jednakowym rozkładzie

a%b, c d ) %& O 1) wtedy:

oraz

°,

A0b

√& ~ a%0,1) ± przykład 1

c

%& 0 1) d

~ d %& 0 1) ± tw. 3

cd

Ponadto zmienne losowe °, v są niezależne

Wtedy:

°

~n%& 0 1)

1

& 0 1v

Mamy:

A0b

A0b

c √&

,

,

√&

d

%&

1

1

0

1)

v

&01

&01·

cd

1.7 Rozkład ² 0 Snedecora

Rozkład l 0 Snedecora l%&, _) &, _ , 1,2, …

°

Definicja:

Niech A~ d %&) oraz v~ d %_) będą niezależnymi zmiennymi losowymi.

Mówimy, że zmienna losowa

1

&A

1

v

_

Strona 6

STATYSTYKA

http://totto1.prv.pl

ma rozkład l 0 Snedecora z &, _ stopniami swobody.

Fakt:

1

_w&

2B

. _ ³

d

A

d

2

V%+) ,

³§1 XY,Z %+) + [ \

&

_ - .

- .- . &

_

d

2

2

-A w .

&

Przykład 4:

Niech AB , … , A1 vB , … , v1 będą niezależnymi zmiennymi losowymi o rozkładach

odpowiednio równych a%b¢ , c d ); a%b¥ , c d )

Wtedy:

%& 0 1) d

A,

~ d %& 0 1) ± tw. 3

cd

%_ 0 1) d

~ d %_ 0 1) ± tw. 3

v,

cd

Ponadto zmienna losowa A, v są niezależne

1

& 0 1 A ~l%& 0 1, _ 0 1)

1

_ 0 1v

Mamy:

1 %& 0 1)¢d

1

A

¢d

&01 , &01

cd

,

1

1 %_ 0 1)¥d ¥d

v

_01

_01

cd

2. DANE STATYSTYCZNE. MODEL STATYSTYCZNY

Przykład 5:

1) Centrala telefoniczna

W 200 losowo wybranych 5 0 sekundowych odcinkach czasowych, badano liczbę

zgłoszeń. otrzymano wynik:

0,5,3, … ,2.

2) Auto – test

Przeprowadzono 50 niezależnych eksperymentów polegających na hamowaniu

badanego typu samochodu.

Zaobserwowano długości drogi hamowania %w metrach)

18,13; 17,61; … ; 18,62

Wykład 3

05.03.2008r.

Definicja:

Populacja – zbiór obiektów

Cecha %zmienna) – funkcja określona na obiektach populacji %ozn. A)

Strona 7

STATYSTYKA

http://totto1.prv.pl

Rozkład %rzeczywisty) populacji – rozkład wartości tej cechy A na elementach populacji.

Próba – podzbiór populacji złożony z obiektów podlegających badaniu statystycznemu

Rozkład %empiryczny) z próby – rozkład wartości cechy A na elementach próby.

AB

A

A , ´ d ¶ 0 dane

µ

A1

Przykład 5 %Cd.):

częstość

zgłoszeń

0

1

2

3

4

5

%

16%

33,5%

24,5%

15,5%

7,5%

3%

dyskretna cecha

długość

drogi

liczebność

hamowania

hamowania

17,6 – 17,8

4

17,8 – 18

5

18 – 18,2

6

18,2 – 18,4

8

18,4 – 18,6

11

18,6 – 18,8

12

18,8 – 19

4

ciągła cecha

Konstruując model matematyczny eksperymentu statystycznego.

Dane A , %AB , Ad , … , A1 ) traktujemy jako realizację wektora losowego

A , %AB , Ad , … , A1 ) o rozkładzie ¹ należącej do pewnej rodziny rozkładu º

» 0 przestrzeń próby

¼ 0 c 0 ciało podzbiorów zbioru » na którym określone są rozkłady ¹ w zbiorze ½

Próby proste

», ¼, º 0 przestrzeń statystyczna

• częstość wartości cechy A w próbie

%rozkład empiryczny)

• funkcja prawdopodobieństwa rozkładu

Poissona %rozkład tradycyjny)

• wielobok częstotliwości

wartości cechy A w próbie

%rozkład empiryczny)

• gęstość rozkładu normalnego

%rozkład teoretyczny)

Strona 8

STATYSTYKA

http://totto1.prv.pl

Budując model zakładamy, że cecha A jest zmienną losową o rozkładzie ¹ z rodziny º

%jednowymiarowy). Indukuje ona przestrzeń statystyczną w taki sposób, że AB , … , A1 są

niezależnymi zmiennymi losowymi o jednakowym rozkładzie ¹ [ º.

»,»

¨

¨¨»

¨ ¨

…

¨¨

¨¡

»

1

¼,¼

¨¨¨¨ ¨¨¨¨¡

¼ … ¼

1

º,º

¨

¨¨º

¨ ¨

…

¨¨¨¡

º

1

», ¼, º 8 %», ¼, º)1

¹ 0 rozkład populacji

º , ¾¹¿ : À [ ÁÂ

Á 0 przestrzeń populacji

Á Ã \J 0 model parametryczny

Á Ä \J 0 model nieparametryczny

Przykład 5:

1) A 0 budujemy model

Zakładamy A~M%N) N O 0

Zatem » , ¾0,1,2, … Â 0 zbiór potencjalnych wartości

¼ , 2»

º , ¾M%N) N O 0Â

Model %», ¼, º)dYY

Uwaga:

À,N

Á , \§ Ã \ 0 przestrzeń parametru

2) A 0 długość drogi hamowania

Zakładamy, że A~a%b, c d ) b [ \; c O 0

»,\

¼ , Å %borelowski)

º , ¾Æ%b, c d ): b [ \, c d O 0Â

zatem

Model %», ¼, º)ÇY 0 przestrzeń statystyczna

Uwaga:

À , %b, c d ) 0 parametr

Á , \ \§ Ã \d 0 przestrzeń parametru

Strona 9

STATYSTYKA

http://totto1.prv.pl

Niech %», ¼, º) będzie przestrzenią statystyczną 8 Niech A , %AB , Ad , … , A1 ) będzie

próbą z populacji o rozkładzie ¹¿ , gdzie À [ Á jest parametrem.

Wykład 4

12.03.2008r.

3. STATYSTYKI DOSTATECZNE I ZUPEŁNE

Niech A , %AB , Ad , … , A1 ) będzie próba z populacji o rozkładach ¹¿ gdzie À [ Á jest

parametrem.

Statystyką nazywamy każdą funkcję mierzalną È próby A.

np. A , ∑1JKB AJ 0 średnia z próby.

B

1

d , 12B ∑1JKBAJ 0 A 0 wariancja z próby

B

d

Definicja:

Statystyka È jest dostateczna dla rodziny rozkładów º , ¾¹¿ : À [ Á gdy rozkład

warunkowy:

A|È , n

nie zależy od parametru À

Przykład 6:

Niech A , %AB , Ad , … , A1 ) będzie próbą z populacji o rozkładzie M%N), N O 0 0 parametr.

rozważmy statystykę postaci:

1

ÈA , I AJ

JKB

Mamy È~M%&N)

Zatem

Î 0,

Ì

1

I +J y n

JKB

1

͹A , +

, I +J , n

Ì

Ë ¹%È , n) JKB

,

Î0,

Ì

¹A , +ÊÈ 0 n ,

Ï,

Î 0,

Ì

¹A , +, È , n

¹%È , n)

1

I +J y n

JKB

1

Í∏1JKB ¹%AJ , +J )

, I +J , n

Ì

¹%È , n)

Ë

JKB

1

I +J y n

JKB

1

ÍP

n!

, I +J , n

Ì 1

2Q1 u u

Ë ∏JKB +J ! P & N JKB

21Q %0N)∑Ò

ÑÓÔ /Ñ

Strona 10

Ï,

Î0,

Ì

Ï,

1

Î 0,

Ì

Ì

I +J y n

JKB

Ï

P 2Q N/Ñ

1

1

∏

Í JKB + !

J

Ì

Ì P 21Q %0N)u , I +J , n

JKB

Ë

n!

1

I +J y n

JKB

1

Í

n!

, I +J , n

Ì u 1

Ë & ∏JKB +J ! JKB

Ï

STATYSTYKA

http://totto1.prv.pl

Stąd rozkład warunkowy A|È , n nie zależy od N, czyli ÈA , ∑1JKB AJ jest dostateczny

od parametru N.

Twierdzenie 4 %Kryterium faktoryzacji):

Statystyka È jest dostateczna dla parametru À ⇔ funkcje prawdopodobieństwa

%gęstość) próby A można przestawić w postaci:

¹¿ A , ¿ -ÈA. ÖA

gdzie funkcja Ö nie zależy od parametru À a funkcja %zależna od À) zależy od A tylko

poprzez wartości statystyki È.

Przykład 7:

Niech A , %AB , Ad , … , A1 ) będzie próbą z populacji o rozkładzie a%b, c d ), b [ \, c d O 0

Wtedy:

1

1

V[,r A , × VØ,r %AJ ) , × Ù

JKB

, %2Mc)

,

gdzie

2

JKB

1

d exp Û0

1

√2Mc d

1

exp f0

1 %AJ 0 b)d

gÚ

cd

2

1

I%AJ 0 b)Ü

2c d

1

%2Mc d )2 d exp Û0

JKB

1

1

1

zI AJd 0 2b I AJ w &b d {Ü

2c d

JKB

JKB

ß

ã

1

1

1

&b d â

Þ &

d

exp Þ0 d I AJ 0 d I AJ 0 d â · ç

1 , Ø,r %n)ÖA

,

2c ¡ 2c ¡ 2c

Þ

â è%/)

JKB

JKB

Ý

á

àÔ %¢)

àr %¢)

¨¨¨¨¨¨¨¨¨¨¨¨¨¨¨ ¨¨¨¨¨¨¨¨¨¨¨¨¨¨¨¡

1

%2Mc d )2 d

n , %nB , nd );

äå,ær %u)

1

nB A , I AJ ;

JKB

1

nd A , I AJd

JKB

Zatem statystyka dostateczna dla parametru À , %b, c d ) ma postać:

1

1

ÈA , zI AJ , I AJd {

JKB

JKB

Definicja:

Statystykę dostateczną È nazywamy minimalną statystyka dostateczną jeżeli dla każdej

statystyki dostatecznej istnieje funkcja Ö taka, że È , Ö%é)

Definicja:

Statystyka È jest zupełna dla rodziny rozkładów º , ¾¹¿ : À [ Á) %dla parametru Θ) gdy

z warunku

®¿[ë : i¿ Ö%È) , 0

Strona 11

STATYSTYKA

http://totto1.prv.pl

wynika, że:

Przykład 6 %Cd.):

Ö 8 0 prawie wszędzie º

1

ÈA , I AJ 0 statystyka dostateczna dla parametru N.

Niech:

JKB

21Q %&N)J

∑Z

Ö%x) · &J J

JKY Ö%x)P

21Q

iQ Ö%È) ,

, Pì

I

N ,0

x!

x!

íY JKY

¨¨¨¨ ¨¨¨¨¡

Z

îïðñðä òóuęäóôõ

Ö%x) · &

, 0 x , 0,1,2, …

x!

Ö%x) , 0 x , 0,1,2, …

Ö80

1

∑

Zatem statystyka È , JKB AJ jest zupełna dla parametru N.

J

Twierdzenie 5:

Jeżeli statystyka È jest dostateczna i zupełna dla rodziny rozkładów º, to È jest

minimalną statystyką dostateczną dla rodziny º.

Definicja:

Rodzinę rozkładów prawdopodobieństwa º , ¾¹¿ : À [ Á nazywamy ö 0 parametrową

rodziną wykładniczą jeżeli funkcje prawdopodobieństwa %lub gęstość) rozkładu ¹¿

można zapisać w postaci:

ú

Przykład 8:

Zatem:

VØ,r ,

(¿ %+) , Ö%+) exp ÷I øª %À)Ȫ %+) 0 ù%À)û

ªKB

º , ¾a%b, c d ), b [ \, c d O 0Â

1 %AJ 0 b)d

1

1

g,

exp ü0 d %+ d 0 2b+ w b d )ý

d

2

c

2c

√2Mc d

√2Mc d

d

1

b

1

b

,

exp f d + 0 d + d 0 d g

c

2c

2c

√2Mc d

1

exp f0

, exp þ

øB %b, c d ) ,

b

cd

b

1 d

bd

1

ç

+

0

+

0

0 ln%2Mc d )

d

d

d

¨¨¨¨¨ ¨

c

2c

2c

2 ¨¨¨¨¡

Ô

àÔ

r

àr

ÈB %+) , +

ød %b, c d ) ,

1

2c d

ù%+) , 0

Èd %+) , + d

Strona 12

bd

1

w ln%2Mc d )

d

2c

2

Ö%+) , 1

STATYSTYKA

http://totto1.prv.pl

Zatem rodzina rozkładów º jest rodziną wykładniczą.

Wykład 5

19.03.2008r.

Twierdzenie 6 %Lemanna):

Niech A , %AB , Ad , … , A1 ) będzie próbą z populacji o rozkładzie z rodziną wykładniczą

º dla której zbiór

¾øB %À), … , øú %À): À [ ÁÂ

zawiera niezdegerowany prostokąt w \d .

Wtedy statystyka

1

1

ÈA , zI ÈB %AJ ), … , I Èú %AJ ){

JKB

JKB

jest dostateczna i zupełna dla rodziny rozkładów º.

Przykład 8 %Cd.):

Rozważmy następujący zbiór:

b

1

øB %b, c d ), ød %b, c d ): b [ \, c d O 0 , d , 0 d : b [ \, c d O 0 , \ \

c

2c

d

– zawiera niezdegenerowany prostokąt w \ .

zatem statystyka:

1

1

1

1

ÈA , zI ÈB %AJ ), I Èd %AJ ){ , zI AJ , I AJ {

JKB

JKB

JKB

jest dostateczna i zupełna dla rodziny rozkładów normalnych.

JKB

4. ESTYMACJA PUNKTOWA %SZACOWANIE)

Niech A , %AB , Ad , … , A1 ) będzie próbą z populacji z rozkładem prawdopodobieństwa o

rozkładzie ¹¿ , gdzie À [ Á jest parametrem.

Ponadto niech %À) będzie funkcją parametryczną.

Definicja:

Statystykę ÈA o wartościach w zbiorze %À) %skonstruowana w ten sposób, aby jej

wartości szacowały prawdziwą wartość funkcji parametrycznej %À))

nazywamy estymatorem funkcji parametrycznej %À). Oznaczamy

A.

Przykład 9:

Załóżmy, że badamy cechę A o której to cesze zakładamy, że A~M%N), N O 0 0 (^k.

Poszukamy estymatorów funkcji parametrycznej.

a) B %N) , iQ %A) , N

b) d %N) , ¹Q %A , 0) , P 2Q

Przykładowe estymatory:

Strona 13

STATYSTYKA

http://totto1.prv.pl

a)

B A , A

b)

d A , P 2¢

Przykład 10:

Badamy cechę A.

Model: A~a%b, c d ), b, c d 0 parametry.

Poszukujemy estymatorów funkcji parametrycznej:

a) B %b, c d ) , iØ,r %A) , b

b) d %b, c d ) , j^kØ,r %A) , c d

Przykłady estymatorów:

a)

B A , A

b)

d A , d

Definicja:

Statystykę

A nazywamy estymatorem nieobciążonym funkcji par %Á), gdy

®¿[ë i¿

A , %À)

Przykład 11:

Zakładamy, że cecha A ma dowolny rozkład

Estymujemy prawdopodobieństwo ( , ¹%A [ ), gdzie jest zbiorem borelowskim.

Rozważmy „estymator częściowy” postaci:

#¾x: AJ [ Â

(̂ A ,

&

Mamy #¾x: AJ [ Â ~ $%&, ()

Zatem

1

1

i -(̂ A. , i%#¾x: AJ [ Â , &( , (

&

&

Czyli estymator (̂ jest estymatorem nieobciążonym dla (.

Uwaga:

Niech l będzie dystrybuantą rozkładu zmiennej losowej A, tzn. l%+) , ¹%A +).

Wtedy dystrybuanta empiryczna

#¾x: AJ +Â

l1 %+) ,

&

jest nieobciążonym estymatorem dystrybuanty l w punkcie +.

Przykład 12:

Zakładamy, że badana cecha A populacji ma rozkład o wartości oczekiwanej b.

Ponieważ

Strona 14

STATYSTYKA

http://totto1.prv.pl

1

1

1

1

1

iA , i z I AJ { , I i%AJ ) , W b W & , b

&

&

&

JKB

JKB

Zatem A jest estymatorem nieobciążonym dla b.

Uwaga:

Niech ^B , … , ^1 będą liczbami takimi, że ∑1JKB ^J , 1

Wtedy statystyka b̂ A , ∑1JKB ^J AJ jest nieobciążonym estymatorem parametru b.

Mamy

1

1

i -b̂ A. , I ^J i%AJ ) , b I ^J , b

JKB

JKB

Przykład 12 (cd.):

Zakładamy dodatkowo, że cecha A ma skończoną wariancję c d oraz, że & O 1. Wtedy:

1

1

1

1

2A

&

d

d

1

d

d)

i% , i z

IAJ 0 A { , i I AJ 0

IA w

A

&01

& 0 1 ¡J & 0 1 &01

JKB

JKB

JKB

¨¨¨ ¨¨

¨¡

1¢

, iz

Ponadto:

1

1

2

r

d¢ 1

12B

1

&

1

&

d

d

I AJd 0

A {,

I i%AJd ) 0

i -A .

&01

&01

&01

&01

JKB

JKB

d

i%AJd ) , j^k%A

%A¨J¡) , c d w b d

¨ ¨¡

¨

J) w i

1

d

r

Ør

i -A . , j^kA w i d A ,

1

cd

w bd

&

1

1

1

1

1 d

cd

j^kA , j^k z I AJ { , d j^k zI AJ { , d I j^k%AJ ) , d c & ,

&

&

&

&

&

Zatem:

i%

d)

1

JKB

JKB

1

&

cd

,

I%c d w b d ) 0

w bd

&01

&01 &

JKB

JKB

&

&

1

&

&

1

cd w

bd 0

cd 0

bd , c d

0

, cd

&01

&01

&01

&01

&01 &01

czyli statystyka d jest estymatorem nieobciążonym dla c d .

,

Wykład 6

26.03.2008r.

%À) 0 funkcja parametryczna

A , %AB , … , A1 ) 0 próba

%A) 0 estymator dla %À)

Strona 15

STATYSTYKA

http://totto1.prv.pl

0 estymator nieobciążony

®¿[ë i¿ -

A. , %À)

Definicja:

Ciąg estymatorów -

1 A. funkcji parametrycznej %À) nazywamy (słabo) zgodnym,

gdy ciąg -

1 A. jest zbieżny według prawdopodobieństwa do %À) tzn.:

®¿[ë ®íY lim ¹¿ %|

1 %A) 0 %À)| ) , 0

1Z

Przykład 12 (cd.):

Z prawa wielkich liczb Chińczyna wynika, że

jest zgodnym estymatorem dla b.

Ponadto d 0

- ∑1 A d 0 A .

12B 1 JKB J

1

B

d

b̂ 1 A , A

Zastosujemy prawo wielkich liczb Chińczyna do ciągu ABd , Add

Wtedy

1

Zatem c

d

1Z

d

1Z

1

I AJd i%A d ) , c d w b d

&

JKB

Czyli jest zgodnym estymatorem parametru c d

d

Twierdzenie 7:

Niech

1 A będzie nieobciążonym estymatorem funkcji parametrycznej %À), dla

której:

®¿[ë j^k¿

1 A 0

Wtedy

1 A jest zgodnym estymatorem dla %À).

1[Z

Lemat %Nierówność Czybyszewa):

Jeżeli A jest zmienną losową o wartości oczekiwanej b i skończonej wariancji c d , to

prawdziwe jest:

1

®QíY : ¹%|A 0 b| Nc) d

N

Dowód tw. 7:

Obieramy dowolne À [ Á; O 0

Mamy: ®¿[ë : i¿

1 A , %À)

Niech:

N,

j^k¿

1 A

Zatem:

Strona 16

STATYSTYKA

http://totto1.prv.pl

¹¿ z ¡

1 A 0 %À)

{

ì ç

¢

Ponieważ:

Ø

Q

j^k¿

1 A

d

j^k

1 A

0

1Z

d

¹¿ %|

1 A 0 %À)| ) 0

Zatem:

1Z

Czyli

1 A jest zgodnym estymatorem dla %À).

4.1 Estymatory nieobciążone o minimalnej wariancji

Niech ! będzie rodziną estymatorów nieobciążonych posiadających skończoną

wariancję dla każdego À [ Á dla %À).

Statystykę

Y A nazywamy estymatorem nieobciążonym o minimalnej wariancji

(ENMW) funkcji parametrycznej %À), gdy:

®ä

¢[" ®¿[ë j^k¿

Y A j^k¿

A

Twierdzenie 8:

ENMW funkcji parametrycznej %À) jest wyznaczony jednoznacznie z dokładnością do

zbioru miary zero.

Lemat 1:

Niech È będzie ENMW funkcji parametrycznej %À), statystyką taką, że:

®¿[ë : i¿ %) , 0. Wtedy ®¿[ë : i¿ %È) , 0

Dowód lematu 1:

Niech ° , È w #; # [ \

Mamy i%°) , i%È)

ì w #i%)

¡ , %À)

ä%¿)

KY

Zatem U jest estymatorem nieobciążonym dla %À).

j^k%°) , j^k%È) w # d j^k%) w 2# ¨

$%&%È,

é)

¨ ¨

¨¡

'à2ä%¿)(

Ponieważ È jest ENMW dla %À), to:

Stąd ) 0

Lemat 2:

j^k%È) j^k%°) , j^k%È) w # d j^k%) w 2#i -È 0 %À).

# d jk%) w 2#i -È 0 %À). 0

) , 4iÈ 0 %À) 0

d

i -È 0 %À). , 0

i%È) 0 %À)i%) , 0

i%È) , 0

Strona 17

STATYSTYKA

http://totto1.prv.pl

Niech A, v będą zmiennymi losowymi takimi, że |*%A, v)| , 1

Wtedy istnieją, liczby ^ y 0 i $ y 0 takie, że ¹%v , ^A w $) , 1

Ponadto ^ ,

+ó,%¢,¥)

-.ñ%/)

; $ , i%v) 0 ^i%A)

Dowód tw. 8:

Niech È, będą ENMW dla %À).

Zatem i%È) , i%) , %À); j^k%È) , j^k%)

Ponadto:

$%&%È, ) , iÈ 0 %À) 0 %À) , i%È) 0 %À) i%È)

ì 0 %À) i%)

ì w d %À)

ä%¿)

, i%È) 0 d %À) , i%È d ) 0 d %À) , j^k%È)

Mamy i%È 0 ) , 0

Czyli È 0 0 ia dla 0

Zatem (z lematu 1) mamy iÈ%È 0 ) , 0

i%È d ) 0 i%È) , 0

i%È) , i%È d )

Stąd:

$%&%È, )

j^k%È)

*%È, ) ,

,

,1

/&^k%È)j^k%) j^k%È)

Zatem (z lematu 2) mamy:

Istnieją stałe # y 0 i 0 takie, że:

Ponadto:

Stąd È , (. 1.

ä%¿)

È , # w 0 (. 1.

$%&%È, ) j^k%È)

,

,1

j^k%)

j^k%È)

0 , i%È) 0 i%) , 0

#,

Twierdzenie 9 %Rao ― Blackwella):

Niech

A będzie estymatorem nieobciążonym funkcji parametrycznej %À), È

statystyką dostateczną dla parametru À. Wtedy:

1. i%

|È) 0 estymator nieobciążony funkcji parametrycznej %À)

2. ®¿[ë : j^k¿ i%

|È) j^k¿

A

Lemat:

Jeżeli odpowiednie wartości oczekiwane istnieją, to:

1. ii%A|v) , i%A)

2. j^ki%A|v) j^k%A)

Dowód :

Mamy, że A|È , n nie zależy od parametru θ, bo È jest statystyką dostateczną. Zatem

A|È , n nie zależy od parametru θ.

Strona 18

STATYSTYKA

http://totto1.prv.pl

Wykład 7

02.04.2008r.

Twierdzenie 9:

A ― Estymator nieobciążony dla %À)

È 0 statystyka dostateczna dla À

i

A|È

1. Estymator nieobciążony dla %À)

2. j^k -i -

A. |È. j^k -

A.

Stąd:

i

AÊÈ nie zależy od parametru À, czyli jest statystyką.

Ponadto:

i¿ %i

AÊÈ , i¿ -

A. , %À)

czyli i

AÊÈ jest Estymatorem nieobciążonym dla %À)

dodatkowo:

j^k -i

AÊÈ. j^k -

A.

Twierdzenie 10 %Lehmanna ― Scheffego):

Niech

będzie nieobciążonym estymatorem funkcji parametrycznej %À), È statystyką

dostateczną i zupełną dla parametru À.

Wtedy i

AÊÈ jest Estymatorem nieobciążonym o minimalnej wariancji funkcji

parametrycznej %À).

Dowód tw. 10:

Niech %È) , i

AÊÈ

Mamy i¿ %È) , %À)

j^k %%È)) j^k -

A.

Niech

A będzie dowolnym estymatorem nieobciążonym dla funkcji parametrycznej

%À).

Zatem dla każdego c [ Á

Rozważmy statystykę:

mamy:

%È) , iAÊÈ

i¿ -%È). , %À)

j^k -%È). j^k -A.

0 %È)

l¿ - 0 %È). , l %È) 0 i -%È). , 0

Zatem z zupełności statystyki È

Strona 19

STATYSTYKA

http://totto1.prv.pl

0 8 0 (. 1.

8 (. 1.

Stąd ®[ë

j^k %È) , j^k -%È). j^k -A.

czyli %È) , i

AÊÈ jest Estymatorem nieobciążonym o minimalnej wariancji funkcji

parametrycznej %À).

Przykład 9 (cd.):

Niech A , %AB , … , A1 )4 będzie próbą z populacji o rozkładzie M%N), N O 0 0 parametr

oraz niech d %N) , P 2Q .

Niech

d A ,

#¾J:¢Ñ KYÂ

1

, 1 ∑1JKB XY %AJ )

B

Wiemy, że

d A 0 Estymator nieobciążony dla d %N) 0 przykład 11

Poznadto

ÈA , ∑1JKB AJ ― statystyka dostateczna i zupełna dla parametru N %przykład 6)

Zatem:

1

1

1

1

1

1

i

d AÊÈ , n , i z I XY %AJ ) I Aª , nÏ { , I i zXY %AJ ) I Aª , nÏ{

&

&

JKB

1

ªKB

JKB

1

, i zXY %AB ) I Aª , nÏ{ , ¹ zAB , 0 I AJ , n{

ªKB

ªKB

JKB

¹%AB , 0, ∑1JKB AJ , n) ¹%AB , 0) W ¹%∑1JKB AJ , n)

,

,

¹%∑1JKB AJ , n)

¹%∑1JKB AJ , n)

%& 0 1)Nu P 2%12B)Q

P 2Q

%& 0 1)u

1 u

n!

,

,

, 1 0

%&N)u P 21Q

&n

&

n!

1 à

d A , 1 0

&

Twierdzenie 11:

Niech È będzie statystyką dostateczną i zupełną dla parametru À oraz niech

%È) będzie

Estymatorem nieobciążonym funkcji parametrycznej %À). Wtedy

%È) jest

Estymatorem nieobciążonym o minimalnej wariancji funkcji parametrycznej %À).

Lemat:

Jeżeli A , Ö%v) oraz istnieje i%A|v), to i%A|v) , A

Dowód tw. 11:

Z twierdzenia 10 i%

%È)|È) 0 ENMW funkcji parametrycznej %À)

Z lematu i%

%È)|È) ,

%È)

czyli

%È) jest ENMW funkcji parametrycznej %À).

Strona 20

STATYSTYKA

http://totto1.prv.pl

Przykład 10 (cd.):

Niech A , %AB , … , A1 ) %& O 1) będzie próbą z populacji o rozkładzie a%b, c d ); b [ \; c O 0

Estymujemy funkcję parametryczną B %b, c d ) , b, d %b, c d ) , c d

Wiemy, że statystyka

1

1

ÈA , zI AJ , I AJd {

jest dostateczna i zupełna dla %b, c d )

Mamy:

JKB

JKB

B A , A ― Estymator nieobciążony dla parametru b

d A , d 0 Estymator nieobciążony dla parametru c d

Zatem

1

1

1

1

B A , A , I AJ , ÈB A

&

&

JKB

1

d

d

1

1

1

1

I AJd 0

zI AJ { ,

Èd A 0

-ÈB A.

d A , d ,

&01

&%& 0 1)

&01

&%& 0 1)

JKB

JKB

Zatem A i są ENMW dla b i c odpowiednio.

d

d

Mówimy, że rodzina rozkładów º , ¾¹¿ : À [ Á à \ na przestrzeni próby » à \1

spełnia warunki regularności Cramera – Rao , gdy dla funkcji prawdopodobieństwa (lub

gęstości) rozkładu ¹¿ mamy:

Zbiór , A , »: ¹¿ A O 0 nie zależy od parametru À. Dla dowolnych + [ i À [ Á

istnieje skończona pochodna

5 ln (¿ %+)

5À

Jeżeli È jest dowolną statystyką taką, że i¿ %È) * ∞ dla dowolnych À [ Á, to

5

5

¦ ÈA¹¿ As+ , ¦ ÈA ¹¿ As+

5À »

5À

»

Do końca rozdziału zakładamy, że rodzina º , ¾¹¿ : À [ Á rozkładów

prawdopodobieństwa spełnia warunki regularności Cramera – Rao.

d

Funkcję X1 %À) , i¿ 68¿ ln (¿ A9 nazywamy ilością informacji Fishera o parametrze À z

próby A.

Wykład 8

Własność 1:

Dowód:

7

09.04.2008r.

X1 %À) , &XB %À)

Strona 21

STATYSTYKA

http://totto1.prv.pl

d

1

d

1

1

5

5

5

X1 %À) , i¿ Û ln z× (¿ %AJ ){Ü , i¿ Û I ln (¿ %AJ )Ü , i¿ ÛI

ln (¿ %AJ )Ü

5À

5À

5À

JKB

1

JKB

JKB

d

d

5

5

5

, i¿ :I ln (¿ %AJ ) w 2 I ln (¿ %Aª ) ln (¿ A <

5À

5À

5À

1

JKB

, I i¿ ü

JKB

ª;

d

5

5

5

ln (¿ %AJ )ý w 2 I üi¿ ln (¿ %Aª ) W i¿ ln (¿ A ý

5À

5À

5À

ª;

5

, & i¿ ü ln (¿ %AB )ý , &XB %À)

¨¨5À

¨¨¨ ¨¨¨¨¨¡

d

=Ô %¿)

1

5

5

5

%>) , ¦

ln (¿ %Aª )(¿ %Aª ) s+ª , ¦

W

(¿ %Aª ) W (¿ %Aª )s+ª , ¦

(¿ %Aª )s+ª

» 5À

» (¿ %Aª ) 5À

» 5À

5

,

¦ (¿ %Aª )s+ª , 0

5À ¨

» ¨¨ ¨¨¨¡

B

Jeżeli dla dowolnych + [ i À [ Á istnieje skończona pochodna 7¿r ln (¿ A oraz

Własność 2:

5d

5d

¦

(

As+

,

¦

( As+

d ¿

5À d » ¿

» 5À

7r

to X1 %À) , i¿ 60 7¿r ln (¿ A9

Dowód:

7r

i¿ ü0

5 5

5

1

5

ln (¿ Aý , i¿ :0 ?

W

( A@<

5À sÀ

5À (¿ A 5À ¿

d

5

1 5d

, i¿ ´0 þ0

(¿ A{ w

(¿ A¶

dz

(¿ A 5À d

(¿ A 5À

1

1

5

1

5d

, i¿ f

W

(¿ Ag 0 i¿ f

W

(¿ Ag , X1 %À)

(¿ A 5À

(¿ A 5À d

¨¨¨¨¨ ¨¨¨¨¨¡

¨¨¨¨¨¨ ¨¨¨¨¨¨¡

AB òC ¢

¨¨¨¨¨¨ ¨¨¨¨¨¨¡

7¿

7

7

'C ü AB òC ¢ý

7¿

¨¨¨¨ ¨¨¨¨¡

%>)KY

DÒ %C)

5

5d

5d

(

A

W

(

A

W

(

As+

,

¦

(

As+

,

¦ (¿ As+ , 0

¿

¿

d ¿

d ¿

5À d ¨¨ ¨¨¡

» (¿ A 5À

» 5À

»

%>) ¦

1

d

W

d

B

Przykład13:

Niech A , %AB , … , A1 ) będzie próbą z populacji o rozkładzie M%N), gdzie N O 0

Mamy:

Strona 22

STATYSTYKA

http://totto1.prv.pl

P 2Q N/

(Q ,

; + , 1,2, …

+!

ln (Q %+) , 0N w + ln N 0 ln +!

5

+

ln (Q %+) , 01 w

5N

N

d

5

+

ln (Q %+) , 0 d

d

5N

N

+

1

&

X1 %N) , &XB %N) , & W iQ - d . , & W d i

¡

Q %A) ,

N

N

N

Zatem:

Q

Twierdzenie 12 %Nierówność Cramera ― Rao):

Niech

A będzie estymatorem nieobciążonym o skończonej wariancji funkcji

parametrycznej %À) oraz niech 0 * X1 %À) * ∞. Wtedy:

%À)d

®¿[ë : j^k¿

A X1 %À)

oraz równość zachodzi ⇔ gdy

7

7¿

ln (¿ A , x%À)

A 0 %À)

Dowód:

Lemat %Nierówność Cauchy’ego ― Schwarza):

Jeżeli odpowiednie wartości oczekiwane istnieją, to $%&%A, v)d j^k%A)j^k%v), przy

czym równość zachodzi ⇔ gdy ¹%v , ^A w $) , 1, gdzie

$%&%A, v)

; $ , i%v) 0 ^i%A)

^,

j^k%A)

Dowód tw. 12:

Niech A ,

Zatem

7

7¿

ln (¿ A

EF %G) , i¿ ü

v ,

A

5

5

1

5

ln (¿ Aý , ¦

ln (¿ A(¿ A s+ , ¦

W

(¿ %A) W (¿ As+

5À

» 5À

» (¿ A 5À

5

5

(¿ As+ ,

¦ (¿ As+ , 0

5À ¨

» 5À

Ȭ

¨ ¨¨¨¡

,¦

KB

i¿ %A) , 0

d

5

HIJF %G) , i¿ A 0 i¿

, i¿ ü ln (¿ Aý , X³ %À)

5À

EF %K) , i¿

A , %À)

d

%A)d

HIJF %K) , j^k¿ -

A.

Strona 23

STATYSTYKA

http://totto1.prv.pl

$%&¿ %A, v) , i¿ ü

5

ln (¿ A -

A 0 %À).ý

5À

, i¿ ü

5

5

ln (¿ A

Aý 0 %À) i¿ : ln (¿ A<

¨¨ ¨¨¡

5À

5À

¨¨¨¨ ¨¨¨¨¡

¢

KY

5

1

5

,¦

ln (¿ A

A(¿ As+ , ¦

W

(¿ %A) W

A W (¿ As+

» 5À

» (¿ A 5À

5

5

, ¦

A (¿ As+ ,

¦

A(¿ As+ , 4%À)

5À

5À ¨¨¨¨ ¨¨¨¨¡

»

»

ä

¢

'C¨ ¨

¨

¨¡

Stąd:

czyli:

Ponadto:

Zatem:

L%C)

%À)d X1 %À) W j^k¿

A

j^k¿

A %À)d

X1 %À)

5

ln (¿ A , #

A w 0, gdzie

5À

$%&¿ %v, A)

%À)

#,

,

, x%À)

j^k%v)

j^k¿

A

5

0 , i¿ A 0 #i¿ %v) , i¿ ü ln (¿ Aý 0 # ¨

i¿¨ ¨

A

¨¡ , 0#%À)

¨¨¨¨ ¨¨¨¨¡

5À

KY

ä%¿)

5

ln (¿ A , x%À)

A 0 x%À)%À) , x%À)

A 0 %À)

5À

Wniosek:

Estymator nieobciążony

A funkcji parametrycznej %À) dla którego

%À)d

®¿[ë j^k¿

A ,

X1 %À)

jest Estymatorem nieobciążonym o minimalnej wariancji funkcji parametrycznej %À).

Estymatory nieobciążone, dla których spełniona jest powyższa równość nazywamy

efektywnymi w sensie Cramera – Rao.

Przykład 9 (cd.):

Niech A , %AB , … , A1 ) będzie próbą z populacji o rozkładzie M%N), gdzie N O 0

Ponadto niech B %N) , N

Niech

B A , A 0 Estymator nieobciążony dla B %N) , N %przykład 12)

Mamy:

&

%przykład 13)

X1 %N) ,

N

Strona 24

STATYSTYKA

http://totto1.prv.pl

j^kQ A ,

j^kQ %A) N

,

&

&

N B %N)d

,

&

X1 %N)

czyli

B A , A jest ENMW (efektywnym w sensie Cramera – Rao) parametru N.

Stąd:

j^kQ A ,

4.2. Estymatory największej wiarygodności

Niech A , %AB , … , A1 ) będzie próbą z populacji o rozkładzie ¹¿ z rodziny

º , ¾¹¿ : À [ Á à \8 Â

Ponadto niech rozkłady ¹¿ opisane będą za pomocą funkcji prawdopodobieństwa (lub

gęstości).

Funkcję ö określoną wzorem:

öÀ, + , (¿ A

nazywamy funkcją wiarygodności.

Estymatorem największej wiarygodności parametru À (ENW) nazywamy statystykę

ÀM+, której wartość ÀM+ spełnia warunek:

®/[» : öÀM+, + , sup öÀ, +

¿[ë

Uwaga:

Dla dowolnego parametru À, ENW może istnieć albo być wyznaczony niejednoznacznie.

Przyjmujemy, że funkcja parametryczna %À) jest statystyką

-ÀM+., gdzie ÀM+ ENW

parametru À.

Zazwyczaj wygodnie jest operować funkcją ln ö niż funkcją ö.

Przykład 9 (cd.):

Mamy A~M%N) N O 0

Zatem:

B %N) , N;

(Q %+) ,

1

d %N) , P 2Q

P 2Q N/

;

+!

1

+ , 0,1,2, …

P 2Q N¢Ñ

N1¢

21Q

öN, A , × (Q %AJ ) , ×

,P

∏1JKB AJ !

AJ !

JKB

JKB

1

ö , lnö%N, A) , 0&N w &A ln N 0 ln × AJ !

&A

5ö

, 0& w

N

5N

Strona 25

JKB

STATYSTYKA

http://totto1.prv.pl

&A

,0 ⇔N,A

N

&A

5 dö

&

5 dö

,

0

;

A , 0 * 0

d

d

d

5N

N

5N

A

N

Zatem ENW dla parametru N jest NA , A

0& w

Stąd ENW dla B %N) jest

B A , A

d %N) jest

d A , P 2¢

Wykład 9

16.04.2008r.

Niech A , %AB , … , A1 )4 będzie próbą z populacji o rozkładzie ¹¿ , gdzie À [ Á jest

parametrem.

5. ESTYMACJA PRZEDZIAŁOWA

Ponadto niech %À) [ \ będzie funkcją parametryczną.

Definicja:

Przedział -ÈB A, nd A. określony parą statystyk ÈB , Èd takich, że ¹¿ %ÈB Èd ) , 1 dla

każdego À [ Á, nazywamy przedziałem ufności dla %À) na poziomie ufności 1 0 #

%0 * # * 1), gdy:

®¿[ë : ¹¿ -ÈB A * %À) * Èd A. 1 0 #

Przykład14:

Niech A , %AB , … , A1 )4 będzie próbą z populacji o rozkładzie z wartością oczekiwaną b i

skończoną wariancją c d .

Zakładamy, że b [ \ jest parametrem, a c d jest znane.

Mamy:

¹Ø OA 0 iA

¡O N PA

¡ Ø

√1

¹Ø

1

0 z nierówności Czebyszewa

Nd

ÊA 0 bÊ

1

√& N d

c

N

ÊA 0 bÊ

1

¹Ø

√& * N 1 0 d

c

N

Strona 26

STATYSTYKA

http://totto1.prv.pl

¹Ø 0N *

¹Ø 0

Nc

√&

¹Ø A 0

A0b

1

√& * N 1 0 d

c

N

*A0b *

Nc

√&

Nc

√&

*b*Aw

10# , 10

1

Nd

10

Nc

√&

Q

1

Nd

10

N , √#

1

Nd

c

c ¹Ø A 0

*b*Aw

10#

¨

¨ ¨

#&

¨

¨ ¨

#&

√¨¡

√¨¡

àÔ ¢

àr ¢

Zatem %1 0 #) W 100% przedział ufności dla parametru b ma postać:

A 0

c

√#&

; Aw

c

√#&

Definicja:

Funkcję R -A, %À). nazywamy funkcją centralną dla %À), gdy rozkład

Konstrukcja przedziałów ufności za pomocą funkcji centralnej.

prawdopodobieństwa R -A, %À). jest absolutnie ciągły i nie zależy od parametru À.

R -A, %À). jest funkcją ciągłą i ściśle monotoniczną względem %À).

Obieramy funkcję centralną R -A, %À).

Konstrukcja:

Wybieramy stałe ^ i $ tak, aby ®¿[ë : ¹¿ -^ * R -A, %À). * $. , 1 0 #

Stałe ^, $ można dobrać na wiele sposobów. Zazwyczaj dobieramy je tak, aby

#

¹¿ %R ^) , ¹%R $) ,

2

Strona 27

STATYSTYKA

http://totto1.prv.pl

Rozwiązujemy nierówność ^ * R -A, %À). * $ względem %À) otrzymując przedział

-ÈB A, Èd A..

Przykład 10 (cd.):

A~a%b, c d ) ; b, c d 0 parametry

B %b, c d ) , b ; d %b, c d ) , c d

a) Dla B :

RA, b ,

A0b

√& ; RA, b~n%& 0 1) 0 przykład 3

¹Ø,r %R n#) ,

#

2

#

¹Ø,r %R * n#) , 1 0

2

#

#

lS %n#) , 1 0

n# , n%1 0 , & 0 1)

2

2

A0b

0n# *

√& * n#

n#

n#

0

* A 0 b √& *

√&

√&

n#

n#

A0

* b √& * A w

√&

√&

%1

zatem 0 #) W 100% przedział ufności dla b:

b) Dla d :

%>) zA 0

√&

n -1 0

#

#

, & 0 1. , A w

n -1 0 , & 0 1.{

2

2

√&

%& 0 1) d

RA, c ,

cd

d

d %&

RA, c ~

0 1) 0 tw. 3

d

Strona 28

STATYSTYKA

http://totto1.prv.pl

#

¹Ø,r %R ^) ,

2

#

lS %^) ,

2

%& 0 1) d

^*

*$

cd

%& 0 1) d

%& 0 1) d

* cd *

$

^

#

¹Ø,r %R * $) , 1 0

2

#

lS %$) , 1 0

2

#

d

$ , -1 0 , & 0 1.

2

d

Zatem %1 0 #) W 100% przedział ufności dla c ma postać

#

^ , - , & 0 1.

2

#

¹Ø,r %R $) ,

2

d

%& 0 1) d

%& 0 1) d

?

,

@

#

#

d -1 0 , & 0 1. d - , & 0 1.

2

2

Przykład 9 (cd.):

A~M%N) N O 0 0 parametr

B %N) , N ; d %N) , P 2Q

%& 100)

^) Dla B :

Q

A~a -N, 1. 0 z centralnego twierdzenia granicznego

szukamy stałych ^ i $:

RA, N ,

A0N

√&

√N

RA, N~a%0,1)

¹Q %R tT ) ,

Strona 29

#

2

STATYSTYKA

http://totto1.prv.pl

#

¹Q %R * tT ) , 1 0

2

#

lS %°T ) , 1 0

2

#

m%tT ) , 1 0

2

#

tT , t -1 0 .

2

A0N

0tT *

√& * tT

√N

ÊA 0 NÊ

√& * tT /d bo tT O 0

√N

d

A 0 N

& * tTd

N

d

&A 0 2&NA w &Nd 0 NtTd * 0

d

&Nd 0 2&A w tTd N w &A * 0

d

d

d

d

) , 2&A w tTd 0 4&d A , 4&d A w tTU w 4&AtTd 0 4&d A , tTd 4&A w tTd O 0

ÈB A ,

2&A w tTd 0 tT 4&A w tTd

2&

,Aw

4# d

# A

A tTd

0 tT V w d W A 0 t -1 0 . V

2&

& 4&

2 &

tTd

# A

A tTd

w tT V w d W A w t -1 0 . V

2&

& 4&

2

&

Zatem %1 0 #)100% przedział ufności dla par N %& 100):

Èd A , A w

# A

# A

%>>) ?max XA 0 t -1 0 . V Y , XA w t -1 0 . V Y@

2 &

2 &

Porównajmy %>) i %>>)

AZ

√&

AZ

n -1 0

/A

#

, & 0 1.

2

#

t -1 0 .

2

√&

Fakt:

%1 0 #)100% przedział ufności dla parametru N:

1

#

1

#

z d - , 2&A. , d 1 0 , 2&A w 1{

2&

2

2&

2

Przykład 5 (cd.):

^) A 0 liczba zgłoszeń

Model: A~M%N) N O 0 0 parametr

Funkcja parametryczna

]^ %_) , _

]` %_) , a2_

Estymator punktowy

1,74

0,17

Strona 30

[\% przedział ufności

%1,59; 1,89)

%0,15; 0,20)

STATYSTYKA

http://totto1.prv.pl

$) A 0 długość drogi hamowania

Model: a%b, c d ) b, c d 0 parametry

Funkcja parametryczna

]^ b, c` , _

]` b, c` , c`

Estymator punktowy

18,38

0,13

[\% przedział ufności

%18,28; 18,48)

%0,09; 0,20)

Niech A , %AB , … , A1 )4 będzie próbą z populacji o rozkładzie ( [ ¹ , ¾¹¿ : À [ ÁÂ

gdzie À jest parametrem.

6. WERYFIKACJA HIPOTEZ STATYSTYCZNYCH

Hipoteza statystyczna:

― hipoteza zerowa:

dY : ¹ [ ºY e º %À [ ÁY e Á)

― hipoteza alternatywna:

dB : ¹ [ ºB e º %À [ ÁB e Á)

ºY f ºB , g %ÁY f ÁB , g)

Definicja:

Testem statystycznym nazywamy statystykę:

¯: » ¾0,1Â

określoną następująco:

1, A [ ù

Ï

¯+ , X A , Ù

0, A [ ù

gdzie:

1 oznacza decyzję „odrzucamy hipotezę zerową dY ”

0 oznacza decyzję „nie ma podstaw do odrzucenia dY ”

Typowa postać obszaru krytycznego ù:

ù , ¾A [ »:

ÈA

ç

x

Â

¡ Błąd I rodzaju:

Odrzucamy dY , gdy jest ona prawdziwa

Błąd II rodzaju:

Przyjmujemy dY , gdy jest ona fałszywa

ô.ñuóść

îu.uõîuõJª

uðîuóôð

ô.ñuóść

Jñõuõï1.

Definicja:

Funkcję 0: Á 0,1 taką, że 0%À) , ¹¿ %A [ ù) nazywamy funkcją mocy testu.

Uwaga:

Strona 31

STATYSTYKA

http://totto1.prv.pl

òñ.ô8. lłę8m = ñó8ï.m

Îhi

iji

ik

̹¿ %A [ ù

¹¿ A

[¨¡

ù

0%À) , 1 0 ¨

¨ ¨

Í

òñ.ô8.

Ì

lłę8m == ñïę8m

Ë

RYSUNEK!!!

, À [ ÁY

, À [ ÁB Ï

Uwaga:

Zmniejszenie prawdopodobieństwa błędu I rodzaju powoduje zwiększenie

prawdopodobieństwa błędu II rodzaju (i na odwrót).

konstrukcja „optymalnego” (jednostajnie najmocniejszego) testu na poziomie istotności

# %0 * # * 1):

1. Ustalamy poziom istotności # i wyznaczamy wszystkie testy, dla których:

%>) À [ ÁY : 0%À) #

2. Wśród testów spełniających %>) wybieramy ten, dla którego:

®¿[ëÔ : 0%À) , max

6.1. Testy jednostajnie najmocniejsze.

Zakładamy, że rozkłady ¹¿ : À [ Á badanych cech A są absolutnie ciągłe z funkcją gęstości

V¿ .

Twierdzenie 14 %Lemat Neymana ― Pearsona):

Niech ù , A [ »: n

nCÔ ¢

Cr ¢

xT będzie obszarem krytycznym dla testu hipotezy zerowej

dY : À [ Á, przeciwko hipotezie alternatywnej dB : À [ Á, przy czym xT O 0 wyznaczamy z

równości:

0 %ÀY ) , #

gdzie # jest zadanym poziomem istotności.

Jeżeli ù > jest dowolnym obszarem krytycznym testu powyższej hipotezy na poziomie

istotności #, to 0 %ÀB ) 0> %ÀB )

czyli test z obszarem krytycznym ù jest najmocniejszy.

V¿ A

©0 %ÀY ) , ¹¿o A [ ù , ¹¿o

xT , #© ? ? ?

V¿ A

Dowód tw. 14:

Mamy:

Strona 32

STATYSTYKA

http://totto1.prv.pl

0 %ÀB ) 0 0> %ÀB ) q ¹¿Ô A [ ù 0 ¹¿Ô A [ ù > , ¦ V¿Ô +s+ 0 ¦ V¿Ô +s+

,¦

f>

,¦

f>

V¿Ô +s+ w ¦

f>

V¿Ô +s+ 0 ¦

, xT f¦

f>

V¿Ô +s+ 0 ¦

> 2

f>

V¿Ô +s+ ¦

V¿o +s+ 0 ¦

> 2

>

V¿Ô +s+ 0 ¦

f>

V¿o +s+g

> 2

xT V¿o +s+ 0 ¦

V¿Ô +s+

> 2

xT V¿o +s+

ß

ã

Þ

â

, xT Þ¦

V¿o +s+ w ¦ V¿o +s+ 0 ¦ V¿o +s+ w ¦

V¿o +s+â

¨¨¨¨¨¨¨¨¨¨ ¨¨¨¨¨¨¨¨¨¨¡

f>

f>

f>

> f

Þ¨¨¨¨¨¨¨¨¨ ¨¨¨¨¨¨¨¨¨¡

â

/8/

n

pr Co

pr> nCo /8/

Ý

á

%À¨Y¡) 0

%À

, xT ¹¿o + [ ù 0 ¹¿o + [ ù > , x

0¨> T Û0

¨

¨Y¡)Ü 0

sY ¨¨¨¨¨ ¨¨¨¨¨¡

KT

tT

sY

Przykład 15:

Niech A , %AB , … , A1 ) będzie próbą z populacji o rozkładzie a%b, c d ), gdzie b jest

parametrem a c d jest znane. Weryfikujemy hipotezę dY : b , bY przeciwko hipotezie

dB : b O bY

Niech dB : b , bB O bY

Zatem:

Q

bY 0 bB * 0

1

1 %+J 0 bB )d

1

d )2 d

%2Mc

VØÔ + , × VØÔ %+J ) , ×

exp Ù0

Ú

,

exp

÷0

I%+J 0 bB )d û

d

d

d

2

c

2c

√2Mc

1

JKB

stąd:

1

JKB

1

1

1

VØo + , %2Mc d )2 d exp ÷0

Strona 33

1

1

I%+J 0 bY )d û

2c d

JKB

JKB

STATYSTYKA

http://totto1.prv.pl

1 1

d

d ∑JKB%+J 0 bB ) v

2c

1

ù , X+ [ \ :

xT Y

1

exp u0 d ∑1JKB%+J 0 bY )d v

2c

1

1

1

1

d

, ÷+ [ \ : exp ÷0 d zI%+J 0 bB ) 0 I%+J 0 bY ){û xT û

2c

exp u0

JKB

1

JKB

1

, ÷+ [ \1 : I%+J 0 bB )d 0 I%xJ 0 bY )d 02c d ln%xT )û

, ÷+ [ \

1

JKB

1

: I +Jd

JKB

JKB

0 2bB &+ w

&bBd

1

0 I +Jd w 2bY &+ 0 &bYd 02c d ln xT û

JKB

, + [ \ : 2&+%bY 0 bB ) w &%bBd 0 bYd ) 02c d ln xT , + [ \1 : 2&+%bY 0 bB ) 02c d ln xT 0 &%bBd 0 bYd )

1

Î

02c d ln xT 0 &%bBd 0 bYd ){

, + [ \1 : + , + [ \1 : + xT )

2&%b

0

b

¨¨¨¨¨¨¨ ¨¨¨¨¨¨¨¡

Í

z

Y

B

x

Ë

y

Jw

Ponadto:

0 %bY ) , #

¹Øo + [ ù , #

¹Øo A xT , #

Ponieważ:

Zatem:

¹Øo A * xT , 1 0 #

l¢||o %xT ) , 1 0 #

A|dY ~a bY ,

cd

&

xT 0 bY

m

√& , 1 0 #

c

xT 0 bY

√& , t%1 0 #)

c

c

xT , bY w

t%1 0 #)

√&

c

t%1 0 #)v

M&

Ponieważ obszar krytyczny ù nie zależy od wyboru wartości bB , zatem skonstruowany test jest

jednostajnie najmocniejszy przy hipotezie alternatywnej dB : b O bY

Uwaga:

1. Równoważna postać obszaru krytycznego:

Stąd:

ù , u+ [ \1 : + bY w

Strona 34

STATYSTYKA

http://totto1.prv.pl

+ 0 bY

√& t%1 0 #)Ú

c

2. Dla hipotezy alternatywnej dB : b * bY jednostajnie najmocniejszy test ma postać:

+ 0 bY

ù , Ù+ [ \1 :

√& t%#)Ú

c

3. Dla hipotezy alternatywnej dB : b y bY jednostajnie najmocniejszy test nie istnieje!!

ù , Ù+ [ \1 :

6.2. Testy ilorazu wiarygodności

Niech A , %AB , … , A1 )4 będzie próbą z populacji o rozkładzie z rodziny º , ¾¹¿ : À [ Á à \T Â

Ponadto niech rozkłady ¹¿ z rodziny º opisane będą za pomocą funkcji

prawdopodobieństwa (lub gęstości) (¿ .

Testujemy hipotezę dY : À [ ÁY przeciwko hipotezie alternatywnej dB : À [ ÁB

Definicja:

Testem ilorazu wiarygodności nazywamy test z obszarem krytycznym

sup öÀ, +

¿[ëÔ

ù , X+ [ »:

xT Y

sup öÀ, +

¿[ëo

gdzie xT jest najmniejszą stałą taką, że ®¿[ëo : 0%À) #.

Uwaga:

Jeżeli dY i dB są hipotezami prostymi, to test ilorazu wiarygodności pokrywa się z testem

lematu Neymana – Pearsona, czyli jest najmocniejszy.

Wyznaczając test używamy równoważnego obszaru krytycznego postaci:

sup öÀ, +

¿[ëÔ

ù , X+ [ »:

xT Y

sup öÀ, +

¿[ëo

Supremum funkcji wiarygodności osiągane jest dla À , ÀM+, gdzie ÀM + jest ENW

parametru À.

Przykład16 (Test t – Studenta dla jednej próby):

Niech A , %AB , … , A1 ) będzie próbą z populacji o rozkładzie a%b, c d ),

gdzie b, c d ― parametry. Wyznaczamy test ilorazu wiarygodności hipotezy zerowej

dY : b , bY przeciwko hipotezie alternatywnej dB : b y bY

Mamy:

Á , ¾%b, c d ): b [ \, c d O 0Â

öb, c , + , %2M)

d

2

1

1

2

d %c d ) d exp ÷0

Ponadto ENW parametrów b, c mają postać:

d

Strona 35

1

1

I%+J 0 b)d û

2c d

JKB

STATYSTYKA

http://totto1.prv.pl

1

1

b̂ + , + c} , I%+J 0 b)d przykład 10 %4.2)

&

d

Zatem

sup öb, c d , + ,

%Ø,r )[ë

JKB

Î

{

1

1

Ì

1

1

&

2

d

d d

~

d

%2M)

I%+

0

+)

,

exp -0 .

J

d

2

Í 2~ ¨

z

JKB¨¨ ¨¨¨¡Ì

Ì

1(~ r

Ë

y

d

¾%b,

):

c b , bY , c O 0Â

ÁY ,

Ì

1

1

%2M)2 d %c} d )2 d exp 0

sup öb, c d + , sup öbY , c d , +

Zatem:

%Ø,r )[ë

íY

1

&

&

1

, ln öbY , c , + , 0 ln%2M) 0 ln%c d ) 0 d I%+J 0 bY )d

2c

2

2

Zatem:

d

1

&

1

5

,

0

w

I%+J 0 bY )d

2c d 2c U

5c d

JKB

JKB

1

5

, 0 &c d , I%+J 0 bY )d

5c d

cd ,

sup öbY , c d , + ,

r

1

1

2

%2M)2 d ~Yd d

1

JKB

1

I%+J 0 bY )d , ~Yd

&

JKB

ß

ã

1

1

1

&

2

Þ 1

â

exp Þ0 d I%+J 0 bY )d â , %2M)2 d ~Yd d exp -0 .

2

2~Y ¨¨¨ ¨¨¨¡

JKB

Þ

â

Ý

1(~or

á

2

&

%2M)2 d ~ d d exp -0 .

d

~Yd d

~ d

2

1

1

1 Y

1

%x

)

ù , + [ \ :

x

,

X+

[

\

:

x

Y

,

Ù+

[

\

:

Ú , %>)

T

T

T

1

1

2

&

~ d

~ d

2

d

d

~

d

%2M) Y exp -0 .

2

1

1

1

1

~Yd , I%+J 0 bY )d , I%+J 0 + w + 0 bY )d

&

&

1

JKB

1

JKB

1

1

1

1

2

, I%+J 0 +)d w %+ 0 bY ) I%+J 0 +) w %+ 0 bY )d , ~ d w %+ 0 bY )d

&

¨¨¨ ¨¨¨¡ &

¨¨¨ ¨¨¨¡

JKB

(~ r

JKB

∑

/Ñ 21/

ì

¨

¨ ¨

¨¡

Ò

Óo

Strona 36

STATYSTYKA

http://totto1.prv.pl

d

d

%+ 0 bY )d

~ d w %+ 0 bY )d

1

1

1Ú

%>) , Ù+ [ \ :

%x

)

%x

)

Ú

,

Ù+

[

\

:

1

w

T

T

~ d

~ d

1

, Ù+ [ \1 :

1

d

d

%+ 0 bY )d

|+ 0 bY |

1

1

1

%x

)

%x

)

0

1Ú

,

÷+

[

\

:

0 1û , %>>)

T

T

~ d

~

1

1

&01

1

&01 d

W

I%+J 0 +)d ,

, I%+J 0 +)d ,

&

&

&01

&

~d

JKB

JKB

Î

{

Ì

Ì

d

|+

|

0

b

Y

%>>) , ÷+ [ \1 :

0 1û , + [ \1 :

√& √& V%& 0 1) %xT )1 0 1

Í

√& 0 1 W

¨¨¨¨¨¨ ¨¨¨¨¨¨¡z

Ì

Ì

x

Ë

Jw

y

|+ 0 bY |

ù , Ù+ [ \1 :

√& xT Ú

|+ 0 bY |

0%bY ) #

¹Øo ÊÈ+Ê xT #

d

%x )1

T

+

Ï 0 bY √ & O

¨¨ ¨

¨¡

óï1. à

|o

~n%& 0 1)

%przykład 3)

¹Øo ÊÈ+Ê * xT 1 0 #

¹Øo 0xT * È+ * xT 1 0 #

là||o %xT ) 0 là||o %0xT ) 1 0 #

là||o %xT ) 0 1 w là||o %xT ) 1 0 #

2là||o %xT ) 2 0 #

là||o %xT ) 1 0 d

T

xT n%1 0 d , & 0 1)

T

Zatem:

ù , Ù+ [ \1 :

|+ 0 bY |

#

√& n -1 0 , & 0 1.Ú

2

Uwaga:

Dla hipotezy alternatywnej dB : b O bY obszar krytyczny ma postać:

+ 0 bY

ù , Ù+ [ \1 :

√& n%1 0 #, & 0 1)Ú

Dla hipotezy alternatywnej dB : b * bY obszar krytyczny ma postać:

+ 0 bY

ù , Ù+ [ \1 :

√& n%#, & 0 1)Ú

Przykład 5b (cd.):

Na poziomie istotności # , 0,05 zweryfikujmy hipotezę głoszącą, że średnia długość

hamowania dla samochodu wyposażonego w nowy typ układu hamulcowego jest

istotnie krótsza niż w poprzednio stosowanym typie (wynosiła ona wtedy 18,6 [m]).

A 0 długość drogi hamowania

Strona 37

STATYSTYKA

http://totto1.prv.pl

Model: A~a%b, c d ); µ, σd 0 parametry

Formułujemy hipotezy:

d : b , 18,6Ï

Y

dB : b * 18,6

& , 50 ; A , 18,38

Wartość statystyki testowej:

A 0 bY

18,38 0 18,6

W √50 W 04,32

√& ,

√0,13

Wartość krytyczna:

n%#, & 0 1) , n%0,05,49) , 0n%0,95,49) , 01,677

Decyzja:

Odrzucamy hipotezę dY .

Przykład 17 Test ` dla wariancji w jednej próbie:

Niech A , %AB , … , A1 ) %& O 1) będzie próbą z populacji o rozkładzie a%b, c d ), gdzie b, c d

― parametry. Weryfikujemy hipotezę zerową dY : c d , cYd

Statystyka testowa: d ,

%12B)( r

or

d

Rozkład statystyki testowej || Y ~ d %& 0 1)

Obszary krytyczne:

1. dB : c d y cYd

ù , u+ [ \1 : d + d -1 0

2. dB : c d * cYd

3. dB : c d * cYd

Wykład 11

26.03.2008r.

#

#

, & 0 1. lub d + - , & 0 1.v

2

2

ù , ¾+ [ \1 : d + d %1 0 #, & 0 1)

ù , + [ \1 : d + d %#, & 0 1)

Przykład 18 (Test t – Studenta dla dwóch prób):

Niech AB , %ABB , … , AB³ ) ; Ad , %AdB , … , Ad1 ) %_, & O 1) będą niezależnymi próbami z

populacji o rozkładach a%bB , c d ); a%bd , c d ) odpowiednio, gdzie bB , bd , c d 0 parametry

Weryfikujemy hipotezę zerową: dY : bB , bd przeciwko hipotezie alternatywnej

dB : bB y bd

Strona 38