Wrocław University of Technology

SPOTKANIE 4:

Podstawowe rozkłady prawdopodobieństwa

Maciej Zięba

Studenckie Koło Naukowe ”Estymator”

[email protected]

27.10.2015

Pojęcie prawdopodobieństwa

Prawdopodobieństwo reprezentuje pewne przekonanie

dotyczące zjawisk.

Przekonanie to wyraża się pewną wartością rzeczywistą

z przedziału [0, 1].

Suma przekonań odnośnie wszystkich możliwych

zdarzeń jest równa 1.

Możliwe zdarzenia reprezentowane są za pomocą

zmiennej losowej X.

Przykład: rzut kostką sześcienną

X = {1, 2, 3, 4, 5, 6},

2/29

Interpretacja częstościowa prawdopodobieństwa

Rzuciłem kostką 15 razy:

3

2

2

3

2

3

razy

razy

razy

razy

razy

razy

wypadła

wypadła

wypadła

wypadła

wypadła

wypadła

”1”

”2”,

”3”

”4”,

”5”,

”6”.

Prawdopodobieństwo wylosowania ”6”

jest równe:

p(X = 6) = p(6) =

3

1

= .

15

5

3/29

Bayesowska interpretacja prawdopodobieństwa

Mamy informację, że ze względu na

własności fizyczne kostek

prawdopodobieństwo wylosowania ”6”

jest równe 16 .

Dla jednej na pięć kostek

wykorzystywanych w kasynach

prawdopodobieństwo wylosowania ”6”

równe 13 .

Prawdopodobieństwo wylosowania ”6”

jest równe:

p(6) =

1

4 1 1 1

· + · = .

5 6 5 3

5

4/29

Dyskretne zmienne losowe

Zbiór możliwych wartości X jest co

najwyżej przeliczalny.

Suma prawdopodobieństw równa się 1:

X

p(X = x) =

x∈X

X

p(x) = 1.

x∈X

Dla podzbioru A ⊆ X :

X

x∈A

p(x) = 1 −

X

p(x),

x∈¬A

gdzie ¬A stanowi dopełnienie zbioru A.

5/29

Ciągłe zmienne losowe

Rozkład opisuje funkcją gęstości p(x).

Prawdopodobieństwo X ∈ [a, b]:

p(a ¬ X ¬ b) =

Zb

p(x)dx

a

Dystrybuanta:

p(X ¬ b) = P (b) =

Zb

p(x)dx

−∞

Funkcja gęstości spełnia

reguły:

R

brzegową: p(x) = p(x, y)dy

łańcuchową: p(x, y) = p(x|y)p(y)

6/29

Wartość oczekiwana

Typową własnością rozkładu jest wartość oczekiwana

(średnia), którą dla rozkładu dyskretnego definiuje się

następująco:

E[X] =

X

x · p(x),

x∈X

dla rozkładu ciągłego definiuje się następująco:

E[X] =

Z

x · p(x)dx,

x∈X

Wartość oczekiwana dla rzutu monetą:

E[X] = 1 · θ + 0 · (1 − θ) = θ.

7/29

Wariancja i odchylenie standardowe

Wariancja jest własnością która opisuje rozpiętość

rozkładu (jak bardzo odchylają się wartości x od średniej)

i definiuje się następująco:

V ar[X] = E[(X − E[X])2 ] = E[X 2 ] − (E[X])2

Odchylenie standardowe definiowane jest jako

pierwiastek z wariancji:

std[X] =

q

V ar[X]

Wariancja dla rzutu monetą:

V ar[X] = θ · (1 − θ).

8/29

Korelacja i kowariancja

Miarą liniowej zależności pomiędzy zmienną losową X i

Y jest kowariancja zadana wzorem:

cov[X, Y ] = E[(X − E[X])(Y − E[Y ])]

= E[XY ] − E[X]E[Y ].

Kowariancja przyjmuje wartości z przedziału

(−∞, ∞), w praktyce wygodniej jest operować na

znormalizowanej postaci kowariancji nazywanej

korelacją:

cov[X, Y ]

,

corr[X, Y ] = q

V ar[X]V ar[Y ]

która przyjmuje wartości z przedziału [−1, 1].

9/29

Korelacja i kowariancja

10/29

Rozkład dwupunktowy

:

Zmienna losowa X ∼ Ber(θ) przyjmuje wartości ze

zbioru: X = {0, 1}.

Funkcja rozkładu prawdopodobieństwa:

Ber(x|θ) = θI(x=1) (1 − θ)I(x=0) = θx (1 − θ)1−x

Rozkład ma interpretację pojedynczego rzutu monetą.

Parametr θ reprezentuje prawdopodobieństwo sukcesu

w rzucie monetą.

Podstawowe własności rozkładu:

E[X] = θ, V ar[X] = θ · (1 − θ).

11/29

Rozkład wielopunktowy

Wektory binarnych zmiennych losowych spełniające

P

warunek K

i=1 xi = 1.

Funkcja rozkładu prawdopodobieństwa:

Cat(x, θ) =

K

Y

I(xi =1)

θi

i=1

Rozkład ma interpretację rzutu K-wymiarową kostką.

Parametr θi reprezentuje prawdopodobieństwo

wypadnięcia i oczek.

Podstawowe własności rozkładu:

E[Xj ] = θj , V ar[Xj ] = θj · (1 − θj ), cov[Xj , Xi ] = −θj θi

12/29

Rozkład jednostajny

Funkcja gęstości:

p(x) =

1

, x ∈ [a, b],

0,

w.p.p.

b−a

Podstawowe własności rozkładu:

E[X] =

funkcja gęstości

dystrybuanta

(b − a)2

a+b

, V ar[X] =

.

2

12

13/29

Rozkład Gaussa

Funkcja gęstości:

N (x|µ, σ 2 ) = √

(x−µ)2

1

e− 2σ2

2πσ 2

Podstawowe własności rozkładu:

E[X] = µ, V ar[X] = σ 2 .

14/29

Wielowymiarowy rozkład Gaussa

Funkcja gęstości:

N (x|µ, Σ) =

1

q

(2π)K/2 |Σ|−1

e−(x−µ)

T Σ−1 (x−µ)

Podstawowe własności rozkładu:

E[X] = µ, cov[X] = Σ.

Istotną własnością rozkładu jest

macierz precyzji Λ = Σ−1 .

15/29

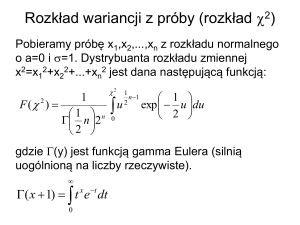

Rozkład Gamma

Funkcja gęstości:

Ga(x|a, b) =

Γ(b) =

Z∞

ba a−1 −bx

x e ,

Γ(b)

ub−1 e−u du.

0

Podstawowe własności rozkładu:

a

a

E[X] = , V ar[X] = 2 .

b

b

16/29

Rozkład Beta

Funkcja gęstości:

Beta(x|a, b) =

xa−1 (1 − x)b−1

,

B(a, b)

B(a, b) =

Γ(a)Γ(b)

Γ(a + b)

Podstawowe własności rozkładu:

E[X] =

V ar[X] =

a

a+b

ab

(a +

b)2 (a

+ b + 1)

.

17/29

Funkcja wiarygodności

Dysponujemy danymi

D = {(xn )}N

n=1 .

Rozpatrujemy model, który

generuje dane z pewnego rozkładu

p(x|θ).

Funkcję wiarygodności (ang.

likelihood function) definiuje się

następująco:

p(D|θ) =

N

Y

p(xn |θ).

n=1

18/29

Funkcja wiarygodności

Dysponujemy ciągiem obserwacji dotyczących

rzutu monetą D = {o, o, o, r, r, o, r, o, r}

Chcemy ocenić, czy bardziej wiarygodne jest,

że dane zostały wygenerowane:

z rozkładu Ber(x|0.5),

czy też z rozkładu Ber(x|0.75).

Wartości funkcji wiarygodności Ber(D|θ)

dla rozkładów wynoszą:

Ber(D|0.5) = 0.59 = 0.001953125,

Ber(D|0.75) = 0.754 · 0.255 = 0.00030899.

19/29

Funkcja wiarygodności

Dysponujemy ciągiem obserwacji dotyczących

rzutu monetą D = {o, o, o, r, r, o, r, o, r}

Chcemy ocenić, czy bardziej wiarygodne jest,

że dane zostały wygenerowane:

z rozkładu Ber(x|0.5),

czy też z rozkładu Ber(x|0.75).

Wartości funkcji wiarygodności Ber(D|θ)

dla rozkładów wynoszą:

Ber(D|0.5) = 0.59 = 0.001953125,

Ber(D|0.75) = 0.754 · 0.255 = 0.00030899.

19/29

Funkcja wiarygodności

Dysponujemy ciągiem obserwacji

D = {0.24, 0.32, 0.21, −0.2, −0.87,

0.23, −0.12, 0.01}

Chcemy ocenić, czy bardziej wiarygodne jest,

że dane zostały wygenerowane:

z rozkładu N (0, 1),

czy też z rozkładu N (1, 0.1).

Wartości funkcji wiarygodności

N (D|0, 1) = 0.00037608,

N (D|1, 0.1) = 2.15 · 10−20 .

20/29

Funkcja wiarygodności

Dysponujemy ciągiem obserwacji

D = {0.24, 0.32, 0.21, −0.2, −0.87,

0.23, −0.12, 0.01}

Chcemy ocenić, czy bardziej wiarygodne jest,

że dane zostały wygenerowane:

z rozkładu N (0, 1),

czy też z rozkładu N (1, 0.1).

Wartości funkcji wiarygodności

N (D|0, 1) = 0.00037608,

N (D|1, 0.1) = 2.15 · 10−20 .

20/29

Estymator maksymalnej wiarygodności

Interesuje nas znalezienie modelu o

najwyższej wiarygodności.

Formalnie, zadanie to formułujemy jako

zadanie optymalizacji:

θ̂ M LE = arg max p(D|θ)

θ

= arg max

θ

N

Y

p(xn |θ),

n=1

gdzie θ̂ M LE nazywany jest estymatorem

maksymalnej wiarygodności (ang.

maximal likelihood estimate, MLE).

21/29

Estymator maksymalnej wiarygodności

W praktyce definiuje się alternatywne

zadanie optymalizacji:

θ̂ M LE = arg min − log p(D|θ)

θ

= arg min

θ

N

X

− log p(xn |θ).

n=1

Okazuje się, że operacja logarytmu nie

zmienia położenia punktu

optymalnego!

22/29

Estymator maksymalnej wiarygodności

Negatywny logarytm z funkcji wiarygodności:

− log Ber(D|θ) = −

N

X

{xn log θ + (1 − xn ) log(1 − θ)}

n=1

= −m log θ − (N − m) log(1 − θ)

gdzie m oznacza liczbę sukcesów.

Estymator MLE:

θM LE =

m

,

N

23/29

Estymator maksymalnej wiarygodności

Negatywny logarytm z funkcji wiarygodności:

− log N (D|µ, σ 2 ) = −

N

N

1 X

N

(xn − µ)2 − log σ 2 − log 2π

2

2σ n=1

2

2

Estymator MLE parametru µ jest równy:

µM LE =

N

1 X

xn

N n=1

Estymator MLE parametru σ 2 :

2

σM

LE =

N

1 X

(xn − µM LE )2

N n=1

24/29

Estymator maksymalnego a posteriori

Załóżmy, że dysponujemy ciągiem obserwacji dotyczących

rzutu monetą D = {r, r, r, r, r}.

Jeżeli wykonamy estymację parametrów MLE parametru

θ wówczas:

θM LE =

5

m

= = 1.

N

5

W rezultacie otrzymujemy rozkład dwupunktowy dla

którego prawdopodobieństwo sukcesu 1.

W celu rozwiązania tego problemu załóżmy, że parametr

θ charakteryzuje się niepewnością.

25/29

Estymator maksymalnego a posteriori

Formalnie, zadanie to formułujemy jako zadanie

optymalizacji:

θ̂ M AP = arg max p(θ|D),

θ

gdzie θ̂ M AP nazywany jest estymatorem maksymalnego a

posteriori (ang. maximal a posteriori estimate, MAP).

Korzystając z reguły Bayesa ostatecznie mamy:

θ̂ M AP = arg max p(θ)p(D|θ).

θ

26/29

Estymator maksymalnego a posteriori

Wprowadźmy rozkład na parametr θ:

Beta(θ|a, b) =

Γ(a + b) a−1

θ (1 − θ)b−1 .

Γ(a)Γ(b)

Wówczas mamy dla rozkładu a posteriori:

p(θ|D) ∝

Γ(a + b + N ) m+a−1

θ

(1 − θ)l+b−1 ,

Γ(a + m)Γ(b + l)

gdzie l = N − m.

Estymator MAP:

θ̂M AP =

m+a−1

N +a+b−2

27/29

Uczenie Bayesowskie i częstościowe

W przypadku podejścia częstościowego konstrukcja

rozkładu przebiega następująco:

W pierwszym kroku wykonywana jest estymacja θ̂.

W drugim kroku ”wstawiamy” estymator θ̂ do rozkładu:

p(x|D) = p(x|θ̂)

W przypadku podejścia Bayesowskiego następuje

wycałkowanie względem parametrów θ:

p(x|D) =

Z

p(x|θ)p(θ|D)dθ

28/29

Uczenie Bayesowskie

Przykład

Interesuje nas znalezienie p(x = r|D):

p(x = r|D) =

Z1

Przykład:

p(x = r|θ)p(θ|D)dθ

0

=

Z1

0

θp(θ|D)dθ =

m+a

N +a+b

D=

{r, r, r, r, r, o, r}

a = 2, b = 3

6

7

7

=

10

θM LE =

m

N

m+a−1

θ̂M AP =

N +a+b−2

m+a

p(x = r|D) =

N +a+b

θM LE =

θ̂M AP

p(x = r|D) =

2

3

29/29