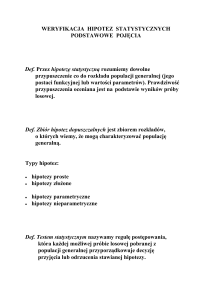

Hipotezy statystyczne

Definicja, sformułowanie i

weryfikacja

Autor: Janusz Górczyński

1

Definicja

Hipotezą statystyczną jest dowolne zdanie orzekające o

parametrach populacji lub jej rozkładzie. Prawdziwość hipotezy

jest oceniana na podstawie wyników próby losowej.

Hipoteza statystyczna może orzekać o parametrach populacji i

takie hipotezy nazywamy hipotezami parametrycznymi.

Pozostałe hipotezy statystyczne (te, które nie dotyczą

parametrów), nazywamy hipotezami nieparametrycznymi.

Autor: Janusz Górczyński

2

Hipotezy parametryczne

Przykład 1.

Interesuje nas wydajność pracy pracowników pewnego

zakładu produkcyjnego. Zakładamy, że modelem tej cechy

może być zmienna losowa normalna o nieznanych

parametrach m i .

Przypuszczamy, że średnia wydajność (w populacji) jest

równa znanej wartości m0. Tym samym sformułowaliśmy

hipotezę statystyczną dotyczącą parametru m:

H0 : m m0

Autor: Janusz Górczyński

3

Hipotezy nieparametryczne

Przykład 2.

W poprzednim przykładzie założyliśmy, że interesująca nas

cecha (wydajność pracy pracowników) może być

modelowana zmienną losową normalną. Możemy więc

sformułować hipotezę dotyczącą rozkładu tej cechy:

H0 : X ~ N (m; )

Autor: Janusz Górczyński

4

Weryfikacja hipotezy

Hipoteza statystyczna musi być na podstawie wyników próby

zweryfikowana.

Testem statystycznym nazywamy regułę postępowania,

która każdej możliwej próbie przyporządkowuje decyzję

odrzucenia hipotezy lub nie daje podstaw do podjęcia takiej

decyzji.

Proces weryfikacji hipotezy statystycznej obejmuje z jednej

strony jej sformułowanie (jako tzw. hipotezy zerowej), z

drugiej strony musimy sformułować hipotezę alternatywną

oznaczaną z reguły symbolem H1.

Autor: Janusz Górczyński

5

Weryfikacja hipotez statystycznych

Rozpatrzmy hipotezę parametryczną z przykładu 1, gdzie

wypowiadaliśmy się o możliwej wartości średniej

generalnej. Odpowiednią hipotezę zerową i alternatywną

możemy zapisać jako:

H0 : m m0 H1: m m0

Na podstawie wyników próby losowej chcemy teraz

skonstruować taki test statystyczny, który da możliwość

podjęcia decyzji co do prawdziwości hipotezy zerowej.

Autor: Janusz Górczyński

6

Weryfikacja hipotez statystycznych (c.d.)

Przy konstrukcji testu skorzystamy z faktu, że statystyka:

x m0

t

sx

ma, przy prawdziwości H0:m=m0, rozkład t-Studenta z liczbą

stopni swobody v = n - 1.

Załóżmy, że H0:m=m0 jest prawdziwa.

Jeżeli tak, to m m0 = 0 oraz x m0 0 (ponieważ x m

).

Tym samym wartość statystyki t powinna niewiele odbiegać

od zera (jeżeli H0 jest prawdziwa).

Autor: Janusz Górczyński

7

Weryfikacja hipotez statystycznych (c.d.)

W sytuacji, gdy wartości statystyki t będą odbiegać od zera

dość znacznie, to powinniśmy zacząć wątpić w prawdziwość

naszego założenia (o tym, że m m0 ).

Pozostaje do rozstrzygnięcia kwestia, kiedy można uznać, że

wyniki naszej próby świadczą przeciwko prawdziwości hipotezy zerowej. Wykorzystamy do tego celu fakt, że dla każdego

x m0

t

sx

znajdziemy taką wartość t ,v , dla której spełniona jest

równość

P ( t t , v )

Autor: Janusz Górczyński

8

Weryfikacja hipotez statystycznych (c.d.)

Tym samym wartość t ,v wyznacza nam obszar krytyczny

dla naszej hipotezy H0:

( ; t ,v ) (t ,v ; )

Jeżeli wartość empiryczna statystyki t znajdzie się w tym

obszarze, to H0 musimy odrzucić jako zbyt mało

prawdopodobną.

Obszar ( t ,v ; t ,v ) jest obszarem dopuszczalnym dla H0 ,

mówimy, że wyniki naszej próby nie przeczą hipotezie zerowej.

Proszę zauważyć, że nie jest to równoważne zdaniu, że hipoteza

zerowa jest prawdziwa! (my jej tylko nie możemy odrzucić).

Autor: Janusz Górczyński

9

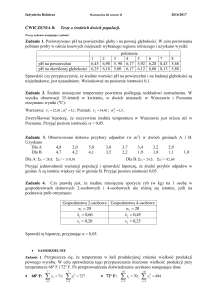

Błędy weryfikacji

Wyniki próby mogą być takie, że uznamy za fałszywą i

odrzucimy hipotezę H0 , która w rzeczywistości jest

prawdziwa. Jest to tzw. błąd I rodzaju, a prawdopodobieństwo jego popełnienia jest równe .

Możliwa jest także sytuacja odwrotna: wyniki próby nie

pozwoliły na odrzucenie H0 , która w rzeczywistości była

fałszywa. Popełniamy wtedy tzw. błąd II rodzaju, a jego

prawdopodobieństwo jest równe .

Zwiększenie liczebności próby powoduje zmniejszenie

prawdopodobieństwa .

Autor: Janusz Górczyński

10

Błędy weryfikacji cd.

Brak podstaw do

odrzucenia H0

1

P-stwo

Błąd I rodzaju

P-stwo

Błąd II rodzaju

P-stwo 1

Moc testu

H0 prawdziwa P-stwo

H0 fałszywa

Odrzucenie H0

Autor: Janusz Górczyński

11

Hipoteza o średniej generalnej m

Niech zmienna losowa X ma rozkład normalny o nieznanych

parametrach m i . Na podstawie n-elementowej próby

losowej chcemy zweryfikować hipotezę zerową H0 : m m0

wobec alternatywy H1: m m0

Procedura testowa:

1. Ustalamy poziom istotności

2. Obliczamy wartość empiryczną statystyki t-Studenta

x m0

temp.

Sx

3. Odczytujemy z tablic statystycznych wartość krytyczną

statystyki t ,v n 1

Autor: Janusz Górczyński

12

Hipoteza o średniej generalnej m (c.d)

Wnioskowanie:

Jeżeli t emp. t ,v , to H0 odrzucamy na korzyść H1.

Jeżeli t emp. t ,v , to nie mamy podstaw do odrzucenia

H0.

Autor: Janusz Górczyński

13

Hipoteza o średniej generalnej m (c.d.)

Hipoteza H0 : m m0 może być także weryfikowana przy

inaczej skonstruowanej hipotezie alternatywnej ( H1: m m0

lub H1: m m0 ). Procedura weryfikacyjna przebiega

podobnie, zmienia się tylko obszar krytyczny:

Hipoteza zerowa

Alternatywa (jednostronna)

H0 : m m0

H1: m m0

Obszar krytyczny

( , t2 ,v )

(t2 ,v , )

H0 odrzucamy, jeżeli:

temp t2 ,v

temp t2 ,v

Autor: Janusz Górczyński

H1: m m0

14

Hipoteza o równości dwóch średnich

generalnych

Niech X 1 ~ N (m1 ; ) oraz X 2 ~ N (m2 ; ) . Na podstawie

odpowiednich prób losowych chcemy zweryfikować hipotezę:

H0 : m1 m2 wobec H1: m1 m2

Procedura testowa:

1. Ustalamy poziom istotności

2. Obliczamy wartość empiryczną statystyki t-Studenta

t emp.

x1 x2

sr

3. Odczytujemy z tablic statystycznych wartość krytyczną

statystyki t

,v n1 n2 2

Autor: Janusz Górczyński

15

Hipoteza o równości dwóch średnich

generalnych (c.d.)

Wnioskowanie o prawdziwości

H0 : m1 m2 wobec H1: m1 m2

Jeżeli t emp. t ,v , to H0 odrzucamy jako zbyt mało

prawdopodobną.

Jeżeli

t emp. t ,v , to nie mamy podstaw do odrzucenia H0.

Autor: Janusz Górczyński

16

Hipoteza o różnicy średnich generalnych

(c.d.)

Niech X 1 ~ N (m1 ; ) oraz X 2 ~ N (m2 ; ) . Na podstawie

odpowiednich prób losowych chcemy zweryfikować

hipotezę: H0 : m1 m2

Hipoteza alternatywna może być jednostronna ( H1: m1 m2

lub H1: m1 m2 )

Procedura testowa przebiega podobnie jak poprzednio,

zmieniają się jedynie obszary krytyczne.

Hipoteza zerowa

Hipotezy alternatywne

H1: m1 m2

H1: m1 m2

H0 : m1 m2

Obszar krytyczny

( , t2 ,v )

Autor: Janusz Górczyński

(t2 ,v , )

17

Inny sposób weryfikacji hipotezy o

równości średnich. NIR

Hipoteza

H0 : m1 m2

odrzucana wtedy, gdy:

przy

H1: m1 m2

jest

t emp. t ,v

x1 x2

x1 x2

t ,v

t ,v x1 x2 t ,v sr

sr

sr

Iloczyn t ,v sr nazywamy najmniejszą istotną różnicą

(least significant difference) i oznaczamy skrótem NIR

(LSD).

Autor: Janusz Górczyński

18

Najmniejsza istotna różnica

Hipotezę H0 : m1 m2 przy alternatywie H1: m1 m2 będziemy

odrzucać wtedy, gdy:

x1 x2 NIR

NIR (LSD) jest taką różnicą wartości danej cechy w dwóch

populacjach, którą jeszcze można uznać za losową

(przypadkową).

Różnice większe od NIR są już spowodowane własnościami

danych populacji (nie są przypadkowe).

Autor: Janusz Górczyński

19

Test istotności dla frakcji

Niech zmienna X ma w populacji rozkład zero-jedynkowy z

prawdopodobieństwem sukcesu p. Parametr ten można

interpretować jako wskaźnik struktury w populacji.

Interesuje nas weryfikacja hipotezy zerowej:

H0 : p p0 wobec H1: p p0

Procedura weryfikacyjna wykorzystuje rozkład N(0, 1):

1. Obliczamy zemp.

2. H0 odrzucamy, jeżeli

p p0

p (1 p )

n

gdzie

k

p

n

zemp. z

Autor: Janusz Górczyński

20

Test istotności dla różnicy frakcji

Rozważmy dwie zmienne zero-jedynkowe z parametrami

odpowiednio p1 i p2. Interesuje nas weryfikacja H0 : p1 p2

przy alternatywie H1: p1 p2 .

k

Niech p1 1 oraz p 2 k 2 oznaczają odpowiednio frakcje

n1

n2

elementów wyróżnionych w obu próbach.

Wiadomo, że

p (1 p1 ) p2 (1 p2 )

p1 p 2 ~ N p1 p2 ; 1

n1

n2

Jeżeli H0 : p1 p2 p jest prawdziwa, to

1 1

p1 p 2 ~ N 0; p(1 p)

n1 n2

gdzie p oznacza wspólną wartość dla obu zmiennych.

Autor: Janusz Górczyński

21

Test istotności dla różnicy frakcji (c.d.)

Jako ocenę wspólnego prawdopodobieństwa sukcesu dla obu

zmiennych przyjmuje się wyrażenie:

k1 k 2

p

n1 n2

Ostatecznie statystyka

zemp

p1 p 2

1 1

p (1 p )

n1 n2

ma rozkład N(0, 1).

Hipotezę H0 : p1 p2 przy H1: p1 p2

jeżeli

odrzucamy,

zemp. z

Autor: Janusz Górczyński

22

Test istotności dla wariancji

2

Niech X ~ N (m; ) , interesuje nas weryfikacja hipotezy

2

2

2

2

przy

alternatywie

.

H

:

H0 : 0

1

0

W praktyce nie formułuje się H1 jako dwustronnej czy

lewostronnej, co wynika z faktu, że duża wariancja jest

niekorzystna.

Weryfikację hipotezy zerowej przeprowadzamy w oparciu o nelementową próbę wykorzystując fakt, że statystyka

(n 1) s2

2

ma rozkład

2

z liczbą stopni swobody v = n – 1.

Autor: Janusz Górczyński

23

Test istotności dla wariancji (c.d.)

(n 1) s2

2

Jeżeli prawdziwa jest H0, to statystyka emp

20

ma rozkład 2 z liczbą stopni swobody v = n - 1.

Wnioskowanie:

2

2

Jeżeli emp ,v n1 , to H0 odrzucamy na korzyść H1.

2

2

Jeżeli emp ,v n1 , to nie mamy podstaw do odrzucenia

H0 .

Autor: Janusz Górczyński

24

Test istotności dla dwóch wariancji

Niech X1 ~ N (m1; 1 ) oraz X 2 ~ N .(m2 ; 2 )

Na podstawie odpowiednich prób losowych chcemy

2

2

zweryfikować H0 : 12 22 przy alternatywie H1: 1 2

Statystyka

F

s12

12

s22

22

ma rozkład Fishera-Snedecora z liczbami stopni swobody

u n1 1 oraz v n2 1

.

Autor: Janusz Górczyński

.

25

Test istotności dla dwóch wariancji (c.d.)

Jeżeli H0 : 12 22 jest prawdziwa, to również statystyka

2

1

2

2

s

F

s

ma rozkład Fishera-Snedecora z liczbami stopni swobody

u n1 1 oraz v n2 1 .

Z uwagi na konstrukcję tablic statystycznych, które zawierają

wartości tylko dla prawostronnego obszaru krytycznego,

wartość empiryczną statystyki F budujemy tak, aby była

większa od 1 (w liczniku umieszczamy większą wariancję z

próby).

Autor: Janusz Górczyński

26

Test istotności dla dwóch wariancji (c.d.)

Wnioskowanie:

s12

1. Obliczamy wartość empiryczną statystyki Femp 2

s2

2. Dla ustalonego odczytujemy z tablic wartość krytyczną

F ,u ,v gdzie u i v są odpowiednio liczbami stopni swobody

dla średnich kwadratów w liczniku i mianowniku.

3. Jeżeli

Femp F ,u ,v

, to H0 : 12 22 odrzucamy na

korzyść H1: 12 22

Autor: Janusz Górczyński

27

Hipotezy nieparametryczne

Hipotezy tego typu dotyczą z reguły zgodności rozkładu

empirycznego z rozkładem określonym przez hipotezę lub

zgodności rozkładów pewnej cechy w kilku populacjach bez

określania, o jaki rozkład chodzi. Z tego też powodu testy

służące do weryfikacji takich hipotez nazywamy testami

zgodności.

Do najczęściej stosowanych testów zgodności należą:

2 (chi-kwadrat) Pearsona

(lambda) Kołmogorowa-Smirnowa

w Shapiro-Wilka

Autor: Janusz Górczyński

28

Test zgodności

2

Niech hipotezą zerową będzie przypuszczenie, że cecha X ma

w populacji rozkład określony dystrybuantą F0(x):

H0 : F ( x ) F0 ( x )

wobec H1: F ( x ) F0 ( x )

Statystyka

(n n t ) 2

2

j

j

j

n tj

2

przy prawdziwości H0 ma asymptotyczny rozkład z

liczbą stopni swobody v = k -u - 1.

Autor: Janusz Górczyński

29

Test zgodności

2

(c.d.)

t

n

Wielkość

j np j jest teoretyczną liczebnością w j-tym

przedziale, k jest liczbą przedziałów klasowych, a u liczbą

parametrów szacowanych z próby.

Wartość empiryczną statystyki

2emp

j

(n j ntj ) 2

ntj

porównujemy z wartością krytyczną ,v k u 1

wnioskując analogicznie jak w pozostałych hipotezach.

2

Autor: Janusz Górczyński

30

Test zgodności Chi-kwadrat

Elementem kluczowym przy wykorzystaniu statystyki Chikwadrat jest wielkość

p P( x ( x1 j ; x2 j ))

t

j

Która jest teoretycznym prawdopodobieństwem

wystąpienia obserwacji w j-tym przedziale przy

założeniu prawdziwości H0.

Autor: Janusz Górczyński

31

Test 2 zgodności kilku rozkładów

Obserwujemy tę samą cechę w kilku populacjach. Interesuje

nas odpowiedź na pytanie, czy rozkłady te są takie same (co

pociąga za sobą równość parametrów!).

Jeżeli dystrybuantę danej cechy w i-tej populacji oznaczymy

jako Fi, to hipoteza zerowa ma postać:

H0 : F1 F2 ... Fk

Zastosowanie testu 2 wymaga zestawienia próby w postaci

tabeli dwukierunkowej. W jednym kierunku umieszczamy

poziomy danej cechy, w drugim populacje.

Autor: Janusz Górczyński

32

Test 2 zgodności kilku rozkładów (c.d.)

Klasy

cechy X

1

2

:

r

1

n11

n12

n1r

Numer populacji

2

....

n21

....

n22

....

nij

n2r

....

k

nk1

nk2

nkr

Autor: Janusz Górczyński

33

Test 2 zgodności kilku rozkładów (c.d.)

k

Statystyka testowa ma postać:

r

2

i 1 j 1

gdzie n

t

ij

n

ij

t 2

ij

n

nijt

ni n j

n

Przy prawdziwości H0 statystyka ta ma rozkład 2 Pearsona z

liczbą stopni swobody v=(k-1)(r-1).

Wnioskowanie przebiega analogicznie jak przy innych

hipotezach.

Autor: Janusz Górczyński

34

Podejmowanie decyzji weryfikacyjnych na

podstawie krytycznego poziomu istotności

Dotychczas podejmowaliśmy decyzje weryfikacyjne poprzez

zbadanie, czy wartość empiryczna statystyki testowej

znajduje się w obszarze krytycznym danej hipotezy (przy z

góry ustalonym poziomie istotności ).

W pakietach statystycznych stosuje się inne podejście

polegające na obliczeniu dla konkretnej statystyki z próby

prawdopodobieństwa odrzucenia hipotezy zerowej.

Prześledźmy to na przykładzie weryfikacji hipotezy

H0 : m m0 wobec H1: m m0

Autor: Janusz Górczyński

35

Krytyczny poziom istotności

(c.d.)

Dla wartości empirycznej statystyki temp wyznaczonej na

podstawie n-elemnetowej próby obliczane jest prawdopodobieństwo otrzymania wartości statystyki testującej co

najmniej tak dużej, jak ta uzyskana z próby, czyli

p P(t temp )

Kryterium odrzucenia hipotezy zerowej jest relacja

wyznaczonego prawdopodobieństwa do przyjętego

poziomu istotności .

Jeżeli p , to H0 odrzucamy.

Jeżeli p , to nie mamy podstaw do odrzucenia H0.

Autor: Janusz Górczyński

36