Marcin Miłkowski

WSTĘP DO KOGNITYWISTYKI

SYMULACJE, OBLICZENIA I

MODELOWANIE: CHIŃSKI

POKÓJ

O czym będzie mowa

John Searle i jego Chiński Pokój

przeciwko AI

Problem ugruntowania symboli

Modele obliczeniowe i fizyczne

komputery

John Searle przeciwko AI

Mocna sztuczna

inteligencja:

Komputery mogą

myśleć.

Słaba sztuczna

inteligencja:

Komputery mogą

symulować myślenie,

tak jak pogodę.

Program rozumienia tekstu R.

Schanka

Program Schanka był w stanie

odpowiadać na proste pytania

dotyczące wprowadzonego do

komputera tekstu.

Dziś też istnieją jeszcze lepsze

systemy odpowiadające na pytania.

R. Schank twierdził, że ten

program rozumie tekst i odpowiada

na pytania.

Chiński pokój

Odpowiedzi na ten eksperyment

Odpowiedź systemowa:

Searle nic nie rozumie, ale nic

dziwnego, bo pojedyncze neurony też

nie.

Odpowiedź z języka angielskiego:

Searle może i nie rozumie języka

chińskiego, ale musi rozumieć

angielski, aby wykonywać instrukcje.

Podobnie komputery rozumieją

instrukcje sterujące (A. Sloman)

Odpowiedzi na chiński pokój

Odpowiedź robotyczna

Podłączmy do komputera kamerę lub

inne receptory, dajmy mu efektory.

Taki robot będzie rozumiał po

chińsku.

Według Searle’a symbole mogłyby być

tylko na temat bodźców percepcyjnych

i reakcji albo na temat przedmiotów i

działań. On ich by jednak nie

rozróżnił, co wg niego obala

odpowiedź robotyczną.

Odpowiedzi na chiński pokój

Odpowiedź z symulatora mózgu:

Zastąpmy karteczki impulsami

elektrycznymi, zmniejszmy pokój, aby

mieścił się w małej piłce. Jak będzie

miał skalę mózgu, to czym właściwie

to się będzie różniło od mózgu?

(D. Hofstadter i D. Dennett)

Searle: a po co nam w ogóle wtedy AI?

Searle a Leibniz w Monadologii

(1714)

„Należy wszakże przyznać, że postrzeżenie i to, co

do niego należy, nie da się wytłumaczyć racjami

mechanicznymi. To znaczy przez kształty i ruchy.

Przypuściwszy zaś, że istnieje maszyna, której

budowa pozwala, aby myślała, czuła, miewała

postrzeżenia, będzie można pomyśleć ją, z

zachowaniem tych samych proporcji, tak powiększoną,

aby można do niej wejść jak do młyna. Założywszy

to, odnaleźlibyśmy wewnątrz przy zwiedzaniu jej

tylko części, które popychają się wzajemnie, nigdy

jednak nic, co tłumaczyłoby postrzeżenie. [...]

trzeba szukać tego właśnie w substancji prostej, a

nie w rzeczy złożonej, czy też w machinie” (par.

17)

Searle a Leibniz

Searle, w przeciwieństwie do

Leibniza, twierdzi, że mózgi mają

moce biologiczne, dzięki którym

rozumieją.

Tych mocy nie mają programy, które

są tylko przekształceniami

symboli.

Nie odpowiadają mechanizmom

biologicznym?

Modele obliczeniowe

Dwa poziomy równoważności

obliczeniowej (Fodor 1968):

Słaba – wyjście obliczenia jest takie

samo przy takich samych wyjściach.

(Liczy się tylko wytwór poznawczy).

Mocna – nie tylko wyjścia są takie

same przy takich samych wejściach,

ale i proces jest równoważny. (Liczy

się też proces poznawczy!)

Eksperyment Searle’a a jego

argumentacja

Późniejsza argumentacja Searle’a:

1. Program komputerowy jest składniowy.

2. Składnia nie jest wystarczająca dla

semantyki.

3. Umysły mają semantykę.

Zatem implementacja programu jest

niewystarczająca dla umysłu.

Parodia Chalmersa

1. Przepisy kulinarne są składniowe.

2. Składnia jest niewystarczająca

dla kruchości.

3. Ciastka są kruche.

Zatem implementacja przepisu jest

niewystarczająca dla ciastka.

Realizacja obliczeń

Programy komputerowe, tak jak

maszyny Turinga, są rozumiane jako

abstrakty.

Ale komputery to fizyczne

mechanizmy, konkretne i dotykalne.

Nie są zatem sprowadzalne do

składni.

Problem ugruntowania symboli

Stevan Harnad:

parafraza problemu

Searle’a

Jak stworzyć system,

w którym symbole

będą ugruntowane, tj.

nie będą odnosić się

tylko do innych symboli?

Problem ugruntowania symboli

Harnad: Sam system komputerowy nie

ma symboli sensownych, jeśli nie

oddziałuje ze środowiskiem.

Nie można nauczyć się chińskiego,

jeśli ma się tylko słownik chińskochiński.

Trzeba móc wyjść poza same symbole,

czyli je ugruntować.

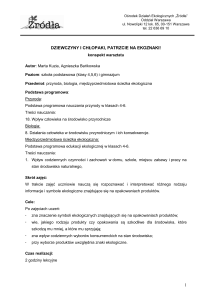

Luc Steels i gadające głowy

Stworzono komunikujące się

ze sobą roboty na temat

prostych kształtów

geometrycznych

Eksperyment jest uproszczony, bo

roboty komunikują się bez

większego ważniejszego powodu, ale

Steels uważa, że problem

rozwiązał.

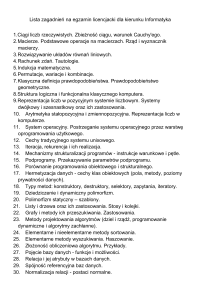

Modele obliczeniowe w

kognitywistyce

Dzisiaj 90% prac teoretycznych w

głównych czasopismach z

kognitywistyki to prace opisujące

modele obliczeniowe.

Większość modeli jest stosunkowo

małego zakresu, tj. opisuje

pojedyncze zdolności poznawcze.

Nie chodzi o sztuczną

inteligencję, tylko o zrozumienie

mechanizmów myślenia.

Czy są granice sztucznej

inteligencji?

Zdaniem Kartezjusza maszyny nigdy

nie opanują języka naturalnego.

IBM Watson niedawno wygrał w

teleturnieju Jeopardy.

Turing: myśleć to komunikować się

sensownie

Skąd wiemy, że maszyna myśli?

Stąd, że możemy się z nią

porozumiewać.

Test Turinga – jeśli komputer go

przejdzie, to myśli.

Do tej pory żaden komputer go nie

przeszedł, a większość

współczesnych prób to żarty lub

zabawki.

Test Turinga

Jeśli rozmówca nie rozpozna, czy –

komunikując się za pośrednictwem

interfejsu maszynowego –

komunikuje się z maszyną, czy z

człowiekiem, to maszyna jest

inteligentna, czyli myśli.

Test ma być przeciwko

szowinistycznemu przesądowi, że ciało

jest istotne.

Krytyka Testu Turinga

Zwierzęta, w tym niegrające w

szachy słonie, nie przejdą testu.

A myślą.

Podobnie małe dzieci.

Przejście test nie jest konieczne do

tego, aby być inteligentnym.

Krytyka Testu Turinga

Test może przejść komputer, który

wcale nie rozumuje, tylko ma

ogromny zbiór zawierający ogromną

liczbę konwersacji, „kosmiczny

gramofon” gigantycznej wielkości

(S. Lem).

Przejście Testu nie jest

wystarczające, aby być inteligentnym.

Wiele osób potrafi być oszukanych

przez boty.

Idea testu: nierozróżnialność

zachowania

Test Turinga jest z ducha

behawiorystyczny: liczy się nie

struktura wewnętrzna, tylko

nierozróżnialność zachowania

(słaba równoważność wytworu

poznawczego, procesy poznawcze

nieważne).

W tym sensie Google Translate też

tłumaczy, jeśli jego wytwór jest

nierozróżnialny.

Sztuczna inteligencja a

kognitywistyka

Inżynieryjnej sztucznej

inteligencji wystarcza

nierozróżnialność zachowania, bo

chodzi o szybkie nowe narzędzia.

Nawet działające zupełnie inaczej niż

człowiek.

Obliczeniowa kognitywistyka

potrzebuje więcej: wyjaśnienia,

jak oblicza człowiek.

Podsumowanie

Searle skrytykował dosyć

buńczuczne twierdzenia, że

programy same w sobie są

inteligentne.

Ale jego tezy stają się wątpliwe,

jak odnieść je do symulatora

mózgu. Parodia Chalmersa jest

zasłużona.

Podsumowanie

W robotyce poznawczej problem

ugruntowania symboli jest bardzo

żywy i chętnie dyskutowany.

Test Turinga pozostaje niezdany, a

jego zdanie niestety nie musi

oznaczać, że wygrała maszyna

inteligentna. Boty są wredne.

Dodatkowe lektury

Łupkowski, P. (2010). Test

Turinga: perspektywa sędziego.

Poznan: Wydawnictwo Naukowe UAM.

Dostępna bezpłatnie.

Searle J.R., Umysły, mózgi i

programy, [w:] Filozofia umysłu.

Fragmenty filozofii analitycznej,

red. B. Chwedeńczuk, Fundacja

Aletheia - Wydawnictwo Spacja,

Warszawa 1995, s. 301–324.