Mgr Rejer Izabela

Mgr Wawrzyniak Agata

Mgr Wąsikowska Barbara

Zastosowania Sztucznej Inteligencji w ekonomii

Summary

The article has the aim to present the topic of application of Artificial Intelligence

tools in economy. Economic problems, which are described here, are very difficult to solve.

As a rule they are multidimensional problems. They are characterised by existence of many

feedbacks between variables. This is a reason why classical mathematics is sometimes useless

in solving this kind of problems.

In the first part of this article there are presented basic information about Artificial

Intelligence (AI) as a science. In the further passage there are described different applications

of main methods of AI, which are used in dealing with economic problems, such as:

genetic algorithms,

neural networks,

fuzzy logic.

Wstęp

W imponującym rozwoju technik komputerowych i globalizacji wymiany informacji

należy zauważyć nieadekwatność istniejących systemów komputerowych do zjawisk

zachodzących w rzeczywistości gospodarczej. Wyraża się to między innymi w stosowaniu

logiki dwuwartościowej do opisu zjawisk rozmytych, co ogranicza obszary zastosowań i

podnosi koszty wprowadzania komputerów. Konsekwencją rozwoju tradycyjnych systemów

komputerowych jest także generowanie ogromnych zbiorów danych, których analiza jest

utrudniona ze względu na ich rozmiar.

Jedną z dziedzin, której rozwój stał się możliwy dzięki rozwojowi technologii

komputerowej, jest sztuczna inteligencja. Rozwój wielu narzędzi sztucznej inteligencji

umożliwił praktyczne wyeliminowanie wspomnianej wyżej nieprzystosowalności zbiorów

danych. Powszechne stało się zastosowanie narzędzi Sztucznej Inteligencji w takich

dziedzinach jak: sterowanie procesami technologicznymi, bankowość, zarządzanie, handel

oraz operacje na giełdzie papierów wartościowych. Niestety jest to jeszcze zjawisko

praktycznie nieznane na gruncie polskiej gospodarki.

Niniejszy artykuł ma przybliżyć tematykę zastosowań narzędzi sztucznej inteligencji w

ekonomii. Problemy ekonomiczne, o których będzie mowa, są problemami trudnymi do

rozwiązania. Z reguły są to bowiem problemy wielkowymiarowe, które cechuje istnienie

wielu wzajemnych sprzężeń zwrotnych między występującymi w nich zmiennymi. Dlatego

niemożliwe wydaje się być skuteczne rozwiązywanie tego rodzaju problemów (przynajmniej

wielu z nich) przy pomocy matematyki klasycznej.

W pierwszej części niniejszego artykułu przedstawiono podstawowe informacje dotyczące

Sztucznej Inteligencji jako dziedziny nauki. Następnie omówiono zastosowanie głównych

metod AI (ang. Artificial Intelligence) w problemach ekonomicznych.

1. Powstanie i rozwój Sztucznej Inteligencji

W ciągu kilku ostatnich lat popularne stały się badania w dziedzinie zwanej Sztuczną

Inteligencją. Ich celem jest możliwie dokładne imitowanie działania ludzkiego umysłu, za

pomocą elektronicznych maszyn, a w przyszłości zbudowanie maszyn przewyższających

ludzkie zdolności w tym zakresie. Z roku na rok obserwuje się niesłychany wzrost szybkości

działania komputerów, dzięki czemu stają się one wygodnymi i szybkimi maszynami

automatyzującymi pracę obliczeniowe związane z przetwarzaniem informacji. Współczesne

komputery potrafią w ciągu zaledwie ułamka sekundy policzyć skomplikowane zadanie

matematyczne czy wyznaczyć budżet dużej firmy. Jednak pozornie proste czynności, które

ludzie wykonują bez kłopotów, takie np. jak rozpoznawanie twarzy czy wychwycenie słowa z

rozmowy, są niezmiernie trudne do zaprogramowania. Tym czasem sieci neuronów ludzkiego

mózgu mają naturalną łatwość wykonywania tego typu zadań. Tak więc naukowcy zaczęli

budować maszyny o architekturze naśladującej mózg ludzki. Wzrost zainteresowania

wynikami badań nad AI wynika przynajmniej z kilku powodów. Po pierwsze: są one istotne

dla budowy robotów, czyli maszyn spełniających praktyczne zapotrzebowanie przemysłu na

urządzenia zdolne do wykonywania różnorodnych i skomplikowanych zadań, które

dotychczas wymagały zaangażowania człowieka. Po drugie: interesujący jest również rozwój

systemów eksperckich - programów komputerowych obejmujących całą istotną wiedzę

posiadaną przez ekspertów w danej dziedzinie. Nasuwa się tu jednak pytanie: czy wiedzę i

doświadczenie człowieka można zastąpić programem komputerowym? Po trzecie: Sztuczna

Inteligencja może mieć również bezpośrednie znaczenie dla psychologii. Niektórzy badacze

bowiem, mają nadzieję, że próbując imitować za pomocą urządzeń elektronicznych działanie

ludzkiego mózgu zdołają się dowiedzieć czegoś istotnego o jego działaniu, i to niezależnie od

porażki czy sukcesu tych prób. Istnieje również przekonanie, że badania nad AI mogą wnieść

wiele do najważniejszych zagadnień filozofii.

Człowiekiem, który wpadł na koncepcję współczesnego komputera (w 1935 r.) był Alan

Nathison Turing. Obecnie wszystkie komputery są w istocie „maszynami Turinga”. Ten

brytyjski matematyk był także pionierem Sztucznej Inteligencji. W roku 1950 w swym

słynnym artykule „Maszyny liczące a inteligencja” („Computing Machinery and

Intelligence”) opublikowanym w brytyjskim czasopiśmie filozoficznym „Mind” wyraził

pogląd mówiący, że aby uznać iż komputer myśli powinien on potrafić udzielić odpowiedzi

na dowolne pytanie, w taki sposób jaki odpowiedziałby na to pytanie człowiek. W artykule

tym również Turing po raz pierwszy opisał test zwany obecnie „testem Turinga, który miał

umożliwić rozstrzygnięcie, czy można zasadnie stwierdzić, że dana maszyna myśli. Aby

poddać komputer testowi Turinga należy umieścić w jednym pomieszczeniu jakiegoś

człowieka w drugim zaś komputer. Należy to jednak zrobić tak, by osoba zadająca pytania nie

wiedziała, w którym pomieszczeniu jest człowiek, a w którym maszyna. Następnie osoba

przesłuchująca zadaje szereg pytań i na podstawie otrzymywanych odpowiedzi, usiłuje

odróżnić człowieka od komputera. Zarówno pytania jak i odpowiedzi są przekazywane

jedynie za pomocą klawiatury i monitora. Przesłuchiwany człowiek ma obowiązek mówić

prawdę i starać się przekonać przesłuchującego, iż rzeczywiście jest człowiekiem, natomiast

komputer jest zaprogramowany tak aby „kłamiąc” starał się go przekonać, że to właśnie on

jest człowiekiem. Jeśli po przeprowadzeniu serii takich testów przesłuchujący nie jest w

stanie zidentyfikować

rzeczywistego człowieka, to uznajemy, iż komputer przeszedł

pomyślnie test.

Od momentu opublikowania koncepcji „testu Turinga” bezustannie podejmowane są

próby zbudowania maszyny mogącej sprostać wymaganiom testu. Jednym z pierwszych

urządzeń AI był zbudowany przez W. Greya Waltera w początku lat pięćdziesiątych

elektroniczny „żółw”. Poruszał się on po podłodze korzystając z własnego napędu, dopóki

napięcie w bateriach nie spadło do niebezpiecznie niskiego poziomu. Wtedy to rozpoczynał

poszukiwania najbliższego kontaktu. Po naładowaniu baterii ruszał w dalszą drogę po pokoju.

W późniejszych czasach skonstruowano wiele podobnych urządzeń.

Przykładem odmiennego kierunku badań jest stworzony w 1972 roku przez Terry’ego

Winograda program komputerowy, zdolny do sensownej rozmowy na temat rozmaitych

kolorowych klocków, które podczas symulacji układał jeden na drugim na różne sposoby.

Mimo jednak tych wczesnych sukcesów niezmiernie trudnym problemem okazało się

zbudowanie urządzenia do kontrolowania ruchów prostego, sztucznego ramienia, zdolnego do

wykonywania bezkolizyjnych manewrów w pobliżu przypadkowo rozmieszczonych

przeszkód.

Bliższy idei testu Turinga jest program komputerowy napisany w latach sześćdziesiątych

przez K. M Colby’ego, który miał symulować zachowanie psychoterapeuty. Działał on tak

dobrze, że niektórzy pacjenci woleli korzystać z jego usług niż z pomocy prawdziwych

psychoterapeutów i byli bardzo skłonni zwierzyć się mu ze swoich problemów.

Kolejnymi

urządzeniami,

stanowiącymi

dobry

przykład

maszyn

zdolnych

do

„inteligentnego zachowana” są komputery grające w szachy. W chwili obecnej niektóre

maszyny

osiągnęły

godny uwagi

poziom

gry,

zbliżony do

poziomu

mistrzów

międzynarodowych. Maszyny grające w szachy, oprócz zdolności wykonywania dokładnych

obliczeń, korzystają również z ogromnej wiedzy książkowej. Jednym z najsławniejszych

programów komputerowych do gry w szachy był program napisany przez Dana i Kathe

Spracklenów, który otrzymał tytuł mistrza Federacji Szachowej Stanów Zjednoczonych.

Warto wspomnieć, że na ogół komputery radzą sobie lepiej w konkurencji z ludźmi, jeśli

stawia się dodatkowe wymaganie, aby grać bardzo szybko. Ludzie radzą sobie lepiej, jeśli

mają do dyspozycji więcej czasu na obmyślanie posunięć. Wynika to z faktu, że na ogół

komputery podejmują decyzje na podstawie precyzyjnych i dokładnych obliczeń wariantów,

podczas gdy ludzie korzystają na ogół z „sądów”, wynikających ze stosunkowo powolnej,

świadomej oceny pozycji szachownicy.

Obecnie, błyskawiczny rozwój techniki sprawił, iż zaczęły rozwijać się nowe dziedziny

takie jak: systemy ekspertowe, zbiory rozmyte i logika rozmyta, sztuczne sieci neuronowe,

algorytmy genetyczne, które znalazły różne zastosowania (min w ekonomii).

2. Metody sztucznej inteligencji

Pojęciem sztucznej inteligencji określa się zbiór metod, które mają na celu opisanie

rzeczywistości w sposób przypominający rozumowanie człowieka. Metody te powstały jako

przeciwwaga tradycyjnych algorytmów komputerowych, zawodzących często w sytuacjach,

które człowiek potrafi rozwiązać bez większych problemów. Z reguły po metody sztucznej

inteligencji sięga się wtedy gdy brakuje klasycznych metod matematycznych pozwalających

na rozwiązanie rozpatrywanego problemu. Metody te wykorzystywane są też często wtedy

kiedy dany problem badawczy może co prawda zostać rozwiązany metodami klasycznymi,

ale wykorzystanie metod sztucznej inteligencji przyspieszy czas uzyskania rozwiązania.

Cechą charakterystyczną wszystkich metod sztucznej inteligencji jest fakt, że generują

one wyniki w pewnym stopniu przybliżone. Nie można wykorzystywać ich więc w

sytuacjach, które wymagają dużej precyzji obliczeń np. w zastosowaniach inżynierskich, czy

przy operacjach wykonywanych na kontach bankowych. Są one natomiast z powodzeniem

stosowane w szerokiej gamie zastosowań ekonomiczno-społecznych, których i tak w

większości przypadków nie można rozwiązać ze 100% precyzją.

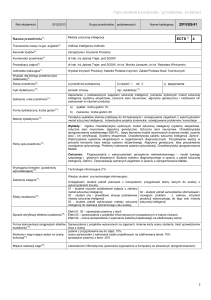

Do rodziny metod sztucznej inteligencji zaliczane są w chwili obecnej trzy podstawowe

klasy metod. Należy wśród nich wyróżnić: sieci neuronowe, systemy rozmyte oraz algorytmy

genetyczne. Miejsce poszczególnych metod sztucznej inteligencji na tle ogółu metod

badawczych można przedstawić następująco:1 (rys. nr 1).

Poznanie

wnioskowanie

indukcyjne

ukryte

wnioskowanie

dedukcyjne

jawne

precyzyjne

wnioskowanie

algorytmiczne

regresja nieparametryczna

sieci neuronowe

adaptacyjne systemy rozmyte

algorytmy genetyczne

systemy ekspertowe

regresja parametryczna

Złożoność

Rys. 1 – Miejsce poszczególnych klas metod sztucznej inteligencji wśród ogółu metod

badawczych.

Jak widać na zaprezentowanym wykresie metody sztucznej inteligencji należą do klasy metod

indukcyjnych, wykorzystywanych w problemach cechujących się wysokim stopniem

złożoności oraz niejawnymi powiązaniami między zmiennymi.

1

Zieliński, Jerzy S. – „Inteligentne systemy w zarządzaniu. Teoria i praktyka”, PWN, Warszawa 2000, str.172

2.1 Algorytmy genetyczne

Algorytmy genetyczne są wykorzystywane do rozwiązywania zadań optymalizacyjnych,

z którymi bardzo często mamy do czynienia w naukach ekonomicznych. Przykładem może tu

być dobrze znany problem poszukiwania najkrótszej drogi (problem komiwojażera) czy też

problem znalezienia optymalnej wielkości zapasów, które należy

utrzymywać w

przedsiębiorstwie. Problemy optymalizacyjne występujące w ekonomi bardzo często można

zaliczyć do problemów NP-trudnych. Oznacza to, że do ich optymalizacji nie wystarczą

klasyczne metody pełnego przeszukiwania przestrzeni możliwych rozwiązań. Rozpatrzmy

dokładniej problem komiwojażera. W skrócie polega on na znalezieniu najkrótszej drogi

pomiędzy określoną ilością miast, przy spełnieniu założenia, że każde z miast jest odwiedzane

tylko raz, a miasto startowe jest jednocześnie kończącym. W przypadku 5 miast problem ten

może zostać rozwiązany poprzez wygenerowanie i porównanie wszystkich możliwych

rozwiązań (12). Jednakże nawet nieznaczne zwiększenie ilości miast powoduje wprost

kolosalny wzrost liczby możliwych rozwiązań – dla 10 miast jest ich już 181440, dla 30 –

4*1030! Istnienie tak dużej ilości koniecznych do rozpatrzenia przypadków sprawia, że

rozwiązywanie tego typu problemów trzeba oprzeć na przybliżonych metodach poszukiwania

rozwiązania optymalnego2. Do metod takich należą wzorowane na naturalnej ewolucji

algorytmy genetyczne. Ich działanie oparte jest na mechanizmach doboru naturalnego i

dziedziczenia, a podstawową zasada, którą się kierują w doborze rozwiązań optymalnych jest

ewolucyjna zasada przeżycia osobników jak najlepiej przystosowanych. Wynika z tego, że

dokonują one w pewien sposób ukierunkowanego przeszukiwania przestrzeni możliwych

rozwiązań. Poza wymienionym wcześniej problemem komiwojażera i problemem

optymalizacji zapasów w przedsiębiorstwie, algorytmy genetyczne są wykorzystywane w

optymalizacji

sieci

dystrybucyjnej,

analizie

bankructw

przedsiębiorstw,

ustalaniu

harmonogramów zarządzania produkcją i innych podobnych zagadnieniach.

2.2 Sieci neuronowe

Podstawową zaletą sieci neuronowych decydujących o ich coraz powszechniejszym

wykorzystaniu w różnych dziedzinach nauki jest możliwość rozwiązania postawionego

zadania bez wcześniejszej znajomości metody jego rozwiązywania. Ta cecha sieci

neuronowych jest przydatna szczególnie wtedy kiedy metoda taka nie istnieje. W dziedzinie

nauk ekonomicznych często można spotykać się z problemami cechującymi się tak wysokim

stopniem złożoności, że stworzenie matematycznych modeli na podstawie których można by

je rozwiązywać jest praktycznie niemożliwe. Sieć neuronowa potrafi natomiast poradzić sobie

z dowolnie skomplikowanymi problemami przy założeniu że są one rozwiązywalne i że

istnieje odpowiedni zbiór danych, które mogą zostać wykorzystane w procesie uczenia sieci.

Sieć neuronowa działa bowiem na podobnych zasadach jak mózg ludzki. Uczy się ona

rozwiązywać postawiony przed nią problem w oparciu o prezentowane jej przykłady uczące.

Jeżeli przykładów tych jest zbyt mało, to będzie zachowywała się jak niedouczone dziecko,

jeżeli jest ich zbyt dużo, to podczas prób rozwiązania problemu zagubi się w gąszczu

szczegółów. Jedną z ciekawszych cech sieci neuronowych jest ich zdolność do generalizacji,

czyli uogólniania wiedzy prezentowanej w trakcie uczenia. Zdolność ta przejawia się

poprawnym zachowaniem sieci w przypadku wprowadzenia do niej informacji w pewnym

stopniu różniącej się wszystkich informacji, które zostały zaprezentowane podczas procesu

uczenia. Dwie inne cechy sieci neuronowych otwierające przed nimi pole zastosowań

ekonomicznych to umiejętność radzenia sobie z niekompletnymi i zaszumionymi danymi oraz

umiejętność aproksymacji systemów nawet bardzo silnie nieliniowych. Do podstawowych

klas problemów ekonomicznych, które z powodzeniem są rozwiązywane przy pomocy sieci

neuronowych należy zaliczyć predykcję, optymalizację, klasyfikację oraz analizę danych.

Istota zagadnień optymalizacyjnych została już omówiona przy okazji algorytmów

genetycznych, a więc w punkcie tym będzie ona pominięta. Należy tylko nadmienić, że sieci

neuronowe najczęściej wykorzystywane do rozwiązywania problemów optymalizacyjnych to

sieci ze sprzężeniami zwrotnymi, głównie sieci Hopfielda.

Zdolności

aproksymacyjne sieci

neuronowych są ostatnio szczególnie często

wykorzystywane do przewidywania zachowań rynków finansowych. Badana jest tutaj

zarówno możliwość zmiany, czy kontynuacji trendu cenowego poszczególnych instrumentów

finansowych, jak i ich konkretne ceny. Innymi ekonomicznymi zadaniami prognostycznymi

stawianymi przed sieciami neuronowymi są prognozy: bankructw przedsiębiorstw,

wskaźników ekonomicznych, zapotrzebowania na pracowników, przepływów gotówkowych

oraz zjawisk i wskaźników makroekonomicznych takich jak: bezrobocie, inflacja, PKB i

innych. Ważną zaletą sieci neuronowych wykorzystywanych do celów prognostycznych jest

fakt, że w wyniku uczenia sieć może nabyć zdolności przewidywania wyjściowych sygnałów

wyłącznie na podstawie obserwacji, bez konieczności stawiania w sposób jasny hipotez o

Korbicz J., Obuchowski A., Uciński D. – „Sztuczne sieci neuronowe. Podstawy i zastosowania”, Akademicka

Oficyna Wydawnicza PLJ, Warszawa, 1994, str. 137-138

2

naturze związku pomiędzy wejściowymi danymi, a przewidywanymi wynikami. 3 Bardzo

często w celach prognostycznych wykorzystuje się najprostsze sieci perceptronowe o

jednokierunkowym przepływie sygnałów i nieliniowych, ciągłych funkcjach aktywacji,

wyposażone z reguły w jedną warstwę ukrytą. Wśród bardziej specjalistycznych sieci

zajmujących się tego typu zagadnieniami należy wymienić sieci realizujące regresję

uogólnioną (GRNN).

Innym, często przytaczanym ekonomicznym zastosowaniem sieci neuronowych są

zagadnienia klasyfikacyjne. Zagadnienia te polegają na wyodrębnieniu w przestrzeni

rozważań rozpatrywanego problemu szeregu rozłącznych klas, identyfikujących jego

poszczególne charakterystyczne obszary. Zadaniem sieci neuronowych, wykorzystywanych w

zagadnieniach klasyfikacyjnych jest wytworzenie w trakcie nauki pól decyzyjnych

odpowiadających zdefiniowanym przez użytkownika klasom. Prawidłowo nauczona sieć

cechuje się tym, że podanie jej dowolnego wzorca wejściowego powoduje wygenerowanie

identyfikatora klasy, do której prezentowany wzorzec jest w największym stopniu podobny.

Do rozwiązywania zagadnień klasyfikacyjnych wykorzystuje się z reguły zwykłe

jednokierunkowe sieci z ciągłymi, nieliniowymi funkcjami aktywacji. Identyfikacja klas jest

w nich zorganizowana najczęściej poprzez przypisanie jednego neuronu wyjściowego sieci

jednej konkretnej klasie. Sieci tego typu mają więc tyle neuronów wyjściowych, na ile klas

został podzielony rozpatrywany problem. Sztandarowym, bardzo często spotykanym,

ekonomicznym zastosowaniem klasyfikacyjnych sieci neuronowych jest badanie zdolności

kredytowej przedsiębiorstw. Sieć realizująca tego typu zadanie uczona jest w oparciu o dane

zawarte w zgromadzonych wcześniej wnioskach kredytowych. Na podstawie danych tych

sieć identyfikuje obszary odpowiadające np. klientom wypłacalnym, niewypłacalnym oraz

pozostałym. Oczywiście ilość klas może być dowolna, zależna od użytkownika. Kolejnym

ciekawym zagadnieniem rozwiązywanym przy pomocy sieci klasyfikacyjnych są próby

identyfikacji formacji cenowych informujących, zgodnie z teorią analizy technicznej, o

możliwości zmiany bądź kontynuacji aktualnego trendu cenowego danego instrumentu

finansowego.

Innymi

często

spotykanymi

ekonomicznymi

zastosowaniami

sieci

klasyfikacyjnych są zagadnienia związane: z klasyfikacją obligacji, oceną stopnia

opłacalności przedsięwzięć inwestycyjnych, wyborem funduszu powierniczego, wyborem

strategii sprzedaży i inne.

Zagadnienia związane z analizą danych są w pewien sposób podobne do zagadnień

klasyfikacyjnych. W zasadzie cel ich jest taki sam. Jest nim podział rozpatrywanego

3

Tadeusiewicz R. – „Sieci neuronowe”, Akademicka Oficyna Wydawnicza RM, Warszawa, 1993, str. 16

problemu na szereg klas. Podstawową różnicą odróżniającą od siebie te dwa rodzaje

zagadnień jest znajomość kryteriów decyzyjnych. W zagadnieniach klasyfikacyjnych kryteria

te są dokładnie zdefiniowane, co oznacza, że ilość klas jest ściśle znana. Zadaniem sieci

neuronowej jest jedynie nauczenie się poprawnego klasyfikowania nowych obiektów do

zdefiniowanych wcześniej klas. W zadaniach związanych z analizą danych kryteria decyzyjne

pozwalające na zakwalifikowanie danego obiektu do określonej klasy nie są znane. Co więcej

nieznane są również same klasy. Zadaniem stawianym przed sieciami neuronowymi

wykorzystywanymi w procesie analizy danych jest właśnie wyszukanie tych klas, czyli

podział całego zbioru danych na szereg jednorodnych podzbiorów. Oczywiście podział ten

powinien być przeprowadzony w taki sposób aby elementy tego samego podzbioru były jak

najbardziej podobne do siebie, zaś elementy różnych podzbiorów - jak najbardziej odmienne4.

Do rozwiązywania tego typu problemów wykorzystuje się różne odmiany sieci

samouczących, spośród których do najbardziej znanych należą chyba sieci Kohonena. Sieci

pozwalające na dokonywanie analizy dużych zbiorów danych są obecnie coraz częściej

wykorzystywane w zagadnieniach ekonomicznych. Przykładem może być analiza trendów

cenowych instrumentów finansowych pod względem występujących w nich prawidłowości.

Analiza taka pozwala np. na wyodrębnienie ze zbioru próbek formacji cenowych

charakterystycznych dla danego waloru, które następnie można wykorzystać do prognozy

przyszłej wartości tegoż waloru przy pomocy przeznaczonej do rozwiązywania tego rodzaju

zadań sieci neuronowej.

2.3 Logika rozmyta

Otaczająca nas rzeczywistość gospodarcza charakteryzuje się bardzo wysokim stopniem

złożoności. Z tego powodu trudno jest ją opisać używając dokładnych, precyzyjnych pojęć.

Najczęściej do opisu zjawisk występujących w rzeczywistości gospodarczej używa się więc

pojęć nie precyzyjnych, lecz rozmytych. Odwrotną zależność występującą między precyzją

opisu problemów występujących w otaczającym nas świecie, a ich złożonością najlepiej

oddaje zasada niespójności sformułowana przez twórcę logiki rozmytej Lofti Zadeha. Brzmi

ona następująco: „w miarę wzrostu złożoności systemu nasza zdolność do formułowania

istotnych stwierdzeń dotyczących jego zachowania maleje, osiągając w końcu próg poza

którym precyzja i istotność stają się cechami wzajemnie prawie się wykluczającymi”5.

Zieliński, Jerzy S. – „Inteligentne systemy w zarządzaniu. Teoria i praktyka”, PWN, Warszawa 2000, str.191

Piegat A. – „Modelowanie i sterowanie rozmyte”, Akademicka Oficyna Wydawnicza EXIT, Warszawa, 1999,

str. 18

4

5

Niemożność formułowania precyzyjnych stwierdzeń na temat opisywanego systemu stała

się głównym motorem rozwoju nowej dziedziny wiedzy zwanej logiką rozmytą. W coraz

większej ilości wyrobów (szczególnie japońskich) wykorzystuje się logikę rozmytą. W roku

1980 firma F.L Smidth & Company z Kopenhagi jako pierwsza zastosowała system oparty na

logice rozmytej do sterowania piecem cementowni. W roku 1988 firma Hitachi powierzyła

nadzór nad metrem w Sendai (Japonia) programowi opartemu na logice rozmytej. Od tego

czasu przedsiębiorstwa Japońskie zaczęły wykorzystywać to podejście w produkcji setek

wyrobów sprzętu gospodarstwa domowego i elektroniki użytkowej. Zastosowania logiki

rozmytej nie ograniczają się tylko do systemów sterowania. Za pomocą tej nowej dziedziny

życia można w zasadzie opisać każdy system o ciągłych parametrach, niezależnie od tego, czy

będzie to zagadnienie z fizyki, biologii, czy też ekonomii. Przykładem problemu

ekonomicznego, do rozwiązania którego to można wykorzystać logikę rozmytą może być

problem odpowiedniego ukierunkowanie działalności przedsiębiorstwa. Jasne określenie cech

klientów

ma

istotne

znaczenie

zwłaszcza

przy zastosowaniu

metod

marketingu

bezpośredniego. Jeśli firma planuje np. rozesłanie materiałów reklamowych określonego

towaru, to w celu ograniczenia kosztów oferta ta powinna być skierowana tylko do tych

klientów, którzy prawdopodobnie byliby skłonni dany produkt kupić. Kryteriami

definiującymi potencjalnych nabywców mogą być: wiek, dane o dochodach, dane

demograficzne, dane geograficzne, historia poprzednich zakupów itp. Firma prowadząca dane

badania marketingowe gromadzi uzyskane informacje w bazach danych, obejmujących często

dane dotyczące nawet kilkudziesięciu tysięcy osób. Problemem jest oczywiście wybór

właściwych

cech

klientów,

którzy mogą

stać

się

celem

podejmowanych

akcji

marketingowych.

Innymi problemami, które można rozwiązać przy pomocy logiki rozmytej są problemy

związane z podejmowaniem decyzji dotyczących aktywności giełdowej. Problemy te należą

do najbardziej skomplikowanych zagadnień związanych z inżynierią finansową. Często

wykazują one cechy nieliniowych zachowań o charakterze chaotycznym i mają zwykle

skomplikowana dynamikę. Jedna z najistotniejszych kwestii jest właściwe wykorzystanie

rozpoznawalnych trendów oraz zbudowanie strategii rynkowej, która będzie przynosić zyski

w czasie długotrwałych i silnych trendów, zaś minimalizować straty w czasie chwilowych

wahań koniunktury. Strategie te bazują na intuicyjnych regułach, które w sposób naturalny

mogą być modelowane przy wykorzystaniu logiki rozmytej.

Zakończenie

Sztuczna inteligencja jest dziedziną nauki stosunkowo młodą, ale bardzo prężnie się

rozwijającą. Ciągle wzrasta ilość metod badawczych oraz rozszerzane są obszary jej

wykorzystania w ekonomii. Ostatnio pojawiają się nowe metody np. analiza danych przy

wykorzystaniu zbiorów przybliżonych. Zaprezentowane powyżej zalety poszczególnych

metod sztucznej inteligencji powodują, że stanowią one coraz częściej wykorzystywane

przeciwwagę dla klasycznych metod matematycznych. Coraz częściej można także

obserwować łączenie poszczególnych metod w metody hybrydowe łączące w sobie zalety

poszczególnych narzędzi.

Bibliografia

1. Inteligentne systemy w zarządzaniu – teoria i praktyka, praca napisana pod redakcja

Jerzego S. Zielińskiego;

2. Penrose R.: Nowy umysł cesarza – o komputerach, umyśle i prawach fizyki, Wydawnictwo

Naukowe PWN, Warszawa 2000;

3. Piegat A.: Modelowanie i sterowanie rozmyte, Akademicka Oficyna Wydawnicza EXIT,

Warszawa 1999 r.;

4. Logika rozmyta, „Świat Nauki”, wrzesień 1993 r.;

5. Rozmyty świat, „Wiedza i Życie”, luty 1997 r.;

6. Czy maszyna może się uczyć całkiem sama?, „Wiedza i Życie”, sierpień 1998 r.;

7. Sztuczna inteligencja w realnym świecie zastosowań, „Computerworld”, nr 41, 1994 r.;

8. Zapomniane pomysły Alana Turinga, „Świat Nauki”, czerwiec 1999 r.;

9. Mistrz duchowy sztucznej inteligencji, „Świat Nauki”, styczeń 1994 r.;

10. Sztuczna inteligencja, „Świat Nauki”, listopad 1995 r.;

11. Rutkowska D., Piliński M., Rutkowski L.: Sieci neuronowe, algorytmy genetyczne i

systemy rozmyte, Wydawnictwo Naukowe PWN, Łódź 1999 r.;

12. Tadeusiewicz R.: Sieci neuronowe, Akademicka Oficyna Wydawnicza RM, Warszawa,

1993 r.;

13. Korbicz J., Obuchowski A., Uciński D.: Sztuczne sieci neuronowe. Podstawy i

zastosowania, Akademicka Oficyna Wydawnicza PLJ, Warszawa, 1994 r.