Polska Akademia Nauk Oddział w Gdańsku

Komisja Informatyki

Metody Informatyki Stosowanej

Nr 2/2009 (19)

Szczecin 2009

Metody Informatyki Stosowanej

Kwartalnik Komisji Informatyki Polskiej Akademii Nauk Oddział w Gdańsku

Komitet Naukowy:

Przewodniczący:

prof. dr hab. inż. Henryk Krawczyk, czł. koresp. PAN, Politechnika Gdańska

Członkowie:

prof. dr hab. inż. Michał Białko, czł. rzecz. PAN, Politechnika Koszalińska

prof. dr hab. inż. Ludosław Drelichowski, Uniwersytet Technologiczno-Przyrodniczy w Bydgoszczy

prof. dr hab. inż. Janusz Kacprzyk, czł. koresp. PAN, Instytut Badań Systemowych PAN

prof. dr hab. Jan Madey, Uniwersytet Warszawski

prof. dr hab. inż. Leszek Rutkowski, czł. koresp. PAN, Politechnika Częstochowska

prof. dr hab. inż. Piotr Sienkiewicz, Akademia Obrony Narodowej

prof. dr inż. Jerzy Sołdek, Politechnika Szczecińska

prof. dr hab. inż. Andrzej Straszak, Instytut Badań Systemowych PAN

prof. dr hab. Maciej M. Sysło, Uniwersytet Wrocławski

Recenzenci współpracujący z redakcją:

Marian Adamski, Zbigniew Banaszak, Alexander Barkalov, Włodzimierz Bielecki, Piotr Bubacz,

Ryszard Budziński, Henryk Budzisz, Andrzej Czyżewski, Ludosław Drelichowski, Witold Dzwinel,

Imed El Frey, Mykhaylo Fedorov, Paweł Forczmański, Dariusz Frejlichowski, Krzysztof Giaro,

Larysa Globa, Zbigniew Gmyrek, Janusz Górski, Stanisław Grzegórski, Volodymyr Harbarchuk,

Volodymyr Hrytsyk, Wojciech Jędruch, Aleksander Katkow, Przemysław Klęsk, Shinya Kobayashi,

Leonid Kompanets, Józef Korbicz, Marcin Korzeń, Georgy Kukharev, Mieczysław Kula,

Eugeniusz Kuriata, Emma Kusztina, Małgorzata Łatuszyńska, Wiesław Madej, Oleg Mashkov,

Oleg Maslennikow, Karol Myszkowski, Evgeny Ochin, Krzysztof Okarma, Piotr Pechmann,

Jerzy Pejaś, Andrzej Pieczyński, Andrzej Piegat, Jacek Pomykała, Orest Popov, Remigiusz Rak,

Valeriy Rogoza, Khalid Saeed, Jerzy Sołdek, Boris Sovetov, Marek Stabrowski, Andrzej Stateczny,

Janusz Stokłosa, Alexander Ţariov, Leszek Trybus, Zenon Ulman, Anrzej Walczak,

Jarosław Wątróbski, Sławomir Wiak, Antoni Wiliński, Waldemar Wolski, Waldemar Wójcik,

Oleg Zaikin, Zenon Zwierzewicz

Redaktor Naczelny:

Antoni Wiliński

Sekretarz redakcji:

Piotr Czapiewski

ISSN 1898-5297

Wydawnictwo:

Polska Akademia Nauk Oddział w Gdańsku, Komisja Informatyki

Adres kontaktowy: ul. Żołnierska 49 p. 104, 71-210 Szczecin, email: [email protected]

Druk: Pracownia Poligraficzna Wydziału Informatyki

Zachodniopomorskiego Uniwersytetu Technologicznego w Szczecinie

Nakład 510 egz.

Spis treści

Włodzimierz Bielecki, Tomasz Klimek, Maciej Pietrasik

OBLICZENIE TRANZYTYWNEGO DOMKNIĘCIA SPARAMETRYZOWANYCH RELACJI ZALEŻNOŚCI

NIE NALEŻĄCYCH DO KLASY D-FORM . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

Larisa Dobryakova, Evgeny Ochin

METODA STEGANOGRAFICZNA NA BAZIE WPROWADZENIA DODATKOWEGO BITU DANYCH

MEDIALNYCH . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

Luiza Fabisiak

ANALIZA WIELOKRYTERIALNA W ZARZĄDZANIU STRATEGICZNYM E-BIZNESU . . . . . . . . . . . . 23

Tomasz Hyla

AUTOMATYCZNE SPRAWDZANIE I WERYFIKACJA STATUSU ALGORYTMÓW KRYPTOGRAFICZNYCH

WYKORZYSTYWANYCH W INFRASTRUKTURZE KLUCZA PUBLICZNEGO . . . . . . . . . . . . . . . . . . . 31

Sławomir Jaszczak, Michał Wierzbicki

TRANSLACJA PROGRAMU IL DO GRAFU SFC . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 41

Jerzy Korostil, Łukasz Nozdrzykowski

THE ANALYSIS OF THE IMPORTANCE OF IMAGE ATTRIBUTES AFFECTING VISIBILITY FACT

OF STEGANOGRAPHIC HIDE MESSAGES IN DIGITAL IMAGE . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57

Marcin Mirończuk, Tadeusz Maciak

EKSPLORACJA DANYCH W KONTEKŚCIE PROCESU KNOWLEDGE DISCOVERY IN DATABASES

(KDD) I METODOLOGII CROSS-INDUSTRY STANDARD PROCESS FOR DATA MINING

(CRISP-DM) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 65

Stanisław Niepostyn, Ilona Bluemke

MODELER MODELU PRZESTRZENNEGO DOD W ŚRODOWISKU TOPCASED . . . . . . . . . . . . . . . 81

Aleksy Patryn, Walery Susłow, Michał Statkiewicz

ERRORS IN IDENTIFICATION OF GEOMETRICAL GRAPHICAL FORMS: COMPUTERIZED STUDY . . . 93

Izabela Rojek

METODY SZTUCZNEJ INTELIGENCJI W ROZWOJU SYSTEMÓW INFORMATYCZNYCH

DLA PRZEDSIĘBIORSTW PRODUKCYJNYCH I WODOCIĄGOWYCH . . . . . . . . . . . . . . . . . . . . . . . 101

Maciej Roszkowski

WYBRANE METODY KLASYFIKACJI BEZWZORCOWEJ W ZASTOSOWANIU DO KLASYFIKACJI

DANYCH DOTYCZĄCYCH JAKOŚCI ŻYCIA MIESZKAŃCÓW PAŃSTW OECD . . . . . . . . . . . . . . . 113

Jan Sadolewski

WPROWADZENIE DO WERYFIKACJI PROSTYCH PROGRAMÓW W JĘZYKU ST ZA POMOCĄ

NARZĘDZI COQ, WHY I CADUCEUS . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 121

Tatyana Shatovska, Iryna Kamenieva, Olena Liskonog

CLUSTERIZATION MODULES FOR "ONTOLOGY DATA MODELS FOR DATA AND METADATA

EXCHANGE REPOSITORY" SYSTEM TEXT COLLECTIONS . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 139

Dominik Strzałka

STANY NIERÓWNOWAGOWE PROCESÓW W PRZETWARZANIU ALGORYTMICZNYM . . . . . . . . . 145

Tatiana Tretyakova

FUZZY COMPONENTS IN THE CONTENTS OF KNOWLEDGE BASES OF INTELLIGENT DECISION

SUPPORT SYSTEMS (ON AN EXAMPLE OF USE OF HYDROMETEOROLOGICAL INFORMATION IN

REGIONAL MANAGEMENT) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 161

Antoni Wiliński

STRATEGIA INWESTOWANIA NA KONTRAKTACH TERMINOWYCH NA WIG20 OPARTA NA

KONCEPCJI SAIDENBERGA . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 169

Marek Włodarski

PORÓWNANIE PARAMETRYCZNEJ I NIEPARAMETRYCZNEJ METODY OBLICZANIA KRZYWEJ ROC

NA PRZYKŁADZIE ZBIORU SYGNAŁÓW ELEKTRORETINOGRAFICZNYCH . . . . . . . . . . . . . . . . . . 177

Obliczenie tranzytywnego domknięcia

sparametryzowanych relacji zależności

nie należących do klasy d-form

Włodzimierz Bielecki, Tomasz Klimek, Maciej Pietrasik

Zachodniopomorski Uniwersytet Technologiczny w Szczecinie, Wydział Informatyki

Abstract:

Approaches for calculating the exact transitive closure of a single dependence relation are

presented. These approaches are based on calculating firstly the power k of a relation, then

transitive closure is easily formed by making k in the formula received to be existentially

quantified. Supposed approaches permit for enlarging the scope of dependence relations for

which it is possible to calculate exact transitive closure. This enlarges the scope of program

loops for which it is possible to extract both fine- and coarse-grained parallelism. Results of

experiments with popular benchmarks are presented.

Keywords:

affine loops, dependence, transitive closure, program transformation, parallelization

1. Wprowadzenie

Wyznaczenie dokładnego domknięcia przechodniego grafu w przypadku wielu algorytmów staje się kluczowym wymaganiem zapewniającym prawidłowość wykonywanych

przez nich obliczeń. Dotyczy to przede wszystkim problemów związanych z analizą hierarchii (systemy baz danych), analizą przepływów (transport, sieci komputerowe i telekomunikacyjne) jak i również analizą zależności czasowych (systemy równoległe i rozproszone).

Jeżeli zagadnienie dopuszcza możliwość ponowienia procesu obliczeniowego w przypadku

zmiany parametrów wejściowych (dodanie lub usunięcie kolejnych wierzchołków), wówczas za prawidłowe uznaje się zastosowanie jednego z dobrze znanych algorytmów przeszukiwania w głąb (ang. depth-first search) lub przeszukiwania wszerz (ang. breadth-first

search) [5]. Niestety powyższe metody nie sprawdzają się w przypadku gdy proces wyznaczenia domknięcia przechodniego może być przeprowadzony tylko raz, a otrzymany wynik

powinien być prawidłowy niezależnie od zmieniającej się liczby wierzchołków takiego grafu. Dotychczas zaproponowano kilka sposobów rozwiązania tego problemu, które zaprezentowano w publikacjach [1][2][9]. Jednak specyfika danego zadania determinuje konieczność

doboru odpowiedniej formy reprezentacji grafu. Ponieważ obszar naszych zainteresowań

sprowadza się do zastosowań w zakresie przetwarzania równoległego i rozproszonego, jeśli

za wierzchołki przyjmiemy instancje instrukcji a za krawędzie łączące te wierzchołki zależności pomiędzy tymi instancjami, to za odpowiedni uznaliśmy wybór relacji krotek symbolizujących istniejące połączenia pomiędzy wierzchołkami za pomocą ograniczeń w postaci

afinicznych równań i nierówności. Artykuł ten jest kontynuacją prac zapoczątkowanych

w [6][7][8][9], dotyczących opracowania algorytmów wyznaczających domknięcie przechodnie relacji afinicznej na bazie jej potęgi k i ich zastosowania do wyeksponowania zarówno drobno- jak i gruboziarnistej równoległości zawartej w pętlach.

Metody Informatyki Stosowanej, nr 2/2009 (19), s. 5-15

Polska Akademia Nauk Oddział w Gdańsku, Komisja Informatyki

ISSN 1898-5297

http://pan.wi.zut.edu.pl

6

Włodzimierz Bielecki, Tomasz Klimek, Maciej Pietrasik

2. Pojęcia podstawowe

Graf skierowany G ( V , E ) nazywamy domknięciem przechodnim grafu G, gdy E

jest zbiorem wszystkich takich par ( v, w ) wierzchołków ze zbioru V, że w grafie G istnieje

droga z v do w. Grafy mogą być reprezentowane za pomocą relacji krotek definiujących

mapowanie n - wymiarowych krotek na m - wymiarowe krotki. Krotka wejściowa symbolizuje wówczas początek a krotka wyjściowa koniec krawędzi łączącej dowolne dwa wierzchołki takiego grafu. K-krotka (ang. Tuple) – jest to punkt w przestrzeni Z k o wartościach

całkowitych o wymiarze k. Postać ogólna relacji wygląda następująco :

s , s

1

, ..., s k t 1, t 2 , ..., t k ' |

2

n

,

i1

i 1

i2

, ...,

i

mi

s .t .

F

i

(1)

,

gdzie F i to ograniczenia w postaci afinicznych równań i nierówności nałożonych na składowe krotki wejściowej s1 , s2 ,..., sk , wyjściowej t1 , t2 ,..., tk ' , zmienne egzystencjalne

i1 , i 2 ,..., im i stałe symboliczne. Istnieją dwie relacje związane z domknięciem przechodi

nim: dodatnie domknięcie przechodnie – R i domknięcie przechodnie R* R I , gdzie

I to relacja tożsamości:

s , s

1

, ..., s k s 1, s 2 , ..., s k |

2

n

,

i 1

i1

i2

, ...,

i

mi

s .t .

F

i

,

(2)

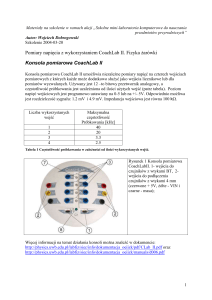

F i to ograniczenia w postaci afinicznych równań i nierówności nałożonych na składowe krotki wejściowej s1 , s2 ,..., sk , zmienne egzystencjalne i1 , i 2 ,..., imi i stałe symboliczne. Rysunek 1 przedstawia graf reprezentowany przez relację R {[i ] [i 1] : 1 i n} ,

dla n=3, wraz z odpowiadającymi jej relacjami R {[i ] [i '] : 1 i i ' 4} i

R* {[i ] [i '] : 1 i i ' 4} {[i] [i] : 1 i 4}

R

R+

R*

Rysunek 1. Relacja reprezentująca graf, wraz z jej dodatnim domknięciem przechodniem

i domknięciem przechodnim

Dokładne domknięcie przechodnie relacji R przyjmuje następującą postać:

Obliczenie tranzytywnego domknięcia sparametryzowanych relacji zależności…

7

R R k , gdzie

(3)

k 1

R k R R k 1

R k 1 R R k 2

...

(4)

R1 R

R0 I

“ ” jest operatorem kompozycji relacji. Z powyższego zapisu (3) wynika, że proces obliczenia relacji R powinien być poprzedzony wyznaczeniem relacji R k . W kolejnym rozdziale zaprezentowane zostaną techniki umożliwiające wyznaczanie relacji R k dla pojedynczej afinicznej relacji R .

3. Wyznaczanie relacji R k i R dla pojedynczej relacji afinicznej

3.1. Stan wiedzy

k

Najprostsze rozwiązanie umożliwiające obliczenie relacji R i R sprowadza się do zastosowania algorytmu iteracyjnego. Przykład takiego algorytmu wygląda następująco:

1

Rk

2

R1 R

3

4

i2

i 2

do

5

R i R i 1 R

6

7

if

8

( R i ) ( R i R i 1 R i 2 ... R1 ) then

begin

R k ( R1 k 1) ( R 2 k 2 ) ... ( R i 1 k i 1)

9

10

break

end

11

i i 1

12

13

14

15

16

while i N

if R k then

begin

print „Obliczenie dokładnego

end

k

powiodło się”

Rnie

Rysunek 2. Iteracyjny algorytm obliczania potęgi k relacji

i

W algorytmie z rysunku 2 relacja R zawiera krawędzie przechodnie obliczone w i-tej

k

iteracji, a R sumę tych krawędzi uzyskanych w iteracjach od pierwszej do i-1. Powyższy

algorytm poddano licznym modyfikacjom, mającym na celu skrócenie czasu jego działania,

8

Włodzimierz Bielecki, Tomasz Klimek, Maciej Pietrasik

poprzez zwiększenie przyrostu krawędzi przechodnich uzyskanych w danej iteracji zgodnie

z poniższym wzorem:

k 1

k 1

R R k R I R 2 R I R I R 2 I R 4

k

(5)

Pomimo wyraźnej prostoty algorytmy iteracyjne nie mogą być wykorzystywane wprost

do wyznaczenia dokładnego domknięcia przechodniego relacji sparametryzowanych, ponieważ w ich przypadku warunek stopu (linia nr 6 algorytmu) nie zawsze będzie spełniony.

Na przykład, dla następującego przykładu relacji:

R {[m, n] [m 1, m n 1] : 1 n m P 2}

(6)

metoda iteracyjna zawodzi. Zgodnie z bieżącym stanem wiedzy nie istnieje sformalizowane

podejście umożliwiające obliczenie relacji R k i R w ogólnym przypadku. W artykule [9]

wyodrębniono klasę relacji d-form, dla których jest to możliwe.

Relacja należy do klasy d-form wtedy i tylko wtedy gdy przyjmuje następującą postać :

i1 , i2 ,..., im j1 , j2 ,..., jm : p,1 p m,

,

p s.t. ( L p j p i p U p j p i p M p p )

(7)

gdzie L p , U p , M p Z i definiują one wartości stałe nakładające ograniczenia na różnicę

składowych krotki wyjściowej j p , wejściowej i p i zmiennych egzystencjalnych p . W

przypadku gdy L p lub U p ograniczenie takie jest pomijane przy zapisie powyższej relacji (8). Rysunek 2 przedstawia relację R {[i, j ] [i ', j 2] : 1 i i ' n 1 j m 2}

dla n=4 i m=3, należącą do klasy relacji d-form.

Rysunek 2. Przykład relacji d-form

Dla powyższej relacji R k wygląda następująco:

i, j i ', j ' : k 0 i

'

i

k j ' j 2k

1

2

Rk

1 i n 1 1 j m 2 2 i ' n 3 j ' m .

3

4

(8)

Obliczenie tranzytywnego domknięcia sparametryzowanych relacji zależności…

9

Gdzie poszczególne ograniczenia mają następujące znaczenie:

(1) ograniczenia nałożone na różnicę składowych krotki wyjściowej i’ i wejściowej i dla

danego k.

(2) ograniczenia nałożone na różnicę składowych krotki wyjściowej j’ i wejściowej j dla

danego k.

(3) ograniczenia definiujące zbiór domain( R ).

(4) ograniczenia definiujące zbiór range( R ).

Dodając kwantyfikator do relacji R k wzglądem zmiennej k otrzymujemy relację R :

'

i

k j' j 2k

i, j i' , j' : ( k : k 0 i

1

2

R

.

1

1

1

2

2

'

3

'

)

i

n

j

m

i

n

j

m

3

4

(9)

W pozostałych przypadkach z uwagi na brak sformalizowanych metod umożliwiających

obliczenie relacji R k w sposób dokładny, dobrze znaną praktyką jest zastosowanie zamiennika w postaci przybliżenia dolnego (niepełny zbiór krawędzi przechodnich) lub górnego

(krawędzie nadmiarowe). Przybliżenie dolne otrzymujemy stosując poniższą formułę:

n

k

RLB

(n) R

(10)

k 1

Dla odpowiednio małych wartości parametru n rozwiązanie to będzie zarazem rozwiązaniem dokładnym i równoważnym wykonaniu n kroków algorytmu iteracyjnego. W przypadku ograniczenia górnego zważywszy na fakt, że dla dowolnej relacji R istnieje relacja d

należąca do klasy d-form, taka że R d , relację R k obliczamy zgodnie z podejściem charakterystycznym dla relacji d-form, a otrzymane rozwiązanie stanowi przybliżenie górne

krawędzi przechodnich relacji R.

3.2. Rozwinięcie istniejących metod

Proces wyznaczenia potęgi k pojedynczej relacji afinicznej rozpoczynamy zawsze od

próby poszukiwania rozwiązania dokładnego. Kluczowe staje się sprawdzenie czy relacja

tworzy łańcuch połączonych ze sobą krawędzi grafu. Jeśli domain( R) range( R)

oznacza to, iż żaden z końców relacji nie należy jednocześnie do jej początków i tym samym relacja R k przyjmuje postać:

R dla k 1

Rk

dla k 1

(11)

Najczęściej taki przypadek ma miejsce, gdy liczba zmiennych krotek wejściowej relacji

rożni się od liczby zmiennych krotki wyjściowej tej samej relacji. Sytuację taką obrazuje

relacja (12)

R {[i ] [i ', j ] : 1 i i ' n 1 j m }

(12)

W przeciwnym wypadku, gdy relacja dla której poszukujemy jej potęgi k nie jest relacją

d-form i spełnione są poniższe warunki:

1) relacja nie jest sumą wielu relacji, których krotki wyznaczające początki i końce są różne,

10

Włodzimierz Bielecki, Tomasz Klimek, Maciej Pietrasik

2) każdy koniec/początek posiada dokładnie jeden początek/koniec, tzn. dla dowolnego

początku d domain( Ri ) /końca r range( Ri ) istnieje dokładnie jeden koniec

range( Ri (d )) /początek domain( Ri1 (r )) , co jest równoważne z tym, że nie istnieją takie

d i i d j , że d i d j i R (d i ) R(d j ) / ri i r j , że ri r j i R 1 (ri ) R 1 (r j ) ,

3) liczba zmiennych zawartych w opisie relacji, musi być mniejsza lub równa ilości zmiennych indeksujących pętli,

wówczas możemy skorzystać z alternatywnego podejścia do obliczenia relacji R k opartego

na utworzeniu i rozwiązaniu układu równań rekurencyjnych. Szczegóły tej metody wraz z

wynikami przeprowadzonych badań zawarte są w artykułach [6][7][8]. Dla przykładowej

relacji R {[i] [2i] : 1 i 2i n } , która nie jest typu d-form, przybliżenie górne relacji R k , obliczone w oparciu o metodę przedstawioną w [9], wygląda następująco:

Rk i i' : k 0 i'i k i 1 2i n 2 i' n ( : i' 2 ) ,

(13)

podczas gdy podejście oparte na zastosowaniu układu równań rekurencyjnych:

[i ] [i '] : k 0 i 1 2i n i ' i 2k

Rk

,

2 i ' n ( :2 i ' )

(14)

pozwala zdefiniować relację reprezentującą rozwiązanie dokładne. Na podstawie przeprowadzonych obserwacji wytypowaliśmy kolejną klasę relacji, dla której obliczenie jej

dokładnej potęgi k jest możliwe. Należą do niej tzw. relacje hybrydowe, czyli takie których

część odpowiadających sobie składowych krotki wejściowej i wyjściowej jest charakterystyczna dla relacji d-form, a pozostała spełnia wymagania konieczne dla utworzenia i rozwiązania układu równań rekurencyjnych.

Dla przykładowej relacji (15):

R [i, j ] [i ', 2 j ] : 1 i i ' n j 1 2 j m ,

(15)

para składowych wejściowych i wyjściowych – i, i’ spełnia wymagania charakterystyczne dla relacji d-form, z kolei para składowych wejściowych i wyjściowych – j, 2j jest

odpowiednia dla utworzenia i rozwiązania układu równań rekurencyjnych. Stosując połączenie technik obliczania R k charakterystycznych dla relacji d-form wraz z metodą polegającą na utworzeniu i rozwiązaniu układu równań rekurencyjnych względem poszczególnych

składowych krotki wejściowej i wyjściowej, możliwe jest wyznaczenie potęgi k dla tego

typu relacji (15). Proces ten wygląda następująco.

1. Sprawdzamy czy dla poszczególnych składowych krotki wejściowej i wyjściowej istnieje zależność tylko pomiędzy odpowiadającymi sobie parami składowych znajdujących

się na tej samej pozycji. Jeśli nie, to koniec, proponowane podejście nie pozwala na obliczenie tranzytywnego domknięcia. Inaczej, tworzymy relacje Ri , 1 i m , gdzie m to

liczba składowych krotki wejściowej i wyjściowej, składające się tylko z i-tej składowej

tychże krotek. Pozostałe składowe deklarujemy jako zmienne egzystencjalne.

Dla relacji (15) uzyskujemy:

R1 [i ] [i ' ] : ( j : 1 i i ' n j 1 2 j m ) =

[i] [i' ] : 1 i i' n 2 m ,

Obliczenie tranzytywnego domknięcia sparametryzowanych relacji zależności…

11

R2 [ j ] [2 j ] : ( i ' , i : 1 i i ' n j 1 2 j m )=

[ j ] [2 j ] : 2 j m 1 j 2 n.

2. Dla nowo powstałych relacji Ri sprawdzamy ich przynależność do klasy relacji a) dform b) lub takiej, dla której możliwe jest utworzenie i rozwiązanie układu równań rekurencyjnych

a) ri diffTo Re l ( difference ( Ri )) , gdzie funkcja biblioteczna difference( R ) pakietu

Omega[10] oblicza zbiór wektorów dystansu relacji R, a funkcja diffToRel pakietu

Omega[10] tworzy relację r na podstawie zadanego zbioru.

r1 diffTo Re l ( difference ( R1 )) ;

Po wprowadzeniu ograniczenia dla r1 na domain( R1 ) i range( R1 ) :

r1 (r1 \ domain( R1 )) / range( R1 ) , przystępujemy do dokonania sprawdzenia:

r1 R1 R1 r1 , czyli r1 R1 a to oznacza że relacja R1 spełnia warunek konieczny przynależności do klasy relacji d-form.

b) jeżeli (lf Ri ) Ri ( lf Ri ) Ri , gdzie lf to relacja leksykograficznie

dodatnia, oznacza to że wykluczono istnienie wspólnych początków i końców.

Relacja R jest leksykograficznie dodatnia wtedy i tylko wtedy, gdy:

x y R, 0 y x ,

(16)

Pierwsza część warunku: (lf R2 ) R2 wyklucza istnienie takich ri i r j , że

ri r j

i

r range( Ri )

( lf Ri ) Ri

R 1 (ri ) R 1 (r j ) .

i

wyklucza

istnienie

takich

Z

di

kolei

i

dj,

druga

że

część:

di d j

i d domain( Ri ) i R(d i ) R (d j ) .

Ponieważ dla analizowanej relacji warunek: (lf R2 ) R2 ( lf R2 ) R2 ,

gdzie lf {[i ] [i ' ] : i ' i } jest spełniony wnioskujemy, iż spełnione są wymagania

niezbędne do utworzenia i rozwiązania układu równań rekurencyjnych w celu wyznaczenia jej k-tej potęgi.

Jeżeli każda z relacji Ri należy do dowolnej z powyższych klas to kontynuujemy

postępowanie. W przeciwnym przypadku koniec, proponowane podejście nie pozwala na obliczenie tranzytywnego domknięcia.

3. Tworzymy relację Rc łącząc poszczególne składowe relacji Ri wraz z ich ograniczeniami.

m

Rc {[ s1 , s2 ,..., sm ] [t 1, t 2 ,..., t m ] : constraints on si from Ri

i 0

constraints on ti from Ri }

12

Włodzimierz Bielecki, Tomasz Klimek, Maciej Pietrasik

Rc [i , j ] [i ' , 2 j ] : 1 i i ' n 2 m 2 j m 1 j 2 n , gdzie

1

2

(1) jest to ograniczenie dla zmiennych i, i’,

(2) jest to ograniczenie dla zmiennej j.

Ponieważ Rc R R Rc , możliwe jest połączenie obu technik w celu wyznaczenia relacji R k , która w tym przypadku wygląda następująco:

[i, j ] [i ', j ']: k 0 1 i n j 1 2 j m 2 i ' n

Rk

2 j ' m i ' i k j ' j 2k ( :2 i '

)

(17)

Ostatecznie otrzymana relacja R k powinna spełniać warunek wystarczający :

r k R k , gdzie

R

rk

k

R R

dla

dla

k 1

k 1

(18)

(19)

aby można było uznać, że reprezentuje rozwiązanie dokładne.

Należy zwrócić uwagę, że w procesie mapowania krotki wejściowej na krotkę wyjściową (15), w tej ostatniej, każda ze składowych zależy tylko i wyłącznie od odpowiadającej

jej składowej krotki wejściowej, czyli tej znajdującej się na tej samej pozycji. Relacja (20)

nie spełnia tego wymagania, ponieważ jej druga składowa krotki wyjściowej jest mapowana

nie tylko względem pierwszej ale i drugiej składowej krotki wejściowej:

R [i, j ] [i ', i j ] : 1, i ' 3 i i ' n j 1 i j m

(20)

Jednak jeśli relacja reprezentuje skończony zbiór relacji spełniających wcześniej zdefiniowane warunki: 1, 2 i 3, wówczas korzystne staje się dokonanie rozwinięcia takiej relacji

do sumy relacji, dla których możliwe jest utworzenie i rozwiązanie układu równań rekurencyjnych. Pewne kroki w tym kierunku zostały już poczynione a ich analiza stała się przedmiotem dalszych badań autorów.

4. Wyniki badań

Do badań wybrano trzy benchmarki: NAS[13], Livemoore Loops[12] oraz UTDSP[14].

Pierwszy z nich, opracowany przez NASA, składa się z pięciu jąder oraz trzech aplikacji

CFD (ang. Computional Fluid Dynamics). Łącznie zawiera on 431 pętli, jednak do naszych

badań wykorzystaliśmy 257 (pozostałe zawierają instrukcje skoku, bądź instrukcje zmieniające krok pętli oraz odwołania do niezdefiniowanych zewnętrznych funkcji, które mogą

wprowadzić nieznane zależności danych). Benchmark Livemoore Loops opracowany przez

Lawrence Livermoore National Laboratory zawiera 24 pętle, z których odrzucono 5 ze

względu na występujące w nich ograniczenia w postaci funkcji oraz instrukcje break i continue. Ostatni zbiór testowy – UTDSP (University of Toronto Digital Signal Processing)

składający się z sześciu jąder oraz 10 aplikacji przeznaczonych do cyfrowego przetwarzania sygnałów, zawiera 77 pętli, spośród których wybrano 29, które spełniają wspomniane

wcześniej wymagania. Do badań został zastosowany program Petit służący do przeprowadzenia analizy zależności w pętlach programowych. Wynikiem analizy zależności jest zbiór

Obliczenie tranzytywnego domknięcia sparametryzowanych relacji zależności…

13

relacji zależności produkowanych dla danej pętli. Celem badań było rozpoznanie jaki jest

procent relacji poszczególnych pętli oraz zbadanie możliwości obliczenia tranzytywnego

domknięcia relacji. W tym celu zostało opracowane narzędzie w oparciu o bibliotekę Omega [10], które rozpoznaje typ relacji, oblicza dla niej najpierw Rk, a potem jej tranzytywne

domknięcie korzystając z odpowiedniej techniki omówionej w artykule.

Tabela 1a

1

2

3

4

5

6

Benchmark

Liczba

wszystkich

relacji

Liczba relacji

bez wspólnych

elementów

dziedziny i

przeciwdziedziny

Livemoore

1148

22

1,92%

76

6,62 %

UTDSP

700

26

3,71 %

244

34,86 %

NAS

52098

772

1,48 %

11459

22 %

Procent relacji

Liczba relacji

Procent relacji

bez wspólnych

o różnych

o różnych

elementów

wymiarach krotek wymiarach krotek

dziedziny i

wej. i wyj.

wej. i wyj.

przeciwdziedziny

Tabela 1b

7

8

9

Benchmark

Liczba

relacji

d-form

Procent

relacji

d-form

Livemoore

1044

90,94 %

0

UTDSP

425

60,71 %

NAS

39776

76,35 %

10

11

12

Liczba

relacji

hybrydowych

Procent

relacji

hybrydowych

0%

3

0,26 %

2

0,29 %

1

0,14 %

10

0,02%

48

0,09 %

Liczba relacji,

Procent relacji,

których Rk

których Rk

wyzn. za pomocą wyzn. za pomocą

równań

równań

rekurencyjnych

rekurencyjnych

Tabela 1c

13

14

15

Benchmark

Liczba relacji, dla

których wyznaczono Rk

Procent relacji,

dla których wyznaczono Rk

Relacje, których

Rk obliczono met.

iterac.

Livemoore

1145

99,74 %

3

UTDSP

698

99,71 %

2

NAS

52098

100 %

0

Tabela 1 przedstawia wyniki badań. W kolumnie 3 podane są liczby relacji, których

krotki wejściowe i wyjściowe mają taki sam wymiar; R k dla tych relacji obliczone w oparciu o wzór (11). Kolumna 5 zawiera liczby relacji o rożnych wymiarach krotek wejściowej

i wyjściowej, ich R k również jest obliczone za pomocą wzoru (11). Kolumna 15 przedstawia liczby innych relacji czyli takich, które nie można odnieść do żadnej z klas relacji rozpatrywanych w danym artykule. Na przykład, relacja o następującej postaci:

R [l, i, k ] [l ' , i k 1, k ' ] : 1 l l ' loop i n 0 k ' 2 k k ' i 0 k

14

Włodzimierz Bielecki, Tomasz Klimek, Maciej Pietrasik

nie należy ani do klasy d-form, ani do klasy relacji hybrydowych, jej tranzytywne domknięcie nie może być obliczone w oparciu o równania rekurencyjne ponieważ graf zależności

reprezentowany przez R nie jest łańcuchem. R k dla tych relacji zostało obliczone metodą

iteracyjną przedstawioną w podrozdziale 3.1.

Z analizy wyników zawartych w Tabeli 1 nasuwają się następujące wnioski. Dla badanych benchmarków najwięcej relacji to są relacje, należące do klasy d-form. Ale również są

relacje, których tranzytywne domkniecie nie może być obliczone w oparciu o znane podejścia, są to relacje, których tranzytywne domknięcie może być obliczone tylko na podstawie

metody zawartej w danym artykule. Przeprowadzone badania również wskazują na to, że

pozostaje grupa relacji (chociaż i nie liczna), dla których nie są znane nie iteracyjne podejścia pozwalające na obliczenia tranzytywnego domknięcia (przykład takiej relacji podany

jest wyżej). Celem naszych przyszłych badań jest opracowanie uniwersalnej nie iteracyjnej

metody pozwalającej na obliczenie tranzytywnego domknięcia dowolnej afinicznej relacji

zależności.

5. Podsumowanie

Przedstawiliśmy w artykule sposoby obliczenia domknięcia przechodniego sparametryzowanych relacji nie należących do klasy relacji d-form. Do takich relacji należą relacje,

których ograniczenia tranzytywnego domknięcia mają nieliniowe wyrażenia oraz relacje

hybrydowe czyli takie, których część odpowiadających sobie składowych krotki wejściowej i wyjściowej jest charakterystyczna dla relacji d-form [9], a pozostała pozwala na zastosowanie techniki opartej na utworzeniu i rozwiązaniu układu równań rekurencyjnych [7].

Przedstawione podejścia pozwalają na rozszerzenie możliwości obliczania tranzytywnego

domknięcia relacji, a znaczy znajdowanie równoległości dla większego spektrum pętli programowych.

Bibliografia

[1] B. Boigelot. Symbolic Methods for Exploring Infnite State Spaces. PhD thesis, Universite de Liµege, 1998.

[2] E. Nuutila. Efficient Transitive Closure Computation in Large Digraphs, Mathematics

and Computing in Engineering Series No. 74 PhD thesis Helsinki University of Technology

[3] P. Feautrier, Some Efficient Solutions to the Affine Scheduling Problem, Part I. OneDimensional Time, International Journal of Parallel Programing, Vol 21(5), 1992

[4] P. Feautrier, Some Efficient Solution to the Affine Scheduling Problem, Part II, MultiDimensional Time, International Journal of Parallel Programing, Vol 21(6), 1992

[5] T. Cormen, C. E. Leiserson, R. Rivest, Introduction to Algorithms, The MIT Press,

2001

[6] W. Bielecki, R. Drążkowski, Approach to building free schedules for loops with affine

dependences represented with a single dependence relation, WSEAS Transactions on

Computers, Issue 11, Volume 4, 2005

[7] W. Bielecki, T. Klimek, K. Trifunovič, Calculating Exact Transitive Closure for a

Normalized Affine Integer Tuple Relation, Electronic Notes in Discrete Mathematics 33

(2009) 7–14

[8] W. Bielecki, T. Klimek, K. Trifunovič, Obliczenie potęgi k znormalizowanej afinicznej

relacji, Metody Informatyki Stosowanej Nr 2/2008 (Tom 15)

Obliczenie tranzytywnego domknięcia sparametryzowanych relacji zależności…

15

[9] W.Kelly, W. Pugh, E. Rosser, T. Shpeisman, Transitive clousure of infinite graphs and

its applications, Languages and Compilers for Parallel Computing, 1995

[10] W. Kelly, V. Maslov, W. Pugh, E. Rosser, T. Shpeisman, D. Wonnacott, The Omega

library interface guide, Technical Report CS-TR-3445, Dept. of Computer Science,

University of Maryland, College Park, March 1995

[11] http://mathworld.wolfram.com/RecurrenceEquation.html [online] [Dostęp 15.04.2009]

[12] http://www.netlib.org/benchmark/livermore [online] [Dostęp 30.03.2009]

[13] http://www.nas.nasa.gov/Software/NPB [online] [Dostęp 03.04.2009]

[14] http://www.eecg.toronto.edu/~corinna/DSP/infrastructure/UTDSP.html [online]

[Dostęp 10.04.2009]

Metoda steganograficzna na bazie wprowadzenia

dodatkowego bitu danych medialnych

Larisa Dobryakova, Evgeny Ochin

Zachodniopomorski Uniwersytet Technologiczny w Szczecinie,

Wydział Informatyki

Abstract:

Into the container-original it is introduced the additional low-order digit which is equal to

high (signed) bit. This additional low-order digit is non-significant, that is it does not bring

distortions in the container-original. Applying procedure of importation of the stego-message

in this bit we don’t bring distortions in the container-original.

Keywords:

steganography, LSB, additional bit, message embedding, container-original, container-result

1. Wprowadzenie

Steganografia – nauka zajmująca się ukrytym przesyłania danych, przy której ukrywa

się sam fakt przesyłania danych. W odróżnieniu od kryptografii, gdzie obserwator potrafi

ustalić, czy jest przesyłana wiadomość zaszyfrowanym tekstem, metody steganografii pozwalają na przesyłanie poufnej informacji niepostrzeżenie dla osób obcych.

W związku z obecnym rozwojem techniki obliczeniowej i szybkich kanałów przesyłania

informacji pojawiły się nowe metody steganograficzne, których podstawą są informacje

zawarte w plikach komputerowych [1].

W steganografii komputerowej istnieją dwa główne rodzaje plików: stego-wiadomość

(ukrywana wiadomość) i kontener – plik, który używa się do ukrycia w nim wiadomości.

Początkowy stan kontenera, gdy jeszcze nie zawiera ukrytej informacji, nazywa się kontenerem–oryginałem, a konieczny stan kontenera, gdy już zawiera stego-wiadomość, nazywa się

kontenerem–rezultatem1. W charakterze kontenera-oryginału często wykorzystuje się różne

pliki medialne, na przykład, pliki obrazu, dźwięku, wideo i inne. Wbudowanie stegowiadomości w kontener idzie w parze z pewnymi zniekształceniami danych medialnych,

jednak charakter zniekształceń musi być minimalny, aby słuchacz (lub widz), nie zauważył

pogorszenia jakości danych, zawartych w pliku medialnym. Wzrok i słuch człowieka nie

odróżnia nieznacznych zmian w kolorach obrazu lub w jakości dźwięku [2, 3, 4, 6].

Wyróżnia się dwie klasy metod wbudowania (dodawania2) stego-wiadomości w kontener [7].

1

W literaturze mozna znaleść „stego-plik, stegoobiekt”. W ramach danego artykułu wykorzystamy słowo„kontener-rezultat”, dlatego, że po-pierwszej, trzeba było w tekscie artykułu rozróżnić i podkreślić takie

pojęcia kontenera do wbudowania wiadomości i po wbudowaniu, po-drugiej takie pojęcia najcięściej sa używanie w literaturze angielskiej, po-trzeciej pod pojęciem „stego-plik, stegoobiekt” można zrozumieć jak kontener-oryginał, tak i kontenerar-rezultat lub w niektórych przypadkach stego-wiadomość.

2

Słowo „wbudowanie” jest najbardziej często stosowane przy opisie metod ukrywania informacji w literaturze polskiej.

Metody Informatyki Stosowanej, nr 2/2009 (19), s. 17-22

Polska Akademia Nauk Oddział w Gdańsku, Komisja Informatyki

ISSN 1898-5297

http://pan.wi.zut.edu.pl

18

Larisa Dobryakova, Evgeny Ochin

1. Klasa metod zniekształcających.

Klasa ta charakteryzuje się pewnymi zniekształceniami kontenera.

2. Klasa metod niezniekształcających.

Metody tej klasy nie zniekształcają kontenera.

Jedną z najbardziej znanych zniekształcających metod wbudowywania stegowiadomości w kontener jest zamiana najmniej znaczących bitów danych medialnych (Least

Significant Bit – LSB) na odpowiednią dwójkową stego-wiadomość. Metodę tę można wyjaśnić następująco.

Niech kontener-oryginał przedstawia I-elementowy wektor liczb dwójkowych Npozycyjnych, które reprezentowane są w kodzie uzupełniającym i opisują pewne dane audio:

N 2

Di di , N 1 2 N 1 d i , n 2n , i 0,1,..., I 1.

(1)

n 0

gdzie di ,n {0,1} – n-ta cyfra dwójkowa i-tej próbki kontenera-oryginału, di , N 1 – znak i-tej

próbki kontenera-oryginału ( di , N 1 0 dla liczb nieujemnych 0, di , N 1 1 dla liczb ujem-

nych), przy czym:

2 N 1 Di (2 N 1 1).

(2)

Na przykład, dla N=8 , zakres liczb reprezentowanych przez Di wynosi 128 Di 127 .

Stego-wiadomość tekstową przedstawimy w postaci wiersza bitowego długości K bitów3:

s0 s1 sk sK 1 ,

sk {0,1} .

(3)

Oznaczmy kontener-rezultat jako:

N 2

Di di, N 1 2 N 1 di,n 2n , i 0,1,..., I 1,

(4)

n0

gdzie di,n+ {0,1} – n-ta cyfra dwójkowa i-tej próbki kontenera-rezultatu, di, N 1 – znak i-tej

próbki kontenera-rezultatu.

Istnieje wiele różnych metod częściowej albo pełnej zamiany najmniej znaczących bitów di ,0 danych medialnych bitami stego-wiadomości. Najbardziej znany algorytm [5, 8]

wbudowania stego-wiadomości w kontener można opisać następująco:

N 2

N 1

D

s

d

2

di ,n 2n ,

i

i

i , N 1

n 1

D D , i K ,..., I 1

i

i

i 0,1,..., K 1

(5)

Stego-wiadomość zamienia najmniej znaczące bity pierwszych K próbek konteneraoryginału, co doprowadza do pewnych zniekształceń tego kontenera.

3

W literaturze mozna znaleść oznaczenie wierszy bitów jako s0 , s1 , sk , , sK 1 , jednak w ramach danego

artykułu korzystamy oznaczenie s0 s1 sk sK 1 dlatego, że w literaturze anglojęzycznej najczęściej używa się

opis ciągu bitów postaci s0 s1 sk sK 1 , na przykład 011100011 itd.

Metoda steganograficzna na bazie wprowadzenia dodatkowego bitu danych medialnych

19

Dlatego, że zniekształceniom poddają się tylko najmniej znaczące bity konteneraoryginału, to największa względna wartość zniekształceń jednej próbki kontenera-oryginału

równa jest 2 N , a średnia względna wartość zniekształceń jednej próbki określa się jako:

e

2 N

K

K 1

i 0

Di Di

2 N

K

K 1

d

i 0

i ,0

di,0

(6)

Na przykład, dla N 8 , w przypadku zniekształcenia K / 2 próbek, otrzymamy

28 K

e

29 0.2 .

K 2

Rozpatrzymy jeszcze jedno podejście do oceny zniekształceń jednej próbki konteneraoryginału.

Możliwe są tylko cztery kombinacje4 wartości najmniej znaczących bitów konteneraoryginału di ,0 oraz kontenera-rezultata di,0 (zob. tab. 1).

Tabela 1. Wartości LSB kontenera-oryginału di ,0 oraz kontenera-rezultata di,0 oraz prawdopodobieństwa je wystąpienia

j

di ,0

0

1

2

3

0

0

1

1

d

i ,0

Prawdopodobieństwo

pojawienia się

pary di ,0 di,0 – p j

Wartość

zniekształcenia

0

1

0

1

1/ 4

1/ 4

1/ 4

1/ 4

0

1

1

0

ej

Wartość

zniekształcenia

próbki Di

0

2 N

2 N

0

W przypadku braku jakiejkolwiek informacji apriorycznej o prawdopodobieństwach

wartości 0 albo 1 w najmniej znaczących bitach kontenera-oryginału di ,0 i kontenerarezultata di,0 , można przewidzieć ich jednakowe prawdopodobieństwo. W takim przypadku

średnia wartość zniekształceń jednego najmniej znaczącego bitu może być określona jako:

3

e ' e j / 4 (0 1 1 0 ) / 4 0.5

(7)

j 0

a średnia względna wartość zniekształceń jednej próbki odpowiednio jako 0.5 2 N 2 ( N 1) .

Na przykład, dla N 8 otrzymamy e' 2 (81) 29 0.2 , co zgadza się z oceną (6)

dla przypadku równie prawdopodobnego pojawienia się par najmniej znaczących bitów

kontenera-oryginału di ,0 i kontenera-rezultata di,0 .

2. Metoda zmniejszania zniekształceń danych medialnych

W kontener-oryginał (1) wprowadźmy dodatkowy bit di ,1 . Wynik takiej operacji analogicznie z (1) można przedstawić jako:

4

Cztery kombinacje daje 2 bity: jeden od kontenera-oryginału i drugij od kontenera-rezultatu.

20

Larisa Dobryakova, Evgeny Ochin

N 2

D 'i d 'i , N 1 2 N 1 d 'i ,n 2n , i 0,1,..., I 1

(8)

n 1

Operacja modyfikacji kontenera (8) nie doprowadza do zniekształceń konteneraoryginału (1) dlatego, że:

e

2 N

K

K 1

i 0

Di D 'i

2 N

K

K 1

d ' 0

d

i 0

i ,0

(9)

i ,0

0

W przypadku, gdy dodatkowy bit kontenera-oryginału jest równy 0, to dodatkowe zniekształcenie, wprowadzone w kontener-oryginał jest równe 0 – dla liczb nieujemnych i 0.5 –

dla liczb ujemnych. Wtedy, gdy dodatkowy bit kontenera-oryginału jest równy 1, to dodatkowe zniekształcenie, wprowadzone do kontenera-oryginał jest równe 0.5 – dla liczb nieujemnych i 0 – dla liczb ujemnych. W celu minimalizacji zniekształceń kontenera-oryginału

przy wprowadzaniu dodatkowego bitu (modyfikacji) nadamy wartości dodatkowego bitu

kontenera-oryginału wartość znaku kontenera-oryginała d 'i ,1 d 'i , N 1 .

Wbudujemy stego-wiadomość w zmodyfikowany kontener-oryginał (8). Analogicznie

jak w wyrażeniu (5) przedstawimy kontener-rezultat jako:

N 2

1

N 1

D

'

s

2

d

'

2

d 'i , n 2n ,

i i i , N 1

n0

D ' D ' , i K ,..., I 1

i

i

i 0,1,..., K 1

(10)

Stego-wiadomość wbudowuje się w dodatkowy bit d 'i ,1 pierwszych K próbek modyfikowanego kontenera-oryginału (8), co doprowadza do pewnych zniekształceń konteneraoryginału. Dlatego, że zniekształceniom jest poddawany tylko dodatkowy bit d 'i ,1 zmodyfikowanego kontenera-oryginału , to największa wartość względna zniekształceń jednej

próbki kontenera-oryginału równa 2 ( N 1) , a średnia względna wartość zniekształceń jednej

próbki może zostać określoną jako:

e

2 ( N 1)

K

K 1

i 0

D 'i D 'i

2 ( N 1)

K

K 1

d '

i 0

(11)

i , 1

Na przykład, dla N 8 , w przypadku zniekształcenia K / 2 próbek, otrzymamy

29 K

e

210 0.1 .

K 2

Możliwe są tylko kombinacje wartości dodatkowego bitu kontenera-rezultata d 'i ,1 opisane w tabeli 2.

Tabela 2. Wartości LSB kontenera-rezultatu di,01 i prawdopodobieństwa ich wystąpienia

j

d 'i , N 1

d 'i ,1

0

1

2

3

0

0

1

1

0

1

0

1

wartości bitu d 'i ,1

Wartość

zniekształcenia

e j bitu d 'i ,1

0

1/ 2

1/ 2

0

0.5

0.5

2

2 ( N 1)

0

0

0

Prawdopodobieństwo p j

Wartość

zniekształcenia

próbki D 'i

0

( N 1)

Metoda steganograficzna na bazie wprowadzenia dodatkowego bitu danych medialnych

21

W przypadku braku jakiejkolwiek informacji apriorycznej o prawdopodobieństwach

wartości 0 albo 1 w najmniej znaczących bitach kontenera-rezultatu d 'i ,1 można przewidzieć ich jednakowe prawdopodobieństwo. W takim przypadku średnia wartość zniekształceń jednego najmniej znaczącego bitu może być określona jako:

3

e' e j / 4 (0 0.5 0.5 0 ) / 4 0.25

(12)

j 0

a średnia względna wartość zniekształceń jednej próbki odpowiednio 0.25 2 N 2 ( N 2) .

Na przykład, dla N 8 otrzymamy e' 2 (8 2) 210 0.1 , co zgadza się z oceną dla

przypadku równoprawdopodobnego pojawienia się wartości 0 albo 1 w pozycji d 'i ,1 kontenera-rezultatu.

3. Zniekształcenia po wbudowaniu stego-wiadomości

W tabeli 3 przedstawione zostały oceny średniej wartości zniekształceń jednej próbki

kontenera-oryginału dla opracowanego algorytmu wbudowania wiadomości w dane medialne na podstawie wprowadzenia dodatkowego najmniej znaczącego bitu kontenera oraz dla

algorytmu zamiany najmniej znaczących bitów pierwszych K próbek kontenera. Modelowanie wykonano w środowisku MATLAB.

Tabela 3. Wartości zniekształceń kontenera-oryginału

Algorytm

Algorytm zamiany najmniej

znaczących bitów pierwszych

K próbek kontenera

Algorytm na podstawie wprowadzenia dodatkowego bitu

Średnia wartość zniekształceń

jednej próbki kontenera

0.50

0.25

4. Wniosek

W rezultacie wprowadzenia dodatkowego bitu danych medialnych kontener-rezultat D

nie zniekształca się w stosunku do kontenera-oryginału, a przy warunku d 'i ,1 d 'i , N 1 modyfikowany kontener-oryginał D ' również nie zniekształca się. W modyfikowany kontenerrezultat D ' wnoszone są zniekształcenia, jednak je warośc jest dwa razy mniejsza, niż przy

wykorzystaniu algorytmu zamiany najmniej znaczących bitów pierwszych K próbek kontenera-oryginału.

W postaci badań praktycznych przeprowadzone zostało modelowanie na bazie Matlab,

tzn. napisany został program realizujący algorytm i obliczona wartośc zniekształceń kontenera-oryginału. Wyniki praktyczne obliczenia znieksztalceń są w tab. 3, co potwierdza wyniki teoretyczne, opisane w tab. 2.

Tekst programu zajmuje kilka stron, dlatego nie przyprowadzamy go w danem artykułu.

Jednak czytelnik zainteresowany może zapytać kopię tego programu na adres

[email protected] i otrzymać tekst programu bezpłatnie.

22

Larisa Dobryakova, Evgeny Ochin

Jednem z najważniejszych problemów, związanych z steganografią jest stegoanaliza,

przeznaczona dla odnalezienia ukrytych wiadomosci w plikach medialnych. W ramkach

danego artykułu problem odnalezienia ukrytych wiadomosci nie rozpatruje się.

Bibliografia

[1] В.Г. Грибунин, И. Н. Оков, И.В. Туринцев. Цифровая стеганография. Москва.

СОЛОН–Пресс. 2002.

[2] Osborne C., van Schyndel R., Tirkel A. A Digital Watermark. IEEE International Conference on Image Processing. 1994.

[3] Bender W., Gruhl B., Morimoto N., Lu A. Techniques for data hiding. IBM systems

journal. 1996. Vol.35. № 3.

[4] Petitcolas F., Anderson R., Kuhn M. Information Hiding – A Survey. Proceedings IEEE,

Special Issue on Identification and Protection of Multimedia Information. 1999. Vol 87.

№7.

[5] Arnold M., Kanka S. MP3 robust audio watermarking. International Watermarking

Workshop. 1999.

[6] Fridrich J., Du R., Long M. Steganalysis of LSB encoding in color images. ICME, 2000.

[7] Katzenbeisser S., Petitcolas F.A.P. (eds.). Information Hiding Techniques for Steganography and Digital Watermarking. Artech House, Norwood MA, 2000.

[8] Kirovski D., Malvar H. Spread-Spectrum Watermarking of Audio Signals. IEEE Transactions on Signal Processing. Vol. 51. 2003.

Analiza wielokryterialna

w zarządzaniu strategicznym e-biznesu

Luiza Fabisiak

Zachodniopomorski Uniwersytet Technologiczny w Szczecinie,

Wydział Informatyki

Abstract:

Present work trying to make an effort of adaptation multiple criteria decision in formulating

economy on-line store. Turn in study magnify problem of creating e-commerce strategy business. All methods and techniques scope in this subject was analyzed and methodic guidelines

of proposal own salvation was shown. Results applied strategy analyze methods connected

with multiple criteria decision aid in creating realistic e-commerce strategy was shown.

Whole execute research closing by final conclusion.

Keywords:

online shop, e-commerce, AHP, multicriteria decision support

1. Wstęp

Jednym z najszybciej rozwijających się działów gospodarki w skali globalnej jest

w ostatnich latach handel elektroniczny. Usługi elektroniczne są procesem polegającym na

dodawaniu większej funkcjonalności do istniejących programów użytkowych w handlu

elektronicznym i biznesie elektronicznym. Celem usług elektronicznych jest zwiększenie

satysfakcji klienta z usług internetowych, które są dostarczane. Różnorodność i bogactwo

sieci powoduje, że klient ma ze swego komputera dostęp do olbrzymich ilości informacji

i wielu ofert sprzedaży, co daje mu bezprecedensową władzę przy wyborze produktu.

W nowej cyfrowej ekonomii równowaga sił została gwałtownie przechylona ze sprzedawcy

do konsumenta. W tym środowisku znaczenie programów gromadzenia szczegółowych informacji o klientach i rozszerzonego wsparcia dla klientów nigdy nie było większe. Rozwój

rynku e-commerce w Polsce jest wyrazem podążania przedsiębiorstw w kierunku gospodarki elektronicznej[1]. Coraz liczniejsze sklepy internetowe wzorują swoje rozwiązania na

amerykańskich liderach, takich jak Amazon.com oraz Walmart.com.

2. E-commerce

Handel w Internecie rozwija się w błyskawicznym tempie. Powszechna komputeryzacja

oraz tani dostęp do Internetu w Stanach Zjednoczonych stworzyła podstawy do jego narodzin. W 1996 roku obroty firm prowadzących działalność w Sieci wyniosły 800 mln. USD,

a z roku na rok wynosiły dziesięciokrotnie więcej (źródło: Forrester Research). Elektroniczny handel tworzy tzw. Nową Ekonomię – gospodarkę. Zagraniczni analitycy uważają,

że handel w Internecie stanie się motorem stałego, szybkiego wzrostu gospodarczego w najbliższej latach [2].

Metody Informatyki Stosowanej, nr 2/2009 (19), s. 23-30

Polska Akademia Nauk Oddział w Gdańsku, Komisja Informatyki

ISSN 1898-5297

http://pan.wi.zut.edu.pl

24

Luiza Fabisiak

Stworzenie własnego sklepu zapewnia nieograniczone możliwości zarządzania jego parametrami. Wszystkie wykonywane operacje zależne są jedynie od woli przedsiębiorcy,

jednocześnie nie wywołują wzrostu kosztów działania. Począwszy od programowania informatycznego, skończywszy na rozstawieniu towarów na elektronicznych półkach. Zasada

działania sklepu internetowego jest dosyć skomplikowana i opiera się na wykorzystywaniu

specjalistycznego oprogramowania. Schemat pojedynczej transakcji może wyglądać następująco: klient wchodząc na stronę internetowego sklepu danej firmy poszukuje interesującego go produktu. Może w tym celu skorzystać z wyszukiwarki produktów. Po znalezieniu

interesującego go towaru zapoznaje się z jego opisem, wyglądem itp. Jeżeli produkt odpowiada jego oczekiwaniom to dodaje go do swojego koszyka, który towarzyszy mu od momentu wejścia na witrynę sklepu [3]. Sklep internetowy działa na podobnych zasadach co

tradycyjny tzn. umożliwia klientowi zapoznanie się z towarem, dokonanie zakupu, zapłaty

za zmówiony produkt. Najważniejszą różnicą jest to, że istnieje on tylko w Internecie w postaci wyspecjalizowanej witryny WWW oraz, że klient nie może otrzymać towarów fizycznych (książki, sprzęt elektroniczny itp.) bezpośrednio po dokonaniu zakupu lecz musi czekać na ich dostarczenie [4]. Jedną z zalet posiadania szerokiego asortymentu w sklepie internetowym jest możliwość przyciągnięcia większej liczby klientów i zwiększenie średniej

wartości zamówienia. Zaindeksowane w wyszukiwarkach towary przyciągają klientów

z całego świata. Liczba klientów jest ograniczona jedynie dostępem do Internetu i barierą

językową [5].

Techniki marketingowe stosowane w sklepach internetowych, do których zaliczyć można np. cross-selling oraz systemy rekomendacji, polegające najczęściej na pokazaniu towarów, zakupionych przez klientów, którzy kupili oglądany towar („Klienci, którzy kupili towar A, kupili również:...”) [6]. System rekomendacji jest jedną z metod, które powodują, że

towary rzadko zamawiane mogą zacząć sprzedawać się w dużych ilościach, jeżeli zostanie

zamówiony taki towar kupując równocześnie bestseller [13]. Posiadanie długiego ogona pozycji asortymentowych, dającego możliwość szerokiego wyboru, nie tylko z hitów, ale również z niszowych pozycji nie dostępnych w tradycyjnych sklepach daje przewagę konkurencyjną na rynku [7].

Po wprowadzeniu systemu rekomendacji należy uwzględnić polecenie produktu tak aby

było związane z aktualnie przeglądanym asortymentem, a przy polecaniu dodatkowym wybieranego towaru nie ograniczał się tylko do jednej strony produktu. Amazon.com kolejne

produkty poleca na stronie wyświetlającej się po dodaniu produktu do koszyka, a także na

stronie głównej koszyka. W ten sposób żaden fragment strony się nie marnuje, a sklep wykorzystuje do końca możliwości sprzedaży i ułatwia eksplorację serwisu. W sklepie internetowym amazon.com na stronie głównej znajdujemy sekcje z informacjami o produktach kupionych przez osoby, które w wyszukiwarkę wpisywały podobne zapytania. Tego typu mechanizmy są skuteczne, co ma znaczenie przy budowie zaufania klienta [8].

Pomiędzy pokazywaniem produktów kupowanych przez innych użytkowników, a produktów uzupełniających zachodzi ważna różnica. W pierwszym przypadku klienci nie czują

się atakowani reklamą - ponieważ to informacja bazująca na wyborach innych klientów,

czyli ich rekomendacje. Natomiast drugi przypadek to konkretna reklama - wyświetlanie

więcej niż 3-4 produktów, która może być źle odbierane [7,8].

3. Struktura informacyjna sklepu internetowego

Ważną cechą sklepu internetowego powinna być wygoda i prosta w obsłudze, która

umożliwia, że klient w trakcie transakcji, wyboru produktów potrafi się poruszać po sklepie

w sposób intuicyjny. Elementem ułatwiającym nawigację po sklepie internetowym jest tzw.

Analiza wielokryterialna w zarządzaniu strategicznym e-biznesu

25

belka nawigacyjna dająca możliwość przejścia do dowolnego działu sklepu (kategorii produktów), bez konieczności powrotu do strony startowej sklepu. Wszystkie analizowane

sklepy posiadają ten atrybut. Poprawiające nawigację inne elementy to łącze do strony startowej sklepu, wgląd w zawartość koszyka oraz dostęp do wyszukiwarki[9]. Klient sklepu

internetowego niejednokrotnie może mieć pytania związane np. z informacją dotyczącą dostawy towaru, formą zapłaty bądź bezpieczeństwem zakupów jakie posiada sklep. Dlatego

istotne jest umieszczenie łącza do pomocy oraz FAQ (ang. Frequently Asked Questions),

Atutem sklepu internetowego jest umieszczona w nim mapa serwisu, przedstawiająca

wszystkie kategorie i grupy produktów. - atrybut taki posiada Amazon.com [8,14].

Sklepy internetowe są typową działalnością e-commerce. Za definicję sklepu internetowego można przyjąć stwierdzenie, że jest to strona WWW współpracująca z bazą danych

realizująca przyglądanie, wybór i nabywanie określonego typu produktów. Każdy sklep internetowy powinien zapewniać realizację podstawowych funkcji w celu odpowiedniej komunikacji z klientem i osiągnięciu maksymalnych zysków ze sprzedaży. Można to osiągnąć

przez odpowiednią realizację techniczną, która powinna zapewniać [10]:

mechanizm uczenia się upodobań klienta,

łatwy dostęp do artykułów zgrupowanych w grupach tematycznych i posiadających

szczegółowy opis,

podpowiadania klientowi oferty uzupełniających i komplementarnych,

oferowanie sprzedaży wiązanej i promocyjnej,

szybki proces kupowania przez tworzenie listy zakupowych,

wyszukiwanie produktów, grup produktów,

system rabatów opartych o indywidualne profile klienta, umowy handlowe, upusty ilościowe oraz promocyjne,

zaawansowaną obsługę klienta, wyłącznie z komunikacją elektroniczną oraz personalizowaną stroną przedstawiającą historię transakcji,

dużą skalowością systemu umożliwiającą integracje z innymi systemami [11].

Abstrahując od różnych znanych rozwiązań oraz podejść do budowy serwisu internetowego typu e-market, w niniejszej pracy została zaprezentowana struktura sklepu internetowego pod kontem określonych potrzeb klienta z uwzględnieniem podstawowych metodologicznych procedur projektowania struktury informacyjnej (Rys. 1).

Rysunek 1. Schemat budowy sklepu internetowego

Źródło: opracowanie własne na podstawie [12]

26

Luiza Fabisiak

Schemat prezentuje dokonywanie zakupów realizowanych na zasadzie pełnego uwierzytelnienia danych klienta poprzez jego rejestrację i automatyzację w bazie danych serwera.

Sytuacja umożliwia korzystanie z pełnej oferty sklepu internetowego, dopiero po procesie

rejestracji i zalogowaniu się na serwer jednocześnie uwzględnia wiarygodność klienta co

pozwala na bezpiecznie przeprowadzenie transakcji. Dodatkowo rejestracja umożliwia firmom na podglądanie zamówień klientów w zakresie ich zainteresowań, co pozawala na

tworzenie określonych profili zakupów w postaci zbiorów danych konkretnych produktów

realizowanych w ramach zaopatrzenia i dystrybucji. Wykorzystywanie tego rodzaju technik

pozwala na odpowiednie dopasowanie ofert zakupu do indywidualnych potrzeb i oczekiwań

klienta. Na prezentowanym rysunku (Rys. 1) sklepu internetowego uwzględniono i wprowadzono pojęcie tzw. informacji jawnych oraz informacji nie jawnych, gdyż w rzeczywistych relacjach pomiędzy konkretnym nabywcą a sklepem internetowym zostają zachowane

pewne bariery pozwalające z jednej strony zachować dbałość oraz formę sprzedaży a z drugiej bezpieczeństwo danych osobowych klientów i zasoby on-line [12].

4. Proponowane rozwiązanie

Badania ukierunkowano na opracowanie procedury generowania wskazań strategicznych, a w konsekwencji wyboru produktu przez klienta, w połączeniu z ich ilościową reprezentacją. W tym celu połączony został proces formalnych mechanizmów agregacji, opartych na metodzie wielokryterialnego wspomagania decyzji.

Zastosowana metoda hierarchicznej analizy problemu (ang. AHP – Analytic Hierarchy

Process), wspomaga podejmowanie decyzji w obecności wielu kryteriów dla wybranych

problemów decyzyjnych [15]. Metoda AHP ukazuje podejście wielokryterialne, oparte na

strategii modelowania preferencji i przy założeniu porównywalności wariantów, uwzględniając specyfikę psychologicznych procesów wartościowania o charakterze hierarchicznym

i relacyjnym. Jednocześnie metoda wspiera artykułowanie preferencji decydenta (lub oceniających) oraz wykorzystanie ich w procesie agregacji ocen [16]. Preferencje oceniających

(decydujące o subiektywności ocen) stanowią istotę podejścia wielokryterialnego i są zjawiskiem naturalnym dla ocen dokonywanych przez człowieka, w odróżnieniu od pomiarów

o charakterze obiektywnym [17]. Wyniki otrzymane za pomocą tej metody są wartościami

liczbowymi, określającymi hierarchię możliwych wariantów wg zbiorczej (wielokryterialnej) jakościowej oceny.

Występujące w modelu czynniki ryzyka, stanowią kryteria oceny wariantów środowiska

sklepu internetowego. Wariantami decyzyjnymi są projektowe lub realizacyjne rozwiązania,

który w efekcie zapewnia odpowiednie zastosowanie strategii przedsiębiorstwa.

W ramach metody AHP dokonano dekompozycji problemu decyzyjnego, w postaci hierarchicznej struktury decyzyjnej (Rys. 2): cel nadrzędny (otoczenie środowiska), cele pośrednie (główne czynniki składające się na wybór danego rodzaju filmu), czynniki cząstkowe (wybrane kryteria) i warianty decyzyjne (rozwiązanie projektowe lub realizacyjne).

Proponowaną procedurę przedstawiono na przykładzie sklepu internetowego. W tym celu zastosowano metodę AHP, na podstawie przeprowadzonej serii eksperymentów badawczych, ujawniono celowość prezentowanej multimetody.

Analiza wielokryterialna w zarządzaniu strategicznym e-biznesu

27

Rysunek 2. Schemat struktury hierarchicznej zadania w metodzie Saaty’ego

Źródło: opracowanie własne

5. Weryfikacja empiryczna proponowanego rozwiązania

W praktyce sklasyfikowano wszystkie czynniki mające wpływ na bieżącą i przyszłą pozycję sprzedaży danych produktów w sklepie internetowym. Istnieją dwa kryteria, które zostały sklasyfikowane: zewnętrzne w stosunku do e-sklepu, które posiadają również charakter uwarunkowań wewnętrznych oraz wywierający wpływ negatywny lub pozytywny na

zakupy w Internecie przez użytkowników.

Tabela 1. Analiza oceny kupujących poprzez wybrane kryteria

Lp. WYBRANE KRYTERIA

1.

2.

3.

4.

WIEK

ZAWÓD

PŁEĆ

MIEJSCE ZAMIESZKANIA

SUMA

RANKING = WAGA x ilość przyznanych punktów (1-9)

Thriller

Akcja

Komedia

Animacja

Punkty

Punkty

Punkty

Punkty

5

3,4

3

2,04 5

3,4

5

4,08

1

0,23 4

0,92 8

1,84 3

0,69

5

2,8

4

2,24 4

2,24 6

3,36

6

3,36 1

0,56 6

3,36 5

2,8

9,79

5,75

10,84

10,93

Źródło: opracowanie własne

Kolejno zdefiniowano strukturę hierarchii, odzwierciedlającej problem. Do oceny analizy zakupów przez Internet wystarcza przyjęcie hierarchicznego modelu o podstawowej

strukturze, składającej się z najwyżej czterech poziomów czyli celu nadrzędnego, celu

głównego, czynników cząstkowych oraz wariantów decyzyjnych.

W modelu hierarchicznym otoczenie środowiska internetowego jest skutkiem zgodnym

z określonymi celami cząstkowymi, jakie zostały opisane przez zdefiniowane atrybuty oraz

związane z nimi kryteria oceny. System kryteriów oceny całego otoczenia środowiska,

w którym zostało przedstawione podejście analityczne poprzez wybór odpowiednich czynników ma zatem strukturę hierarchiczną.

Dla celów kolejnych analiz wyznaczono ważność wybranych alternatywnych wariantów

strategii sklepu internetowego. Wyznaczony wektor priorytetów znormalizowano, i pozwoliło na opracowanie ilościowej reprezentacji oraz rankingu klientów. Wyniki badań na Wykresie 1 i 2.

28

Luiza Fabisiak

Wykres 1. Ogólne pierwszeństwo alternatywnych strategii – priorytety

Źródło: opracowanie własne

Wykres 2. Ogólne pierwszeństwo alternatywnych strategii – Ocena użyteczności wariantów

Źródło: opracowanie własne

Przez agregacja ocen w ramach rekomendacji użytkowników sklepów internetowych w

danym otoczeniu środowiskowym stanowi podstawę do uogólnienia wyników w postaci

tabeli danych zagregowanych, która jest postawą utworzenia zredukowanej struktury wykresu, poddającej oceny końcowe wyznaczone dla kryteriów głównych, czynników i wariantów.

Interpretując wyniki powyższych analiz można stwierdzić, że w większości przypadków

sklepy internetowe kontaktuje się ze środowiskiem neutralnym. Może to prowadzić do

wniosków, że aby osiągnąć wszystkie założone cele, będzie potrzebny odpowiedni nakład

pracy i środków. Z przeprowadzonej analizy wynika, że sklepy internetowe powinny zastosować odpowiednie strategie: koncentracji, rozwoju rynku, rozwoju produktu przeznaczony

do grupy docelowej klientów. Sklep internetowy może przyjąć jedną z tych strategii sugerując się statystyką zakupów lub zastosować wszystkie naraz docierając do wszystkich klientów. Stosowanie się do powyższych strategii pozwoli zdobyć lepszą sprzedawalność jak

również pozyskać nowych klientów. Jak wynika z danych, sklep jest zorganizowany w sposób zapewniający jej sprawne istnienie na rynku internetowym, a także jest odpowiednio

zabezpieczona przed konkurencją.

Analiza wielokryterialna w zarządzaniu strategicznym e-biznesu

29

Wykres 3. Ukazanie czynników wybranych kryteriów za pomocą pierwszeństwa wag

Źródło: opracowanie własne

6. Podsumowanie

Przedstawiona w niniejszej pracy procedura badawcza obejmuje analizę decyzyjną

w sklepie internetowym. Aparat wielokryterialnego wspomagania decyzji, stanowią część

projektowanych strategii innowacyjności. Zastosowana metoda AHP posłużyła do kwantyfikacji ilościowej poszczególnych składników strategii, co stanowi bardzo intuicyjny i wygodny aparat matematyczny. Warto jednocześnie zaznaczyć, że prezentowany zestaw metod

cechuje komplementarny charakter. Wykorzystana w pracy koncepcja definiowania preferencji pozwala na łatwe powiązanie wyników badań z określeniem wartości preferencji po-

30

Luiza Fabisiak

równywanych wariantów według przyjętych kryteriów. Uogólniając wyniki badań należy

wskazać, że prezentowane rozwiązanie może stanowić efektywne narzędzie analityczne

wykorzystywane w procesie zarządzania strategicznego.

Bibliografia

[1] Kołodko G. W. Nowa gospodarka, Redakcja naukowa, Warszawa 2001

[2] http://www.wswebstyle.com

[3] Niedźwiedziński M. Globalny handel elektroniczny. Wydawnictwo Naukowe PWN

2004

[4] Laudon K. C., Traver C. G. E-Commerce. Wydawnictwo Prentice Hall 2006

[5] Beier F., Rutkowski K. Logistyka. Warszawa Szkoła Główna Handlowa 1995

[6] Maguire J. Ten Tips for Getting Customers to Up the Order, December 15, 2004

[7] Chodak G. Symulator obrotów magazynowych w sklepie internetowym - propozycja

implementacji, Gospodarka Materiałowa i Logistyka 2004

[8] http://www.amazon.com

[9] Drygas P. Polski detaliczny handel internetowy, Marketing i Rynek, nr 2/2005,

[10] Gregor B., Stawiszyński M. E-commerce. Oficyna Branta, Bydgoszcz, Łódź 2002

[11] Rosenfeld L., Mougille P. Architektura informacji w serwisach internetowych, Wydawnictwo Helion, Gliwice 2003

[12] Teluk T. E-biznes Nowa gospodarka, Wydawnictwo Helion, Gliwice 2002

[13] Wojciechowski M. Odkrywanie wzorców zachowań użytkowników WWW. Materiały

konf. POLMAN'99, OWN, Poznań 1999

[14] Linder G., Smith G. Amazon.com recommendations. Item-to-item Collaborative Filtering, IEEE Internet Computing 2003

[15] Saaty T. L., The Analytic Hierarchy Process, New York MacGraw Hill. 1980.

[16] Saaty T. L., Vargas L. G. The Analytic Hierarchy Process Series, University of Pittsburg 1990.

[17] Saaty T. A scaling method for priorities in hierarchical structures, J of Mathematical

Psychology, 15, 1977.

[18] Tyszka T. Analiza decyzyjna i psychologia decyzji, PWN, Warszawa 1986.

Automatyczne sprawdzanie i weryfikacja statusu

algorytmów kryptograficznych wykorzystywanych

w infrastrukturze klucza publicznego

Tomasz Hyla

Zachodniopomorski Uniwersytet Technologiczny w Szczecinie,

Wydział Informatyki

Abstract:

Currently a lot of services is using a PKI infrastructure for digital signatures, documents’

time stamping, websites identity verification and many others. It is important to use proper,

recognized cryptographic algorithms. Recommended Cryptographic Algorithm Status List

provides information about recognized algorithms by information providers grouped by countries. The list can be used as a secondary trust source during verification of a digitally signed

document. The Cryptographic Algorithm Status Operator manages the list and gathers information from information sources. The operator can be queried for recognized algorithms and

can be used to verify the validity of an algorithm in certain period of time.

Keywords:

cryptographic algorithms, PKI, long-term storage, trust, digital signature

1. Wprowadzenie

Obecnie wykorzystywanych jest wiele usług wykorzystujących infrastrukturę klucza

publicznego (PKI), począwszy od podpisu elektronicznego do znakowania czasem dokumentów. Użytkownicy wszystkich usług wykorzystujących PKI muszą ufać głównym, zaufanym urzędom certyfikacji wystawiającym certyfikaty kwalifikowane. Głównym źródłem

zaufania jest sprawdzenie ścieżki certyfikacji. Dodatkowym źródłem zaufania może być

także określona w standardzie ETSI lista statusu zaufanych usług. Ważnym problemem

związanym z wszystkimi usługami PKI jest stosowanie odpowiednio silnych algorytmów

kryptograficznych uniemożliwiających ich złamanie w czasie ważności konkretnych usług.

W artykule została przedstawiona propozycja Centrum Informacji o Algorytmach Kryptograficznych (CIoAK), które zawiera Listę Polecanych Algorytmów Kryptograficznych

(LPAK). Lista LPAK umożliwia użytkownikom automatyczne sprawdzanie aktualnie polecanych algorytmów lub weryfikacje tego czy były polecane w określonym czasie. Obecnie

informacje na temat polecanych lub wymaganych algorytmów i ich parametrów jest rozproszona po różnych dokumentach. Zawierają ją standardy międzynarodowe oraz różne akty

prawne w różnych państwach.

Rozdział 2 porusza problem zaufania w infrastrukturze klucza publicznego. Rozdz. 2.1

zawiera informacje o infrastrukturze oraz o usługach PKI. Następnie został przedstawiony

problem ważności algorytmów kryptograficznych w ujęciu norm międzynarodowych i legislacji narodowych (rozdz. 2.2) oraz lista statusu zaufanych usług (rozdz. 2.3), mogąca stanowić drugorzędne źródło zaufania. Rozdział 3 prezentuje proponowane rozwiązanie na

Metody Informatyki Stosowanej, nr 2/2009 (19), s. 31-40

Polska Akademia Nauk Oddział w Gdańsku, Komisja Informatyki

ISSN 1898-5297

http://pan.wi.zut.edu.pl

32

Tomasz Hyla

które składa się CIoAK (rozdz. 3.2) oraz LPAK (rozdz. 3.3), która stanowi uzupełnienie

listy statusów zaufanych usług. W rozdz. 3.4 przedstawiony został sposób dostarczania danych do CIoAK oraz protokół do komunikacji z użytkownikami. Rozdział 4 zawiera podsumowanie i dyskusje.

2. Zaufanie w PKI

2.1. Usługi infrastruktury klucza publicznego

Podpis cyfrowy to informacja dołączona do danych, umożliwiająca weryfikację ich autentyczności i integralności. Jedną z technik tworzenia podpisu cyfrowego jest szyfrowanie

kluczem prywatnym skrótu z podpisywanego dokumentu. Każdy podpis cyfrowy składany

przez tego samego użytkownika jest inny (wyjątek stanowi podpisywanie tego samego dokumentu z wykorzystaniem paddingu nierandomizowanego). Natomiast podpis własnoręczny powinien być zawsze taki sam. Podpis cyfrowy jest wielokrotnie trudniejszy do podrobienia [1] od podpisu własnoręcznego. Aby stwierdzić, że dany klucz publiczny jest przypisany do konkretnej osoby konieczna jest Infrastruktura Klucza Publicznego (ang. PKI –

Public Key Infrastructure). Infrastruktura PKI, czyli oprogramowanie, sprzęt, polityki, protokoły i prawo potrzebne aby Alicja mogła zweryfikować podpis cyfrowy Boba [1, 2], jest

wykorzystywana obecnie powszechnie w Internecie (np. do bezpiecznych połączeń ze stronami internetowymi banków). W wielu państwach podpis cyfrowy złożony z użyciem PKI

jest uznawany za równoważny podpisowi własnoręcznemu.

Zaufanie do ważności certyfikatów cyfrowych, potwierdzających przynależność klucza

publicznego do osoby fizycznej, wynika z zaufania do urzędu certyfikacji (ang. CA – Certification Authority) wydającego dany certyfikat. Proces sprawdzania ważności podpisu cyfrowego polega na sprawdzeniu skrótu dokumentu ze skrótem odszyfrowanym z użyciem

klucza publicznego zawartego w certyfikacie. Następnym krokiem jest sprawdzenie łańcucha certyfikatów (tworzących tzw. ścieżkę certyfikacji), aż do certyfikatu głównego, zaufanego urzędu certyfikacji oraz sprawdzenie listy certyfikatów unieważnionych (ang. CRL –

Certificate Revocation List). W infrastrukturze PKI pierwszorzędne źródło zaufania do

ważności podpisu cyfrowego stanowi właśnie sprawdzenie ścieżki certyfikacji.

Dzięki wykorzystaniu infrastruktury PKI istnieje możliwość stwierdzenia integralności,

autentyczności, poufności oraz niezaprzeczalności pochodzenia dokumentów cyfrowych.

Ważność certyfikatów trwa zwykle dwa lata. W przypadku gdy dokument musi być przechowywany przez dłuższy okres czasu konieczny jest jeden z sposobów przedłużenia okresu

ważności podpisu cyfrowego, np. z użyciem znacznika czasu. Przykładowo, dokumenty

medyczne wchodzące w skład elektronicznego rekordu zdrowotnego (ang. EHR – Electronic Health Record) muszą być przechowywane przez całe życie pacjenta, co wielokrotnie

przekracza ważność certyfikatów. Istnieje kilka metod opisanych w [3-5] pozwalających na

przedłużenie ważności dokumentów medycznych.

2.2. Ważność algorytmów kryptograficznych

Wszystkie usługi wykorzystujące infrastrukturę klucza publicznego wykorzystują algorytmy kryptograficzne. Z uwagi na szybki przyrost mocy obliczeniowej komputerów oraz

postęp w dziedzinie kryptografii, projektanci systemów PKI muszą określić czy dany algorytm uważany jest za bezpieczny i czy spełnia wymogi prawne, aby podpis cyfrowy był

równoważny odręcznemu. W różnych państwach mogą być polecane/wymagane różne algorytmy o różnych parametrach. Na przykład w Polsce załącznik nr 3 Rozporządzenia Rady

Automatyczne sprawdzanie i weryfikacja statusu algorytmów kryptograficznych…

33

Ministrów [6] do ustawy o podpisie elektronicznym [7] zawiera informacje na temat minimalnych wymagań dotyczących algorytmów szyfrowych służących do składania podpisu

elektronicznego. Natomiast specyfikacja techniczna ETSI TS 102 176-1 [8] zawiera dokładne zalecenia na temat stosowania algorytmów w infrastrukturze klucza publicznego.

W normie ETSI TS 102 176-1 zdefiniowano listę polecanych algorytmów funkcji skrótu

oraz listę algorytmów używanych do podpisu elektronicznego, a także ich kombinacji nazwanych zestawem do podpisu (ang. signature suite). Głównymi parametrami powodującymi włączenie danego algorytmu do tej specyfikacji technicznej są:

uznanie algorytmu za bezpieczny,

popularność stosowania algorytmu,

łatwa możliwość referencji do jego specyfikacji.

W przypadku, gdy algorytm nie jest umieszczony na liście nie oznacza, że nie można go

używać, a oznacza że algorytm nie spełnił wyżej wymienionych wymagań. Można założyć

rozsądny poziom bezpieczeństwa jeżeli polecane algorytmy zostaną użyte z wykorzystaniem polecanych parametrów w kontekście ich rekomendacji. Lista tych algorytmów jest

aktualizowana co pewien okres czasu aby uwzględnić zmiany w dziedzinie kryptografii.

2.3. Lista statusu zaufanych usług

Standard ETSI TS 102 231 [9] zawiera informacje o sposobie tworzenia list statusu zaufanych usług (ang. TSL - Trusted-service Status List) udostępniających informacje na temat statusu zaufanych usług, aby zainteresowane strony mogły ustalić czy usługa zaufania

(ang. trust service) działała lub działa według uznanych zasad (ang. recognized scheme) lub

czy działała według uznanych zasad w czasie w którym transakcja zależna od tej usługi

miała miejsce. Celem TSL jest określenie zharmonizowanego sposobu publikacji informacji

na temat statusu usług zaufanych i ich dostawców. Listy TSL są zarządzane przez operatorów, którzy postępują według określonych zasad oceny.

W ETSI TS 102 231 zdefiniowano tylko typ, rodzaj i znaczenie informacji które mogą

być prezentowane za pomocą TSL, natomiast nie definiuje w jaki sposób informacje mają

być zbierane przez operatorów. Standard nie określa jakich zasad oceny operator powinien

użyć w celu ustalenia statusu usługi zaufanej, którą nadzoruje. Nie definiuje także jak status

lub informacje powiązane z zasadami powinny być prezentowane poza kontekstem TSL, np.

na stronie zasad. Operator TSL musi być w stanie dostarczać informacje na temat jej zawartości w formie do odczytu przez użytkownika, która jest łatwa do pozyskania i umożliwia

drukowanie, oraz w formie do przetwarzania maszynowego umożliwiającej automatyczną

weryfikację statusu.

Informacje zawarte w TSL powinny stanowić drugorzędne źródło zaufania; podstawowe

źródło zaufania powinno wynikać ze sprawdzenia ścieżki certyfikacji. Lista TSL jest podpisana cyfrowo w celu umożliwienia sprawdzenia autentyczności i oprócz aktualnego statusu

usług zaufanych musi zawierać także informacje o historii ich statusu. TSL składa się z 4

głównych komponentów:

1. Zawierającego informacje na temat zasad wydawania (ang. issuing scheme).

2. Identyfikującego TSP (ang. Trusted-service Provider) uznawanego przez zasady.

3. Identyfikującego usługi dostarczane przez TSP i ich aktualny status.

4. Zawierającego historię statusu usług.

34

Tomasz Hyla

3. Informacja o statusie algorytmu kryptograficznego

3.1. Problem dostępności informacji o polecanych algorytmach kryptograficznych

Obecnie w większości systemów infrastruktury klucza publicznego rodzaj wykorzystywanych algorytmów jest ustalany podczas projektowania systemu lub podczas działania

systemu przez eksperta uprawnionego do wprowadzania zmian w wykorzystaniu algorytmów. Informacje na temat polecanych lub wymaganych algorytmów i ich parametrów zawierają standardy międzynarodowe (np. przedstawiony w rozdz. 2.2 standard ETSI) oraz

różne akty prawne w różnych państwach (np. w Polsce Rozporządzenie do ustawy o podpisie elektronicznym [6]). Przykładowo, polityka stosowania kryptografii w ochronie zdrowia

w Wielkiej Brytanii została opisana przez A. Donaldsona [10]. Podpis elektroniczny jest

zwykle równoważny prawnie podpisowi odręcznemu, jeżeli w danym państwie istnieją odpowiednie akty prawne i spełnione są zawarte w nich wymagania odnośnie algorytmów.

Wiedza na temat stosowania konkretnych algorytmów jest rozproszona po różnych dokumentach. W przypadku tworzenia systemu np. dla Turkmenistanu, należałoby przeszukać

tamtejsze ustawodawstwo co może być kosztowne i problematyczne. Dodatkowym problemem w przypadku systemów archiwizujących dokumenty podpisane elektronicznie jest

konieczność, w zależności od przyjętego rozwiązania, ponownego (co pewien okres) podpisania czy znakowania czasem. W długim okresie czasu musi co pewien czas następować

zmiana algorytmów lub ich parametrów. Na przykład wg specyfikacji Evidence Record

Syntax [11] konieczność zmiany algorytmu funkcji skrótu wymaga mechanizmów innych

niż te, które są wbudowane w protokół wymiany informacji. W przypadku weryfikowania

archiwalnych dokumentów podpisanych cyfrowo wiedza na temat polecanych algorytmów

w przeszłości może stanowić dodatkowe źródło zaufania.

W dalszej części niniejszego rozdziału została przedstawiona propozycja Centrum Informacji o Algorytmach Kryptograficznych (CIoAK), które zawiera Listę Polecanych Algorytmów Kryptograficznych (LPAK) (będącą odpowiednikiem TLS) oraz umożliwia użytkownikom automatyczne sprawdzanie aktualnie polecanych algorytmów lub weryfikacje