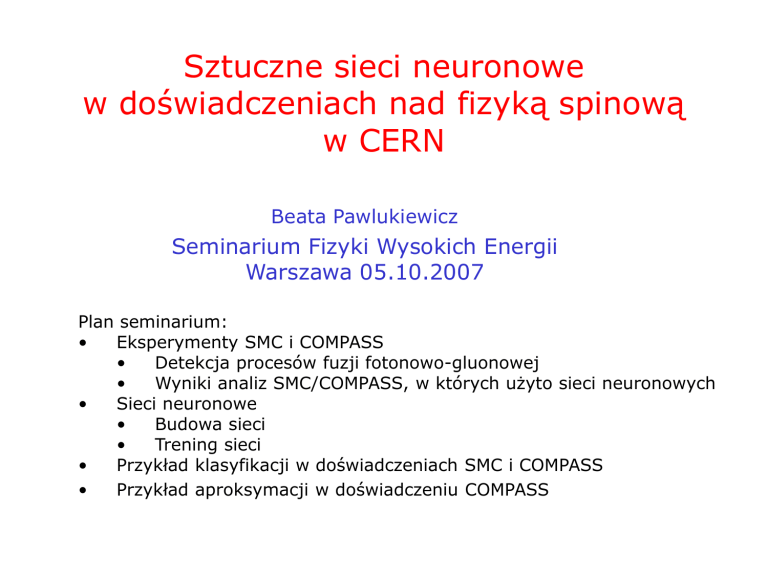

Sztuczne sieci neuronowe

w doświadczeniach nad fizyką spinową

w CERN

Beata Pawlukiewicz

Seminarium Fizyki Wysokich Energii

Warszawa 05.10.2007

Plan seminarium:

•

Eksperymenty SMC i COMPASS

•

Detekcja procesów fuzji fotonowo-gluonowej

•

Wyniki analiz SMC/COMPASS, w których użyto sieci neuronowych

•

Sieci neuronowe

•

Budowa sieci

•

Trening sieci

•

Przykład klasyfikacji w doświadczeniach SMC i COMPASS

•

Przykład aproksymacji w doświadczeniu COMPASS

slajdy z prezentacji G. Brony, 08.06.07

05.10.2007

B. Pawlukiewicz

2

z Monte-Carlo

05.10.2007

B. Pawlukiewicz

3

G/G w kanale mezonów powabnych

z Monte-Carlo

slajdy z prezentacji G. Brony, 08.06.07

05.10.2007

B. Pawlukiewicz

4

Wyniki otrzymane przy użyciu

sieci neuronowych

SMC, high pT (Q2>1 GeV2), 1993-1996

G

0.200.28( stat.)0.10( syst .)

G

Phys.Rev.D70:012002,2004

COMPASS w kanale mezonów powabnych, 2000-2004

praca doktorska G. Brona

05.10.2007

B. Pawlukiewicz

5

Sieci neuronowe – co to jest?

05.10.2007

B. Pawlukiewicz

6

Sztuczne sieci neuronowe

• Uproszczony model mózgu - zespół powiązanych

ze sobą komórek równolegle przetwarzających informacje

w1

w2

S

w3

http://www.mindcreators.com/NeuronBasics.htm

NEURON

• Neuron:

• oblicza sumę ważoną sygnałów wejściowych

• zwraca odpowiedź w postaci pojedynczego sygnału

• przesyła odpowiedź do kolejnych elementów

• Neurony tworzą warstwy

05.10.2007

B. Pawlukiewicz

7

Pojedynczy neuron liniowy

nieliniowy

wektor wag

liczby

funkcja aktywacji

E

Q2

y

x1

x2

xn

1

w1

w0

w2

S

f(S)

y

wn

wektor wejściowy

odpowiedź neuronu

pobudzenie neuronu

w x

i

y f (wi xi )

i

i

i

05.10.2007

B. Pawlukiewicz

8

Nieliniowe funkcje aktywacji

• dyskretne (signum, skok jednostkowy...)

• ciągłe: każda funkcja ograniczona, monotoniczna, niewielomianowa

– sigmoidalna (prosta postać pochodnej!)

S 1

f (S)(1e )

f(S)

S

05.10.2007

B. Pawlukiewicz

9

Neuron dyskretny

x1

x2

xn

w0

w1

w2

S

y

wn

f(S)

• pobudzenie neuronu

w x

i

i

i

• odpowiedź sieci y =

1 S0

0 S0

• (n-1)-wymiarowa hiperpłaszczyzna

dzieli przestrzeń na dwie podprzestrzenie

05.10.2007

S

B. Pawlukiewicz

n

w x

i 0

i

i

0

10

Znaczenie dodatkowej wagi

neuron dyskretny

x1

w1

w2

x2

S

y

2

W0

1

c=0

S0

0

x11 w

x22w2

0w

0x

w

1x

w

1

2

05.10.2007

. x

.. . . .

.

.

.

x

.

.

. . ..

. . .

c=1.5

B. Pawlukiewicz

11

1

Wielowarstwowa sieć neuronów nieliniowych

MLP (multi-layer perceptron)

1

x1

1

w10

w11

S

f(S)

wji

w1n

S

S

S

f(S)

f(S)

S

S

xn

1

y

f(S)

f(S)

f(S)

warstwa wyjściowa

warstwa wejściowa

05.10.2007

warstwy ukryte

B. Pawlukiewicz

12

http://nc25.troja.mff.cuni.cz/~soustruznik/talks.html

Dowolny podział przestrzeni przy użyciu

neuronów dyskretnych

05.10.2007

B. Pawlukiewicz

13

Trening sieci neuronowej

• z nauczycielem – znamy pożądaną odpowiedź sieci dla

danych wejściowych (np. z symulacji Monte Carlo)

• cel uczenia: otrzymanie prawidłowych odpowiedzi dla

zbioru, który nie był wykorzystywany w procesie

uczenia (GENERALIZACJA)

• metoda: minimalizacja różnicy pomiędzy

oczekiwanymi a otrzymanymi odpowiedziami sieci

za pomocą iteracyjnego procesu adaptacji wag

05.10.2007

B. Pawlukiewicz

14

Trening sieci z nauczycielem.

Pierwsze kroki.

• przygotowanie danych wejściowych

• ustalona architektura sieci

• losowanie początkowych wag w

05.10.2007

B. Pawlukiewicz

15

Przygotowanie danych wejściowych

f’(S)

• podział wektorów wejściowych i pożądanych odpowiedzi

na podzbiory: uczący i testowy

• przygotowanie danych:

–przeskalowanie do takiego zakresu, żeby wypadkowe pobudzenie

neuronu pokrywało się z zakresem, w którym pochodna funkcji

aktywacji jest istotnie różna od zera

–eliminacja zbędnych zmiennych

–wygładzenie rozkładów szybkozmiennych

S

05.10.2007

B. Pawlukiewicz

16

Trening sieci z nauczycielem

algorytm

rozbudowy

x k , z k (x k )

miara błędu sieci:

Q ( w )

y k (x k ,w)

(

1

k (x k )

k k

)

Q spełnia

„STOP”?

nie

k z k (x k ) – y k (x k ,w)

05.10.2007

2

poprawa

architektury

tak

nie

KONIEC

poprawa wag

B. Pawlukiewicz

17

tak

Warunek zatrzymania uczenia

wagi stają się stabilne

błąd sieci dla zbioru uczącego przestaje maleć

błąd sieci dla zbioru testowego zaczyna rosnąć

w dobrych warunkach statystycznych => oba

błędy przestają maleć

błąd sieci

•

•

•

•

zbiór testowy

zbiór uczący

en.wikipedia.org

05.10.2007

liczba iteracji

B. Pawlukiewicz

18

Minimalizacja funkcji błędu

• szukamy takiego wektora w, dla którego Q(w)

osiąga globalne minimum

• używamy metod gradientowych

• zmiana j-tej wagi w kroku (i+1) proporcjonalna do

składowej gradientu:

wj

(i 1)

w j

(i)

Q

w j

w j j

(i)

błąd j-tego neuronu z warstwy wyjściowej:

(Σ )( z ( xk ) y( xk ))

j f akt

a błąd neuronu z warstwy ukrytej?

05.10.2007

B. Pawlukiewicz

19

Algorytm wstecznej propagacji błędu

idea: błąd propaguje się od warstwy ostatniej do pierwszej

wystarczy wiedza o gradiencie dla warstwy późniejszej

błąd m-tego neuronu warstwy ukrytej:

1

x1

1

1

(

(Σ ) j w jm

n f akt

)

m

f(S)

f(S)

f(S)

f(S)

y

suma po wszystkich wyjściach

neuronu ukrytego

f(S)

xn

f(S)

05.10.2007

B. Pawlukiewicz

20

Przykładowa powierzchnia błędu

prezentacja R. Suleja, seminarium IPJ, 2005

05.10.2007

B. Pawlukiewicz

21

Szukanie minimum globalnego funkcji błędu

– rożne algorytmy gradientowe

prezentacja R. Suleja, seminarium IPJ, 2005

05.10.2007

B. Pawlukiewicz

22

Wady i zalety sieci neuronowej

Zalety:

• pozwala rozwiązywać problemy bez znajomości analitycznej zależności

między danymi wejściowymi a oczekiwanymi wyjściami

• skuteczna w rozwiązywaniu problemów nieseparowalnych

• zdolność generalizacji

• różnorodność zastosowań:

– rozpoznawanie pisma, mowy, analizy finansowe rynku...

Wady:

• brak dowodów zbiegania do globalnego minimum metodami

gradientowymi

• kłopotliwe dla niedoświadczonego użytkownika, jeśli sam ustala

algorytm, parametry algorytmu oraz architekturę sieci

• niebezpieczeństwo przetrenowania lub niedouczenia sieci

05.10.2007

B. Pawlukiewicz

23

Sieci użyte w analizie problemów fizycznych

sieci

ze względu na

funkcję aktywacji

liniowe

nieliniowe

ciągłe

dyskretne

ze względu na

architekturę

sieci nieliniowe

jednokierunkowe

rekurencyjne

http://www.ire.pw.edu.pl/~rsulej/NetMaker/

wielowarstwowe

jednowarstwowe

uczenie

ze względu na

rodzaj uczenia

05.10.2007

z nauczycielem

bez nauczyciela

z krytykiem

B. Pawlukiewicz

24

Zadanie klasyfikacji

typowe zadanie klasyfikacji:

odseparowanie sygnału od tła

zadanie realizuje sieć:

• dwie warstwy ukryte + wyjściowa

• sigmoidalna fakt neuronu wyjściowego

jakość nauki określają dwa współczynniki:

trafność (purity r) i sprawność (efficiency h)

r ( )

N1 (sygna ł zident. jako sygna ł )

N1 N 2 (tlo zident. jako sygna ł )

05.10.2007

h ( )

B. Pawlukiewicz

N1 (sygna ł zident. jako sygna ł )

N 3 (sygna ł )

25

Selekcja przypadków PGF

para hadronów z dużym pT, dane SMC

krzywa ciągła – sygnał

krzywe przerywane - tło

praca doktorska K. Kowalik, IPJ

05.10.2007

B. Pawlukiewicz

26

Selekcja przypadków PGF

para hadronów z dużym pT, dane SMC

Phys.Rev.D70:012002,2004

05.10.2007

B. Pawlukiewicz

27

Selekcja przypadków PGF

para hadronów z dużym pT, dane COMPASS-owe

Meas. Sci. Technol., Vol. 18 (2007)

05.10.2007

B. Pawlukiewicz

28

Zadanie aproksymacji

aproksymacja nieznanej zależności między

zmiennymi wejściowymi a pożądanymi odpowiedziami

zadanie realizuje sieć:

• dwie warstwy ukryte + wyjściowa

• liniowa fakt neuronu wyjściowego

jakość aproksymacji określa współczynnik korelacji:

R

05.10.2007

1

k z y

(z

k

)(

z y k y

)

k

B. Pawlukiewicz

29

Zadanie aproksymacji all

kanał mezonów powabnych, COMPASS

RNN = 0.82

DIS 2006, COMPASS, G. Mallot

05.10.2007

B. Pawlukiewicz

30

Podsumowanie

•

sieci zostały użyte do zadań detekcji sygnału

i estymacji nieznanej funkcji

•

użyto sieci typu MLP trenowanych z nauczycielem

•

w obu zastosowaniach wyniki sieci okazały się nieznacznie

lepsze od wyników otrzymanych metodami tradycyjnymi

•

analiza danych COMPASS-a z użyciem sieci

(m.in. separacja PGF w kanale D0 od tła) w toku.

05.10.2007

B. Pawlukiewicz

31

Serdecznie dziękuję

R. Sulejowi i prof. B. Badełek za pomoc

w przygotowaniu tego seminarium

05.10.2007

B. Pawlukiewicz

32