Inteligentne Systemy

Autonomiczne

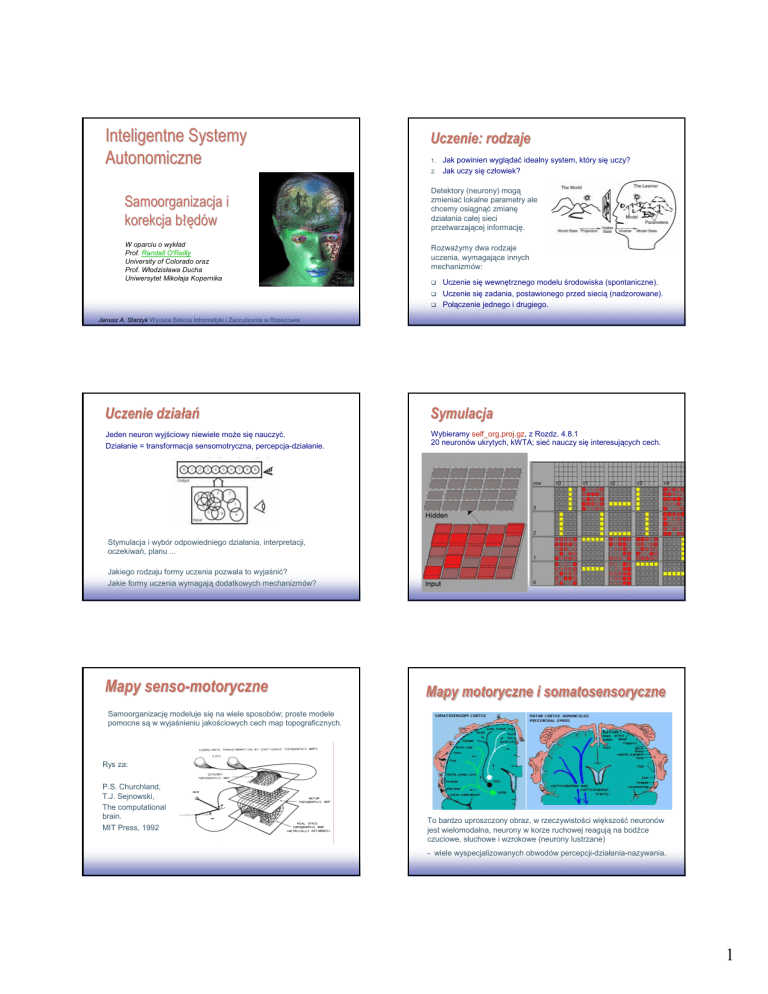

Uczenie: rodzaje

1.

2.

Detektory (neurony) mogą

zmieniać lokalne parametry ale

chcemy osiągnąć zmianę

działania całej sieci

przetwarzającej informację.

Samoorganizacja i

korekcja błędów

W oparciu o wykład

Prof. Randall O'Reilly

University of Colorado oraz

Prof. Włodzisława Ducha

Uniwersytet Mikołaja Kopernika

Rozważymy dwa rodzaje

uczenia, wymagające innych

mechanizmów:

1

EE141

Janusz

Jak powinien wyglądać idealny system, który się uczy?

Jak uczy się człowiek?

Uczenie się wewnętrznego modelu środowiska (spontaniczne).

Uczenie się zadania, postawionego przed siecią (nadzorowane).

Połączenie jednego i drugiego.

2

EE141

A. Starzyk Wyższa Szkoła Informatyki i Zarządzania w Rzeszowie

Uczenie dział

działań

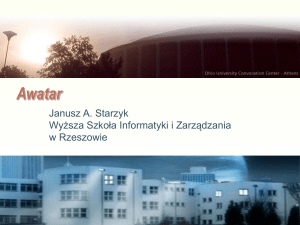

Symulacja

Jeden neuron wyjściowy niewiele może się nauczyć.

Działanie = transformacja sensomotryczna, percepcja-działanie.

Wybieramy self_org.proj.gz, z Rozdz. 4.8.1

20 neuronów ukrytych, kWTA; sieć nauczy się interesujących cech.

Stymulacja i wybór odpowiedniego działania, interpretacji,

oczekiwań, planu ...

Jakiego rodzaju formy uczenia pozwala to wyjaśnić?

Jakie formy uczenia wymagają dodatkowych mechanizmów?

3

EE141

4

EE141

Mapy senso-motoryczne

Mapy motoryczne i somatosensoryczne

Samoorganizację modeluje się na wiele sposobów; proste modele

pomocne są w wyjaśnieniu jakościowych cech map topograficznych.

Rys za:

P.S. Churchland,

T.J. Sejnowski,

The computational

brain.

MIT Press, 1992

To bardzo uproszczony obraz, w rzeczywistości większość neuronów

jest wielomodalna, neurony w korze ruchowej reagują na bodźce

czuciowe, słuchowe i wzrokowe (neurony lustrzane)

- wiele wyspecjalizowanych obwodów percepcji-działania-nazywania.

5

EE141

6

EE141

1

Reprezentacja palc

ów: plastyczno

ść

palców:

plastyczność

Najprostsze modele

SOM lub SOFM (Self-Organized Feature Mapping) – self-organizing

feature map, jeden z najbardziej popularnych modeli.

Jak mapy topograficzne mogą się utworzyć w mózgu?

Lokalne połączenia neuronów tworzą grupy silnie

ze sobą oddziaływujących, słabiej na większe

odległości i hamujących pobliskie grupy.

Ręka

Przed

stymulacją

Twarz

Po

stymulacji

Historia:

Pola czuciowe w korze rozszerzaja sie po

stymulacji

– lokalne dominacje wynikajace z pobudzenia

Plastycznosc obszarow kory do reprezentacji

sensoryczno-motorycznych

7

EE141

von der Malsburg i Willshaw (1976), uczenie konkurencyjne,

Hebbowskie z potencjałem „Mexican hat”, głównie układ wzrokowy.

Amari (1980) – modele warstwowe tkanki neuronowej.

Kohonen (1981) – uproszczenie bez hamowania; tylko dwa

niezbędne czynniki: konkurencja i kooperacja.

8

EE141

SOM

SOM:: idea

SOM algorytm: konkurencja

Węzły powinny oceniać podobieństwo danych wejściowych do ich

parametrów.

Wektor wejściowy X jest porównywany z parametrami węzła W.

Podobieństwo = minimalna odległość lub min. iloczyn skalarny.

Konkurencja: znajdź węzeł j=c którego W jest najbardziej zbliżone do X.

X − W( j ) =

∑( X

i

− Wi ( j )

)

2

i

c = arg min X − W ( j )

j

Dane: wektory XT = (X1, ... Xd) z d-wymiarowej przestrzeni.

Siatka węzłów z lokalnymi procesorami (neuronami) w każdym węźle.

Węzeł numer c jest najbardziej podobny do wektora wejściowego X

Jest on zwycięzca i tylko on uczy się podobieństwa do X, dlatego jest to

konkurencyjna procedura uczenia.

Lokalny procesor # j ma d parameterów adaptacyjnych W(j).

Cel: dostosuj parametry W(j) tak by modelować klastry w p-ni X.

9

EE141

Mozg: neurony które są pobudzone przez sygnał aktywizują się i uczą.

10

EE141

SOM algorytm: kooperacja

Mapy i zniekształcenia

Kooperacja: węzły na siatce bliskie do węzła zwycięzcy c powinny

zachować się podobnie. Zdefiniujmy funkcje sąsiedztwa O(c):

(

2

h( r, rc , t ) = h0 (t )exp − r − rc / σ c 2 (t )

)

t – numer iteracji (lub czas),

rc – lokalizacja zwycięskiego węzła c (w przestrzeni fizycznej zwykle 2D).

||r-rc|| – odległość od zwycięskiego węzła przeskalowana przez σc(t).

h0(t) – powoli zanikający mnożnik.

Funkcja sąsiedztwa określa jak silnie parametry zwycięskiego węzła i

węzły sąsiedztwa maja się zmieniać, by upodobnić się do danej

wejściowej X

11

EE141

Początkowe zniekształcenia mogą powoli zanikać (dobrze) albo mogą zastygnąć

12

(zle) … dając użytkownikowi zniekształcony obraz rzeczywistości.

EE141

2

SOM algorytm: dynamika

Demonstracje za pomocą GNG

Zasada adaptacji: wybierz zwycięzcę c, i jego sąsiedztwo O(rc),

zmień ich parametry czyniąc je bardziej podobnymi do danych X

Growing SelfSelf-Organizing Networks demo

http://www.neuroinformatik.ruhr-uni-bochum.de/ini/VDM/research/gsn/DemoGNG/GNG.html

For ∀i ∈ O ( c )

Parametery programu SOM:

W ( i ) ( t + 1) = W ( i ) ( t ) + h ( ri , rc ,t ) ⎣⎡ X ( t ) − W ( i ) ( t ) ⎦⎤

Wybierz w sposób przypadkowy nowy wektor danych X i powtórz.

Zmniejszaj powoli h0(t) az nie będzie zmian wag połączeń.

Rezultat:

W(i) ≈ centra lokalnych klasterów w przestrzeni cech wektora X

Węzły sąsiedztwa reprezentują sąsiednie rejony w przestrzeni

wejściowej

t – iteracje

ε(t) = εi (εf / εi )t/tmax

σ(t) = σi (σf / σi )t/tmax

określa krok uczenia

określa rozmiar sąsiedztwa

(

2

h(r , rc , t , ε ,σ ) = ε (t ) exp − r − rc / σ 2 (t )

Mapy 1x30 pokazują formację krzywych Peano.

Można spróbować odtworzyć mapy Penfielda.

13

EE141

14

EE141

Mapowanie kWTA CPCA

Trenowanie SOM

x=dane

o=pozycje w ag

neuronów

)

x

o

o

o

o x

o

o

o

o

x

o

xo

o

o

N -w ym iarow a

przestrzeń danych

Wada algorytmu GNG:

kora nie wytwarza nowych

neuronów u dorosłej osoby

w agi w skazują

na punkty w N -D

Uczenie

Hebbowskie tworzy

relacje pomiędzy

wejściem i

wyjściem.

Przykład:

pat_assoc.proj.gz

siatka neuronów

w 2-D

z Rozdziału 5,

opisany w 5.2

Fritzke algorithm Grownig Neural Gas (GNG)

Demonstracje uczenia konkurencyjnego GNG w Java:

http://www.neuroinformatik.ruhr-uni-bochum.de/ini/VDM/research/gsn/DemoGNG/GNG.html

Symulacje dla 3

zadań, od łatwego

do niemożliwego.

15

EE141

16

EE141

Uczenie zadań

zadań

Reguł

Reguła Delta

Niestety uczenie Hebbowskie nie wystarczy by nauczyć się dowolnej

relacji pomiędzy wejściem i wyjściem.

Może to zrobić uczenie oparte na korekcji błędów.

Idea:

wagi wik należy tak korygować by

zmieniały się mocno dla dużych

błędów i nie ulegały zmianie jeśli

błędu nie ma, więc

∆wik ~ ||tk – ok|| si

Skąd biorą się cele?

Od „nauczyciela”, lub

konfrontując z

przewidywaniami

modelu wewnętrznego.

Zmiana jest też proporcjonalna do

wielkości pobudzenia przez wejścia si

Faza + jest prezentacją celu, faza –

wynikiem sieci.

To jest reguła Delta.

17

EE141

18

EE141

3

Przypisywanie zasł

zasług

Ograniczanie wag

Credit/blame assignment

Nie chcemy by wagi zmieniały się bez ograniczeń i nie przyjmowały

ujemnych wartości.

Jest to zgodne z wymaganiami biologicznymi które separują neurony

hamujące i pobudzające oraz maja ograniczenie górne wag.

Błąd jest lokalny, dla wzorca k.

Jeśli powstał duży błąd i wyjście ok jest znacznie mniejsze niż

oczekiwane to neurony wejściowe o dużej aktywności jeszcze ją

zwiększą. Jeśli wyjście ok jest znacznie większe niż oczekiwane to

neurony wejściowe o dużej aktywności znacznie ją zmniejszą.

Np. wejścia si to ilość kalorii w różnym pożywieniu, wyjście to

umiarkowana waga; za dużo to trzeba zmniejszyć wysokokaloryczne

wagi (spożycie), za mało to trzeba zwiększyć.

Reprezentacje tworzone przez proces minimalizacji błędu są wynikiem

najlepszego przypisania zasług do wielu jednostek, a nie największej

19

korelacji (jak w modelach Hebbowskich).

EE141

Poniższy mechanizm zmiany wag oparty o regule delta zapewnia

spełnienie obu ograniczeń

∆wik = ∆ik (1- wik) jesli ∆ik >0

jesli ∆ik <0

∆wik = ∆ik wik

gdzie ∆ik jest zmiana wagi wynikająca z propagacji błędu

Równanie to ogranicza wartości wagi do

przedziału 0-1.

Ograniczenie górne uzasadnione jest

biologicznie przez maksymalna ilością

NT który może być wypuszczony i

maksymalna gęstością synaps

1

waga

∆wik =ε ||tk – ok|| si

0

∆wik

∆ik

20

EE141

Uczenie zadań

zadań

Symulacje

Chcemy: uczenie Hebbowskie i uczenie wykorzystujące korekcję

błędów, jednostki ukryte i biologicznie uzasadnione modele.

Wybieramy:

pat_assoc.proj.gz, z Rozdz. 5

Kombinacja korekcji błędów i korelacji da się uzgodnić z tym co

wiadomo o LTP/LTD

Opis: Rozdz. 5. 5

Reguła Delta potrafi się nauczyć

trudnych odwzorowań,

przynajmniej teoretycznie ...

∆wij = ε [ ⟨ xi yj ⟩ + − ⟨ xi yj ⟩ −]

Hebbowskie sieci modelują stany świata ale nie percepcje-działanie.

Korekcja błędu może się nauczyć mapowania.

Niestety reguła delta dobra jest tylko dla jednostki wyjściowej, a nie

ukrytej, bo trzeba jej podać cel.

Metoda wstecznej propagacji błędu potrafi uczyć jednostki ukryte.

Ale nie ma dla niej dobrego uzasadnienia biologicznego ... .

21

EE141

22

EE141

4