Paweł Krakowiak

Momenty i kumulanty rozkładów

prawdopodobieństwa, współczynnik zmienności,

skośność i kurtoza, funkcje generujące momenty.

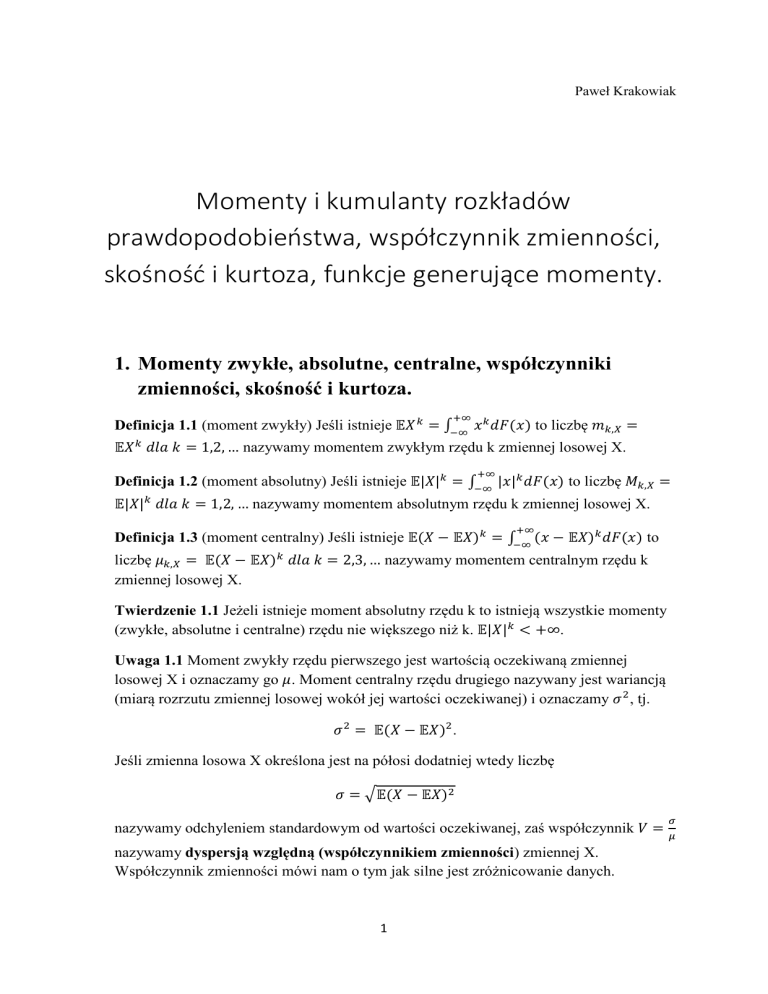

1. Momenty zwykłe, absolutne, centralne, współczynniki

zmienności, skośność i kurtoza.

+∞

Definicja 1.1 (moment zwykły) Jeśli istnieje 𝔼𝑋 𝑘 = ∫−∞ 𝑥 𝑘 𝑑𝐹(𝑥) to liczbę 𝑚𝑘,𝑋 =

𝔼𝑋 𝑘 𝑑𝑙𝑎 𝑘 = 1,2, … nazywamy momentem zwykłym rzędu k zmiennej losowej X.

+∞

Definicja 1.2 (moment absolutny) Jeśli istnieje 𝔼|𝑋|𝑘 = ∫−∞ |𝑥|𝑘 𝑑𝐹(𝑥) to liczbę 𝑀𝑘,𝑋 =

𝔼|𝑋|𝑘 𝑑𝑙𝑎 𝑘 = 1,2, … nazywamy momentem absolutnym rzędu k zmiennej losowej X.

+∞

Definicja 1.3 (moment centralny) Jeśli istnieje 𝔼(𝑋 − 𝔼𝑋)𝑘 = ∫−∞ (𝑥 − 𝔼𝑋)𝑘 𝑑𝐹(𝑥) to

liczbę 𝜇𝑘,𝑋 = 𝔼(𝑋 − 𝔼𝑋)𝑘 𝑑𝑙𝑎 𝑘 = 2,3, … nazywamy momentem centralnym rzędu k

zmiennej losowej X.

Twierdzenie 1.1 Jeżeli istnieje moment absolutny rzędu k to istnieją wszystkie momenty

(zwykłe, absolutne i centralne) rzędu nie większego niż k. 𝔼|𝑋|𝑘 < +∞.

Uwaga 1.1 Moment zwykły rzędu pierwszego jest wartością oczekiwaną zmiennej

losowej X i oznaczamy go 𝜇. Moment centralny rzędu drugiego nazywany jest wariancją

(miarą rozrzutu zmiennej losowej wokół jej wartości oczekiwanej) i oznaczamy 𝜎 2 , tj.

𝜎 2 = 𝔼(𝑋 − 𝔼𝑋)2.

Jeśli zmienna losowa X określona jest na półosi dodatniej wtedy liczbę

𝜎 = √𝔼(𝑋 − 𝔼𝑋)2

𝜎

nazywamy odchyleniem standardowym od wartości oczekiwanej, zaś współczynnik 𝑉 = 𝜇

nazywamy dyspersją względną (współczynnikiem zmienności) zmiennej X.

Współczynnik zmienności mówi nam o tym jak silne jest zróżnicowanie danych.

1

Definicja 1.4 (współczynnik skośności) Współczynnikiem skośności zmiennej losowej X

nazywamy liczbę 𝛾 =

𝜇3,𝑋

𝜎3

. Używa się do charakteryzacji skośności rozkładów. Informuje

nas o tym jak wyniki dla danej zmiennej kształtują się wokół średniej.

Uwaga 1.2 𝜇3,𝑋 = 0 dla rozkładów symetrycznych (gdy wykres funkcji gęstości jest

symetryczny względem prostej 𝑥 = 𝜇). 𝜇3,𝑋 przyjmuje wartości dodatnie dla rozkładów

prawo skośnych (takich, gdzie rozrzut po prawej stronie wartości oczekiwanej jest

większy niż po lewej), a wartości ujemne dla rozkładów lewo skośnych.

Definicja 1.5 (kurtoza) Współczynnikiem ekscesu zmiennej losowej X nazywamy liczbę

𝜇4,𝑋

𝜇4,𝑋

,

kurtozą

nazywamy

współczynnik

ekscesu

pomniejszony

o

3,

tj.

𝛾

=

− 3. 𝛾2 ≥

2

4

𝜎

𝜎4

−2. Jest to miara koncentracji i spłaszczenia rozkładu. Określa rozmieszczenie i

koncentrację wartości w pobliżu średniej.

2. Funkcja generująca momenty.

Definicja 2.1 (funkcja generująca momenty) Funkcja generująca momenty (FGM) to

funkcja zmiennej rzeczywistej t określona dla danej zmiennej losowej X o danej

+∞

dystrybuancie F w sposób następujący: 𝑀𝑋 (𝑡) = 𝔼𝑒 𝑡𝑋 = ∫−∞ 𝑒 𝑡𝑥 𝑑𝐹(𝑥), o dziedzinie

wyznaczonej przez zbiór tych wartości t, dla których występująca we wzorze wartość

oczekiwana istnieje i jest skończona..

+∞

Uwaga 2.1 𝑀𝑋 (0) = 𝔼𝑒 0 = ∫−∞ 𝑑𝐹(𝑥) = 1.

Uwaga 2.2 Gdy X przyjmuje wartości nieujemne, 𝑀𝑋 jest określona (wraz ze swoimi

pochodnymi dowolnego rzędu) dla wszystkich 𝑡 < 0. Gdy X przyjmuje wartości

nieujemne ograniczone z góry, 𝑀𝑋 jest określona (wraz ze swoimi pochodnymi

dowolnego rzędu) dla wszystkich 𝑡 ∈ ℝ..

Twierdzenie 2.1 Jeżeli FGM zmiennej losowej X określona jest na pewnym przedziale

zawierającym zero tj. dla 𝑡 ∈ (−𝑡0 , 𝑡0 ), 𝑡0 > 0, to:

1. 𝑖𝑠𝑡𝑛𝑖𝑒𝑗ą 𝑤𝑠𝑧𝑦𝑠𝑡𝑘𝑖𝑒 𝑚𝑜𝑚𝑒𝑛𝑡𝑦 𝑧𝑚𝑖𝑒𝑛𝑛𝑒𝑗 𝑙𝑜𝑠𝑜𝑤𝑒𝑗 𝑋, 𝑡𝑗. 𝔼|𝑋|𝑘 < +∞, k=1,2,…

2. 𝑀𝑋 (𝑡) = ∑∞

𝑘=0

𝑡 𝑘 𝔼𝑋 𝑘

𝑘!

, 𝑑𝑙𝑎 𝑡 ∈ (−𝑡0 , 𝑡0 )

(𝑘)

3. 𝑀𝑋 (0) = 𝔼𝑋 𝑘 , 𝑘 = 1,2 …

Twierdzenie 2.2 𝑀𝑎𝑋+𝑏 (𝑡) = 𝑒 𝑏𝑡 𝑀𝑋 (𝑎𝑡)

Twierdzenie 2.3 Załóżmy, że 𝑋1 , 𝑋2 , … , 𝑋𝑛 są niezależnymi zmiennymi losowymi,

których FGM sa określone na wspólnym przedziale (−𝑡0 , 𝑡0 ), 𝑡0 > 0. Wówczas 𝑊 =

𝑋1 + 𝑋2 + ⋯ + 𝑋𝑛 ma FGM określoną na przedziale (−𝑡0 , 𝑡0 ) wzorem:

𝑛

𝑀𝑊 (𝑡) = ∏

𝑖=1

𝑀𝑋𝑖 (𝑡), 𝑡 ∈ (−𝑡0 , 𝑡0 )

2

Twierdzenie 2.4 Jeżeli FGM zmiennych losowych X i Y są równe na przedziale

(−𝑡0 , 𝑡0 ), 𝑡0 > 0 to X i Y mają ten sam rozkład.

Twierdzenie 2.5 Jeżeli FGM jest określona na przedziale otwartym zawierającym zero to

wyznacza ona jednoznacznie rozkład.

3. Funkcja generująca kumulanty.

Definicja 3.1 (funkcja generująca kumulanty) Funkcja generująca kumulanty (FGK) to

funkcja określona wzorem 𝐶𝑋 (𝑡) = ln( 𝑀𝑋 (𝑡)). Dziedziną tej funkcji jest dziedzina

funkcji 𝐹𝑋 .

Uwaga 3.1 Oczywiście 𝐶𝑊 (𝑡) = ∑𝑛𝑖=1 𝐶𝑋𝑖 (𝑡). Zatem FGK dla sumy 𝑊 = 𝑋1 + 𝑋2 + ⋯ +

𝑋𝑛 niezależnych zmiennych losowych jest sumą FGK dla składników 𝑋𝑖 , 𝑖 = 1, … , 𝑛.

Ponadto własność ta zachodzi dla dowolnej pochodnej 𝑘 − 𝑡𝑒𝑔𝑜 rzędu FGK, w

szczególności dla 𝑡 = 0:

𝑛 𝜕 𝑘 𝐶 (𝑡)

𝜕 𝑘 𝐶𝑊 (𝑡)

𝑋𝑖

|

=∑

| , 𝑘 = 1,2, …

𝑘

𝜕𝑡

𝜕𝑡𝑘 𝑡=0

𝑖=1

𝑡=0

Definicja 3.1 (kumulanta) Kumulantę zmiennej losowej X rzędu k definiujemy wzorem

𝑐𝑘 =

𝜕 𝑘 𝐶𝑋 (𝑡)

| , 𝑘 = 1,2, …

𝜕𝑡𝑘 𝑡=0

Uwaga 3.2 Z powyższego wynika, że kumulanty to takie szczególne charakterystyki,

które sumują się do sum niezależnych zmiennych losowych.

Uwaga 3.3 Zachodzą następujące zależności:

𝑐1 = 𝜇 (wartość oczekiwana)

𝑐2 = 𝑚2 − 𝜇 2 = 𝜇2 (wariancja)

𝑐3 = 𝜇3 (moment centralny rzędu 3)

𝑐4 = 𝜇4 − 3𝜎 4 (moment centralny rzędu 4 pomniejszony o trzykrotność kwadratu

wariancji)

𝑐

5. 𝛾 = 𝜎33

1.

2.

3.

4.

6. 𝛾2 =

𝜇4 −3𝜎4

𝜎4

𝑐

= 𝜎44

4. Przykłady

Przykład 4.1 Funkcja gęstości rozkładu Γ(𝛼, 𝛽), 𝛼 > 0, 𝛽 > 0, ma postać:

𝛽 𝛼 𝛼−1 −𝛽𝑥

𝑥

𝑒

𝑓(𝑥) = { Γ(𝛼)

0

𝑑𝑙𝑎 𝑥 ≤ 0

3

, 𝑑𝑙𝑎 𝑥 > 0

FGM dla rozkładu Γ(𝛼, 𝛽) ma postać:

+∞

𝑀(𝑡) = ∫

0

𝑒

𝑡𝑥

+∞

𝛽 𝛼 𝛼−1 −𝛽𝑥

(𝛽 − 𝑡)𝛼 𝛼−1 −(𝛽−𝑡)𝑥

𝛽 𝛼

𝛽 𝛼

𝑥

𝑒

𝑑𝑥 = (𝛽−𝑡) ∫

𝑥

𝑒

= (𝛽−𝑡) ,

Γ(𝛼)

Γ(𝛼)

0

𝑑𝑙𝑎 𝑡 ∈ (−∞, 𝛽)

Dla 𝑡 ∈ (𝛽, +∞) podana całka jest rozbieżna.

FGK dla rozkładu Γ(𝛼, 𝛽) ma postać:

𝐶(𝑡) = 𝛼[ln 𝛽 − ln(𝛽 − 𝑡)], 𝑑𝑙𝑎 𝑡 ∈ (−∞, 𝛽)

𝐶 ′ (𝑡) =

𝐶 ′′ (𝑡) =

𝛼

𝛼

, 𝑤𝑖ę𝑐 𝐸𝑋 =

𝛽−𝑡

𝛽

𝛼

𝛼

𝑤𝑖ę𝑐 𝑉𝑎𝑟𝑋 = 2

2

(𝛽 − 𝑡)

𝛽

Niech 𝑋1 , 𝑋2 , … , 𝑋𝑛 będą niezależnymi zmiennymi losowymi, 𝑋𝑖 ~Γ(𝛼𝑖 , 𝛽), 𝑖 = 1, … , 𝑛 𝑊 =

𝛽

𝑋1 + 𝑋2 + ⋯ + 𝑋𝑛 . Wtedy 𝑀𝑊 (𝑡) = (𝛽−𝑡

)

∑𝑛

𝑖=1 𝛼𝑖

, 𝑡 ∈ (−∞, 𝛽) .

Przykład 4.2

Funkcja prawdopodobieństwa dla rozkładu 𝑃(𝜆) ma postac:

𝑃(𝑁 = 𝑘) = 𝑒 −𝜆

𝜆𝑘

, 𝑘 = 0,1, …

𝑘!

FGM dla rozkładu 𝑃(𝜆) ma postać:

∞

𝑀(𝑡) = ∑

𝑒 𝑡𝑘 𝑒 −𝜆

𝑘=0

∞ (𝑒 𝑡 𝜆)𝑘

𝜆𝑘

𝑡

= 𝑒 −𝜆 ∑

= 𝑒 𝜆(𝑒 −1) , 𝑡 ∈ ℝ

𝑘!

𝑘!

𝑘=0

FGK dla rozkładu 𝑃(𝜆) ma postać:

𝐶(𝑡) = 𝜆(𝑒 𝑡 − 1), 𝑡 ∈ ℝ

𝑐𝑘 = 𝐶 (𝑘) (𝑡)|𝑡=0 = 𝜆,

𝑘 = 1,2, …

Zatem 𝐸𝑋 = 𝑉𝑎𝑟𝑋 = 𝜆.

Niech 𝑋1 , 𝑋2 , … , 𝑋𝑛 będą niezależnymi zmiennymi losowymi o rozkładach Poissona z

parametrami 𝜆1 , … , 𝜆𝑛 , 𝑊 = 𝑋1 + 𝑋2 + ⋯ + 𝑋𝑛 . Wtedy:

𝑀𝑊 (𝑡) = ∏𝑛𝑖=1 𝑀𝑋𝑖 (𝑡) = 𝑒 𝜆1 (𝑒

𝑡 −1)+⋯+𝜆 (𝑒 𝑡 −1)

𝑛

= 𝑒 𝜆(𝑒

𝑡 −1)

, 𝑔𝑑𝑧𝑖𝑒 𝜆 = 𝜆1 + ⋯ + 𝜆𝑛 .

Oznacza to, że suma zmiennych losowych o rozkładzie Poissona ma także rozkład Poissona.

4