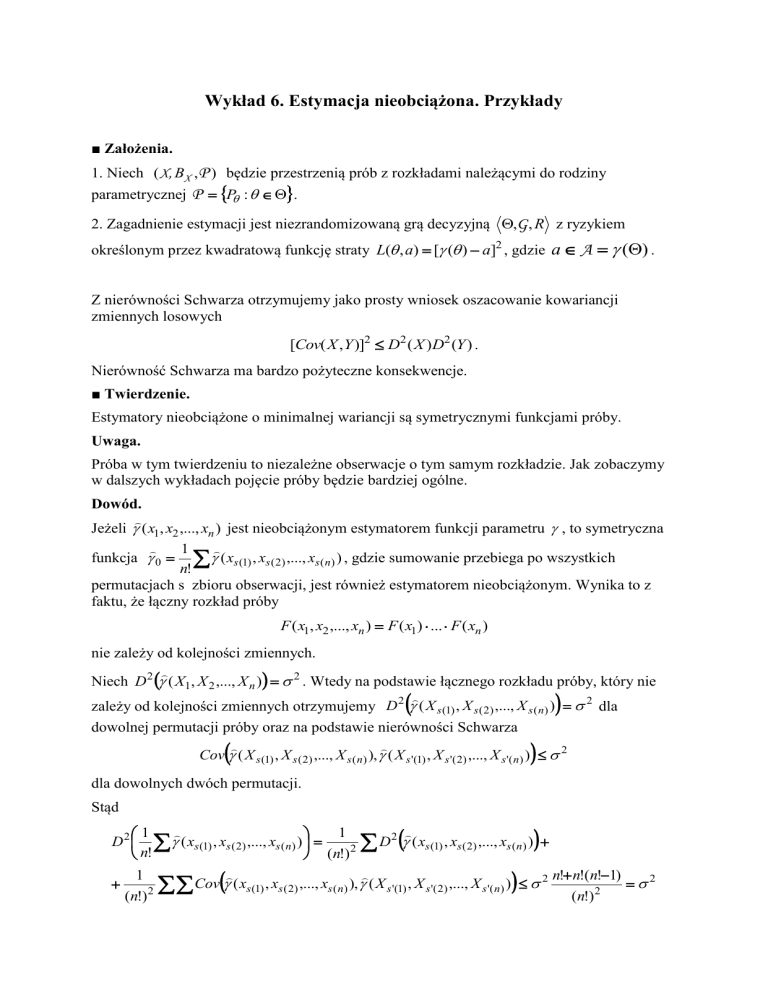

Wykład 6. Estymacja nieobciążona. Przykłady

■ Założenia.

1. Niech ( X, BX ,P ) będzie przestrzenią prób z rozkładami należącymi do rodziny

parametrycznej P P : .

2. Zagadnienie estymacji jest niezrandomizowaną grą decyzyjną ,G , R z ryzykiem

określonym przez kwadratową funkcję straty L( , a) [ ( ) a]2 , gdzie a A () .

Z nierówności Schwarza otrzymujemy jako prosty wniosek oszacowanie kowariancji

zmiennych losowych

[Cov( X ,Y )]2 D2 ( X ) D2 (Y ) .

Nierówność Schwarza ma bardzo pożyteczne konsekwencje.

■ Twierdzenie.

Estymatory nieobciążone o minimalnej wariancji są symetrycznymi funkcjami próby.

Uwaga.

Próba w tym twierdzeniu to niezależne obserwacje o tym samym rozkładzie. Jak zobaczymy

w dalszych wykładach pojęcie próby będzie bardziej ogólne.

Dowód.

Jeżeli ( x1, x2 ,..., xn ) jest nieobciążonym estymatorem funkcji parametru , to symetryczna

1

funkcja 0 ( xs (1) , xs ( 2) ,..., xs ( n) ) , gdzie sumowanie przebiega po wszystkich

n!

permutacjach s zbioru obserwacji, jest również estymatorem nieobciążonym. Wynika to z

faktu, że łączny rozkład próby

F ( x1, x2 ,..., xn ) F ( x1) ... F ( xn )

nie zależy od kolejności zmiennych.

Niech D2 ( X1, X 2 ,..., X n ) 2 . Wtedy na podstawie łącznego rozkładu próby, który nie

zależy od kolejności zmiennych otrzymujemy D 2 ( X s (1) , X s ( 2) ,..., X s ( n) ) 2 dla

dowolnej permutacji próby oraz na podstawie nierówności Schwarza

Cov ( X s (1) , X s ( 2) ,..., X s ( n) ), ( X s '(1) , X s '( 2) ,..., X s '( n) ) 2

dla dowolnych dwóch permutacji.

Stąd

1

1

D 2 ( xs (1) , xs ( 2) ,..., xs ( n) )

D 2 ( xs (1) , xs ( 2) ,..., xs ( n) )

2

n!

(n!)

1

n! n!(n!1)

Cov ( xs (1) , xs ( 2) ,..., xs ( n) ), ( X s '(1) , X s '( 2) ,..., X s '( n) ) 2

2

2

2

(n!)

(n!)

Twierdzenie powyższe odgrywa ważną rolę, gdy nie jest znana postać rodziny rozkładów.

■ Lemat.

Każdy nieobciążony estymator wielkości ( ) można przedstawić w postaci 0 V ,

gdzie 0 jest nieobciążonym estymatorem dla ( ) i V jest nieobciążonym estymatorem

zera.

Przykład.

Wiadomo z poprzednich przykładów, że estymatorem nieobciążonym wartości oczekiwanej

jest

X

1 n

Xi .

n i 1

Każdy nieobciążony estymator można wobec tego zapisać w postaci x V , gdzie

E (V ) 0 . Jeżeli ma to być estymator o minimalnej wariancji, to x V musi być

symetryczną funkcją próby co prowadzi do wniosku, że V musi też być symetryczną funkcją

próby.

Jeżeli teraz o rodzinie rozkładów założymy jedynie, że posiada pierwszy moment skończony,

to dobierając odpowiedni rozkład można pokazać, że V 0 p.w. Stąd wynika następujący

wniosek .

■ Wniosek.

W rodzinie wszystkich rozkładów posiadających pierwszy moment skończony estymator X

jest jedynym symetrycznym estymatorem nieobciążonym wartości oczekiwanej. Jest więc

estymatorem NJMW.

Uwaga.

W rodzinach o bardziej ograniczających założeniach teza wniosku nie musi być prawdziwa.

Przykład 1-rozkład ciągły.

Niech X będzie próbą z rozkładu R(0, ) .

2

Uwaga.

Czy analogiczny przypadek dyskretny dla próby z rozkładu

1/ N

PN (k )

0

kN

kN

ma podobne rozwiązanie?

Przykład 2- rozkład ciągły.

Niech X oznacza czas życia pewnego elementu. Niezawodność elementu mierzymy

prawdopodobieństwem, że element przeżyje do chwili z

z ( ) P ( X z )

przy czym P jest prawdopodobieństwem zależnym od nieznanego parametru .

Wiadomo, że P ( ,1) dla 0 jest rozkładem wykładniczym z funkcją gęstości

f ( x) e x I (0, ) ( x)

Możemy zatem niezawodność wyrazić wzorem

z ( ) P ( X z ) e

z

x

1

dx e x e zx dla z 0 .

z

Ponieważ łączna gęstość w rozkładzie wykładniczym jest postaci

fX ( x1,..., xn ) ne xi I (0,) (min x) ,

więc statystyką dostateczną i zupełną (bo jest rodzina wykładnicza) jest T xi .

3

Na mocy twierdzenia Lehmanna-Scheffego do wyznaczenia najlepszego estymatora

nieobciążonego potrzebny jest dowolny estymator nieobciążony funkcji parametru

z ( ) e zx , który następnie poprawimy biorąc jego warunkową wartość oczekiwaną

względem statystyki T.

Zauważmy, że

z ( ) e

x

z

dx I[ z , ) ( x) f ( x)dx E ( I[ z , ) ( X1))

0

Stąd otrzymujemy estymator nieobciążony I[ z , ) ( x) .

Najlepszy estymator nieobciążony ma więc postać E I[ z , ) ( X1 ) | T .

Statystyka T ma rozkład Erlanga ( , n) o funkcji gęstości

f T (t )

nt n 1e t

(n 1)!

I (0, ) (t )

Ponieważ chcemy wyznaczyć rozkład warunkowy X1 i T X1 ... X n , to na początek

weźmy zmienne niezależne X1 i T0 X 2 ... X n ~ ( , n 1) . Wtedy

( X 1 ,T0 )

f

(T0 )

( x, t ) f X1 ( x) f

(t ) e x

nt n 2e t

(n 2)!

I (0, ) ( x) I (0, ) (t ) .

Teraz wyznaczymy odwzorowanie ( X1, T0 ) ( X1, T ) następująco Y1 X1, Y2 X1 T0 .

Stąd X1 Y1, T0 Y2 X1 i otrzymujemy h( y1, y2 ) [ y1, y2 y1]

Wykorzystując twierdzenie o zmianie zmiennych

( X 1 ,T0 )

f(Y1 ,Y2 ) ( y1, y2 ) f

(h( y1, y2 ))

h( y1, y2 )

( X ,T )

f 1 0 ( y1, y2 y1) 1 0

1 1

( y1, y2 )

otrzymujemy

( X 1 ,T )

f

( X 1 ,T0 )

( x, t ) f

( x, t x ) e

f ( X 1 ,T ) ( x, t )

x

n (t x)n 2 e (t x)

(n 2)!

n (t x)n 2 e t

(n 2)!

Stąd

4

I (0, ) ( x) I (0, ) (t x)

I (0, ) ( x) I (0, ) (t x) .

( X 1 |T )

f

(x | t)

n 1

1

t

x

t

( X 1 ,T )

f

n (t x) n 2 e t

( x, t )

f T (t )

I (0, ) ( x) I (0, ) (t x)

(n 2)!

nt n 1e t

I (0, ) (t )

(n 1)!

n 2

I (0, ) (t x)

dla t 0 .

Mając warunkową gęstość możemy na koniec poprawić wyznaczony estymator obliczając

n 1

E ( I[ z , ) ( X1 ) | T ) I[ z , ) ( x)

1

t

0

0

t

n 1

1

t

z

x

t

n 2

I (0, ) (t x)dx

dla t z

x

t

n 2

dla t z

0

n 1

z

dx dla t z

dla t z

1 t

Ostatecznie najlepszy estymator nieobciążony ma postać

dla t z

0

n 1

.

z ( x1,..., xn )

z

1

dla

t

z

xi

Przykład 3 – rozkład skokowy.

Próba x1,..., xn pochodzi z rozkładu zero-jedynkowego B (1, p ) w którym P( X i 1) p .

5

Przykład 4 – rozkład skokowy.

Chcemy oszacować liczbę N ryb w jeziorze. W tym celu łowimy k ryb, które znakujemy i

wpuszczamy z powrotem do jeziora. Następnie po pewnym czasie łowimy n ryb.

Prawdopodobieństwo złowienia ryby oznakowanej jest równe p k / N , a stąd N k / p .

Problem polega więc na oszacowaniu wielkości N k / p przy znanym k , a więc na

oszacowaniu wielkości 1 / p . Zauważmy, że liczba ryb oznakowanych w stosunku do ilości

wszystkich ryb w jeziorze jest niewielka, a więc p jest bardzo małe. Natomiast wielkość

1 / p jest bardzo wrażliwa na zmiany p bliskich zera (np. gdy p zmieni się z 0.01 na 0.001 ,

to 1 / p zmieni się ze 100 na 1000). W związku z tym, przy takim sposobie prowadzenia

obserwacji) każde szacowanie narażone jest na bardzo duże błędy.

Ominięcie tego problemu to inny sposób prowadzenia tego badania. Polega on na odławianiu

ryb tak długo dopóki nie otrzymamy z góry ustalonej liczby sukcesów tzn. ryb

oznakowanych.

Niech zmienna X m oznacza liczbę doświadczeń potrzebnych do uzyskania m sukcesów.

Analizując prawdopodobieństwo P( X x) łatwo policzyć, że w x m 1 doświadczeniach

musimy mieć m 1 sukcesów i ostatnie musi zakończyć się sukcesem

6