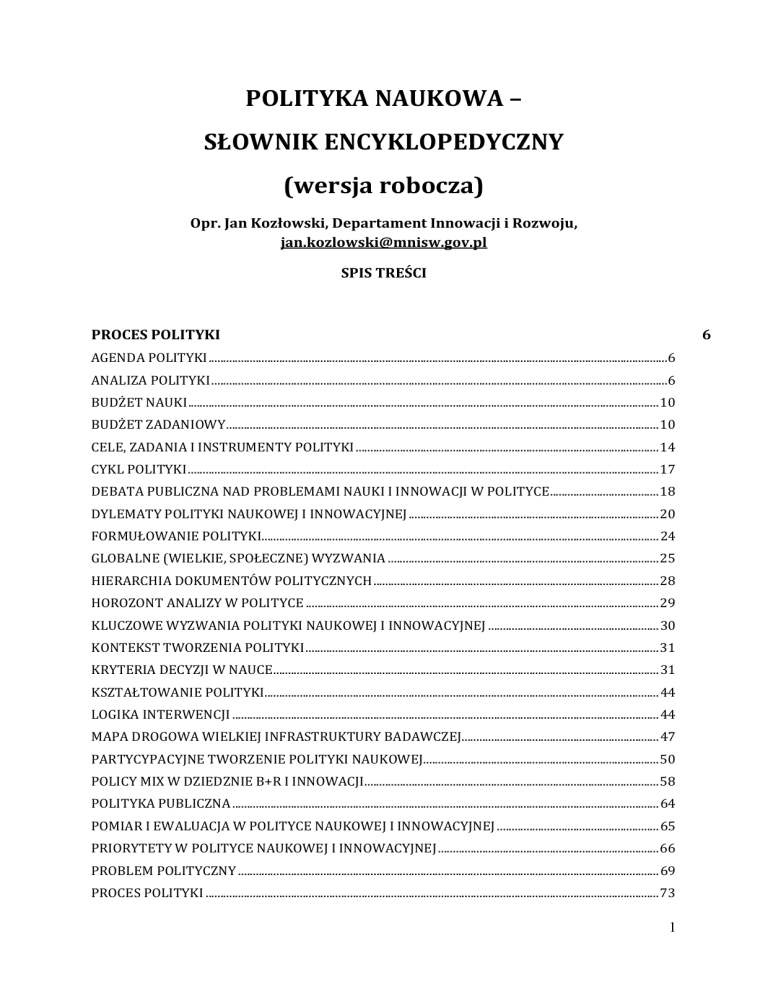

POLITYKA NAUKOWA –

SŁOWNIK ENCYKLOPEDYCZNY

(wersja robocza)

Opr. Jan Kozłowski, Departament Innowacji i Rozwoju,

[email protected]

SPIS TREŚCI

PROCES POLITYKI

6

AGENDA POLITYKI ............................................................................................................................................................6

ANALIZA POLITYKI ...........................................................................................................................................................6

BUDŻET NAUKI ................................................................................................................................................................ 10

BUDŻET ZADANIOWY ................................................................................................................................................... 10

CELE, ZADANIA I INSTRUMENTY POLITYKI ....................................................................................................... 14

CYKL POLITYKI ................................................................................................................................................................ 17

DEBATA PUBLICZNA NAD PROBLEMAMI NAUKI I INNOWACJI W POLITYCE ..................................... 18

DYLEMATY POLITYKI NAUKOWEJ I INNOWACYJNEJ ..................................................................................... 20

FORMUŁOWANIE POLITYKI....................................................................................................................................... 24

GLOBALNE (WIELKIE, SPOŁECZNE) WYZWANIA ............................................................................................ 25

HIERARCHIA DOKUMENTÓW POLITYCZNYCH ................................................................................................. 28

HOROZONT ANALIZY W POLITYCE ........................................................................................................................ 29

KLUCZOWE WYZWANIA POLITYKI NAUKOWEJ I INNOWACYJNEJ .......................................................... 30

KONTEKST TWORZENIA POLITYKI ........................................................................................................................ 31

KRYTERIA DECYZJI W NAUCE ................................................................................................................................... 31

KSZTAŁTOWANIE POLITYKI...................................................................................................................................... 44

LOGIKA INTERWENCJI ................................................................................................................................................. 44

MAPA DROGOWA WIELKIEJ INFRASTRUKTURY BADAWCZEJ................................................................... 47

PARTYCYPACYJNE TWORZENIE POLITYKI NAUKOWEJ................................................................................ 50

POLICY MIX W DZIEDZNIE B+R I INNOWACJI.................................................................................................... 58

POLITYKA PUBLICZNA ................................................................................................................................................. 64

POMIAR I EWALUACJA W POLITYCE NAUKOWEJ I INNOWACYJNEJ ....................................................... 65

PRIORYTETY W POLITYCE NAUKOWEJ I INNOWACYJNEJ ........................................................................... 66

PROBLEM POLITYCZNY ............................................................................................................................................... 69

PROCES POLITYKI .......................................................................................................................................................... 73

1

RAMY ANALIZY POLITYKI NAUKOWEJ I INNOWACYJNEJ ............................................................................ 80

RAMY POLITYKI .............................................................................................................................................................. 82

REFORMY BUDŻETU PAŃSTWA ............................................................................................................................... 84

RETORYKA POLITYCZNA............................................................................................................................................. 90

ROLA WIEDZY W PROCESIE POLITYCZNYM....................................................................................................... 93

SKŁADNIKI POLITYK NAUKOWEJ I INNOWACYJNEJ ....................................................................................... 97

SPÓJNOŚĆ POLITYKI ...................................................................................................................................................... 98

TWÓRCZA SWOBODA CZY STEROWANIE NAUKĄ ........................................................................................ 101

UMIĘDZYNARODOWIENIE POLITYKI ................................................................................................................. 108

UZASADNIENIA POLITYKI NAUKOWEJ I INNOWACYJNEJ ......................................................................... 109

WDRAŻANIE POLITYKI ............................................................................................................................................. 111

WDRAŻANIE REFORMY SZKOLNICTWA WYŻSZEGO ................................................................................... 112

ZAŁOŻENIA I RAMY KONCEPCYJNE POLITYK ................................................................................................. 117

ZARZĄDZANIE WIEDZĄ W ORGANIZACJACH RZĄDOWYCH..................................................................... 117

ZASADA OSTROŻNOŚCI ............................................................................................................................................. 118

FINANSOWANIE B+R I INNOWACJI

120

FINANSOWANIE BADAŃ W SEKTORZE PUBLICZNYM ................................................................................ 120

FINANSOWANIE BUDŻETOWE BADAŃ W SEKTORZE SZKÓŁ WYŻSZYCH ........................................ 121

FINANSOWANIE INSTYTUCJONALNE ................................................................................................................. 124

FINANSOWANIE PROJEKTÓW ............................................................................................................................... 125

FINANSOWE INSTRUMENTY WSPIERANIA B+R I INNOWACJI W PRZEDSIĘBIORSTWACH ...... 126

POMOC PUBLICZNA DLA B+R I INNOWACJI .................................................................................................... 133

EWALUACJA

134

EWALUACJA ................................................................................................................................................................... 134

ROZLICZALNOŚĆ .......................................................................................................................................................... 143

OCENA SKUTKÓW REGULACJI ............................................................................................................................... 145

KRAJOWE SYSTEMY EWALUACJI BADAŃ ......................................................................................................... 150

EWALUACJA KRAJOWEGO SYSTEMU BADAŃ I INNOWACJI ..................................................................... 156

OCENA WPŁYWU BADAŃ ......................................................................................................................................... 161

BENCHMARKING POLITYK ...................................................................................................................................... 185

EWALUACJA POLICY MIX ......................................................................................................................................... 197

EWALUACJA POLITYKI NAUKOWEJ I INNOWACYJNEJ ................................................................................ 198

EWALUACJA PROGRAMÓW NAUKOWYCH I TECHNOLOGICZNYCH...................................................... 213

EWALUACJA DYSCYPLIN NAUKOWYCH ............................................................................................................ 215

EWALUACJA INSTYTUCJI I GRUP BADAWCZYCH .......................................................................................... 217

2

EWALUACJA INSTYTUCJI PUBLICZNEGO SEKTORA NAUKI OPARTA NA POMIARZE DOKONAŃ ..... 220

ORGANIZACJA EWALUACJI INSTYTUCJONALNEJ .......................................................................................... 232

FAZY EWALUACJI INSTYTUCJONALNEJ ............................................................................................................. 237

EWALUACJA POZA-UCZELNIANYCH PUBLICZNYCH INSTYTUCJI NAUKOWYCH (PPIN) ............. 242

EWALUACJA EX-POST AGENCJI FINANSUJĄCYCH BADANIA NAUKOWE I TECHNOLOGICZNE 246

EWALUACJA APARATURY I INFRASTRUKTURY BADAWCZEJ ................................................................. 252

PEER REVIEW................................................................................................................................................................ 254

EWALUACJA EX ANTE WNIOSKÓW GRANTOWYCH..................................................................................... 273

EWALUACJA EX POST GRANTÓW BADAWCZYCH ......................................................................................... 273

EWALUACJA POLICY INTELLIGENCE – FORM WSPARCIA INFORMACYJNO-ANALITYCZNEGO

POLITYKI NAUKOWEJ I INNOWACYJNEJ ........................................................................................................... 274

EWALUACJA PROGRAMU RAMOWEGO ORAZ „HORYZONTU 2020”...................................................... 275

EWALUACJA ZACHĘT PODATKOWYCH.............................................................................................................. 278

IMPACT FACTOR .......................................................................................................................................................... 279

METODY EWALUACJI B+R FINANSOWANYCH ZE ŹRÓDEŁ PUBLICZNYCH ....................................... 280

METODY STOSOWANE W EWALUACJI INSTYTUCJONALNEJ ................................................................... 294

PYTANIA I KRYTERIA W EWALUACJI INSTYTUCJONALNEJ...................................................................... 301

PROBLEM BEZSTRONNOŚCI EWALUATORA ................................................................................................... 310

KONCEPCJE DLA POLITYKI NAUKOWEJ

313

BAZA NAUKOWA .......................................................................................................................................................... 313

BIG DATA ......................................................................................................................................................................... 313

DOSKONAŁOŚĆ BADAWCZA ................................................................................................................................... 315

FAZY POLITYKI NAUKOWEJ .................................................................................................................................... 322

FAZY ROZWOJU GOSPODARCZEGO ...................................................................................................................... 332

GOSPODARKA OPARTA NA WIEDZY ................................................................................................................... 337

GOSPODARKA UCZĄCA SIĘ ...................................................................................................................................... 337

INTELIGENCJA ROZPROSZONA ............................................................................................................................. 341

INTELIGENTNA SPECJALIZACJA............................................................................................................................ 342

INTELIGENTNE MIASTO ........................................................................................................................................... 344

INTERES PUBLICZNY ................................................................................................................................................. 345

INTERESARIUSZE POLITYKI NAUKOWEJ.......................................................................................................... 346

KAPITAŁ INTELEKTUALNY ..................................................................................................................................... 347

KONWERGENCJA.......................................................................................................................................................... 350

KOREA JAKO KRAJ GONIĄCY CZOŁÓWKĘ ......................................................................................................... 350

KRAJOWY KONTEKST POLITYKI NAUKOWEJ I INNOWACYJNEJ............................................................. 354

TWÓRCZOŚĆ, INNOWACJE, BADANIA NAUKOWE, KSZTAŁCENIE I POLITYKA................................ 356

3

MĄDROŚĆ TŁUMU ....................................................................................................................................................... 360

N+T DLA ROZWOJU ..................................................................................................................................................... 360

NAUKA W SPOŁECZEŃSTWIE ................................................................................................................................ 361

NOWA REWOLUCJA PRZEMYSŁOWA .................................................................................................................. 362

ODPOWIEDZIALNE BADANIA I INNOWACJE ................................................................................................... 362

POJĘCIA POLITYKI NAUKOWEJ ............................................................................................................................. 366

POTRÓJNA SPIRALA ................................................................................................................................................... 367

PUŁAPKA NISKIEGO DOCHODU............................................................................................................................. 367

PUŁAPKA ŚREDNIEGO DOCHODU ........................................................................................................................ 368

REFLEKSYJNOŚĆ........................................................................................................................................................... 371

REWOLUCJA 3D ............................................................................................................................................................ 374

ROLA RZĄDU W BADANIACH I INNOWACJACH ............................................................................................. 376

ROZLICZALNOŚĆ .......................................................................................................................................................... 378

SKUMULOWANE KORZYŚCI .................................................................................................................................... 380

SPOŁECZEŃSTWO INFORMACYJNE ..................................................................................................................... 382

WIEDZA JAKO DOBRO PUBLICZNE ...................................................................................................................... 385

ORGANIZACJA I MECHANIZMY

387

AGENCYFIKACJA........................................................................................................................................................... 387

EUROPEIZACJA.............................................................................................................................................................. 387

GOVERNANCE................................................................................................................................................................ 388

KOORDYNACJA POLITYCZNA A ROZWÓJ NAUKOWY I TECHNOLOGICZNY JAPONII ..................... 392

NOWE ZARZĄDZANIE PUBLICZNE ....................................................................................................................... 394

STRATEGICZNE PLANY ROZWOJU NAUKI I TECHNIKI ............................................................................... 396

POLITYKA MIĘDZY SFERĄ RYNKU I INSTYTUCJI SPOŁECZNYCH .......................................................... 400

PRYNCYPAŁ-AGENT ................................................................................................................................................... 403

STYLE POLITYKI ........................................................................................................................................................... 404

POLITYKA „UCZĄCA SIĘ” - UCZENIE SIĘ POLITYKI....................................................................................... 406

TYPY POLITYK

412

POLITYKA INNOWACYJNA ....................................................................................................................................... 412

POLITYKA NAUKOWA................................................................................................................................................ 421

POLITYKA NAUKOWA UNII EUROPEJSKIEJ...................................................................................................... 423

POLITYKA OPARTA NA DOWODACH .................................................................................................................. 425

POLITYKA TECHNOLOGICZNA ............................................................................................................................... 427

4

BADANIA NAUKOWE I ANALIZY NA RZECZ POLITYKI NAUKOWEJ

429

ANALIZA KOSZTÓW I KORZYŚCI ........................................................................................................................... 429

BADANIA NA RZECZ POLITYKI .............................................................................................................................. 429

BADANIA NAD POLITYKĄ NAUKOWĄ I INNOWACYJNĄ ............................................................................ 431

DORADZTWO NA RZECZ POLITYKI NAUKOWEJ ............................................................................................ 442

EKSPLORACJA TEKSTU ............................................................................................................................................. 447

METODY GRUPOWANIA SŁUŻĄCE OKREŚLANIU KLUCZOWYCH KOMPETENCJI KRAJU............ 451

NAUKI SPOŁECZNE A POLITYKA RZĄDOWA ................................................................................................... 451

OTWARTA NAUKA

460

E-INFRASTRUKTURA OTWARTEGO DOSTĘPU............................................................................................... 460

NAUKA OBYWATELSKA ............................................................................................................................................ 467

OTWARTA NAUKA....................................................................................................................................................... 472

OTWARTE DANE .......................................................................................................................................................... 479

OTWARTE OPROGRAMOWANIA ........................................................................................................................... 482

OTWARTE PEER REVIEW ........................................................................................................................................ 482

OTWARTE ZASOBY EDUKACYJNE ........................................................................................................................ 483

OTWARTY DOSTĘP ..................................................................................................................................................... 483

OTWARTY MANDAT ................................................................................................................................................... 491

OTWARTY NOTATNIK BADAWCZY...................................................................................................................... 492

OTWARTY PODRĘCZNIK .......................................................................................................................................... 493

OTWARTY SPRZĘT BADAWCZY ............................................................................................................................ 494

5

PROCES POLITYKI

AGENDA POLITYKI

(Policy Agenda, research policy portfolio)

Agenda polityki naukowej to zbiór kluczowych problemów (a także żądań i propozycji)

które decydenci i ich doradcy uznają za ważne dla >kształtowania polityki. Problemy

zgłaszane są przez interesariuszy, uczestników >debaty politycznej i >konsultacji, analityków i badaczy polityki, media i obywateli. Wkład to budowy agendy wnoszą także

>ewaluacje wdrożonych wcześniej polityk.

Agenda polityki jest częścią >procesu polityki i >cyklu polityki, do którego (w porządku

chrono-logicznym) zalicza się także >formułowanie polityki, >podejmowanie decyzji,

>wdrażanie polityki oraz jej >ewaluację.

Często zbiór kluczowych problemów uznanych za ważne rząd przedstawia w formie

>dokumentu politycznego (np. „Zielonej Księgi”). Agendę polityki wykorzystuje się jako

punkt wyjścia dla opracowania bardziej szczegółowych definicji problemów oraz propozycji rozwiązań.

>Problemy polityki muszą być określone w sposób uznający potrzebę podjęcia >interwencji publicznej. Spośród zgłaszanych problemów decydenci i ich doradcy wybierają

ważniejsze i/lub możliwe do przekształcenia w >politykę, >program lub w >instrument

polityki. O wyborze decydują m.in. możliwości finansowe rządu, panujące koncepcje

ekonomiczne i polityczne, siła nacisku interesariuszy i mediów, skala spodziewanego

oporu przeciwników interwencji itd.

Termin w języku angielskim wprowadzony w życie w pod koniec lat 1970., upowszechniony w latach 1990.

Bibliografia

Handbook of Public Policy Analysis. Theory, politics and methods. Ed. By Frank Fischer, Gerald Miller and

Mara S. Sidney, CRC Press, 2007, ss. 45-48.

ANALIZA POLITYKI

(Policy analysis)

Analiza polityki to ocena bieżącej polityki w porównaniu z możliwymi alternatywami.

Produkt analizy politycznej to porada wskazująca na prawdopodobne skutki proponowanych działań: wprowadzenie interwencji A spowoduje takie to a takie konsekwencje.

Mówiąc bardzie szczegółowo, celem analizy polityki jest określenie, które z różnych alternatywnych polityk pozwolą najlepiej osiągnąć dany zestaw celów. Analizę polityk

dzieli się na opisową i normatywną [Wikipedia 2013]. Analiza polityki uznaje się nieraz

za jedną z faz >cyklu polityki i jeden z dwóch głównych podejść w >procesie politycznym

(obok podejścia menedżerskiego).

6

Analityk polityki powinien wiedzieć jak zbierać, organizować i przekazywać informacje

w sytuacjach ścisłych deadlinów i presji czasu. Musi umieć szybko rozumieć naturę problemów i umieć rozwijać strategię polityczną. Musi umieć określać (przynajmniej jakościowo, o ile tylko możliwe także ilościowo) spodziewane efekty polityk i przekazywać

swoje ustalenia politykom [Dunn 1994; Weimer 1998].

Wg jednego z modeli analiza polityki składa się z czterech kroków: 1) weryfikacji, definiowania i uszczegółowienia problemu polityki, 2) ustalenia kryteriów oceny zgodnych

z założonymi celami, 3) identyfikacji alternatywnych polityk, 4) oceny alternatywnych

polityk [Por. Patton 1993].

Termin “analiza polityki” powstał w Stanach Zjednoczonych w latach 1950-tych. Analiza

polityki wspiera definiowanie problemów politycznych, identyfikowanie „interesariuszy” i ich interesów, ustalanie priorytetów oraz budowę strategii politycznych. Określa

się ją jako stosowaną naukę społeczną sięgającą po wiele metod badawczych w celu

przygotowania informacji i analiz, które mogą zostać wykorzystane przez organa polityczne dla rozwiązywania problemów. Powstanie nowego terminu oznaczało, że informacje i analizy – nieodłączny składnik decyzji politycznych od starożytności – zaczęły

być wytwarzane nie ad hoc na potrzeby konkretnych decyzji, tylko w sposób ciągły, systematyczny, wyprzedzający.

Analiza polityki jest dziś nieodłączną częścią polityki definiowanej przez Michaela Oekshotta jako działalność dialektyczna oparta na refleksji > hipotezie > działaniu jako teście

> refleksji itd. [Oekshott 1999]. Jako taka bywa ona zaliczana do szerszego pojęcia mechanizmów opartych na sprzężeniu zwrotnym, takich jak ewaluacja polityczna, audyt

lub też pomiar dokonań (performance measurement). Analizę polityczną określa się nieraz jako ewaluację ex ante w badaniu przyszłych opcji politycznych [OECD 1999].

W Europie w latach 1990-tych upowszechnił się inny zbliżony termin, „strategic intelligence” lub też „strategic policy intelligence” (brak zręcznego polskiego odpowiednika,

zob. >Wsparcie informacyjne i analityczne polityki). Nawet specjaliści mają kłopot ze

wskazaniem różnic pomiędzy oboma terminami. Analiza polityki wydaje się odnosić raczej do jednej z funkcji >procesu politycznego, a „strategic policy intelligence” – raczej

do zbioru określonych metod zbierania i przetwarzania informacji, takich jak m.in. >foresight, >ewaluacja polityk (policy evaluation), >wartościowanie technologii (techology

assessment), >skanowanie widnokręgu (horizon scanning) oraz prognozowanie rozwoju

technologii (technology forecasting). Każda z tych metod z kolei sięga po rozmaite techniki, takie jak np. technika delficka lub budowa scenariuszy. Granice każdej z tych metod

nie są wyraźnie określone. Metody te odpowiadają nieraz na podobne pytania i służą

podobnym celom, takim jak np. wkład w ustalenie >priorytetów w nauce i technice.

Zasadą we współczesnej analizie politycznej jest stosowanie „pakietu” różnych metod.

Zdaniem Ruuda Smitha czterema kanonami współczesnej analizy są partycypacja (oparta na założeniu, że nikt, nawet eksperci, nie są posiadaczami „jedynej prawdy”, a włączanie różnych interesariuszy zwiększa szanse sukcesu poznawczego i realizacyjnego metody), mediacja (poznawanie różnych punktów widzenia i wzajemne uczenie się ułatwia

znalezienie konsensusu), obiektywizacja (ograniczenie subiektywizmu przez uwzględ7

nianie statystyk i analiz) oraz wspieranie decyzji (analiza wspiera nie tylko podejmowanie, ale także realizację decyzji) [Smith 2001].

W miarę zacieśniania więzi pomiędzy państwami, analiza polityki nabiera coraz bardziej

międzynarodowego charakteru (OECD, EU).

Koncepcja analizy polityki Giandomenico Majone. Najważniejsze składniki analizy

politycznej to dane, informacje, dowody, argumenty i wnioski.

Składnik analityczny

Kryteria adekwatności

Dane

Rzetelność, odtwarzalność, wiarygodność

Informacje

Związek z zagadnieniem, wystarczalność, odpowiedniość, solidność

Dowody

Rzetelność, dopuszczalność, siła

Argument

Trafność, siła przekonywania, przejrzystość

Wniosek

Wiarygodność, wykonalność, dopuszczalność

„Analiza zwykle zaczyna się od czegoś mniej zorganizowanego niż problem, mianowicie

od sytuacji problemowej. Jest to świadomość, że powinno być inaczej, ale bez jasnego

wyobrażenia o działaniach naprawczych. Przedstawienie problemu jest procesem przełożenia sytuacji problemowej na faktyczny problem polityki, określający cele, które mają

być osiągnięte, oraz strategię ich realizacji.

Ilość szczegółowych informacji, które przydają się na etapie określania problemu, jest

inna niż w przypadku poszukiwania rozwiązań przy danym sformułowaniu. Właściwe

sposoby analizy będą się odpowiednio różnić w tych dwóch sytuacjach. Ze względu na

niezorganizowany charakter sytuacji problemowej wyobraźnia, oceny sytuacji oraz myślenie poprzez analogie s skojarzenia odgrywają w określeniu problemu większą rolę niż

dyscyplina i umiejętności techniczne”.

„Dane są (…) surowcem niezbędnym do zbadania problemu lub być może wynikiem

pierwszej obróbki takich surowców. W analizie polityki dane często się „znajduje”, a nie

„wytwarza”: to znaczy, że uzyskuje się je poprzez nieplanowane obserwacje (jak w przypadku szeregów czasowych), a nie na podstawie zaplanowanych eksperymentów. Ten

fakt (…) wymaga umiejętności rzemieślniczych innych i pod wieloma względami trudniejszych do zdobycia niż te, które są potrzebne do analizy danych doświadczalnych. (…)

dane są zwykle zbierane według kategorii, które rzadko idealnie pasują do celów konkretnej analizy.”

„Zanim dane zostaną użyte jako argument, trzeba im zwykle nadać bardziej użyteczną i

wiarygodną formę. To przekształcenie danych wymaga nowego zestawu umiejętności

rzemieślniczych, zastosowania nowych narzędzi (często o charakterze statystycznym

lub matematycznym) oraz dokonania nowych ocen. Tę nową fazę pracy analityka, wytwarzanie informacji, można zilustrować wieloma przykładami: obliczanie średnich oraz

innych wskaźników i parametrów statystycznych, dopasowanie krzywej do zbioru

8

punktów, redukcja danych za pomocą jakiejś statystycznej metody analizy wielu zmiennych.”

„Dowody nie są synonimem danych ani informacji. Są to informacje wyselekcjonowane z

dostępnego zbioru i wprowadzone w konkretnym punkcie argumentu, aby przekonać

określonych odbiorców o prawdziwości lub fałszywości pewnego stwierdzenia. Dobór

nieodpowiednich danych lub modeli, umieszczenie ich w niewłaściwym miejscu argumentu albo wybór stylu prezentacji, który nie pasuje do docelowych odbiorców, może

osłabić skuteczność informacji wykorzystywanych jako dowody, niezależnie od ich rzeczywistej wartości poznawczej. Dlatego kryteria oceny dowodów są inne niż kryteria

stosowane do ewaluacji faktów. Fakty można osądzać w kategoriach mniej lub bardziej

obiektywnych kanonów, lecz dowody muszą być oceniane stosowanie do wielu czynników właściwych danej sytuacji, takich jak swoisty charakter sprawy, rodzaj odbiorców,

panujące zasady przedstawiania dowodów lub wiarygodność analityka.”

„Wniosek analizy polityki może być prognozą, zleceniem, ewaluacją funkcjonujących

programów, nową propozycją lub innym spojrzeniem na stary problem. Niezależnie od

swojego charakteru, wniosek zależy zawsze od wielu założeń i wyborów metodologicznych. Inne określenie problemu, inne narzędzia i modele lub kilka odmiennych ocen sytuacji dokonanych w zasadniczych punktach argumentacji mogłyby doprowadzić do zupełnie różnych wniosków.”

„Narzędzia analizy polityki można z grubsza sklasyfikować według ich funkcji w określaniu problemu, w generowaniu danych i wykonywaniu na nich operacji, a także w interpretacji. Kategoria narzędzi pojęciowych i interpretacyjnych obejmuje takie dyscypliny, jak matematyka, ekonomia, nauki polityczne i behawioralne, które analityk musi

w pewnym stopniu opanować, aby być kompetentny w swojej pracy [Majone 2007].”

Por. też >RETORYKA POLITYKI, PROBLEM POLITYCZNY I JEGO DEFINIOWANIE.

Bibliografia

OECD Improving evaluation practices: best practice guidelines for evaluation and background paper, OECD

Working Papers, v. 7, no. 11, Paris 1999.

Daniël Tijink, http://www.deruijter.net/ocv.htm

Alexander Tübke, Executive Summary, w: Strategic Policy Intelligence: Current Trends, the State of Play and

Perspectives, ed. by: Alexander Tübke, Ken Ducatel, James P. Gavigan, Pietro Moncada-Paternò-Castello,

IPTS 2001.

Ruud Smith, The New Role of Strategic Intelligence w: Strategic Policy Intelligence: Current Trends, the State

of Play and Perspectives, ed. by: Alexander Tübke, Ken Ducatel, James P. Gavigan, Pietro Moncada-PaternòCastello, IPTS 2001

Robert Hoppe, Policy analysis, science and politics: from `speaking truth to power` to `making sense together`, “Science and Public Policy” vol. 26, nr 3, 1999.

Michael Oakeshott 1991. Rationalism in Politics and Other Essays. Indianapolis: Liberty Press

Wikipedia Policy analysis 2013.

Handbook of Public Policy Analysis. Theory, politics and methods. Ed. By Frank Fischer, Gerald Miller and

Mara S. Sidney, CRC Press, 2007.

9

Jac. L.A. Geurts, Cisca Joldersma, Methodology for participatory policy analysis, “European Journal of Operational Research” 128 2001 ss. 300-310.

William N. Dunn, Public policy analysis: An introduction, Prentice Hall 1994.

David L. Weimer, Aidan R. Vining, Policy Analysis. Concept and Practice, Prentice Hall 1998.

Carl. V. Patton, David S. Sawicki, Basic Methods of Policy Alaysis and Planning, Prentice Hall 1993.

Giandomenico Majone, Dowody, argumenty i perswazja w procesie politycznym, Wyd. Nauk. Scholar, Warszawa 2004.

BUDŻET NAUKI

Popularna nazwa określająca część 28 budżetu państwa W Polsce oraz wydatki na naukę zapisane w innych częściach budżetu. Ministerstwo Nauki i Szkolnictwa Wyższego

publikuje rokrocznie Sprawozdanie z realizacji zadań i budżetu w 2001 r. w zakresie Nauki oraz realizacji budżetu w części 28 – Nauka. Sprawozdanie obejmuje dochody i wydatki z działów: 730 – Nauka, 750 – Administracja publiczna, 752 – Obrona narodowa,

921 – Kultura i Ochrona Dziedzictwa Narodowego.

Sprawozdanie zawiera także tablice >budżetu zadaniowego.

BUDŻET ZADANIOWY

(Performance budget)

Budżet zadaniowy to „metoda zarządzania finansami publicznymi, ukierunkowana na

osiąganie większej skuteczności oraz efektywności i przejrzystości wydatkowania środków publicznych, polegająca na:

1. opracowywaniu budżetu państwa w oparciu o cele budżetu zadaniowego, zgodne

ze wskazaniami zawartymi w dokumentach strategicznych i programowych rządu, w ramach których to celów, umieszczane są - właściwe przedmiotowo tym celom - zadania, wraz z adekwatnymi miernikami informującymi o rezultatach/wynikach realizacji tych zadań - a także o rezultatach/wynikach realizacji

ich części składowych (a zarazem - o stopniu osiągania celów budżetowych zadań

w aspekcie skuteczności oraz efektywności),

2. monitorowaniu oraz ewaluacji poszczególnych zadań budżetu zadaniowego za

pomocą mierników, dzięki czemu wytwarzane są informacje efektywnościowe

(ang. performance information) służące podnoszeniu jakości alokacji w planowaniu budżetu w kolejnych latach/okresach planowania budżetowego,

3. praktycznym stosowaniu informacji efektywnościowych w procesie planowania

budżetu przez rząd, a także wykorzystaniu ich podczas prac parlamentarnych

nad uchwalaniem ustawy budżetowej (najczęściej jako tzw.: performanceinformed budgeting) [Wikipedia 2013]”

Polski odpowiednik ang. performance budget kładzie nacisk na inne elementy procesu

budżetowego, nie na wyniki i wykonawstwo, tylko na zadania.

Geneza. Rozrost sektora publicznego, zmiana struktury wydatków publicznych (np.

zwiększenie udziału „twardych” wydatków na służbę zdrowia, spowodowanych starzeniem się społeczeństw), zaniepokojenie wzrostem zadłużenia budżetowego oraz skut10

kami nierównowagi budżetowej wpłynęły na zmianę w podejściu rządów do wydatków

publicznych. W późnych latach 1970-tych i we wczesnych latach 1980-tych, po załamaniu się powojennej prosperity, zrozumiano potrzebę wprowadzenia nowego systemu

budżetu, który pozwalałby na lepsze równoważenie celów w stosunku do możliwości

finansowych rządów i lepiej łączyłby proces budżetowy z innymi funkcjami kierowniczymi.

Tradycyjny roczny budżet faworyzuje wydatki krótko-terminowe. Skłania do tego, by

brać pod uwagę wyłącznie skutki finansowe decyzji alokacyjnych. Środki przydziela nie

ze względu na wagę celów i zadań oraz nie ze względu na wnioski płynące z analizy politycznej i ewaluacji, tylko z punktu widzenia organizacji wykonawczych. Decyzje co do

podziału funduszy opierają się nie na np. ocenie krańcowej użyteczności (marginal utility) alternatywnych opcji ich wykorzystania, co na historycznych podziałach kwot oraz

na presji interesariuszy. Organizacje wykonawcze wywierają nieustanny nacisk na budżet, dyktowany bardziej potrzebą zwiększenia ich własnego znaczenia niż koniecznością realizacji ważnych zadań [OECD 1998]. Sama tylko konstrukcja budżetu wystarczy

np. do wytłumaczenia, dlaczego instytucje naukowe wyciągają stale ręce pod dodatkowe

środki. Dzieje się tak m.in. dlatego, że szansa stworzenia czegoś nowego zależy od nowych funduszy, gdyż budżet tradycyjny tylko z trudem znosi redystrybucję funduszy

rozdzielonych w przeszłości [Vessuri 2003]. Także sama tylko konstrukcja tradycyjnego

budżetu wyjaśnia, dlaczego w krajach słabiej rozwiniętych instrumenty polityczne (np.

stosowane dla rozwoju nauki) są z reguły proste, niezróżnicowane, statyczne oraz pasywne [Sagasti 1979]. Tworząc tradycyjny budżet zakłada się, że każdy dotychczasowy

wysiłek powinien być kontynuowany, a organizacja utrzymana (jeśli tylko formalnie pozostaje w zgodzie z przepisami księgowania). Gdy brakuje celów jako punktów odniesienia, nie sposób w praktyce proponować alternatywnych rozwiązań podziału środków. W takiej sytuacji zapisy budżetowe to z reguły repetycja rozwiązań przyjętych w

przeszłości. Kontrola realizacji konwencjonalnego budżetu ma wyłącznie formę audytu

księgowości. Jest to związane z faktem, że >agencje wykonawcze i sami wykonawcy nie

są w stanie odnieść swoich wydatków do żadnego celu. W tych warunkach, możliwa jest

tylko wąsko księgowo-prawnicza ocena wyników. Rząd nie jest zatem w stanie utrzymywać merytorycznej (a nie czysto formalnej) kontroli nad wydatkami. Sztywność budżetu w zderzeniu ze złożonymi i szybko zmieniającymi się problemami rodzi pokusę

tworzenia procedur koordynacyjnych oraz funduszy specjalnych. Jednak często systemy

koordynacji są zbyt słabe by oprzeć się naciskowi wykonawców, a fundusze specjalne

stwarzają szerokie pole do nadużyć oraz do niekontrolowanego wypływu pieniędzy budżetowych [UNESCO 1984].

Budżet zadaniowy a budżet tradycyjny. Tradycyjny proces budżetowy ukierunkowany na wkład (input-focused management and budgeting) kładzie nacisk na zasoby, personel, sprzęt i urządzenia. Wielkość funduszy to zazwyczaj główna miara wykonania. Nie

przeprowadza się ewaluacji wyników.

Jednak skoro ministerstwa i agencje rządowe mają wydawać środki dla osiągania celów,

należy wymagać od nich, aby opisały i określiły ilościowo, co chcą osiągnąć lub co osią11

gnęły za pieniądze podatnika. Budżetowy zadaniowy wprowadza zatem kontrolę wydatków, której elementami są:

Produkty (outcomes)

Wartość za pieniądze (value for

money)

Efekty (outputs)

Efektywność (effectiveness)

Proces (process)

Wydajność (efficiency)

Wkłady (inputs)

Koszty (costs)

Ekonomiczność (economy)

Źródło: Kristensen 2002.

W budżecie zadaniowym oblicza się, ile dostarczono usług lub wytworzono wyrobów.

Wyniki definiuje się jako dobra lub usługi (zazwyczaj te ostatnie), które agencje rządowe

dostarczają obywatelom, biznesowi lub innym agencjom rządowym. W budżecie zadaniowym określa się, co poszczególny program ma osiągnąć w kategoriach dobra publicznego, dobrobytu, lub bezpieczeństwa. Np. obniżyć śmiertelność wypadków drogowych o 20% w następnych 5 latach, zmniejszyć liczbę zachorowań na określoną chorobę

lub zapewnić większości studentów pewien poziom osiągnięć edukacyjnych w kolejnych

3 latach. Po zdefiniowaniu efektów rząd ocenia, czy programy, jakie wprowadził, zapewniają ich osiągnięcie [OECD 1998].

Uznaje się, że budżet zadaniowy stanowi dobrą platformę integracji planowania, zarzą-

dzania, monitoringu i ewaluacji (wraz z jednostkami odpowiedzialnymi za te funkcje).

Jego zaletą jest fakt, że uczy myśleć w ciągu: „pożądane rezultaty > konieczne wydatki,

aby je osiągnąć”, lub „uzyskane rezultaty > informacja, czy uzasadniają one kontynuowanie wydatków”, zamiast ciągu myślenia: „zasoby > rezultaty, które należy wyszukać,

aby uzasadnić wydatki”. Podejście to przesuwa nacisk z wielkości zużytych zasobów na

zakres i jakość osiągniętych krótko-i-długofalowych rezultatów. Łączy koszty z rezultatami programu. Dostarcza porównawczej oceny efektywności, skuteczności i sprawności

programów [Kristensen 2002].

Metody podejmowania decyzji budżetowych. W procesach decyzyjnych, dotyczących

np. projektu budżetu, ustaw lub programów rządowych, stosuje się wiele trybów podejmowania decyzji. Należą do nich np. metoda ekspercka (decyzję podejmują zaufani

eksperci, ministerialni lub kontraktowi), negocjacje (decyzję podejmują grupy interesariuszy), polityczna (politycy), benchmarking (decyzja oparta na wzorcowych praktykach), empiryczna (decyzja oparta na zastosowaniu metod analizy danych). W procesie

budżetowym stosuje się zwykle wszystkie opisane tu tryby, choć w różnych formach i

proporcjach. Do metod najważniejszych należą: ekonometryczne (kryteria określane jako stopień zysku, cost/benefit, ogólne koszty finansowe, itd.), metoda wielo-kryterialna

(bierze pod uwagę niewspółmierne kryteria i punkty widzenia), analiza kosztu i efektywności, symulacje i scenariusze, program budgeting, zero-base budgeting, relevance

graphs, badania rynkowe, badania prognostyczne itd. Negocjacje ważne są w pewnych

kulturach administracyjnych (jak np. w Niderlandach) i mniej ważne w innych. Konsensus uzgadniany jest pomiędzy różnymi interesariuszami, takimi jak obywatele, lokalne

społeczności, przemysł, ministerstwa itd. Każdy z trybów podejmowania decyzji wyróż12

nia inny typ osoby odpowiedzialnej za proces: metoda ekonometryczna – ekonomistę;

metoda wielo-kryterialna – analityka; negocjacje – mediatora, prawnika, negocjatora

[UNESCO 1984].

Ważnym środkiem pomocniczym w tworzeniu budżetu jest >analiza wpływu regulacji

(Regulatory Impact Analysis).

Poziomy decyzji budżetowych. Decyzje budżetowe podejmowane są na wielu poziomach. Zazwyczaj wyróżnia się następujące:

a. Ustalenie wielkości publicznych wydatków. (Poziom zagregowanych decyzji politycznych, aggregate policy-making).

b. Podział pomiędzy główne sektory, takie jak obrona, bezpieczeństwo publiczne,

edukacja, nauka, i inne. (Poziom podziału między-sektorowego).

c. Przydział zasobów do poszczególnych programów wewnątrz sektorów, np. edukacja pielęgniarek, szkolnictwo średnie, oraz uniwersytety, wewnątrz budżetu

edukacji. (Poziom między-sektorowej strategii politycznej).

d. Przydział zasobów do poszczególnych działań lub organizacji w ramach poszczególnego programu, np. przydzielenie większych funduszy uniwersytetowi X niż

uniwersytetowi Y, gdyż X ma lepsze wyniki w badaniach naukowych lub też szybciej wzrosła w nim liczba studentów w kierunkach uznawanych przez rząd z

priorytetowe. (Poziom zarządzania priorytetami programowymi).

e. Przydział pieniędzy wewnątrz poszczególnych instytucji lub typów działań (np.

gdy uniwersytet zdecyduje przesunąć zasoby z budżetu wynagrodzeń do budżetu

podróży).

Rzeczywisty proces budżetowy i finansowy nie zawsze aranżowany jest w tak prosty

sposób. Linia podziału pomiędzy tworzeniem (ustalaniem) budżetu a jego realizacją

przedstawia się różnie, w zależności od poziomu, na który się na to patrzy. Z punktu widzenia ministra, punkty d. i e. to nie tworzenie, lecz realizacja budżetu. Jednak z punktu

widzenia osób decydujących o podziale funduszy publicznych na tych szczeblach, to nadal tworzenie budżetu (dostępne zasoby są przydzielane pomiędzy konkurującymi ze

sobą celami) [OECD 1998]. Przejście z budżetu tradycyjnego na budżet oparty na wynikach angażuje wszystkie kolejne piętra jego tworzenia i realizacji. Tą drogą także ewaluacja „schodzi” ze szczebla rządowego na szczeble wykonawcze.

Próby integracji procesu budżetowego, audytu i ewaluacji. Jak dotąd jednak proces

budżetowy, audyt i ewaluacja rzadko tylko są w pełni zintegrowane. W przeszłości podejmowano wiele prób integracji projektowania budżetu, audytu i ewaluacji. Powiązania

te nie były jednak pełne lub nie zawsze kończyły się sukcesem. Za pierwszą próbę łączenia ewaluacji i procesu budżetowego uznaje się system PPBS (Planning-ProgrammingBudgeting) wprowadzony przez Roberta McNamarę w amerykańskim Departamencie

Obrony w początkach lat 1960-tych. PPBS miało być super-racjonalną teorią podejmowania decyzji, w której wybory będą opierane na systematycznej ilościowej analizie

[OECD 1993]. W Australii (proces budżetowy 1995/96) rezultaty ewaluacji wspierały

77% nowych propozycji politycznych i 65% propozycji dotyczących oszczędności. Proces łączenia procesu budżetu z ewaluacją był kierowany przez Ministerstwo Finansów

[OECD 1997].

13

Ocena budżetu zadaniowego. Mimo swej popularności, budżet zadaniowy nie został

wprowadzony we wszystkich krajach rozwiniętych. Kraje, które nadal stosują budżet

tradycyjny (np. Norwegia) osiągają cele stawiane przed budżetem zadaniowym za pomocą innych narzędzi, takich jak audyt, ewaluacje i planowanie.

Budżet zadaniowy lepiej nadaje się do zarządzania pewnych dziedzin (np. inwestycji

drogowych), a gorzej innych (np. inwestycji w badania podstawowe). Szczególne trudno

w jego ramach oceniać programy, które posiadają długi horyzont czasowy (np. odnowy

środowiska, rozwoju broni lub badań podstawowych) lub mają charakter chroniczny

(zmniejszenie przestępczości lub likwidacja ubóstwa). Często zdarza się, że sukces lub

porażka takiego programu zależą w mniejszym stopniu od podjętych działań, co od

przypadkowej koincydencji z warunkującymi je zjawiskami leżącymi poza zasięgiem interwencji publicznej (np. spadek przestępczości w mieście wskutek zmian demograficznych) [UNESCO 1998].

Bibliografia

H. Vessuri, Science, politics, and democratic participation in policy-making: a Latin American view, “Technology in Society”, Volume 25, Number 2 (2003), pp. 265-266.

Jens Kromann Kristensen, Walter S. Groszyk and Bernd Bühler, Outcome focused management and budgeting OECD 2002.

Jens Kromann Kristensen, Walter S. Groszyk and Bernd Bühler, Outcome focused management and budgeting OECD 2002

Katherine G. Willoughby and Julia E. Melkers, Performance Budgeting in the States, Internet.

OECD In Search Of Results: Performance Management Practices, Paris 1997, ss. 140.

OECD Integrating financial and performance management: a concept paper 1998

OECD Linking evaluation with budget, PUMA/SBO(97)7

OECD Using evaluation PUMA/SBO/RD(93)1

UNESCO Manual on the national budgeting of scientific and technological activities : integration of the "science and technology" function in the general State budget. Paris 1984.

CELE, ZADANIA I INSTRUMENTY POLITYKI

Cele i zadania polityki to „zamierzone infrastrukturowe, finansowe, instytucjonalne, społeczne, środowiskowe, lub inne rezultaty, do których polityka ma się przyczynić”, „opis

pożądanego stanu przyszłego systemu”. „Nie ma absolutnego kryterium rozróżnienia celów i zadań (...)” Cele wydają się być zdefiniowane jako oświadczenia, zwykle ogólne i

abstrakcyjne, o pożądanym stanie, ku któremu skierowana jest polityka, podczas gdy zadania to konkretne, zoperacjonalizowane oświadczenia o szczegółowych pożądanych rezultatach. Zadania, zintegrowane w ramach procesu planowania programu zapewniają

pomost między celami i etapem realizacji interwencji [Glossary 2002; Yolles; Preparing

2003].

Polityka jest, z definicji, zorientowana na cele. Zakres celów jest bardzo szeroki, od np.

poprawy umiejętności pracowników do np. zwiększenia liczby kobiet absolwentów w

szkołach technicznych (bardziej szczegółowe cele określa się często jako zadania). Cele

14

wyłaniają się z >AGENDY POLITYKI i są częścią >CYKLU POLITYKI. Są one kształtowane

przez interesy, poglądy, przekonania i modele koncepcyjnych osób uczestniczących w

>PROCESIE POLITYCZNYM. W ustalaniu celów dużą rolę odgrywa >ZALEŻNOŚĆ OD

SZLAKU.

W oparciu o cele wysokiego szczebla oraz uzasadnienia dla interwencji politycznej (zob.

>UZASADNIENIA DLA POLITYKI), formułuje się bardziej konkretne cele polityczne. Cele

mogą być bardzo zróżnicowane pod względem podmiotów, którymi się zajmują i rezultatów, jakie starają się osiągnąć. Cele różnią się również pod względem szczebla artykulacji - niektóre z nich są bardzo ogólne, np. zwiększenie działalności komercjalizacyjnej

uczelni, podczas gdy bardziej szczegółowe, np. powoływanie biur transferu technologii.

Rzeczą użyteczną jest budowa hierarchii celów.

Instrumenty polityki są zróżnicowane. Można je podzielić w różny sposób,

•

wg dominujących mechanizmów zastosowania, np. zachęty finansowe, regulacje i

informacje (czasami określane jako „marchew, kij i kazanie”),

•

•

wg grup docelowych celów, np. firm, uczelni itp.,

celów, które mają one dotyczyć.

Z reguły poszczególne kraje mają pełny zestaw instrumentów polityki naukowej i innowacyjnej, ale sposoby ich opracowania i wdrażania mogą być bardzo różne [IPP 2014].

Sukces polityki zależy od określenia jasnych celów. Jeśli istnieje ich wiele, muszą być ze

sobą zgodne. Muszą także być na tyle elastyczne, aby zmieniać się w miarę okoliczności.

Cele muszą:

• Opisywać obecną sytuację.

• Wskazać kierunki działań.

• Określać bariery w realizacji celów.

• Określić sposób rezultaty zostaną oceniane i zmierzone.

• Określać kroki konieczne dla osiągnięcia sukcesu [Slack].

Wzajemną zależność pomiędzy obszarami polityki, jej celami i środkami przedstawia

następująca tabela:

POLITYKA NAUKOWA I INNOWACYJNA

– OBSZARY, CELE , ŚRODKI I PRZYKŁADY

Obszar

Cel polityki

Środki

Przykłady z poszczególnych krajów

Zabezpieczanie

właściwych

warunków ramowych

Rozwijanie zasobów

ludzkich w B+R

Zachęcanie rynku do finansowania innowacji

Reformy edukacji na poziomie

wyższym

Wspieranie przez rządy i

przemysł edukacji zawodowej

Ustanowienie ram prawnych

dla kapitału ryzyka

Austria – kursy zawodowe

Finlandia – program

partnerstwa publiczno-prywatnego

Węgry – ustawa o kapitale ryzyka

Tworzenie kul-

Obniżenie asymetrii in-

Oparta na Internecie sieć in-

Kanada – Inicjatywa

15

tury

innowacyjnej

formacyjnej

Upowszechnienie najlepszych praktyk w zarządzaniu innowacjami

Wspieranie tworzenia

innowacyjnych firm

formacji biznesowych

Finansowanie dyfuzji narzędzi benchmarkingu i diagnostyki

Publiczne inwestycje w kapitał ryzyka

Strategiczna

Norwegia – program

BUNT

Hiszpania – program

MINER

USA – program SBIC

Pobudzanie

dyfuzji

technologii

Pobudzanie zdolności

absorpcyjnych firm

Ulepszenie powiązań

mię-dzy MSP i badaniami publicznymi

Współfinansowanie konsultantów dla podnoszenia poziomu kompetencji organizacyjnych firm

Współfinansowanie awansu

tech-nologicznego firm via

programy publiczno-prywatnego partnerstwa

Norwegia – program

BUNT

Hiszpania – Centra

CDTI

Wspieranie

tworzenia sieci

i klastrów

Pobudzanie tworzenia

kla-strów innowacyjnych firm

Zapewnianie lepszej

harmo-nizacji pomiędzy

infrastru-kturą N+T i

potrzebami przemysłu

Polityki zamówień i pośrednictwa

Współzawodnictwo pomiędzy

regionami o finansowanie inicjatyw klastrowych

Współfinansowanie ośrodków doskonałości dla wsparcia powiązań między uniwersytetami a przemysłem

Niderlandy – polityki

tworzenia klastrów

Niemcy – Inicjatywa

BioRegio

Szwecja – Program

Centrum Kompetencji

NUTEK

Francja – Réseaux Nationaux de la Reherche (RNS)

Wspieranie

B+R

Podtrzymywanie długofalo-wych szans technolo-gicznych

Wzrost wydatków rządowych

na badania podstawowe

Partnerstwo publiczno-prywatne

Australia – Program

CRC

Austria – Program CD

Społeczeństwo i Laboratoria

Odpowiedź na

globalizację

Wzrost powiązań między firmami o kapitale

krajowym i zagranicznym

Tworzenie sieci krajowych

konkurencyjnych firm technologicznych

Irlandia - Program

Narodowych Powiązań

Ulepszenie

tworzenia polityk

Wspieranie koordynacji

politycznej

Ulepszanie ewaluacji

polityk

Podnoszenie funkcji koordynacyjnych na najwyższy

szczebel polityczny

Korea – Narodowa

Rada Nauki i Technologii

Wielka Brytania –

ROAME

OECD, 1999.

Bibliografia

Brian Slack, The Policy Process.

Glossary of Key Terms in Evaluation and Results Based Management (OECD, 2002).

IPP, Innovation Policy Platform, Policy goals and means, 2014-01-13

J. S. Metcalfe, Science, Technology and Innovation Policy in Developing Economies, 2000. Paper prepared for

the workshop on Enterprise Competitiveness and Public Policies, Barbados 22nd – 25th November 1999.

16

Maurice Yolles, Organization as a Complex Systems: Social cybernetics and knowledge in theory and practice.

Michael Quinn Patton, Qualitative Research and Evaluation Methods. Sage Publications, California 1990.

OECD, Managing Innovation Systems: overview, 1999.

Preparing Program Objectives. Theory and Practice, prepared by Alex Iverson for the Evaluation Unit, The

International Development Research Centre, 2003, Toronto.

Slavo Radosevic, Strategic Technology Policy for Eastern Europe, "Economic Systems", Vol. 18, No. 2, June 1994.

CYKL POLITYKI

(Policy cycle)

W naukach politycznych cykl polityki to narzędzie stosowane w analizie rozwoju polityki. Najczęściej w ramach cyklu polityki wyróżnia się cztery fazy: ustalania >agendy polityki, >formułowania polityki, >wdrażania oraz >ewaluacji. W pierwszej fazie następuje

rozpoznanie kwestii wymagających uwagi rządu. W drugiej fazie kwestie te przekształca

się w >problemy polityczne, dokonuje się oceny możliwych opcji ich rozwiązania oraz

ustala ostateczny kształt >polityki, >programu lub >instrumentu polityki. W trzeciej fazie wprowadza się w życie podjęte decyzje. W fazie czwartej – ocenia efektywność polityki (polityk) w kategoriach zamierzeń i rezultatów [Nakamura 1987].

Narzędziami stosowanymi w czasie Cyklu Polityki są m.in. >Definiownie Problemu, >Logika Interwencji, >Analiza Polityki, >Ocena Wpływu (ex ante i ex post), >Monitoring, >Ewaluacja

Polityki (ex ante, mid-term i ex post).

Niektóre >agencje stosują sformalizowany zestaw Logiki Interwencji, Monitoringu, Ewaluacji i Oceny Wpływu, np. szwedzka Vinnova [Delanghe 2013].

Warren E. Walker [2003] proponuje podział cyklu na osiem faz:

1. Identyfikacja problemów

2. Określenie celów

3. (Wstępny) wybór środków

4. Identyfikacja alternatywnych polityk

5. „Badania przesiewowe” (screening) alternatywnych polityk oraz szczegółowa analiza

obiecujących polityk (ocena wpływu, impast assessment)

6. Wybór polityki

7. Wdrożenie wybranej polityki

8. Monitoring i ewaluacja rezultatów.

Fazy 4-6 zalicza się do >analizy polityki.

Australijski podręcznik polityki [Bridgman 2004] także proponuje podział na osiem faz:

1. Identyfikacja problemów

2. Analiza polityki

3. Rozwój instrumentu polityki

4. Konsultacje (które powinny przenikać przez cały >proces polityki)

17

5. Koordynacja

6. Decyzje

7. Wdrażanie

8. Ewaluacja

Perspektywa cyklu podkreśla zwrotność (pętlę) poszczególnymi cyklami polityki (ewaluacja jako wkład do budowy agendy), co prowadzi do ciągłego utrwalania procesu politycznego.

Podział procesu polityki na fazy zaproponował jako pierwszy Harold Laswell (1956). Cykl polityki jest idealizacją. Jednak pomimo swych ograniczeń, koncepcja cyklu polityki jest jedną z najczęściej stosowanych w naukach politycznych.

Zwraca się uwagę na dwa problemy związane z modelem cyklu polityki.

Po pierwsze, stwarza on wrażenie racjonalnego procesu składającego się z wyraźnie wyodrębnionych faz. Jednak proces polityczny rzadko ma jednoznaczny początek i koniec. Cechuje go stałe dostosowywanie się do zmieniających okoliczności. Agenda polityki to w rzeczywistości ciągła

działalność. Poszczególne etapy cyklu polityki zazębiają się ze sobą.

Po drugie, jest on wizją odgórnej realizacji polityki. Rzeczywista polityka coraz częściej łączy podejście odgórne z oddolnym.

Podkreśla się też, że w warunkach rzeczywistych polityki rzadko są przedmiotem całościowych

ewaluacji. Z reguły polityka jest stale monitorowana, kontrolowana i modyfikowana w trakcie jej

realizacji [OECD 2009].

Bibliografia

Robert T. Nakamura, The Textbook Policy Process And Implementation Research, “Review of Policy Research”, Vol. 7, Issue 1, pages 142–154, September 1987.

Bridgman and Glyn Davis, The Australian Policy Handbook, Allen & Unwin, 2004.

Handbook of Public Policy Analysis. Theory, politics and methods. Ed. By Frank Fischer, Gerald Miller and

Mara S. Sidney, CRC Press, 2007, ss. 43-53.

Warren E. Walker, The Use of Screening in Policy Analysis, Management Science, Vol. 32, No. 4. Apr., 1986,

ss. 389-402.

Henri Delanghe, Peter Teirlinck, Optimizing the Policy Mix by the Development of a Common Methodology

for the Assessment of (Socio-)Economic Impacts of RTDI Public Funding. Literature Review, December 2013.

OECD Country Reviews Of Innovation Policy, 2009.

DEBATA PUBLICZNA NAD PROBLEMAMI NAUKI I INNOWACJI W POLITYCE

[Public debate on science and innovation issues]

Debata publiczna nad problemami nauki i innowacji w polityce, to dyskusja połączona z

przedstawianiem przeciwstawnych punktów widzenia w sprawach istotnych dla interesu publicznego, prowadzona w mediach komercyjnych i społecznych, angażująca naukowców, decydentów, dziennikarzy, czasem także obywateli. Debata odbywa się bądź

wewnątrz środowiska akademickiego lub politycznego, bądź też ma charakter ogólnokrajowy i angażuje szerszą opinię publiczną.

18

Jeśli chodzi o debatę publiczną na temat nauki i innowacji, można wyróżnić trzy poziomy:

• narodowy (ogólnopolskie gazety, telewizja i radio);

• debaty naukowców (np. w miesięczniku "Forum Akademickie", czytanym przez menedżerów, decydentów i administratorów nauki, kilka tysięcy czytelników);

• debaty ekspertów i zainteresowanych stron (np. w kwartalniku "Nauki i Szkolnictwa

Wyższego" lub w trakcie Kongresów Instytutu Gospodarką Rynkową), kilkuset czytelników i uczestników.

W krajach EU oraz krajach stowarzyszonych przeprowadzono w ostatnich latach ok. 150

debat publicznych nt. zagadnień nauki i innowacji w polityce. Pięć najważniejszych grup

tematycznych to:

•

•

•

•

•

•

•

Zmiana klimatu, polityka energetyczna i ochrona środowiska, związana z rolą nauki

w redukcji emisji CO2, a także (w mniejszym stopniu) sprawy zrównoważonego

rozwoju (różnorodności biologicznej, gospodarki odpadami i recyklingu, zanieczyszczenia wody i powietrza).

Reforma szkół wyższych, nowe ustawy, fuzje uczelni, koncentracja wysiłków w szkołach wyższych na obszarach strategicznych, w szczególności sprawa wiązania strategii uczelni z potrzebami społecznymi.

Krajowe strategie B+R, sposób ustalania krajowych celów i priorytetów.

Gospodarka oparta na wiedzy, ze szczególnym uwzględnieniem roli nauki w rozwoju gospodarczym oraz rozpoznania i wzmocnienia krajowych przewag konkurencyjnych na rynkach

międzynarodowych.

Dyskusje dotyczące technologii, w szczególności biotechnologii, ale także nanotechnologii oraz technologii związanych ze zdrowiem i bezpieczeństwem.

Autonomia uniwersytecka, zawód nauczyciela akademickiego.

Finansowanie publicznego sektora nauki, ewaluacja badań [MASIS 2010].

W Polsce następujące kwestie związane z nauką i innowacjami były w ostatnich latach

przedmiotem ogólnokrajowych debat:

•

•

•

•

In vitro jako metody leczenia niepłodności (głównie w kontekście społecznym i religijnym). Czy in vitro powinno być dozwolone czy zabronione? Jeśli dozwolone, w jakim zakresie i na jakich warunkach?

Zmiany klimatu (głównie w kontekście skutków propozycji Komisji Europejskiej dotyczących bilansu energetycznego). Czy nowe wymagania unijne mogą spowolnić

wzrost gospodarczy Polski i czy Polska może uzyskać ich czasowe odroczenie?

Strategia innowacji. Czy w Polsce jako kraju goniącym europejską czołówkę instrumenty polityki innowacyjnej przejęte z krajów rozwiniętych są skuteczne? Jak podnosić świadomość znaczenia innowacji wśród przedsiębiorców?

Nowa reforma nauki i szkolnictwa wyższego (od 2008 r.), a w szczególności

o Koncepcja "flagowych" uniwersytetów badawczych (Krajowe Naukowe

Ośrodki Wiodące). Czy KNOW poprawi jakość polskiej nauki?

19

o Nowy model uczelni, ich autonomii i kontroli rządowej, relacje między

szkołami publicznymi i prywatnymi, opłaty za studia. Jak pogodzić odgórną reformę z zachowaniem tradycyjnej autonomii akademickiej?

o Nowy model kariery akademickiej, a zwłaszcza przyszłość habilitacji. Jak

poprawić i usprawnić przebieg studiów bez utraty mechanizmów kontroli

jakości?

Bibliografia

MASIS Final synthesis report 2012.

MASIS, Niels Mejlgaard, Tine Ravn, Lise Degn, Common Issues and Research Priorities, Preliminary report,

December 2010.

MASIS, National Report, Poland, October 2011.

DYLEMATY POLITYKI NAUKOWEJ I INNOWACYJNEJ

Przed polityką staje m.in. zadanie określenia strategicznych celów nauki i techniki.

•

W jakiej mierze nauka i technika winny służyć celom czysto ekonomicznym, a w jakim

powinny one budować tożsamość narodową i prestiż kultury narodowej w świecie?

•

W jakich dziedzinach kraj powinien znaleźć się na (światowym) froncie badawczym? W

jakim zakresie powinien przejmować i wykorzystywać dokonane za granicą odkrycia i

wynalazki?

•

Do jakiego stopnia powinien wspierać adaptację stworzonych i wyprodukowanych za

granicą urządzeń, maszyn i technologii?

•

Jak określić społecznie optymalny poziom inwestycji w B+R?

•

Jak dokonać społecznie optymalnego podziału pieniędzy na B+R spośród różnych opcji?

•

Co zrobić, aby szczupłe środki na B+R były wydajnie wykorzystywane?

•

Jak uniknąć dublowania badań bez gaszenia konkurencji i tworzenia monopoli?

•

Jak wynagradzać innowatorów pobudzając jednocześnie dyfuzję innowacji (np. patenty

wynagradzając wynalazców często hamują upowszechnianie wynalazków).

Łatwiej odpowiedzieć na te pytania „w zasadzie”, niż w praktyce.

Problem zasad finansowania B+R zogniskowany jest wokół pytania, jaki poziom oraz

ukierunkowanie tematyczne i geograficzne B+R finansowanych ze źródeł publicznych

byłyby optymalne z punktu widzenia zapewnienia maksymalnego zwrotu (ekonomicznego i społecznego). Rozstrzygnięcie tego problemu jest trudne i wymaga uwzględnienia

wielu dylematów związanych z ekonomicznym aspektem prowadzenia działalności B+R.

Np. konfliktu interesu pomiędzy wynalazcą a społeczeństwem: wynalazcy zależy na wynagrodzeniu za wynalazek, społeczeństwie na jego upowszechnieniu.

Trudność rozstrzygnięcia problemu optymalnego poziomu finansowania B+R wynika z

samego charakteru B+R. B+R jest kosztowne. Co gorsza, często jego koszty nie mają końca (nigdy dokładnie nie wiadomo, jak wiele czasu zabierze odkrycie tego, czego się szu20

ka) oraz są jak studnia bez dna (jeśli nie znalazło się tego, czego się szukało, nie ma wielu szans na odzyskanie zainwestowanych pieniędzy). B+R z reguły jest ryzykowne, gdyż

(pomijając jego bardziej rutynową część, bliską pomiarom i testowaniu) leży ono w sferze niepewności: niepewności badawczej, technologicznej, rynkowej, niepewności co do

rezultatu pojedynku z konkurencją, czy też niepewności co do tego, czy uda się ochronić

własność intelektualną uzyskaną dzięki badaniom. Wszystko to czyni B+R działalnością,

która niezwykle trudno ocenić. To z kolei powoduje, że niełatwo znaleźć inwestora

chętnego do podjęcia ryzyka inwestycji.

Ale B+R nie tylko trudno finansować, ale także trudno nim zarządzać. Działalność innowacyjna to zajęcie dla wielu różnych grup ekspertów: naukowców, projektantów, specjalistów od marketingu, inżynierów produkcji, dostawców, klientów, szkoleniowców.

Skuteczna koordynacja jest konieczna, ale trudna i kosztowna. Do tego dochodzą jeszcze

trudności z komórkami B+R w przedsiębiorstwach (określenie właściwych zadań, ustalenie kontraktów, monitoring prac).

Jednym z kluczowych problemów zarówno finansowania, jak i zarządzania B+R są trudności transakcji spowodowane asymetrią informacji. Asymetria informacji to sytuacja,

gdy jedna ze stron transakcji wie więcej od innej. Badacz wie zwykle więcej o rzeczywistych technicznych i rynkowych perspektywach B+R niż bankier, a menedżer – od kierownictwa przedsiębiorstwa. W jaki sposób bankier lub też dyrektor firmy mieliby lepiej

wiedzieć od badacza, czy pieniądze na B+R są wykorzystywane z pożytkiem dla przedsiębiorstwa, czy też dla pomnożenia sławy naukowej? Ocena zewnętrzna jest możliwa,

ale wymaga monitoringu i negocjacji.

Nieraz trudno wyciągnąć korzyści nawet z inwestycji zakończonych sukcesem. Nie tylko

z powodu problemów związanych z ochroną własności intelektualnej (jak zabezpieczyć

produkt przed łatwym skopiowaniem i uzyskać za niego zysk przekraczający koszty

wprowadzenia go na rynek), ale i z tego powodu, że często przedsiębiorstwom brakuje

aktywów uzupełniających, takich jak umiejętności produkcyjne lub nawet marketingowe.

Każda państwowa polityka N+T oraz indywidualne strategie przedsiębiorstw muszą

brać pod uwagę i rozstrzygać zarysowane tu dylematy, m.in. dylemat zabezpieczenia i

upowszechnienia wynalazku, dylemat niepewności i ryzyka, dylemat asymetrii informacji, dylemat zarządzania i koordynacji [Strahlcyde], nie mówiąc już o takich dylematach,

jak

•

Zasad podziału funduszy pomiędzy różnymi, często nieporównywalnymi dyscyplinami

(np. biologią molekularną a fizyką wysokich energii), a zwłaszcza pomiędzy różnymi gałęziami dyscyplin, a także pomiędzy różnymi sektorami nauki (instytuty państwowe,

uczelnie i przemysł)?

•

Ustalenia odpowiednich proporcji pomiędzy finansowaniem badań podstawowych i

stosowanych oraz prac rozwojowych, a dokładniej, badań, które rozwija się nie dla

określonego zleceniodawcy, tylko w celach czysto poznawczych, badań które uprawia

się dla ściśle określonego celu gospodarczego oraz badań które rozwija się nie dla bezpośredniego celu gospodarczego, tylko dla "ulepszenia jakości życia społeczeństwa"

21

(wskutek czego nie mogą one być finansowane przez gospodarkę). Doświadczenie pokazuje, że takie kraje, jak Szwecja, które zaniedbały budżetowego finansowania badań

podstawowych, zapłaciły za to słono w następnych dziesięcioleciach; uprawa ich działa

bowiem ożywczo na rozwój nauk stosowanych [OECD 1992].

•

Dylematu: wspierać rozwój czy zastosowania technologii; wspierać technikę jako wiedzę, jako umiejętności czy jako urządzenia; wspierać B+R, usługi naukowo-techniczne

czy uczenie się; rozwój technologii w kraju czy międzynarodowy [Metcalfe 1995].

•

Swobody i kierowania: w jakiej mierze w nauce powinna nadal obowiązywać tradycyjna europejska idea wolności badań, a w jakiej nauka powinna być rządzona przez

priorytety i zadania, służące interesom społeczeństwa i gospodarki? Jaki zakres niezależności powinni mieć poszczególni uczestnicy systemu nauki i techniki? Jaką rolę powinno odgrywać planowanie?

•

Wszechstronnego rozwoju lub specjalizacji. Żaden kraj, nawet Stany Zjednoczone, nie

powinien rozwijać wszystkich dziedzin nauki i techniki; winien szukać "nisz badawczych", w których mógłby odnieść największe - z punktu widzenia nauki, techniki i gospodarki - sukcesy; obok (niewielu) priorytetów badawczych powinien ustalać posteriorytety, tj. listę pól lub dyscyplin nie zasługujących na wsparcie finansowe z budżetu

państwa [OECD 1992].

•

Wyboru jednego z dwóch podejść co do określania rozmiarów krajowego wysiłku B+R:

„podażowego” i „popytowego”. Wg pierwszego, powinno się utrzymywać sporą nadwyżkę badań nad aktualnymi potrzebami, biorąc pod uwagę możliwość wystąpienia nieoczekiwanych „fuzji”,. „przecięć”, „odprysków”, zmian trendów rozwojowych nauki i techniki itd.. Wg drugiego, zakres wysiłku powinien być (w zasadzie) dostosowany do aktualnych potrzeb. (W okresie komunistycznym rozmiary B+R wykraczały znacznie poza

potrzeby gospodarcze i społeczne. Jest zatem zdrowiej, gdy dopuści się obecnie do głosu

podejście „popytowe”) [Andreff 1997].

•

Określenia optymalnych relacji pomiędzy priorytetami ustalanymi na różnych szczeblach: a) poszczególnych uczonych oraz kierowników zespołów; b) dyscyplin lub regionów; c) rządu.

•

Określania optymalnych proporcji pomiędzy nakładami na prace badawczo-rozwojowe

oraz nakładami na obsługę nauki (tj. na transfer technologii, informację naukową i

techniczną, kształcenie naukowców i inżynierów i in.)

•

Określania optymalnych dla danego typu badań struktur organizacyjnych.

•

Ustalania najwłaściwszych proporcji między finansowaniem badań z budżetu nauki i

techniki oraz z budżetu innych resortów (zdrowia, edukacji i in.).

•

Określenia proporcji między bezpośrednimi (fundusze na działalność naukową i techniczną z budżetu państwa) a pośrednimi środkami polityki naukowej i technicznej (polityki: kredytowa, podatkowa, patentowa i licencyjna, zachęcające przemysł do finansowania prac badawczych i rozwojowych).

•

Ustalania proporcji między działaniami krótko-terminowymi a długofalowymi.

Kolejne dylematy dotyczą wyboru najlepszych rozwiązań instrumentów politycznych. Np. czy

proponowane instrumenty dotykają rzeczywistych potrzeb innowacyjnych firm? Jaka jest ich

22

efektywność mierzona stosunkiem kosztów do korzyści? Jakie są ich efekty i wpływ? Jak są one

koordynowane z pozostałą częścią systemu politycznego? [Nauwelaers 2002].

Żaden z dylematów nie jest łatwy do rozwiązania.

Istnieją rozmaite sposoby ich rozwiązywania. Jedne z nich polegają na takim rozgraniczeniu sfer, dzięki której z dwóch konfliktowych opcji każda obowiązywałaby na innym

poziomie albo obszarze. Np. dylemat swobody i sterowania w nauce rozwiązywany jest

w taki sposób, że kryteria decyzji o projektach badawczych opiera się na zasadach swobody (peer review), a kryteria decyzji o podziale pieniędzy dyscyplinami na priorytetach

rządowych.

Inny sposób rozwiązania, to twórcza fuzja obu opcji. Np.

•

dylemat „import technologii zagranicznych albo tworzenie ich w kraju” rozwiązywany

bywa przez tworzenie zachęt dla ulepszania zakupionych technologii zagranicznych (I

tak, Korea preferowała własne B+R, podczas gdy Irlandia, Singapur i Hong Kong ukierunkowały swoje polityki na wzrost działalności innowacyjnej podejmowanej przez

trans-narodowe korporacje. Jeszcze inne kraje po prostu pozostawiły sprawę upgradingu technologii siłom rynkowym) [UNIDO 2002/03];

•

dylemat wyboru formy procesu politycznego (analiza polityczna ekspertów albo negocjacje i konsultacje ze wszystkimi interesariuszami) rozwiązywany jest np. przez realizację foresight`u.

Kolejny sposób to znajdowanie nowej formuły instrumentu politycznego. Dylemat „czy

dla pobudzania rozwoju technologii stosować ulgi podatkowe, które stwarzają pokusę

nadużycia firm, czy też dotacje dla firm, które stwarzają pokusę nadużycia agencji rządowych” rozwiązywany jest coraz częściej przez dofinansowanie realizacji projektów

technologicznych konsorcjów opartych na partnerstwie publiczno-prywatnym, w którym każdy z udziałowców (np. uniwersytety, laboratoria rządowe i przedsiębiorstwa

prywatne) nie tylko dzieli się z pozostałymi kosztami, ryzykiem i (ewentualnymi) korzyściami, ale także ich kontroluje.

Jeszcze inny sposób to znalezienie „optymalnego punktu równowagi” (np. dla rozwiązania dylematu interesu wynalazcy i interesu społeczeństwa - takiej poprawy własności

intelektualnej, która nie blokowałaby dyfuzji innowacji oraz takiej dyfuzji, która zabezpieczałaby prawa innowatora; redukcji niepotrzebnego dublowania B+R z jednoczesnym zachowaniem pożądanego poziomu współzawodnictwa w B+R) [Strahlcyde].

Nieraz rozwiązanie dylematu zależy od osiągniętego poziomu gospodarczego. Np. dylemat czy finansować projekty badawcze i technologiczne stosunkowo tanie i mało ryzykowne (których efekty w sensie naukowym lub ekonomicznym będą miały ograniczoną

wartość), czy też projekty kosztowne i ryzykowne, ale obiecujące znaczną „wypłatę” w

wypadku wygranej, rozwiązywany jest w ten sposób, że w miarę wzrostu dobrobytu finansuje się coraz więcej projektów tej drugiej grupy.

Bez pewnej swobody w ustalaniu priorytetów na niższych szczeblach, priorytety wyższego szczebla nie spełnią swego zadania, np. bez puli badań i projektów badawczych

instytutów rolniczych trudno dokonać właściwego wyboru celów wielkich programów

23

badań rolniczych; bez zdobycia umiejętności naukowych i menedżerskich w realizacji

małych projektów, trudno kierować wielkimi programami, itd. [OECD 1992].

Nakreślone wyżej dylematy polityki N+T i innowacji nie są bynajmniej dane „raz na zawsze”; tajemnica pomyślnej polityki polega też nieraz na trafnym i szybkim odczytaniu

zmian otoczenia, które powodują konieczność modyfikacji pola sensownych wyborów, a

nawet zmianę kategorii pojęciowych stosowanych w podejmowaniu decyzji. Np. zwraca

się uwagę, że problem decydentów polega dziś nie tyle na wyborze pomiędzy badaniami

podstawowymi a stosowanymi, ale m.in. na formułowaniu priorytetów w taki sposób,

aby podkreślały one bezpośrednie powiązanie pomiędzy badaniami podstawowymi i

przełomami teoretycznymi z jednej strony, a badaniami stosowanymi i pracami rozwojowymi z drugiej strony; aby służyły one mobilizacji dodatkowych zasobów finansowych, zarówno publicznych, jak i prywatnych, na rzecz badań podstawowych i stosowanych [Rodrigues 2003].

Różnice w rozwiązaniach dylematów mogą wynikać z takich zmiennych jak: wielkość

rynku, położenie geograficzne, zasoby naturalne, zewnętrzne presje, historia, początkowa, baza kompetencji, itd.

Bibliografia

C. Nauwelaers, and R. Wintjes, Innovating SMEs and regions: the need for policy intelligence and interactive

policies, “Technology Analysis and Strategic Management”, (2002) 14 (2), 201-215.

Industrial Development Report 2002/2003. Competing through Innovation and Learning, UNIDO.

J.S. Metcalfe, Technology systems and technology policy in a evolutionary framework, “Cambridge Journal of

Economics” 1995, 19, s. 25-46.

Maria João Rodrigues, European Policies for a Knowledge Economy, Edward Elgar, 2003.

Public Funding Of R&D: Emerging Policy Issues 13-14 March 2001.

Reviews of National Science and Technology Policy: Czech and Slovak Republic, OECD 1992.

Reviews of National Science and Technology Policy: Czech and Slovak Republic, OECD 1992.

University of Strathclyde Business School, http://www.economics.strath.ac.uk/Teaching/3rd_Year/

31_341_ Econ_Org_and_Econ_Perf/ PDF/341~prod.doc

Wladimir Andreff, wypowiedź na konferencji NATO „Institutional Transformation of S&T Systems and

S&T Policy in Economies in Transitions”, Budapeszt, 28-30 sierpnia 1997.

FORMUŁOWANIE POLITYKI

[Policy formulation]

Formułowanie polityki to druga faza >cyklu polityki, podczas której żądania, problemy i

propozycje zgłaszane zarówno z kręgu ministerstwa i/lub agencji wykonawczych

(urzędnicy, doradcy polityczni, analitycy polityki), jak i z zewnątrz ministerstwa (>sieci

polityki, media, badacze polityki, obywatele) są przekształcane w >polityki, >programy

oraz >instrumenty rządowe (cele, zadania, środki realizacji, mierniki wykonania, harmonogram). W fazie formułowania kwestie przeformułowuje się w >problemy polityczne oraz dokonuje się oceny możliwych opcji ich rozwiązania.

24

Od lat 1960. w fazie formułowania polityk administracje rządowe często korzystają z

pomocy >analizy polityki, >doradztwa na rzecz polityki, >badań na rzecz polityki,

wspomaganych przez różne techniki, takie jak analiza kosztów i korzyści, analiza systemowa, badania operacyjne i inne. W fazie formułowania opracowuje się często >logikę

interwencji oraz rozpatruje planowane działania w kontekście wcześniej wdrożonych i

planowanych (tzw. >mieszanka polityk).