Część I

Podstawy

11

Rozdział 1

Próbkowe odpowiedniki wielkości

populacyjnych

1.1

Rozkład empiryczny

Statystyka matematyczna opiera się na założeniu, że dane są wynikiem pewnego „doświadczenia losowego”. Przypuśćmy, że dane mają postać ciągu liczb x1 , x2 , . . . , xn . Zakładamy, że

mamy do czynienia ze zmiennymi losowymi X1 , X2 , . . . , Xn określonymi na przestrzeni probabilistycznej (Ω, F, P) i dane są realizacjami (wartościami) tych zmiennych losowych, czyli

x1 = X1 (ω), . . . , xn = Xn (ω) dla pewnego ω ∈ Ω. Nie znamy rozkładu prawdopodobieństwa

P na przestrzeni Ω, który „rządzi” zachowaniem zmiennych losowych i chcemy się dowiedzieć

czegoś o tym rozkładzie na podstawie obserwacji x1 , x2 , . . . , xn . Rozważmy najpierw prostą

sytuację, kiedy obserwacje są realizacjami niezależnych zmiennych losowych o jednakowym

rozkładzie.

1.1.1 DEFINICJA. Próbką z rozkładu prawdopodobieństwa o dystrybuancie F nazywamy

ciąg niezależnych zmiennych losowych X1 , X2 , . . . , Xn o jednakowym rozkładzie, P(Xi 6 x) =

F (x) dla i = 1, 2, . . . , n. Będziemy używali oznaczenia

X1 , X2 , . . . , Xn ∼iid F.

W powyższej definicji dystrybuanta jest tylko pewnym sposobem opisu rozkładu prawdopodobieństwa. Mówiąc na przykład o próbce z rozkładu normalnego, napiszemy X1 , . . . Xn ∼iid

N(µ, σ 2 ). Mówi się także, że X1 , X2 , . . . , Xn jest próbką z rozkładu fikcyjnej zmiennej losowej

X ∼ F.

Uwaga. W statystycznych badaniach reprezentacyjnych stosuje się różne schematy losowania z populacji skończonej. W Definicji 1.1.1 żądamy niezależności, zatem ta definicja nie

obejmuje próbki wylosowanej bez zwracania.

13

14

ROZDZIAŁ 1. PRÓBKOWE ODPOWIEDNIKI WIELKOŚCI POPULACYJNYCH

1.1.2 DEFINICJA. Niech X1 , X1 , . . . , Xn będzie próbką z rozkładu o dystrybuancie F .

Funkcję

n

1X

1(Xi 6 x)

F̂ (x) =

n i=1

nazywamy dystrybuantą empiryczną.

Gdy chcemy podkreślić, że próbka ma rozmiar n, to piszemy F̂n zamiast F̂ . Traktujemy F̂

jako „empiryczny odpowiednik” nieznanej dystrybuanty F .

1.1.3 Przykład (Waga noworodków). Powiedzmy, że wylosowano 114 noworodków1 w celu

poznania cech fizycznych dzieci urodzonych w Warszawie w roku 2009. Waga noworodków

była taka:

3080

3720

3280

2620

3310

3460

3200

3760

2900

3730

2470

2400

3650

3520

3960

3690

3770

3800

3530

3640

3750

3640

3620

2500

3250

3200

3300

3200

2580

3394

3330

2780

4010

3420

2740

2540

4000

3700

2490

3070

2700

3640

2680

2760

3230

4330

3800

3270

3180

3500

3260

4640

3740

2680

2700

3480

2570

3790

3440

3480

3790

3780

3760

2700

3490

3580

2420

3480

3120

3160

4140

3900

3600

3190

3760

3000

2500

2110

3340

3890

3620

3930

3760

3060

3180

3960

2900

2660

2930

3420

3070

3190

3950

3740

2850

3760

2800

4320

3600

3160

3330

3270

2380

2700

3200

3490

3670

3500

3450

3114

3012

2030

2750

3100

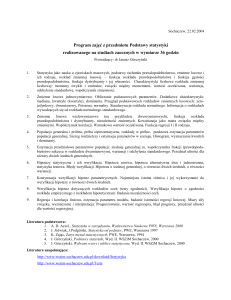

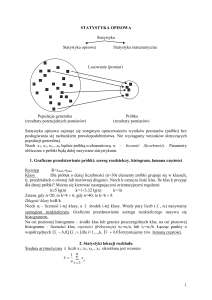

Dane traktujemy jako próbkę z rozkładu prawdopodobieństwa zmiennej losowej X = „waga

noworodka losowo wybranego z populacji”. Rysunek 1.1 przedstawia dystrybuantę empiryczną F̂ odpowiadającą tej próbce.

♦

Dystrybuanta empiryczna jest funkcją pary argumentów (x, ω), czyli F̂ : R × Ω → [0, 1],

ale wygodnie jest pomijać argument ω. Dla ustalonego ω ∈ Ω dystrybuanta

empiryczna

P

jest funkcją R → [0, 1], która argumentowi x przyporządkowuje liczbę

1(Xi (ω) 6 x)/n.

Dla ustalonego a ∈ R wartość dystrybuanty empirycznej jest zmienną losową, F̂ (a) : Ω →

[0, 1]. Ciąg indykatorów odpowiada schematowi Bernoulliego z prawdopodobieństwem sukcesu F (a) i dlatego zmienna losowa F̂ (a) ma następujący rozkład prawdopodobieństwa:

n

P(F̂ (a) = k/n) =

F (a)k (1 − F (a))n−k

(k = 0, 1, . . . , n).

k

1

W istocie, dane pochodzą z dwóch numerów „Gazety Wyborczej”, („Gazeta Stołeczna”, 29 sierpnia 2009

i 5 września 2009).

1.1. ROZKŁAD EMPIRYCZNY

15

1.0

noworodki

0.8

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

Fn(x)

0.6

●

●

●

●

●

0.4

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

0.2

●

●

●

0.0

●

●

●

●

●

●

●

●

●

2000

●

●

●

●

●

●

●

●

●

●

2500

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

3000

3500

4000

4500

x

Rysunek 1.1: Dystrybuanta empiryczna wagi noworodków. Dane z Przykładu 1.1.3.

16

ROZDZIAŁ 1. PRÓBKOWE ODPOWIEDNIKI WIELKOŚCI POPULACYJNYCH

1.1.4 DEFINICJA. Rozważmy próbkę X1 , X2 , . . . , Xn . Dla każdego ω ∈ Ω, niech X1:n (ω) 6

X2:n (ω) 6 · · · 6 Xn:n (ω) będzie ciągiem liczb X1 (ω), X2 (ω), . . . , Xn (ω) uporządkowanym w

kolejności rosnącej. Określone w ten sposób zmienne losowe X1:n , X2:n , . . . , Xn:n nazywamy

statystykami pozycyjnymi.

W szczególności, X1:n = min(X1 , . . . , Xn ) i Xn:n = max(X1 , . . . , Xn ); pierwsza i ostatnia

statystyka pozycyjna to, odpowiednio, najmniejsza i największa obserwacja w próbce.

Dystrybuanta empiryczna F̂ jest funkcją „schodkową”: jest stała na każdym z przedziałów

pomiędzy statystykami pozycyjnymi [Xi:n , Xi+1:n [. Widać, że

dla x < X1:n mamy F̂ (x) = 0;

dla Xi:n 6 x < Xi+1:n mamy F̂ (x) =

i

;

n

dla x > Xn:n mamy F̂ (x) = 1.

W punktach Xi:n funkcja F̂ ma nieciągłości (skacze w górę). Jeśli teoretyczna dystrybuanta

F jest ciągła, to P(X1:n < X2:n < · · · < Xn:n ) = 1, a więc, z prawdopodobieństwem 1, mamy

F̂ (Xi:n ) = i/n i każdy skok dystrybuanty empirycznej ma wielkość 1/n. Jeśli teoretyczna

dystrybuanta jest dyskretna, to z niezerowym prawdopodobieństwem niektóre statystyki

pozycyjne będą się pokrywać i dystrybuanta empiryczna będzie miała skoki wysokości 2/n

lub 3/n i tak dalej.

W poniższym stwierdzeniu będziemy mieli do czynienia z nieskończoną próbką, czyli z ciągiem zmiennych losowych X1 , X2 , . . . , Xn , . . ., które są niezależne i mają jednakowy rozkład

prawdopodobieństwa. Możemy sobie wyobrazić, że wciąż dodajemy do próbki nowe zmienne

losowe. Dystrybuanta empiryczna F̂n jest określona tak jak w Definicji 1.1.2, to znaczy,

zależy od początkowych zmiennych X1 , . . . , Xn . Rozpatrujemy teraz ciąg dystrybuant empirycznych F̂1 , F̂2 , . . . , F̂n , . . ..

1.1.5 Stwierdzenie. Jeśli X1 , . . . , Xn , . . . jest próbką z rozkładu o dystrybuancie F , to dla

każdego x ∈ R,

F̂n (x) →p.n. F (x), (n → ∞).

Dowód. Zmienne losowe 1(X1 6 x), . . . , 1(Xn 6 x), . . . są niezależne i mają jednakowy

rozkład prawdopodobieństwa: 1(Xn 6 x) przyjmuje wartość 1 z prawdopodobieństwem

F (x) lub wartość 0 z prawdopodobieństwem 1 − F (x). Oczywiście, E1(Xn 6 x) = F (x). Z

Mocnego Prawa Wielkich Liczb (MPWL) dla schematu Bernoulliego wynika, że zdarzenie

limn→∞ F̂n (x) = F (x) zachodzi z prawdopodobieństwem 1. To znaczy, że ciąg zmiennych

losowych F̂n (x) jest zbieżny prawie na pewno do liczby F (x).

Istnieje mocniejsza wersja poprzedniego stwierdzenia, którą przytoczymy bez dowodu. Można

pokazać, że zbieżność F̂ → F zachodzi jednostajnie z prawdopodobieństwem 1.

1.1. ROZKŁAD EMPIRYCZNY

17

0.8

0.6

Fn(x)

0.4

0.2

0.0

0.0

0.2

0.4

Fn(x)

0.6

0.8

1.0

n=25

1.0

n=10

−1

0

1

2

3

−3

−2

−1

0

x

x

n=100

n=500

1

2

3

1

2

3

0.8

0.6

Fn(x)

0.4

0.2

0.0

0.0

0.2

0.4

Fn(x)

0.6

0.8

1.0

−2

1.0

−3

−3

−2

−1

0

x

1

2

3

−3

−2

−1

0

x

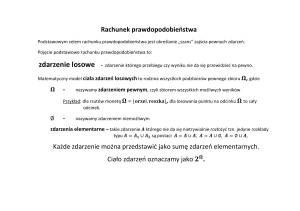

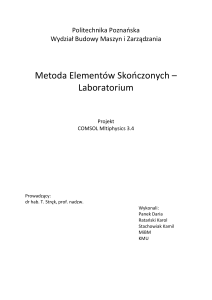

Rysunek 1.2: Zbieżność dystrybuant empirycznych do dystrybuanty.

18

ROZDZIAŁ 1. PRÓBKOWE ODPOWIEDNIKI WIELKOŚCI POPULACYJNYCH

1.1.6 TWIERDZENIE (Gliwienko-Cantelli). Jeżeli X1 , . . . , Xn , . . . jest próbką z rozkładu

o dystrybuancie F to

sup

|F̂n (x) − F (x)| →p.n. 0

(n → ∞).

−∞<x<∞

Jeśli mamy możliwość nieograniczonego powiększania próbki, to możemy poznać rozkład

prawdopodobieństwa z dowolną dokładnością.

Zamiast dowodu Twierdzenia Gliwienki-Cantelliego przytoczymy wyniki przykładowych symulacji komputerowych. Na Rysunku 1.2 widać dystrybuanty empiryczne F10 , F25 , F100

i F500 , dla próbki z rozkładu normalnego N(0, 1) – na tle teoretycznej dystrybuanty tego

rozkładu (ciągła, niebieska krzywa).

Skoncentrowaliśmy uwagę na dystrybuancie empirycznej, ale podobnie można zdefiniować

o empiryczny rozkład prawdopodobieństwa. Rozważmy zbiór borelowski B ⊆ R i próbkę

X1 , X2 , . . . , Xn z rozkładu zmiennej losowej X. Przybliżeniem nieznanej liczby P (B) =

P(X ∈ B) jest prawdopodobieństwo empiryczne

n

1X

1(Xi ∈ B).

P̂ (B) =

n i=1

Określone w ten sposób odwzorowanie P̂ : B × Ω → R, gdzie B oznacza rodzinę zbiorów borelowskich, nazywane jest empirycznym rozkładem prawdopodobieństwa. Dla

ustalonego ω ∈ Ω jest to dyskretny rozkład prawdopodobieństwa; jeśli wartości x1 =

X1 (ω), . . . , xn = Xn (ω) są różnymi liczbami to P̂ ({xi }) = 1/n dla i = 1, 2, . . . , n, czyli empiryczny rozkład prawdopodobieństwa jest rozkładem równomiernym na zbiorze {x1 , . . . , xn }.

Z drugiej strony P̂ (B) jest, dla ustalonego zbioru B, zmienną losową (a nie liczbą). Oczywiście, P̂ (] − ∞, x]) = F̂ (x).

1.1.7 Przykład (Statystyczna kontrola jakości). Producent chce się dowiedzieć, jaki procent

wytwarzanych przez niego wyrobów jest wadliwych. Sprawdza dokładnie pewną liczbę sztuk.

Powiedzmy, że badaniu poddano 50 sztuk i wyniki są takie (zakodujemy „wyrób prawidłowy”

jako liczbę „1” i „wadliwy” jako „0”):

1011111110111101111111111

1111110111111111011111111

Potraktujemy ten ciąg jako próbkę z pewnego rozkładu prawdopodobieństwa na zbiorze

dwupunktowym {prawidłowy, wadliwy} = {1, 0}. Producenta interesuje liczba

P (0) = P (wadliwy) = % sztuk wadliwych wśród wszystkich wyrobów.

1.2. MOMENTY I KWANTYLE Z PRÓBKI.

19

Na podstawie próbki możemy obliczyć prawdopodobieństwo empiryczne

P̂ (0) = P̂ (wadliwy) = % sztuk wadliwych wśród 50 zbadanych wyrobów

=

5

= 0.10.

50

Przykład jest trywialny. Chodzi tylko o to, żeby podkreślić różnicę między nieznaną, interesującą nas liczbą P (0) i znaną ale losową wielkością P̂ (0).

♦

1.2

Momenty i kwantyle z próbki.

Określimy teraz próbkowe odpowiedniki pewnych wielkości, związanych z rozkładem prawdopodobieństwa. Będziemy postępowali w podobnym duchu jak w definicji dystrybuanty

empirycznej. Cały czas X1 , . . . , Xn jest próbką. Średnią z próbki nazywamy zmienną

losową

n

1X

Xi .

X̄ =

n i=1

Widać, że X̄ jest wartością oczekiwaną rozkładu empirycznego. Podobnie, wariancja z

próbki

n

1X

2

S̃ =

(Xi − X̄)2

n i=1

jest niczym innym, jak wariancją rozkładu empirycznego. Wyższego rzędu momenty z

próbki (zwykłe i centralne) oznaczymy przez âk i m̂k :

n

1X k

X ,

âk =

n i=1 i

n

1X

m̂k =

(Xi − X̄)k .

n i=1

Są to odpowiedniki momentów, czyli

ak = EX k ,

mk = E(Xi − EX)k .

Wielkości ak i mk zależą od „prawdziwego”, teoretycznego rozkładu zmiennej losowej X,

podczas gdy âk i m̂k są obliczone dla rozkładu empirycznego. Oczywiście, â1 = X̄ i m̂2 = S̃ 2 ,

ale te dwa momenty spotykać będziemy tak często, że zasługują na specjalne oznaczenie.

Zauważmy jeszcze oczywisty związek m̂2 = â2 − â21 (Zadanie 1.4).

20

ROZDZIAŁ 1. PRÓBKOWE ODPOWIEDNIKI WIELKOŚCI POPULACYJNYCH

Kwantyle próbkowe określamy zgodnie z tym samym schematem. Po prostu zastępujemy

rozkład prawdopodobieństwa rozkładem empirycznym i obliczamy kwantyle. Przypomnijmy

najpierw definicję kwantyla. Niech 0 < q < 1. Jeśli P(X < ξq ) = F (ξq −) 6 q 6 F (ξq ) =

P(X 6 ξq ), to liczbę ξq nazywamy kwantylem rzędu q zmiennej losowej X. Taka liczba

zawsze istnieje, ale nie musi być wyznaczona jednoznacznie. Jeśli istnieje dokładnie jedna

liczba ξq taka, że P(X 6 ξq ) = F (ξq ) = q to oczywiście ξq jest q-tym kwantylem. Podobnie

jest w przypadku gdy F (ξq −) < q < F (ξq ). Jeśli jednak F (a) = F (b) = q, to każda z liczb z

przedziału [a, b] jest kwantylem.

Liczbę ξˆq nazywamy kwantylem empirycznym rzędu q, jeśli

F̂ (ξˆq −) 6 q 6 F̂ (ξˆq ).

Statystyka pozycyjna Xdnpe:n jest kwantylem empirycznym rzędu p ale niekoniecznie jedynym. Najlepiej widać to na przykładzie mediany (kwantyla rzędu q = 1/2). Jeśli rozmiar próbki n jest liczbą nieparzystą, to statystyka pozycyjna o numerze (n + 1)/2 jest

medianą z próbki. Jeśli rozmiar próbki jest liczbą parzystą, to każda z liczb z przedziału

[Xn/2:n , Xn/2+1,n ] jest medianą rozkładu empirycznego. W R i innych pakietach statystycznych, dla uniknięcia niejednoznaczności, zwykle podaje się środek przedziału median:

(Xn/2:n + Xn/2+1:n )/2. Przyjmiemy następujące oznaczenia na medianę i medianę z próbki:

med(X) = ξ1/2 ,

ˆ = med(X

ˆ

ˆ

med

1 , . . . , Xn ) = ξ1/2 .

Kwantyle rzędu 1/4 i 3/4 noszą nazwę kwartyli i bywają oznaczane Q1 i Q3

1.2.1 Przykład (Waga noworodków, kontynuacja). Dla naszej „niemowlęcej” próbki z Przykładu 1.1.3 mamy

X̄ = 3302.105,

S̃ = 502.5677

ˆ = 3330. Kwartyle próbkowe, zgodnie z naszą definiJak już zauważyliśmy poprzednio, med

cją, są równe Q1 = ξˆ1/4 = X29:114 = 2930 i Q3 = ξˆ3/4 = X86:114 = 3700 2 .

♦

Medianę, kwartyle, minimum i maksimum próbki przedstawia tak zwany „wykres pudełkowy”

(ang. Box and Whiskers Plot, Rysunek 1.3). Boki prostokąta (na tym rysunku boki pionowe)

odpowiadają kwartylom. Kreska wewnątrz prostokąta pokazuje medianę. „Wąsy” umieszcza

się (w zasadzie) w miejscu minimum i maksimum z próbki. Wykres pudełkowy pozwala na

graficzne porównanie kilku próbek. W tym przypadku na jednym obrazku widnieje kilka

pudełek, a ich „grubość” może być związana z licznościami poszczególnych próbek.

Na zakończenie naszych wstępnych rozważań wspomnimy o jeszcze jednym graficznym sposobie podsumowania danych. Na Rysunku 1.4 przedstawiony jest histogram danych z Przykładu 1.1.3. Wydaje się, że szczegółowe objaśnienia są zbędne, bo budowa histogramu jest

2

Określenie kwantyla próbkowego w pakietach statystycznych nieco różni się od naszego, ale nie ma to

zasadniczego znaczenia, szczególnie jeśli próbka jest duża. W naszym przykładzie R podaje następujące

wartości kwartyli: Q1 = ξˆ1/4 = 2947.5 i Q3 = ξˆ3/4 = 3697.5.

1.2. MOMENTY I KWANTYLE Z PRÓBKI.

21

noworodki

2000

2500

3000

3500

4000

4500

Rysunek 1.3: Wykres pudełkowy. Dane z Przykładu 1.1.3.

22

ROZDZIAŁ 1. PRÓBKOWE ODPOWIEDNIKI WIELKOŚCI POPULACYJNYCH

dość oczywista i dobrze znana czytelnikom prasy i telewidzom. Zwróćmy tylko uwagę na to,

że skala osi pionowej zastała tak dobrana, aby pole pod histogramem było równe 1, podobnie

jak pole pod wykresem gęstości prawdopodobieństwa. W istocie, histogram jest w pewnym

sensie empirycznym odpowiednikiem gęstości.

4e−04

2e−04

0e+00

Density

6e−04

Histogram of noworodki

2000

2500

3000

3500

4000

4500

noworodki

Rysunek 1.4: Histogram danych z Przykładu 1.1.3.

5000

1.3. ZADANIA

1.3

23

Zadania

1.1. Obliczyć EF̂ (x), Var F̂ (x).

1.2. Pokazać, że ciąg zmiennych losowych

Zidentyfikować parametry tego rozkładu.

√

n(F̂n (x) − F (x)) jest zbieżny do rozkładu normalnego.

1.3. Podać granicę limn→∞ P(F̂n (x) 6 F (x)) przy założeniu, że 0 < F (x) < 1. Dokładnie uzasadnić

odpowiedź.

1.4. Wyprowadzić alternatywny wzór na wariancję próbkową:

n

S̃ 2 =

1X 2

Xi − X̄ 2 .

n

i=1

1.5. Niech X1 , .P

. . , Xn będzie próbką z rozkładu normalnego N(µ, σ 2 ). Podać rozkład średniej

próbkowej X̄ =

Xi /n.

1.6. Obliczyć dystrybuantę i gęstość rozkładu zmiennej losowej Un:n = max(U1 , . . . , Un ), gdzie

U1 , . . . , Un jest próbką z rozkładu jednostajnego U(0, 1).

1.7. (Ciąg dalszy). Obliczyć EUn:n , gdzie Un:n oznacza ostatnią statystykę pozycyjną (maksimum

z próbki) z rozkładu jednostajnego U(0, 1).

1.8. (Ciąg dalszy). Obliczyć VarUn:n , gdzie Un:n oznacza maksimum z próbki z rozkładu jednostajnego U(0, 1).

1.9. (Ciąg dalszy). Zbadać zbieżność według rozkładu ciągu zmiennych losowych n(1 − Un:n ), gdzie

Un:n oznacza ostatnią statystykę pozycyjną (maksimum z próbki) z rozkładu jednostajnego U(0, 1).

1.10. Niech X1 , . . . , Xn będzie próbką z rozkładu wykładniczego Ex(λ). Obliczyć rozkład prawdopodobieństwa X1:n , pierwszej statystyki pozycyjnej (minimum z próbki). Podać dystrybuantę,

gęstość, nazwę tego rozkładu.

1.11. Rozważmy próbkę X1 , . . . , Xn z rozkładu o dystrybuancie F . Pokazać, że zmienna losowa

Xk:n (k-ta statystyka pozycyjna) ma dystrybuantę

P(Xk:n 6 x) =

n X

n

i=k

i

F (x)i (1 − F (x))n−i .

1.12. Załóżmy, że dystrybuanta F jest funkcją ciągłą i ściśle rosnącą, a zatem istnieje funkcja

odwrotna F −1 :]0, 1[→ R. Pokazać, że jeśli U ∼ U(0, 1) to zmienna losowa X = F −1 (U ) ma

dystrybuantę F .

1.13. (Ciąg dalszy). Niech Uk:n oznacza statystykę pozycyjną z rozkładu U(0, 1). Pokazać, że

Xk:n = F −1 (Uk:n ) ma rozkład taki jak statystyka pozycyjna z rozkładu o dystrybuancie F .

24

ROZDZIAŁ 1. PRÓBKOWE ODPOWIEDNIKI WIELKOŚCI POPULACYJNYCH

Rozdział 2

Modele statystyczne

2.1

Przestrzenie statystyczne

Zaczniemy od formalnej definicji, której sens postaramy się w dalszym ciągu wyjaśnić i

zilustrować przykładami.

2.1.1 DEFINICJA. Przestrzeń statystyczna jest to trójka (X , F, {Pθ ; θ ∈ Θ}), gdzie X

jest zbiorem, wyposażonym w σ-ciało F podzbiorów, zaś {Pθ ; θ ∈ Θ} jest rodziną rozkładów

prawdopodobieństwa na przestrzeni (X , F). Zbiór X nazywamy przestrzenią obserwacji zaś

Θ nazywamy przestrzenią parametrów.

Widoczny jest związek z definicją znaną z rachunku prawdopodobieństwa. Dla każdego ustalonego θ ∈ Θ, trójka (X , F, Pθ ) jest przestrzenią probabilistyczną. Najważniejszą nowością w

Definicji 2.1.1 jest to, że rozważamy rodzinę rozkładów prawdopodobieństwa, {Pθ ; θ ∈ Θ}.

Jak już powiedzieliśmy w poprzednim rozdziale, w statystyce matematycznej traktujemy

dane jako wynik doświadczenia losowego, ale nie wiemy, jaki rozkład „rządzi” badanym

zjawiskiem. Wobec tego rozpatrujemy rodzinę wszystkich branych pod uwagę rozkładów

prawdopodobieństwa. Zakładamy, że „prawdziwy” rozkład należy do tej rodziny, czyli jest

to rozkład Pθ0 dla pewnego θ0 ∈ Θ, tylko nie umiemy wskazać θ0 .

2.1.2 Uwaga (Kanoniczna przestrzeń próbkowa). Powiedzmy, że wynikiem obserwacji są

zmienne losowe X1 , . . . , Xn . Niech Ω będzie zbiorem wszystkich możliwych wyników doświadczenia losowego, a więc w naszym przypadku zbiorem ciągów ω = (x1 , . . . , xn ). Możemy

przyjąć, że zmienne losowe Xi są funkcjami określonymi na przestrzeni próbkowej Ω wzorem

Xi (ω) = xi . Wektor X = (X1 , . . . , Xn ) możemy traktować jako pojedynczą, wielowymiarową obserwację i napisać X(ω) = ω. Przy tej umowie, milcząco przyjętej w Definicji 2.1.1,

rozkład prawdopodobieństwa na przestrzeni Ω = X jest tym samym, co rozkład prawdopodobieństwa obserwacji: Pθ (B) = Pθ (X ∈ B), dla B ∈ F. Jest to, co należy podkreślić, łączny

rozkład wszystkich obserwowanych zmiennych losowych. Szczególny wybór przestrzeni Ω nie

ma zasadniczego znaczenia, jest po prostu wygodny.

25

26

ROZDZIAŁ 2. MODELE STATYSTYCZNE

2.1.3 Uwaga (Ciągłe i dyskretne przestrzenie obserwacji). Skupimy uwagę na dwóch typach

przestrzeni statystycznych, które najczęściej pojawiają się w zastosowaniach. Mówimy o modelu ciągłym, jeśli X jest borelowskim podzbiorem przestrzeni Rn , wyposażonym w σ-ciało

B zbiorów borelowskich i n-wymiarową miarę Lebesgue’a. Model nazywamy dyskretnym,

jeśli przestrzeń X jest skończona lub przeliczalna, wyposażona w σ-ciało 2X wszystkich podzbiorów i miarę liczącą.

Rozkład prawdopodobieństwa obserwacji X najczęściej opisujemy przez gęstość fθ na przestrzeni X , zależną od parametru θ ∈ Θ. W zależności od kontekstu, posługujemy się gęstością

względem odpowiedniej miary. W skrócie piszemy X ∼ fθ . Jeśli zmienna X ma skończony

lub przeliczalny zbiór wartości X , to

fθ (x) = Pθ (X = x).

(jest to gęstość względem miary liczącej). Dla jednowymiarowej zmiennej losowej X o absolutnie ciągłym rozkładzie, fθ jest „gęstością w zwykłym sensie”, czyli względem miary

Lebesgue’a. Mamy wówczas dla dowolnego przedziału [a, b],

Z

b

fθ (x)dx.

Pθ (a 6 X 6 b) =

a

Jeśli X = (X1 , . . . , Xn ) to rozumiemy, że fθ jest łączną gęstością prawdopodobieństwa na

przestrzeni X = Rn . Dla dowolnego zbioru borelowskiego B ⊆ Rn ,

Z

Z

Z

fθ (x)dx = · · · fθ (x1 , . . . , xn )dx1 · · · dxn .

Pθ (X ∈ B) =

B

B

W szczególnym przypadku, gdy zmienne X1 , . . . , Xn są niezależne i mają jednakowy rozkład,

pozwolimy sobie na odrobinę nieścisłości, oznaczając tym samym symbolem fθ jednowymiarową gęstość pojedynczej obserwacji i n-wymiarową gęstość całej próbki: fθ (x1 , . . . , xn ) =

fθ (x1 ) · · · fθ (xn ).

Jeśli T : X → R, to wartość średnią (oczekiwaną) zmiennej losowej T (X) obliczamy zgodnie

ze wzorem

R

w przypadku ciągłym;

X T (x)fθ (x)dx

Eθ T (X) =

P

w przypadku dyskretnym.

x∈X T (x)fθ (x)

R

Jeśli X ⊆ Rn , to całka X jest n-wymiarowa, dx = dx1 · · · dxn . Podobnie, będziemy używać

symboli Var θ , Covθ i podobnych.

Jeśli rodzina rozkładów prawdopodobieństwa {Pθ ; θ ∈ Θ} jest zdefiniowana przez podanie

rodziny gęstości {fθ ; θ ∈ Θ} względem pewnej (wspólnej dla wszystkich rozkładów) miary,

to mówimy, że przestrzeń statystyczna jest zdominowana. Nasze rozważania będą niemal

wyłącznie ograniczone do takich przestrzeni.

2.1. PRZESTRZENIE STATYSTYCZNE

27

Przejdziemy teraz do przykładów, które wyjaśnią sens (nieco abstrakcyjnej) Definicji 2.1.1.

2.1.4 Przykład (Statystyczna kontrola jakości, kontynuacja). Powróćmy do Przykładu

1.1.7. Przestrzenią obserwacji jest X = {0, 1}n . Obserwacje X1 , . . . , Xn są zmiennymi losowymi o łącznym rozkładzie prawdopodobieństwa

Pp (X1 = x1 , . . . , Xn = xn ) =

n

Y

pxi (1 − p)1−xi = pΣxi (1 − p)n−Σxi ,

i=1

P

Pn

gdzie xi ∈ {0, 1} dla i = 1, . . . , n i

xi oznacza

i=1 xi . Nieznanym parametrem jest

prawdopodobieństwo „sukcesu”, θ = p. Przestrzenią parametrów jest Θ = [0, 1].

♦

2.1.5 Przykład (Badanie reprezentacyjne). Powiedzmy, że populacja składa się z r jednostek. Przedmiotem badania jest nieznana liczba m jednostek „wyróżnionych”. Na przykład

może to być liczba „euroentuzjastów” w populacji wyborców albo liczba palących w populacji studentów. Interesują nas własności całej populacji, ale pełne badanie jest niemożliwe

lub zbyt kosztowne. Wybieramy losowo n jednostek spośród r i obserwujemy, ile jednostek

wyróżnionych znalazło się wśród wylosowanych. Załóżmy, że stosujemy schemat losowania

bez zwracania 1 . Najlepiej wyobrazić sobie losowe wybranie n kul z urny zawierającej r kul,

w tym m czerwonych i r − m białych. Liczby r i n są znane. Liczba X kul białych wśród

wylosowanych jest obserwacją. Zmienną losowa X ma tak zwany hipergeometryczny rozkład

prawdopodobieństwa:

, m r−m

r

Pm (X = x) =

,

x

n−x

n

zależny od parametru θ = m ze zbioru Θ = {0, 1, . . . , r}. Przestrzenią obserwacji jest zbiór

X = {0, 1, . . . , n}.

♦

Parametr θ jest „etykietką” identyfikującą rozkład prawdopodobieństwa. Nie zawsze θ jest

liczbą, może wektorem lub nawet funkcją.

2.1.6 Przykład (Model nieparametryczny). Zgodnie z Definicją 1.1.1, ciąg obserwowanych

zmiennych losowych X1 , . . . , Xn stanowi próbkę z rozkładu o dystrybuancie F , jeśli

PF (X1 6 x1 , . . . , Xn 6 xn ) = F (x1 ) · · · F (xn ).

Symbol PF przypomina, że dystrybuanta F jest nieznana i odgrywa rolę „nieskończenie wymiarowego parametru”. Przestrzenią parametrów jest zbiór wszystkich dystrybuant. Przestrzenią obserwacji jest X = Rn 2 .

♦

1

2

Próbka wylosowana w ten sposób nie jest próbką w sensie Definicji 1.1.1.

Jest to jedyny w tym skrypcie przykład przestrzeni statystycznej, która nie jest zdominowana.

28

ROZDZIAŁ 2. MODELE STATYSTYCZNE

2.1.7 Przykład (Wypadki). Liczba wypadków drogowych w ciągu tygodnia ma, w dobrym

przybliżeniu, rozkład Poissona. Niech X1 , . . . , Xn oznaczają liczby wypadków w kolejnych

tygodniach. Jeśli nic specjalnie się nie zmienia (pogoda jest podobna i nie zaczyna się właśnie

okres wakacyjny) to można przyjąć, że każda ze zmiennych Xi ma jednakowy rozkład. Mamy

wtedy próbkę z rozkładu Poissona, czyli

fθ (x1 , . . . , xn ) = Pθ (X1 = x1 , . . . , Xn = xn ) = e−θn

θΣxi

.

x1 ! · · · xn !

Przestrzenią obserwacji jest X = {0, 1, 2, . . .}n , a przestrzenią parametrów Θ =]0, ∞[. Wiemy,

że Eθ Xi = θ i Var θ Xi = θ.

♦

2.1.8 Przykład (Czas życia żarówek). Rozpatrzmy jeszcze jeden przykład z dziedziny statystycznej kontroli jakości. Producent bada partię n żarówek. Interesuje go czas życia, to

jest liczba godzin do przepalenia się żarówki. Załóżmy, że czasy życia X1 , . . . , Xn badanych

żarówek stanowią próbkę z rozkładu wykładniczego Ex(θ), czyli

fθ (x1 , . . . , xn ) =

n

Y

(θe−θxi ) = θn e−θΣxi .

i=1

Jest to typowe i dość realistyczne założenie. Mamy tutaj X = [0, ∞[n i Θ =]0, ∞[. Zauważmy, że Eθ Xi = 1/θ i Var θ Xi = 1/θ2 .

♦

2.1.9 Przykład (Pomiar z błędem losowym). Powtarzamy niezależnie n razy pomiar pewnej

wielkości fizycznej µ. Wyniki poszczególnych pomiarów X1 , . . . , Xn są zmiennymi losowymi

bo przyrząd pomiarowy jest niedoskonały. Najczęściej zakłada się, że każdy z pomiarów ma

jednakowy rozkład normalny N(µ, σ 2 ). Mamy zatem

n

1

1 X

2

fµ,σ (x1 , . . . , xn ) = √

(xi − µ) .

exp − 2

2σ

2πσ

Tutaj rolę parametru θ gra para liczb (µ, σ), gdzie −∞ < µ < ∞ i σ > 0. Przestrzenią

parametrów jest Θ = R×]0, ∞[. Oczywiście, przestrzenią obserwacji jest X = Rn . Wiemy,

że Eµ,σ Xi = µ i Var µ,σ Xi = σ 2 .

♦

2.2

Statystyki i rozkłady próbkowe

Rozpatrujemy, jak zwykle, przetrzeń statystyczną (X , F, {Pθ ; θ ∈ Θ}). Niech (T , A) będzie

przestrzenią mierzalną (znaczy to, że zbiór T jest wyposażony w σ-ciało podzbiorów A;

zazwyczaj będzie to podzbiór przestrzeni Rd z σ-ciałem borelowskim).

2.2. STATYSTYKI I ROZKŁADY PRÓBKOWE

29

2.2.1 DEFINICJA. Mierzalną funkcję T : X → T określoną na przestrzeni obserwacji X

nazywamy statystyką o wartościach w przestrzeni T .

W Definicji 2.2.1 istotne jest to, że statystyka jest wielkością obliczoną na podstawie danych

i nie zależy od nieznanego parametru θ. Będziemy w skrócie pisać T = T (X). Skupiamy

uwagę na przypadkach, kiedy przestrzeń T ma wymiar znacznie mniejszy niż X : staramy

się obliczyć taką statystykę T (X) która ma „streścić dane X”.

2.2.2 Przykład (Statystyki

Pn i inne zmienne losowe). W Przykładzie 2.1.4 (Statystyczna

kontrola jakości), S =

i=1 Xi , a więc liczba prawidłowych wyrobów w próbce jest statystyką. Oczywiście, S : {0, 1}n → {0, 1, . . . , n}. Statystyka S ma dwumianowy rozkład

prawdopodobieństwa:

n s

Pp (S = s) =

p (1 − p)n−s .

s

p

W skrócie napiszemy S ∼ Bin(n, p). Zmienna losowa (S − np)/ np(1 − p) nie jest statystyką, bo zależy od nieznanego parametru p. Ma w przybliżeniu normalny rozkład prawdopodobieństwa N(0, 1), jeśli n jest duże a p(1 − p) nie jest zbyt małe.

P

W Przykładzie 2.1.7 (Wypadki) sumaryczna liczba wypadków S = ni=1 Xi jest statystyką

i ma rozkład Poiss(nθ).

P

W Przykładzie 2.1.8 (Żarówki) średnia X̄ = (1/n) ni=1 Xi jest statystyką i ma rozkład

Gamma(n, nθ).

♦

Model normalny, wprowadzony w Przykładzie 2.1.9 zasługuje na więcej miejsca. Załóżmy,

że X1 , . . . , Xn jest próbką z rozkładu N(µ, σ 2 ). Ważną rolę w dalszych rozważaniach odgrywać

będą statystyki:

n

1X

Xi ,

X̄ =

n i=1

n

1 X

(Xi − X̄)2 ,

S =

n − 1 i=1

2

S=

√

S 2.

Zauważmy, że S 2 różni się od wariancji z próbki S̃ 2 , o której mówiliśmy w poprzednim

rozdziale: mnożnik 1/n zastąpiliśmy przez 1/(n − 1). Rozkład prawdopodobieństwa średniej

z próbki jest w modelu normalnym niezwykle prosty: X̄ ∼ N(µ, σ 2 /n). Zajmiemy się teraz

rozkładem statystyki S 2 .

Rozkład chi-kwadrat z k stopniami swobody jest to, z definicji, rozkład zmiennej losowej

Y =

k

X

Zi2 ,

i=1

gdzie Z1 , . . . , Zk są niezależnymi zmiennymi losowymi o rozkładzie N(0, 1). Będziemy pisali

symbolicznie Y ∼ χ2 (k).

30

ROZDZIAŁ 2. MODELE STATYSTYCZNE

Uwaga. Rozkłady chi-kwadrat są szczególnej postaci rozkładami Gamma, mianowicie χ2 (k) =

Gamma(k/2, 1/2) (Zadanie 2.5). Jeśli Y ∼ χ2 (k) to EY = k i VarY = 2k.

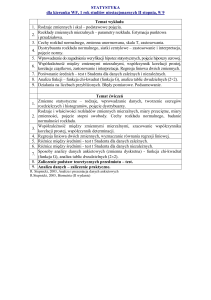

Wykresy gęstości kilku rozkładów χ2 są pokazane na Rysunku 2.1.

2.2.3 Stwierdzenie (Twierdzenie Fishera). W modelu normalnym, X̄ i S 2 są niezależnymi

zmiennymi losowymi,

X̄ ∼ N(µ, σ 2 /n);

n−1 2

S ∼ χ2 (n − 1).

2

σ

Pominiemy dowód, bo w Rozdziale 9 udowodnimy twierdzenie znacznie ogólniejsze. Niezależność zmiennych losowych X̄ i S 2 nie jest oczywista. Zauważmy też, że pojawia się rozkład

chi-kwadrat z n − 1 stopniami swobody, chociaż (n − 1)S 2 jest sumą n kwadratów zmiennych

normalnych.

2.2.4 Wniosek. Eµ,σ S 2 = σ 2 i Var µ,σ S 2 = 2σ 4 /(n − 1).

Rozkład t Studenta z k stopniami swobody jest to, z definicji, rozkład zmiennej losowej

Z

,

T =p

Y /k

gdzie Z i Y są niezależnymi zmiennymi losowymi, Z ∼ N(0, 1) i Y ∼ χ2 (k). Będziemy pisali

symbolicznie T ∼ t(k). Dwa rozkłady t oraz rozkład normalny są pokazane na Rysunku 2.2.

2.2.5 Wniosek. W modelu normalnym, zmienna losowa

√

n(X̄ − µ)/S ma rozkład t(n − 1).

Rozkład F Snedecora z k i m stopniami swobody jest to, z definicji, rozkład zmiennej

losowej

Y /k

,

R=

U/m

gdzie Y i U są niezależnymi zmiennymi losowymi, Y ∼ χ2 (k) i U ∼ χ2 (m). Będziemy pisali

symbolicznie R ∼ F(k, m).

2.2.6 Przykład (Model dwóch próbek). Załóżmy, że obserwujemy niezależne zmienne lo2

sowe X1 , . . . , Xn i Y1 , . . . , Ym , przy tym Xi ∼ N(µX , σX

) i Yj ∼ N(µY , σY2 ) dla i = 1, . . . , n

2

i j = 1, . . . , m. Statystyki X̄ i SX są określone tak jak poprzednio, dla próbki X1 , . . . , Xn .

Podobnie określamy statystyki Ȳ i SY2 , dla próbki Y1 , . . . , Ym . Z tego, co powiedzieliśmy

wcześniej wynika, że

2 2

SX

σY

∼ F(n − 1, m − 1).

2 2

SY σX

2 2

2

Zauważmy, że zmienna losowa SX

σY /(SY2 σX

) nie jest statystyką, bo zależy nie tylko od

2

obserwacji, ale i od nieznanych paramerów σX i σY . Jeśli założymy, że σX

= σY2 to statystyka

2

2

SX /SY ma rozkład F(n − 1, m − 1).

2.2. STATYSTYKI I ROZKŁADY PRÓBKOWE

31

chi2( 2 )

0.3

density

0.2

2

0

0.0

0.1

1

density

3

0.4

4

0.5

chi2( 1 )

0

2

4

6

χ

8

10

0

2

4

6

χ

2

10

chi2( 10 )

0.06

density

0.04

0.00

0.00

0.02

0.05

density

0.10

0.08

0.15

0.10

chi2( 5 )

8

2

0

5

10

χ

2

15

20

0

5

10

χ

15

20

2

Rysunek 2.1: Rozkłady χ2 dla różnej liczby stopni swobody.

32

ROZDZIAŁ 2. MODELE STATYSTYCZNE

0.4

t−Student

t(1)

0.1

0.2

N(0,1)

0.0

density

0.3

t(3)

−4

−2

0

2

4

t

Rysunek 2.2: Rozkłady t Studenta i rozkład normalny.

2.3. DOSTATECZNOŚĆ

33

2

Podobnie, jeśli σX

= σY2 = σ 2 to

X̄ − Ȳ − (µX − µY )

p

2

(k − 1)SX

+ (m − 1)SY2

r

km

(k + m − 2) ∼ t(k + m − 2).

k+m

♦

2.3

Dostateczność

Rozważmy przestrzeń statystyczną (X , F, {Pθ : θ ∈ Θ}) i statystykę T = T (X) o wartościach

w przestrzeni (T , A).

2.3.1 DEFINICJA. Statystykę T = T (X) nazywamy dostateczną, jeśli warunkowy rozkład prawdopodobieństwa obserwacji X przy danej wartości statystyki T = t nie zależy od

parametru θ, dla każdego t ∈ T .

Uwaga. W pewnym uproszczeniu, statystyka jest dostateczna, jeśli prawdopodobieństwo warunkowe

(*)

Pθ (X ∈ B|T (X) = t) nie zależy od θ,

dla dowolnego zbioru B ∈ F i (prawie) każdego t. Niestety, ścisłe sformułowanie Definicji

2.3.1 wymaga znajomości ogólnego pojęcia warunkowego rozkładu prawdopodobieństwa i

teorii miary. Zwróćmy uwagę, że określenie warunkowego rozkładu poprzez gęstość tutaj się

bezpośrednio nie stosuje, bo rozkład X przy danym T (X) = t jest zazwyczaj skupiony na

„podprzestrzeni o niższym wymiarze”, patrz Zadanie 2.15. Jeśli jednak X jest przestrzenią

dyskretną, to możemy się posłużyć elementarną definicją prawdopodobieństwa warunkowego.

W tym przypadku warunek (∗) redukuje się do tego, że

(**)

Pθ (X = x|T (X) = t) nie zależy od θ,

dla dowolnych t i x (to prawdopodobieństwo jest niezerowe tylko jeśli T (x) = t).

Sens Definicji 2.3.1 wyjaśni „doświadczenie myślowe”. Wyobraźmy sobie, że statystyk zaobserwował X = x, obliczył i zapisał T (x) = t, po czym. . . zgubił dane, czyli stracił x.

Może jednak wylosować „sztuczne dane” X 0 z rozkładu warunkowego obserwacji przy danym

T = t, ponieważ ten rozkład nie wymaga znajomości θ. Skoro sztuczne dane X 0 mają ten

sam rozkład prawdopodobieństwa co prawdziwe dane X, więc nasz statystyk nic nie stracił

zapisując t i zapominając x. Stąd właśnie nazwa: statystyka dostateczna zawiera całość

informacji o parametrze zawartych w obserwacji.

Załóżmy teraz, że przestrzeń statystyczną (X , F, {Pθ : θ ∈ Θ}) jest zdominowana (Uwaga

2.1.3), to znaczy rozkłady Pθ mają gęstości fθ . Zwykle są to albo gęstości względem miary

Lebesgue’a, albo „gęstości dyskretne” fθ (x) = Pθ (X = x).

34

ROZDZIAŁ 2. MODELE STATYSTYCZNE

2.3.2 TWIERDZENIE (Kryterum faktoryzacji). Statystyka T = T (X) jest dostateczna

wtedy i tylko wtedy gdy gęstości obserwacji można przedstawić w postaci

fθ (x) = gθ (T (x))h(x).

Dowód. Żeby uniknąć trudności technicznych, ograniczymy się tylko do przypadku dyskretnej przestrzeni X . Jeśli T (x) = t to

fθ (x)

0

x0 :T (x0 )=t fθ (x )

Pθ (X = x|T (X) = t) = P

i oczywiście Pθ (X = x|T (X) = t) = 0 jeśli T (x) 6= t. Jeżeli spełniony jest warunek faktoryzacji to natychmiast otrzymujemy, w przypadku T (x) = t,

h(x)

gθ (t)h(x)

P

=

.

0

0

x0 :T (x0 )=t gθ (t)h(x )

x0 :T (x0 )=t h(x )

Pθ (X = x|T (X) = t) = P

Odwrotnie, jeśli Pθ (X = x|T (X) = t) P

nie zależy od θ to własność faktoryzacji zachodzi dla

h(x) = Pθ (X = x|T (X) = t) i gθ (t) = x0 :T (x0 )=t fθ (x0 ).

2.3.3 Przykład (Ile jest kul w urnie?). Kule w urnie są ponumerowane: U = {1, 2, . . . , r}

ale r jest nieznane. Pobieramy próbkę n kul, bez zwracania. Niech S oznacza losowy zbiór

numerów a max(S) – największy spośród nich. Prawdopodobieństwo wylosowania zbioru

s ⊂ U jest równe

( 1 nr

jeśli r > max(s),

1(r > max(s))

=

Pr (S = s) =

r

0

jeśli r < max(s).

n

Stąd widać, że max(S) jest statystyką dostateczną. W czasie II wojny światowej alianci notowali seryjne numery zdobytych czołgów niemieckich w celu oszacowania liczby produkowanych przez nieprzyjaciela czołgów. Rozważany schemat urnowy jest uproszczonym modelem

takiej sytuacji.

♦

2.3.4 Przykład (Statystyki dostateczne w poprzednich

przykładach). W Przykładzie 2.1.4

Pn

(Schemat Bernoulliego), liczba sukcesów S = i=1 Xi jest statystyką dostateczną.

P

W Przykładzie 2.1.7 (model Poissona) suma obserwacji S = ni=1 Xi jest statystyką dostateczną.

P

W Przykładzie 2.1.8 (model wykładniczy) średnia X̄ = (1/n) ni=1 Xi jest statystyką dostateczną.

W Przykładzie 2.1.9 (model normalny z nieznanymi µ i σ) (X̄, S 2 ) jest dwuwymiarową

statystyką dostateczną.

♦

2.4. RODZINY WYKŁADNICZE

2.4

35

Rodziny wykładnicze

Tak jak poprzednio, rozważamy model statystyczny, a więc rodzinę rozkładów prawdopodobieństwa na przestrzeni obserwacji X .

2.4.1 DEFINICJA. Rodzina rozkładów prawdopodobieństwa {Pθ : θ ∈ Θ} jest rodziną

wykładniczą jeśli rozkłady Pθ mają, względem pewnej miary na X , gęstości fθ postaci:

X

k

fθ (x) = exp

Tj (x)ψj (θ) + ψ0 (θ) h(x), (θ ∈ Θ).

j=1

Podkreślmy, że w tej definicji wymagamy, żeby istniały gęstości względem jednej miary

wspólnej dla wszystkich θ. W większości zastosowań spotykamy, jak zwykle, albo gęstości

względem miary Lebesgue’a, albo „gęstości dyskretne” fθ (x) = Pθ (X = x). Bez straty

ogólności można zakładać, że funkcje T1 (x), . . . , Tk (x) są liniowo niezależne. To założenie

będze w dalszym ciągu obowiązywać. Zauważmy prostą konsekwencję Definicji 2.4.1. Zbiór

{x : fθ > 0}, który nazywamy nośnikiem rozkładu Pθ , 3 jest taki sam dla wszystkich θ.

2.4.2 Przykład. Rodzina rozkładów jednostajnych {U(0, θ) : θ > 0} nie jest rodziną wykładniczą. Ponieważ

1

fθ (x) = 1(0 6 x 6 θ),

θ

więc nośnikiem rozkładu U(0, θ) jest przedział [0, θ], który oczywiście zależy od θ.

♦

2.4.3 Przykład. Rodzina rozkładów wykładniczych {Ex(θ) : θ > 0} jest rodziną wykładniczą, bo gęstości możemy napisać w następującej postaci:

fθ (x) = θe−θx = exp(−θx + log θ).

Nośnikiem każdego rozkładu wykładniczego jest ten sam przedział [0, ∞[.

♦

2.4.4 Przykład. Rodzina rozkładów {Poiss(θ) : θ > 0} jest rodziną wykładniczą, bo

1

θx

fθ (x) = e−θ = exp − θ + x log θ

.

x!

x!

Oczywiście, każdy rozkład Poissona ma nośnik {0, 1, 2, . . .}.

♦

2.4.5 Przykład. Rodzina przesuniętych rozkładów Cauchy’ego o gęstościach

fθ (x) =

1

,

π(1 + (x − θ)2 )

2

θ ∈] − ∞, ∞[, nie jest rodziną wykładniczą, bo funkcja

Pk log fθ (x) = − log π − log(1 + (x − θ) )

nie da się przedstawić w postaci sumy iloczynów j=1 Tj (x)ψj (θ) + ψ0 (θ).

♦

3

Pozwalamy tu sobie na drobne uproszczenie, bo gęstość rozkładu prawdopodobieństwa jest wyznaczona

jednoznacznie tylko prawie wszędzie.

36

ROZDZIAŁ 2. MODELE STATYSTYCZNE

2.4.6 Przykład. Rodzina rozkładów {Gamma(α, λ) : α > 0, λ > 0} jest rodziną wykładniczą.

λα

λα α−1 −λx

x e

= exp − λx + (α − 1) log x + log

fα,λ (x) =

Γ(α)

Γ(α)

Oczywiście, wspólnym nośnikiem wszystkich rozkładów Gamma jest przedział ]0, ∞[.

♦

Inne przykłady rodzin wykładniczych to między innymi rodzina rozkładów normalnych

{N(µ, σ) : −∞ < µ < ∞, λ > 0}, rozkładów {Beta(α, β) : α, β > 0}, rodzina rozkładów

dwumianowych {Bin(n, θ) : 0 < θ < 1}, ujemnych dwumianowych i wiele innych. Przejdźmy

do omówienia kilku ciekawych własnosci rodzin wykładniczych.

2.4.7 Stwierdzenie. Jeżeli X1 , . . . , Xn ∼iid fθ jest próbką z rozkładu należącego do rodziny

wykładniczej, to k-wymiarowy wektor

!

n

n

X

X

T1 (Xi ), . . . ,

Tk (Xi )

i=1

i=1

jest statystyką dostateczną.

Dowód. Jeżeli fθ ma postać taką jak w Definicji 2.4.1, to łaczna gęstość wektora obserwacji

jest następująca:

X

n

k

Y

fθ (x1 , . . . , xn ) =

exp

Tj (xi )ψj (θ) + ψ0 (θ) h(xi )

i=1

= exp

j=1

X

k X

n

Y

n

Tj (xi )ψj (θ) + nψ0 (θ)

h(xi ).

j=1 i=1

i=1

Wystarczy teraz skorzystać z kryterium faktoryzacji (Twierdzenie 2.3.2).

Zwróćmy uwagę, że dla wymiar statystyki dostatecznej w powyższym stwierdzeniu jest równy

k, niezależnie od rozmiaru próbki n. Dla próbki z rodziny wykładniczej możliwa jest bardzo radykalna redukcja danych bez straty informacji. Zauważmy jeszcze, że k w Definicji

2.4.1 wydaje się być związane z wymiarem przestrzeni parametrów. W Przykładach 2.4.3 i

2.4.4 mieliśmy jednoparametrowe rodziny wykładnicze, w Przykładzie 2.4.6 – dwuparametrową rodzinę. Staje się to bardziej przejrzyste, jeśli posłużymy się tak zwaną naturalną

parametryzacją rodzin wykładniczych. Przyjmijmy wektor

ψ = (ψ1 , . . . , ψk ) = (ψ1 (θ), . . . , ψk (θ))

za nowy parametr, który identyfikuje rozkłady prawdopodobieństwa rozpatrywanej rodziny.

Nieco nadużywając oznaczeń możemy napisać

!

k

X

(2.4.8)

fψ (x) = exp

Tj (x)ψj − b(ψ) h(x),

j=1

2.4. RODZINY WYKŁADNICZE

37

gdzie

Z

b(ψ) = log

exp

X

k

X

!

Tj (x)ψj h(x)dx.

j=1

Jeśli istnieje wzajemnie jednoznaczna odpowiedniość pomiędzy „starym parametrem” θ ∈ Θ

i „nowym parametrem” ψ, to wybór jednej lub drugiej parametryzacji jest tylko kwestią

wygody.

2.4.9 Przykład. Rozkłady dwumianowe Bin(θ, n) mają gęstości postaci

n

n x

n−x

fθ (x) =

θ (1 − θ)

= exp x log θ + (n − x) log(1 − θ)

x

x

n

θ

+ n log(1 − θ)

.

= exp x log

x

1−θ

Naturalnym parametrem jest

ψ = log

θ

1−θ

zaś b(ψ) = n log(1 + eψ ). Zauważmy, że θ/(1 − θ) jest tak zwanym „ilorazem szans”: stosunkiem prawdopodobieństwa sukcesu do prawdopodobieństwa porażki. Funkcja Jeśli θ zmienia

się w przedziale ]0, 1[ to ψ przebiega przedział ]∞, ∞[. Naturalną przestrzenią parametrów

jest więc cała prosta rzeczywista.

♦

2.4.10 Uwaga. Mówimy, że rodzina wykładnicza jest regularna, jeśli przestrzeń naturalnych

parametrów {ψ(θ) : θ ∈ Θ}, traktowana jako podzbiór Rk , ma niepuste wnętrze. Ważną własnością regularnych rodzin wykładniczych jest dopuszczalność „różniczkowania pod znakiem

całki”. Jeśli U : X → R jest statystyką to

Z

Z

∂

∂

U (x)fψ (x)dx =

U (x)

fψ (x)dx,

∂ψj X

∂ψj

X

jeśli ψ jest punktem wewnętrznym naturalnej przestrzeni parametrów i całka po lewej stronie jest dobrze określona. Co więcej, podobna własność zachodzi dla pochodnych wyższych

rzędów. Oczywiście, jeśli funkcje ψj (θ) są odpowiednio gładkie, to możemy bezpiecznie „różniczkować pod znakiem całki” również względem θ. W następnym rozdziale takie operacje

rachunkowe będą odgrywały ważną rolę.

38

2.5

ROZDZIAŁ 2. MODELE STATYSTYCZNE

Zadania

2.1. Rozpatrzmy proces statystycznej kontroli jakości przyjmując te same założenia co w Przykładzie 2.1.4 z tą różnicą, że obserwujemy kolejne wyroby do momentu gdy natrafimy na k wybrakowanych, gdzie k jest ustaloną z góry liczbą. Zbudować model statystyczny.

2.2. Uogólnić rozważania z Przykładu 2.1.5 (badanie reprezentacyjne), uwzględniając więcej niż

jeden rodzaj jednostek „wyróżnionych”. Powiedzmy, że mamy w urnie m1 kul czerwonych, m2

zielonych i r − m1 − m2 białych, gdzie r jest znaną liczbą, a m1 i m2 są nieznane i są przedmiotem

badania. Opisać dokładnie odpowiedni model statystyczny.

2.3. Obliczyć rozkład prawdopodobieństwa zmiennej losowej Z 2 , jeśli Z ∼ N(0, 1) (obliczyć bezpośrednio dystrybuantę i gęstość rozkładu χ2 (1)).

2.4. Obliczyć rozkład prawdopodobieństwa zmiennej losowej Z12 + Z22 , jeżeli Zi ∼ N(0, 1) są niezależne dla i = 1, 2 (obliczyć bezpośrednio dystrybuantę i gęstość rozkładu χ2 (2)).

2.5. Korzystając z Zadania 2.3 oraz z własności rozkładów gamma, udowodnić Uwagę 2.2: gęstość

zmiennej losowej Y ∼ χ2 (k) ma postać

fY (y) =

1

2k/2 Γ(k/2)

y k/2−1 e−y/2 ,

(y > 0).

2.6. Udowodnić zbieżność rozkładów: t(k) →d N(0, 1) dla k → ∞.

2.7. Udowodnić wzór dotyczący rozkładu t-Studenta na końcu Przykładu 2.2.6.

2.8. Niech X1 , . . . , Xn będzie próbką z rozkładu (Weibulla) o gęstości

(

3

3θx2 e−θx

dla x > 0;

fθ (x) =

0

dla x 6 0,

gdzie θ > 0 jest nieznanym parametrem. Znaleźć jednowymiarową statystykę dostateczną.

2.9. Niech X1 , . . . , Xn będzie próbką z rozkładu Gamma(α, λ). Znaleźć dwuwymiarową statystykę

dostateczną, zakładając że θ = (α, λ) jest nieznanym parametrem.

2.10. Rozważamy rodzinę przesuniętych rozkładów wykładniczych o gęstości

(

e−(x−µ) dla x > µ;

fµ (x) =

0

dla x < µ.

Niech X1 , . . . , Xn będzie próbką losową z takiego rozkładu. Znaleźć jednowymiarową statystykę

dostateczną dla parametru µ.

2.11. Rozważamy rodzinę przesuniętych rozkładów wykładniczych z parametrem skali o gęstości

(

λe−λ(x−µ) dla x > µ;

fµ,λ (x) =

0

dla x < µ.

Niech X1 , . . . , Xn będzie próbką losową z takiego rozkładu. Znaleźć dwuwymiarową statystykę

dostateczną dla parametru (µ, λ).

2.5. ZADANIA

39

2.12. Rozważamy rodzinę rozkładów na przestrzeni {0, 1, 2, . . .}:

(

θ

dla x = 0;

fθ (x) = Pθ (X = x) =

(1 − θ)/2x dla x ∈ {1, 2, . . .}.

gdzie θ ∈]0, 1[ jest nieznanym parametrem. Niech X1 , . . . , Xn będzie próbką losową z wyżej podanego rozkładu. Znaleźć jednowymiarową statystykę dostateczną.

2.13. Niech X1 , . . . , Xn będzie schematem Bernoulliego z prawdopodobieństwem sukcesu θ. Obliczyć warunkowy

Pn rozkład prawdopodobieństwa zmiennych losowych X1 , . . . , Xn przy danym S = s,

gdzie S = i=1 Xi jest liczbą sukcesów. Zinterpretować fakt, że statystyka S jest dostateczna.

2.14. Niech X1 , . . . , Xn będzie próbką z rozkładu Poiss(θ). Obliczyć warunkowy

rozkład prawdopoP

dobieństwa zmiennych losowych X1 , . . . , Xn przy danym S = s, gdzie S = ni=1 Xi . Zinterpretować

fakt, że statystyka S jest dostateczna.

P

2.15. Niech X1 , . . . , Xn będzie próbką z rozkładu Ex(θ). Niech S = ni=1 Xi . Pokazać, że rozkład

warunkowy

(X1 , . . . , Xn−1 ) przy danym S = s jest jednostajny na sympleksie {(x1 , . . . , xn−1 ) : xi >

P

x

6

s}. Zinterpretować fakt, że statystyka S jest dostateczna.

0, n−1

i=1 i

2.16. Znaleźć rozkład zmiennej losowej

n

1 X

(Xi − µ)2

σ2

i=1

w modelu normalnym. Porównać z twierdzeniem Fishera (Stwierdzenie 2.2.3).

2.17. (Ciąg dalszy). Wyprowadzić tożsamość

n

n

1 X

1 X

n

2

(Xi − µ) = 2

(Xi − X̄)2 + 2 (X̄ − µ)2 .

2

σ

σ

σ

i=1

i=1

Jaki jest rozkład prawdopodobieństwa pierwszego i drugiego składnika po prawej stronie?

2.18. Rozważmy jednoparametryczną

wykładniczą rodzinę rozkładów z gęstościami danymi wzorem

fψ (x) = exp T (x)ψ − b(ψ) h(x). Pokazać, że

Eψ T (X) =

∂b(ψ)

.

∂ψ

2.19. (Ciąg dalszy). Pokazać, że

Var ψ T (X) =

∂ 2 b(ψ)

.

∂ψ 2

2.20. (Ciąg dalszy). Pokazać, że

Eψ exp rT (X) = exp b(ψ + r) − b(ψ) .

40

ROZDZIAŁ 2. MODELE STATYSTYCZNE