1

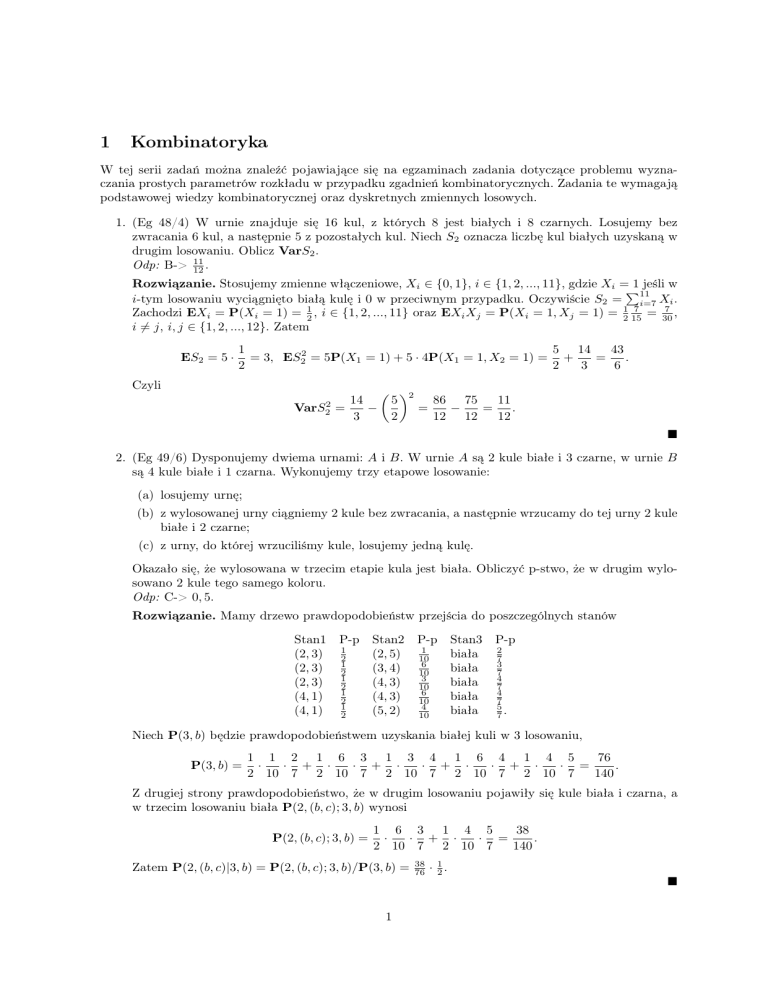

Kombinatoryka

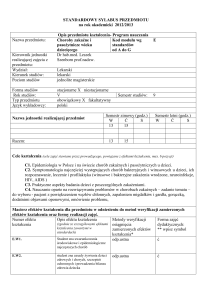

W tej serii zadań można znaleźć pojawiające się na egzaminach zadania dotyczące problemu wyznaczania prostych parametrów rozkładu w przypadku zgadnień kombinatorycznych. Zadania te wymagają

podstawowej wiedzy kombinatorycznej oraz dyskretnych zmiennych losowych.

1. (Eg 48/4) W urnie znajduje się 16 kul, z których 8 jest białych i 8 czarnych. Losujemy bez

zwracania 6 kul, a następnie 5 z pozostałych kul. Niech S2 oznacza liczbę kul białych uzyskaną w

drugim losowaniu. Oblicz VarS2 .

Odp: B-> 11

12 .

Rozwiązanie. Stosujemy zmienne włączeniowe, Xi ∈ {0, 1}, i ∈ {1, 2, ..., 11}, gdzie Xi = 1 jeśli w

P11

i-tym losowaniu wyciągnięto białą kulę i 0 w przeciwnym przypadku. Oczywiście S2 = i=7 Xi .

7

7

= 30

,

Zachodzi EXi = P(Xi = 1) = 21 , i ∈ {1, 2, ..., 11} oraz EXi Xj = P(Xi = 1, Xj = 1) = 21 15

i 6= j, i, j ∈ {1, 2, ..., 12}. Zatem

ES2 = 5 ·

1

5 14

43

= 3, ES22 = 5P(X1 = 1) + 5 · 4P(X1 = 1, X2 = 1) = +

=

.

2

2

3

6

Czyli

VarS22

14

−

=

3

2

5

11

86 75

−

=

.

=

2

12 12

12

2. (Eg 49/6) Dysponujemy dwiema urnami: A i B. W urnie A są 2 kule białe i 3 czarne, w urnie B

są 4 kule białe i 1 czarna. Wykonujemy trzy etapowe losowanie:

(a) losujemy urnę;

(b) z wylosowanej urny ciągniemy 2 kule bez zwracania, a następnie wrzucamy do tej urny 2 kule

białe i 2 czarne;

(c) z urny, do której wrzuciliśmy kule, losujemy jedną kulę.

Okazało się, że wylosowana w trzecim etapie kula jest biała. Obliczyć p-stwo, że w drugim wylosowano 2 kule tego samego koloru.

Odp: C-> 0, 5.

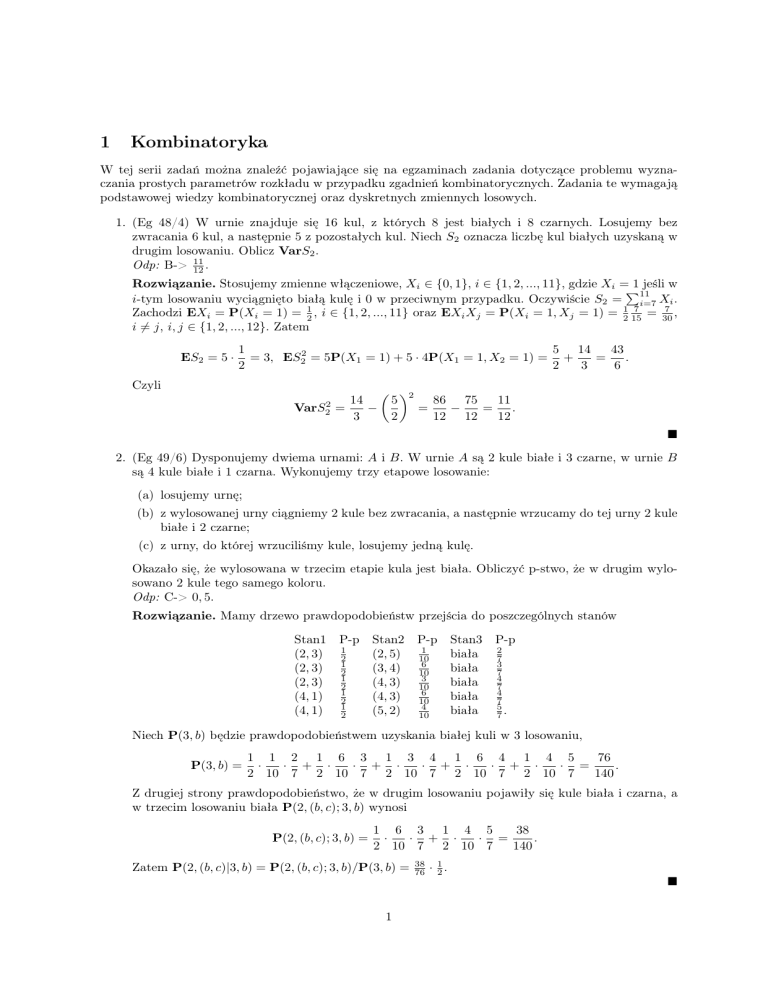

Rozwiązanie. Mamy drzewo prawdopodobieństw przejścia do poszczególnych stanów

Stan1

(2, 3)

(2, 3)

(2, 3)

(4, 1)

(4, 1)

P-p

1

2

1

2

1

2

1

2

1

2

Stan2

(2, 5)

(3, 4)

(4, 3)

(4, 3)

(5, 2)

P-p

1

10

6

10

3

10

6

10

4

10

Stan3

biała

biała

biała

biała

biała

P-p

2

7

3

7

4

7

4

7

5

7.

Niech P(3, b) będzie prawdopodobieństwem uzyskania białej kuli w 3 losowaniu,

P(3, b) =

1 1 2 1 6 3 1 3 4 1 6 4 1 4 5

76

·

· + ·

· + ·

· + ·

· + ·

· =

.

2 10 7 2 10 7 2 10 7 2 10 7 2 10 7

140

Z drugiej strony prawdopodobieństwo, że w drugim losowaniu pojawiły się kule biała i czarna, a

w trzecim losowaniu biała P(2, (b, c); 3, b) wynosi

P(2, (b, c); 3, b) =

1 6 3 1 4 5

38

·

· + ·

· =

.

2 10 7 2 10 7

140

Zatem P(2, (b, c)|3, b) = P(2, (b, c); 3, b)/P(3, b) =

38

76

· 12 .

1

3. (Eg 50/7) W urnie znajduje się 20 kul białych, 20 kul czarnych i 20 kul niebieskich. Losujemy bez

zwracania 24 kule. Niech

(a) X oznacza liczbę wylosowanych kul białych;

(b) Y oznacza liczbę wylosowanych kul czarnych;

(c) Z oznacza liczbę wylosowanych kul niebieskich.

Współczynnik

korelacji zmiennych losowych X + 2Y i Z, Corr(X + 2Y, Z) jest równy?

√

Odp: B-> − 23 .

Rozwiązanie. Przypomnijmy, że Corr(X + 2Y, Z) = √

Cov(X+2Y,Z)

√

Var(X+2Y )

Var(Z)

. Łatwo zauważyć, że

Cov(X, Z) = Cov(Y, Z), Var(X) = Var(Y ) = Var(Z), zatem

Cov(X + 2Y, Z) = Cov(X, Z) + 2Cov(Y, Z) = 3Cov(X, Z).

Podobnie

Var(X + 2Y ) = Cov(X + 2Y, X + 2Y ) = 5Var(X, X) + 4Cov(X, Y ).

P24

Korzystamy zmiennych włączeniowych, żeby obliczyć Cov(X, Z). Niech X = i=1 1Xi =1 , gdzie

Xi = 1 jeśli w i tym losowaniu pojawiła się biała kula. Analogicznie definiujemy Yi , Zi , i ∈

{1, 2, ..., 24}. Zachodzi

EX = 24P(X1 = 1) =

24

= 8,

3

EX 2 = 24P(X1 = 1) + 24 · 23P(X1 = 1, X2 = 1) = 8 +

24 · 23 · 19

496

=8·

.

3 · 59

59

Wreszcie

23 · 20

24 · 23

3 · 59 = 8 ·

.

EXY = 24 · 23P(X1 = 1, Y2 = 1) =

3 · 20

59

472

496

472

czyli Cov(X, Y ) = 8 460

= −8 · 12

= 8·

59 − 59

59 oraz Var(X) = 8 59 − 59

a = 8 · 12

,

mamy

59

24

59 .

Niech zatem

Cov(X + 2Y, Z) = −3a, Var(X + 2Y ) = 10a − 4a = 6a, Var(Z) = 2a.

Ostatecznie

√

−3a

3

3

.

Corr(X + 2Y, Z) = √ √ = − √ = −

2

6a 2a

2 3

4. (Eg 51/10) Pan A przeznaczył 5 zł na pewną grę. W pojedynczej kolejce gry pan A wygrywa 1

zł z p-stwem 1/3 przegrywa 1 zł z p-stwem 2/3. Pan A kończy grę, gdy wszystko przegra lub gdy

będzie miał 10 zł. P-stwo, że A wszystko przegra jest równe?

Odp: D-> 0, 97.

Rozwiązanie. Zadanie dotyczy prawdopodobieństwa ruiny. W celu rozwiązania budujemy niezależne zmienne losowe Xk , k > 1 takie, że Xk = 1 jeśli A wygrywa oraz Xk = −1 jeśli A przegrywa.

Definiujemy Sn = X1 + ... + Xn , n > 1 oraz S0 = 0. Okazuje się, że zmienne Mn = 2Sn , n > 0

tworzą martyngał względem naturalnej filtracji. Rzeczywiście

21

1

E(Mn |Fn−1 ) = Mn−1 E2Xn = Mn−1

·2+

= Mn−1 .

3

32

Zauważmy, że gracz kończy grę w momencie τ = inf{n > 0 : Sn ∈ {−5, 5}}. Zatem z twierdzenia

Dooba (moment τ nie jest ograniczony ale nietrudno pokazać, że w tym przypadku również to

2

twierdzenie działa) wynika, że 1 = EMτ . Niech teraz a = P(Sτ = 5), b = P(Sτ =−5 ). Ponieważ jak

łatwo sprawdzić P(τ < ∞) = 1, więc a + b = 1, nadto

1 = EMτ = a25 + b2−5 .

Mamy zatem układ równań

Stąd a =

25 −1

210 −1 ,

b=

210 −25

210 −1 .

a+b

a25 + b2−5

=

=

1

1

Szukana wartość to b ' 0, 97.

5. (Eg 52/2) W urnie znajduje się 100 ponumerowanych kul o numerach 1, 2..., 100. Losujemy bez

zwracania 10 kul, zapisujemy numery, kule zwracamy do urny. Czynność te powtarzamy 10 razy.

Oblicz wartość oczekiwaną liczby kul, które zostały wylosowane dokładnie dwa razy.

Odp: D-> 19, 37.

Rozwiązanie. Zadanie staje się proste jeśli zastosujemy zmienne włączeniowe, 1Xi =1 , i ∈ {1, 2, ..., 100},

gdzie

Xi = 1 jeśli dokładnie dwa razy kula z numerem i została wylosowana. Należy wyznaczyć

P100

E i=1 1Xi =1 = 100P(X1 = 1), gdyż P(Xi = 1) są identyczne. Pozostaje zauważyć, że

2 8

9

1

10

.

P(Xi = 1) =

10

10

2

P100

9 8

Stąd E i=1 1Xi =1 = 45 · 10

' 19, 37.

6. (Eg 53/10) Z urny, w której jest 6 kul czarnych i 4 białe losujemy kolejno bez zwracania po jednej

kuli, tak długo aż wylosujemy kulę czarną. Wartość oczekiwana liczby wylosowanych kul białych

jest równa?

Odp: B-> 47 .

P∞

Rozwiązanie. Przypomnijmy wzór EX =

k=0 P(X > k), dla zmiennych X o watotściach

całkowitych dodatnich. Sprawdzamy, że

2

4·3

2

4

= , P(X > 2) =

=

,

10

5

10 · 9

15

4·3·2

1

4·3·2·1

1

P(X > 3) =

=

, P(X > 4) =

=

,

10 · 9 · 8

30

10 · 9 · 8 · 7

210

P(X > 0) = 1, P(X > 1) =

nadto P(X > k) = 0 dla k > 4. Stąd EX =

2

5

+

2

15

+

1

30

+

1

210

=

120

210

= 74 .

7. (Eg 54/7) mamy dwie urny: I i II. Na początku doświadczenia w każdej z urn znajdują się 2

kule białe i 2 czarne. Losujemy po jednej kuli z każdej urny - po czym kulę wylosowaną z urny I

wrzucamy do urny II, a te wylosowana z urny II wrzucamy do urny I. Czynność tę powtarzamy

wielokrotnie. Granica (przy n → ∞) p-stwa, iż obie kule wylosowane w n-tym kroku są jednakowego koloru, wynosi:?

Odp: C-> 73 .

Rozwiązanie. Zadanie rozwiązuje się metoda łańcuchów Markowa. Jest możliwych 5 stanów na

liczbę kul białych w urnie I. Należy znaleźć prawdopodobieństwa przejścia w jednym kroku. Mamy

S 0

1

2

3

4

0 0

1

0

0

0

6

9

1 1

0

0

16

16

16

P =

1

1

1

2

0

0

4

2

4

9

6

1

3 0

0

16

16

16

4 0

0

0

1

0

3

P4

należy wyznaczyć rozkład stabilny z równania πM = π oraz warunku, że k=0 πk = 1. Nietrudno

zauważyć symetrię macierzy skąd wynika, że π0 = π4 , π1 = π3 . Nadto natychmiast zauważamy, że

1

π0 = 16

π1 . Wystarczą zatem 2 równania (w terminach π1 i π2 )

7

π1 + 14 π2

π1 = 16

1

1

= 8 π1 + 2π1 + π2

1

8

Skąd wynika, że π0 = π4 = 70

, π1 = π3 = 35

, π2 = 18

35 . Obliczamy prawdopodobieństwa warunkowe

wylosowania kul różnego koloru w zależności od stanu liczby kul białych w I urnie

5

1

, P((b, c)|2) = .

8

2

Dostajemy ze wzoru Bayesa dla stanów rozłożonych według π (czyli w granicy n → ∞)

P((b, c)|0) = P((b, c)|4) = 1, P((b, c)|1) = P((b, c)|3) =

P((b, c)) = 2 ·

5 8

1 18

4

1

+2· ·

+

= .

70

8 35 2 35

7

Zatem prawdopodobieństwo zdarzenia przeciwnego wynosi 37 .

8. (Eg 55/3) Wylosowano niezależnie 15 liczb z rozkładu symetrycznego ciągłego i ustawiono je w ciąg

według kolejności losowania. Otrzymano 8 liczb dodatnich (każda z nich oznaczamy symbolem a)

i 7 ujemnych (każdą z nich oznaczamy symbolem b). Obliczyć p-stwo, że otrzymano 6 serii, gdzie

serią nazywamy ciąg elementów jednego typu, przed i za którym występuje element drugiego typu,

na przykład w ciągu: aaabbbbaabbbbba jest 5 serii (3 serie elementów typu a i 2 serie elementów

typu b).

14

Odp: C-> 143

Rozwiązanie. Należy zauważyć, że zbiór Ω złożony

ze wszystkich możliwych podzbiorów 8 ele

mentowych w zbiorze 15 elementowym ma 15

elementów.

Teraz należy zauważyć, że seria będzie

8

jednoznacznie wyznaczonym podzbiorem jeśli podamy od jakiego symbolu zaczynamy, a następnie

długości ścieżek k1 , k2 , k3 dla serii symbolu a oraz l1 , l2 , l3 dla serii symbolu b. Oczywiście ścieżki

muszą mieć długość dodatnią nadto k1 + k2 + k3 = 8, l1 + l2 + l3 = 7. Ogólnie

liczba rozwiązań

równania x1 + ... + xk = n w liczbach naturalnych (bez zera) wynosi n−1

.

Zatem

liczność zbioru

k−1

A6 złożonego z serii długości 6 wynosi

7 6

|A6 | = 2 ·

.

2 2

Ostatecznie

P(A6 ) =

14

|A6 |

=

.

||Ω|

143

9. (Eg 56/4) Dysponujemy 5 identycznymi urnami. Każda z nich zawiera 4 kule. Liczba kul białych

w i-tej urnie jest równa i − 1, gdzie i = 1, 2, ..., 5, pozostałe kule są czarne. Losujemy urnę, a

następnie ciągniemy z niej jedną kulę i okazuje się, że otrzymana kula jest biała. Oblicz p-stwo,

że ciągnąc drugą kule z tej samej urny (bez zwracania pierwszej) również otrzymamy kulę białą.

Odp: D-> 32 .

Rozwiązanie. Ze symetrii zadania jest jasne, że szansa wylosowania białej kuli w pierwszej rundzie

wynosi 12 . Aby obliczyć szansę wyciągnięcia dwóch kul białych stosujemy wzór Bayesa

5

i−1

X

1

2

.

P((b, b)) =

4

5

2

i=1

P5

i−1

Zachodzi wzór kombinatoryczny

= 53 (trójkąt Pascala). Nadto 53 / 42 = 53 , stąd

i=1

2

P((b, b)) = 31 . To oznacza, że P((b, b)|b) = 23 .

4

10. (Eg 57/1) Urna zawiera 5 kul o numerach: 0, 1, 2, 3, 4. Z urny ciągniemy kulę, zapisujemy numer i

kulę wrzucamy z powrotem do urny. Czynność tę powtarzamy, aż kula z każdym numerem zostanie

wyciągnięta co najmniej raz. Oblicz wartość oczekiwaną liczby powtórzeń.

5

.

Odp: C-> 11 12

Rozwiązanie. Tutaj łatwo zauważyć, że jeśli T1 , ..., T5 będą czasami oczekiwania na kolejny nowy

symbol, to T1 = 1 nadto Tk+1 − Tk , k ∈ {1, 2, 3, 4} ma rozkład geometryczny z prawdopodobieństwem sukcesu pk = 5−k

5 (i wartości oczekiwanej 1/pk ). Zatem

ET5 = 1 +

4

X

E(Tk+1 − Tk ) = 1 +

k=1

4

X

k=1

5

5

= 11 .

5−k

12

11. (Eg 58/7) W urnie znajduje się 20 kul: 10 białych i 10 czerwonych. Losujemy bez zwracania 8 kul, a

następnie z pozostałych w urnie kul losujemy kolejne 6 kul. Niech S8 oznacza liczbę wylosowanych

kul białych wśród pierwszych 8 wylosowanych kul, a S6 liczbę kul białych wśród następnych 6 kul.

Oblicz Cov(S8 , S8 + S6 ).

Odp: C-> 12

19 .

Rozwiązanie. Oczywiście skorzystamy ze zmiennych włączeniowych. Niech Xi , i ∈ {1, ..., 14}

oznacza

1 jeśli w i tej

rundzie pojawiła się biała kula i 0 w przeciwnym przypadku. Mamy S8 =

P8

P16

X

oraz

S

=

i

6

i=1

i=9 Xi . Zachodzi

ES8 = 8P(X1 = 1) = 4, E(S6 ) = 6P(X1 = 1) = 3.

Teraz

ES82 = 8P(X1 = 1) + 8 · 7P(X1 = 1, X2 = 1) = 4 + 56 ·

328

1 9

·

=

.

2 19

19

Stąd

VarS8 =

328 304

24

−

=

.

19

19

19

Z drugiej strony

ES8 S6 = 48P(X1 = 1, X2 = 1) = 48 ·

1 9

· .

2 19

Co daje

Cov(S8 , S6 ) =

216 228

12

−

=− .

19

19

19

Ostatecznie

Cov(S8 , S8 + S6 ) = VarS8 + Cov(S8 , S6 ) =

24 12

12

−

=

.

19 19

19

12. (Eg 60/9) W urnie znajduje się 30 kul, na każdej narysowana jest litera i cyfra. Mamy:

(a) 10 kul oznaczonych X1;

(b) 6 kul oznaczonych Y 1;

(c) 8 kul oznaczonych X2;

(d) 6 kul oznaczone Y 2.

Losujemy bez zwracania 15 kul. Niech NX1 oznacza liczbę kul oznaczonych literą X1 wśród kul

wylosowanych,a N2 liczbę kul z cyfrą 2 wśród kul wylosowanych. Obliczyć Var(NX1 |N2 = 5).

15

Odp: A-> 16

.

Rozwiązanie. Dokonujemy uproszczenia, mamy pięć kul wylosowanych z cyfrą 2. Zatem de facto

losujemy 10 typu X1 lub X2, czyli ze zbioru 18 elementowego. W tym modelu probabilistycznym

5

musimy policzyć wariancję zmiennej N̄X1 co robimy przez zmienne włączeniowe. Niech Xi , i ∈

{1, ..., 10} będzie zmienną przyjmującą 1 jeśli na i-tej pozycji stoi X1 oraz 0 jeśli X2. Oczywiście

P10

N̄X1 = i=1 1Xi =1 . Wyznaczamy

EN̄X1 = 10P(X1 = 1) = 10 ·

5

25

=

.

8

4

Nadto

2

EN̄X1

= 10P(X1 = 1) + 90P(X1 = 1, X2 = 1) = 10 ·

5

5 9

320

+ 90 · ·

=

= 40.

8

8 15

8

Stąd

VarN̄X1 =

15

640 625

−

=

.

16

16

16

13. (Eg 61/5) W urnie znajduje się 100 kul ponumerowanych od 1 do 100. Losujemy bez zwracania 25

kul i zapisujemy numery, a następnie wrzucamy kule z powrotem do urny. Czynność powtarzamy

5 razy. Oblicz wartość oczekiwaną liczby kul, które zostały wylosowane co najmniej 2 razy.

Odp: D-> 36, 7.

Rozwiązanie. Zadanie rozwiązujemy przez zmienne włączeniowe. Niech Xi , i ∈ {1, ..., 100} przyjmuje wartość 1 jeśli kula z numerem i pojawiła się co najmniej 2 razy w losowaniu i 0 w przeciwnym

przypadku. Oczywiście szukana odpowiedź to

E

100

X

Xi = 100P(X1 = 1).

i=1

Żeby policzyć P(X1 = 1) zauważmy, że w każdym z 5 losowań kula i miała prawdopodobieństwo

1

4 , że się pojawi. Zatem

P(X1 = 1) =

5 k 5−k

X

5

1

3

k=2

Czyli wynik to 100 ·

47

128

k

4

4

5

4

3

1 3

47

=1−

−5·

=

.

4

4 4

128

' 36, 7.

14. (Eg 62/6) Z urny, w której są 2 kule białe i 3 czarne, wylosowane jedną kulę a następnie wrzucono ja

z powrotem dorzucając kulę w tym samym kolorze co wylosowana. Następnie z urny wylosowano 2

kule, wrzucono je z powrotem dorzucając 2 kule identyczne jak wylosowane. Następnie wylosowano

3 kule. Okazało się, że są to 3 kule białe. Oblicz p-stwo, że w drugim losowaniu wylosowane kule

różnych kolorów.

Odp: A-> 15

29 .

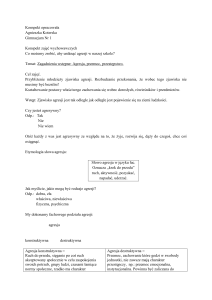

Rozwiązanie. Potrzebujemy struktury drzewa aby opisać kolejne losowania

Stan1

(3, 3)

(3, 3)

(3, 3)

(2, 4)

(2, 4)

P-p

2

5

2

5

2

5

3

5

3

5

Stan2

(5, 3)

(4, 4)

(3, 5)

(4, 4)

(3, 5)

P-p

1

5

3

5

1

5

1

15

8

15

Stan3

(b, b, b)

(b, b, b)

(b, b, b)

(b, b, b)

(b, b, b)

P-p

5

28

1

14

1

56

1

14

1

56

Wyznaczamy

2 1 5

2 3 1

· ·

+ · · +

5 5 28 5 5 14

2 1 1

3 1 1

3 8 1

29

+ ·

·

+ ·

·

=

.

+ · ·

5 5 56 5 15 14 5 15 56

25 · 28

P(3, (b, b, b)) =

6

Teraz wyznaczamy

P(2, (b, c); 3, (b, b, b)) =

2 3 1

3 8 1

16

· ·

+ ·

·

=

.

5 5 14 5 15 56

25 · 28

Stąd

P(2, (b, c); 3, (b, b, b)) =

16

.

29

15. (Eg 63/1)W urnie znajdują się kule, z których każda jest oznaczona jedną z liter alfabetu:

• 10 kul oznaczonych literą A.

• 20 kul oznaczonych literą B.

• 30 kul oznaczonych literą C.

• x kul oznaczonych innymi literami alfabetu.

Losujemy bez zwracania 9 kul z urny. Zmienne losowe NA , NB , NC oznaczają, odpowiednio, liczbę

wylosowanych kul z literami A, B, C. Jakie musi być x , aby zmienne losowe NA +NB oraz NB +NC

były nieskorelowane.

Odp: C-> x = 15.

Rozwiązanie. Korzystamy ze zmiennych Ai , Bi , Ci , Xi , 1 6 i 6 9 gdzie zmienne przyjmują wartości 0 lub 1, przy czym 1P

jeśli na pozycji wPi-tym losowaniu

odpowiednio A, B, C oraz inną

Pwybrano

9

9

9

literę. Zachodzi NA = i=1 Ai , NB = i=1 Bi NC = i=1 Ci . Należy wyliczyć Cov(NA , NB ),

Cov(NB , NC ), Cov(NC , NA ). Zachodzi

ENA = 9

20

30

10

, ENB = 9

, ENC = 9

,

60 + x

60 + x

60 + x

nadto

10

20

,

60 + x 59 + x

20

30

ENB NC = 72EB1 C2 = 72

,

60 + x 59 + x

10

30

,

ENC NA = 72EC1 A2 = 72

60 + x 59 + x

20

19

20

ENB2 = 72EB1 B2 + 9EB12 = 72

+9

.

60 + x 59 + x

60 + x

ENA NB = 72EA1 B2 = 72

Stąd

9 · 10 · 20

8

9

9 · 10c2̇0(−x − 51)

(

−

)=

,

60 + x 59 + x 60 + x

(60 + x)2 (59 + x)

9 · 20 · 30

8

9

9 · 20 · 30(−x − 51)

Cov(NB , NC ) =

(

−

)=

,

60 + x 59 + x 60 + x

(60 + x)2 (59 + x)

9 · 30 · 10

8

9

9 · 30 · 10(−x − 51)

Cov(NB , NC ) =

(

−

)=

,

60 + x 59 + x 60 + x

(60 + x)2 (59 + x)

9 · 20 8 · 19

9 · 20

9 · 20(x2 + 91x + 34 · 60)

Cov(NB , NB ) =

(

+1−

)=

.

60 + x 59 + x

60 + x

(60 + x)2 (59 + x)

Cov(NA , NB ) =

Zatem NA + NB i NB + NC są nieskorelowane jeśli

0 = Cov(NA + NB , NB + NC ) = Cov(NA , NB ) + Cov(NC , NA ) + Cov(NB , NB ) + Cov(NB , NC )

7

co jest równoważne

−1100(x + 51) + 20(x2 + 91x + 34 · 60) = 0.

Przekształcając to równanie

x2 + 36x − 765 = 0.

Rozwiązaniami tego równanie są x =

rozwiązania dodatnie zatem x = 15.

−36±66

,

2

czyli x1 = 15 i x = −51. Interesują nas wyłącznie

8

1

Gaussowskie zmienne losowe

W tej serii rozwiążemy zadania dotyczące zmiennych o rozkładzie normalny. Wymagana jest wiedza na

temat własności rozkładu normalnego, CTG oraz warunkowych wartości oczekiwanych.

1. (Eg 48/6) Niech X1 , X2 , ..., Xn , ... będą niezależnymi zmiennymi losowymi o identycznym rozkła1

1

dzie o gęstości f (x) = 2√

1

(x). Niech Un = (X1 ...Xn ) n . Wtedy: (asymptotyka Un − e−2 )?

x (0,1)

√

Odp: B-> limn→∞ P((Un − e−2 ) n < 4e−2 ) = 0, 977.

Rozwiązanie. Zadanie polega na umiejętnym zastosowaniu CTG. Zauważmy, że Yi = − log Xi ,

i ∈ {1, ..., n} oraz

t

P(Yi > t) = P(Xi < e−t ) = e− 2 , t > 0.

Czyli Yi ma rozkład Exp( 12 ), w szczególności EYi = 2, VarYi = 4. Zatem

n

√

√

1X

(Un − e−2 ) n = e−2 (exp(

(Yi − 2) − 1) n.

n i=1

Z mocnego prawa wielkich liczb wynika, że limn→∞

Pn

i=1 (Yi

− 2) = 0. Zatem

n

n

(exp(

1

n

n

√

1X

1X

1 X

(Yi − 2)(1 + O(

(Yi − 2) − 1) n = √

(Yi − 2)).

n i=1

n i=1

n i=1

Czyli w sensie rozkładu

n

√

1 X

lim (Un − e−2 ) n = e−2 lim √

(Yi − 2) = 2e−2 Z,

n→∞

n→∞

n i=1

gdzie Z ma rozkład N (0, 1). Stąd

√

lim P((Un − e−2 ) n < 4e−2 ) = P(Z < 2) ' 0, 977.

n→∞

2. (Eg 50/6) Rozważmy następujące zagadnienie testowania hipotez statystycznych. Dysponujemy

próbką X1 , ..., Xn z rozkładu normalnego o nieznanej średniej µ i znanej wariancji równej 4. Przeprowadzamy najmocniejszy test hipotezy H0 : µ = 0 przeciwko alternatywie H1 : µ = −1 na

poziomie istotności α = 1/2. Niech βn oznacza prawdopodobieństwo błędu drugiego rodzaju, dla

rozmiaru próbki n. Wybierz poprawne stwierdzenie: (asymptotyka βn )

Odp: D-> limn→∞ βn e

√

√ πn

2

n

8

= 1.

Rozwiązanie. Najpierw znajdujemy błąd drugiego rodzaju czyli akceptacja hipotezy H0 w sytuacji gdy zachodzi H1 . Test najmocniejszy oparty jest na konstrukcji obszaru krytycznego wynikającej z Twierdzenia Neymana-Pearsona (o porównywaniu gęstości). Niech µ0 = 0, µ1 = −1 oraz

niech fµ0 , fµ1 będą gęstościami rozkładu wektora (X1 , ..., Xn ) niezależnych zmiennych losowych

o tym samym rozkładzie co zmienna X, odpowiednio X ∼ N (µ0 , 4), X ∼ N (µ1 , 4). W metodzie Neymana-Pearsona badamy iloraz wiarygodności, to znaczy fµ1 (x1 , ..., xn )/fµ0 (x1 , ..., Xn ).

W przypadku rozkładów ciągłych nie potrzeba randomizacji, a obszar krytyczny ma postać

K = {(x1 , ..., xn ) ∈ Rn : fµ1 (x1 , ..., xn )/fµ0 (x1 , ..., xn ) > C}

dla stałej C dobranej tak aby Pµ0 ((X1 , ..., Xn ) ∈ K) = α. W naszym przypadku oznacza to

konieczność znalezienia stałej C̄ takiej, że

Pµ0 (X1 + ... + Xn < C̄) =

1

1

.

2

Oczywiście C̄ = 0. Błąd drugiego rodzaju wynosi

√

βn = Pµ1 (X1 + ... + Xn > C̄) = P(−n + 2 nZ > 0),

gdzie Z ma rozkład N (0, 1). Zatem zostaje zbadać asymptmpotykę

√

n

βn = P(Z >

).

2

Oczywiście P(Z > t) '

√1 e

2πt

−t2

2

stąd

√

πn n

lim βn √ e 8 = 1.

n→∞

2

3. (Eg 51/4) Niech X i Y będą niezależnymi zmiennymi losowymi o rozkładach normalnych, przy

tym EX = EY = 0, VarX = 3 i VarY = 1. Oblicz P(|X| < |Y |).

Odp: A-> P(|X| < |Y |) = 0, 3333.

Rozwiązanie. To zadanie ma czysto geometryczne rozwiązanie. Wystarczy wykorzystać

rotacyjną

√

niezmienniczość standardowego rozkładu normalnego nadto zauważyć, że X = 3X̄, gdzie X̄ ma

rozkład N (0, 1). Zatem (X̄, Y ) ma standardowy rozkład normalny na R2 oraz

√

1

P(|X| < |Y |) = P( 3|X̄| < |Y |) = µS 1 ({α ∈ S 1 : | tg α| < √ }),

3

gdzie µS 1 jest miarą Lebesgue’a na okręgu jednostkowym unormowaną do 1. Oczywiście {α ∈ S 1 :

| tg α| < √13 } = {α ∈ S 1 : |α| 6 π6 lub |π − α| 6 π6 } Zatem

1

1

µS 1 ({α ∈ S 1 : | tg α| < √ }) = .

3

3

4. (Eg 52/5) Załóżmy, że X, Y są zmiennymi o łącznym rozkładzie normalnym, EX = EY = 0,

VarX = 2, VarY = 4 i Cov(X, Y ) = 1. Oblicz E(XY |X − Y = t),

3 2

Odp: C-> 47 − 16

t .

Rozwiązanie. Potrzebujemy metody znajdowania bazy niezależnych liniowych funkcji od X, Y

zawierającej X − Y . Szukamy α takiego, że X − αY będzie niezależne od X − Y . Wystarczy

sprawdzić kowariancję

Cov(X − Y, X − αY ) = 2 − α − 1 + 4α = 1 + 3α.

Stąd α = − 13 . Wystarczy teraz rozpisać X, Y w znalezionej bazie. Mamy

X = 14 [(X − Y ) + 3(X + 31 Y )]

Y = 34 [−(X − Y ) + (X + 31 Y )]

Niech Z = (X + 13 Y ), zmienną X − Y możemy traktować jako parametr t przy wyliczaniu warunkowej wartości oczekiwanej (bo jest niezależna od Z). Zatem

1

3

3

E(XY |X − Y = t) = E( (t + 3Z) (−t + Z)) =

(−t2 + 3tEZ + 3EZ 2 ).

4

4

16

Oczywiście EZ = 0. Natomiast z dwuliniowości kowariancji i

EZ 2 = VarZ = 2 +

2 4

28

+ =

.

3 9

9

3 2

Czyli E(XY |X − Y = t) = − 16

t + 74 .

2

5. (Eg 53/9) Mamy próbą prostą ((X1 , Y1 ), (X2 , Y2 ), ..., (X10 , Y10 )) z rozkładu normalnego dwuwymiarowego o nieznanych parametrach

EXi = EYi = µ, VarXi = VarYi = σ 2 , Cov(Xi , Yi ) = σ 2 ρ.

Niech

10

Zi = Xi + Yi , Ri = Xi − Yi , SZ2 =

10

1X

1X

2

(Zi − Z̄)2 , SR

=

(Ri − R̄)2 ,

9 i=1

9 i=1

gdzie Z̄ oraz R̄ to odpowiednie średnie z próbki. Do testowania hipotezy H0 : ρ =

alternatywie H1 : ρ 6= 13 możemy użyć testu o obszarze krytycznym postaci:

1

3

przeciwko

SZ2

SZ2

<

k

,

lub

1

2

2 > k2 ,

SR

SR

przy czym liczby k1 i k2 dobrane są tak, aby przy założeniu, że H0 jest prawdziwa

P(

SZ2

S2

< k1 ) = P( Z2 > k2 ) = 0, 05.

2

SR

SR

Liczby k1 i k2 są równe: ?

Odp: D-> k1 = 0, 629 i k2 = 6, 358.

Rozwiązanie. Zauważmy, że (Xi + Yi ) jest niezależne od (Xi − Yi ), istotnie

Cov(Xi + Yi , Xi − Yi ) = VarXi − Cov(Xi , Yi ) + Cov(Yi , Xi ) − Var(Yi ) = 0.

2

To oznacza, że SZ2 i SR

są niezależne. Wystarczy wyznaczyć ich rozkłady. Mamy

Var(Xi + Yi ) = 2σ 2 + 2ρσ 2 = 2(1 + ρ)σ 2 .

Analogicznie

Var(Xi − Yi ) = 2σ 2 − 2ρσ 2 = 2(1 − ρ)σ 2 .

1

1

To oznacza, że Zi = [2(1 + ρ)] 2 σ Ẑi , Ri = [2(1 − ρ)] 2 R̂i , gdzie Ẑi , R̂i są niezależne z rozkładu

N (0, 1). Zatem

SZ2

1 + ρ ŜZ2

=

.

2

2

SR

1 − ρ ŜR

To oznacza, że aby wyznaczyć k1 , k2 należy wziąć wartości dla F9,9 i pomnożyć je przez

przy H0 wynosi 2. Czyli k2 = 2 · 3, 1789 ' 6, 358 oraz k1 = 2 · (1/3, 1789) ' 0, 629

1+ρ

1−ρ ,

które

6. (Eg 54/9) Zmienne losowe X i Y są niezależne i zmienna X ma rozkład logarytmiczno-normalny

LN (µ, σ 2 ), gdzie µ = 1 i σ = 2, a zmienna Y ma rozkład wykładniczy o wartości oczekiwanej 2.

Niech S = X + Y . Wtedy E(S|X > e) jest równa?

Odp: E-> 41, 26.

Rozwiązanie. Przypomnijmy definicję

E(S|X > e) =

ES1X>e

.

P(X > e)

Teraz zauważmy, że X = eY , gdzie Y ma rozkład N (1, 4), czyli Y = 1 + 2Z, gdzie Z ∼ N (0, 1).

Zatem

1

P(X > e) = P(1 + 2Z > 1) = P(Z > 0) = .

2

3

Obliczamy

1

ES1X>e = EX1X>e + P(X > e)EY = Ee1+2Z 1Z>0 + 2 = 1 + eEe2Z 1Z>0 .

2

Należy obliczyć

Ee2Z 1Z>0 =

Z

0

∞

x2

1

e2x √ e− 2 dx = e2

2π

Zatem

Ee

2Z

2

Z

∞

1Z>0 = e

−2

Z

∞

0

2

1

1

√ e− 2 (x−2) .

2π

x2

1

√ e− 2 dx = e2 P(Z > −2).

2π

Ostatecznie

E(S|X > e) = 2 + 2e3 P(Z > −2) ' 41, 26.

7. (Eg 55/4) Załóżmy, że zmienne losowe X, Y mają łączny rozkład normalny taki, że

EX = 1, EY = 0, Var(X) = 2, Var(Y ) = 9, i Cov(X, Y ) = 3.

Oblicz Cov(X 2 , Y 2 ).

Odp: D-> 18.

Rozwiązanie. Przypomnijmy, że ogólny wzór na k-ty moment zmiennej V rozkładzie N (0, σ 2 )

ma postać

EV 2k

= σ 2k (2k − 1)(2k − 3)...3 · 1,

2k+1

EV

= 0

Aby obliczyć Cov(X 2 , Y 2 ) potrzebujemy policzyć EX 2 Y 2 . Po raz kolejny należy posłużyć się bazą

złożoną z liniowych względem X, Y zmiennych niezależnych. Ściślej szukamy α takiego, że X − αY

jest nieskorelowane z Y , a przez to niezależne bo (X, Y ) tworzą wektor gaussowski. Mamy

Cov(Y, X − αY ) = 3 − 9α,

stąd α = 31 . Niech Z = X − 31 Y , zachodzi EZ = 1, VarZ = 2 − 23 3 + 19 9 = 1. Dalej mamy rozkład

X = Z + 13 Y , stąd

1

2

1

EX 2 Y 2 = E(Z + Y )2 Y 2 = EZ 2 EY 2 + EZEY 3 + EY 4 .

3

3

9

Drugi składnik powyżej jest zerem bo EY = 0, a stąd EY 3 = 0. Zauważmy jeszcze, że podobnie

1

EX 2 EY 2 = (EZ 2 + EY 2 )EY 2 .

9

Dlatego

Cov(X 2 , Y 2 ) =

1

(EY 4 − (EY 2 )2 ).

9

Pozostaje zauważyć, że EY 4 = 3 · 92 oraz EY 2 = 9. Zatem

Cov(X 2 , Y 2 ) =

1

(3 · 92 − 92 ) = 2 · 9 = 18.

9

4

8. (Eg 57/3) Niech X1 , X2 , ..., Xn będą niezależnymi zmiennymi losowymi z rozkładu normalnego o

2

wartości oczekiwanej

Pn 0 i nieznanej wariancji σ . Rozważmy estymatory odchylenia standardowego

σ postaci σ̂c = c i=1 |Xi |. Niech σ̂c̄ oznacza estymator o najmniejszym błędzie średniokwadratowym w klasie√rozważanych estymatorów. Wtedy c̄ jest równe ?

2π

Odp: D-> π+2n−2

.

Rozwiązanie. Niech X ma rozkład N (0, σ 2 ). Oczywiście E|X| =

√

√ 2 σ,

π

zatem

√

2

f (c) = E(σ̂c̄ − σ) = Var(σ̂) + (Eσ̂ − σ) = nc Var(|X|) + (cn √ − 1)2 σ 2 =

π

√

2

2

= nc2 (1 − )σ 2 + (cn √ − 1)2 .

π

π

2

2

2

Aby obliczyć punkt minimum znajdujemy z równania f 0 (c) = 0. Zachodzi

√

2 2

2 2

2 2

0

√

)σ .

f (c) = 2nc(1 − )σ + 2(n c − n

π

π

π

stąd f 0 (c) = 0 dla

√

√

2

2π

2

.

n( (n − 1) + 1)c = n √ czyli c =

π

π + 2n − 2

π

9. (Eg 58/4) Niech X1 , X2 , ..., Xn , ..., N będą zmiennymi losowymi. Zmienne X1 , X2 , ..., Xn , ... mają

rozkład logarytmiczno-normalny LN (µ, σ 2 ), gdzie µ = 2, σ 2 = 4. Zmienna N ma rozkład Poissona

PN

o wartości oczekiwanej 2. Niech SN =

i=1 Xi dla N > 0 oraz SN = 0 dla N = 0. Wtedy

współczynnik asymetrii

Odp: D->

E(SN −ESN )3

(VarSN )3/2

jest równy?

e6

√

.

2

Rozwiązanie. Niech X ma rozkład LN (µ, σ 2 ), najpierw zauważmy, że

E(SN − ESN )3 = EE[(SN − ESN )3 |N ] = EE[(SN − N EX + (N − EN )EX)3 |N ] =

= EN E(X − EX)3 + 3EN (N − EN )EXE(X − EX)2 + E(N − EN )3 (EX)3 .

Zauważmy, że

2 = EN = VarN = E(N − EN )2 = EN (N − EN ) = E(N − EN )3

(scentrowane momenty drugi i trzeci dla rozkładu Poissona są równe wartości oczekiwanej). Zatem

E(SN − ESN )3 = 2(E(X − EX)3 + 3EXE(X − EX)2 + (EX)3 ) = 2EX 3 .

Z definicji X = exp(Y ), gdzie Y ma rozkład N (µ, σ 2 ), a dalej Y = σZ + µ, gdzie Z ma rozkład

N (0, 1). Przypomnijmy wzór n transformatę Laplace’cea dla rozkładu N (0, 1)

E exp(λZ) = exp(

λ2

).

2

Stąd

EX 3 = E exp(3σZ + 3µ) = e

9σ 2

2

+3µ

= e24 .

Zatem E(SN − ESN )3 = 2e24 . Analogicznie pokazujemy

VarSN = E(SN − ESN )2 = EN E(X − EX)2 + VarN (EX)2 = 2EX 2 .

5

Mamy

EX 2 = E exp(2σZ + 2µ) = e2σ

2

+2µ

= e12 .

czyli VarSN = E(SN − ESN )2 = 2e12 . Obliczamy

2e24

E(SN − ESN )3

e6

√

=

=

.

3

(VarSN )3/2

2

(2e12 ) 2

10. (Eg 59/1) Zmienna losowa X rozkład logarytmiczno-normalny LN (µ, σ 2 ), gdzie µ = 1 i σ 2 = 4.

Wyznacz E(X−e|X>e)

.

EX

Odp: C-> 1, 82.

Rozwiązanie. Zauważmy, że X = eY , gdzie Y ma rozkład N (µ, σ 2 ), nadto Y = σZ + µ = 2Z + 1,

gdzie Z pochodzi z rozkładu N (0, 1). Z definicji

E(X − e|X > e) =

E1X>e (X − e)

.

P(X > e)

Obliczamy

P(X > e) = P(2Z + 1 > 1) = P(Z > 0) =

Zatem

1

.

2

1

E1X>e (X − e) = eE1Z>0 (e2Z − 1) = e(E1Z>0 e2Z − ).

2

Nadto

E1Z>0 e2Z =

Z

∞

e2x e−

x2

2

0

a stąd

E1Z>0 e2Z = e2

Z

1

√ dx = e2

2π

∞

e−

−2

x2

2

Z

∞

e−

(x−2)2

2

0

1

√ dx

2π

1

√ dx = e2 P(Z > −2).

2π

Otrzymujemy

E(X − e|X > e) = 2e3 P(Z > −2) − e

z drugiej strony z transformaty Laplace’a

EX = E exp(2Z + 1) = e3 .

Czyli

E(X − e|X > e)

= 2P(Z > −2) − e−2 ' 1, 82.

EX

11. (Eg 60/6) Zmienne losowe X1 , X2 , ..., X20 są niezależne o jednakowym rozkładzie normalnym o

P5

wartości oczekiwanej 1 i wariancji 4. Niech S5 = i=1 Xi i E(S52 |S20 = 24) jest równa ?

Odp: D-> 51.

P20

Rozwiązanie. Niech S15 = i=6 Xi . Z jednej strony S20 = S5 + S15 nadto szukamy α takiego,

że

0 = Cov(S5 + S15 , S5 − αS15 ) = Var(S5 ) − αVar(S15 ) = 5 · 4 − α15 · 4 = 20(1 − α3).

Stąd α = 3. Oczywiście

S5 =

1

1

1

1

[(S5 + S15 ) + 3(S5 − S15 )] = [S20 + 3(S5 − S15 )].

4

3

4

3

6

Zatem

E(S52 |S20

=

!

2

1

1

S20 + 3(S5 − S15 ) |S20 =

16

3

= 24) = E

1 2

1

9

1

3

S + S20 E(S5 − S15 ) + E(S5 − S15 )2 .

16 20 8

3

16

3

Sprawdzamy

1

15

80

1

·4=

.

E(S5 − S15 ) = 0, E(S5 − S15 )2 = 5 · 4 +

3

3

9

3

Zatem

E(S52 |S20 = 24) =

1 2

9 80

S20 +

= 36 + 15 = 51.

16

16 3

12. (Eg 61/6) Rozważmy następujące zagadnienie testowania hipotez statystycznych. Dysponujemy

próbką X1 , ..., Xn z rozkładu normalnego o nieznanej średniej µ i znanej wariancji równej 2. Przeprowadzamy najmocniejszy test hipotezy H0 : µ = 0 przeciwko alternatywie H1 : µ = 2 na

poziomie istotności α = 21 . Niech βn oznacza prawdopodobieństwo błędu drugiego rodzaju, dla

rozmiaru próbki n. Wybierz poprawne stwierdzenie: (asymptotyka βn ).

n

Odp: E-> limn→∞ e−n /β√

= 1.

4πn

Rozwiązanie. Niech f0 , f2 będą gęstościami odpowiednio N (0, 2), N (2, 2). Przypomnijmy, że test

najmocniejszy Neymana Pearsona polega na porównaniu gęstości, czyli zbiór krytyczny ma postać

f2 (x1 , ..., xn )

> C},

f0 (x1 , ..., xn )

K = {(x1 , ..., xn ) ∈ Rn :

gdzie C jest stałą taką, że

Pµ=0 ((X1 , ..., Xn ) ∈ K) =

1

.

2

Łatwo zauważyć, że

K = {(x1 , ..., xn ) :

n

X

xi > C̄}.

i=1

Stąd szukamy stałej C̄ takiej, że

Pµ=0 (X1 + ... + Xn > C̄) =

1

2

stąd C̄ = 0. Błąd drugiego rodzaju to akceptacja hipotezy H0 podczas, gdy zachodzi H1 . Oznacza

to, że

βn = Pµ=2 (X1 + ... + Xn 6 0).

√

Przy µ = 2 zachodzi Xi = 2Zi + 2, gdzie Z, Zi , i = 1, 2, . . . będą niezależne z rozkładu N (0, 1).

Stąd

√

√

√

βn = P( 2(Z1 + ... + Zn ) 6 −2n) = P( 2nZ 6 −2n) = P(Z 6 − 2n).

Ponieważ P(Z > t) '

2

t

√ 1 e− 2

2πt

, więc

lim

n→∞

βn

√

e−n /

4πn

= 1.

7

13. (Eg 62/2) Niech X1 , X2 , X3 , ... będą niezależnymi zmiennymi losowymi o tym samym rozkładzie

logarytmiczno normalnym parametrami µ ∈ R i σ > 0. Niech Tn oznacza estymator największej

wiarygodności wariancji V 2 w tym modelu w oparciu o próbę X1 , X2 , ..., Xn . Niech µ = −0, 5 i

σ = 1. Wtedy

√

P(|Tn − V 2 | n > 10, 73) =?

Odp: A-> 0, 134.

Rozwiązanie. Zachodzi Xi = eYi , i = 1, 2, ..., n, gdzie Y, Y1 , Y2 , ..., Yn są niezależne i pochodzą

z rozkładu N (µ, σ 2 ). Trzeba przypomnieć estymatory największej wiarygodności dla rozkładu

normalnego

n

1X

1

(Yi − Ȳ )2 .

µ̄n = Ȳ = (Y1 + ... + Yn ), σ̄n2 = Y¯2 − (Ȳ )2 =

n

n i=1

Powyższe estymatory wykorzystujemy aby znaleźć estymator wariancji V 2 . Mamy

V 2 = VarY = EY 2 − (EY )2 = e2σ

2

+2µ

− eσ

2

+2µ

= e − 1.

Nadto z powyższego wzory wynika, że

2

2

Tn = e2µ̄n (e2σ̄n − eσ̄n ).

Należy pamiętać, że µ̄n i σ̄n2 są niezależne. Mamy

2

2

Tn − V 2 = (e2µ̄n − e−1 )(e2σ̄n − eσ̄n )+

2

2

+ e−1 (e2σ̄n − e2 − eσ̄n − e).

Z mocnego prawa wielkich liczb wynika, że µ̄n → µ, σ̄n2 → σ 2 prawie na pewno. Nadto

√

√

√ 2µ̄n

n(e

− e−1 ) = ne−1 (e2µ̄n +1 − 1) = ne−1 (2µ̄n + 1)(1 + O(2µ̄n + 1)).

Oczywiście w sensie słabej zbieżności

lim

√

n→∞

Stąd

lim

√

n→∞

n(2µ̄n + 1) = N (0, 4).

2

2

n(e2µ̄n − e−1 )(e2σ̄n − eσ̄n ) = A ' N (0, [2(e − 1)]2 )

Ściślej korzystając z σ̄n2 → σ 2

√

√

2

2

lim n(e2µ̄n − e−1 )(e2σ̄n − eσ̄n ) = lim n(e2µ̄n − e−1 )(e2 − e) = A.

n→∞

Analogicznie

n→∞

√

2

2

e2σ̄n − e2 + eσn − e = (2e2 − e) n(σ̄n2 − 1)(1 + O(σ̄n2 − 1)).

W sensie słabej zbieżności

lim

n→∞

Zatem

2

√

n(σ̄n2 − 1) = N (0, 2).

2

lim e−1 (e2σ̄n − e2 − eσ̄n − e) = B ' N (0, 2[2e − 1]2 ).

n→∞

Ostatecznie korzystając z niezależności µ̄n oraz σ̄n2 dostajemy dla niezależnych A i B

√

lim n(Tn − V 2 ) = A + B ' N (0, [2(e − 1)2 ] + 2[2e − 1)]2 ).

n→∞

Niech Z będzie z N (0, 1) otrzymujemy

√

lim P(|Tn − V 2 | n > 10, 73) = P(|Z| > p

n→∞

10, 73

[2(e − 1)2 ] + 2[2(e − 2)]2

) = 0, 134.

Przedstawiona metoda ma swoją nazwę jako metoda delta. Powyższy przypadek szczególny można

zebrać w ogólne twierdzenie.

8

Twierdzenie 1 (Metoda delta) Jeżeli dla ciągu zmiennych Tn mamy

przy n → ∞ i h : R → R jest funkcją różniczkowalną w punkcie µ, to

√

n(h(Tn ) − h(µ)) → N (0, σ 2 (h0 (µ))2 ),

√

n(Tn − µ) → N (0, σ 2 )

w sensie zbieżności według rozkładu.

14. (Eg 63/7) Zmienna losowa (X, Y, Z) ma rozkład normalny z wartością oczekiwaną EX = 0,

EY = EZ = 1 i macierzą kowariancji

1 1 0

1 4 2 .

0 2 4

Obliczyć Var(X(Y + Z)).

Odp: D-> 17.

Rozwiązanie. Stosujemy metodę z uniezależnianiem zmiennych. Z założenia wynika, że Cov(X, Y ) =

1 oraz Cov(X, Z) = 0, Cov(Y, Z) = 2. Zatem zmienne X i Z są niezależne, Wystarczy dobrać α

i β tak aby Y − αX − βZ było niezależne (czyli równoważnie nieskorelowane) ze zmiennymi X i

Z. Sprawdzamy, że

Cov(Y − αX − βZ, X) = 1 − α, czyli α = 1

nadto

Cov(Y − αX − βZ, Z) = 2 − 4β, czyli β =

1

.

2

Zatem baza liniowa składa się ze zmiennych niezależnych X, Ȳ = Y − X − 12 Z, Z, gdzie X ma

rozkład N (0, 1), zmienna Ȳ ma rozkład N ( 12 , 2), a zmienna Z rozkład N (1, 4). Obliczamy

Var(X(Y + Z)) = Var(XY ) + 2Cov(XY, XZ) + Var(XZ) =

1

1

= Var(X Ȳ ) + 2Cov(X Ȳ , X(X + Z)) + Var(X(X + Z))+

2

2

1

+ 2Cov(X Ȳ , XZ) + 2Cov(X(X + Z), XZ) + Var(XZ) =

2

1

= EX 2 EȲ 2 + EX 2 EȲ EZ + EX 4 − (EX 2 )2 + EX 2 EZ 2 +

4

1

1

5

+ 2EX 2 EȲ EZ + 2EX 2 EZ 2 = (2 + ) + + 2 + + 1 + 10 = 17.

4

2

4

15. (Eg 64/9) Niech Y1 , Y2 , ..., Yn będą niezależnymi zmiennymi losowymi, przy czym zmienna Yi ,

i = 1, 2, ..., n, ma rozkład logarytmiczno-normalny LN

i , 1), gdzie x1 , x2 , ..., xn są znanymi

P(bx

n

liczbami, a b jest nieznanym parametrem. Załóżmy, że i=1 x2i = 4. Niech b̄ będzie estymatorem

największej wiarogodności parametru b, a ḡ = exp(2b) estymatorem funkcji g(b) = exp(2b). Wtedy

obciążenie estymatora ḡ

Eb ḡ − g(b)

jest równe

√

Odp: B-> e2b ( e − 1).

Rozwiązanie. Najpierw obliczamy wiarygodność dla zmiennych Z1 , Z2 , ..., Zn , gdzie Zi = ln Yi ,

czyli Zi ma postać N (bxi , 1). Obliczamy wiarygodność dla Z1 , ..., Zn

n

n

L(b, z) = (2π)− 2 exp(−

9

1X

(zi − bxi )2 ).

2 i=1

Rozwiązujemy równanie f 0 (b) = 0 dla f (b) = ln L(b, z). Wówczas

n

X

hx, zi

1

(zi − bxi )xi = 0, czyli b =

= hx, zi.

hx,

xi

4

i=1

Stąd

n

b̄ =

1X

xi Z i .

4 i=1

Pozostaje zauważyć, że b̄ ma rozkład N (b, 41 ). Stąd

1

Eb ḡ − g(b) = Eb exp(2b̄) − e2b = e2b (e 2 − 1).

10

1

Parametry rozkładów

W tej serii będziemy obliczać różne parametry zmiennych losowych. Wymagana jest znajomość własności

rozkładów probabilistycznych oraz umiejętne korzystanie z niezależności zmiennych losowych.

1. (Eg 48/7) Niech X1 , X2 , ..., Xn , ... będą niezależnymi zmiennymi losowymi o jednakowym rozkładzie wykładniczym o gęstości

f (x) = 2e−2x gdyx > 0 oraz f (x) = 0 gdy x 6 0.

Niech N będzie zmienną losową, niezależną od X1 , X2 , ..., Xn , ..., o rozkładzie ujemnym dwumiar

n

nowym P(N = n) = Γ(r+n)

Γ(r)n! p (1 − p) dla n = 0, 1, 2, ..., gdzie r > 0 i p ∈ (0, 1) są ustalonymi

parametrami. Niech ZN = min(X1 , X2 , ..., XN ), gdy N > 0 oraz ZN = 0, gdy N = 0. Oblicz

E(N ZN ) i Var(N ZN ).

2r

r

i Var(N ZN ) = 1−p

Odp: C-> E(N ZN ) = 1−p

2

4 .

Rozwiązanie. Dla zmiennej Z z rozkładu wykładniczego Exp(λ) zachodzi EZ = λk!k , k =

0, 1, 2, . . .. Przypomnijmy, ze minimum z niezależnych zmiennych wykładniczych ma rozkład wykładniczy o parametrze będącym sumą parametrów dodawanych zmiennych. To znaczy rozkład Z

1

oraz EZn2 = 2n1 2 oraz EZ0 = EZ02 = 0. Obliczamy

ma postać Exp(2n). W szczególności EZn = 2n

E(N ZN ) =

∞

X

P(N = n)nEZn =

n=0

∞

X

E(N ZN )2 =

∞

1X

1

P(N = n) = (1 − pr ),

2 n=1

2

P(N = n)n2 EZn2 =

n=0

∞

X

n=1

=

∞

1X

1

P(N = n) = (1 − pr ).

2 n=1

2

Stąd

Var(N ZN ) =

1

1

(2 − 2pr − 1 + 2pr − p2r ) = (1 − p2r ).

4

4

2. (Eg 49/3) Niech X1 , X2 , ..., Xn , ... I1 , I2 , ..., In , ..., N będą niezależnymi zmiennymi losowymi. Zmienne

X1 , X2 , ..., Xn , ... mają rozkład o wartości oczekiwanej 2 i wariancji 1. Zmienne I1 , I2 , ..., In , ...

mają rozkład jednostajny na przedziale (0, 1). Zmienna N ma rozkład ujemny dwumianowy

PN

P(N = n) Γ(2+n)

( 43 )2 ( 14 )n dla n = 0, 1, 2, ... Niech SN = 0, gdy N = 0 oraz SN = i=1 Ii Xi ,

n!

gdy N > 0. Wtedy Var(SN ) jest równa: ?

Odp: C-> VarSN = 34 .

Rozwiązanie. Przypomnijmy własności rozkładu ujemnego dwumianowego EN = 2( 34 )−1 ( 41 ) = 23

oraz VarN = 2( 34 )−2 14 = 89 i EN 2 = 43 . Niech X ma rozkład taki jak X1 , X2 , . . . nadto I ma rozkład

taki jak I1 , I2 , . . . Mamy

ESN =

∞

X

P(N = n)ESn =

n=0

∞

X

P(N = n)nEIEX =

n=0

∞

X

P(N = n)n = EN.

n=1

Nadto

2

ESN

=

∞

X

n=0

=

P(N = n)ESn2 =

∞

X

P(N = n)(nEX 2 EI 2 + n(n − 1)(EXEI)2 ) =

n=0

∞

X

2

2

P(N = n)(n(n + )) = EN (N + ).

3

3

n=0

Czyli

2

4 4 4

4

VarSN = EN 2 + EN − (EN )2 = + − = .

3

3 9 9

3

1

3. (Eg 50/1) Niech X1 , X2 , ..., Xn , ... będą niezależnymi zmiennymi losowymi z rozkładu gamma o

gęstości

p(x) = 16xe−4x , gdy x > 0, oraz p(x) = 0 gdyx 6 0.

Niech N będzie zmienną losową niezależna od zmiennych X1 , X2 , ..., Xn , ... spełniającą

1

1

, i P(N = 1) = P(N = 2) = P(N = 3) = .

2

6

PN

Niech S = 0, gdy N = 0 oraz S = i=1 Xi , gdy N > 0. Wtedy E(S − ES)3 jest równe ?.

7

Odp: B-> 16

.

P(N = 0) =

Rozwiązanie. Przypomnijmy momenty dla zmiennej Z z rozkładu Gamma(α, β) zachodzi

EZ =

2α

α

α

, E(Z − EZ)2 = 2 , E(Z − EZ)3 = 3 .

β

β

β

W przypadku zadania α = 2, β = 4, stąd

EX =

1

1

1

, E(X − EX)2 = , E(X − EX)3 =

.

2

8

16

Podobnie wyznaczamy

EN = 1, E(N − EN )2 =

4

, E(N − EN )3 = 1.

3

Zatem

E(S − ES)3 = E(S − N EX + N EX − ES)3 = EE[(S − N EX + N EX − ES)3 |N ] =

= EN E(X − EX)3 + 3E(N − EN )2 EXE(X − EX)2 + E(N − EN )3 (EX)3 =

4 1 1 1

7

1

+3· · · + =

.

=

16

3 2 8 8

16

4. (Eg 51/7) Załóżmy, że X1 , X2 , ..., Xn , ... są niezależnymi zmiennymi losowymi o jednakowym rozkładzie wykładniczym o gęstości

f (x) = exp(−x) dla x > 0.

Zmienna losowa N jest niezależna od X1 , X2 , ..., Xn , ... i ma rozkład Poissona o wartości oczekiwanej λ. Niech

Yi = min(Xi , 2), Zi = Xi − Yi ,

S (Y ) =

N

X

Yi , S (Z) =

i=1

N

X

Zi .

i=1

Oblicz Cov(S (Y ) , S (Z) ).

Odp: A-> Cov(S (Y ) , S (Z) ) = 2λe−2 .

Rozwiązanie. Niech Y, Z będą miały rozkład odpowiednio jak X1 , X2 , . . ., Y1 , Y2 , . . .. Wyznaczamy

ES (Y ) = EN EY = λEY

oraz

ES (Z) = EN (EX − EY ) = λEZ.

2

Wyznaczamy

ES (Y ) S (Z) =

∞

X

n

n

∞

X

X

X

P(N = n)E(

Yi ,

Zi ) =

P(N = n)(nE(Y Z) + n(n − 1)EY EZ) =

n=0

i=1

n=0

i=1

= EN E(Y Z) + E(N (N − 1))EY EZ = λE(Y Z) + λ2 EY EZ.

Mamy

Z

∞

P(X > 2 + t)dt = 2e−2 .

E(Y Z) = 2E(X − 2)+ = 2

t=0

Stąd

Cov(S (Y ) , S (Z) ) = 2λe−2

5. (Eg 52/8) Załóżmy, że X1 , X2 , ..., Xn , ... są niezależnymi zmiennymi losowymi o tym samym rozkładzie jednostajnym na przedziale [0, 1], zaś N jest zmienną losową o rozkładzie ujemnym dwumianowym:

n+2 3

P(N = n) =

p (1 − p)n dla n = 0, 1, 2, ...

n

niezależną od zmiennych losowych X1 , X2 , ..., Xn , ... Niech MN = max{X1 , X2 , ..., XN }, gdy N > 0

oraz MN = 0, gdy N = 0. Statystyk otrzymał trzy niezależne obserwacje zmiennej losowej MN

równe

1

0, 0, .

2

Wartość estymatora największej wiarogodności dla parametru p otrzymana na podstawie tych

danych jest równa ?

Odp: B-> 0, 877.

Rozwiązanie. Zadanie należy rozwiązać przez wyznaczenie wiarygodności, skoro wśród obserwacji

pojawiły się dwa zera to znaczy, że dwukrotnie pojawiło się zdarzenie o prawdopodobieństwie p3 .

Z drugiej strony szansa otrzymania wartości 0 < t 6 1 wynosi

∞

X

P(N = n)P(max(X1 , ..., Xn ) 6 t) =

∞

X

P(N = n)tn =

n=1

n=1

p3

,

(1 − t(1 − p))3

gdzie ostatnia równość bierze się ze zmiany parametru w rozkładzie ujemnym dwumianowym.

Zatem warunkowo na N > 0 zmienna MN ma rozkład ciągły o gęstości

3p3 (1 − p)

.

(1 − t(1 − p))4

Stąd wiarygodność będzie miała postać

1

48p9 (1 − p)

L(p, (0, 0, ))) =

.

2

(1 + p)4

Znajdujemy maksimum f (p) = log L(p, (0, 0, 12 )),

1

1

1

0 = f 0 (p) = 9 −

−4

.

p 1−p

1+p

Stąd równanie

√

−5 + 406

6p + 5p + 9 = 0, p =

' 0, 877.

12

2

3

6. (Eg 53/2) Niech X0 , X1 , ..., Xn , ... będą niezależnymi zmiennymi losowymi o rozkładzie jednostajnym na przedziale (0, 2). Niech zmienna losowa N oznacza numer pierwszej ze zmiennych losowych

X1 , ..., Xn , ... o wartości większej niż X0 , zatem

N = inf{n > 1 : Xn > X0 }.

Wtedy EXN jest równa?

Odp: C-> 32 .

Rozwiązanie. Dla ustalonego X0 = x ∈ (0, 2) rozkład Nx = inf{n >: Xn > x} jest rozkładem

geometrycznym z prawdopodobieństwem sukcesu (1 − x). Dalej rozkład XN dla ustalonego N i

X0 ma rozkład jednostajny na (x, 2) ze średnią x+2

2 . Zatem

EXN = EE(XN |X0 , N ) = E

X0 + 2

3

= .

2

2

7. (Eg 54/4) Zmienna losowa N ma rozkład geometryczny postaci

1 3

P(N = k) = ( )k dla k = 0, 1, 2, ...

4 4

Rozważamy losową liczbę zmiennych losowych X1 , X2 , ..., XN przy czym zmienne losowe X1 , X2 , ..., XN

są niezależne wzajemnie i niezależne od zmiennej losowej N . Każda ze zmiennych Xi ma ten sam

rozkład o parametrach

EX = 1, E(X 2 ) = 2, E(X 3 ) = 3.

3

PN

Niech SN = i=1 Xi , gdy N > 0 oraz SN = 0, gdy N = 0. Współczynnik skośności E(SN −ESN3 )

(VarSN ) 2

Odp: B-> 2, 538.

Rozwiązanie. Przypomnijmy, że

E(S − ES)3 = E(S − N EX + N EX − ES)3 = EE[(S − N EX + N EX − ES)3 |N ] =

= EN E(X − EX)3 + 3E(N − EN )2 EXE(X − EX)2 + E(N − EN )3 (EX)3 .

Dla rozkładu geometrycznego (startującego z 0) z parametrem p

EN =

1−p

(1 − p)

(1 − p)(2 − p)

, E(N − EN )2 =

, E(N − EN )3 =

.

p

p2

p3

Stad

EN =

1

4

20

, E(N − EN )2 = , E(N − EN )3 =

.

3

9

27

Dalej

EX = 1, E(X − EX)2 = 1, E(X − EX)3 = −1.

Dostajemy

1 4 20

E(S − ES)3 = − + +

3 3 27

Podobnie

E(S − ES)2 = EN E(X − EX)2 + E(N − EN )2 (EX)2 =

1 4

7

+ = .

3 9

9

Współczynnik skośności

E(SN − ESN )3

(VarSN )

3

2

=

47

3

(7) 2

' 2, 538.

4

8. (Eg 55/7) Zmienna losowa N ma rozkład geometryczny

P(N = n) = pn (1 − p), dla n = 0, 1, 2, ...,

gdzie p ∈ (0, 1) jest nieznanym parametrem. Rozważamy losową liczbę zmiennych losowych

X1 , X2 , ..., XN ,

przy czym zmienne losowe X1 , X2 , ..., XN są niezależne wzajemnie i niezależne od zmiennej losowej

N . Każda ze zmiennych Xi ma rozkład jednostajny o gęstości danej wzorem: fθ (x) = 1/θ, dla

0 6 x 6 θ oraz 0 w przeciwnym przypadku, gdzie θ > 0 jest nieznanym parametrem. Obserwujemy

tylko te spośród zmiennych X1 , X2 , ..., XN , które są większe od 5. Nie wiemy ile jest pozostałych

zmiennych ani jakie są ich wartości. Przypuśćmy, że zaobserwowaliśmy następujące wartości

8.5, 10, 6, 7.4, 9, 5.2.

Na podstawie tych danych wyznacz wartości estymatorów największej wiarogodności parametrów

θ i p.

12

.

Odp: C-> θ̂ = 10 i p̂ = 13

Rozwiązanie. Niech X ma rozkład taki jak X1 , X2 , . . .. Znajdujemy wiarygodność, szansa że

wylosujemy 6 zmiennych większych niż 5 wynosi

∞ X

n + 6 5p n

(P(X > 5))

P(X 6 5) P(N = n + 6) = (P(X > 5)) (1 − p)p

( ) .

6

θ

n=0

n=0

6

∞

X

n

6

6

Warunkowo względem wymagania, że 6 zmiennych przekroczyło 5 ma gęstość postaci

6

5 Y

1x <θ .

(P(X > 5))−6 ( )6

θ i=1 i

Nadto z własności rozkładu ujemnego dwumianowego

∞ X

n + 6 5p n

5p

( ) = (1 − )−7

6

θ

θ

n=0

Stąd wiarygodność ma postać

6

5p 6 Y

5p

L(θ, p; x1 , x2 , x3 , x4 , x5 , x6 ) = (1 − p)( )

1x <θ (1 − )−7 .

θ i=1 i

θ

Najpierw zauważamy, że θ > 10 (w przeciwnym razie dostajemy 0) nadto dla θ > 0 funkcja L jest

malejąca czyli zatem θ̂ = 10. Wówczas wystarczy znaleźć p dla którego maksimum osiąga funkcja

L(10, p; x1 , x2 , x3 , x4 , x5 , x6 ). To oznacza, że trzeba znaleźć punkt maksimum funkcji

1

f (p) = (1 − p)p6 (1 − p)−7 .

2

Warunek f 0 (p) = 0 jest równoważny

1

7

7

(6p5 − 7p6 )(1 − p) + p6 − p7 .

2

2

2

Stąd p̄ =

12

13 .

5

9. (Eg 56/6) Załóżmy, że X1 , X2 , ..., Xn , ... są niezależnymi zmiennymi losowymi o tym samym rozkładzie jednostajnym na przedziale [0, 1], zaś N jest zmienną losową o rozkładzie geometrycznym,

P(N = k) = p(1 − p)k , gdy k = 0, 1, 2, ...

niezależną od zmiennych losowych X1 , X2 , ..., Xn , ... Liczba p ∈ (0, 1) jest ustalona. Niech YN =

min{X1 , ..., XN }, gdy N > 0 oraz YN = 0, gdy N = 0 i ZN = max{X1 , ..., XN }, gdy N = 0.

Obliczyć P(ZN − YN > 21 ).

4p

Odp: B-> 1 − (1+p)

2.

Rozwiązanie. Zacznijmy od prostszego zadania, rozkład (Yn , Zn ) ma gęstość n(n−1)(z−y)n−2 10<y<z<1 .

Zatem

Z 1 Z z− 12

Z 1

1

1

1

1

n−2

P(Zn − Yn > ) =

n(n − 1)(z − y)

n(z n−1 − ( )n−1 )dz = 1 − n − n n .

dydz =

1

1

2

2

2

2

0

2

2

Stąd

1

1

1

1

) = EP(ZN − YN > |N ) = E(1 − N − N N ) =

2

2

2

2

∞

X

4p

2p

2p(1 − p)

1−

(1 + k)p[(1 − p)2−1 ]k = 1 −

−

=1

.

1+p

(1 + p)2

(1 + p)2

P(ZN − YN >

k=0

10. (Eg 57/4) Niech X1 , X2 , ..., Xn , ... I1 , I2 , ..., In , ..., N będą niezależnymi zmiennymi losowymi. Zmienne

X1 , X2 , ..., Xn , ... mają rozkład wykładniczy o wartości oczekiwanej 1. Zmienne I1 , I2 , ..., In , ...

mają rozkład dwupunktowy P(Ii = 1) = 1 − P(Ii = 0) = 21 . Zmienna N ma rozkład ujemny

3 2 1 n

Niech SN = 0, gdy N = 0 oraz

dwumianowy P(N = n) = n+1

n ( 4 ) ( 4 ) dla n = 0, 1, 2, .... √

PN

Var(SN )

SN = i=1 Ii Xi , gdy N > 0. Wtedy współczynnik zmienności

jest równy: ?

ESN

q

13

Odp: C->

2 .

Rozwiązanie. Niech X, I mają rozkład taki jak odpowiednio X1 , X2 , . . ., I1 , I2 , . . .. Obliczamy

EN = 2/3, VarN = 8/9 (rozkład ujemny dwumianowy B− (α, p) ma wartość oczekiwana α 1−p

p

1

i wariancję α 1−p

),

EI

=

,

EX

=

1,

VarX

=

1

(rozkład

wykładniczy

Exp(λ)

ma

wartość

p2

2

oczekiwaną λ i wariancję 1/λ2 ). Zatem

1 3 1

1

ESN = EN EIEX = 2( / ) = .

4 4 2

3

Z drugiej strony

VarSN = EN Var(IX) + VarN (EIX)2 = EN (EI 2 EX 2 − (EIEX)2 ) + VarN (EIEX)2 =

2 1

1

8 1

1 2

13

= ( · 2 − ( )2 ) + ( )2 = + =

.

3 2

2

9 2

2 9

18

Czyli

p

√

Var(SN )

13

= √ .

ESN

2

11. (Eg 59/8) Załóżmy, że X1 , X2 , ..., Xn , ... są dodatnimi niezależnymi zmiennymi losowymi o jednakowym ciągłym rozkładzie prawdopodobieństwa. Niech R0 = 0 i Rn = max{X1 , ..., Xn }, gdy

n > 0. Niech N i M będą niezależnymi zmiennymi losowymi o rozkładach Poissona, przy czym

6

EN = 1 i EM = 2. Wtedy P(RN +M > RN ) jest równe?

Odp: C-> 23 (1 − e−3 ).

Rozwiązanie. Zauważmy, że dla n + m > 0

P(Rn+m > Rn ) =

m

,

n+m

bo szanse, że któraś ze zmiennych jest największa są równe a szansa, że dwie zmienne przyjmują

tę samą wartość jest zerowa. Zatem

P(RN +M > RN ) = EP(RN +M > RN |N, M ) = E

M

1N +M >0 .

N +M

Przypomnijmy, że rozkład warunkowy M pod warunkiem N + M ma postać B( ENEM

+EM , N + M )

nadto N + M ma rozkład P oiss(EN + EM ). Czyli

E

M

1

2

2

1N +M >0 = E

1N +M >0 E(M |N + M ) = E1N +M >0 = (1 − e−3 ).

N +M

N +M

3

2

12. (Eg 60/2) Zmienne losowe X1 , X2 , ..., Xn są warunkowo niezależne przy znanej wartości zmiennej

losowej θ i mają rozkłady o wartości oczekiwanej E(Xi |θ) = 10θ i wariancji Var(Xi |θ) = 100θ2 .

Niech N będzie zmienną losową warunkowo niezależną od X1 , X2 , ..., Xn przy znanym θ i o warunkowym rozkładzie

P(N = n|θ) = n(1 − θ)n−1 θ2 , dla n = 1, 2, 3, ...

Zmienna losowa θ ma rozkład Beta o gęstości p(θ) = 6θ(1−θ), gdy θ ∈ (0, 1). Niech SN =

Wtedy wariancja Var( SNN ) jest równa?

Odp: C-> 25.

P∞

Rozwiązanie. Zauważmy, że E(N −1 |θ) = θ2 n=1 (1 − θ)n−1 = θ, zatem

PN

i=1

Xi .

SN 2

SN − N E(X|θ)

SN 2

SN

−E

) = EE[(

+ E(X|θ) − E

) |θ] =

N

N

N

N

= E[E(N −1 |θ)Var(X|θ)] + Var(E(X|θ)) = 100Eθ3 + 100Var(θ) =

E(

R1

R1

R1

3

Dalej Eθ3 = 6 0 θ4 (1 − θ)dθ = 15 , Eθ2 = 6 0 θ3 (1 − θ)dθ = 10

, Eθ = 6 0 θ2 (1 − θ) = 21 , stąd

1

α

VarX = 20

. Ogólnie można pamiętać wzór że dla rozkładu Beta(α, β), EX = α+β

, VarX =

αβ

(α+β)2 (α+β+1) ,

w zadaniu α = 2, β = 2. Czyli

Var

SN

= 20 + 5 = 25

N

13. (Eg 61/10) Niech X1 , X2 , ..., Xn , ... będą niezależnymi zmiennymi losowymi o rozkładzie wykładniczym o wartości oczekiwanej 4. Niech N będzie zmienną losową o rozkładzie geometrycznym o

funkcji p-stwa

4 1

P(N = k) = · ( )k dla k = 0, 1, 2, ...,

5 5

PN

niezależną od zmiennych X1 , X2 , ..., Xn , ... Niech Sn = i=1 Xi , gdy N > 0 oraz SN = 0 gdy

N = 0. Wtedy P(SN < 5) jest równe: ?

Odp: C-> 1 − 0, 2e−1 .

7

Rozwiązanie. Przypomnijmy, że Sn , n > 1 ma rozkład Gamma(n, 41 ) Obliczamy

P(SN > 5) = EP(SN > 5|N ) =

∞

X

P(Sn > 5)P(N = n) =

n=1

=

4

5

Z

∞

(

5

∞

X

n−1

∞ Z

X

n=1

1

1

x

)e− 4 x dx =

n

(n

−

1)!(20)

25

n=1

∞

Z

1

1

e( 20 − 4 )x dx =

n=5

∞

5

1

1

xn−1 e− 4 x dx =

(n − 1)!4n

1 −1

e .

5

Stąd P(SN < 5) = 1 − 0, 2e−1 .

14. (Eg 62/9) Niech X1 , ..., Xn , ... będą niezależnymi zmiennymi losowymi z rozkładu jednostajnego na

przedziale [0, 1]. Niech N będzie zmienną losową o rozkładzie ujemnym dwumianowym niezależną

od zmiennych X1 , ..., Xn , ... o funkcji p-stwa

P(N = n) =

(n + 2)(n + 1) 3

p (1 − p)n , dla n = 0, 1, 2, ...

2

Niech YN = min{X1 , ..., XN }, gdy N > 0 oraz YN = 0, gdy N = 0 i ZN = max{X1 , ..., XN }, oraz

ZN = 0 gdy N = 0. Wyznacz E(YN ZN ).

2

)

.

Odp: E-> p(1−p

2

Rozwiązanie. Przypomnijmy, że (Yn , Zn ) ma rozkład o gęstości n(n − 1)(z − y)n−2 106y<z61 .

R1

Nadto z rozkładu beta wiemy, że 0 xα−1 (1 − x)β−1 dx = Γ(a)Γ(b)

Γ(a+b) Zatem podstawiając y = zw

1

Z

Z

z

n−2

n(n − 1)yz(z − y)

EYn Zn =

0

Z

dydz = n(n − 1)

0

1

z

n+1

Z

1

dz

0

w(1 − w)n−2 dw =

0

1

.

n+2

Stąd

∞

X

(n + 1) 3

1

1N >0 =

p (1 − p)n .

N +2

2

n=1

P∞

Z ujemnego rozkładu dwumianowego wiemy, że n=0 (n + 1)p2 (1 − p)n = 1. Zatem

E(YN ZN ) = EE(YN ZN |N ) = E

E(YN ZN ) = −

p3

p

p(1 − p2 )

+ =

.

2

2

2

15. (Eg 63/6) Niech X1 będzie zmienną losową o rozkładzie jednostajnym na przedziale (0, 1), X2

zmienną losową o rozkładzie jednostajnym na przedziale (0, X1 ), X3 zmienną losową o rozkładzie

jednostajnym na przedziale (0, X2 ) i tak dalej. Niech N oznacza zmienną losową, taką że

P(N = n) =

λn

, gdy n = 1, 2, 3, ...,

n!(eλ − 1)

gdzie λ > 0 jest ustaloną liczbą. Zmienna N jest niezależna od zmiennych X1 , X2 , X3 , .... Wtedy

E(N !X1 · X2 · ... · XN ) jest równa

eλ −λ−1

Odp: D-> λ(e

λ −1) .

Rozwiązanie. Zaważmy, że

E(X1 ...Xn ) = E(X1 ...Xn−1 )E(Xn |X1 , ..., Xn−1 ) = E(X1 ...Xn−2 )

= E(X1 ...Xn−2 )E(

2

Xn−1

1

|X1 , ..., Xn−2 ) = ... =

.

2

(n + 1)!

8

2

Xn−1

=

2

Zatem

EN !(X1 ...XN ) =

=

∞

X

λn

1

=

λ − 1) n + 1

n!(e

n=0

∞

X

eλ − λ − 1

λn

=

.

(n + 1)!(eλ − 1)

λ(eλ − 1)

n=1

9

1

Testowanie hipotez

W tej części rozwiązane zostaną zadania dotyczące testowania hipotez. Wymagana jest wiedza z zakresu

najmocniejszych testów, ilorazu wiarygodności, parametrów testów statystycznych.

1. (Eg 52/1) Niech X1 , X2 , ..., X8 będzie próbką z rozkładu prawdopodobieństwa Pareto o dystrybuancie

1

Fθ (x) = 1 − θ dla x 6 1 oraz Fθ (x) = 0 dla x < 1,

x

gdzie θ > 0 jest nieznanym parametrem. Rozpatrzmy zadanie testowania hipotezy H0 : θ = 2

przeciwko alternatywie H1 : θ = 4. Zbudowano taki test, dla którego suma prawdopodobieństw

błędów I i II rodzaju, oznaczanych odpowiednio przez α i β, jest najmniejsza. Oblicz tę najmniejszą

wartość α + β.

Odp: B-> 0, 3336.

Rozwiązanie. Niech fθ (x) = θxθ+1 będzie gęstością rozkładu Pareto. Testem który dla ustalonego

błędu pierwszego rodzaju (równego α) minimalizuje błąd drugiego rodzaju jest test NeymanaPearsona, którego obszar krytyczny ma postać

Q8

f4 (xi )

> C},

K = {(x1 , .., x8 ) : Q8i=1

i=1 f2 (xi )

gdzie C jest dobrane tak aby Pθ=2 (X ∈ K) = α. Nietrudno zauważyć, że K = {(x1 , .., x8 ) :

P8

P8

i=1 log xi < C̄} dla pewnego C̄. Zauważmy, że log Xi ma rozkład Exp(θ) zatem

i=1 log Xi ma

rozkład Gamma(8, θ). Stąd C̄ musi być tak dobrane, że

Z

8

X

Pθ=2 (

log Xi < C̄) =

C̄

28 7 −2x

x e

dx = α(C̄).

7!

∞

48 7 −4x

x e

dx = β(C̄).

7!

0

i=1

Z kolei błąd drugiego rodzaju to

Z

8

X

log Xi 6 C̄) =

Pθ=4 (

C̄

i=1

Wystarczy znaleźć punkt minimum funkcji α(C̄) + β(C̄). Zauważmy, że α0 (C̄) + β 0 (C̄) = 0 jeśli

−28 e−2C̄ + 48 e−4C̄ = 0

stąd C̄ = 4 log 2. Pozostaje albo skorzystać z tablic rozkładu χ2 , wtedy dostajemy 0, 3336. Z

przybliżenia rozkładem normalnym. Niech Z będzie z rozkładu N (0, 1)

α(C̄) = Pθ=2 (

oraz

β(C̄) = Pθ=4 (

P8

log Xi − 4

C̄ − 4

(4 log 2) − 4

√

√

< √ ) ' P(Z <

) ' 0, 1927.

2

2

2

P8

log Xi − 2

C̄ − 2

(8 log 2) − 4

p

√

) ' 0, 1373.

6 p

) ' P(Z >

2

1/2

1/2

i=1

i=1

Zatem α(C̄) + β(C̄) ' 0, 330.

2. (Eg 53/3) Niech X1 , X2 , ..., Xn będą niezależnymi zmiennymi losowymi z rozkładu normalnego

N (m + θ, 1), Y1 , Y2 , ..., Yn będą niezależnymi zmiennymi losowymi z rozkładu normalnego N (m −

θ, 1). Wszystkie zmienne są niezależne. Parametry m i θ są nieznane. Weryfikujemy hipotezę

H0 : θ = 0 przy alternatywie H1 : θ = 0, 5 za pomocą testu opartego na ilorazie wiarogodności na

1

poziomie istotności 0, 05. Moc tego testu przy n = 18 jest równa: ?

Odp: C-> 0, 913.

Rozwiązanie. Testy oparte na ilorazie i wiarygodności polegają na tym, że porównuje się LK (x) =

supθ∈ΘK L(θ, x z LH (x) = supθ∈ΘH L(θ, x). Obszar krytyczny ma zatem postać

K = {x ∈ Rn :

LK (x)

> λ0 }

LH (x)

dla pewnego λ0 > 1 spełniającego warunek

Pθ (

LK (X)

> λ0 ) 6 α, gdy θ ∈ ΘH ,

LH (X)

dla zadanej istotności α. W przypadku tego zadania są tylko dwie hipotezy i dlatego test oparty

na ilorazie wiarygodności redukuje się do testu Neymana Pearsona. Najlepiej zapamiętać, że w

przypadku

rozwiązywanego zadania obszar krytyczny będzie miał postać K = {(x, y) ∈ Rn × Rn :

Pn

i=1 (xi − yi ) > C}. Oczywiście wynik ten można potwierdzić rachunkiem zauważmy, że

Pn

exp(− 21 ( i=1 [(xi − m − 21 ))2 + (yi − m + 21 )2 ])

LK (x, y)

Pn

=

=

LH (x, y)

exp(− 21 ( i=1 [(xi − m))2 + (yi − m)2 ])

n

1

1 X

= exp( ( [(xi − yi ) − ])).

2 i=1

2

Stąd natychmiast szukana postać obszaru krytycznego. Znajdujemy właściwe C ze wzoru

n

X

Pθ=0 (K) = P( (Xi − Yi ) > C) = 0, 05.

i=1

Pn

Niech Z będzie z √

rozkładu N (0, 1) oczywiście w sensie rozkładu i=1 (Xi − Yi ) (przy założeniu

Pn

θ = 0) ma postać 2nZ. Stad C = 6 · 1, 64 nadto dla θ = 21 w sensie rozkładu i=1 (Xi − Yi ) ma

√

postać n + 2nZ

√

√

n

Pθ= 21 (K) = P(n + 2nZ > 2n1, 64) = P(Z > 1, 64 − √ ).

2n

Dla n = 18 dostajemy P(Z > 1, 64 − 3) = P(Z > −1, 36) ' 0, 913.

3. (Eg 54/10) Niech X1 , X2 , X3 , X4 , X5 będą niezależnymi zmiennymi losowymi z rozkładu o gęstości

pλ (x) = λe−λx , gdy x > 0, oraz pλ (x) = 0 gdyx < 0,

gdzie λ > 0 jest nieznanym parametrem. Niestety nie obserwujemy zmiennych X1 , X2 , X3 , X4 , X5

ale zmienne Yi = [Xi ], i = 1, 2, 3, 4, 5, gdzie symbol [x] oznacza część całkowitą liczby x. Dysponując próbą Y1 , Y2 , Y3 , Y4 , Y5 weryfikujemy hipotezę H0 : λ = 1, przy alternatywie H1 : λ = 3 za

pomocą testu o obszarze krytycznym

K = {λ̂ > 1, 79},

gdzie λ̂ oznacza estymator największej wiarygodności parametru λ otrzymany na podstawie próby

losowej Y1 , Y2 , Y3 , Y4 , Y5 . Rozmiar tego testu jest równy (wybierz najlepsze przybliżenie).

Odp: C-> 0, 286.

Rozwiązanie. Rozkład zmiennych Yk ma postać

Pλ (Yk = n) = Pλ (Xk ∈ [k, k + 1)) = e−λk − e−λ(k+1) = (1 − e−λ )e−λk , dla k > 0,

2

czyli jest rozkładem geometrycznym z prawdopodobieństwem sukcesu p = (1−e−λ ). Wiarygodność

dla rozkładów geometrycznych o prawdopodobieństwie sukcesu p ma postać

L(p, k) =

5

Y

p(1 − p)ki = p5 (1 − p)k1 +...+k5 , gdzie k = (k1 , ..., k5 ).

i=1

Dla ustalonego k niech f (p) = log L(p, k). Szukamy p takiego, że f 0 (p) = 0, czyli

f 0 (p) =

5

1

− (k1 + ... + k5 )

= 0.

p

1−p

5

Czyli p̂ = 5+k1 +...+k

. Stąd natychmiast λ̂ = − log(1 − p̂). Ponieważ jest to rosnąca funkcja p̂, więc

5

5

> 1 − exp(−1, 79)}. Obliczamy rozmiar

obszar krytyczny ma postać K = {k ∈ N5 : 5+k1 +...+k

5

testu

5

Pλ=1 (

> 1 − exp(−1, 79)).

5 + Y1 + ... + Y5

Oczywiście przy założeniu λ = 1 zmienna Y1 + ...Y5 ma rozkład B− (5, p), gdzie p = 1 − e−1 . Zatem

Pλ=1 (Y1 + ... + Y5 < 5[(1 − exp(−1, 79))−1 − 1]) = Pλ=1 (Y1 + ... + Y5 6 1)

Przypomnijmy, że p = 1 − e−λ . Otrzymujemy

Pλ=1 (Y1 + ... + Y5 = 0) = p5 , Pλ=1 (Y1 + ... + Y5 = 1) = 5p5 (1 − p).

Zatem odpowiedź to p5 + 5p5 (1 − p), gdzie p = 1 − e−1 , która w przybliżeniu wynosi 0, 286.

4. (Eg 55/5) Niech X będzie pojedynczą obserwacją z rozkładu o gęstości

pθ (x) =

2

θ θ

θ

(θ − 2|x|) gdy x ∈ [− , ] oraz pθ (x) = 0 gdy |x| > ,

θ2

2 2

2

gdzie θ > 0 jest nieznanym parametrem. Weryfikujemy hipotezę H0 : θ = 1 przy alternatywie

H1 : θ 6= 1 za pomocą testu opartego na ilorazie wiarogodności na poziomie istotności 0.2. Moc

tego testu przy alternatywie θ = 6 jest równa: ?

Odp: B-> 0, 76.

Rozwiązanie. Ponownie należy skorzystać z testu opartego na ilorazie wiarygodności. Zauważmy,

że w tym przypadku

LK (x)

supθ pθ (x)

=

.

LH (x)

p2 (x)

Zauważmy, że x musi należeć do przedziału [− 21 , 12 ] w przeciwnym przypadku iloraz będzie nieθ (x)

skończony. Zatem supθ pθ (x) = supθ θ22 (θ − 2|x|) przyjmuje maksimum dla ∂p∂θ

= 0 czyli

−

4

2

(θ − 2|x|) + 2 = 0

3

θ

θ

stąd θ = 4|x|. Zatem

LK (x) =

1

.

4|x|

To oznacza, że

LH (x)

1

=

.

LK (x)

8|x|(1 − 2|x|)

Obliczamy C takie, że

Pθ=1 (

1

> C) = 0, 2.

8|x|(1 − 2|x|)

3

Warunek jest równoważny temu, że |x|(1−2|x|) 6 (8C)−1 . Niech d =

lub |x| > 1+d

4 = b. Zauważmy, że

Pθ (X 6 t) =

1 − 12 [θ − 2|x|]2

1

2

2 [θ − 2|x|]

√

1 − C −1 czyli |x| 6

1−d

4

=a

0 < t 6 θ2

.

− θ2 < t 6 0

2

, jeśli |a| 6 θ2 , a w przeciwnym razie 1 nadto Pθ (|X| > b) =

Stąd Pθ (|X| 6 a) = 1− [θ−2|a|]

θ2

jeśli |b| 6 θ2 , a w przeciwnym razie 0. Zatem

[θ−2|b|]2

θ2

Pθ=1 (X ∈ K) = 1 − [1 − 2|b|]2 + [1 − 2|a|]2 = 1 + 2d − 2d(1/2) = 0, 2.

√

√

√

1−8C̄

1−8C̄

2

2

Pozostaje zauważyć, że b − a =

nadto

b

−

a

=

. Niech d = 1 − 8C̄. Zachodzi

2

4

Pθ=1 (X ∈ K) = 1 − [1 − 2|a|]2 + [1 − 2|b|]2 = 1 − 2d + d = 1 − d

Stąd d =

4

5

a dalej a =

1

20 ,

b=

9

20 .

Obliczamy moc testu dla θ = 6

Pθ=6 (|x| 6 a, |x| > b) = 1 −

9 2

1 2

(6 − 10

(6 − 10

)

)

+

' 0, 76.

36

36

5. (Eg 56/5) Obserwujemy niezależne zmienne losowe X1 , X2 , X3 , X4 , Y1 , Y2 , Y3 , Y4 , Y5 . Zmienne losowe X1 , X2 , X3 , X4 mają ten sam rozkład o dystrybuancie Fµ1 . Dystrybuanta Fµ spełnia warunek

Fµ (x) = F (x − µ)

dla pewnej ustalonej, nieznanej, ciągłej, ściśle rosnącej dystrybuanty F . Weryfikujemy hipotezę

H0 : µ1 = µ2 przy alternatywie H1 : µ1 < µ2 stosując test o obszarze krytycznym

K = {S : S < 16},

gdzie S jest sumą rang zmiennych losowych X1 , X2 , X3 , X4 w próbce złożonej ze wszystkich obserwacji ustawionych w ciąg rosnący. Wyznaczyć rozmiar testu.

18

Odp: A-> 126

.

Rozwiązanie. Test rangi oparty jest o spostrzeżenie, że gdyby µ1 = µ2 wtedy zmienne X i

Y powinny być losowo wymieszane. W związku z tym wystarczy obliczyć prawdopodobieństwo

wszystkich układów sprzyjających temu że S < 16 przy założeniu losowego położenia zmiennych

X1 , ..., X4 po ustawieniu w ciąg rosnący w całej próbce. Sprawdzamy, że jest dokładnie

18 moż

liwych układów nadto wyborów zbiorów 4 elementowych w 9 elementowym jest 94 = 126. Stąd

18

rozmiar testu wynosi 126

.

6. (Eg 56/10) Niech X1 , X2 , X3 , X4 będą niezależnymi zmiennymi losowymi o identycznym rozkładzie

geometrycznym postaci

P(X = k) = p(1 − p)k gdy k = 0, 1, 2, ...,

gdzie p ∈ (0, 1) jest nieznanym parametrem. Hipotezę H0 : p = 21 przy alternatywie H1 : p > 21

weryfikujemy testem jednostajnie najmocniejszym na poziomie istotności 0, 1875. Moc tego testu

przy alternatywie p = 54 jest równa:?

Odp: E-> 0, 73728.

Rozwiązanie. Test jednostajnie najmocniejszy oparty jest o statystykę T (x) przy której dla

0

,k)

dowolnego p0 > p funkcja L(p

L(p,k) jest rosnącą funkcją T (k). Obliczamy

L(p0 , k)

(1 − p0 )k1 +...+k4

=

=

L(p, k)

(1 − p)k1 +...+k4

4

1 − p0

1−p

k1 +...+k4

.

Zatem szukaną statystyką jest T (k) = −(k1 + ... + k4 ). W przypadku rozkładów zawsze trzeba

liczyć się z problemem randomizacji testu. To znaczy test ma postać

1 gdy T (k) > C

γ gdy T (k) = C

ϕ(k) =

0 gdy T (k) < C

Stałe C i γ wyznacza się z warunku Ep= 12 ϕ(X) = 0, 1875. Zauważmy, że przy p = 21 , X1 + ... + X4

ma rozkład ujemny dwumianowy B− (4, 21 ). Należy znaleźć C ∈ N takie, że Pp= 12 (X1 + ... + X4 <

C) 6 0, 1875 oraz P(X1 + ... + X4 ) > 0, 1875. Okazuje się, że C = 2, a test szczęśliwie nie jest

zrandomizowany. Obliczamy moc testu dla p = 45 .

Pp= 45 (X1 + ... + X4 < 2) = 0, 7328.

7. (Eg 57/6) Niech X1 , X2 , ..., X8 będzie próbką z rozkładu prawdopodobieństwa Pareto o dystrybuancie

1

Fθ (x) = 1 − θ dla x 6 1 oraz Fθ (x) = 0 dla x < 1,

x

gdzie θ > 0 jest nieznanym parametrem. Rozpatrzmy zadanie testowania hipotezy H0 : θ = 4

przeciwko alternatywie H1 : θ = 2. Zbudowano taki test, dla którego suma prawdopodobieństw

błędów I i II rodzaju, oznaczanych odpowiednio przez α i β, jest najmniejsza. Oblicz tę najmniejszą

wartość α + β.

Odp: B-> 0, 3336.

Q8

θ+1

Rozwiązanie. Zauważmy, że gęstość ma postać fθ (x) = θ8 i=1 x1i

. Stosujemy test Neymana

Pearsona, w tym obliczy iloraz wiarygodności

8

8

Y

X

L(2, x)

= 2−8

x2i = 2−8 exp(2

log xi ).

L(4, x)

i=1

i=1

Zatem obszar krytyczny K = {x ∈ R8 :

L(2,x)

L(4,x)

> C} można zapisać jako

K = {x ∈ R8 :

8

X

log xi > C̄}

i=1

Należy zauważyć, że log Xi ma rozkład Exp(θ) stąd

Γ(8, θ). Stąd

P8

i=1

log Xi ma przy zadanym θ rozkład

α(C̄) + β(C̄) = Pθ=4 (K) + 1 − Pθ=2 (K) =

Z C̄ 8

Z ∞ 8

2

4

exp(−4x)dx +

exp(−2x)dx = f (C̄).

=

7!

7!

0

C̄

Poszukujemy C̄ takiego, że f 0 (C̄) = 0 Równanie f 0 (C̄) = 0 jest równoważna

e−2C̄ = 28 e−4C̄ .

Czyli C̄ = 4 log 2. Pozostaje obliczyć α(C̄)+β(C̄). Można skorzystać z tablic rozkładu chi-kwadrat,

wtedy odpowiedzią jest 0, 3336. Alternatywnie korzystając z rozkładu normalnego dla zmiennej Z

z rozkładu N (0, 1)

P8

α(C̄) = Pθ=4 (

log Xi − 2

C̄ − 2

(8 log 2) − 4

p

√

6 p

) ' P(Z >

) ' 0, 1373

2

1/2

1/2

i=1

5

oraz

P8

i=1

β(C̄) = Pθ=2 (

log Xi − 4

C̄ − 4

(4 log 2) − 4

√

√

< √ ) ' P(Z <

) ' 0, 1927,

2

2

2

a stąd α(C̄) + β(C̄) ' 0, 330.

8. (Eg 57/8) Niech X będzie zmienną losową o rozkładzie Weibulla o gęstości

fθ (x) = 3θx2 exp(−θx3 ), gdy x > 0 oraz fθ (x) = 0 gdy x 6 0.

gdzie θ > 0 jest nieznanym parametrem. Niestety nie obserwujemy zmiennej X, ale zmienną Y

równą X−1, gdy X > 1. W wyniku tych obserwacji otrzymujemy prostą próbę losową Y1 , Y2 , ..., Y10

(nie wiemy ile razy pojawiły się wartości zmiennej X z przedziału (0, 1]) i na jej podstawie wyznaczamy estymator największej wiarogodności θ̂ parametru θ. Dobierz stałą c tak, aby zachodziła

równość

Pθ (θ < cθ̂) = 0, 95.

Odp: D-> 1, 57.

Rozwiązanie. W zadaniu musimy przejść do zmiennych Yi które mają gęstość fθ (xi |xi > 1). Jest

jasne, że p = P(Xi > 1) ma postać

Z ∞

Z ∞

p=

3θx2 exp(−θx3 )dx =

θ exp(−θx)dx = e−θ .

0

1

Zatem zmienne Yi mają gęstość eθ fθ (yi + 1)1yi >0 , stąd wiarygodność ma postać

L(θ, y) = e10θ

10

Y

fθ (yi + 1)1yi >0 .

i=1

Aby obliczyć estymator największej wiarygodności rozważmy funkcję f (θ) = log L(θ, y), której

pochodna ma postać jest równa

10

1 X

(yi + 1)3 .

f 0 (θ) = 10 + 10 −

θ i=1

Stąd θ̂ = P10 ((Y10+1)3 −1) . Zauważmy, że dla przechodząc do zmiennych obserwowanych Yi ten

i

i=1

estymator ma postać

10

θ̂ = P10

3

i=1 ((1 + Yi ) − 1)

Pozostaje sprawdzić dla jakiego c zachodzi

10c

Pθ (θ 6 P10

i=1 (1

+ Yi )3 − 1

) = 0, 95.

P10

Oczywiście (1 + Yi )3 ma rozkład wykładniczy Exp(θ) przesunięty o 1. Stąd też i=1 (1 + Yi )3 ma

P10

rozkład Γ(10, θ) przesunięty o 10. Ściślej i=1 (1 + Yi )3 ma ten sam rozkład co 10 + Y , gdzie Y

ma rozkład Γ(10, θ). Stąd

Pθ (θ 6 P10

10c

i=1 (1

+ Yi

)3

−1

) = Pθ (θ 6

10c

) = 0, 95.

Y

1

2

Łatwo zauważyć, że Y ma ten sam rozkład co Z/(2θ), gdzie Z ma rozkład Γ( 20

2 , 2 ) czyli χ z 20

stopniami swobody. Zatem

0, 95 = P(Z 6 20c)

Z tablic rozkładu χ2 dostajemy 20c ' 31, 410, czyli c ' 1, 57.

6

9. (Eg 58/3) Niech X1 , X2 , ..., X10 będą niezależnymi zmiennymi losowymi o tym samym rozkładzie.

Weryfikowano hipotezę H0 : VarX = 4 przy alternatywie H1 : VarX > 4. Zakładając, że zmienne

losowe X, mają rozkład normalny o wartości oczekiwanej 0 wykorzystano test jednostajnie najmocniejszy na poziomie 0, 05. W rzeczywistości zmienne losowe X, mają rozkład o gęstości

fc (x) = c|x| exp(−cx2 ),

gdzie c > 0 jest nieznanym parametrem. Wyznacz rzeczywisty rozmiar wykorzystanego testu

(wybierz najlepsze przybliżenie).

Odp: B-> 0, 013.